连续域卷积操作跟踪算法的改善

2019-12-06李玉芳韩松伟

王 鑫,李玉芳,宋 策,韩松伟

(1.中国科学院长春光学精密机械与物理研究所,吉林 长春 130033;2. 中国第一汽车集团有限公司研发总院,吉林 长春 130013)

1 引 言

在机器视觉领域里,目标跟踪是一个非常基本的问题,并且在众多应用领域(如监控安防系统、无人机系统、无人驾驶系统、智能交通管理系统、人机交互系统,在线视觉跟踪系统)中,扮演着十分重要的角色。目标跟踪的基本原理是:给定目标物初始位置,结合一系列连续的图像帧,估算出目标物的运动轨迹。在线视觉跟踪的“在线”特点决定了,即使机器视觉对实时计算的约束条件异常复杂,理想的跟踪算法都应该保证系统的“精确性”和“鲁棒性”。

近些年来,可辨识相关分类器(DCF)在实时跟踪领域中扮演的角色越来越重要。国内外为了改善和提高基于DCF的改进算法的跟踪性能,基本上都是围绕向多维空间拓展[1-2]、鲁棒性估计模型[3-4]、机器学习模型[5-6]、引入非线性基核函数法[7],应对边界效应策略[8-9]几个角度展开研究的。但是,这些改进算法在提升系统跟踪性能的同时,图像的特征维度也随之提高,这一变化增加了系统的计算复杂程度和延迟。例如,Bolme团队开发的第一代MOSSE算法[10]比连续域卷积操作跟踪(C-COT)算法[11]的计算速度快了近1 000倍[12],但在精确性方面,后者只比前者提高一倍,同时C-COT算法引入了更多的约束条件,极易引起过拟合。

基于C-COT算法存在的问题,本文从模型维度、训练集大小和模板更新策略3个方面入手,在不牺牲跟踪系统性能的同时,降低跟踪系统的延迟和过拟合出现的概率。

2 C-COT算法原理分析

2.1 构造连续域插值函数

(1)

式(1)中,bd是差值函数,t∈[0,T)是连续域变量,T是连续域支撑空间长度。插值函数Jd{xd}(t)由内插函数bd的各个平移形式叠加而成,其中特征值xd[n]充当加权值。

2.2 构造置信函数

(2)

每个特征通道先用式(1)进行差值操作,然后和对应的分类器进行卷积运算,最后把分类器的卷积响应累加得到式(2)中的置信函数。

2.3 期望泛函

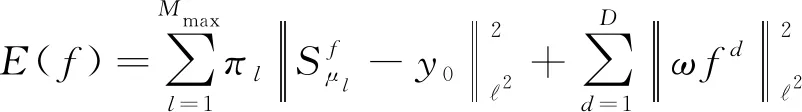

(3)

式(3)中,权重αj≥0控制着每个训练样本的影响力,惩罚系数ω≥0由特征点在整幅图像中的位置决定。样本处在背景区则ω值较大,在目标区则ω值较小。

2.4 训练连续分类器

(4)

根据帕赛瓦尔(Parseval)公式,结合式(3)和(4)可得:

(5)

2.5 正规方程的构造

(6)

(7)

式(7)中(AHΓA+WHW)为对称正定方程,可以用共轭梯度迭代(Conjugate Gradient)法求解。

3 C-COT算法的改善

3.1 对C-COT算法进行改善的原因和目的

本文的目的是提高DCF算法的计算速度和跟踪性能。从MOSSE算法依次到KCF算法、DSST算法、CN算法、SRDCF算法、C-COT算法,跟踪性能的确越来越好,但模型越来越复杂,计算速度也越来越慢。导致计算速度降低的原因主要有:训练的模型维度越来越高、训练集越来越大、模板更新的速度越来越快。本文的目的是在不牺牲跟踪性能的同时,降低跟踪系统的延迟和C-COT算法中过拟合出现的概率。

3.2 卷积因式分解

定义新的卷积算子,如下:

SPf{x}=Pf*J{x},

(8)

(9)

因为式(9)满足卷积的线性性质,故其因式分解可归纳为两步,即包含D维特征的特征向量J{x}(t)先在t处,与降维矩阵PT相乘,得到包含C维特征的特征向量再与分类器向量f进行卷积运算。

(10)

(11)

(12)

卷积因式分解的主要目的是,降低特征通道的维数,进而降低跟踪系统的计算复杂程度和内存空间占用率。由分类器的自适应特点决定,降维矩阵P可以通过训练第一帧图像获得,并在后续跟踪过程中保持不变,故本文仅通过存储预测值PTJ{xj}的方式,就节省了大量内存空间,且PTJ{xj}还可作为C-COT算法的输入,经训练能得到一个C维分类器,即将特征维数D降低到C,进而降低系统计算复杂程度。

3.3 紧凑衍生模型

在C-COT算法中,跟踪系统刻画一个目标物的简单运动就需要大量样本,而且其中很多样本是冗余样本,这点极易造成过拟合。

本文提出一个更具代表性的小模型,即紧凑衍生模型,既可以避免存储完整的样本训练集,又能提高样本的多样性。本文选择的训练模型取自服从高斯分布的样本集,这样既能保证每个样本代表特定的运动时期,又能大大降低过拟合出现的风险。

(13)

(14)

(15)

结合式(15),式(13)可转化为式(16):

(16)

式(16)可参考式(7)求解分类器。

3.4 模型更新策略

如果为求取求解分类器,对图像的每一帧都进行迭代,不仅会影响跟踪系统的计算速度,还容易造成过拟合。因此本文每隔NS=5帧进行一次模型的更新,即执行式(7)的迭代求解分类器。因为式(7)是动态变化的,不必精确求解,所以仅在处理第一帧图像时,设定CG法迭代次数NCG=100,而在处理后续帧时,无需过多迭代,设定NCG=5。 基于这种迭代方式,平均每帧只进行NCG/NS次迭代,极大地提升了运行效率。同时,样本集的更新,则是每一帧都进行。

4 实验与结果

本文基于4个标准数据集,通过综合实验验证了本文提出的改善方法。这4个标准数据集分别是:VOT2016数据集[12]、UAV123数据集[13]、OTB-2015数据集[14]以及Temple-Color数据集[15]。

4.1 实验准备

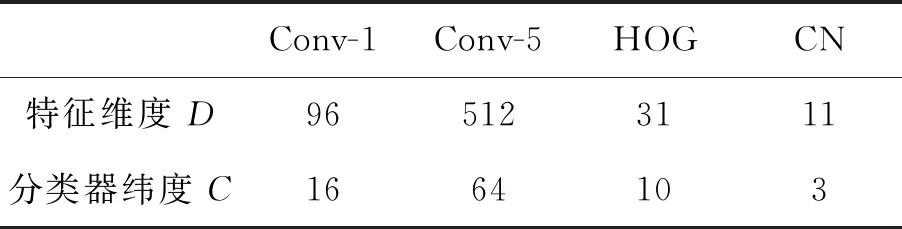

本文基于Matlab环境进行算法验证,使用与C-COT算法相同的4种特征提取方式,即在VGG-m网络[16]中的第一个卷积层(conv1)和最后一个卷积层(conv5)进行特征提取,及HOG法[17]和Color Names (CN)法[18]这两种手动特征提取方式。通过这4种不同的特征提取方式训练因式分解卷积方法中的降维矩阵和分类器,结果如表1所示。

设定式(10)中的正则化参数λ=2×10-7,第

表1 在不同特征提取条件下的特征维度D和分类器数目C

Tab.1 Feature dimensionalityDand the number of filtersCfor each features

Conv-1Conv-5HOGCN特征维度 D965123111分类器纬度 C1664103

本文设定紧凑衍生模型学习速率γ= 0.012,样本的数量L= 50,与C-COT算法使用的样本数(m= 400)相比减少了80%。模型更新时,每NS=6帧更新一次分类器(与C-COT算法一致),CG迭代次数NCG=5。同时,所有视频数据集的全部参数设置固定不变。

4.2 与C-COT算法的对比与分析

本章节基于VOT2016数据集,与C-COT算法进行对比分析,VOT2016数据集包含60个典型视频。使用预期平均重叠率(EAO)对总体性能进行评估,该评估兼顾精确性和鲁棒性[19]。

表2 本文提出的改善算法做出的贡献Tab.2 Contributions of improvement strategy

表2显示了本文在C-COT算法改善方面做出的贡献。把因式分解卷积集成到C-COT算法中,使得 EAO指数提高至0.342,系统计算量减少了6倍。在此基础上,紧凑衍生模型将EAO指数提高至0.352,计算量减少了8倍。模板更新策略进一步将EAO指数提高到0.374,计算量减少了6倍。

本文在单核CPU上进行实验,FPS表征系统每秒可以处理的图像帧数。表2还展示了改善算法对跟踪系统运行速度的提升(不考虑特征提取占用的时间):改善算法的3项工作都不同程度地提高了系统的跟踪速度,相比与C-COT算法,速度一共提升了近20倍。

本文在不改变原算法跟踪精度的前提下,显著地提升了跟踪速度,这对改善跟踪系统的实时性有很大帮助。

4.3 与主流跟踪算法的对比与分析

本文基于4个标准数据集,与最新的主流跟踪系统进行比较。

4.3.1 基于VOT2016数据集的对比与分析

本文从EAO指数、鲁棒性、精确性和运行速度(这里考虑特征提取占用的时间)4个方面,分别与最新的主流跟踪系统进行比较。在EAO指数方面,VOT2016挑战赛中排名第一的C-COT算法的EAO指数为0.331,本文与之相比, EAO指数增加了13.0%;在精确性方面,本文达到了0.72的最低失误率;在运行速度方面,本文仅采用手动特征提取(HOG特征和CN特征)的方式就达到了最快运行速度,详见表3。

表3 不同跟踪策略的实验结果对比与分析

Tab.3 Compare and analysis of experimental results from different tracking strategies

跟踪算法识别率误识别率精确度处理速度SRBT0.2901.250.503.69EBT0.2910.900.443.01DDC0.2931.230.530.20Staple0.2951.350.5411.14MLDF0.3110.830.481.48SSAT0.3211.040.570.48TCCN0.3250.960.541.05C-COT0.3310.850.520.51RDFC&CGM*0.3221.080.5315.13RDFC*0.3740.720.544.53

本文对跟踪速度的提升不是通过缩短特征提取时间实现的,而是通过有效降低图像处理过程中的计算时间实现的。

4.3.2 基于UAV123数据集的对比与分析

“无人机空中跟踪技术”近年来受到广泛关注,并且在野外生命监测、搜救、导航、监控等领域都有广泛的应用,因此无人机持续导航以及实时跟踪技术成为关键。基于此应用背景,理想的跟踪系统应该是精确且稳定的,并且能够在有限的硬件环境下实时运行。此环节采用HOG特征和CN特征进行手动特征提取,且在i7单核CPU上以每秒60帧的速度运行。

UAV123数据集由123个最新航拍视频组成,帧数超过11万,采用“跟踪性能曲线”第一象限积分(AUC)大小来评定跟踪算法的性能。

图1(a)是以UAV123数据集为基础,模拟出的跟踪性能曲线。在排名前五的跟踪系统中,只有基于Staple 算法的跟踪系统是实时运行的,AUC得分为45.3%。在帧频不超过60的情况下,基于本文改善算法(RFCG &CN)的跟踪系统也是实时运行的,且AUC得分为51.7%,比Staple 算法得分高出6.4%。与C-COT算法相比,本文改善算法(RFCG)的跟踪性能略占优势,AUC得分为53.7%。

本文虽然显著提高了C-COT跟算法的踪速度,但是在众多算法中,跟踪速度不是最快的。但是在跟踪速度较快的一系列算法中,跟踪精度是比较高的。

4.3.3 基于OTB2015数据集的对比与分析

本文与20个先进的跟踪算法进行对比,它们分别是:TLD[20]、Struck[21]、CFLB[9]、ACT[1]、TGPR[22]、KCF[7]、DSST[3]、 SAMF[23]、MEEM[24]、DAT[25]、LCT[26]、 HCF[27]、SRDCF[28]、SRDCFad[29]、DeepSRDCF[30]、Staple[31]、MDNet[32]、SiameseFC[33]、TCNN[34]、C-COT[11]。图1(b)是以OTB2015数据集中的100个视频为基础,模拟出的跟踪性能曲线[35-37]。在手动特征提取的条件下,进行跟踪系统性能比较。SRDCFad算法的AUC得分较高,为63.4%,而本文改善算法(RFCG & CN)的跟踪性能略占优势, AUC得分为65.0%。在使用单核CPU,视频每秒60帧的前提条件下, C-COT、MDNet和TCNN这3类算法的AUC得分较高,分别为69.0%、68.5%和66.1%,而本文改善算法(RFCG)的跟踪性能最优,AUC得分为70.0%。

本文在提高原有跟踪算法速度的基础上,也在一定程度上挺高了跟踪精度。

4.3.4 基于Temple-Color数据集的比较与分析

图1(c)是以Temple-Color数据集中128个视频为基础,模拟出的跟踪性能曲线。本文的改善算法(RDFC)较之C-COT算法,跟踪性能有了一定的提升,AUC得分提高了0.8%。

本文基于针对色彩空间的样本,在跟踪精度方面的有一定改善,但不明显。

图1 三类数据集下的跟踪性能曲线Fig. 1 Trace performance curves under three types of datasets

5 结 论

本文以DCF方法为基础,在C-COT算法的基础上,引入了一个因式分解卷积算子,降低了模型中维度,提出了一个训练样本的紧凑衍生模型,在提高样本多样性的同时,降低了系统计算时间和过拟合出现的概率。最后,提出了一个简单有效的模型更新策略,进一步降低了过拟合出现的概率。实验结果证明:基于VOT2016数据集,在EAO指数方面,本文获得的分数为37.4%,比C-COT算法高出13.0%,在精确性方面,本文达到了0.72的最低失误率;基于UAV123数据集,本文获得了53.7%的AUC分数,比C-COT算法高出2%;基于OTB2015数据集,本文获得了70.0%的AUC分数,比C-COT算法高出1%;基于Temple-Color数据集,本文获得了60.5%的AUC分数,比C-COT算法高出1%。

从跟踪性能角度分析,本文在一定程度上改善了系统跟踪精度,明显地提高了原跟踪算法的跟踪速度。跟踪速度的提高降低了系统的硬件标准,这使得复杂的跟踪算法可以应用到更多的实际项目中去。