基于深度学习的彩色以及近红外图像去

2019-11-15马赛克谢长江杨晓敏严斌宇芦璐

马赛克 谢长江 杨晓敏 严斌宇 芦璐

摘 要:单传感器捕获的彩色近红外(RGB-NIR)图像存在光谱干扰,从而导致重建出的标准彩色图像(RGB)图像与近红外(NIR)图像存在色彩失真以及细节信息模糊。针对这个问题提出一种基于深度学习的去马赛克方法,通过引入跳远连接与稠密连接解決了梯度消失和梯度弥散问题,使得网络更容易训练,并且提升了网络的拟合能力。首先,用浅层特征提取层提取了马赛克图像的像素相关性以及通道相关性等低级特征;然后,将得到的浅层特征图输入到连续多个的残差稠密块以提取专门针对去马赛克的高级语义特征;其次,为充分利用低级特征与高级特征,将多个残差稠密块提取到的特征进行组合;最后,通过全局跳远连接恢复最终的RGB-NIR图像。在深度学习框架Tensorflow上使用

公共的图像与视觉表示组(IVRG)数据集、有植被的户外多光谱图像(OMSIV)数据集和森林(Forest)三个公开数据集进行实验。

实验结果表明,所提方法优于基于多级自适应残差插值、基于卷积卷积和神经神经网络以及基于深度残差U型网络的主流的RGB-NIR图像去马赛克方法。

关键词:彩色近红外图像;去马赛克;残差稠密网络;跳远连接;稠密连接

中图分类号:TP391.41

文献标志码:A

Abstract:Spectral interference in Red Green Blue-Near InfRared (RGB-NIR) images captured by single sensor results in colour distortion and detail information ambiguity of the reconstructed standard Red Green Blue (RBG) and Near InfRared (NIR) images. To resolve this problem, a demosaicing method based on deep learning was proposed. In this method, the grandient dppearance and dispersion problems were solved by introducing long jump connection and dense connection, the network was easier to be trained, and the fitting ability of the network was improved. Firstly, the low-level features such as pixel correlation and channel correlation of the mosaic image were extracted by the shallow feature extraction layer. Secondly, the obtained shallow feature graph was input into successive and multiple residual dense blocks to extract the high-level semantic features aiming at the demosaicing. Thirdly, to make full use of the low-level features and high-level features, the features extracted by multiple residual dense blocks were combined. Finally, the RGB-NIR image was reconstructed by the global long jump connection.

Experiments were performed on the deep learning framework Tensorflow using three public data sets, the Common Image and Visual Representation Group (IVRG) dataset, the Outdoor Multi-Spectral Images with Vegetation (OMSIV) dataset, and the Forest dataset. The experimental results show that the proposed method is superior to the RGB-NIR image demosaicing methods based on multi-level adaptive residual interpolation, convolutional neural network and deep residual U-shaped network.Key words:Red Green Blue-Near InfRared (RGB-NIR) image; demosaicing;residual dense network; long jump connection; dense connection

0 引言

近些年来,在图像处理领域对于彩色(Red Green Blue, RGB)图像及其对应的近红外(Near Infrared, NIR)图像的应用变得越来越多,比如:图像融合、行人检测以及人脸识别。同时捕获彩色图像及其红外图像,通常需要两个传感器,然后对捕获到的图像进行配准。虽然得到了成对的彩色图像及红外图像,但是额外引入了配准这一难题。

随着传感器技术的发展,使得用单传感器同时捕获彩色图像与红外图像成为了可能。这不仅解决了两个传感器的成本问题,同时也解决了双传感器带来的配准问题。单传感器在每一个像素位置,根据相应的彩色滤波阵列(Color Filter Array, CFA)捕获单一像素,得到的图像为彩色近红外(Red Green Blue-Near InfRared, RGB-NIR)图像。

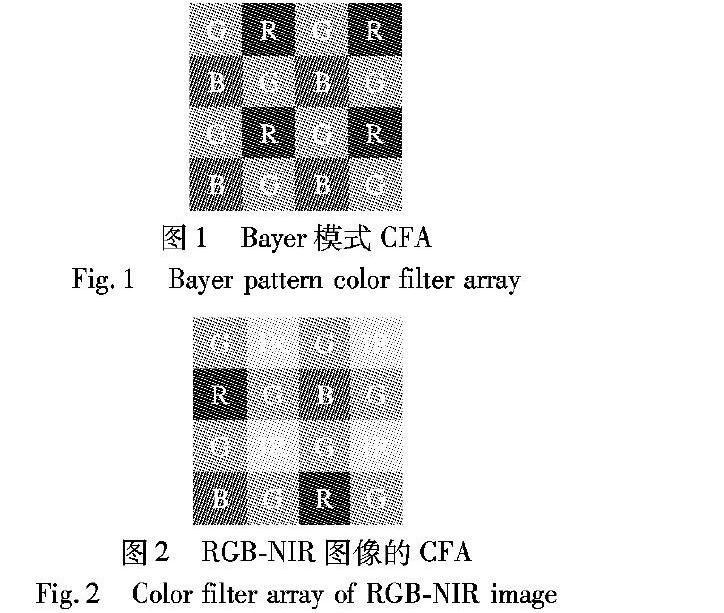

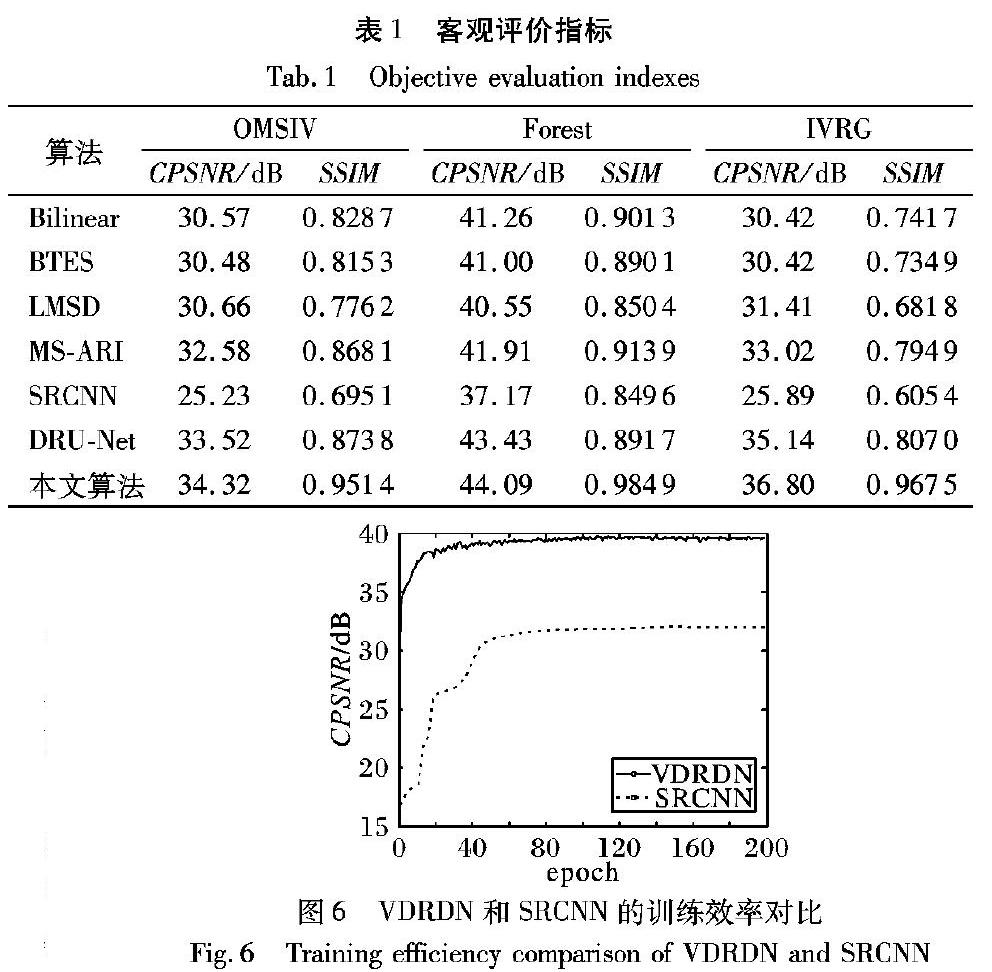

目前大部分的相机通常采用拜尔(Bayer)模式的CFA[1],如图1所示。对红色(Red, R)、绿色(Green, G)、蓝色(Blue, B)三个颜色通道中的一个进行捕获,然后根据插值算法推断出未捕获到的颜色通道的值,这个过程被称为去马赛克[2]。类似于拜尔模式的CFA,专门针对RGB-NIR图像的CFA[3],也相应出现,具体结构如图2所示。

与拜尔模式的CFA相比,RGB-NIR的CFA当中的G分量保持不变,而NIR分量代替了R、B分量总和的一半,R、G分量各自改变为对应的CFA中R、G分量的一半,在本文中,将这种RGB-NIR采样的方式称为稠密RGB-NIR模式[4]。用单传感器捕获RGB以及NIR分量时,传感器输出的为马赛克数据,其中每一像素位置只有R、G、B、NIR当中的一个分量被保存。因此,完整的RGB图像以及NIR图像,需要对马赛克图像进行相应的插值,这与传统的拜尔CFA去马赛克的思路相同。

由于NIR分量在R、G、B分量的波长范围内是完全折射的,因此在传统相机的CFA前面通常都有一个近红外滤光片,以消除NIR分量对R、G、B分量的影响。而对于需要同时捕获RGB图像以及NIR图像来说,需要去除近红外滤波片,这将引入一个光谱干扰的问题。由于NIR分量对其余三个颜色分量的干扰,从而导致得到的图像存在颜色失真问题。

针对同时捕获RGB-NIR,然后重建当中存在的光谱干扰问题,本文将它转换为去马赛克问题,并且提出一种有效的基于卷积神经网络的去马赛克算法。在传统算法中,在对马赛克图像进行插值之后,需要色彩校正等一系列工作,而本文算法可实现马赛克图像到标准彩色图像以及红外图像的端到端映射,不需要再进行额外的操作。

1 相关工作

由于成本与体积的限制,目前大多数用于成像的产品都是采用单传感器获得CFA图像,然后利用一定的手段重建出需要的图像。目前用于RGB-NIR图像去马赛克的算法可以分为两类:一类为基于传统插值算法,另一类为基于学习的去马赛克算法。

1.1 传统插值算法

传统的插值算法通常是根据像素之间的相关性进行相应的重建。最简单的插值算法为双线性插值(Bilinear)[5],它通过相邻像素对未捕获到的像素进行估计,这种方法重建出的图像存在很多伪影以及色彩存在较大的失真。首次针对RGB-NIR的CFA模式,Miao等[6]提出了相应的去马赛克算法。在Miao工作的基础上,Aggarwal等[7]同时考虑空间以及频谱相关来插值,这个插值方式被称为多频谱去马赛克。文献[8]中首先对NIR分量进行双三次插值,接下来通过捕获到的G分量与NIR分量的色差对未捕获的G分量进行估计。文献[9]中提出残差插值算法,首先对G分量进行插值,然后将G分量作为引导图,分别对其余分量与G分量的色差进行插值,

最后将所有分量插值过后的值与原本捕获到的各个分量进行相加,得到标准的彩色图像与红外图像。

1.2 基于学习的去马赛克算法

基于学习的思想主要是根据大量的训练样本学习到马赛克图像到标准图像之间的映射关系。深度学习目前在图像处理的各个领域取得了巨大的成功,比如:目标检测[10]、人脸识别[11]、行为检测[12]以及超分辨率[13]。在去马赛克领域当中,2016年,Gharbi等[14]首次将深度学习应用于对CFA图像联合去马赛克去噪。他们将捕获到的各个通道的像素重新组合;然后,输入到卷积神经网络当中,提取特征;最后,通过重新整理得到标准彩色图像。2017年Tan等[15]通过引入残差模块,使得深度学习用于CFA图像去马赛克取得重大突破。2018年Hu等[16]将卷积稀疏表示应用于RGB-NIR去马赛克,使用字典学习的理论从马赛克图像当中恢复标准的彩色图像以及红外图像。同年,Shopovska等[17]提出深度残差U型网络,将马赛克图像输入网络,然后,通过一连串的下采样与残差模块,最后通过与下采样相反的反卷积操作输出标准的彩色图像以及红外图像。

超分辨率问题与去马赛克问题相似,只是下采样的方式不同。文献[18]中提出了一个对单幅图像进行超分辨率的残差稠密网络结构,本文提出相似的网络结构用于RGB-NIR图像的去马赛克。相对于传统超分辨率卷积神经网络(Super-Resolution Conventional Neural Network, SRCNN)算法的3层结构,本文设计了一个很深的残差稠密网络(Very Deep Residual Dense Network,VDRDN),层数达到了36。

2 本文算法

2.1 算法理论RGB-NIR图像去马赛克的模型[19]定义如式(1)所示:

其中: y为传感器捕获到的马赛克图像的向量;x=[xR,xG,xB,xN]表示需要重建出的理想的彩色圖像以及红外图像;n表示噪声;操作符F建模了单传感器捕获图像的操作。

本文主要是对RGB-NIR图像单纯去马赛克,可以将式(1)改写为:

其中S表示为下采样操作。由于S是奇异的,不存在唯一解,因此需要重建的理想图像可以近似为:

其中:D是一个去马赛克的操作。本文对D建模为一个很深的残差稠密卷积神经网络如式(4)所示:

其中:M表示训练集样本的个数;为真实的RGB-NIR图像。网络参数通过不断地优化重建出的RGB-NIR图像与真实RGB-NIR图像之间的最小均方误差进行更新。

2.2 网络结构

本文提出一种用于RGB-NIR图像去马赛克的网络模型,它由浅层特征提取层、残差稠密块(Residual Dense Block, RDB)以及全局跳远连接构成,具体网络结构如图3所示。网络的输入大小为64×64的4通道马赛克图像,即R、G、B以及NIR通道,每一个通道保留对应RGB-NIR模式的CFA捕获到的像素值,其余未捕获到的像素为0。然后将输入依次经过卷积操作→卷积操作→第一个残差稠密块→第二个残差稠密块→…→第d个残差稠密块→拼接层→1×1卷积→输入的跳远连接→输出。

为保证输入与输出具有同样大小的维度,所有的卷积核大小设置为3×3,步长为1,填充为1,使得网络从输入到输出的维度保持一致。浅层特征提取层包含两次卷积的操作,用于提取一些低级特征,如边缘、颜色、纹理等。提取浅层特征可以表示为:

其中:Iinput表示输入的四通道的马赛克图像;ω1表示第一层卷积层(Conv1)的参数;ω2表示第二层卷积层(Conv2)的参数;“*”表示卷积操作;F0表示得到的特征图。

通过浅层特征提取之后,将输出的低级特征送入残差稠密块(RDB)。如图4所示,残差稠密块中主要操作为跳远连接与稠密连接。通过引入这样的连接很好地解决了梯度消失以及梯度弥散的问题,使得网络更容易训练。同时,由于稠密连接的作用,使得信息在前向传播中不会丢失,充分地利用了低级特征与高级特征,使得網络的学习能力更强。

其中:HRDB,d表示第d个残差稠密块的相应卷积、修正线性单元以及拼接操作,更多的细节参见文献[18];Fd表示通过残差稠密块提取得到的特征图;F0表示输入的马赛克图像经过浅层卷积之后得到的特征图。

通过一系列的残差稠密块提取特征之后,接下来对所有残差稠密块提取到的特征进行拼接,然后将通过1×1卷积改变特征图的通道数为4,最后经过3×3卷积得到最终的特征图。具体过程可以表示为:

其中:Ff表示最终提取到的特征图;ω3表示倒数第二层卷积层(Conv3)的参数;ω4表示最后一层卷积层(Conv4)的参数;Fi表示第i(1,2,…,d)个残差稠密块输出的特征图;[F1,F2,…,Fd]表示所有残差稠密块输出特征的拼接操作。

由于RGB-NIR去马赛克算法只是需要估计出传感器未捕获到的其余三通道的值,因此本文采用一个输入到最终特征图的跳远连接,使得对应像素相加,让网络模型的学习未捕获到的其余通道的像素值。具体过程可以表示为:

3 实验与分析

3.1 训练数据预处理

本文选用文献[20]中的数据集作为训练网络模型的训练集,其中包含477张已经配准的同一场景同一时刻的彩色图像与红外图像。将数据集随机裁剪为64×64大小的图像块,一共得到7万张训练图像,其中每个训练图像为4通道。为模拟RGB-NIR传感器捕获各个通道的像素值,本文对训练集进行相应的下采样得到输入网络的马赛克图像,标签为真实的未采样的图像。相应的图像下采样过程如图5所示。

图5为制作样本集的过程。首先,对完整配对的RGB图像与NIR图像进行拼接,组成四通道的RGB-NIR图像。然后,通过前面提到的稠密RGB-NIR图像CFA对每一个像素点位置的四个分量(R、G、B、NIR)中的一个分量进行保留,其余三个分量值设置为0。最后,得到输入到网络当中的马赛克图像。

图5的左上角为完整的RGB图像,左下角为对应的NIR图像,右上角为得到的RGB-NIR图像的R、G、B三个分量的图像,由于CFA对于G分量采样密度最大,可见整体图像偏绿。

右下角为采样得到的NIR图像,可见当中缺失了很多的信息。其中右边的图像的右下角都是选取图像的局部区域放大,为方便可视化,在展示中未拼接,如果拼接则是完全对应于本文的RGB-NIR图像的CFA模式。

3.2 评价指标

本文采用的测试集为公共的图像与视觉表示组(Images and Visual Representation Group, IVRG)数据集[21]、有植被的户外多光谱图像(Outdoor Multi-Spectral Images with Vegetation, OMSIV)数据集[22]和森林(Forest)数据集[23],其中OMSIV包含533张彩色图像及其对应的红外图像,IVRG包含25张高质量的彩色图像及其对应的红外图像,Forest数据集包含136张彩色图像及其对应的红外图像。客观指标选用复合峰值信噪比(Composition Peak Signal-to-Noise Ratio, CPSNR)[24]以及结构相似性(Structural SIMilarity, SSIM)。

复合峰值信噪比是基于像素点之间的误差,是基于误差敏感的图像质量评价。

其中:的表示重建得出的RGB-NIR图像;x表示真实的RGB-NIR图像。结构相似性由文献[25]提出,为测量图像质量的一种重要指标,值的范围为0~1,越大表示结构越相似。

3.3 参数设定及训练分析

关于网络训练过程当中的一些超参数设定为:学习率为0.0001,Batch_size设为64,梯度下降算法选择Adam。输入图像的大小为64×64,通道数为4,除去倒数第二层的卷积核大小为1×1,其余所有卷积核大小为3×3, padding为1,stride为1。RDB个数为8,每一RDB块当中的卷积+修正线性单元个数为4,因此网络的深度为36层,网络参数总量为3190104。本文采用的实验平台是使用NVIDIA显卡GeForce GTX 1080-TI、3.20GHz Intel i5 CPU、32GB RAM,编译软件采用PyCharm 2019,并使用Tensorflow深度学习框架进行训练。训练200轮(epoch为200),一共训练2d。主观结果采用Matlab R2014a进行绘制。

3.4 实验结果及分析

在与现有方法进行对比时,选择已经公开的实现方法。分别选择Bilinear、基于二叉树的边缘检测(Binary Tree-based Edge-Sensing,BTES)的去马赛克算法[6]、基于最小二乘的多光谱去马赛克(Least-square based Multi-Spectral Demosaicing, LMSD)算法[7]、基于多级自适应残差插值(MultiStage-Adaptive Residual Interpolation,MS-ARI)的去马赛克算法[3]、SRCNN[26]以及基于深度残差U型网络去马赛克(RGB-NIR Demosaicing Using Deep Residual U-Net, DRU-Net)算法[17]。

其中一些算法需要进行相应的改进以符合RGB-NIR去马赛克的需求。超分辨率问题与去马赛克问题类似,SRCNN作为解决超分辨率问题的经典深度学习方法,更改输入与输出的形式得到去马赛克的功能。对OMSIV、IVRG以及Forest三个公开的数据进行测试,得到相应的客观指标与现存主流方法进行对比,结果如表1所示。

在测试集当中选取清晰度高、色彩明亮、饱和度较大的两张图像用于主观显示不同算法之间的结果对比。图7为扇子和蝴蝶图像不同算法的主观结果比较。其中:大图为真实的RGB和对应的NIR图像,图中方框为选取的区域,其他为应用不同算法处理后获得的方框区域放大图。

1)扇子圖像。

Bilinear算法重建出RGB图像存在较大的伪影,图像质量很差。

BTES算法未能重建出真实图像当中的纹路细节,也存在伪影。

LMSD算法重建出的RGB图像偏亮,颜色存在较大失真。

MS-ARI算法重建出RGB图像也存在较大的颜色失真问题。

SRCNN是利用深度学习来解决RGB-NIR图像去马赛克的方法,重建的RGB图像相对于上述传统算法取得了巨大的成功;但是,重建的RGB图像的颜色也存在失真,在图像的条纹处的颜色尤其明显。

基于DRU-Net算法,相对于SRCNN由于采取更优的网络设计,因此重建出的图像取得了更佳的主观效果,颜色失真问题基本消失,只是图像的一些细节未能完美修复。

本文提出的VDRDN算法重建出的RGB图像消除了颜色失真问题,同时恢复出了最准确的细节,在所有对比算法中取得了最佳的视觉质量。

对于重建出的NIR图像,Bilinear、BTES、LMSD、MS-ARI这些传统的插值算法重建出的图像存在细节丢失、额外引入噪声点以及模糊的问题;基于SRCNN算法重建出的NIR图像存在模糊的问题;基于DRU-Net算法以及本文算法均重建出较准确的细节,恢复出了较好的细节。

2)蝴蝶图像。

对于重建出的RGB图像,Bilinear、BTES、LMSD、MS-ARI这些传统的插值算法重建出来的图像存在较大的颜色失真问题,在图像当中的字母的边缘处存在较大的锯齿效应;基于SRCNN算法较好地消除了锯齿效应,而且恢复的细节较好,但是存在一定的颜色失真问题;基于DRU-Net以及本文算法均取得了较好的主观效果。对于重建出NIR图像,基于Bilinear以及基于BTES算法重建出的图像未能重建出细节,图像过于平滑。基于LMSD算法重建出的图像当中存在严重的阴影,恢复出的细节不正确。基于MS-ARI算法恢复出的细节与真实图像不对应。基于SRCNN重建的图像较好地恢复出了细节,但存在模糊问题。基于DRU-Net以及本文算法较好地恢复出了细节,取得了很好的视觉效果。

4 结语

针对目前使用单传感器捕获彩色图像以及近红外图像当中存在的去马赛克问题,本文提出一种基于深度残差稠密网络的算法。

该算法由浅层特征提取、残差稠密块以及全局跳远连接组成。其中:浅层特征提取为两层卷积,用于提取图像的低级特征;其次,残差稠密块一共有8个,每个残差稠密块当中包含4个相应的卷积与非线性映射操作。最终的全局跳远连接模块将输入与最后一个残差稠密块的输出进行相加进行输出。对于OMSIV、IVRG以及Forest数据集,本文算法优于Bilinear、BTES、LMSD、MS-ARI、SRCNN以及DRU-Net,充分说明本文算法的适用性。下一步的工作主要是寻找更优的网络结构,使得RGB-NIR图像去马赛克问题能得到很好的解决。

参考文献(References)

[1] BAYER B E. Color imaging array: US3971065[P]. 197-07-20.

[2] RAMANATH R, SNYDER W E, BILBRO G L, et al. Demosaicking methods for Bayer color arrays[J]. Journal of Electronic Imaging, 2002, 11(3): 306-315.

[3] TERANAKA H, MONNO Y, TANAKA M, et al. Single-sensor RGB and NIR image acquisition: toward optimal performance by taking account of CFA pattern, demosaicking, and color correction [EB/OL]. [2019-01-10]. http://www.ok.sc.e.titech.ac.jp/res/MSI/RGB-NIR/ei2016.pdf.

[4] MONNO Y, TANAKA M, OKUTOMI M. N-to-SRGB mapping for single-sensor multispectral imaging [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision Workshops. Piscataway: IEEE, 2015: 66-73.

[5] GRIBBON K T, BAILEY D G. A novel approach to real-time bilinear interpolation[C]// Proceedings of the 2nd IEEE International Workshop on Electronic Design, Test and Applications. Piscataway: IEEE, 2004: 126-131.

[6] MIAO L, QI H, RAMANATH R, et al. Binary tree-based generic demosaicking algorithm for multispectral filter arrays[J]. IEEE Transactions on Image Processing, 2006, 15(11): 3550-3558.

[7] AGGARWAL H K, MAJUMDAR A. Single-sensor multi-spectral image demosaicing algorithm using learned interpolation weights[C]// Proceedings of the 2014 IEEE Geoscience and Remote Sensing Symposium. Piscataway: IEEE, 2014: 2011-2014.

[8] MARTINELLO M, WAJS A, QUAN S, et al. Dual aperture photography: Image and depth from a mobile camera[C]// Proceedings of the 2015 IEEE International Conference on Computational Photography. Piscataway: IEEE, 2015: 1-10.

[9] MONNO Y, KIKU D, TANAKA M, et al. Adaptive residual interpolation for color and multispectral image demosaicking[J]. Sensors, 2017, 17(12): 2787-2807.

[10] LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single Shot multibox Detector[C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9905. Cham: Springer, 2016: 21-37.

[11] MASI I, RAWLS S, MEDIONI G, et al. Pose-aware face recognition in the wild[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4838-4846.

[12] WANG L, XIONG Y, WANG Z, et al. Temporal segment networks: towards good practices for deep action recognition[C]// Proceedings of the European Conference on Computer Vision, LNCS 9912. Cham: Springer, 2016: 20-36.

[13] YANG J, WRIGHT J, HUANG T S, et al. Image super-resolution via sparse representation[J]. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873.

[14] GHARBI M, CHAURASIA G, PARIS S, et al. Deep joint demosaicking and denoising[J]. ACM Transactions on Graphics, 2016, 35(6): 191-202.

[15] TAN R, ZHANG K, ZUO W, et al. Color image demosaicking via deep residual learning[C]// Proceedings of the 2017 IEEE International Conference on Multimedia and Expo. Piscataway: IEEE, 2017: 793-798.

[16] HU X, HEIDE F, DAI Q, et al. Convolutional sparse coding for RGB+NIR imaging[J]. IEEE Transactions on Image Processing, 2018, 27(4): 1611-1625.

[17] SHOPOVSKA I, JOVANOV L, PHILIPS W. RGB-NIR demosaicing using deep residual U-net[C]// Proceedings of the 26th Telecommunications Forum. Piscataway: IEEE, 2018: 1-4.

[18] ZHANG Y, TIAN Y, KONG Y, et al. Residual dense network for image super-resolution[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 2472-2481.

[19] TANG H, ZHANG X, ZHUO S, et al. High resolution photography with an RGB-infrared camera[C]// Proceedings of the 2015 IEEE International Conference on Computational Photography. Piscataway: IEEE, 2015: 1-10.

[20] BROWN M, SSSTRUNK S. Multi-spectral SIFT for scene category recognition[C]// Proceedings of the 2011 Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2011: 177-184.

[21] SORIA X, SAPPA A D, AKBARINIA A. Multispectral single-sensor RGB-NIR imaging: new challenges and opportunities[C]// Proceedings of the 7th International Conference on Image Processing Theory, Tools and Applications. Piscataway: IEEE, 2017: 1-6.

[22] FREDEMBACH C, SSSTRUNK S. Colouring the near-infrared[EB/OL]. [2019-01-10]. https://infoscience.epfl.ch/record/129419/files/IR_colour.pdf?version=2.

[23] VALADA A, OLIVEIRA G L, BROX T, et al. Deep multispectral semantic scene understanding of forested environments using multimodal fusion[C]// Proceedings of the 2016 International Symposium on Experimental Robotics. Cham: Springer, 2016: 465-477.

[24] MONNO Y, TERANAKA H, YOSHIZAKI K, et al. Single-sensor RGB-NIR imaging: high-quality system design and prototype implementation[J]. IEEE Sensors Journal, 2019, 19(2): 497-507.

[25] WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[26] DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307.