基于人体关节点数据的攻击性行为识别

2019-10-23陈皓肖利雪李广潘跃凯夏雨

陈皓 肖利雪 李广 潘跃凯 夏雨

摘 要:针对人体攻击性行为识别问题,提出一种基于人体关节点数据的攻击性行为识别方法。首先,利用OpenPose获得单帧图像中的人体关节点数据,并通过最近邻帧特征加权法和分段多项式回归完成由人体自遮挡和环境因素所导致缺失值的补全;然后,对每个人体定义动态“安全距离”阈值,如果两人真实距离小于阈值,则构建行为特征矢量,其中包括帧间人体重心位移、人体关节旋转角角速度和发生交互时的最小攻击距离等;最后,提出改进的LightGBM算法w-LightGBM,并对攻击性行为进行识别。采用公共数据集UT-interaction 对所提出的攻击性行为分类识别方法进行测试实验,准确率达到95.45%。实验结果表明,所提方法能够有效识别各种角度的攻击性行为。

关键词:人体关节点数据;攻击性行为识别;缺失值补全;攻击距离

中图分类号: TP18

文献标志码:A

Aggressive behavior recognition based on human joint point data

CHEN Hao*, XIAO Lixue, LI Guang, PAN Yuekai, XIA Yu

School of Computer Science & Technology, Xian University of Posts & Telecommunications, Xian Shaanxi 710121, China

Abstract: In order to solve the problem of human aggressive behavior recognition, an aggressive behavior recognition method based on human joint points was proposed. Firstly, OpenPose was used to obtain the human joint point data of a single frame image, and nearest neighbor frame feature weighting method and piecewise polynomial regression were used to realize the completion of missing values caused by body self-occlusion and environmental factors. Then, the dynamic “safe distance” threshold was defined for each human body. If the true distance between the two people was less than the threshold, the behavior feature vector was constructed, including the human barycenter displacement between frames, the angular velocity of human joint rotation and the minimum attack distance during interaction. Finally, the improved LightGBM (Light Gradient Boosting Machine) algorithm, namely w-LightGBM (weight LightGBM), was used to realize the classification and recognition of aggressive behaviors. The public dataset UT-interaction was used to verify the proposed method, and the accuracy reached 95.45%. The results show that this method can effectively identify the aggressive behaviors from various angles.

Key words: human joint point data; aggressive behavior recognition; missing value completion; attack distance

0 引言

人体的交互行为识别已经成为计算机视觉领域中的热点问题。攻击性行为作为异常交互式行为之一,在限制区域访问检测[1]、人员活动监视[2]、群体活动检测[3]、轨迹追踪[4]、行为识别等领域有着广泛的应用。它可能是言语上的也可能是身体上的,拍、抓、掐、踢、吐、咬、威胁、侵略、羞辱、闲话、攻击、辱骂、欺负、毁坏和破坏都是攻击性行为的例子。每一种行为都会带来伤害的结果,因此对攻击性行为研究对公共安全具有重要意义。目前基于视频流的攻击性行为识别研究大致分为两类:1)基于硬件传感器的交互式行为识别,主要依赖于监控装置的传感器进行信息的捕获,需要对监控器进行额外的设置。如微软3D体感摄像机Kinect[5]通过红外传感器实现对周围环境的感知,获取空间三维人体关节点信息,实现了人体关节点的跟踪,进而能够方便地进行人体运动特征提取[6];但对硬件的依赖会導致应用区域的局限性,并且提高了视频监控的成本,导致很多公共场合都没有安装Kinect监控摄像头。

2)基于软件的人体特征的交互式行为识别,主要采用软件的方式实现对普通视频图像的行为分析,有广泛的发展前景。软件对视频流进行分析时通常采用外观形状、运动和时空等特征对人体行为进行分析,将视频流中的每一帧作为一个原子动作,通过对个体攻击性行为的原子动作序列特征进行识别与理解来识别攻击行为。Ouanane等[7]提出对视频图像的每一帧进行轮廓特征提取,通过轮廓特征分析构建特征词袋,利用K-means算法将特征词袋与骨架特征相融合,然后根据融合后的特征对视频流序列进行特征编码,根据视频流的编码序列实现人体攻击性行为的识别。Serrano等[8]对人体部件构建时空弹性长方体运动轨迹特征,并通过霍夫森林进行有效的攻击性识别。

随着硬件条件的不断提高,陆续产生了许多新的行为识别研究框架系统。2017年,卡耐基梅隆大学的研究人员公开了OpenPose[9]人体骨架识别系统的原代码,实现对监控视频下的目标人物的实时跟踪,它可以在彩色视频中捕捉到COCO(Common Objects in COntext)模型人体骨架信息,同时提供了场景中人体关节点(Joint)信息。OpenPose人体关节点识别系统可以实现实时的多人骨架信息检测,其采用自下而上的人体姿态估计算法,检测人体关键点的位置,然后对人体关键点的热点图采用特征向量亲和参数进行人体关节点的确定。然而,二维人体姿态估计面临着一个无法解决的问题——遮挡[10],传统预测算法不适合于直接对时间性连续数据的缺失值进行预测分析[11]。另外,通过OpenPose获取的视频流骨架运动信息数据量较大,数据之间的相关性较强,不同帧之间数据需要进行深度处理。

本文的主要工作包括:

1)提出最近邻帧特征加权和分段多项式回归缺失数据预测方法;

2)提出人体攻击性行为识别特征向量,将人体运动自身变化的特征与人体重心相结合,实现对攻击行为的描述;

3)提出了LightGBM(Light Gradient Boosting Machine)算法的改进算法——w-LightGBM(weight LightGBM),通过样本类别数量加权,提高多分类样本数量不平衡的分类准确率。

1 人体攻击性行为识别流程

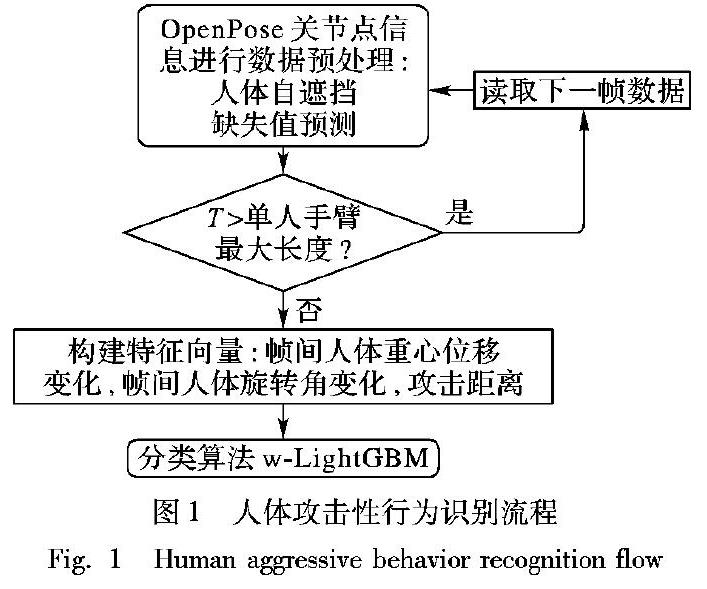

图1为人体攻击性行为识别的主要流程:首先,采用OpenPose获取人体COCO人体关节点信息,并对人体关节点中的数据信息缺失进行预处理。其次,进行交互行为判断。设手臂最大长度为T,以人体的手臂长度为阈值对是否会发生攻击性行为进行判别:对小于阈值的两个人进行攻击性行为特征向量的构建,对不发生攻击性行为的视频帧进行下一帧数据处理。最后,对构建的特征向量使用w-LightGBM进行攻击性行为识别。

1.1 缺失值预处理

1.1.1 人体关节点数据定义

在OpenPose骨架提取中,采用COCO模型对视频流进行二维关节点信息提取,骨架模型详见文献[9]。它由18个关节点和17个肢体向量构成。通过OpenPose可以获得18个关节点数据,本文采用S=( V , E )表示一个人体骨架信息,其中 V ={v0,v1,…,v17}表示的是关节位置集合, E ={ e 0, e 1,…, e 12}表示关节向量的集合。

定义1 关节位置(Joint positions, JP)。将第t帧视频中第j个关节点的位置定义为vj(t)=(xtj,ytj),关节点i的位置定义为vi(t)=(xti,yti),其中i, j∈{0,1,…,17}。

定义2 关节向量(Joint Vector, JV)。根据关节点位置信息对肢体的有效部分进行关节向量提取,表示方式为 e ij(t)= =vj(t)-vi(t), 其中i, j∈{0,1,…,17}。

1.1.2 关节点数据缺失处理

通过OpenPose提取获得的二维人体骨架信息中存在两种数据缺失问题:第一种,攻击者或被攻击者的自身产生的遮挡导致人体的部分位置无法检测到;第二种,由于OpenPose自身算法模型的限制,对具有歧义的关节点信息产生数据丢失。

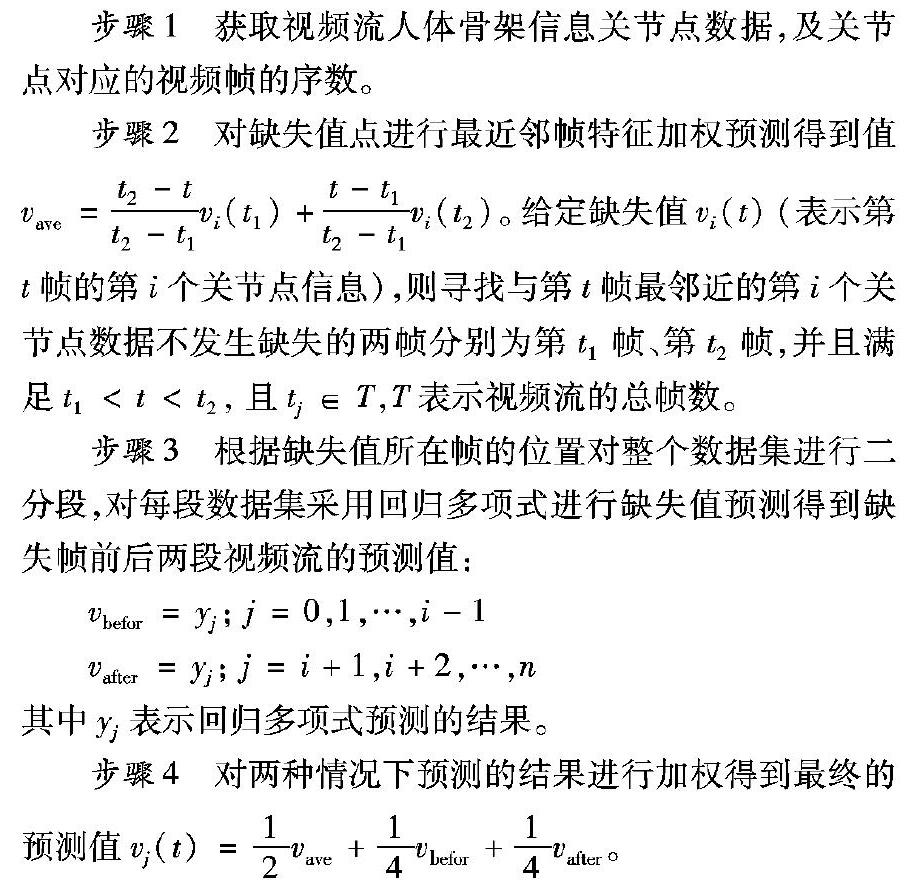

在人体关节点数据的提取中,数据的缺失是随机的甚至会发生在相邻的几帧中,而且视频流中相同位置的关节点数据具有连续性变化、波动性大的特征。采用传统的缺失值预测算法进行数据填补会导致提取的特征精度大幅度下降,因此,本文引入了最近邻帧特征加权法和分段多项式回归进行缺失值预测。具体步骤如下:

步骤1 获取视频流人体骨架信息关节点数据,及关节点对应的视频帧的序数。

步骤2 对缺失值点进行最近邻帧特征加权预测得到值vave= t2-t t2-t1 vi(t1)+ t-t1 t2-t1 vi(t2)。给定缺失值vi(t)(表示第t帧的第i个关节点信息),则寻找与第t帧最邻近的第i个关节点数据不发生缺失的两帧分别为第t1帧、第t2幀,并且满足t1 步骤3 根据缺失值所在帧的位置对整个数据集进行二分段,对每段数据集采用回归多项式进行缺失值预测得到缺失帧前后两段视频流的预测值: vbefor=yj; j=0,1,…,i-1 vafter=yj; j=i+1,i+2,…,n 其中yj表示回归多项式预测的结果。 步骤4 对两种情况下预测的结果进行加权得到最终的预测值vj(t)= 1 2 vave+ 1 4 vbefor+ 1 4 vafter。 1.2 骨架特征矢量的构建 在交互式攻击性行为视频中,视频流中的每帧图像包含攻击者和被攻击者,这时每帧视频图像中人体关节节点数据包含36个关节点数据和34个肢体向量,由于面部向量对运动特征影响较小,因此忽略面部特征,而仅仅将头抽象成一个点,用v0表示。将每帧视频中的人体关节点抽象成图2中的骨架模型图。 在构建特征向量前需要对交互行为是否会发生进行安全距离判断。 1.2.1 安全距离 交往双方的人际关系以及所处情境决定着相互间自我空间的范围。美国人类学家爱德华·霍尔博士划分了四种区域或距离,大体上可分为四种距离:公共距离、社交距离、个人距离(Personal Distance)和亲密距离。其中个人距离为45~120cm,就像伸手碰到对方那样,虽然认识,但是没有特别的关系[12]。因此,本文将安全距离定义为每个人的手臂最大长度(用T表示),这样对于不同身高的人其安全距离阈值不同。通过两个人颈部的距离来判断两个人是否会发生交互行为。计算安全距离阈值T原理如下: T= ∑(v2(t)-v3(t))2 + ∑(v3(t)-v4(t))2 dinter= ∑(v0(t)-v18(t))2 dinter dinter≥T, 攻击行为识别 其中:dinter表示视频帧中任意两个人之间的颈部关节点距离,v0(t)表示第t帧中左侧人的颈部关节点,v18(t)表示第t帧中右侧人的颈部关节点。 1.2.2 骨架特征向量 关节点数据是由(x,y,t)构成的三维数据集,对于这个三维数据直接采用传统的分类算法对人体攻击性行为进行识别存在两个问题:一是视频流中关节点数据量较大且关节点之间的相关性较高,无法进行直接降维,因此直接对人体关节点数据进行攻击性行为的识别困难较大;二是身高不同的人关节点数据相差较大,需要根据不同的人对关节点数据进行归一化。本文进行特征向量构建主要由三方面构成:人体的重心位移差、人体运动角度变化速率和攻击距离。 定义3 特征向量 P ={β0,β1,β2,…,β24}。下面的公式中,θ=cos-1 e j(t)· e k(t) ‖ e j(t)‖·‖ e k(t)‖ 表示人体运动时关节向量之间的夹角变化, e j∈ E 表示人体关节向量;x0= xt8+xt11 2 , y0= yt8+yt11 2 表示两髋骨之间的中点位置;k= xt0-x0 yt0-y0 表示人体中心线所在直线的斜率;pi表示人体各个关节的重心占人体总重心的百分比;v1(t+1)-v1(t)>0表示以视频帧的右侧为正方向,而v1(t+1)-v1(t)<0表示以视频帧的左侧为正方向。β0、 β1表示左侧人体重心位移变化。β2~β10表示人体运动时关节角度变化,Δt表示视频帧差。β2、 β3分别表示左手/右手的大臂与小臂之间的夹角变化的角速度;β4、 β5分别表示左腿/右腿的大腿与小腿之间的夹角变化的角速度;β6表示人体中心线向量(髋骨中心到头部)与竖直方向的夹角;β7、 β8分别表示以人体的头部为极值点,人的中心线与头到左手腕/右手腕向量之间夹角的角速度变化;β9、 β10分别表示以人体的头部为极值点,人的中心线与头到左脚踝/右脚踝向量之间夹角的角速度变化。β11表示视频帧中左侧人体左手到右侧人体身体中心的距离和右手到右侧人体的身体中心的距离中的最小值。β12视频帧中左侧人体左脚到右侧人体身体中心的距离和右脚到右侧人体的身体中心的距离中的最小值。β13~β24表示右侧人体行为特征分量,与左侧分向量相似。 β0=∑pixi β1=∑piyi β2~β10= θ/Δt, v1(t+1)-v1(t)>0(360-θ)/Δt, v1(t+1)-v1(t)<0 因为=0无法判断正方向,只能作为静止物体进行处理,不做为方向判断。 β11= min k·(xt0-xt4)+yt4-yt0 k2+1 , k·(xt0-xt7)+yt7-yt0 k2+1 β12= min k·(xt0-xt10)+yt10-yt0 k2+1 , k·(xt0-xt13)+yt13-yt0 k2+1 β13=∑pixi β14=∑piyi β15~β23= θ/Δt, v19(t+1)-v19(t)>0 (360-θ)/Δt, v19(t+1)-v19(t)<0 β24= min k·(xt0-xt4)+yt4-yt0 k2+1 , k·(xt0-xt7)+yt7-yt0 k2+1 β25= min k·(xt0-xt10)+yt10-yt0 k2+1 , k·(xt0-xt13)+yt13-yt0 k2+1 1.2.3 人體重心计算 在视频流中将人体抽象成一个“质点”,忽略人体自身的形态变化,通过计算这个“质点”在视频帧之间的位移变化表示人体的运动状态信息。根据运动学原理,人体重心位置随人体位移和姿态变化而发生改变。因此,采用人体重心表示这个“质点”,将重心变化作为人体发生不同运动时的特征分量进行分析。根据人体重心在视频帧之间的变化幅度来区分人体是处于运动状态还是静止状态,人体重心计算模型详见文献[13],原理如下: β0=∑pixi β1=∑piyi 1.2.4 人体运动角度变换 在视频流中,每一帧中的人体姿态变化可以看作是发生攻击行为时的原子动作,而整体动作可以由几个典型的关键帧组成,而其他帧都可以看作是这几个关键帧的过渡。根据数据统计,发生一次完整的攻击性行为约为5帧,为降低帧间数据的冗余性,增强特征差异,提高计算效率,本文以5帧为一组进行特征提取。对当前帧和其之前的第5帧进行特征向量的构建,其中关节旋转角变化包括:人体大臂和小臂夹角的变化速率、人体大腿和小腿夹角的变化速率、人体髋骨中心到头部的向量与竖直方向向量的夹角、身体与手腕呈现的角度变化速率、身体与脚腕呈现的角度的速率变化。计算公式为: θ=cos-1 e j(t)· e k(t) ‖ e j(t)‖·‖ e k(t)‖ β2~β10= θ/Δt, v1(t+1)-v1(t)>0 (360-θ)/Δt, v1(t+1)-v1(t)<0 2 w-LightGBM算法 LightGBM[14]算法是XGBoost[15]算法的改进,采用集成树形结构对攻击性行为特征向量进行分类。由于在构建特征向量时,视频数据的长度很难保持一致,因此会产生特征向量的样本数量不均衡,根据1.2节方法实现对不同行为视频流中特征向量的构建,进而统计每种特征向量的数量形成直方图,如图3。由于对每种动作监控时视频流长短不一,导致在训练攻击性行为识别模型时会由于样本数量的不平衡导致识别结果偏向大数量样本类别。本文根据特征向量的样本数量不均衡,提出了w-LightGBM算法对样本种类进行加权分类识别,该方法修正了样本不均衡导致样本识别结果偏向大数据类别的问题。 w-LightGBM算法: 步骤1 统计每种交互行为产生的攻击性行为特征向量 的数量,N表示所有行为特征向量的总数,nkind表示第kind 类的特征向量的数量; 步骤2 计算特征向量数量的平均值 = 1 N ∑ kind=1 nkind,作为样本波动的基准值; 步骤3 根据特征向量的平均值 计算特征向量标准差var= 1 N ∑ N kind=1 (nkind- )2 计算样本波动幅度; 步骤4 根据特征向量的标准差计算特征向量的波动幅度vkind= | nkind- | / var,采用Sigomd函数对波动幅度进行平滑处理; 步骤5 根据经验值对平滑后的特征向量波动值进行权值计算wkind= 1 2 +α 1 1+exp(-vkind) ,其中α为经验值,一般为1.5。 3 实验与分析 本文采用的实验环境为Intel Core i7-6700HQ CPU@2.60GHz 2.59GHz,8GB内存,Windows 10操作系统,Visual Studio 2015。在公共基准数据集UT-interaction上完成攻击性行为识别分析的测试实验,该数据集是以视频数据形式存储的交互行为动作数据集,包括20个视频序列、6类交互行为动作,视频格式为720×480,30fps,视频中人像大小为200像素。本文实验采用数据集中的5种交互行为(握手、拥抱、击拳、推、踢)进行攻击性行为特征向量的构建,采用w-LightGBM算法对攻击性行识别分类。 3.1 实验结果分析 3.1.1 评价指标 实验中,同时采用精确度(precision)、召回率(recall)、综合评价指标F值(F-measure)和样本支持数量(support)作为评价手段来衡量算法的效果: precision= TP TP+FP recall= TP TP+FN F-measure= (ε2+1)*precision*recall ε2precision+recall 对二分类问题来说,TP(true positives)对应于被分类模型正确预测的正样本数;FP(false positives)对应于被分类模型错误预测为正类的负样本;FN(false negatives)为对应于被分类模型错误预测为负类的正样本数;ε为precision和recall的调和度。 2.accuracy是在这个数据集中通过十字交叉验证得到的识别率的,而precision是在进行密性训练时模型在支持数据集上的识别准确率。将accuracy改成小数显示 3.与之前的θ不同,这里是preciSion和recall的调和度,换成ε表示。 3.1.2 实验结果对比 表1为采用本文构建的特征向量在经典算法中的识别效果比較,该结果主要针对的是UT-interaction数据集5种交互行为,且各算法的support值均为2508。其中: accuracy是在数据集中通过十字交叉验证得到的识别率,precision是在进行模型训练时模型在支持数据集上的识别准确率。 由表1可知,在本文提取的特征向量下,与其他常用算法相比,采用本文算法w-LightGBM的准确率达到了9545%,模型得分为1.00。与算法LightGBM相比,本文算法识别率提高了1.47%。可以看出,本文算法w-LightGBM的识别效果要优于目前主流识别算法,因此本文采用改进后的w-LightGBM算法对攻击性行为进行分类。 表2为UT-interaction数据集上主流算法的行为识别率。从表2可以看出 本文算法的准确率较高 ,文献[16]采用嵌入空间多示例学习(Spatial Multiple Instance Learning, SMIL)方法获取多种视觉特征描述交互双方之间的交互信息,并用支持向量机(Support Vector Machine, SVM)进行识别。该方法取得了除本文算法外最好的识别率,但它的实现比较复杂。 文献[17]基于相关滤波(Coherent Filtering, CF)算法将轨迹分组,提取大位移光流特征(Histogram of Large-Displacement Optical Flow, HO-LDOF)作为运动特征,从而得到局部运动模式(Local Motion Patterns, LMP),并用最近邻分类器进行识别,但识别效果不太理想;而 本文提出的攻击性行为识别方法识别效果最好。实验结果表明,本文提出的方法有效性可行,具有较高的适应性,可达到实时应用。 3.2 特征向量效果分析 图4为OpenPose获取人体关节点数据相关关系图,可以看出人体关节点之间的特征相似度。通过关节点的特征相似程度来反映多个关节点之间的相似性和差异性。 根据图中数据可知,人体关节点数据之间相似度较高,特征差异性较小,所表示的运动特征向量单一,直接进行攻擊性行为分析效果较差。因此,在关节点数据的基础上构建攻击性行为特征向量,提高交互行为之间的特征差异性,图5为本文构建的特征分量的相关关系图。由图5可知,特征分量之间的相似性较小,特征差异性较大,特征分量β0~β12相关性较高的原因是其计算公式都与人体的中心线有关。 由图4可知,人体关节点数据之间的相似度较高,特征差异性较小,直接进行攻击性行为分析效果较差。 由图5可知,特征分量之间的相似性较小,特征差异性较大,特征分量β0~β12相关性较高的原因是其计算公式都与人体的中心线有关。 3.3 w-LightGBM算法参数分析 本文测试实验采用数据集UT-interaction中的每种交互行为视频提取到的交互行为特征向量。由于构建的特征向量数量不平衡,直接采用LightGBM算法进行分类,识别率为93.98%;本文对样本数量加权平衡后,识别率提高了147%。 图6是样本平衡权值wkind中α因子值为1.0、1.5和2.0时的评价指标结果。 其中,参数α控制wkind∈[0.5, 0.5+α]。 这些权重的范围从0.5到0.5+α之间。 采用sigmoid函数进行平滑处理时输出范围在0到1之间,加上0.5是为了保证权重的有效性。当一些样本类的数量很大时,产生权重很小,但权重不会小于0.5;而当一些样本类的数量很小时,权重会很大,但不会超过0.5+α。 图7是α值分别为1.0、1.5和2.0时特征向量的分类结果混淆矩阵。由图7可知,将α设为1.5。图6(b)为α=1.5时w-LightGBM算法在UT-interaction数据库上攻击性行为识别的混淆矩阵,从图中可以看出,错误主要集中在推和拥抱这两个交互动作的识别上,推被看作拥抱或者拥抱被看作推的识别错误率较高,这是由于两者在特征向量构建时除在关键帧附近会发生较大的区别外,其前期的靠近行为相似度极高,只是手的位置和两个人之间交互动作发生时距离的变化,发生推时两个人之间的距离会大于拥抱时两个人之间的距离。本文以5帧为一个特征向量,前期特征向量的相似度导致了识别错误的发生。 4 结语 本文提出了一种基于人体关节点数据的攻击性行为识别算法。主要工作包括处理缺失数据并进行预测填充,对关节点数据进行特征向量的构建,使用改进的w-LightGBM算法对交互行为进行分类识别。在人体交互数据集UT-interaction上取得了良好的识别效果,一定程度上提高了基于人体关节数据的攻击性行为识别算法中行为特征表达的有效性和全面性。 参考文献 [1] SCHWAPPACH D, SENDLHOFER G, HSLER L, et al. Speaking up behaviors and safety climate in an Austrian university hospital [J]. International Journal for Quality in Health Care, 2018, 30(9): 701-707. [2] YU S, CHEN H, BROWN R A. Hidden Markov model-based fall detection with motion sensor orientation calibration: a case for real-life home monitoring [J]. IEEE Journal of Biomedical and Health Informatics, 2018, 22(6): 1847-1853. [3] RABIEE H, MOUSAVI H, NABI M, et al. Detection and localization of crowd behavior using a novel tracklet-based model [J]. International Journal of Machine Learning and Cybernetics, 2017, 9(12), 1999-2010. [4] LU X D, KOGA T. Real-time motion detection for high-assurance aircraft tracking system using downlink aircraft parameters [J]. Simulation Modelling Practice and Theory, 2016, 65:81-92. [5] STONE E E, SKUBIC M. Fall detection in homes of older adults using the Microsoft Kinect [J]. IEEE Journal of Biomedical and Health Informatics, 2015, 19(1): 290-301. [6] CHANG X, MA Z, LIN M, et al. Feature interaction augmented sparse learning for fast Kinect motion detection [J]. IEEE Transactions on Image Processing, 2017, 26(8):3911-3920. [7] OUANANE A, SERIR A. New paradigm for recognition of aggressive human behavior based on bag-of-features and skeleton graph [C]// Proceedings of the 8th International Workshop on Systems, Signal Processing and Their Applications. Piscataway, NJ: IEEE, 2013:133-138. [8] SERRANO I, DENIZ O, BUENO G, et al. Spatio-temporal elastic cuboid trajectories for efficient fight recognition using Hough forests [J]. Machine Vision & Applications, 2018, 29(2): 207-217. [9] CAO Z, SIMON T, WEI S. et al. Realtime multi-person 2D pose estimation using part affinity fields [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 1302-1310. [10] MERAD D, AZIZ K, IGUERNAISSI R, et al. Tracking multiple persons under partial and global occlusions: application to customers behavior analysis [J]. Pattern Recognition Letters, 2016, 81: 11-20. [11] RAZARI-FAR R, CHAKRABARTI S, SAIF M, et al. An integrated imputation-prediction scheme for prognostics of battery data with missing observations [J]. Expert Systems with Applications, 2016, 115: 709-723. [12] 史慧.談谈人际交往中的空间距离[J].河南水利与南水北调,2007(7):73-74. (SHI H, Talking about the spatial distance in interpersonal communication [J]. Henan Water Resources and South-to-North Water Diversion, 2007(7): 73-74.) [13] 费章惠.中国大百科全书:力学[M].北京:中国大百科全书出版社,1987:133. (FEI Z H. Encyclopedia of China: Mechanics [M]. Beijing: Encyclopedia of China Publishing House, 1987: 133.) [14] MA X, SHA J, WANG D, et al. Study on a prediction of P2P network loan default based on the machine learning LightGBM and XGboost algorithms according to different high dimensional data cleaning [J]. Electronic Commerce Research and Applications, 2018, 31: 24-39. [15] CHEN W, FU K, ZUO J, et al. Radar emitter classification for large data set based on weighted-XGboost [J]. IET Radar, Sonar & Navigation, 2017, 11(8):1203-1207. [16] SENER F, IKIZLER-CINBIS N. Two-person interaction recognition via spatial multiple instance embedding [J]. Journal of Visual Communication & Image Representation, 2015, 32:63-73. [17] ZHANG B, ROTA P, CONCI N, et al. Human interaction recognition in the wild: analyzing trajectory clustering from multiple-instance-learning perspective [C]// Proceedings of the 2015 IEEE International Conference on Multimedia and Expo. Piscataway, NJ: IEEE, 2015: 1-6. [18] KONG Y, LIANG W, DONG Z, et al. Recognising human interaction from videos by a discriminative model [J]. IET Computer Vision, 2014, 8(4):277-286. [19] KONG Y, FU Y. Modeling supporting regions for close human interaction recognition [C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8926. Berlin: Springer, 2014:29-44. [20] NGUYEN N, YOSHITAKA A. Human interaction recognition using independent subspace analysis algorithm [C]// Proceedings of the 2014 IEEE International Symposium on Multimedia.Piscataway, NJ: IEEE, 2014: 40-46. [21] el houda SLIMANI K N, BENEZETH Y, SOUAMI F. Human interaction recognition based on the co-occurrence of visual words [C]// Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ: IEEE, 2014: 461-466. [22] 王佩瑤,曹江涛,姬晓飞.基于改进时空兴趣点特征的双人交互行为识别[J].计算机应用,2016, 36(10):2875-2879. (WANG P Y, CAO J T, JI X F. Two-person interactive behavior recognition based on improved spatio-temporal interest points [J]. Journal of Computer Applications, 2016, 36(10): 2875-2879.) [23] 姬晓飞,左鑫孟.基于分阶段视觉共生矩阵序列的双人交互识别[J].计算机工程与设计,2017,38(9).2498-2503. (JI X F, ZUO X M. Human interaction recognition based on multi-stag framework and co-occurring visual matrix sequence [J]. Computer Engineering and Design, 2017, 38(9): 2498-2503.)