基于卷积神经网络的JPEG图像隐写分析参照图像生成方法

2019-10-21任魏翔翟黎明王丽娜

任魏翔 翟黎明 王丽娜 嘉 炬

(空天信息安全与可信计算教育部重点实验室(武汉大学) 武汉 430072)(武汉大学国家网络安全学院 武汉 430072)

随着信息技术的飞速发展,多媒体文件在网络中广泛传输,导致多媒体信息安全问题日益严重.信息隐藏的研究成果对解决多媒体信息安全问题具有重要作用.

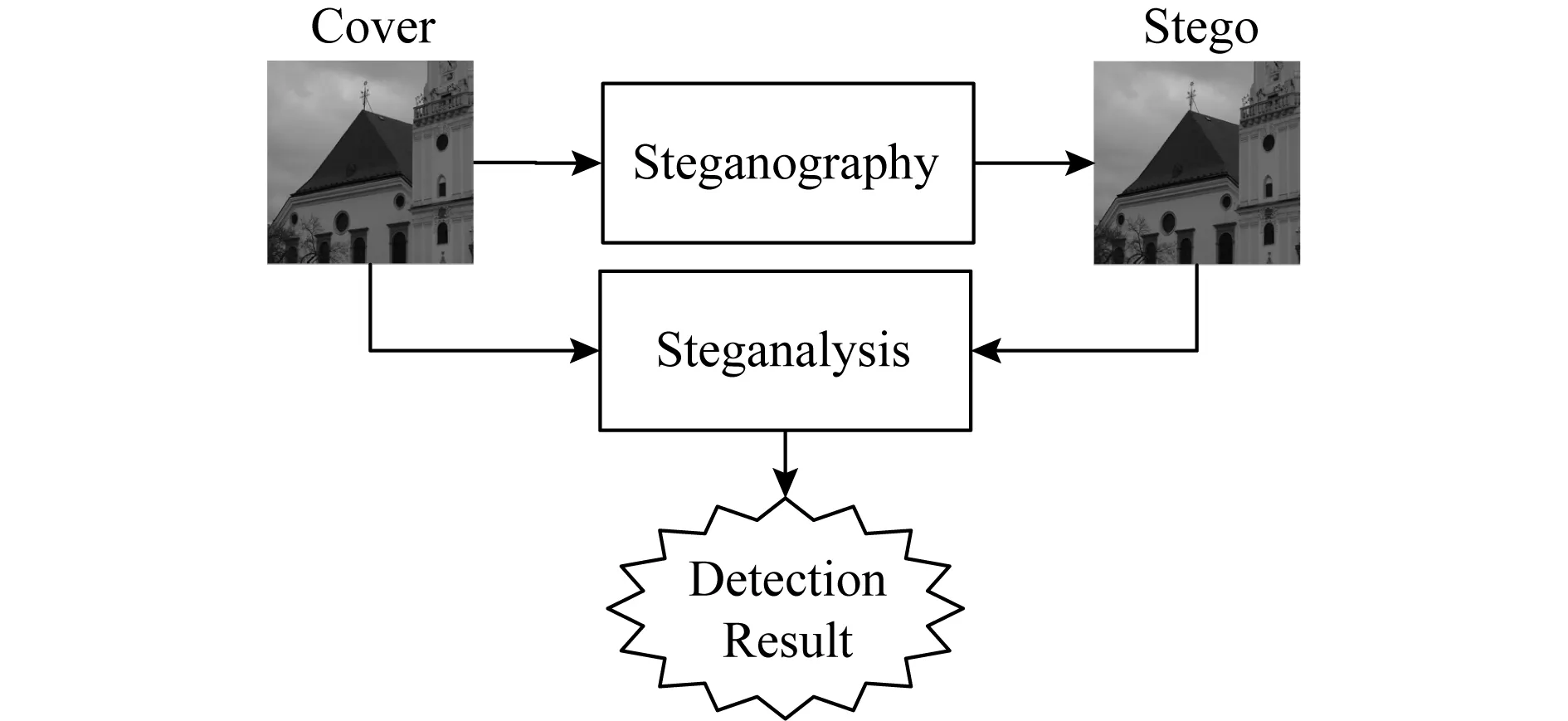

信息隐藏领域的研究可分为隐写(stegano-graphy)、隐写分析(steganalysis)两方面.如图1所示,隐写是将有意义的信息隐藏在另一个称为载体C(cover)的信息中得到隐蔽载体S(stego)的技术[1].隐写分析是隐写术的对抗技术,对可疑的载体信息进行攻击,达到检测、破坏、甚至提取秘密信息的技术[1].

Fig. 1 Steganography and steganalysis图1 隐写与隐写分析

针对数字图像的隐写术通过对图像中的像素或者DCT系数等图像元素进行微量的修改,从而实现在图像中隐藏秘密信息的目的.然而隐写过程中对图像元素的修改操作会对图像元素值的统计分布造成一定的扰动.因此,当前数字图像隐写算法主要通过合理地选择对图像进行修改的位置[2],以及尽量减少所需修改的图像元素[3-4]来达到最小化隐写操作对原始图像所造成影响的目的.当前具有较高安全性的数字图像隐写算法主要为内容自适应隐写算法,该类算法能够有选择地对图像元素进行修改,以减小秘密信息嵌入过程对图像造成影响.该类算法设计过程可分为失真代价函数设计和隐写码的设计2部分.其中失真代价函数用于衡量秘密信息的嵌入过程中对原始图像载体元素的统计规律造成的影响.而隐写码是指在基本嵌入的基础上,为了减小隐写嵌入失真(distortion)(亦称代价)而进行的编码[5].在STC隐写码[6]提出后,面向数字图像的隐写算法的设计工作主要集中在失真代价函数的设计[7-13].然而,隐写的安全性不仅取决于隐写算法、嵌入率等因素,而且在很大程度上收到隐写过程中载体图像自身属性的影响[14].

当前通用图像隐写分析方法的相关研究可分为基于隐写分析特征的检测方法,以及基于深度学习的检测方法.前者通过构建能够描述图像载体统计规律或特性,并且对隐写嵌入操作敏感的隐写分析特征,结合机器学习方法对载体进行检测[15-19].其中,隐写分析特征依据对图像载体.后者基于深度学习技术,构建用于执行隐写分析任务的深度学习模型,以实现隐写信号的端到端检测.目前,基于深度学习的隐写分析相关研究已成信息隐藏领域的热点研究问题,并取得了较好的成果[20-29].

选择信道感知的隐写分析方法以提升针对自适应图像隐写算法检测效果为目标,利用自适应隐写算法对图像各元素修改的概率,将检测重点集中在更易被隐写算法修改的图像区域,从而提升针对自适应隐写算法的检测能力.其中,待检测图像各元素被特定自适应隐写算法修改的概率可视为隐写分析模型的辅助信息.当前选择信道感知的思想已运用于基于特征的隐写分析模型,以及基于深度学习的隐写分析模型.

由于JPEG图像在互联网中的广泛应用,因此针对JPEG图像的研究具有较高的实际意义.当前基于深度学习的JPEG图像隐写分析的研究工作主要集中于负责隐写检测的深度学习模型的相关研究[26-29].基于深度学习隐写分析模型辅助信息的产生方式主要基于研究者专业经验进行设计[23-24].本文借助深度学习方法,从隐写分析辅助信息产生方式的角度,探索提升针对JPEG图像的深度学习隐写分析模型检测效果的新途径.

本文构建具有卷积层和反卷积层的16层卷积神经网络,对待检测图像进行变换,得到待检测图像所对应的参照图像,将参照图像和待检测图像一同作为JPEG图像隐写分析模型的输入数据,从而基于现有针对JPEG图像深度学习隐写分析模型,进一步提升JPEG图像深度学习隐写分析模型检测能力.

本文的主要贡献有3个方面:

1) 提出针对JPEG图像隐写分析的参照图像生成模型,为针对JPEG图像的深度学习隐写分析模型提供辅助信息,从辅助信息的角度探索提升深度学习隐写分析模型检测能力的途径;

2) 隐写分析参照图像生成模型基于深度卷积神经网络,能够通过训练,学习有利于提升隐写检测能力的辅助信息生成方式;

3) 针对多种嵌入率、隐写算法的对比实验结果表明,所提出的针对JPEG图像隐写分析的参照图像生成模型生成的参照图像能够提升针对JPEG图像的深度学习隐写分析模型的检测能力.

1 相关工作

由于JPEG图像在互联网中的广泛使用,针对JPEG图像的隐写分析具有较高的研究价值.因此,基于深度学习的JPEG隐写分析方法也是隐写分析研究领域的热点问题.

在深度学习隐写分析开始引起学者关注期间,Xu[26],Chen等人[27],Zeng等人[28]分别提出了针对JPEG图像的深度学习隐写分析模型.其中,Xu[26]构建了具有20层的深度卷积网络模型,该模型为减少信息丢失,不使用池化操作,并加入跳转链接(shortcut connection),以防止梯度消失现象发生.Chen等人[27]构建的深度学习模型包含64个卷积神经网络,其中每个神经网络与JPEG图像的1个相位相对应,从而实现了网络模型对JPEG图像不同相位数据的分离处理.Zeng等人[28]构建了1种针对JPEG隐写分析的混合卷积经网络模型.该模型首先利用25个DCT变换基对待检测图像进行预处理,之后对预处理结果进行多种不同的量化和截断处理,并将处理的结果分别作为不同深度卷积神经网络的输入.Yang等人[29]基于DenseNet[30]提出了针对JPEG图像的深度学习隐写分析模型.

1.1 JPEG图像深度学习隐写分析处理过程

卷积神经网络(convolutional neural network, CNN)能够提取图像中相邻元素之间存在的相关性.因此,当前针对JPEG图像的深度学习隐写分析模型主要基于卷积神经网络,并将JPEG图像的解压(不取整)结果作为输入数据.除此之外,不同针对JPEG图像的深度学习隐写分析模型在卷积神经网络部分都采用了卷积层(convolutional layer)、批标准化(batch normalization)、ReLU(rectified linear unit)激活函数、平均池化(avarage pooling)等操作.

卷积神经网络中的卷积层由多个卷积核构成,各卷积核的有卷积权重和偏置组成,卷积权重和偏置参与神经网络的训练.卷积层中的各卷积核分别利用卷积权重对输入数据进行卷积操作,并将结果与对应的偏置相加,之后将卷积核的处理结果进行合并,合并结果作为该卷积层的输出.具体处理过程:

outputl=outputl-1*Wl+Bl,

(1)

其中,outputl和outputl-1分别为第l个卷积层的输出数据和输入数据;Wl为第l个卷积层的卷积核参数矩阵;*为卷积操作算子;Bl为第l个卷积层的偏置.

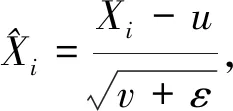

为了提升深度学习隐写分析模型在训练过程中的收敛速度,采用批标准化(batch normalization, BN)层[31],对卷积层输出的特征图进行标准化处理.BN层的处理过程:

(2)

(3)

(4)

(5)

深度神经网络中的激活函数保证了深度学习隐写分析模型进行非线性特性的学习,而ReLU(rectified linear unit, ReLU)激活函数在深度学习模型中得到了广泛的应用.ReLU激活函数的具体处理过程为

(6)

其中,x为ReLU激活函数的输入;f(x)为其输出结果.

平均池化属于1种下采样操作,对矩阵X进行平均池化操作具体过程:

(7)

其中,X为池化操作待处理的矩阵;池化操作的窗口大小为n×n;K为大小为n×n,并且元素全为1的矩阵,“*”为卷积操作算子.

相对于最大池化等其他池化操作,能够保留隐写算法的嵌入操作在载体中引入的微弱扰动.因此,基于深度学习的隐写分析模型主要采用平均池化作为其池化操作.

1.2 深度学习隐写分析辅助信息产生方式

为进一步提升针对JPEG图像的深度学习隐写分析模型检测能力,Yang等人[23]和Ye等人[24]提出的深度学习隐写分析模型在输入数据的基础上,附加以相应的辅助信息.当前基于深度学习的隐写分析模型的辅助信息主要来源于待检测图像各元素被自适应隐写算法修改的概率.

如图2所示,图像中位于纹理复杂区域的元素对应的大于位于平滑区域元素的修改概率.以上现象表明自适应隐写算法更倾向于在图像中的纹理复杂区域进行嵌入操作.

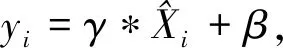

产生以上现象的原因为图像纹理复杂区域的元素值的统计分布相比于平滑区域更为复杂,隐写算法在这些统计规律复杂区域造成的扰动更加不易被觉察.因此,对隐写算法修改概率更高的区域进行更有侧重地检测,有利于提升隐写检测效果待检测图像的元素被自适应隐写算法修改概率可利用损失函数计算得到.具体计算方式为

(8)

其中,βi,j为位于图像位置(i,j)的元素被修改的概率值;λ为大于零的数值,具体数值由隐写相对嵌入率决定.

Fig. 2 An image and the corresponding embedding probability map图2 一张图像及其对应的修改概率图

2 JPEG图像隐写分析参照图像生成模型

虽然利用图像各元素被修改的概率作为辅助信息,能够提升针对JPEG图像的深度学习隐写分析模型的检测能力,但当前基于深度学习隐写分析模型所使用辅助信息的产生方法有待进一步改进,隐写分析模型的输入数据中隐含的与隐写分析有关的信息有待进一步挖掘.

本文从隐写分析辅助信息的角度,探索进一步提升深度学习隐写分析模型检测能力的途径,提出JPEG图像隐写分析参照图像生成模型,尝试更加深入的挖掘待检测图像中与隐写分析有关的信息.首先,基于U-NET[32]构建具有跳转连接(skip connection)的深度卷积神经网络,对待检测图像进行处理,生成用于JPEG图像隐写分析的参照图像.之后,将生成的参照图像作为隐写分析的辅助信息,与隐写分析模型相结合.从而更加充分地挖掘待检测图像中与隐写有关的信息,在现有隐写分析模型的基础上,进一步提升深度学习隐写分析模型的检测能力的目的.

2.1 JPEG图像隐写分析模型的关系

JPEG图像隐写分析参照图像生成模型将待检测图像进行处理和变换,以提升隐写分析模型的检测能力为目的,为针对JPEG图像的深度学习隐写分析模型提供辅助信息.

如图3所示,JPEG图像隐写分析参照图像生成模型与隐写分析模型相互独立,以待检测图像为输入数据.而隐写分析模型的输入数据为待检测图像和JPEG图像隐写分析参照图像生成模型的输出数据.最终检测结果由隐写分析模型输出.

Fig. 3 Relations between the proposed method and steganalysis model图3 本文方法与隐写分析模型的关系

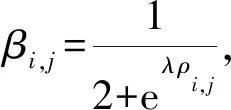

2.2 所提出参照图像生成模型结构

JPEG图像隐写分析参照图像生成模型,由8个卷积层与8个反卷积层(deconvolution)组成,共16层.每个卷积层以及反卷积层的输出依次经过批标准化(BN)和LReLu(leaky ReLu, LReLU)激活函数的处理,分别记为CONV-BN-LReLU和deCONV-BN-LReLU.

本文提出模型的反卷积层又称为转置卷积,记为deCONV.本文模型通过反卷积层实现上采样目的,将经由多个卷积层输出的抽象特征图进行进一步变换,最终得到与输入图像相同大小的参照图像.此外,为抑制梯度消失现象,在模型的卷积层与对称位置的反卷积层之间添加跳转连接(skip connection).

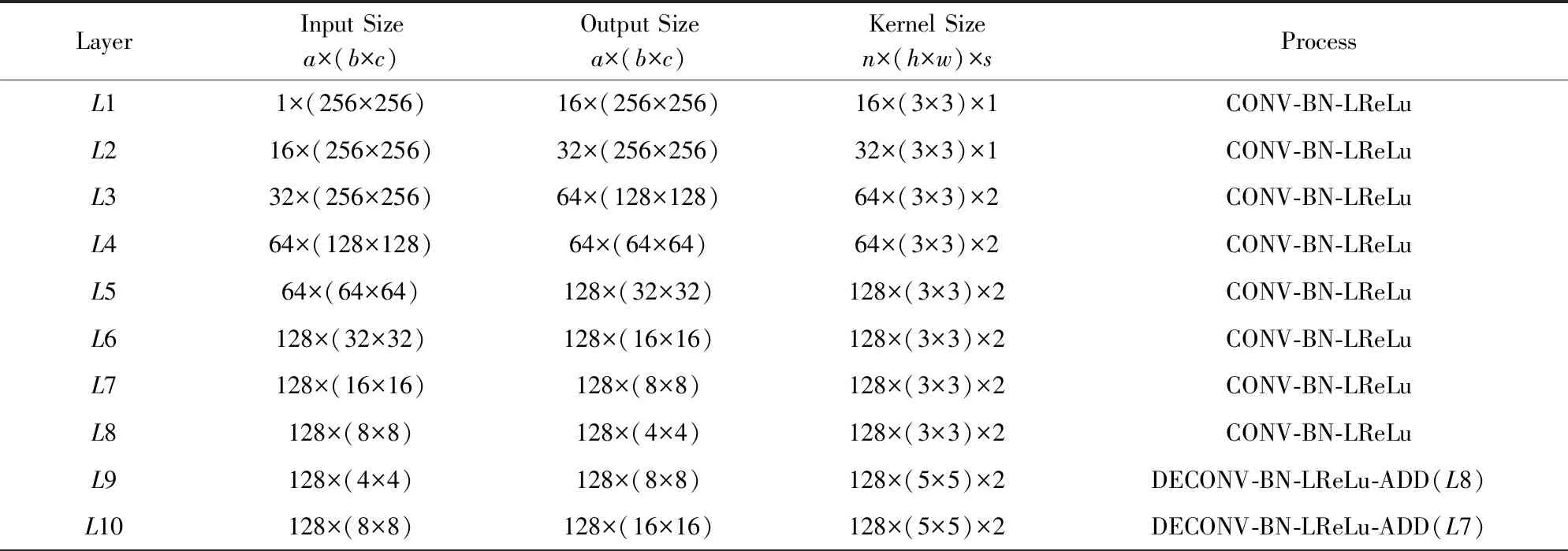

具体网络结构如图4所示,包括2种类型的操作组合:GT1,GT2.网络各层结构的具体参数如表1所示,其中,列2和列3代表对应网络层的输入数据和输出数据尺寸.输入数据和输出数据尺寸参数格式为a×(b×c),a为数据的通道数,b为数据的高度,c为数据的宽度.卷积核尺寸列为对应网络层中卷积核的参数.卷积核的具体参数格式为n×(h×w)×s,n为卷积核的个数,h为卷积核的高度,w为卷积核的宽度,s为卷积操作的步长.Process列表示对应层包含的操作,ADD(·)为按位相加操作,“·”是与当前层相加的网络层标号.

Fig. 4 Structure of reference image generation network for JPEG image deep learning steganalysis model图4 JPEG图像隐写分析参照图像生成模型结构图

Layer Input Sizea×(b×c)Output Sizea×(b×c)Kernel Sizen×(h×w)×sProcessL11×(256×256)16×(256×256)16×(3×3)×1CONV-BN-LReLuL216×(256×256)32×(256×256)32×(3×3)×1CONV-BN-LReLuL332×(256×256)64×(128×128)64×(3×3)×2CONV-BN-LReLuL464×(128×128)64×(64×64)64×(3×3)×2CONV-BN-LReLuL564×(64×64)128×(32×32)128×(3×3)×2CONV-BN-LReLuL6128×(32×32)128×(16×16)128×(3×3)×2CONV-BN-LReLuL7128×(16×16)128×(8×8)128×(3×3)×2CONV-BN-LReLuL8128×(8×8)128×(4×4)128×(3×3)×2CONV-BN-LReLuL9128×(4×4)128×(8×8)128×(5×5)×2DECONV-BN-LReLu-ADD(L8)L10128×(8×8)128×(16×16)128×(5×5)×2DECONV-BN-LReLu-ADD(L7)

Continued (Table 1)

Note:ais the channel of the data,bis the height of the data andcis the width of the data. Besides,nis the number of the convolutional kernel,his the height of the convolutional kernel,wis width of the convolutional kernel andsis the stride for the convolution.

2.3 所提出参照图像生成模型训练方式

本文提出的隐写分析参照图像生成模型可采取2种训练策略:第1种训练策略为预训练策略,记为Pre-training;第2种训练策略为共同训练方式,记为Together.

Fig. 5 Pre-training strategy图5 Pre-training训练策略

第1种训练方式,即预训练方式.首先,对本文所提出参照图像生成模型进行预训练,预训练过程如图5所示.隐写分析参照图像生成模型预训练的损失函数为生成的参照图像与待检测图像对应的cover图像之间的相似程度,该损失函数的计算方法:

φ(I)=I*K,

(9)

φ(R)=R*K,

(10)

(11)

其中,1≤i≤M,1≤j≤N;M,N为图像的宽度和长度;I为待检测图像对应的原始图像;R为本文提出的方法产生的隐写分析参照图像;K是预训练过程中使用的滤波器;φ(I)和φ(R)分别是对I和R进行滤波的结果;φ(I)i,j和φ(R)i,j分别为φ(I)和φ(R)位于(i,j)位置的元素值;LOSS为预训练的损失函数.

首先采用YeNet[24]中所使用的Rich Model[16]中的30个高通滤波器K分别对生成图像R和输入图像所对应的cover图像I进行滤波操作;然后,计算以上2种图像的滤波结果φ(I)和φ(R)之间的均方误差,并将其作为参照图像R与待检测图像对应的cover图像I之间相似程度的度量和预训练的损失函数LOSS.

预训练完成之后,将参照图像生成模型与隐写分析模型相结合,以提升隐写分析任务分类准确率为目标,进行训练.通过对参照图像生成模型进行预训练,保证参照图像与待检测图像所对应的cover图像在残差噪声上尽可能接近.

第2种训练策略,属于1种共同训练方式,如图6所示,将参照图像生成模型与隐写分析模型作为1个整体,以提升隐写分析检测准确率为目标,进行共同训练.

Fig. 6 Together training strategy图6 Together训练策略

2.4 参照图像与隐写分析模型的结合方式

JPEG图像隐写分析参照图像生成模型输出的参照图像将作为深度学习隐写分析模型的辅助信息,与待检测图像一同作为深度学习隐写分析模型的输入,以提升深度学习隐写分析模型的检测能力.

本文所提出方法生成的参照图像可以按照2种方式与隐写分析模型进行结合,如图7所示.

Fig. 7 Reference images input methods图7 参照图像输入方式

第1种结合方式,记为Combine方式,该种方式是将参照图像与对应的待检测图像沿着图像的x轴进行连接(concation)操作,合成结果为1个宽度为待检测待检测图像2倍的矩阵,并将该合成结果作为隐写分析模型的输入.

第2种合结合方式,记为Channel方式,将参照图像和待检测图像沿z轴进行合并.分别作为隐写分析模型的输入数据,在隐写分析模型对2种数据进行相应处理,并将处理的结果进行合并.

3 实验与分析

为验证本文方法有效性,基于JPEG图像隐写分析参照图像生成模型和J-Xune[26],构建隐写分析模型,并与J-Xunet的检测效果进行对比.本文使用Tensorflow深度学习框架实现提出的模型以及对比模型.本论文的数值计算得到了武汉大学超级计算中心的计算支持和帮助.

3.1 数据集合

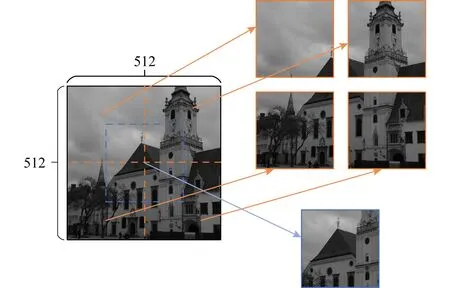

本文实验采用的数据集合来源于BossBase v1.01[33]中的10 000图像.如图8所示,本文在实验中将BossBase v1.01中每张512×512大小的图像从4个对角以及图像的中间部分截取的5张大小为256×256的图像,从而产生50 000张空域图像.之后对50 000张空域图像分别以质量因子为75和95,进行JPEG压缩,得到对应不同质量因子的JPEG图像,作为本文实验中涉及的cover图像.

Fig. 8 Generation of image samples in the experiments图8 实验数据产生方式

本文所涉及的对比实验的训练、验证、测试数据的stego图像由JC-UED[9]和J-UNIWARD[10]和隐写算法分别以相对嵌入率0.1bpnzAC(bits per none zero AC),0.2bpnzAC,0.3bpnzAC,0.4bpnzAC,0.5bpnzAC对50 000张256×256大小的cover图像进行嵌入得到.

对比实验的数据构成如图9所示,将BossBase v1.01中8 000张原始图像对应的40 000张256×256大小的cover图像以及对应的40 000张stego图像,共80 000张图像作为模型的训练数据集合;将BossBase v1.01中与训练测试集合不同的1 000张图像所对应的5 000张256×256大小cover图像以及对应的stego图像,共10 000张图像作为验证数据集合;将BossBase v1.01中其余1 000张图像对应的5 000张256×256大小图像及其对应的stego图像,共10 000张图像作为实验的测试数据集合.

所构建的数据集合保证了本文提出的模型以及对比方法采用相同的训练、验证、测试数据集合,并且训练、验证、测试数据集合的原图像互不重复.

3.2 模型参数设置

本文所提出模型在训练过程中都采用Adam[34]优化算法进行目标函数的优化.其中,学习率初始值为0.001,学习率每5 000次训练衰减为原来的0.9.训练过程中,每个mini-batch包括16对cover和stego图像,即32张图像;每种模型训练的最大训练迭代次数为20万,即80个epoch.

此外,本文实验所涉及的对比算法采用相同参数设置.

Fig. 9 Data sets for the experiments图9 对比实验数据集合构成

3.3 模型训练策略与结合方式的选择

为了确定JPEG图像隐写分析参照图像生成模型的训练策略,以及与深度学习隐写分析模型的结合方式,分别采用Together,Pre-training训练方式以及Combine和Channel结合方式进行包含1种情况的对比实验.

该对比实验中,将本文所提出的隐写分析参照凸显生成模型与J-Xunet[26]隐写分析模型相结合.各种情况下模型的最大训练迭代次数为12.5万次,并选取最后5个epoch的验证结果的平均值作为最终的检测准确率.检测算法为J-UNIWARD[10],相对嵌入率为0.4bpnzAC,JPEG图像载体为质量因子为75.分别采用2种模型结合方式,以及2种不同的训练策略,得到的4种模型在验证数据集合中的检测准确率如表2所示.其中,加粗数据为最高的准确率.模型在验证集合上的准确率在训练过程中的变化情况如图10所示.其中,横坐标为训练的epoch,纵坐标为各个epoch训练完成之后的测试准确率.

Table 2 Detection Accuracy when Different Training Strategies and Combination Ways are Applied

Note: The bold numbers are the best performance in experiments.

Fig. 10 Effect of training strategies and combination ways on verification results图10 训练策略、结合方式对验证结果的影响

实验结果表明:采用Combine方式将参照图像生成模型与隐写分析模型结合,能够获得具有更高检测准确率的模型.当本文方法与J-Xunet隐写分析模型采用Combine方式进行结合,并采用Together训练方式得到的隐写分析模型具有最高的检测准确率.因此,本文对比实验采用Combine方式将参照图像生成模型产生的参照图像与待检测图像结合,并采用Together训练方式进行训练.

3.4 对比实验与结果分析

本文提出的JPEG隐写分析参照图像生成模型与J-Xunet[26]深度学习隐写分析模型结合,从而为针对JPEG图像的深度学习隐写分析模型提供辅助信息,所构成的隐写分析模型记为Reference-J-Xunet.为验证本文提出方法的有效性,利用第3.1节中所构建的隐写分析数据集合,进行Reference-J-Xunet与J-XuNet[26]之间的隐写分析检测能力对比实验.

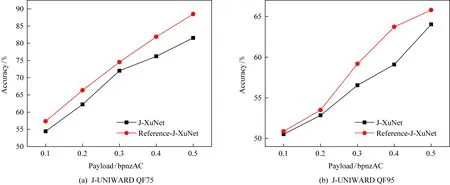

每种深度学习隐写分析模型采用与3.2节中相同的参数设置.每种隐写分析模型训练完成之后,取训练过程中最后5个epoch所保存模型的测试结果的平均值作为最终检测准确率.除此之外,每种隐写分析模型各进行以上3次测试,并取3次测试准确率的平均结果作为最终的测试结果.具体测试结果如图11、图12以及表3所示.其中,图11和图12中的圆点表示本文提出方法针对不同载体质量因子、不同嵌入率,以及不同隐写算法嵌入的样本的隐写分析准确率,而正方形表示J-XuNet相应的隐写分析准确率.表3中,行2数据为待检测样本的相对嵌入率,单位为bpnzAC(bits per non-zero AC DCT coecient).此外,表3中的加粗数据为针对相同算法相同嵌入率情况下最高检测准确率.

Fig. 11 Detection accuracy comparison between J-XuNet and Reference-J-XuNet for J-UNIWARD QF75 and QF95图11 J-XuNet与Reference-J-XuNet对于J-UNIWARD隐写算法的检测准确率对比

Fig. 12 Detection accuracy comparison between J-XuNet and Reference-J-XuNet for JC-UED图12 J-XuNet与Reference-J-XuNet对于JC-UED隐写算法的检测准确率对比

EmbeddingMethodDetecorQF75QF950.10.20.30.40.50.10.20.30.40.5J-UNIWARDReference-J-Xunet57.35266.35774.51281.86788.50850.8853.4959.17663.71865.802J-Xunet54.43862.24672.02676.20581.57250.5252.83856.54459.08964.024JC-UEDReference-J-Xunet76.96686.02490.91692.47295.48656.29664.76272.47877.37881.236J-Xunet72.54482.38887.04490.60494.09655.14662.64465.90475.83876.984

Note: The bold numbers are the best performance in experiments.

在载体质量因子为95时,相对嵌入率为0.1bpnzAC和0.2bpnzAC,隐写算法为J-UNIWARD的情况下,以及载体质量因子为95时,相对嵌入率为0.1bpnzAC,隐写算法为JC-UED的情况下,检测难度较大.为了保证模型在以上情况下的检测效果,本文对比实验采用调优策略进行以上情况下模型的训练.

具体训练过程为:

1) 采用载体质量因子为95,相对嵌入率为0.5bpnzAC的样本,对模型进行训练,共训练80个epoch.

2) 利用当前情况下的样本,继续训练上一步训练过程中得到的模型,即对模型进行调优.调优过程的最大epoch数为80.

在隐写样本的嵌入方法为J-UNIWARD[10]算法、载体图像质量因子为75、隐写样本的相对嵌入率分别为0.1bpnzAC,0.2bpnzAC,0.3bpnzAC,0.4bpnzAC,0.5bpnzAC的情况下,本文提出方法相对于对比方法的隐写分析准确率分别提升了2.914,4.111,2.486,5.662,6.936个百分点.而当载体图像具有较高质量因子,如质量因子为95时,隐写分析难度相对于低质量因子图像更大.因此,实验中载体质量因子为95时,隐写分析准确率相对于载体质量因子为75有所下降.但本文提出方法依然能够提升隐写分析模型的检测能力.在相对嵌入率为0.2bpnzAC,0.3bpnzAC,0.4bpnzAC,0.5bpnzAC的情况下,本文方法的隐写分析准确率相对于对比方法分别提升0.652,2.632,4.629,1.778个百分点.

当隐写样本采用JC-UED[9]算法进行嵌入的情况下,本文提出方法同样能够提升深度学习隐写分析模型的检测能力.当载体图像的质量因子为75且相对嵌入率分别为0.1bpnzAC,0.2bpnzAC,0.3bpnzAC,0.4bpnzAC,0.5bpnzAC的情况下,本文方法隐写分析准确率相对于对比方法分别提升4.422,3.636,3.872,1.868,1.39个百分点.在载体质量因子为95且相对嵌入率分别为0.1bpnzAC,0.2bpnzAC,0.3bpnzAC,0.4bpnzAC,0.5bpnzAC的情况下,本文方法的隐写分析准确率相对于对比方法分别提升1.15,2.118,6.574,1.54,4.252个百分点.

当载体图像质量因子为95、隐写样本相对嵌入率为0.1bpnzAC,隐写算法为J-UNIWARD时,对比试验在模型训练过程中采用了调优策略.虽然本文算法相对于对比方法略有提升,但是本文方法和对比方法的隐写检测准确率均接近50%.

实验结果表明:本文方法能够为基于深度学习的JPEG图像隐写分析模型提供有利于提升检测能力的辅助信息,提升深度学习隐写分析模型的检测能力.但在载体图像具有较高质量因子、较低嵌入率情况下提升效果有待加强.

4 总 结

本文从隐写分析模型辅助信息的角度,探索进一步提升JPEG图像隐写分析模型检测能力的途径.构建了基于卷积神经网络的隐写分析参照图像生成模型为,以更加充分地挖掘待检测图像中与隐写分析有关的信息.本文提出方法对待检测图像进行变换,并与隐写分析模型一同参与训练,保证参照图像生成模型以提升隐写分析检测能力为目标,为隐写分析模型提供辅助信息.对比实验结果表明:本文提出模型,能够为针对JPEG图像的深度学习隐写分析模型提供有助于提升检测能力的辅助信息.但在载体为高质量因子JPEG图像,相对嵌入率较低的情况下,提升效果有待加强.

在未来,将针对隐写分析检测对象的载体属性与深度学习隐写分析模型的特性,对JPEG图像隐写分析参照图像生成模型进行改进与优化,改善本文构建的模型在载体具有高质量因子,相对嵌入率较低情况下的检测能力,探索进一步提升针对JPEG图像的深度学习隐写分析模型检测能力的途径.