基于TBGC的航拍视频车辆检测算法

2019-09-10郭迎春郑婧然于洋

郭迎春 郑婧然 于洋

摘要 针对移动航拍视频中车辆检测准确度低的问题,提出一种基于三邻域点二值梯度轮廓(Three-neighbor-point Binary Gradient Contour,TBGC)特征的航拍车辆检测算法。对相邻帧图像进行SURF(speeded-up robust features)特征点提取匹配,利用角度判别剔除错误匹配点完成图像配准,采用帧间差分获得运动目标的候选区域。由于传统二值梯度轮廓(Binary Gradient Contours,BGC)特征忽略中心像素特性,提出基于3×3邻域相邻像素点量化操作的TBGC特征。提取候选区域的TBGC特征,并利用支持向量机(Support Vector Machine, SVM)完成最终的航拍视频车辆检测。实验中利用提出的TBGC特征在8个数据集上分别与BGC1、LBP、HOG特征进行对比实验,实验结果表明TBGC算法的检测率明显优于传统经典算法,平均检测率为93.09%,并且具有较好的鲁棒性。

关 键 词 航拍视频;车辆检测;支持向量机;TBGC特征

中图分类号 TP391.41 文献标志码 A

Abstract To improve the vehicle detection precision in aerial video, a vehicle detection method for aerial video is proposed based on three-neighbor-point binary gradient contour (TBGC) features. First, the extraction of speed-up robust features (SURF) was extracted and matched for adjacent frame images, and error-matching points were eliminated by angle discrimination to realize image registration. Then, the candidate regions of the moving target were obtained according to the frame difference. Since the traditional binary gradient contour (BGC) features ignore the pixel characteristics at the center, the TBGC features based on the comparison of adjacent pixel points in a 3 × 3 neighborhood were proposed. In this way, the TBGC features in candidate regions were extracted, and support vector machine (SVM) was used to complete the vehicle detection in aerial video at last. In the experiment, the proposed TBGC features were compared with features of BGC1, LBP, and HOG on eight datasets respectively. Experimental results show that the detection rate of TBGC algorithm is obviously better than the traditional classical algorithms, with an average detection rate of 93.09% and stronger robustness.

Key words aerial video; vehicle detection; support vector machine; TBGC features

0 引言

现今无人机航拍技术已经应用到交通运输、工业、农业、军事等各个领域中,进行交通管控、环境保护、灾后救援、军事侦查等,并在相关领域中发挥着重要的作用。与传统的地面监控视频相比,无人机航拍视频具有监控范围大、使用方便灵活,能够更好地检测快速移动目标等优势,因此,针对航拍视频的目标检测研究已经逐渐成为计算机视觉领域的一个研究热点[1]。 然而对于车辆检测问题,由于航拍视频覆盖场景面积较大、关键目标较小、背景复杂,且目标车辆易受光照变化、遮挡、相机抖动以及姿态变化等因素影响[2],因此航拍视频中的车辆检测仍然是一个具有挑战性的课题。

近年来国内外的相关研究已经取得了一定的成果,大体上可以分为基于特征的方法和基于深度学习的方法。在基于特征的方法中,方向梯度直方图(Histogram of Oriented Gradient,HOG)是最为有效的特征之一。Xu等[3]通过道路方向旋转图像,将HOG与支持向量机(Support Vector Machine,SVM)结合可以实现快速且高精度的目标检测,并采用自适应交换策略提高检测效率,但是无法检测到转弯处的车辆。Madhogaria等 [4]利用HOG+SVM检测目标,并结合马尔科夫随机场删除虚假目标,与其他方法相比,显著降低了误报率,但是因训练图像的尺寸固定,需要手动设置参数,灵活性较差。文献[5]增加了纹理和颜色信息,并结合改进HOG特征作为特征描述符,检测的准确率进一步提高,但是用时长,计算量大。由于HOG特征不具有旋转不变性,Liu等[6]在原有经典HOG特征的基础上,提出具有旋转不变性的Fourier-HOG特征。Kamenetsky等[7]将该特征用于航拍图像,取得显著的效果。但是Fourier-HOG胞元只能描述局部区域信息,当对一个较大区域进行描述时,需要计算该区域的区域描述符,特征维数较大,算法效率较差。文献[8]采用光照不变特征减少Fourier-HOG特征的提取区域,从而减少运行时间,但是算法的时間复杂度依然很高。与HOG特征相比,由于尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)特征能够检测到部分被阴影或树木遮挡的车辆,因此该特征也是航拍车辆检测常用的特征之一。Moranduzzo等[9]考虑到特征的尺度不变性和旋转不变性,利用SIFT关键点进行像素点检测,通过SVM对SIFT关键点分类得到车辆的关键点集,该方法主要降低了虚警率,但是关键点的分类精度不够。同时,文献[10]通过基于地理信息系统的筛选评估方法,进一步降低了虚警率,但是仍有部分车辆的漏检。此外,HOG空间金字塔(Spatial Pyramid of HoG,PHOG )特征[11]、Haar-like特征[12]、快速旋转不变特征[13]、旋转不变矩阵(Rotation-Invariant Matrix,RIM)[14]以及结合方向梯度角[15]和径向梯度方向特征的序数金字塔编码方法[16]也被应用到航拍车辆检测中。

深度学习目前也广泛用于航拍车辆检测领域,但是检测效果无法达到基于特征的方法[17]。Chen等[18]针对深层卷积神经网络(DNN)只能提取同一尺寸特征的缺陷,提出混合的深层卷积神经网络,通过将最后一个卷积层和DNN的最大池化层的映射划分为多个可变接收域来提取可变尺寸特征。该方法在卫星图像上获得了显著的效果。文献[17]利用卷积神经网络提取特征并结合SVM分类进行目标检测。该方法在准确性和计算时间上都优于现有的方法。但只是找到了车辆的位置区域,并没有精确地检测到每辆车,并且误检率较高。Deng等[19]提出了一个精确车辆推荐网络,可以检测出航拍图像中的车辆,并利用车辆属性学习网络获得车辆的位置信息。该方法相比于其他的方法鲁棒性更好,准确性更高,但是不适用于车辆高度集中的区域,具有局限性。

无论是基于特征的方法还是基于深度学习的方法,算法本质都是用特征来表征目标。文献[20]对局部二值模式(Local Binary Patterns,LBP)和二值梯度轮廓(Binary Gradient Contours,BGC)特征做了3组对比实验,实验表明BGC特征具有更好的目标表述能力以及旋转平移不变性。考虑到航拍视频中目标车辆由于摄像机的拍摄角度以及姿态变化,具有比较复杂的形态,本文以BGC特征为基础,对BGC的第1种模式BGC1进行改进,提出基于三邻域点二值梯度轮廓(Three-neighbor-point Binary Gradient Contour,TBGC)特征的航拍车辆检测算法,首先针对航拍视频序列进行图像配准,利用帧间差分得到车辆候选区域,最终使用TBGC特征结合SVM完成精确的车辆检测。

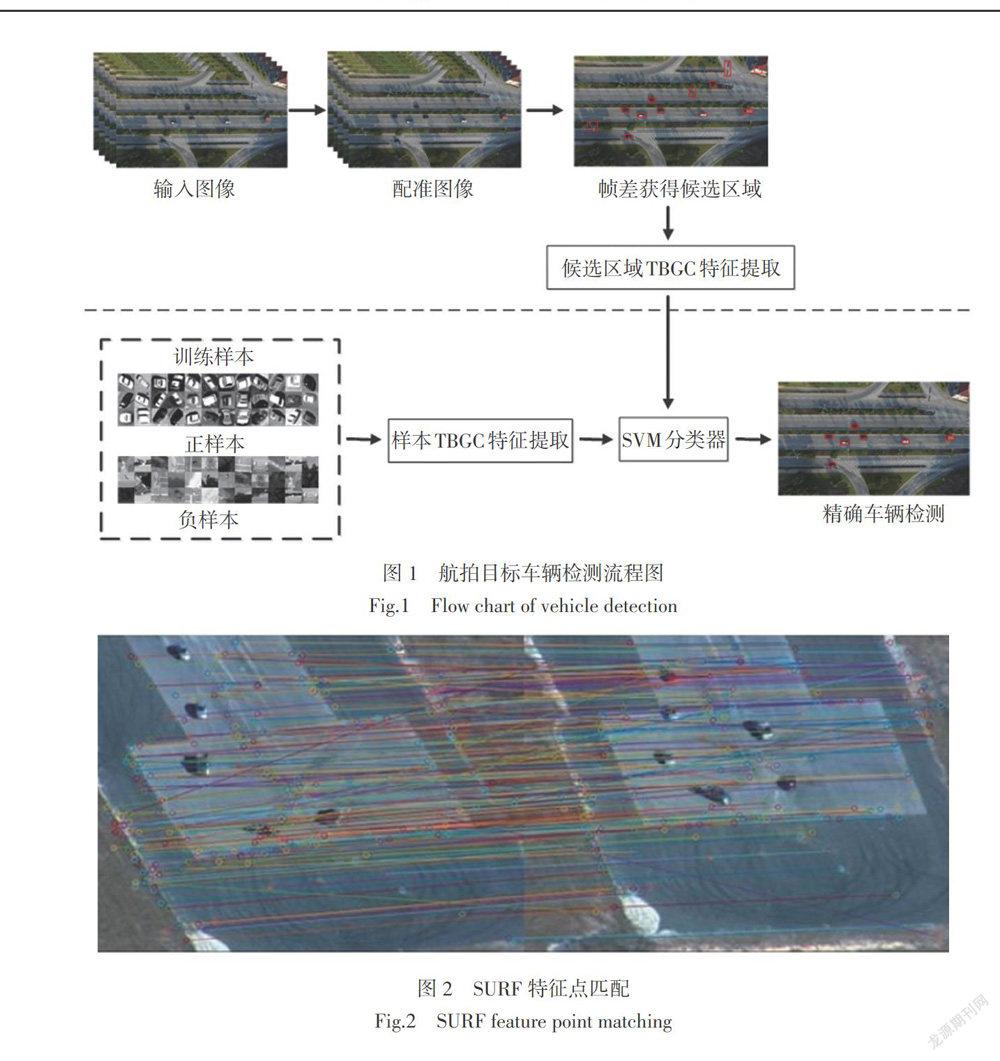

1 总体架构

本文采用的无人机采集的航拍视频序列,由于视频中存在相对运动,所以首先进行基于SURF(Speeded- Up Robust Features)特征点[21]的图像配准,使得相邻帧在同一图像坐标系下;然后利用帧间差分法获得运动目标候选区域;最后对运动目标候选区域进行TBGC特征提取,利用SVM对特征分类提取的先验模型进行目标分类,进而得到精确的检测结果。图1是整体车辆检测的流程图。

2 航拍目标车辆检测

2.1 图像配准

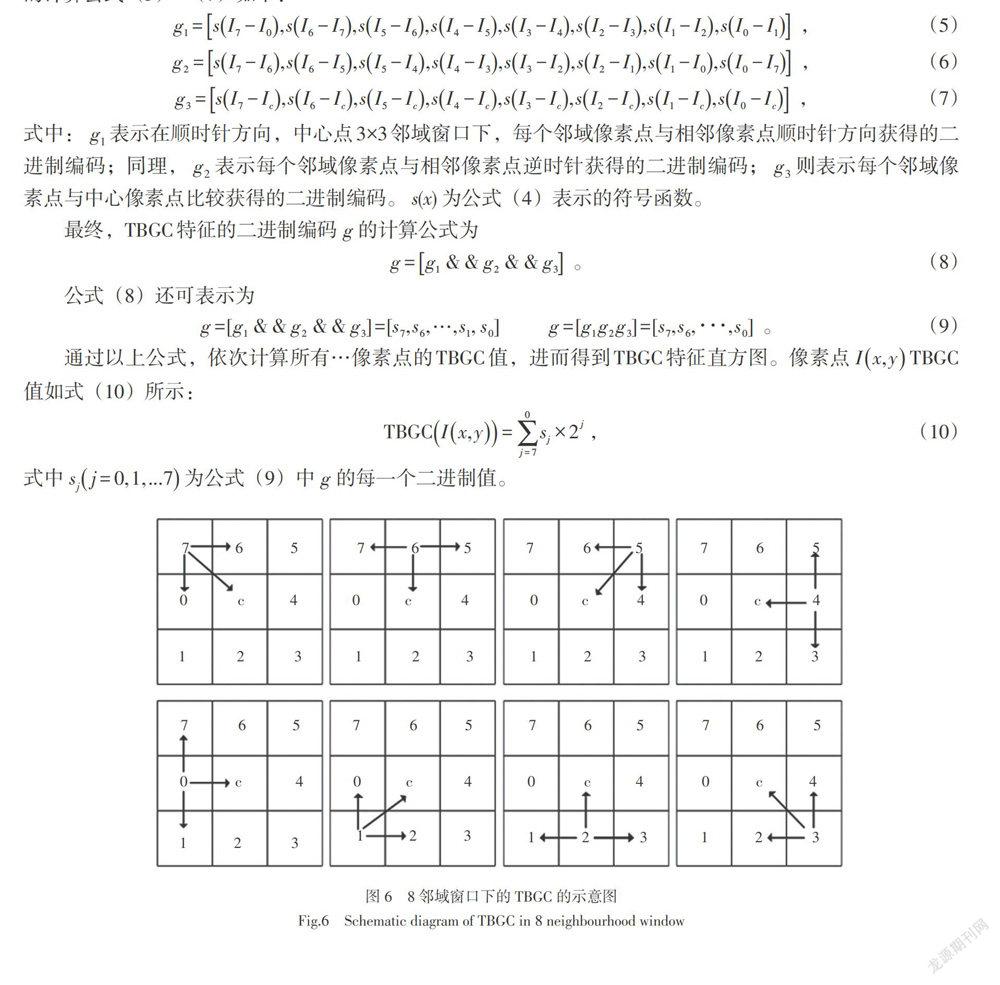

对于视频序列[Ijj=1,...,n]的相邻两帧图像[Ij]和[Ij+1],分别提取SURF特征点,得到两帧图像的特征点集A和B,对特征点集A和B进行匹配,最后再利用随机采样一致算法(Random Sample Consensus, RANSAC)[22]剔除错误的匹配点对。匹配结果如图2所示。

图2是经过RANSAC算法之后的匹配效果图,仍然存在错误的匹配点对。考虑到航拍序列的特点,相邻帧图像之间存在的是平移和旋转的微小运动,所以一对匹配点可以计算出一个角度,所有特征点对之间的角度差异会很小,因此本文采用基于角度判定的策略剔除错误匹配点。匹配点间的角度计算公式为

计算所有匹配点对间的角度集合[C=θ1,θ2,...,θm],升序排序得到集合[D=θ′1,θ′2,...,θ′m],取集合D的前1/4角度值计算平均角度值[θ],其中,前1/4角度值是经过实验具有最好处理效果的取值,最后根据式(2)计算[Ti]。

[Ti]为每个角度对应的特征点对正确与否的判断函数,其中[i]表示每一对特征点。如果[Ti]为1,说明是匹配正确的特征点对,反之,则为匹配错误的特征点对,并剔除。图3为特征点剔除后匹配结果。

剔除错误的匹配点对后,采用双三次插值进行仿射变换,得到配准图。在图像配准之后,本文采用帧间差分的方法获得候选目标运动区域,图4为帧间差分检测结果,从中可以看出仍存在很多非车辆区域,即误检区域。为了进一步完成目标车辆区域精确检测,采用基于特征训练的分类方法。第一步首先对训练集的正负样本提取TBGC特征,然后通过SVM对样本进行训练获得TBGC特征的分类模型。第二步是对帧差后获得的目标候选区域进行识别,对目标候选区域提取TBGC特征,依据第一步得到的分类模型得到精确的检测结果。

2.2 BGC特征

二值梯度轮廓(Binary Gradient Contours,BGC)由Fernández等提出。基于预先定义的路径,使用来自3×3邻域的顺时针方向选择的成对像素值比较,得到3×3邻域中心像素点的二进制描述符,表示该像素点的BGC值。BGC的编码路径不同,则其计算方式也不同。Fernández等提出了3种不同的路径,单回路二值梯度轮廓(BGC1),双回路二值梯度轮廓(BGC2),三回路二值梯度轮廓(BGC3),图5是3种路径的表述方式。

2.3 TBGC特征

根据Antonio Fernández等[20]的实验效果可知,BGC1比BGC2和BGC3的纹理描述能力更强,但是由于BGC1的编码方式过于简单,易受到噪声的影响,所以本文对BGC1进行了改进,使其能够更好地描述目标的纹理特征。

BGC1特征是根据3×3邻域窗口内顺时针方向的邻域像素点之间关系编码得到的,由于只考慮到了邻域像素点之间关系而忽略了中心像素点的影响,而中心像素点又是一个很重要的点,往往比周围的点包含更多的信息,所以本文提出加入中心像素点以及3×3邻域窗口内逆时针方向的邻域像素点之间关系的TBGC特征,使得提取的纹理信息更加丰富,增加了对噪声的鲁棒性,有更好的鉴别能力。图6是TBGC算法示意图。

图6中,首先以第一个3×3窗口的像素点[I7]为例,[I7]分别与[I0],[Ic],[I6]相邻的3个像素点进行像素值的大小比较。其像素路径编号[0,7,6,5,4,3,2,1,0],计算二值梯度轮廓的像素对为[0,7,c,7,6,7,7,6,c,6,5,6,...,1,0,c,0,7,0],其中c代表的是中心像素点,称为TBGC。具体的计算公式(5)~(7)如下:

[g1=sI7-I0,sI6-I7,sI5-I6,sI4-I5,sI3-I4,sI2-I3,sI1-I2,sI0-I1] , (5)

[g2=sI7-I6,sI6-I5,sI5-I4,sI4-I3,sI3-I2,sI2-I1,sI1-I0,sI0-I7] , (6)

[g3=sI7-Ic,sI6-Ic,sI5-Ic,sI4-Ic,sI3-Ic,sI2-Ic,sI1-Ic,sI0-Ic] , (7)

式中:[g1]表示在顺时针方向,中心点3×3邻域窗口下,每个邻域像素点与相邻像素点顺时针方向获得的二进制编码;同理,[g2]表示每个邻域像素点与相邻像素点逆时针获得的二进制编码;[g3]则表示每个邻域像素点与中心像素点比较获得的二进制编码。[s(x)]为公式(4)表示的符号函数。

最终,TBGC特征的二进制编码[g]的计算公式为

[g=g1 & & g2 & & g3] 。 (8)

公式(8)还可表示为

[g=[g1 & & g2 & & g3]=[s7,s6,…,s1, s0]] [g=[g1g2g3]=[s7,s6,∙∙∙,s0]] 。 (9)

通过以上公式,依次计算所有…像素点的TBGC值,进而得到TBGC特征直方圖。像素点[Ix,y]TBGC值如式(10)所示:

[TBGCIx,y=j=70sj×2j], (10)

式中[sjj=0,1,...7]为公式(9)中[g]的每一个二进制值。

在此基础上,利用目标车辆的正负样本结合TBGC特征训练分类模型,并利用建立好的模型对帧间差分得到的候选运动区域进行二次筛选,得到最终的车辆检测结果,实际的检测结果在实验中说明。

3 实验结果及分析

本文的实验数据集分别是公共数据集VIVID的数据集Egtest01-Egtest05、公共数据集KIT AIS中的MunichCrossroad01以及自建的两个视频序列DJI_0006和Video2。其中,Egtest01-Egtest02背景简单,且无人机运动缓慢;Egtest03背景与运动目标的颜色和纹理相近;Egtest04的分辨率较低;Egtest05背景复杂,光照变化明显;MunichCrossroad01背景复杂,视频中出现树木和光照变化;Video2的背景复杂,但摄像机运动缓慢,背景变化较小;DJI_0006的特点是背景复杂且无人机运动较快,背景运动明显。图7是不同数据集示意图。

利用不同的数据集,本文从图像配准、车辆识别以及视频车辆检测三个方面进行详细的实验并分析。首先将本文方法与经典的RANSAC算法进行对比,说明图像配准算法的有效性。实验中利用本文提出的TBGC特征分别与传统BGC1特征和经典特征进行比较,进一步说明提出算法的优势。最后,将本文提出的TBGC特征应用到航拍视频序列中,与最新的算法进行对比,说明本文算法的有效性。

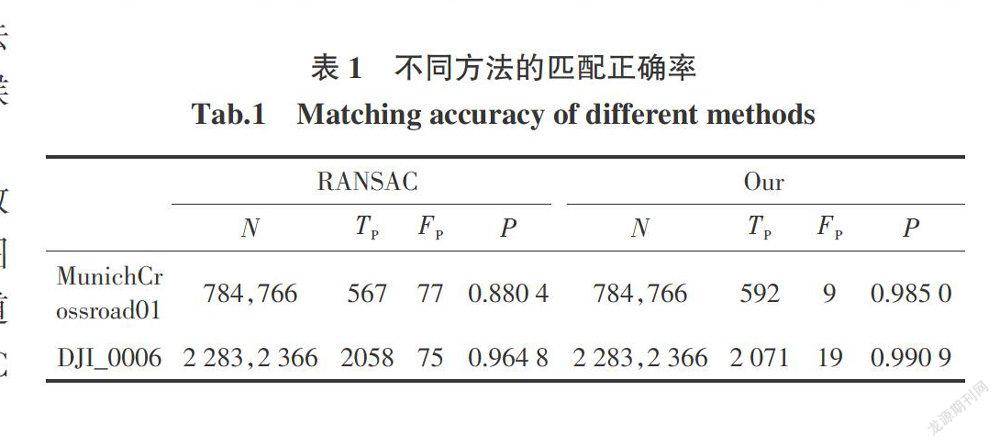

3.1 图像配准

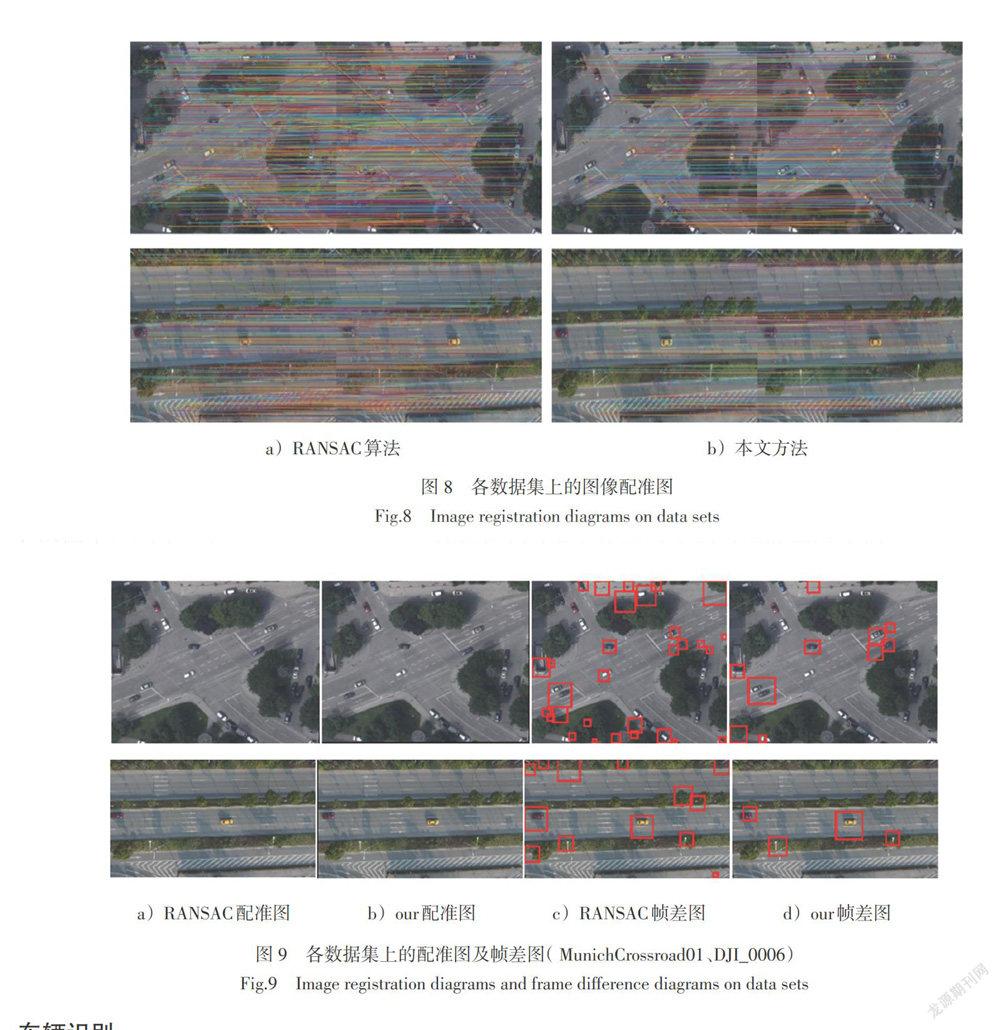

图像配准实验分别在背景变化剧烈的MunichCrossroad01和DJI_0006数据集上进行测试,表1是2个数据库图像配准的实验结果。表中,N代表两帧图像的特征点数目,[TP]代表匹配正确的特征点对数,[FP]代表匹配错误的特征点对数,P代表匹配正确率[P=TP/TP+FP]。由表1的数据可以看出,本文提出的判定角度剔除外点策略在两个数据集上测试的特征点的匹配正确率分别为0.985 0和0.990 9,明显高于基于RANSAC的0.880 4和0.964 8。图8是分别在MunichCrossroad01、DJI_0006两个数据集上的匹配结果。

从两组图中可以看出,基于RANSAC的特征点匹配效果图中,明显存在角度值偏差较大的错误特征点对,而基于本文方法的匹配效果图则可以看出,由于加入角度判定处理,处理结果中并不存在如RANSAC算法中的角度偏差大的匹配点对,因此相对效果更好。图9是分别在MunichCrossroad01、DJI_0006两个数据集上的基于RANSAC算法和基于本文方法的背景补偿图,以及帧间差分获得的车辆候选区域。

在MunichCrossroad01、DJI_0006两个数据集上的配准图9a)、b)可以看出,在图9a)中右下角以及图9b)左侧边界中间车道的车辆区域,本文的算法比传统的RANSAC算法的补偿效果好;并从两个数据集的帧差图9c)、d)可以明显地看出,本文算法实现的帧差效果显著地减少了误检率。其中,在MunichCrossroad01数据集中其他未标注的车辆均是静止的车辆。

3.2 车辆识别

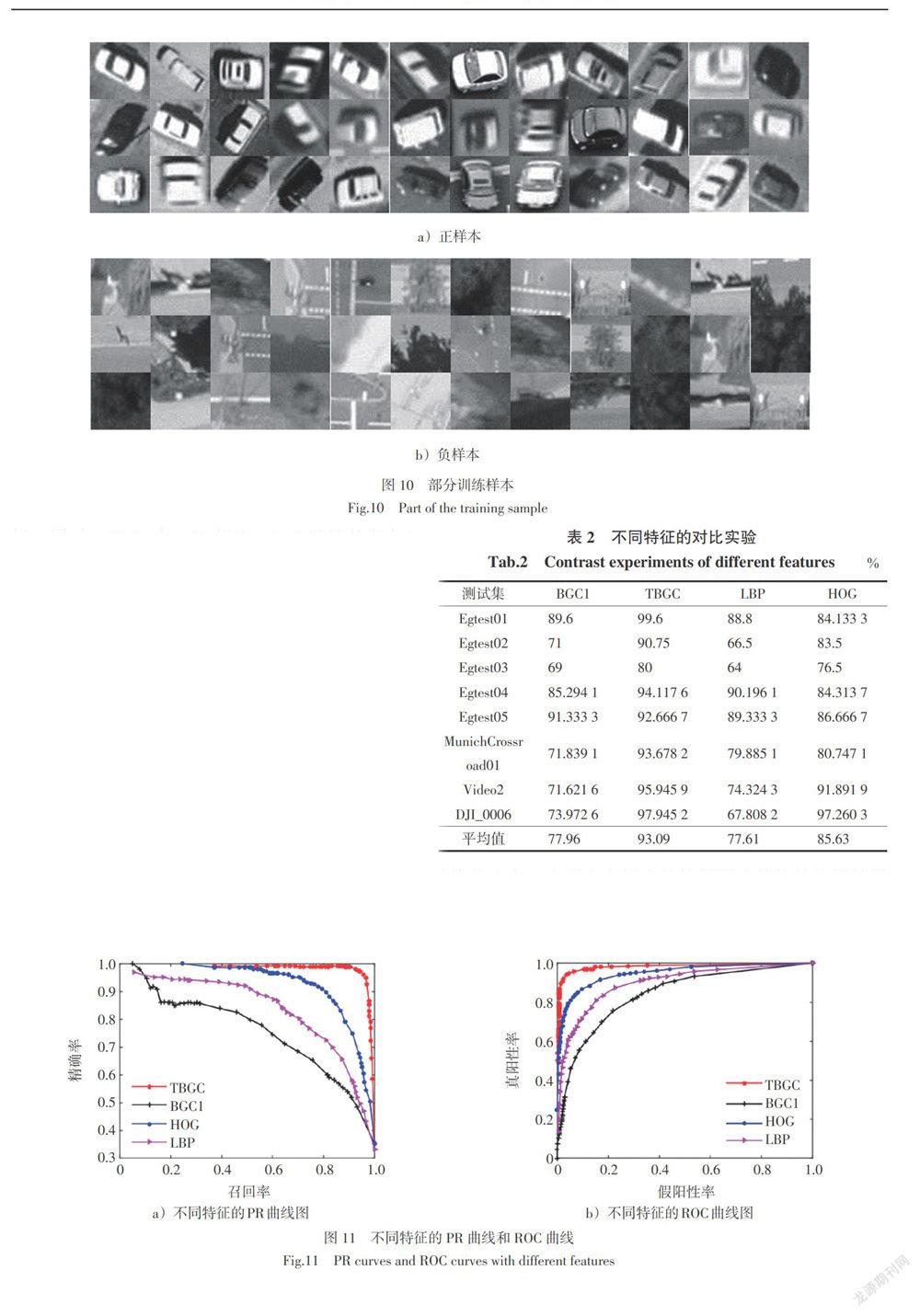

本文的训练数据从不同航拍数据集上随机得到的,包含有不同背景和不同方向车辆的图像为正样本,不包含车辆的图像为负样本,部分样本如图10所示。提取样本的TBGC特征,然后利用SVM训练分类,最后利用测试集验证特征的有效性。由于数据集是航拍视频序列,所以本文的测试集是分别从以上8个视频序列上截取获得的。

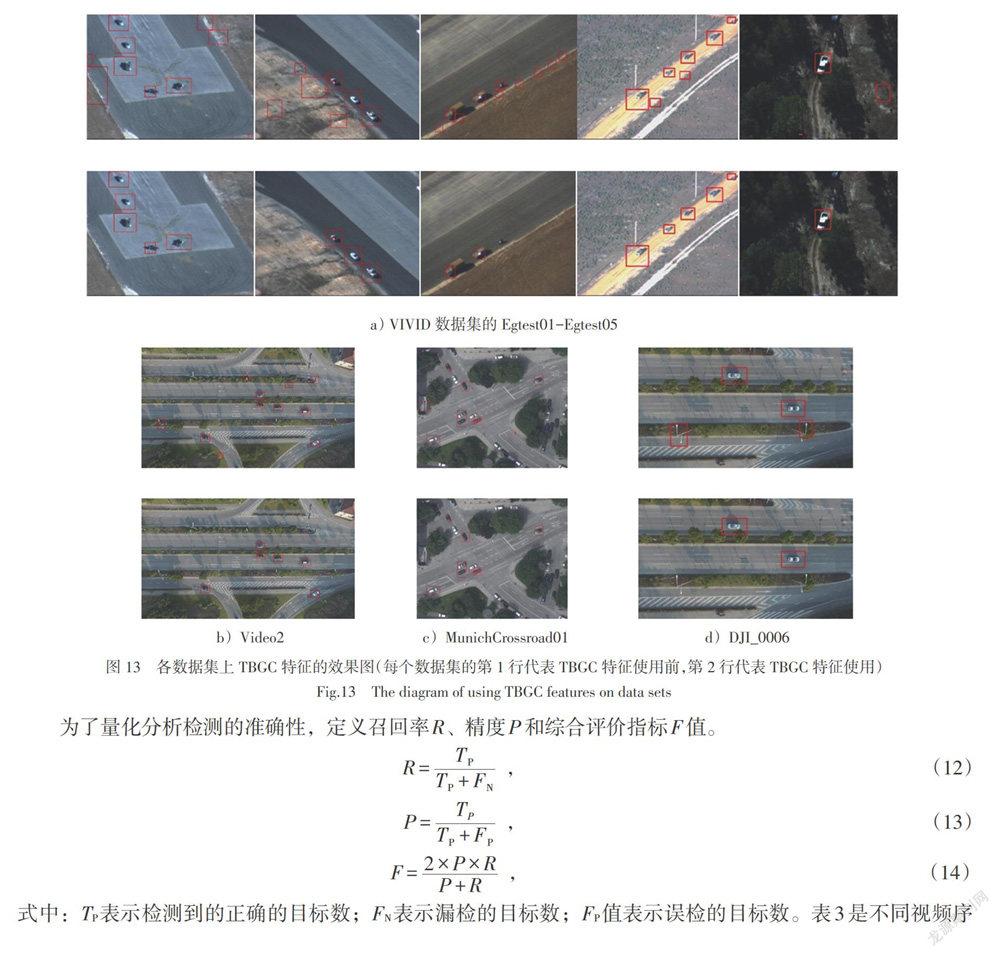

为了验证本文提出TBGC特征的有效性,与BGC1、LBP、HOG特征进行对比实验,实验结果如表2所示。

在实验中,训练集样本数为5 156个,测试集Egtest01- Egtest05样本数均为500,Munich Crossroad01样本数为348,Video2和DJI_0006的样本数分别为74、146。正负样本比例为1∶1。

表2可以明显看出,本文提出的TBGC相对于原特征BGC1,在不同的测试集下准确率有了显著提高,除了Egtest03外均达到的90%以上。在Egtest03数据集上,由于目标车辆与背景的像素差较小,且与训练的正样本的车型差别较大,所以相对效果较差,识别率较低;在Egtest01数据集上由于背景单一,所以准确率达到了99.6%,在复杂背景或具有不同姿态和光照的车辆的其他数据集上,本文提出的特征也平均达到了94%以上,提高了近10%到20%。TBGC特征较原BGC1特征充分考虑到邻域像素点周围的像素点以及中心像素点对邻域像素点的量化的影响,使得TBGC特征可以提取更丰富的纹理信息,鲁棒性更强,效果更好。同时,TBGC与LBP相比,LBP只是考虑中心像素点与邻域像素点的关系进行量化,同上,不如TBGC考虑的充分。与HOG相比,由于航拍序列环境复杂多变,而HOG描述子对噪点相当敏感,且航拍车辆的姿态多变,所以通过HOG特征得到的形状信息不定,而TBGC侧重于纹理信息,因此,效果更好。

为了更好地看出实验的有效性,本文画出相应了PR曲线和ROC曲线,如图11所示。

图11a)为不同特征的PR曲线图,从图中可以看出本文提出的TBGC特征在相同的召回率的情况下,检测精度P比BGC1、LBP和HOG的精度高,明显代表本文特征的红色线位于代表其他特征的线的上方,表明本文提出的特征要比其他的特征效果好。图11b)是不同特征的ROC曲线,从图中可以看出,代表本文特征的红线相比于代表其他特征的线要更靠近于纵轴,更位于图的上方,所以,可以明显地看出红线下方的面积值会更大,即AUC值更大。因此,相对于BGC1、LBP和HOG特征,本文提出的特征TBGC的效果更好。

图12为车辆误识别即未检出的情况示意。如图12a)、b)分别是图像模糊且具有阴影导致车辆与背景间的像素差特别小,进而车辆的纹理特征不明显;车辆在图像中所占的比例太小。以上两种情况均导致了车辆的误识别。

3.3 视频车辆检测

在航拍序列上进行图像配准后,首先利用帧间差分法获得目标候选区域,然后提取该区域的TBGC特征,将其输入到训练好的模型当中,最后根据分类器的分类标签判断出目标候选区域是车辆还是非车辆。本文将在VIVID数据集的Egtest01-Egtest05、MunichCrossroad01、Video2和DJI_0006視频序列上进行实验。

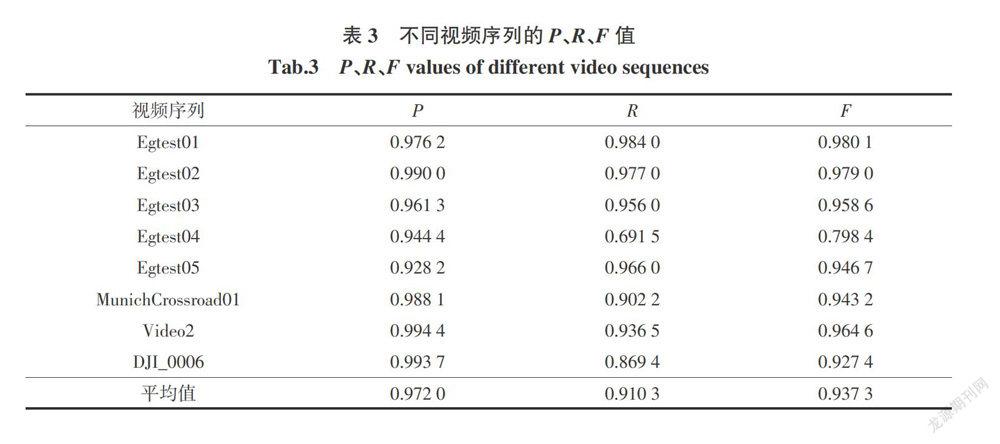

图13是8个数据集上的实验效果图,可以看出基于TBGC特征的车辆识别,明显减少了帧差带来的误检,其中,在MunichCrossroad01数据集中其他未标注的车辆均是静止的车辆。

为了量化分析检测的准确性,定义召回率R、精度P和综合评价指标F值。

式中:TP表示检测到的正确的目标数;FN表示漏检的目标数;FP值表示误检的目标数。表3是不同视频序列的P、R、F值。

从表3中看出,不同视频序列都表现出良好的实验效果。VIVID数据集上目标运动相对缓慢,且图像分辨率低,所以P值、R值和F值相对居中;其中,Egtest04数据集由于分辨率低,帧差出现漏检,所以在整体的实验效果上相对较差;Video2数据集的背景复杂,但是因为其背景运动特别小,误差小且能够更好地得到运动目标区域,所以效果会比VIVID数据集的效果好一点;MunichCrossroad01和DJI_0006属于背景复杂,背景运动明显的视频序列,F值分别达到了0.943 2和0.927 4。

从本文的实验效果中可以得知,在目标与背景颜色特别接近时,由于纹理差别太小,本文提出的TBGC特征无法识别出目标;在目标进出视频时,车辆过于不完整时,会出现漏检;同时帧间差分方法当目标候选区域是背景区域且与训练时的车辆纹理特别接近时,会出现误检的情况。

4 总结

本文针对航拍车辆检测准确率低的情况,提出基于TBGC特征的帧间差分航拍车辆检测算法。TBGC特征充分考虑3×3邻域窗口内顺时针和逆时针方向的邻域像素点以及中心像素点对中心像素点量化的影响,使得提取的纹理信息更加丰富,增加了对于噪声的鲁棒性,具有更好的鉴别能力,通过实验证明了本文提出方法的有效性。但是在实际的测试中,对于纹理不明显的车辆,TBGC特征会失效,同时帧间差分法对于与背景颜色相近的颜色车辆会漏检,针对这两个问题,本文将进行进一步研究。

参考文献:

[1] KUMAR R. Aerial video survelliance and exploitation[M]//Video-Based Surveillance Systems. Springer, Boston, MA, 2002: 29-38.

[2] 刘亚伟,李小民. 无人机航拍视频中目标检测和跟踪方法综述[J]. 飞航导弹,2016(9):53-56,70.

[3] XU Y Z,YU G Z,WANG Y P,et al. A hybrid vehicle detection method based on viola-jones and HOG + SVM from UAV images[J]. Sensors,2016,16(8):1325.

[4] MADHOGARIA S,BAGGENSTOSS P,SCHIKORA M,et al. Car detection by fusion of HOG and causal MRF[J]. IEEE Transactions on Aerospace and Electronic Systems,2015,51(1):575-590.

[5] CHEN Z Y,WANG C,LUO H,et al. Vehicle detection in high-resolution aerial images based on fast sparse representation classification and multiorder feature[J]. IEEE Transactions on Intelligent Transportation Systems,2016,17(8):2296-2309.

[6] LIU K,SKIBBE H,SCHMIDT T,et al. Rotation-invariant HOG descriptors using fourier analysis in polar and spherical coordinates[J]. International Journal of Computer Vision,2014,106(3):342-364.

[7] MORANDUZZO T,MELGANI F. Detecting cars in UAV images with a catalog-based approach[J]. IEEE Transactions on Geoscience and Remote Sensing,2014,52(10):6356-6367.

[8] 毛征,刘松松,张辉,等. 不同光照和姿态下的航拍车辆检测方法[J]. 北京工业大学学报,2016,42(7):982-988.

[9] MORANDUZZO T,MELGANI F. A SIFT-SVM method for detecting cars in UAV images[C]//2012 IEEE Iternational Geoscience and Remote Sensing Symposium,22-27 July 2012,Munich,Germany,2012:6868-6871.

[10] MORANDUZZO T,MELGANI F. Automatic car counting method for unmanned aerial vehicle images[J]. IEEE Transactions on Geoscience and Remote Sensing,2014,52(3):1635-1647.

[11] POOSTCHI M,PALANIAPPAN K,SEETHARAMAN G. Spatial pyramid context-aware moving vehicle detection and tracking in urban aerial imagery[C]//2017 14th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS),29 Aug. -1 Sept. 2017,Lecce,Italy,2017:1-6.

[12] XU Y Z,YU G Z,WU X K,et al. An enhanced viola-jones vehicle detection method from unmanned aerial vehicles imagery[J]. IEEE Transactions on Intelligent Transportation Systems,2017,18(7):1845-1856.

[13] MALAGI V P, BABU D R R. Rotation-invariant fast feature based image registration for motion compensation in aerial image sequences[C]//Proceedings of International Conference on Cognition and Recognition. Springer, Singapore, 2018: 211-221.

[14] WANG G L,WANG X C,FAN B,et al. Feature extraction by rotation-invariant matrix representation for object detection in aerial image[J]. IEEE Geoscience andRemote Sensing Letters,2017,14(6):851-855.

[15] LIN Y D,HE H J,YIN Z K,et al. Rotation-invariant object detection in remote sensing images based on radial-gradient angle[J]. IEEE Geoscience and Remote Sensing Letters,2015,12(4):746-750.

[16] WANG G L,FAN B,ZHOU Z L,et al. Ordinal pyramid coding for rotation invariant feature extraction[J]. Neurocomputing,2017,242:150-160.

[17] AMMOUR N,ALHICHRI H,BAZI Y,et al. Deep learning approach for car detection in UAV imagery[J]. Remote Sensing,2017,9(4):312.

[18] CHEN X Y,XIANG S M,LIU C L,et al. Vehicle detection in satellite images by hybrid deep convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters,2014,11(10):1797-1801.

[19] DENG Z P,SUN H,ZHOU S L,et al. Toward fast and accurate vehicle detection in aerial images using coupled region-based convolutional neural networks[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing,2017,10(8):3652-3664.

[20] FERNÁNDEZ A,ÁLVAREZ M X,Bianconi F. Image classification with binary gradient contours[J]. Optics and Lasers in Engineering,2011,49(9/10):1177-1184.

[21] BAY H,ESS A TUYTELAARS T,et al Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding,2008,110(3):346-359.

[22] CHUM O, MATAS J, KITTLER J. Locally optimized RANSAC[C]//Joint Pattern Recognition Symposium. Springer, Berlin, Heidelberg, 2003: 236-243.

[責任编辑 田 丰]