Trans-NER:一种迁移学习支持下的中文命名实体识别模型

2019-08-13王银瑞彭敦陆

王银瑞,彭敦陆,陈 章,刘 丛

(上海理工大学光电信息与计算机工程学院,上海200093)

E-mail:wyinrui@sina.com

1 引言

随着互联网技术和信息产业的快速发展,新闻、教育、医疗等等不同领域每时每刻都在产生大量的文本数据.面对这些海量文本数据,如何准确高效地进行信息抽取和数据挖掘成为学术界和工业界关注的热点问题,作为其中的主要技术的命名实体识别技术也受到研究者们的高度重视.

命名实体识别(Named entity recognition,NER)技术旨在从文本数据中自动地发现信息实体以及识别它们对应的类别[1],它是自然语言处理研究领域的核心任务之一.高效且准确地识别出文本中包含的实体信息,对于计算机处理文本数据具有重要意义.在自然语言处理研究领域,信息检索、知识图谱、问答系统等多项高层任务均需要命名实体识别任务作为其基础构件.命名实体的识别效率及准确度将影响到后续任务,因此,对其进行深入研究具有重要价值.

研究者们已对中文命名实体识别任务进行了广泛而深入的研究:从早期基于词典和规则的方法,到传统机器学习的方法,到近年来基于深度学习的方法,研究成果在学术界和工业界得到了广泛认可.机器学习和深度学习的方法通常需要大量标注数据以构建效果良好的模型.然而,某些领域由于其领域特殊性,标注数据获取成本高或数量规模较小,这种情况下以上方法表现不佳.例如,在医疗领域,由于医学知识的专业性,只能由专业人士对医疗文本进行数据标注工作,这增加了标注数据获取的成本[2].因此,如何在较小规模数据上获得较好的识别效果成为了亟待解决的问题.

近年来,迁移学习(Transfer Learning)已经在学界引起了广泛的关注与研究.迁移学习是利用已获取的知识对相关领域的不同问题进行求解的一种新机器学习方法,其目的是迁移已有的知识来解决目标领域中仅有少量甚至没有标注数据的学习问题[3].迁移学习已逐步被学者们应用在了深度学习领域,以解决数据集规模较小的问题.词嵌入的研究与广泛应用即是迁移学习应用在自然语言处理领域的实例.

本文试图将迁移学习技术引入中文NER模型以解决上述问题.利用大规模语料库训练语言预测模型,并在此基础上提出基于上下文特征的字符级向量生成算法,通过该算法将语言预测模型蕴含的知识迁移至实体识别模型.实验结果显示,本文提出的模型相比其他模型具有较好的识别效果.

2 相关工作

2.1 命名实体识别

NER一直是自然语言处理领域中的研究热点,从早期基于词典和规则的方法,到传统机器学习的方法,到近年来基于深度学习的方法都不断有研究成果发表.

最近的基于人工神经网络的英文命名实体识别方法取得了优良的效果.文献[4]较早地提出了使用神经网络来实现命名实体识别任务,在他们的工作中提出了窗口方法与句子方法两种网络结构来对文本进行处理.文献[5]在2016年的工作提出了一种循环神经网络(Recurrent neural network,RNN)结合条件随机场(Conditional Random Field,CRF)[6]的网络结构.实验结果表明,RNN-CRF结构在命名实体识别任务中获得了更好的效果,已经超过了基于丰富特征的CRF模型,成为目前基于深度学习的NER方法中的较为主流模型.文献[7]于2016年的工作中在RNN-CRF网络结构的基础上使用了卷积神经网络(Convolutional Neural Network,CNN)来生成英文字符向量.

中文领域的命名实体识别研究也取得了显著成果.文献[8]在2003年的工作中提出了将统计方法与知识库进行结合的方法进行命名实体识别.文献[9]提出综合多种特征进行实体识别任务,这些任务包括语法特征、词性特征等.本文提出的中文实体识别模型相比上述研究,具有两个不同特征:1)模型的输入文本序列基于中文字符级向量表示;2)采用门控循环单元(Gated Recurrent Unit,GRU)构造双向循环神经网络.字符级向量表示方法移除了模型对于分词预处理过程的依赖,避免了分词错误传播和信息缺失使识别准确率降低的弊端.GRU循环神经网络和长短期记忆网络(Long Short-Term Memory,LSTM)相比,不仅具有相似的实验效果,还具有更简单的结构,更容易进行训练[10].

2.2 迁移学习

在面对某一领域的具体问题时,通常可能无法得到构建模型所需规模的数据,而同一领域中的不同任务往往具有共同点.某一领域任务中模型训练的成果往往可以应用在同一领域不同问题的模型中,这种技术叫做迁移学习.文献[11]在2010年的工作中对迁移学习做出了阐述:迁移学习旨在利用学习自源数据集的一些知识在目标数据集上执行任务.借助迁移学习技术,可以将已经利用大量容易获得的数据集进行过训练的模型应用在同一领域的不同任务上,例如将其中可以重用的层直接利用在新模型中,从而使在新任务的模型中所需的参数数量减少和规模减小.或者直接利用源模型的输入作为其他任务模型的输入.新模型可以利用迁移学习源模型中蕴含的信息,从而可以更专注于特定问题的建模.

在过去的几年中,研究者们对如何将迁移学习应用在人工神经网络模型中做出了大量的研究工作.迁移学习在自然语言处理领域也有大量的研究.词嵌入的研究即应用了迁移学习的思想,训练良好的词嵌入可以应用在多种自然语言处理任务中.文献[12]在2016年工作中着重研究了利用了迁移学习的用于句子分类的卷积神经网络.文献[13]提出一种半监督混合模型,应用于序列标注问题,该模型同时利用了未标注数据和标注数据训练模型,体现了迁移学习的思想.

本文提出一种中文命名实体识别领域的迁移学习模型,Trans-NER模型.该模型包括一个源模型、一个目的模型及一种迁移方法.本文在第3节介绍了所构建的源模型与提出的迁移方法,在第4节介绍Trans-NER模型的整体架构与设置.

3 基于上下文特征的字符级向量生成算法

如何构建源模型与如何迁移源模型蕴含的知识是迁移学习的两个重要问题.本文构建语言预测模型作为源模型,提出基于上下文特征的字符级向量生成算法进行知识迁移.

3.1 语言预测模型

目前词向量(或词嵌入、字向量)已广泛应用在NLP深度学习任务中,经良好训练的词向量可以在一定程度上表达词义,并且可以通过向量计算来比较两个词的词义差别.然而词向量仅用一个向量来表示一个词的特点,使其无法表达多重意义,即无法解决“一词多义”的问题.语言预测模型可以综合语境输出词的上下文特征信息,利用这一点弥补基础词向量的缺陷.

本文将语言预测模型构建为关于输入中文文本序列T的概率分布P(T),理想情况下,P(T)表示句子T是一个合理的中文句子的概率.在现实场景下,由于语料库规模与质量的有限性,P(T)实际代表了句子T出现在语料库中的似然.当语料库的规模足够大,并且语料库的质量可以满足问题的需求时,语言预测模型即可较好地拟合出符合中文语言规律的概率分布P(T).

图1 语言预测模型结构Fig.1 Structure of language prediction model

图1 展示了语言预测模型结构简图,可以分为3个部分:循环神经网络层、concatenate层和全连接层.下面依次对每个部分做出详述,同时介绍整个模型的计算流程.

3.1.1 循环神经网络层

该层包括两个LSTM网络.前向LSTM网络用于顺序处理文本序列,后向LSTM用于逆序处理文本序列,以分别提取序列的以前及未来的信息.需要注意的是,这两个LSTM网络具有相同的结构及节点数目配置,但在训练过程中具有不同参数,相互独立.

通过前后两个方向的LSTM网络,模型可以获得句子序列的完整信息,从而估计出输入序列(t1,t2,…,tN)的联合概率分布:

3.1.2 concatenate 层

该层的功能为连接两个循环网络层输出的向量.对于输入序列(t1,t2,…,tN),每一个字符对应一个向量表示 xi,将输入序列映射为向量表示序列X=(x1,x2,…,xN).令下标i表示字符在序列中的位置,hi表示双向LSTM网络输出的隐藏层值,则hi由前向LSTM的隐藏层值和后向LSTM的隐藏层值连接组成,以同时利用序列以前的信息和未来的信息来对当前位置i的字符做出预测.

3.1.3 全连接层

该部分将对循环神经网络部分提取出的上下文特征进行分类与整合计算,并经过tanh激活函数将其映射到字符级向量空间.使用公式表达如下:

3.1.4 损失函数

语言预测模型训练的目标为最大化模型输出正确预测的概率.直接计算该概率较为困难,可以通过最大化模型真实输出与模型期望输出xi的余弦相似度间接地达到目的.余弦相似度的计算公式为:

设置该模型的损失函数为模型真实输出与模型期望输出余弦相似度的相反数,公式表达如下:

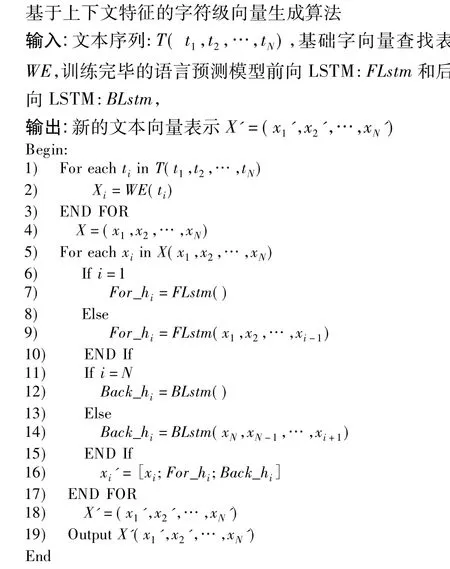

3.2 基于上下文特征的字符级向量生成算法

如何将源模型的知识迁移至目的模型是迁移学习理论中的一个关键问题.考虑到自然语言处理领域任务都需要对文本进行向量化处理的共性,本文提出基于上下文特征的字符级向量生成算法,利用该算法抽取出文本序列中包含的上下文特征信息,算法描述如图2所示.

算法需要的输入为待处理文本序列、基础字向量查找表WE及训练完毕的语言预测模型.这里使用的基础字向量查找表WE与语言预测模型中的保持一致.为了叙述的简便,将语言预测模型的两个LSTM网络的计算过程分别抽象为两个函数:FLstm()与BLstm().首先,对输入文本序列的每一个字符进行基础字向量查表操作,将输入文本序列转换为基础字向量序列(第1-4行),此时的字向量序列并不包含上下文特征信息.然后,算法利用语言预测模型的LSTM网络部分计算每一个字符的上下文特征信息,具体过程如下:对于该字符的前置序列,使用前向LSTM计算隐藏层值输出For_hi(第6-10行);对该字符的后置序列,使用后向LSTM计算隐藏层值输出Back_hi(第11-15行).然后将基础字向量和前向LSTM隐藏层值向量、后向LSTM隐藏层至向量进行连接操作,形成新的向量表示(第16行),最后,输出文本基于上下文特征信息的向量表示序列(第18-19行).

图2 字符级向量生成算法Fig.2 A character level vector generation algorithm

输入文本序列T(t1,t2,…,tN),其基础向量化表示为X=(x1,x2,…,xN).经算法处理后文本序列的新向量序列表示为:

该新字向量序列表示将作为输入应用在实体识别任务中.

4 Trans-NER中文命名实体识别模型

图3 Trans-NER模型结构Fig.3 Structure of Trans-NER model

图3 展示了Trans-NER模型结构图.不同于其他实体识别算法或模型,Trans-NER模型接受整个文本序列作为输入,经过第一层算法的处理,得到每个字符基于上下文特征信息的新字向量.然后将新字向量序列输入双向GRU网络,提取每个字符的实体特征.随后,利用全连接层将所提取到的特征映射为字符是否为实体单元的概率,最后利用CRF层输出识别结果.下面的部分将对该模型的计算过程与设置做出描述.

4.1 提取文本上下文特征

借助本文所提的算法的优势,Trans-NER模型可以充分的提取出每个字符的上下文特征信息,同时字符级的向量表示方法使得模型不需要分词的预处理过程.传统的中文实体识别模型依赖于分词过程,需要分词器对输入进行预处理,这就导致分词中出现的错误会传播至实体识别模型,影响识别效果.本文提出的模型的输入为整个序列,因此避免了该弊端.

无不良反应组患者的PT、TT、APTT及Fib分别为(20.15±0.86)s、(27.93±1.64)s、(41.19±2.08)s、(4.25±0.81)g/L;其PLT、HCT、Hb及RBC分别为(139.85±10.42)×109/L、(0.13±0.06)、(82.09±7.01)g/L、(2.62±1.38)×109/L。

以文本序列T(t1,t2,…,tN)作为输入,其基础的向量化表示为X=(x1,x2,…,xN).利用算法处理后得到字符级向量表示 X'=(x1',x2',…,xN').作为下一层的输入.

4.2 提取实体特征

模型使用双向多层GRU网络提取实体特征.GRU相比LSTM具有更简单的结构,利于计算和训练;同时保持了LSTM一样的效果,解决了传统RNN网络中出现的长期依赖问题.在每层网络之间,加入Relu非线性激活函数,增强模型的拟合效果.模型中全连接层将输出每个字符为实体单元的概率.公式表达为:函数GRU()表示双向GRU网络的计算过程,函数Dense()表示全连接层的计算过程.P为输出的概率分数矩阵,其尺寸为N*K,N为序列的长度,K为实体标签集的大小.则Pi,j表示序列中第i个字符的标签为第j个标签的概率分数.

4.3 相邻标签依赖关系

Trans-NER模型将对每个字符标注出其对应的实体识别标签,以输出实体标签序列.由于自然语言的规律,在标签序列中,相邻的标签之间存在一定的依赖关系,以BIOES标注规则为例,B-LOC标签后不可能出现I-PER标签,而有较大可能出现I-LOC.因而对待标注字符所在的序列综合考虑以作出标注,相比仅考虑单个字符会有更好的效果.本文使用了一个线性条件随机场层对这种依赖关系建模,以解决序列中字符标注结果影响相邻字符标注结果的问题.

定义矩阵Z为状态转移矩阵,Zi,j表示已知当前字符标注为i时,下一个字符标注为j的概率分数大小.定义Y=(y1,y2,…,yN)为对应输入序列的一个可能输出标签序列,结合其概率分数矩阵P与状态转移矩阵Z进行评分:

其中y0和yN+1是句子起始和结束标识符.然后进行全局概率归一化计算,计算出Y对应的概率.

其中YX'是对应输入序列X的所有可能标注序列的集合.在训练过程中,使用反向传播调整模型中的参数,以最大化模型输出正确标注序列的概率.而在利用模型进行实体识别时,选取分数最高的标注序列作为模型的输出:

5 实验

5.1 实验数据与评价指标

本文采用的基础字向量为100维字向量.采用的实验数据为中国法律文书网1http://wenshu.court.gov.cn/上的大量公开法律文书,利用这些文档构建语言预测模型训练集与NER数据集.数据集的统计信息如表1所示.NER数据集使用IOB标注模式(Inside,Outside,Beginning)进行标注,其中包括3种实体类型,人名、地名和组织名(PER,LOC,ORG),共 7 种标签('O','B-ORG','I-ORG','BPER','I-PER','B-LOC','I-LOC').

表1 数据集Table 1 Dataset

论文采用正确率P(%)、召回率R(%)及F值(%)评价模型的识别效果.计算公式如下:

5.2 实验设置与结果分析

在实验中,本文首先将Trans-NER模型与其他方法或模型进行对比,以验证迁移学习的有效性.随后,通过一系列对比实验研究不同因素对迁移学习效果的影响.

5.2.1 实验1.Trans-NER与其他模型的比较

本文选取了几种效果较好且较为流行的实体识别模型与Trans-NER模型进行对比.这些模型包括CRF、层叠马尔科夫模型、LSTM-CRF与GRU-CRF.实验结果见表2.实验结果显示,Trans-NER模型在不同实验指标上均超过了其他模型.这说明在实体识别模型中应用迁移学习技术,提高了模型的识别效果.在接下来的实验中,本文使用GRU-CRF模型作为基准模型进行对比实验.

表2 实验1结果Table 2 Result of experiment 1

5.2.2 实验2.评估Trans-NER在不同规模数据集上的效果

数据集是依据不同的比例从表1的NER数据集中进行不放回随机采样生成.实验结果见图4.本实验在不同大小的NER数据集上训练Trans-NER模型与基准模型,并对两种模型的表现进行测试.不同大小的NER根据实验结果,在不同的NER数据集规模上Trans-NER表现均优于基准模型.随数据集的增大,不论是基准模型还是迁移学习模型结果均有明显的提高.这说明了数据集大小在神经网络训练中的重要性.同时,在40%至60%大小的数据集上,Trans-NER模型也明显优于基准模型,表明在仅有少量数据的情况下,迁移学习技术也可以提升实体识别模型的表现.

图4 实验2结果对比Fig.4 Result contrast diagram of experiment 2

图5 实验4结果Fig.5 Result of experiment 4

表3 实验3结果Table 3 Result of experiment 3

5.2.3 实验3.评估源模型训练集大小对Trans-NER影响

该实验分别在不同规模的语料库上训练语言预测模型,并训练出相应的Trans-NER模型,分别命名.例 如,100%-Trans-NER表示该模型的语言预测模型由100%的语料库训练而成.实验结果见表3.

实验结果表3显示,相比基准模型,60%-Trans-NER、80%-Trans-NER 和100%-Trans-NER 的 F 值(%)提升分别为 0.39、0.98、1.95.可以得出源模型训练集大小对迁移效果的影响:更大的源模型训练集可以训练出质量良好的预训练模型,从而得到更好的迁移效果.而20%-Trans-NER与40%-Trans-NER的F值(%)相比基准模型分别降低了1.71、0.84.利用过小的语料库训练的源模型不仅不能提升实体识别模型的表现,反而降低了其识别效果.

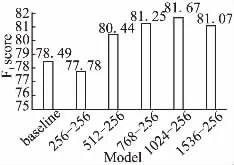

5.2.4 实验4.评估源模型LSTM 网络节点个数对Trans-NER影响

该实验训练了4种不同LSTM网络节点数量配置的语言预测模型,并分别训练相应的Trans-NER模型.256-256表示对应该Trans-NER模型的语言预测模型的LSTM网络节点配置为第1层256个节点,第2层256个,以此类推.F值比较实验结果见图5.

实验结果图5显示,更大的源模型LSTM网络节点数量带来了更好的识别效果,512-256、768-256和1024-256相比基准模型均有提升,同时1024-256的配置取得了最好的效果.然而更多的节点也会导致模型可能出现过拟合,同时训练成本也会增加.同时注意到在256-256的节点数量配置下,Trans-NER模型相比基准模型F值(%)下降了0.71,这说明在迁移学习中,迁移学习源模型的质量对迁移学习的效果有重要影响.

综上,多组实验结果显示本文提出的迁移学习模型Trans-NER在不同规模的数据集上均表现较好.同时试验结果说明迁移学习源模型的质量对迁移学习的效果有重要影响.由此可见,将迁移学习应用在中文命名实体识别领域是可行的.

6 结论

本文将迁移学习应用于自然语言处理领域的中文命名实体识别系统中,借助迁移学习的优势,利用了大量非结构化文本训练得到的语言预测模型的学习成果,在一定程度上解决了实体识别任务在数据集不足的情况下表现不佳的问题.通过实验证明该方法对于命名实体识别领域具有有效性,同时无需人工定义的特征,可以在相对较少的标注语料成本上获得效果的提升.在未来的研究工作中,本文提出的在自然语言处理领域的迁移学习思想可以尝试利用在其他自然语言处理任务中,尤其是缺乏大量标注数据的任务中,研究其对于效果的影响.