基于深度强化学习的图像修复算法设计

2019-07-29崔小洛栾晓飞

崔小洛 栾晓飞

摘 要:日前,图像修复技术已经越来越成熟,出现了各种机器学习算法来填充图片中缺失信息区域的纹理和结构。文中将图像修复过程转化为一个离散的强化学习问题,并设计了一种基于深度强化学习的可以渐进填充缺失区域图像的算法,通过图像修复算法设计出一套修复策略,使得整个修复过程更贴近人类的工作效果。

关键词:图像修复;机器学习;深度强化学习;大数据;自相似;关联性

中图分类号:TP39 文献标识码:A 文章编号:2095-1302(2019)06-00-03

0 引 言

大數据时代,人们对图像信息的需求越来越多,同时也越来越注重图像信息的质量。通常由于图像数据采集设备或传输设备的不足,图像数据往往伴随着大量噪声。由于图像储存设备技术存在瑕疵,导致图像可能出现数据丢失等问题。去除图像中存在的噪声,还原图像中缺失的部分被称为图像修复。目前,图像修复技术被广泛用于遥感、天文、军事以及民用领域[1],作用不可忽视。随着图像数据的海量增长,如何使用快速稳定的算法进行图像修复已成为业界研究的重点。

通常我们把图像修复目标定义为在已有图像上覆盖一部分区域Ω,在该部分区域中的每一个像素点输入像素值,由此凸显了恢复和修改图像或视频工作的重要性。但这也是使用图像修复来理解不同图像模型有效性的结果。从图像模型结构入手,现有的图像修复技术可以分为如下3大类[2]:

(1)当图像中有大量重复片段时就可以使用自相似理论。假设给定一个像素的空间邻域亮度值的概率分布独立于图像其余部分,则该纹理被建模,之后利用近邻划窗,当检测到符合之前纹理特征的Ω时,便进行机械化填充,填充的像素点值会受填充起止数值的影响。

(2)在填充区域Ω时,考虑图像色区空间的相似性,在保证填充区域与图像全局空间分布基本一致的前提下进行图像修复,通过使用纹理合成技术以提高色块填充的精确程度。

(3)第三种则是基于微分方程(PDE)来观察图像纹理的扩散规律,建模与空间信息相关的变分模型指导图像修复工作。这类算法在处理分段图像和较小Ω时,效果显著。

但此类算法都基于人工寻找相应的特征来挑选填充色素。近年来,随着深度学习技术的兴起,通过监督训练神经网络来减小算法生成图像与原图像之间的差异,以替代人工特征选择,效果明显[3-4]。图像的重复信息、空间信息、纹理特征都可以在黑箱中被更好地囊括,甚至可以通过发掘深度学习算法得到更好的深层特征来指导图像修复工作。生成对抗网络[5]等先进的深度学习算法都在图像修复的问题上取得了极好的成果。然而这类算法的生成图像规律通过训练求得,无法学习到一个完整的图像修复过程,只是单纯的端到端学习。

本文基于覆盖区域Ω与图像其他完整部分纹理之间存在的关联性图像修复理论基础,考虑构建一种基于深度强化学习的渐进过程的图像修补方法,通过迭代运算方法,让图像修补过程成为一个策略学习过程,智能体可以在每一步修补过程中进行新的修补路径规划。

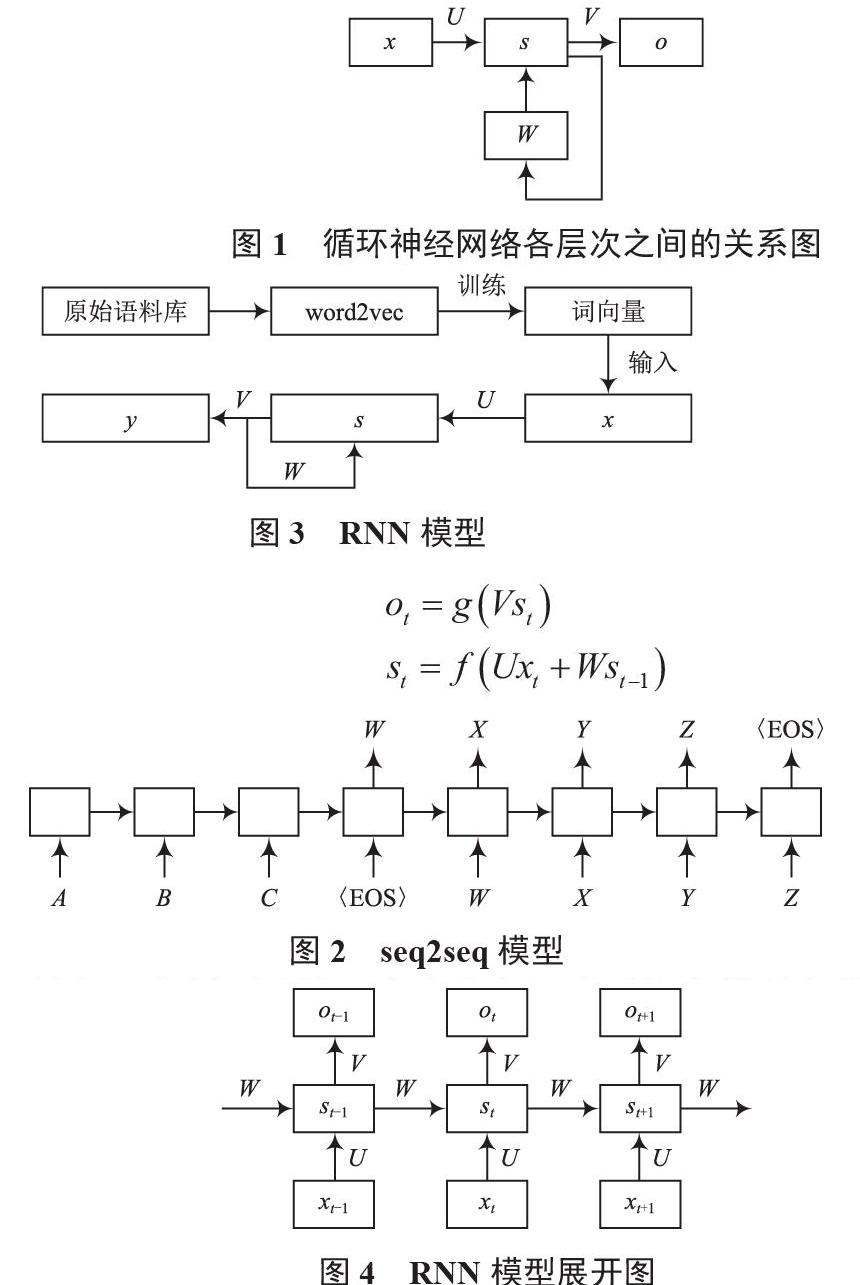

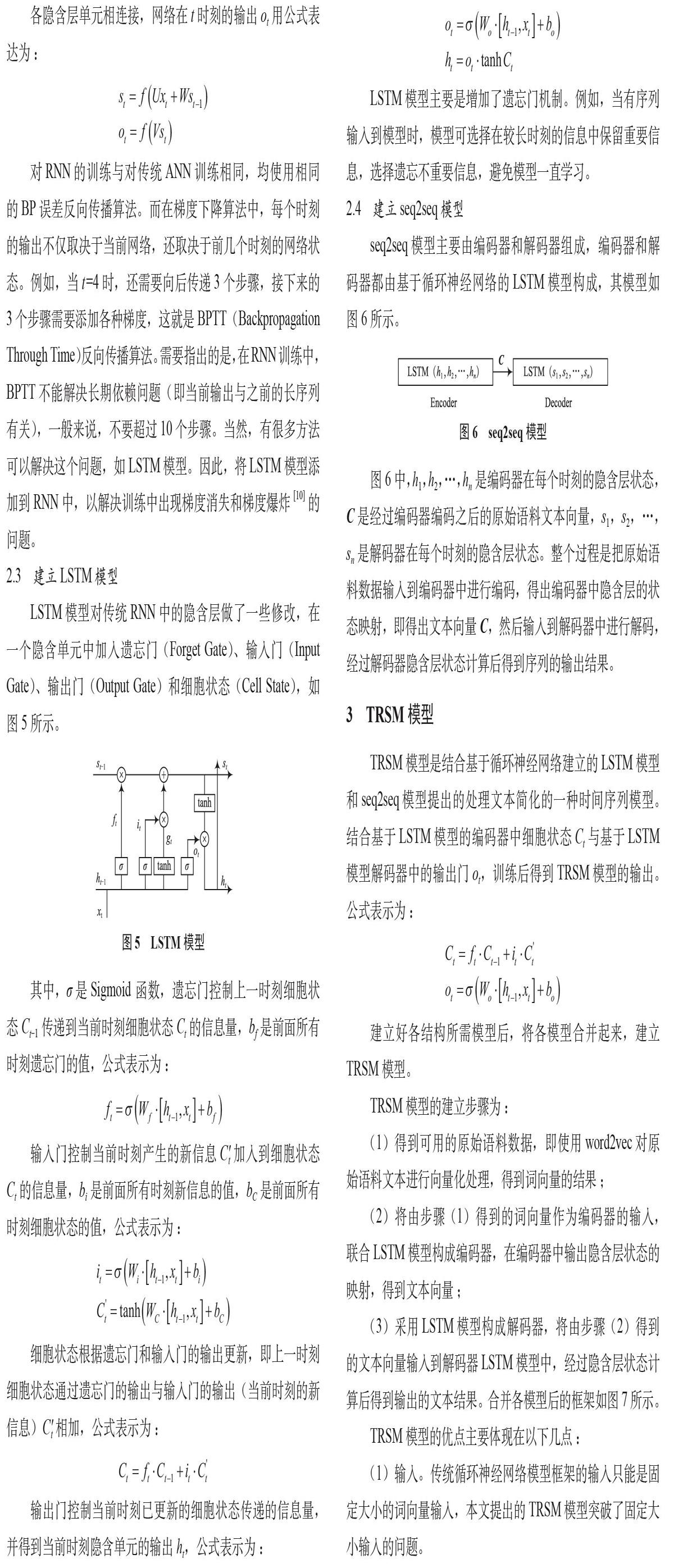

1 相关算法

1.1 强化学习

强化学习是机器学习中的一个重要分支,强化学习智能体的训练基于其自身在环境中的探索,而非人为提供的训练样本[6]。环境返回的回报信息使得智能体可以不断优化策略,强化学习算法的目标就是最大化折扣回报,即:

式中0≤γ≤1为折扣因子。当智能体处于状态St时,根据策略π来选择一个动作at,Q学习算法是强化学习算法的一种,智能体根据环境中的状态St+1,返还一个回报值rt。可以将Q学习算法表达为:

式中α为算法的学习率。此算法在强化学习的过程中,被证明可以收敛得到最优的值函数。

1.2 深度强化学习DQN更新公式:

2015年Deep mind将Double-Q算法引入深度强化学习的策略迭代过程:

2016年Deep mind提出了DDPG。不同于之前的Double-DQN,DDPG将动作选择从值函数网络的学习任务中脱离出来,利用ac框架,将动作选择算法由贪心算法转换为输入为值函数的期望和,输出为动作值,损失函数为最大化动作回报的神经网络。actor网络更新梯度为:

Critic网络更新梯度为:

在更新两网络参数时,使用以τ为参数的迭代式:

Double-DQN概率引入前第n步的值函数来求取最大值,减小了由最大值函数引起的算法系统误差。DDPG的网络更新则是对多个之前的网络进行加权,以保证计算网络更新梯度中所用的值函数为之前所有值函数的数学期望,削弱负向的更新向量对网络更新的影响。

1.3 图像差异

为了衡量两个图像之间的差异,文中使用kl散度作为衡量两个图像之间相似度的方法。定义kl距离为:

2 算法思路

算法思路:将图像修复工作转化为一个强化学习任务,且赋予其相应的数据处理能力。

学习目标:智能体处理图像,改变图像像素点的颜色,使得最终生成的图像与目标图像之间的差异逐渐变小。

当且仅当上述不等式取等且均等于0时,则认为完成了学习任务。由此,我们可以定义强化学习回报公式:

当且仅当两者相等时有最大的回报。由于智能体将一直在环境中进行修改图像的探索,所以二者之间总有差值,最后会在最优解上下波动,得到最优策略。动作值见表1所列。

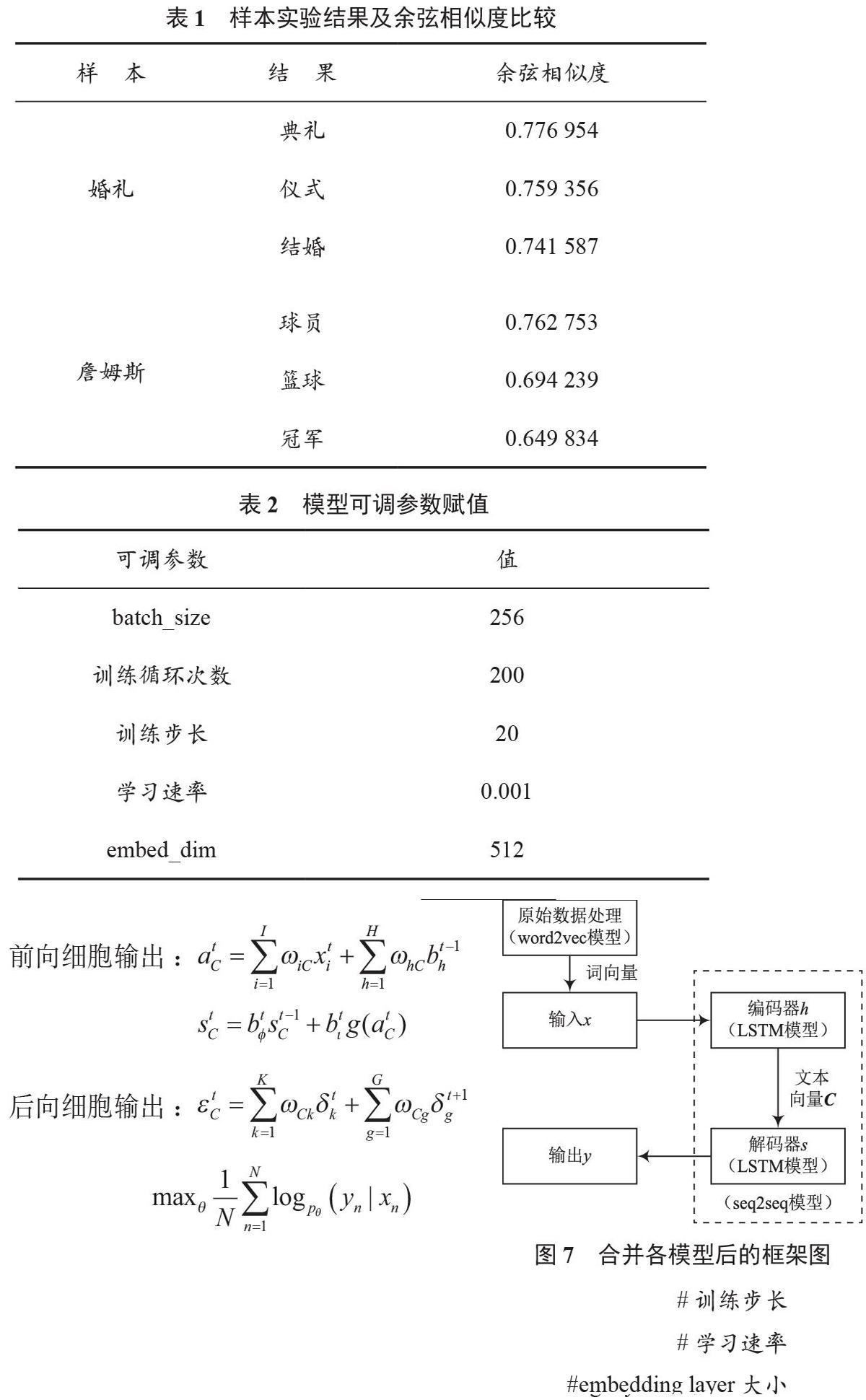

为简化强化学习任务,我们选择按照图像坐标递增的原则,选定用于填充的像素点。选择VGG16提取图像特征,经典的VGG16即16层卷积神经网络模型及设计流程如图1所示。

图像提取出的VGG特征将作为强化学习算法的状态输入,以进一步简化图像,使智能体更好地分辨状态的变化。

经智能体策略生成的新像素点值会改变图像状态,将前后状态、回报和相应的像素点变化动作存入经验缓存区,历经大量探索后让智能体进行训练,完善AC网络参数,形成相应策略后再进行新一轮探索,即离线训练。整个过程计算量较大,建议进行异步探索,以减少算法对硬件的压力和训练时间。

3 结 语

本文提出了一种全新的基于强化学习的图像修复算法思路,通过定义相应的强化学习环境,使智能体按照一定顺序遍历缺失图片区域时可自行补齐相应的像素点,修补图片。与以往算法不同的是,将图像修复过程离散化的修补策略使得算法可以实时跟踪图像相应的状态变化,并根据这些变化实时更新图像补齐策略,解决了传统修复算法存在的一步更新,无法实时跟踪图像修复的问题。通过增强图像修复算法的智能性,将整个图像的修复过程精确到像素级。

参 考 文 献

[1] BERTALMIO,MARCELO,SAPIRO,et al.Image inpainting[J].Siggraph,2005,4(9):417-424.

[2] BUGEAU A, BERTALM?O M, CASELLES V, et al.A comprehensive framework for image inpainting[J].IEEE transactions on image processing,2010,19(10):2634-2645.

[3] ZHU X, QIAN Y, ZHAO X, et al.A deep learning approach to patch-based image inpainting forensics[J].Signal processing image communication,2018,67(9):90-99.

[4] HSU C, CHEN F, WANG G.High-Resolution Image Inpainting through Multiple Deep Networks[C]// International Conference on Vision, Image and Signal Processing.IEEE,2017:76-81.

[5] WANG W,HUANG Q, YOU S,et al.Shape Inpainting Using 3D Generative Adversarial Network and Recurrent Convolutional Networks[C] //IEEE International Conference on Computer Vision.IEEE,2017:2317-2325.

[6] SUTTON R S,BARTO A G.Reinforcement learning:an introduction[J].Machine learning,1992,8(3-4):225-227.

[7]支周,屈肅.一种基于迁移极速学习机的人体行为识别模型[J].物联网技术,2015,5(9):18-20.

[8]邓志龙,张琦玮,曹皓,等.一种基于深度强化学习的调度优化方法[J].西北工业大学学报,2017,35(6):147-153.

[9]宋海声,刘岸果,吕耕耕.基于深度学习的空间变换情景感知模型研究[J].物联网技术,2017,7(3):22-24.

[10]姚君延.基于深度增强学习的路径规划算法研究[D].成都:电子科技大学,2018.