基于卷积神经网络的领带花型情感分类

2018-08-23汪珊娜张华熊

汪珊娜, 张华熊, 康 锋

(浙江理工大学 信息学院, 浙江 杭州 310018)

情感是服装设计的精神本质,织物图案是服装设计的重要内容,蕴含着丰富的情感信息。领带作为服饰品,不仅满足着装者服饰搭配需要,还传达着装者的身份、审美以及价值观等信息。随着数字化设计的发展,服装设计中的图案素材与日俱增,但设计人员很难充分利用已有的丰富的织物图像,这就需要对织物图像进行情感语义分析。

早期研究者通过提取图像的相关手工特征,利用机器学习方法来训练分类器,以实现图像情感分类。Datta等[1]提取低层的颜色、纹理、形状等图像特征,利用支持向量机进行图像美学情感分类,但由于量化粗糙,分类准确率不高;Marchesotti等[2]将图像灰度化后提取SIFT特征和局部颜色描述子进行美学情感分类,但忽略了全局信息和色彩信息;Lo等[3]从图像颜色、布局、边缘等特征的美学角度对图像美感分类进行研究,结果表明图像美学特征可用于图像情感分析。这些手工特征在图像情感分类中取得了一定的效果,然而,由于图像的构图规则和美学规律千变万化,且图像情感存在主观性和复杂性,传统的手工特征和局部特征难以全面表征和准确地量化图像的情感信息。近年来,深度学习方法的出现使得机器学习和特征学习研究有了突破性进展,采用深度学习模型的基于图像内容的检索方法大幅提高了图像搜索准确率[4]。卷积神经网络(convolutional neural networks, 简称CNN)是深度学习算法中的一种学习模型,具有逐层迭代、逐层抽象的特点,以及挖掘数据局部特征、提取全局特征能力,在图像分类的各领域都取得了很好的成果:LeNet-5模型[5]成功应用于手写字符识别,识别率达到99%以上;AlexNet网络模型[6]在海量图像分类领域取得了突破性的成果,在2012年大型图像数据库ImageNet的图像分类竞赛中,准确度超过第2名11%夺得冠军,从而使得CNN成为了学界关注的焦点;之后VGG(visual geometry group)、GoogLeNet、ResNet等模型刷新了AlexNet在ImageNet上创造的记录[7]。学者们开始尝试将深度学习用于图像情感分类问题:Lu等[8]同时考虑了图像的局部视角和全局视角,将CNN用于AVA数据库250 000幅图像的美感质量评价;冀中等[9]探索CNN模型在图像纹理分类中的应用,结果表明CNN模型在大多数纹理数据集上均能取得很好的分类结果。上述方法都只采用了大数据库中的样本图像像素值作为CNN输入,没有融合现有较为成熟的手工特征,在小样本情况下表现较差。

本文以领带花型为研究对象,设计了基于并行CNN的情感分类算法,将其应用于织物图像情感分类。首先确定了领带花型图案的情感描述词,通过统计方式确定了情感标签,由此建立了情感图像库;然后根据领带花型的特点,提取图像颜色、纹理等低层手工美学特征;其次,构建了基本CNN网络模型,通过实验确定CNN网络结构和参数,并将手工特征以及样本图像像素值并行输入CNN网络进行训练,建立织物图像与情感表达之间的映射;最后,通过训练后的分类器对检测样本进行情感分类。

1 算法流程

本文提出的算法流程如图1所示。主要步骤有情感图像库建立、特征提取、网络模型建立、情感分类4个过程。

图1 算法流程Fig.1 Algorithm flow

1)情感图像库建立。由专业设计人员对已有的领带花型图像进行情感标注,建立情感图像库。

2)特征提取。首先对织物扫描图像进行纹理抑制平滑处理[10],滤除扫描过程中产生的纹理及过渡色;其次,对预处理后的图像进行特征提取,提取颜色、纹理等低层图像特征,作为CNN输入。

3)网络模型建立。在Alexnet模型基础上建立CNN网络模型,通过实验、特征可视化调整参数,确定CNN结构。将预处理后训练样本的图像像素值与提取的低层特征并行输入CNN模型:其前向传播通过卷积层和下采样层得到图像特征;其反向传播调整参数,使用随机梯度下降法进行迭代,使得误差值达到收敛状态,完成权值的更新。

特征图公式定义为

f(x)=max(0,x)

在每层卷积层ReLU后用局部响应归一化(local response normalization, LRN)处理,提升网络的泛化能力,该处理过程用公式可表示为

本文使用Softmax回归函数和Log-loss误差函数对输出结果求误差,第L层的损失函数可由下式计算:

式中:pi为样本;qi为样本标签值;M为样本总数;fL为激活函数;wi、wd为权值;λ为正则化项系数。

4)情感分类。将检测样本的图像像素值和手工特征输入Softmax分类器,得到情感分类结果。分类精度计算公式为

式中:nTP为被模型预测为正的正样本数量;nTN为被模型预测为负的负样本数量;nFP为被模型预测为正的负样本数量;nFN为被模型预测为负的正样本数量。

2 情感描述词的确定

情感模型有维度情感模型[11]、离散情感模型[12]。维度情感模型用坐标表示情感空间,不符合人的直观感受,较难将维度空间中的某个坐标转变为特定情感,在织物图像中的使用范围受到限制。Kobayashi等[13]建立了一系列的情感词汇,如“考究的”“古典的”“成熟的”“浪漫的”“奢华的”等,贾京生[14]使用“正式的—休闲的”“儒雅的—粗犷的”“古典的—现代的”“简洁的—复杂的”“艳丽的—淡雅的”5组常用情感词对来描述男西装图像的情感语义,这些离散情感形容词符合人们日常的直觉和常识,适合描述织物图像情感。

领带作为服饰品,有不同的搭配需要。条纹、方格、菱形格等,通常用来表现公司白领自信优雅、成熟大方的气质;鲜艳的颜色配以其他图案给人轻松随意的感觉,通常用于日常着装搭配休闲的衬衫西装;亮色的经纬交错发光领带给人高调和闪亮的感觉,通常用来参加晚宴;夸张的色彩、怪诞的图案则用来表现新潮,给人前卫的感觉。图案作为领带构成的重要组成部分,有丰富的表现内容,既可传统复古也可时尚摩登,因此,不同的色彩、纹理、图案结合会营造出领带或精致或粗犷,或古典或现代等不同的艺术风格。结合文献[2-3]、[12-14]综合选出可描述领带花型情感的7组描述词,再由浙江理工大学服装学院从事服饰品设计的专家挑选出最能表现领带情感的5组,分别为:“正式的—休闲的”“艳丽的—淡雅的”“复杂的—简洁的”“古典的—现代的”“活跃的—沉闷的”。

3 表征情感的图像手工特征

给人美感的领带花型一般具有对称的结构、合理的空间分布、简洁明快的纹理、和谐的色彩分布以及较为丰富的颜色层次[15]。从图像情感的角度,物体不同的色彩、纹理、形状等会让人产生喜好、兴奋、厌恶等心理活动,设计与提取图像中较易引起用户情感变化的特征图像是情感特征提取的核心内容,即建立图像特征到织物情感的映射关系。这本质上就是构建一个合理的计算模型,计算用户的情感空间与图像特征之间的关系。研究者们对表征图像情感的特征做了大量研究,本文从经验出发,借鉴织物图案设计的艺术形式的美感规则,使用以下特征:按色彩、深浅、明暗来描述模型的HSV颜色特征;滤波器频率、方向与人类的视觉系统类似的纹理特征Gabor。

3.1 HSV颜色空间

色彩是表达情感的一门艺术,服饰品给人的第一感觉就是色彩,不同的色彩配置极大地影响着人们的视觉感受和情绪状态,是审美感受的特殊语言。例如红色给人热情的感觉,蓝色给人纯洁的感觉,紫色给人高贵神秘的感觉。色彩能引起人的心理联想,从而读懂色彩所表达的情感。HSV颜色空间是针对用户观感的一种颜色模型,侧重于色彩表示,更适合用来表征情感特征。色相的暖色调表现温暖、活跃,冷色调表现凉爽、冷漠;高饱和度的图像令人兴奋、愉快,有时代感,低饱和度的图像显示朴素。由RGB色彩模式到HSV的转换公式如下:

V=max(R,G,B)

H=H+360,当H<0时

式中:H为图像的色相;S为饱和度;V为亮度。

3.2 纹理特征

纹理是织物的重要特征,包含了丰富的图像构成信息,在情感分析中占据重要地位。纹理与色调组合可表达情绪,如平滑且冷色调给人凉爽的感受,粗糙且暖色调给人温暖的感觉。Gabor滤波器的频率和方向与人类的视觉系统类似,适于图像纹理特征描述。本文采用Gabor特征来表征纹理特征,用公式可表示为

式中:F为每个像素点滤波后的输出特征;p、q为图像像素点的位置;m、l分别定义为小波变换的方向和尺度;分母为标准化因子。

4 CNN网络结构

在织物图像的情感分类中,本文参考Alexnet网络模型[6]建立了网络结构,采用并行CNN结构进行图像情感分类。本文提出的并行CNN结构由3路结构相同的CNN构成,如图2所示。输入数据分别为RGB像素值、经HSV变换后的S通道、平滑滤波处理后经小波变换提取的纹理特征;每个单路CNN由4个卷积层、1个全连接层构成;最后经Softmax分类器输出织物图像的情感类别。图2中数据表示图像像素或神经元个数。

图2 并行CNN结构Fig.2 Structure of parallel CNN

本文根据CNN应用中网络层数与数据库数量级之间的关系,设计了适应织物图像的CNN模型,通过实验不断调整网络层数与参数,以得到较好的模型。每一路CNN的具体参数设置如下。

输入层:将原始图像按比例裁减成256像素×256像素×3像素,再进行HSV转换取通道S,平滑滤波后提取Gabor纹理特征。由于样本数量较少,因此,本文对图像库中的图像进行数据增强[16],通过裁剪每幅图像左上角、左下角、右上角、右下角、中间部分并镜像得到10幅224像素×224像素×3像素的图像。

卷积层1:使图像经过48个11像素×11像素的卷积核,步长为4,得到55像素×55像素的特征图;使用ReLU激励函数,用3像素×3像素的核进行步长为2的最大池化;最后进行LRN处理。

卷积层2:使用128个5像素×5像素的过滤器对48个27像素×27像素的特征图进一步提取特征,过滤器是对48个特征图中的某几个特征图中相应的区域乘以相应的权重,然后加上偏置之后所得到区域进行卷积,宽度高度均填充2像素,最后进行步长为2的最大池化,得到128个13像素×13像素的特征图。

卷积层3:宽度高度均填充1像素,有 192个大小为3像素×3像素的核被连接到第2个卷积层的输出,步长为1,得到192个13像素×13像素的新特征图,再利用ReLU激励函数。

卷积层4:宽度高度均填充1像素,结构同卷积层3,再用3像素×3像素的核进行步长为2的最大池化,得到128个6像素×6像素的新特征图。

全连接层:1 024个神经元。

5 实验与结果分析

5.1 情感图像库建立

根据第2节中确定的领带花型的情感描述词,将图像库分为5个类别:类别1为“正式的—休闲的”,可描述领带用途;类别2为“艳丽的—淡雅的”可描述领带色彩;类别3为“复杂的—简洁的”可描述领带构造;类别4为“古典的—现代的”可描述领带风格;类别5为“活跃的—沉闷的”可描述领带性格表现。

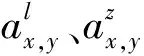

然后请专家对本文选出的4 234张不同风格、颜色的领带花型图像进行情感评价。参考PhotoQualityDataset[17]中美感评价方法,评价者在 5对情感描述词中分别做出选择:前一个标签、后一个标签、不确定,由此获得4 234幅图像的标签。当 8位及以上评价者的评价标签相同时,确定该标签为图像的最后标签,去除不确定标签图像后,得到图像样本库,由此分别建立了5组织物类别,示例样本如图3所示。

图3 织物情感图像库示例样本Fig.3 Library of fabric emotion images. (a) Formal; (b) Casual; (c) Gorgeous; (d) Elegant; (e) Complex; (f) Concise; (g) Classic; (h) Modern; (i) Active;(j)Boring

5.2 实验结果

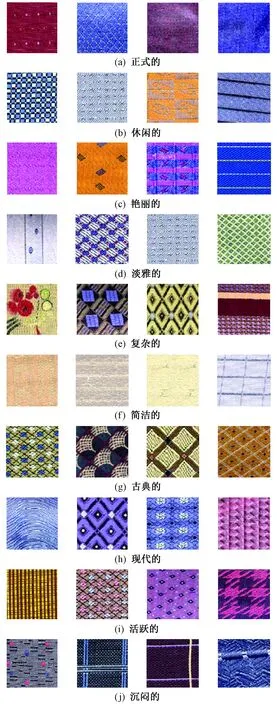

在进行实验时,针对每对感情词在样本库中随机选取3 000幅图像,其中2 000幅作为训练样本, 1 000幅作为检测样本。将织物图像像素值RGB、HSV通道S、纹理Gabor特征并行输入CNN网络,网络结构和网络参数见第4节。实验环境为1块NVIDIA-GTX1080 GPU,使用Caffe框架[18]部署的CNN模型。训练时采用BP算法调整参数,由于样本量较小,学习率设置为0.005,批处理Batch size为64,迭代次数2万次。实验结果如表1所示。

表1 并行CNN分类准确率

由表1可知,用并行CNN对5类情感词进行分类时,在类别2中分类准确率最高,为94.8%,在类别3中最低,为89.7%,可基本满足对织物图像的情感分类需求。

5.3 结果分析

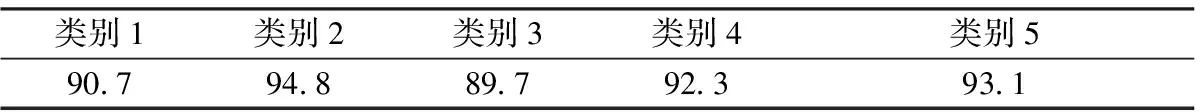

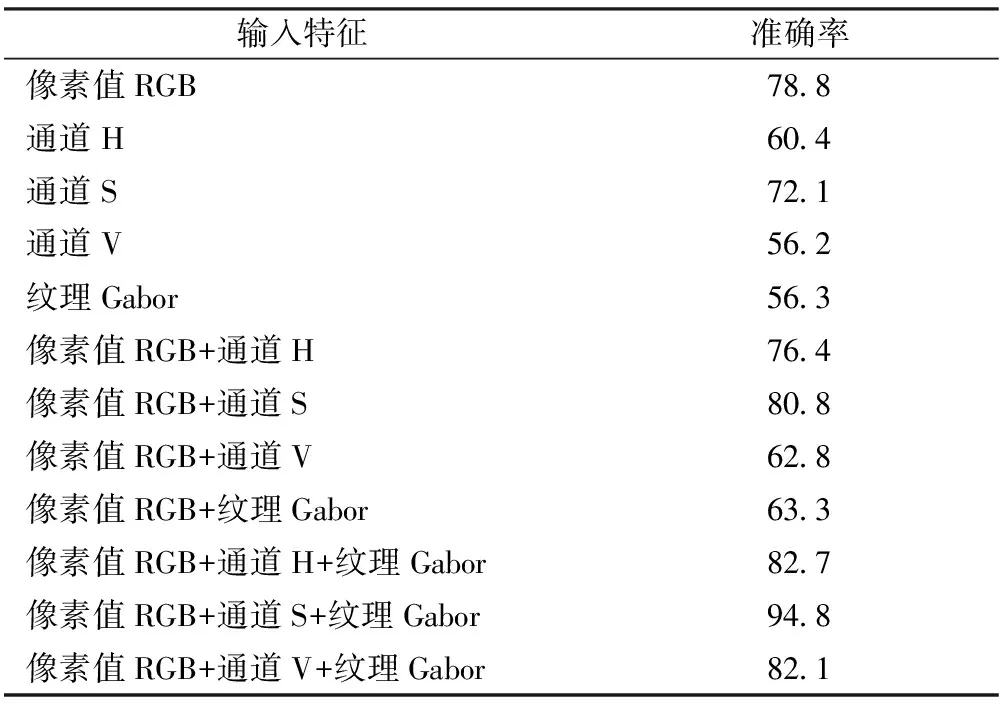

选用织物图像库中类别2的样本,使用不同卷积层次的网络、滤波器数目、不同特征组合分别进行对比实验,具体参数与结果如表2~4所示。

表2 不同卷积层次的情感分类准确率Tab.2 Accuracy of image emotion classification using CNN with different number of layers %

注:“√”表示结构中含有该层。

表3 不同滤波器参数的情感分类准确率Tab.3 Accuracy of image emotion classification using CNN with different parameters %

表4 不同特征组合输入的情感分类准确率Tab.4 Accuracy of image emotion classification using CNN with different input of features %

表2、3结果显示,本文使用的4层卷积网络结构获得的分类准确率最高。相同的网络层数,滤波器个数越多,可学习到的特征图层数量越多,分类表现越好,但滤波器个数的增多会造成网络训练参数的大量增长,在小样本数据库中易造成过拟合等不利现象。从表4可知,在单路输入特征时,输入像素值RGB的分类准确率最高,HSV通道次之,Gabor纹理特征较差,由此可见,色调是影响织物情感的较为重要的因素。RGB与通道H、通道V并行的网络正确率不增反降,本文使用像素值RGB+S通道+纹理Gabor特征得到的分类准确率最高。

将文献[1-3]、[ 19]中提到的特征提取方法与本文方法进行了对比,采用本文的图像库进行验证,对比结果见表5。可以看出,本文方法比传统基于手工特征的分类方法情感分类准确率高。这主要是因为图像情感是人的主观感觉,并不能单纯通过某几种手工特征完全映射人的情感表达;而CNN可自动提取特征,通过大量样本的训练可挖掘数据的局部特征、全局特征和上下文信息,在推理规则不明确的情况下从大量样本中提取与人真实的情感相匹配的情感特征,泛化能力强。

表5 本文与传统方法的情感分类准确率Tab.5 Accuracy of image emotion classification using proposed method and traditional methods %

将本文提出的并行CNN模型与LeNet-5模型(2层卷积,1层全连接)、AlexNet模型(5层卷积,3层全连接)、VGG模型(13层卷积,3层全连接)这 3种经典的CNN网络模型在领带花型图像库中进行训练并检测,结果见表6。可以看到,本文提出的方法分类准确率最高,表现较LeNet-5模型、Vgg-16模型、Alexnet模型更好。这主要是因为LeNet-5模型最初的设计是应用于数字识别,识别目标简单且背景单一,但在处理目标较为复杂的图像时,分类能力受到了限制;Vgg-16模型网络过深,使用大量卷积操作,对于领带花型的小样本数据训练较为困难,较难得到泛化效果好的模型;本文在Alexnet模型的基础上提出的CNN模型,融合了手工美学特征,在一定程度上克服了小样本情况下CNN模型识别率较低的不足。

表6 与流行网络模型的情感分类准确率Tab.6 Emotional classification accuracy of E-net and other popular models %

6 结束语

本文提出了融合手工美学特征的基于并行CNN的织物情感分类方法,实现了领带花型的情感分类。该方法在一定程度上克服了传统美学评价方法提取的手工特征难以全面表征织物情感的不足,以及在小样本情况下CNN模型识别率较低的缺点。从实验结果来看,提出的CNN模型较传统手工特征方法与流行CNN模型有更好的情感分类效果。

在连接并行的CNN时,采用最简单的连接方式且在各路网络中使用了相同参数。由于不同的情感特征对应的图像特征不同,相同的CNN结构和参数不利于提高分类准确率。在后续的研究工作中,将扩大样本图像库,通过CNN各层的特征可视化探索不同特征对应的最优网络结构,赋予不同的权重,这有助于训练出更好的CNN情感模型。