基于卷积神经网络和E2LSH的遥感图像检索研究

2018-07-25彭晏飞訾玲玲

彭晏飞 陶 进 訾玲玲

(辽宁工程技术大学电子与信息工程学院 辽宁 葫芦岛 125105)

0 引 言

数字地球时代正在向我们走来,所谓的“数字地球”是指对真实地球及其相关现象的统一性的数字化重现与认识[1]。遥感图像是一种内容丰富、覆盖面广、经济适用的空间数据载体,是数字地球项目的一项基础性数据。随着各项观测技术的快速发展,遥感图像的数据规模发生了爆炸性增长,如何对大规模遥感图像进行高效检索成为了数字地球建设中的瓶颈性难题。为解决这一问题,众多专家学者在这一领域进行研究并提出了很多行之有效的方法。

与普通图像检索类似,遥感图像检索的发展也经历了从基于文本检索到基于内容检索CBIR(Content-Based Image Retrieval)的过程。成熟的CBIR技术在遥感图像检索领域得到了广泛的应用,很多的团队和机构通过CBIR技术开发出一些遥感图像检索系统[2-4],例如其中的QBIC系统、Netra系统等,都是通过分析遥感图像低层视觉特征的概率密度分布来实现检索的。遥感图像是众多图像的一种,但它又具有自身的特点,所以完全利用CBIR来检索大规模的遥感图像并不能得到一个令人满意的检索效果。因此,众多专家学者从遥感图像自身出发进行探索研究并提出了很多算法。例如,中国科学院开发的Mires系统不仅通过机器学习来提取图像语义特征,而且利用SVM反馈算法来调节低层特征的权值;文献[5]等提出一种综合图像的视觉特征度量函数和SVM 分类器函数的相关反馈算法,提高了系统对用户反馈信息的语义理解能力,优化了检索结果;文献[6]中利用感知哈希将遥感图像进行分块哈希,解决了检索过程出现的图像尺度大、信息丰富等问题;为了提高检索精度和优化结果排序,文献[7]提出了一种基于遗传算法和SVM的检索算法;文献[8]将形态学理论应用到遥感图像检索领域,提出了一种形态学属性面结合SVM分类算法的遥感图像检索技术。

遥感图像是一种特征维度高,信息丰富的图像。至今,遥感图像检索还没有一种特别优异的方法。利用CBIR进行检索最大难点在于低层特征和高层语义之间的鸿沟和它差强人意的检索效果;而当前的检索方法都存在图像特征表达能力不足,并且将数据映射到低维空间,计算并排序海明距离后,还需利用欧式距离进行度量,距离及空间的转换会产生信息损失,导致检索效果不理想;针对以上存在的问题,本文提出一种基于欧氏距离的遥感图像检索方法,利用卷积神经网络CNN(Convolutional Neural Network)提取遥感图像特征,提高特征之间的区别度,增强了方法的特征表达能力;随后利用精确欧式距离的局部敏感哈希E2LSH[9]建立索引结构以加速检索过程,并利用其性质直接计算欧式距离来检索结果,避免了信息损失。多次实验表明,提出的检索方法能有效提高图像特征表达能力,减少信息损失,比传统遥感图像检索方法有更好的检索效果。

1 相关工作

卷积神经网络是深度学习在图像领域的实践成果。自从2012年Krizheevsky等[10]提出的AlexNet 模型至今,卷积神经网络被广泛的应用在了图像分类、图像识别等领域,并取得了令人惊喜的成绩,充分向我们证明了卷积神经网络在特征提取方面的巨大优越性。基于卷积神经网络的各项研究成果展示在我们面前,让我们认识到卷积神经网络的自主学习特征能力和强大的特征表达能力。自此,我们有了新的思考方向和研究路线,不再局限于对CBIR检索结果优化,利用卷积神经网络提取计算机视觉特征,对图像内容有了更加准确精细的描述,更有利于图像检索。

哈希技术将数据映射到低维空间内,使数据降维并在低维空间内进行度量计算,故而使得哈希技术在速度和存储上具有了很大优势,也使得哈希技术成为了高维数据近似近邻搜索的主流方法。局部敏感哈希LSH(Locality-Sensitive Hashing)[11-12]是哈希与图像的第一次结合,将图像特征映射到低维的海明空间内,计算海明距离。但我们在进行距离比较的时候一般使用的都是欧氏距离,因此还需将两种距离进行变换,这种映射与换算的过程不仅麻烦而且会引入很大的误差。E2LSH是一种基于P稳定分布的LSH,此方法不需要映射到低维空间,可以直接计算欧式距离,且利用P稳定分布的性质可以高效地近似高维特征向量,并在保证度量距离的同时,对特征向量有效降维。

2 本文方法

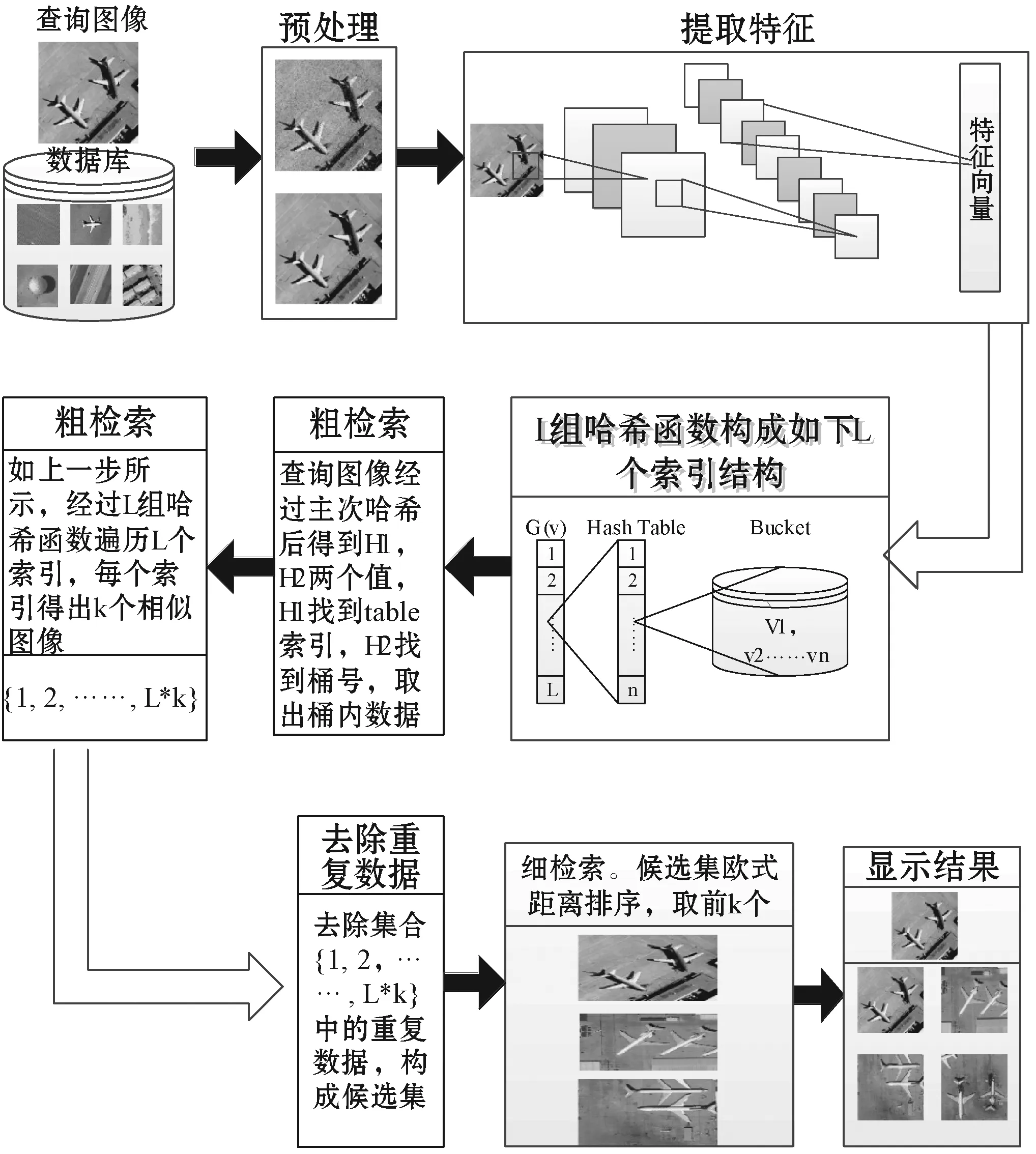

本文的算法结构图如图1所示。

图1 算法结构图

2.1 改进的小波变换算法去除噪声

遥感图像质量受大气状态和拍摄设备影响,为了有更好的检索效果,我们需要在检索之前对遥感图像进行预处理。基于小波变换的图像去噪算法是众多去噪算法众多佼佼者,所以我们实现了文献[13]中的小波变换去噪算法来实现遥感图像预处理。

从频域特征上来看,图像中的噪声往往是一种高频的分量,而大面积的图像背景区域是低频部分,通过这一特点,我们想做的就是把代表噪声的高频部分去掉。将图像进行小波分解之后得到各个分解层的小波系数,设定某一阈值,对大于和小于这一阈值的小波系数分别进行处理,最后利用处理过的小波系数进行重构复原图像。

一个含噪声的图像可以表示为:

s(i,j)=f(i,j)+n(i,j)

(1)

式中:f(i,j)表示原始图像;n(i,j)为噪声。

其去噪过程如下:

(1) 选择一种小波并确定分解层次N,对信号s进行分解,利用mallat金字塔算法得到各级小波系数。

(2)

(3)

(2) 确定阈值,对高频小波系数进行阈值量化。阈值的确定有很多方法,不同的阈值确定方法代表了对高频系数的不同的量化策略。本文采用的是常见的软阈值法。

根据低频小波系数和被处理过的高频系数,对图像进行重构复原。

(4)

经过小波阈值去噪,图像的质量得到一定的改善。图2为原图和经过小波去噪后图像的对比图,由效果可知,经过处理的图像分辨率明显高于原图。

(a) 原图像 (b) 预处理之后的图片 图2 效果对比图

2.2 VGGNet-D模型提取图像特征

随着卷积神经网络的深入研究和应用,卷积神经网络在计算机视觉领域取得了突破性发展,特别是图像理解方面,基本取代了传统图像表示方法。MatConNet是一实现卷积神经网络的Matlab工具包,可以学习一些已经训练过的大型深度CNN模型,如AlexNet、GoogLeNet、VGGNet[14-15]等。MatConNet除了自身包含了很多的CNN计算块,还允许研究者自己编写新的计算块,如卷积、归一、池化等,来提高计算效率。相比于Caffe而言,MatConNet安装简单使用方便,为研究者提供了一个友好的使用环境。

本文采用的模型是VGGNet-D[16]模型,它在ILSVRC数据集上训练过,取得了很好的成绩,并且这一模型的泛化性非常好,将模型迁移到其他图片数据上也可以取得很好的效果。VGGNet-D模型也就是我们常说的VGGNet-16模型,包含13个卷积层和3个全连接层。VGGNet-D模型整体采用若干个3×3的卷积核来代替5×5、7×7这样的卷积核,因为这样可以提取更多的消息。利用该模型进行特征提取时,首先会对输入的图片进行去均值预处理;然后通过3×3的卷积核进行卷积、池化交替操作,来发掘深层特征。

2.3 增强E2LSH建立索引表

E2LSH是一种基于P稳定分布的局部敏感哈希改进形式,也是一种专门针对大规模高维数据的ANN算法。其基本思想与LSH一致,找到一种hash映射,能够使相邻数据被映射到同一hash桶的概率最大,不相邻数据被映射到同一hash桶中的概率最小。进行查询时,只需将查询点映射到某个hash桶中,在桶中进行查询,这样既节省了距离的计算,也减少了查询时间。构造hash函数是LSH算法的关键步骤,而这种能是相邻数据经过hash变换之后映射到同一个hash桶中的hash函数需要满足以下两个条件:

1) 如果d(x,y)≤d1,则PrH[h(x)=h(y)]≥p1

2) 如果d(x,y)≥d2,则PrH[h(x)=h(y)]≤p2

其中d(x,y)表示x和y之间的距离,d1

2.3.1P稳定性质构建hash函数

(5)

(6)

式中:a是一个d维随机向量,每一维都是独立随机从满足P稳定分布的变量中选择的,b是一个[0,w]范围内的随机数。

2.3.2 特征向量碰撞概率

任课教师必须在为学生布置练习题时,充分考虑到练习题的内容是否能够让学生从中获益,同时要确保所布置的习题能够精准地覆盖到班级之中的每一位学生身上,而不是让习题仅仅成为部分学生的专利。为此,任课教师要采取分层习题的设计方式,以此来提升习题的有效性、针对性和覆盖性。

(7)

由以上概率公式可知,当参数w固定时,碰撞概率随着c的减小而增大。因此,该哈希函数是局部敏感的。由文献[18]分析可得最优的参数设置为:

r=4.0c=2.0p1=P(1)p2=P(c)

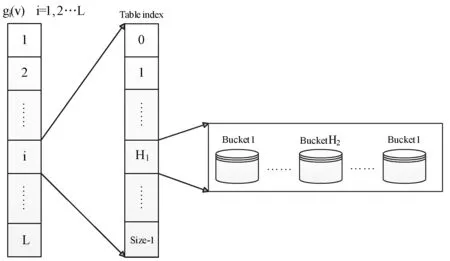

2.3.3 建立索引结构

为了避免单个哈希函数带来的随机性误差,故设计L个函数组gi(v),每个函数组K个随机从哈希簇ha,b(v)中选取的哈希函数组成,其函数格式如下:

gi(v)=(ha1,b1(v),ha2,b2(v),…,hak,bk(v))

(8)

每个d维特征向量经过gi(v)变换后变成K元组(X1,X2,…,Xk),其中Xi是一个正整数。直接将(X1,X2,…,Xk)存入哈希表中,不仅耗费内存且不便于查找,因此设计了两个主次哈希函数h1和h2,他们的具体形式如下:

(9)

(10)

通过以上函数构成了整个算法的索引结构,产生了L个哈希表。h1(v)和h2(v)两个函数产生的两个函数值h1和h2,其中h1是哈希表的index,指向哈希表的某个索引处;h2是h1指向的索引处的桶号。每个数据点经过以上过程后,h1和h2相同的数据点会被存入同一个桶中。每个数据会被分别存入L个哈希表中,具体的哈希的结构如图3所示。

图3 索引结构

3 实验设置及分析

UC Merced Land Use Dataset[19]是一个常用的遥感图像数据集,是从美国地质调查局国家城区地图的图像集合中手动提取出来的,其中包含了森林、海边、飞机等21个类别,每个类别具有100张大小为256×256的图像数据。为了验证本文方法的有效性,在实验中,本文选取谱哈希算法SH[20],主成分分析迭代量化算法PCA-ITQ[21],密度敏感哈希算法DSH[22],位移不变内核局部敏感哈希算法SKLSH[23]以及深度学习与二进制哈希相结合的方法CNNH[24]作为对比算法。本文使用查准率(Precision)和查全率(Recall)以及P-R曲线作为评价指标。

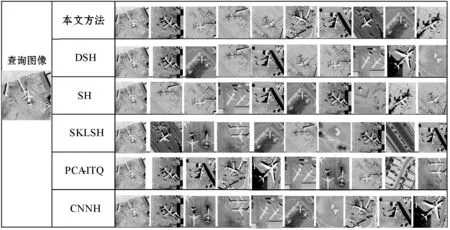

3.1 检索示例

图4所示为本文方法与对比方法的检索结果top10的一个对比表,由上述图标可知,本文方法的检索结果的前十幅全部为查询图像的相似图像,而CNNH、DSH、ITQ以及SH算法top10中有9幅相似图像,SKLSH效果最差,只有8幅相似图像。由此可见,本文方法在检索效果上是优于其他算法的。

图4 检索结果top10图像对比

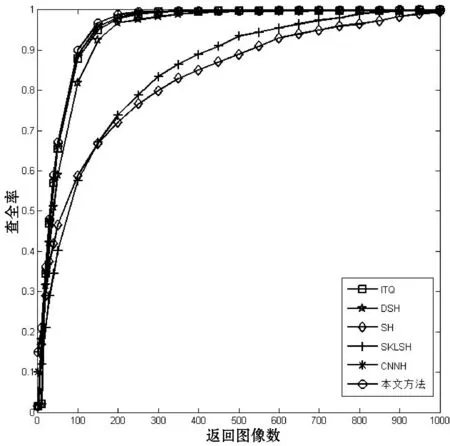

3.2 查全率

查全率是检索结果中的相似图像数占数据集中相似图像数的比例。图5为本文方法与对比算法PCA-ITQ、DSH、SH、SKLSH以及CNNH的查全率对比图。由图中可以看出,随着返回图像数目的增加,相似图像被检索出来的可能在提高,故而算法的查全率随着数目的增大也在变大,但我们可以看到在增长过程中,本文算法的查全率高于其他对比算法。

图5 查全率对比图

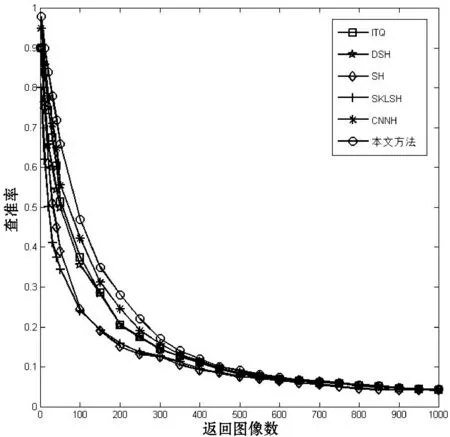

3.3 查准率

查准率是检索结果图像中相似图像数占检索结果数的比例。图6为本文方法与对比算法PCA-ITQ、DSH、SH、SKLSH以及CNNH的查全率对比图。图中显示随着返回图像数目的增加,公式基数不断增加,所有算法的查准率都在下降。但本文方法经过卷积神经网络提取特征,使得特征更具有区别,故而本文算法在下降过程也始终高于其他算法,在图像数100到200之间,本文算法比DSH和ITQ高出了23.5%,比SH和SKLSH高出了50%。

图6 查准率对比图

3.4 P-R曲线

P-R曲线是本文所有测试图像进行距离由大到小排序后,由查准率与查全率构成的曲线。本文算法与对比算法的P-R曲线如图7所示,由图可知,本文算法的P-R曲线完全将对比算法的曲线包围住,可见本文算法的效果性能均优于对比算法。P-R曲线所围成的面积等于该算法的MAP,同样可以证明本文算法的优异性。

图7 P-R曲线

4 结 语

针对当前遥感图像检索方法图像特征表达能力不足、遥感图像特征维度高以及信息损失等问题,本文提出一种将E2LSH结合卷积神经网络的遥感图像检索方法。本文方法利用小波变换去噪的原理对图像进行预处理之后,充分考虑的遥感图像的特征特点,利用卷积神经网络提发掘图像的深层特征及特征之间的隐含关系,提高了图像特征的区别度以及特征描述能力;利用哈希算法E2LSH对高维特征进行高效降维并建立哈希结构,加快检索过程,减少信息损失。经过多次实验证实了本文方法的查准率与查全率有更好的性能表现。