基于前景增强与背景抑制的显著性物体检测*

2018-07-05王豪聪赵晓叶

王豪聪,赵晓叶,彭 力

(1.物联网应用技术教育部工程中心,江苏 无锡 214122;2.江南大学物联网工程学院,江苏 无锡 214122)

1 引言

显著性检测能够模仿生物视觉系统,让计算机筛选出图像中人类感兴趣的目标和区域,这在计算机视觉研究中有着重要的意义。显著性检测作为图像的预处理过程广泛应用于图像分割[1]、目标识别[2]和图像压缩[3]等领域。

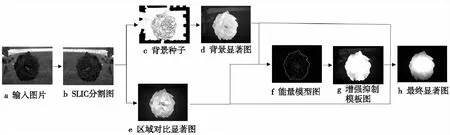

Figure 1 Process of data图1 数据处理流程

近年来,显著性检测逐渐成为国内外的研究热点,主要分为自顶向下(Top-down)和自下而上(Bottom-up)两种机制,在自顶向下的机制中通常有预设的检测目标,需要先学习。自下而上的机制主要通过颜色、纹理等底层纹理的对比实现凸显显著区域的目的。Itti等人[4]通过提取不同尺度图像中亮度、颜色、方向等特征进行对比来凸显显著区域,但是该方法容易产生空洞。Achanta等人[5]提出的FT(Frequency Tuned)算法在复杂背景信息影响下同样也不能很好地突出显著区域。Cheng等人[6]提出的区域对比法可以很好地找到一个较为完整的显著区域,但是对复杂背景处理效果依然不是很好。Wei等人[7]提出了边界先验的方法,指出边界的像素点通常都是背景,从而开始基于背景显著图的研究。但是,如何处理复杂背景和如何抑制背景噪声依然是显著性检测的关键问题。随后Jiang等人[8 - 10]开始研究基于前景和基于背景两种方法的融合,取得了很好的效果,其对于背景先验检测的应用很好地抑制了背景噪声。Perazzi等人[11]通过高斯滤波将颜色和距离的差值来作为显著值,反映出滤波对于显著性检测也很有帮助。Harel等人[12]通过改进分割方法来获得更好的目标物体的轮廓,但对于自身颜色差异较大的物体和与背景颜色相近的物体的分割效果也不好。

本文提出了一种基于前景增强和背景抑制的显著性检测方法。通过区域间对比和边界信息得到显著区域和背景种子[10],通过进一步计算得到基于区域对比和基于背景的显著图。在两幅显著图中运用Seam Carving[13]和Graph-based[12]的分割法更准确地区分显著区域和非显著区域,由于Seam Carving方法的核心在于寻找一副图像中能量最低的分割缝,本文即是从一幅图像的四个边的每一个像素点向对边行进,行进路线沿最低能量路线,因此经过高能量边界后的行进路线会被增强而低能量区域则会抑制,这样就得到了前景增强且背景抑制的模板图。最后,三图融合形成最终的显著图。

2 显著图的计算方法

本文提出的显著性检测方法会产生三张显著图:基于区域对比的显著图、基于背景的显著图以及基于能量模型的模板。最后通过一个融合策略将三幅图融合成最终的显著图,本算法的流程图如图1所示。

2.1 基于区域对比的显著图

对于输入的图像,首先用简单线性迭代聚类SLIC(Simple Linear Iterative Clustering)将图像分割得到K颜色相似的超像素区域。然后,本文采用区域间对比的方法,利用每个超像素区域在LAB颜色空间中的颜色特征和本身的空间位置特征得到每一个超像素ri的显著值,如式(1)所示。

(1)

其中,ci、cj是超像素区域i、j在LAB颜色空间[8]中的颜色向量,即该超像素区域所有像素点在L、A、B三个颜色通道中的均值;‖ci-cj‖2表示第i和第j个超像素区域颜色向量的欧几里德距离;pi、pj表示超像素的空间位置向量,即该超像素区域的位置重心;β1是空间距离因子,用来控制空间位置对像素块显著值的权重,使得邻近超像素块的显著值贡献更大。

然后,根据中心-边缘原则[9],显著区域通常都位于图像的中心位置,pc表示图像的中心位置向量,则每个超像素的前景显著值Sf(ri)可以表示为:

Sf(ri)=e-β2‖pi-pc‖2×S(ri)

(2)

由此可得到基于区域对比的显著图。通过控制β2的大小可以改变位于图像中心位置的显著值。

2.2 基于背景的显著图

传统的背景先验检测法都将位于图像边界的超像素设为背景,而很多图像中存在显著区域延伸到图像边界的情况,因此会产生噪声点并严重影响背景先验检测的可靠性。为此,我们先选出含有较少前景区域的超像素作为背景种子[10],以背景种子为最合适的背景区域,再进行背景先验检测。

首先,通过局部亮度、色彩和纹理的对比提取图像中可能的轮廓。如图2b所示。

Figure 2 Samples of background seeds图2 背景种子样图

定义每一个含有边界的超像素的背景权重为Bi,然后根据Bi的大小来筛选出背景种子,如图2c所示。

(3)

其中,bi是含有边界的超像素中含有轮廓点的个数,|∑Bi|表示所有含有边界的超像素含有的轮廓点的数量。当Bi小于一定阈值时,我们判定这个超像素属于背景种子。由此获得含有较少的前景噪声的K个背景种子。在进行背景先验检测时,我们通过每一个超像素与背景种子在颜色特征和空间位置特征的对比来确定超像素的背景显著值Sb(ri),如式(4)所示。

(1-‖pi-pn‖2/θ)

(4)

其中,K表示最终确定的背景种子;θ是平衡因子,用来调节空间位置特征和颜色特征最终对显著值的影响。由此可得到基于背景的显著图。

3 基于能量的模板图

本文方法中最重要的部分是生成前景增强和背景抑制的模板图。通过观察图1a和图1b可以发现,显著区域与非显著区域之间存在着一定的边界,如何有效增强边界内的显著区域而抑制边界外的区域一直是显著性检测中非常重要的问题。通常都会用高斯滤波[11]或者凸包中心[13]来增强中心区域,这样做通常容易导致对边界区域抑制过大。针对这个问题,本文采用Seam Carving和Graph-based分割法相结合生成的模板来增强显著区域,抑制非显著区域。

首先,运用式(5)的能量函数Ψ处理得到的两幅显著图,可以得到基础的显著区域与非显著区域的边界,进一步运用Graph-based和凸包分割图像得到区域轮廓图,如图3e所示。图3a和图3b为两幅显著图,图3c为采用Graph-based分割得到的轮廓图。

(5)

其中,S代表初步显著图。

根据Seam Carving理论,每一幅图像都有一条水平(垂直)方向上的缝连接图像的一组对边,在这条缝上,图像的能量和是最小的。根据这个思想,我们将能量模板图在上、下、左、右四个方向上的每一个像素点沿最低能量路线向对边行进,即利用式(6)对图3e进行处理,结果如图3t、图3d、图3l和图3r所示,得到S1~S4四幅图像。

S1(x,y)=α1Ψ(x,y)+α2min(S1(x-1,y-1),

S1(x-1,y),S1(x-1,y+1))

(6)

其中,S1表示能量模型,(x,y)表示图像中每个像素点的坐标,而S1第一行的值就是本身的显著值。α1、α2是位于(0,1)的权重参数,用来调整增强效果,α2大于α1时增强前景和抑制背景效果强,反之则弱。式(6)表示当从第一行的任意一个像素开始向对边行进时,如果行进路线上有能量高的像素值,即该行进路线会穿过显著区域,则该路线上之后的值应该被增强。同理应用在从下往上、从左至右、从右至左的三幅图中,得到图3d、图3l和图3r。

Figure 3 Template framework图3 模板图流程

对于每一幅图像上对应的像素点,我们从图3t、图3d、图3l和图3r中选择它的最小值来确定它的最终值,这样可以避免增强轮廓之外的非显著的区域。通过式(7)可以得到最后的模板图。

Smb=min(S1(x,y),S2(x,y),S3(x,y),S4(x,y))

(7)

Sal=ω1Sf×ω2Sb×ω3Smb

(8)

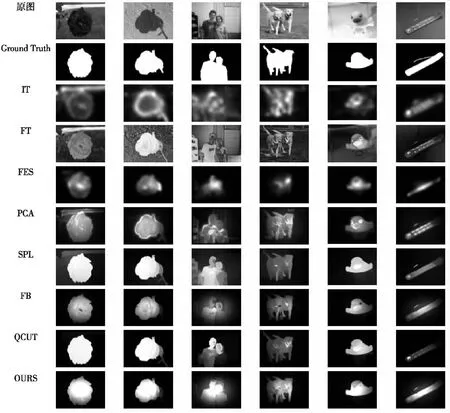

Figure 4 Comparison results of saliency maps图4 显著图结果主观对比

最后,通过式(8)将基于区域对比的显著图、基于背景的显著图和模板图相融合,就可得到最终的显著图,ω1、ω2、ω3为各个显著图的权重参数,取值位于(0,1),参数的大小决定了最终显著图与三幅显著图中的哪一幅更接近。

4 实验结果与分析

本节利用Matlab(R2014b)对本文算法进行仿真实验,系统运行环境为Windows7,Intel(R) Core(TM) i5 3.2 GHz CPU,8 GB内存。本次实验采用公开数据集MSRA-1000中的1 000幅图像作为测试集,每幅图像都有相应的人工标注二值图GT(Ground Truth)做对照模板。文中β1、β2、α1、α2、ω1、ω2、ω3等参数的取值分别为0.1、0.1、0.4、0.6、0.4、0.3、0.4。以下是本文提出的显著性检测算法与7种主流算法进行比较的结果,7种算法分别为:IT[4]、FT[5]、FES[15]、PCA[16]、SPL[17]、FB[10]和QCUT[18]。由于篇幅有限,图4只列出针对MSRA-1000数据集中6幅图像的处理对比结果。

由图4的比对可以清晰看出,本文算法在处理复杂背景图像时可以更好地突出显著区域,边界相对更清晰。而对于前景与背景颜色相近的图像,本文算法依然可以通过增强前景来达到突出显著区域的目的。

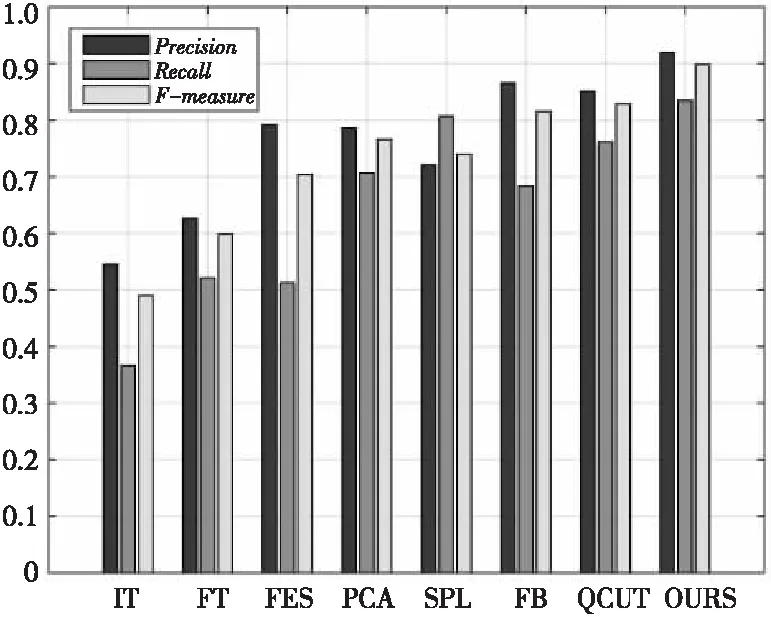

显著性检测客观评价标准包含查准率(Precision)、查全率(Recall)和F-measure值。查准率是指正确检测的显著区域与检测区域的比值,它反映了检测的准确性,衡量检测系统和检测方法拒绝误检测的能力,其补数是误检率,见式(9);查全率是正确检测的显著区域与显著区域的比值,它反映了检测的全面性,衡量检测系统和检测方法正确检测的能力,其补数为漏检率,见式(10);F-measure值[19]来综合两种指标评价标准,使两者之间保持均衡,见式(11)。

(9)

(10)

(11)

其中,gx表示像素点x的真实值,ax表示像素点x的测量值。

本文算法与其他7种算法在查准率、查全率和F-measure的对比数据如图5和图6所示,其中β2=0.3。

Figure 5 PR curve图5 PR曲线

Figure 6 F-measure histogram图6 F-measure柱状图

由图5和图6可以看出,本文算法的查准率、查全率和F-measure均高于其他7种算法,而且均有提高。由此可见,本文提出的基于能量模型的模板图可以有效增强前景区域并抑制背景区域。

为了更加直观且综合地评定算法优劣,我们通过计算PR曲线下的面积AUC(Area Under Curve)[20]来综合评判算法优劣,AUC值越靠近1,表示算法效果越精确。为了在不进行二值化的情况下直接分析算法所得显著图与人工标注二值图GT之间的关系,我们用平均绝对误差MEA(Mean Absolute Error)来评价算法性能,如表1所示。

(12)

其中,M和N代表图像的长与宽;S(x,y)表示测得的显著图在(x,y)处的显著值;GT(x,y)表示人工标注二值图在(x,y)处的显著值。

Table 1 Performance comparison表1 性能指标对比表

由表1可知,本文算法的MEA值为0.123,与QCUT算法相近,但小于其他6种算法,而F-measure值与AUC均远优于其他算法的。但是,本文算法由于是三幅图融合形成最终显著图,在时间上与其他算法相比消耗更多,这点有待于改善。

5 结束语

本文提出了一种基于前景增强和背景抑制的新的显著性区域检测方法。首先通过区域对比和背景种子点得到两幅显著图,根据Seam Carving、Graph-based和凸包得到的模板与原显著图进行融合起到了很好的前景增强背景抑制的作用。本文中的模板不局限于目标性状、环境的变化,可以应用于多场景和多算法中。在公开测试集上与7种主流算法的测试结果对比表明,本文算法显著区域检测结果更准确,抗噪声能力更强。

[1] Victor L,Pushmeet K,Carsten R,et al.Image segmentation with a bounding box prior[C]∥Proc of IEEE 12th International Conference on Computer Vision,2009:277-284.

[2] Ren Zhi-xiang,Gao Shen-hua,Chia Liang-tien.Region-based saliency detection and its application in object recognition[J].IEEE Transactions on Circuits and Systems for Video Technology,2014,24(5):769-779.

[3] Ke Hong-chang, Sun Hong-bin.A video image compression method based on visually salient features[J].Journal of Digital Information Management,2014,12(5):333-343.

[4] Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[5] Achanta R,Hemami S,Estrada F,et al.Frequency-tuned salient region detection[C]∥Proc of IEEE Conference on Computer Vision and Pattern Recognition,2009:1597-1604.

[6] Cheng M M, Mitra N J, Huang X, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015,37(3):569.

[7] Wei Yi-chen,Wen Fang,Zhu Wang-jiang,et al.Geodesic saliency using background priors[C]∥Proc of European Conference on Computer Vision,2012:29-42.

[8] Jiang Huai-zu,Wang Jing-dong,Yuan Ze-jian,et al.Salient object detection:A discriminative regional feature integration approach[C]∥Proc of IEEE Conference on Computer Vision and Pattern Recognition,2013:2083-2090.

[9] Rahtu E,Heikkila J.A simple and efficient saliency detector for background subtraction[C]∥Proc of the 12th IEEE International Conference on Computer Vision,2009:l137-1144.

[10] Wang Jian-peng, Lu Hu-chuan,Li Xiao-hui,et al.Saliency detection via background and foreground seed selection[J].Neurocomputing,2015,152(C):359-368.

[11] Perazzi F, Krähenbühl P,Pritch Y,et al.Saliency filters:Contrast based filtering for salient region detection[C]∥Proc of IEEE Conference on Computer Vision and Pattern Recognition,2012:733-740.

[12] Harel J,Koch C,Perona P.Graph-based visual saliency[C]∥Proc of Conference on Neural Information Processing Systems,2006:545-552.

[13] Xie Yu-lin,Lu Hu-chuan,Visual saliency detection based on bayesian model[C]∥Proc of IEEE International Conference on Image Processing,2011:653-656.

[14] Avidan S,Shamir A.Seam carving for content aware image resizing[C]∥Proc of ACM SIGGRAPH 2007,2007:10-15.

[15] Hamed R T,Esa R,Janne H.Fast and efficient saliency detection using sparse sampling and kernel density estimation[C]∥Proc of SCIA 2011,2011:666-675.

[16] Ran M,Ayellet T,Lihi Z M.What makes a patch distinct?[C]∥Proc of IEEE Conference on Computer Vision and Pattern Recognition,2013:1139-1146.

[17] Yang Chuan,Zhang Li-he,Lu Hu-chuan.Graph-regularized saliency detection with convex-hull-based center prior[J]. IEEE Signal Processing Letters,2013,20(7):637-640.

[18] Aytekin C, Kiranyaz S,Gabbouj M.Automatic object segmentation by quantum cuts[C]∥Proc of International Conference on Pattern Recognition,2014:112-117.

[19] Huang Ying-qing,Liang Xin-bin,Xie Zhi-hong,et al.An FT algorithm based on the characteristics of the normalization of significant value and position of weighted[J].Journal of Ordnance Equipment Engineering,2016,37(6):2096-2304.(in Chinese)

[20] Li Yue-yun,Xu Yue-lei,Ma Shi-ping,et al.The saliency detection based on depth convolution neural network[J].Journal of Image and Graphics,2016,21(1):53-59.(in Chinese)

附中文参考文献:

[19] 黄应清,梁新彬,谢志宏,等.基于特征显著值归一化与位置加权的FT算法[J].兵器装备工程学报,2016,37(6):2096-2304.

[20] 李岳云,许悦雷,马时平,等.深度卷积神经网络的显著性检测[J].中国图象图形学报,2016,21(1):53-59.