基于深度学习的大棚及地膜农田无人机航拍监测方法

2018-03-13韩京冶陈志泊史明昌付红萍

孙 钰 韩京冶 陈志泊 史明昌 付红萍 杨 猛

(1.北京林业大学信息学院, 北京 100083; 2.北京林业大学水土保持学院, 北京 100083)

0 引言

近年来,随着农业现代化的快速发展,设施农业技术逐渐成熟,我国设施农业面积迅速扩大,已成为全球设施农业大国。农业大棚作为新兴的农业设施,具有价格低廉、抵御病虫害、降低气候环境的影响、提高单位面积产量等突出优点[1-2]。同样,地膜作为现代农业重要的生产资料,其蓄水、保温、保墒、保药等作用显著,利于作物早熟,提高产量和品质[2]。2014年我国大棚和地膜覆盖面积近20万km2[3],大棚和地膜农田已经成为重要的土地覆盖类型(地类)。

传统的大棚和地膜覆盖面积信息获取以人工实地测定为主,该方式需要耗费大量的人力、物力,且无法获得准确地理分布情况。准确获取大棚和地膜覆盖面积对于农作物监测、农业产值估算以及政府合理发放补贴具有重要的意义。

随着遥感技术的发展,基于卫星遥感影像的大棚和地膜农田监测方法成为研究热点,AGUERA 等[4]提出一种利用纹理分析提高大棚像素分类精度的方法。黄振国等[5]针对山东寿光大棚菜地,提出了一种基于HJ-1影像的知识分类法,该方法综合了遥感影像的光谱特征、空间结构特征、地物分布规律以及来自专家的经验,其分类总体精度为92.01% 。王志盼等[6]基于Landsat影像提出一种基于增强型水体指数的大棚遥感检测方法,分类总体精度在75%以上。沙先丽[7]提出一种决策树模型,实现了地膜农田信息的提取方法,分类总体精度达到90%以上。尽管方法众多,但卫星遥感影像价格昂贵、获取周期时间长、容易受到自然环境(如云层)影响、分辨率较低,进而影响大棚和地膜农田的识别精度,难以满足小区域、精度要求高的农业监测需求。

无人机(Unmanned aerial vehicle,UAV)是利用无线电遥控设备和自备的程序控制装置操纵的无人驾驶飞机[8],具有机动性强、获取影像分辨率高、时效性高、成本低的优点,越来越多的学者将无人机用于资源调查与监测领域[9-12]。这些基于无人机影像的监测方法,大部分依旧沿用传统卫星遥感解译方法,人工选取特征参数如光谱、纹理、形状等进行分类,不仅需要领域专家的先验知识,而且工程量大。自2012年KRIZHEVSKY等[13]利用深度学习技术刷新了ImageNet大规模视觉识别竞赛的世界纪录以来,深度学习技术在图像分类、图像语义分割等方面已经取得了令人瞩目的成就。图像语义分割是将像素按照图像中表达的含义进行分组,属于像素级别的分类。利用卷积神经网络(Convolution neural network, CNN)的分割方法[14],在PASCAL VOC 2012图像分割数据集上的mIoU(Mean intersection-over-union)达到51.6%,达到当时最佳的性能。但CNN对于小目标识别精度不够且计算效率低下。基于全卷积神经网络的图像语义分割方法[15],将mIoU提高到62.2%。文献[16]将全连接的条件随机场(Conditional random field, CRF)作为FCN的后处理的方法,将mIoU提高到66.4%。文献[17]实现端到端训练FCN和CRF的分割方法,将mIoU提高到74.7%。但CRF具有训练代价大、复杂度高的缺点,对于高分辨率的无人机影像,存在计算成本大、处理耗时长等问题。

针对现有无人机航拍监测研究存在特征选择复杂、识别精度较低、处理时间较长等不足,本文基于深度学习图像语义分割算法,提出一种端到端的无人机影像大棚和地膜农田识别方法。选用赤峰市王爷府镇大棚和地膜农田无人机航拍影像,其中大棚与该区域的广场石砖颜色相近,地膜农田间隙中的土地与普通耕地特征相近,同时影像分辨率高、细节丰富、数据量大,使研究具有典型性和代表性。针对数据集的特点,提出一套完整的无人机航拍监测方法,构建全卷积神经网络,从数据中自动学习特征,将像素按照影像中表达语义的不同进行分割,获得更为准确的大棚和地膜覆盖面积及地理分布信息。

1 数据材料

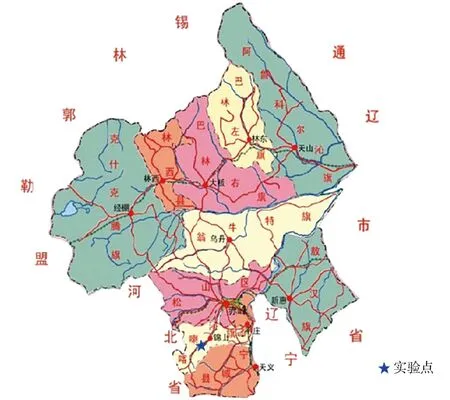

1.1 研究区概况

图1 研究区位置Fig.1 Location of study area

1.2 数据获取与预处理

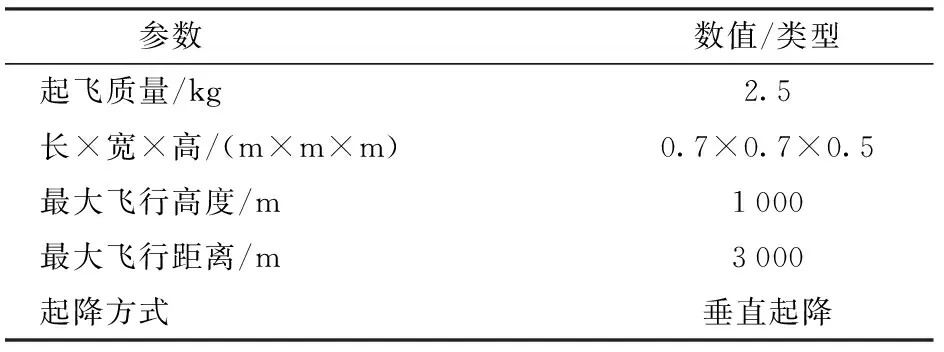

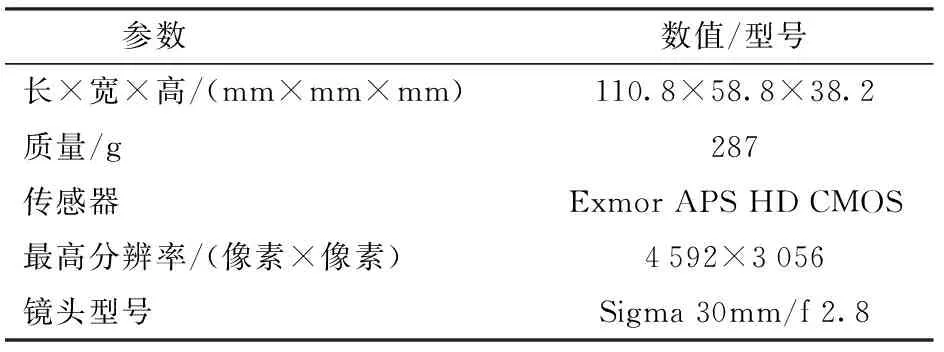

采用六旋翼无人机,搭载索尼NEX-5k相机,详细参数见表1、2。无人机按照规划好的航线飞行,飞行高度300 m,飞行速度5 m/s,镜头垂直航拍,航拍影像为RGB图像,其空间分辨率为8 cm。

表1 无人机主要参数Tab.1 Main specifications of UAV

表2 索尼NEX-5k相机主要参数Tab.2 Main specifications of Sony NEX-5k camera

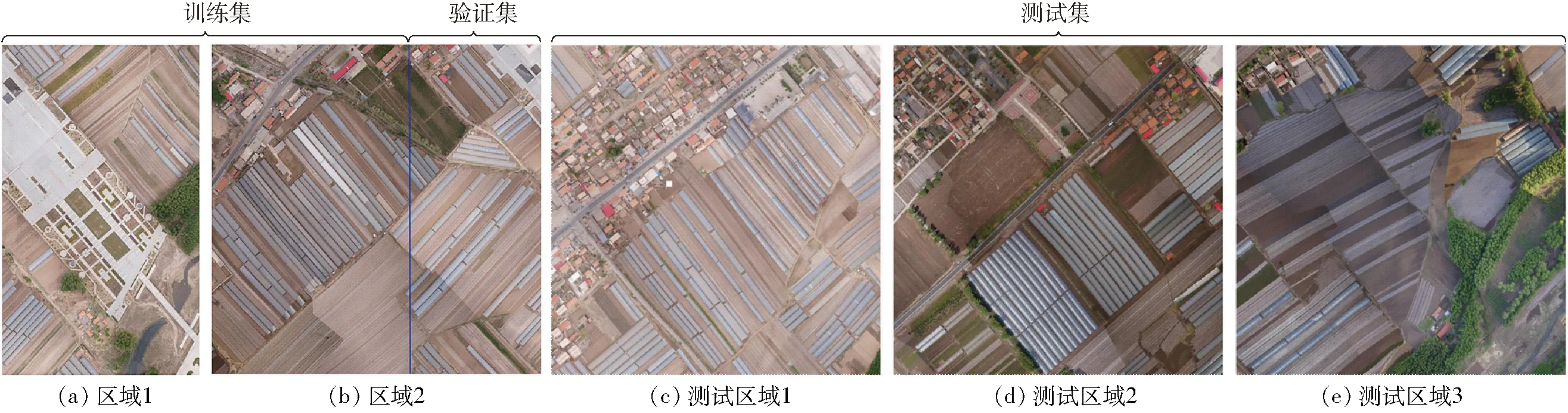

图2 无人机航拍影像Fig.2 UAV aerial images

无人机航片通过商用无人机图像拼接软件Pix4Dmapper进行正射校正和拼接处理:首先导入筛选后的无人机航片并添加地理位置信息,通过空中三角测量法自动实现控制点加密,结合地面控制点数据实现航片的几何校正,最终生成正射影像。本研究选择5块典型区域,区域1为3 000像素×5 000像素(图2a),覆盖面积为0.096 km2。区域2为5 000像素×5 000像素(图2b),覆盖面积为0.16 km2。测试区域1、2、3均为5 000像素×5 000像素(图2c、2d、2e),覆盖面积均为0.16 km2,各区域均无交集。

2 识别方法

2.1 全卷积神经网络(FCN)

采用全卷积神经网络实现像素级别的分类。FCN具有和CNN相同的构建块,即卷积层和下采样层。卷积层是深度神经网络的核心,用于提取图像的颜色、纹理、形状等特征,下采样层用于减小特征的大小并减少网络所需的计算量,也用于防止过拟合。目前FCN主要是基于现有卷积神经网络如AlexNet[13]、VGGNet[18]、GoogleNet[19]和ResNet[20],然后进行微调操作来实现语义分割任务。

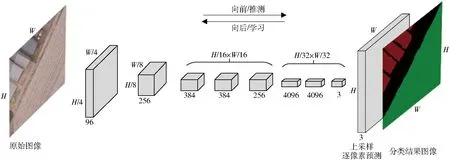

FCN与CNN区别在于,CNN在卷积层之后使用全连接层得到固定长度的特征向量进行分类,但这样会丢失空间信息;而FCN把全连接层替换成卷积层后,对最后一个卷积层的特征图进行上采样,使它恢复到输入图像相同的大小,从而每个像素都有一个预测值,并保留了原始输入图像中的空间信息,实现逐像素分类,如图3所示。

图3 FCN基本结构Fig.3 Basic structure of FCN

2.2 多尺度特征融合

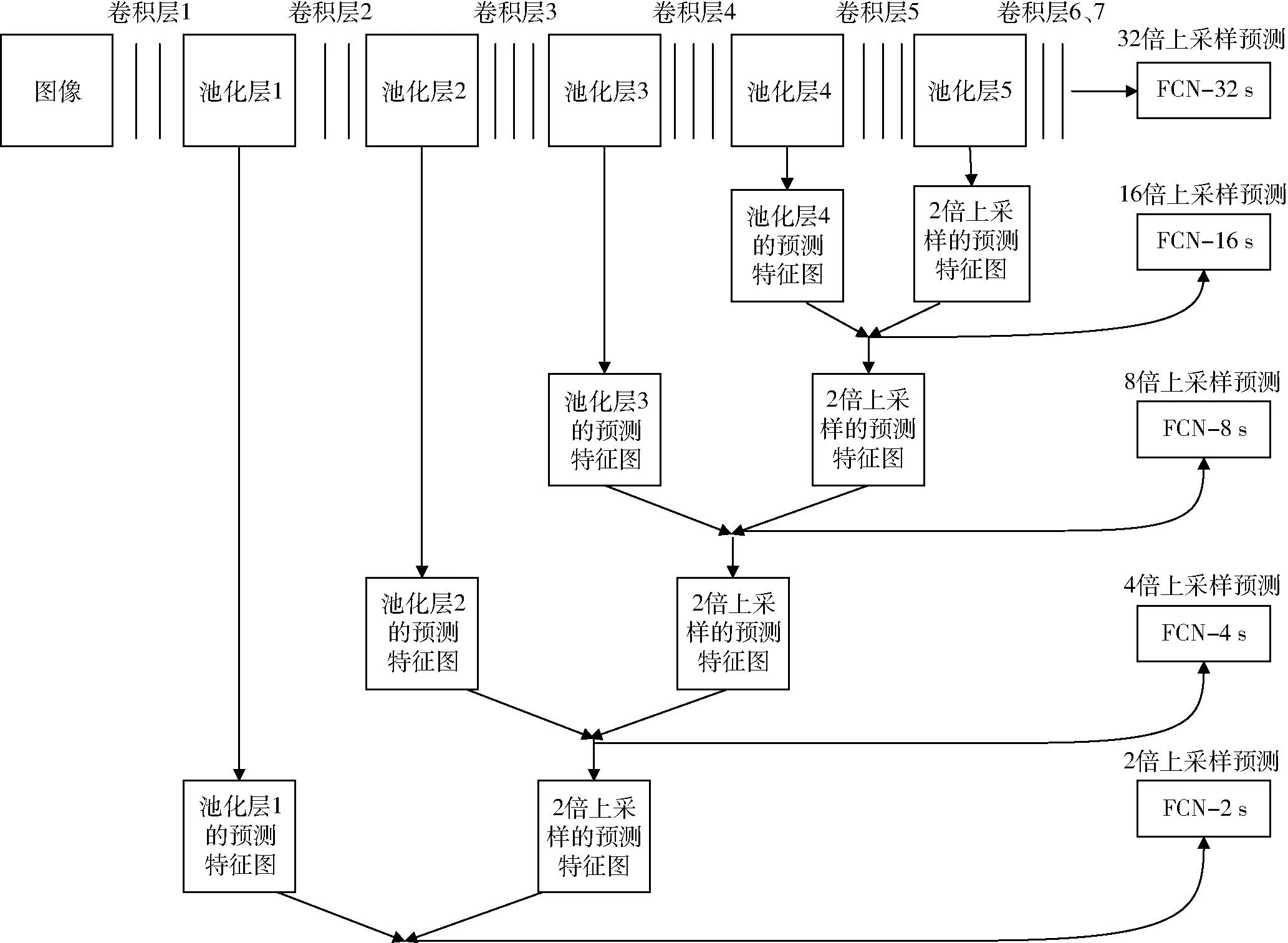

图4 多尺度特征融合示意图Fig.4 Multi-scale feature illustration

由于高分辨率无人机影像具有很多细节信息,如低矮的农作物、车辆等。如果直接将全卷积后的结果进行反卷积,会丢失很多细节特征,得到的结果比较粗糙。因此为了提取影像中细节信息,本文在反卷积时采取融合一部分较浅层的细节特征信息的方法优化输出。如图4所示,考虑大棚和地膜农田无人机影像与PASCAL VOC 2012数据集有较大差异,因此在原有的FCN-32s、FCN-16s、FCN-8s 3种网络结构模型的基础上,融合了更浅层的特征图实现了FCN-4s、FCN-2s 2种网络结构模型,然后通过实验确定最适合大棚和地膜农田识别任务的FCN模型。

3 实验

分别对融合不同尺度细节特征的FCN-32s、FCN-16s、FCN-8s、FCN-4s、FCN-2s网络结构模型进行训练,完整实验流程如图5所示。

图5 实验流程图Fig.5 Experiment flow chart

3.1 数据集划分与数据标注

考虑到实验运行时间和配合网络结构等因素,将5块区域的影像分割成若干个500像素×500像素的图像,如图2所示,训练集为120幅,验证集为40幅,测试集为300幅。

2.1.3 采样方法。按照土壤样品采集技术规范,以怀安县太平庄乡的2块地、阳原县大田洼乡的2块地共4块地为试验地块,分别在每块地的15和30 cm深度层面上随机抽取5个位置,在每个位置上选择3个不同点,然后将15个点得到的土壤按相同的重量混合在一起,获得该地块相应深度层面的混合土壤样本,重量以1 kg为宜,相同样本采集3个,每块地2个深度得到混合土壤样本6个,4块地共得到24个混合土壤样本。

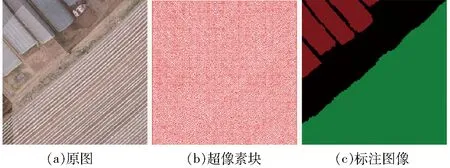

图6 数据标注流程Fig.6 Data annotation procedure

由于无人机影像分辨率高、细节清晰,本文采用人工目视分类为主、地面调查的结果为辅的方式对影像进行像素级语义标注,作为实验分割标准。首先使用零参数的简单线性迭代聚类的超像素图像分割算法[21],自适应地选择每个超像素的紧凑度参数,将无人机影像(图6a)分成10 000块紧凑、均匀尺寸的超像素(图6b),得到的超像素边缘更加规整,提高了标注效果。通过标注每个超像素的类不仅能确定出整幅图的类别区域,而且会大幅度地提升标记速度。然后进行颜色填充,其中背景类的RGB值为(0,0,0),大棚类的RGB值为(128,0,0),地膜农田类的RGB值为(0,128,0),生成标注图像(图6c)。

3.2 模型训练

本实验采取Linux下的Chainer深度学习平台[22],考虑到无人机影像数据量大,计算时间长,因此采用NVIDIA Titan X GPU加速模型训练,其中FCN的初始模型为VGG-16,使用在ImageNet数据集[23]上的预训练模型进行微调,选用随机梯度下降优化算法(Stochastic gradient descent,SGD),并引入动量进行优化,其中动量为0.99,学习率为1×10-10。原始的SGD算法将训练集分成多个批量,每次利用一个批量的样本数据更新参数,公式定义为

xt+1=xt+Δxt

(1)

其中

Δxt=-ηgt

(2)

式中,η是学习率,gt是x在t时刻的梯度,利用一个批量数据更新可以减少计算量并提升收敛速率。但SGD最大的缺点在于每次更新依赖当前的批量,可能按照错误的方向进行。因此本文引入动量改进的SGD算法,更新时在一定程度上保留之前的更新方向,并微调当前批量梯度的更新方向,公式定义为

Δx=ρΔxt-1-ηgt

(3)

其中ρ为动量,表示在多大程度上保留原有的更新方向。因此带动量的SGD算法增加了稳定性、学习速度更快。本实验选用交叉熵作为损失函数,用于衡量神经网络的预测值与实际值差异,公式定义为

(4)

其中

(5)

式中n——训练数据个数

y——期望的输出σ——激活函数

a——神经元实际输出

wi——权重向量xi——输入向量

b——偏置向量

4 结果与分析

为验证本文方法的有效性以及泛化能力,选择无交集的测试区域1、2、3作为测试集进行实验验证。对5种FCN网络结构模型进行训练和评估,并与目前广泛应用的ENVI软件和eCognition软件的识别效果进行比较。同时采取整体正确率和混淆矩阵两种方法来评判识别精度效果。

4.1 大棚、地膜农田识别结果

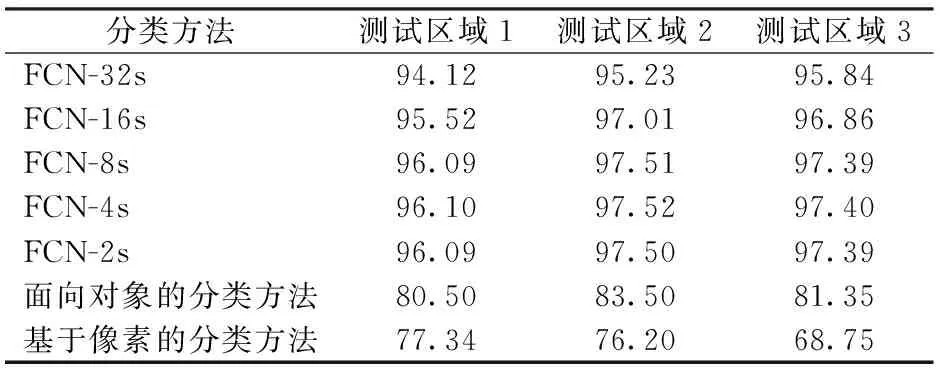

利用ENVI软件进行基于像素的分类方法的对比实验,通过软件中ROI工具在测试区域影像上添加感兴趣区(Regions of interest , ROI),通过ENVI软件中分类器自带的支持向量机(Support vector machine, SVM)方法进行分类。然后利用eCognition软件进行面向对象的分类方法的对比实验,进行影像分割,并通过试误法确定多尺度分割的最佳参数:分割尺度为200、形状权重为0.4、紧致度权重为0.5。影像中大棚、地膜农田在几何和纹理等特征方面与其它地物有明显区别,因此对分割后的影像进行光谱、纹理和形状的特征提取,其中光谱特征包括各波段均值、标准差、比率、亮度等信息,在高分辨率无人机影像中能够提取丰富纹理特征,弥补光谱数据少的缺点,形状特征为长宽比、形状指数等,并采用SVM方法进行分类。最后对5种FCN模型进行分类实验,统计各方法的整体正确率,如表3所示。5种FCN模型中,FCN-4s整体识别率最高,为96.10%、97.52%、97.40%,而FCN-32s的整体识别率最低。FCN-4s相比FCN-32s融合了更多细节特征进而优化识别效果。从表3中可以观察到随着融合细节特征的增加,FCN-32s、FCN-16s、FCN-8s、FCN-4s整体正确率逐渐提升,但FCN-2s获取的过多浅层细节特征无助于正确率的进一步提升。

表3 各方法的整体正确率Tab.3 Overall accuracy of each method %

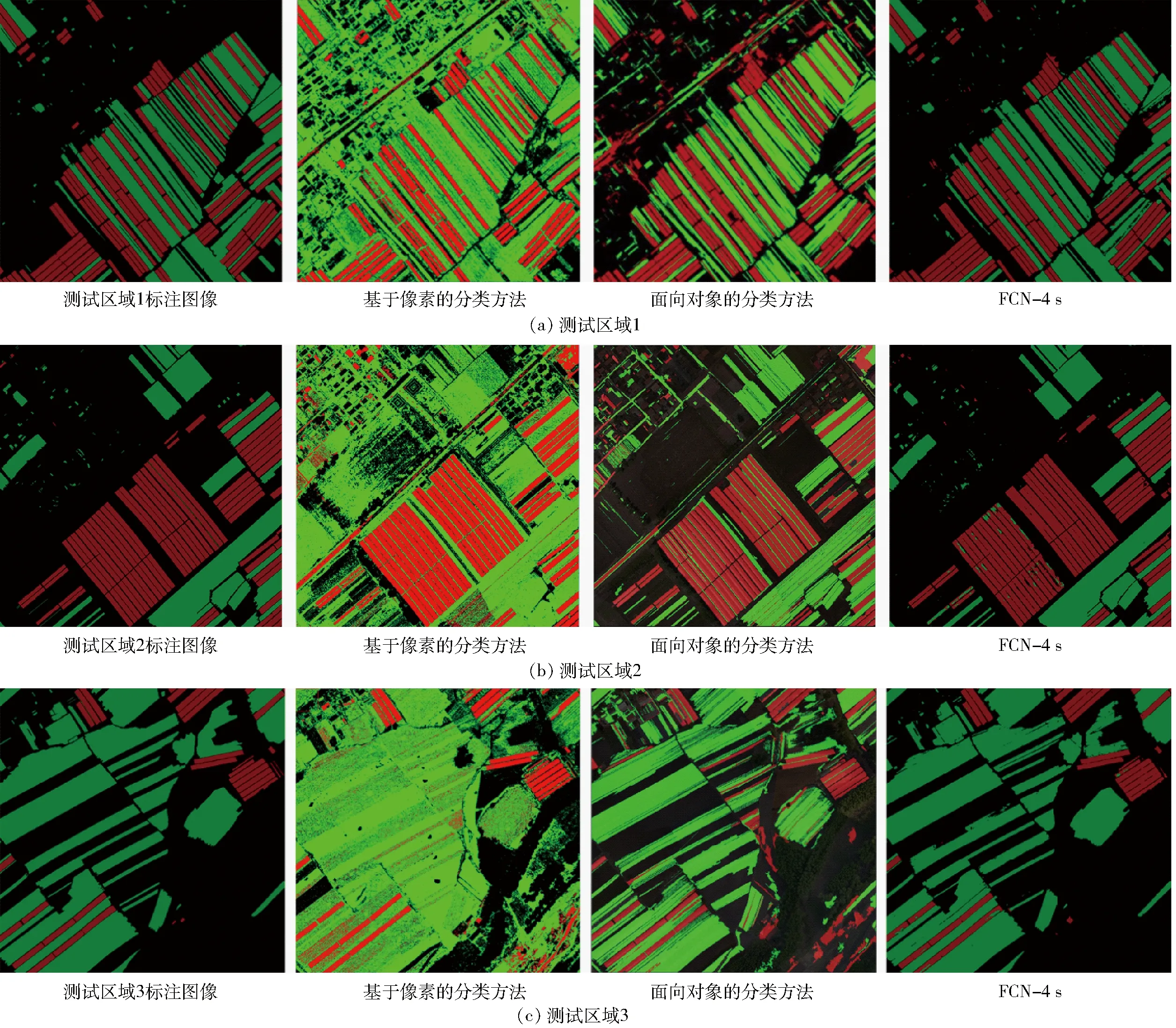

图7为识别效果图,通过对比可知,FCN-4s在3种方法中识别效果最好,基于像素的分类方法识别结果较差,出现椒盐现象和碎片化,面向对象的分类方法虽然明显改善椒盐现象,但对于地膜农田和背景的分类存在大量错分情况。

图7 测试集识别结果对比Fig.7 Comparisons of experimental results on test set

4.2 实验结果分析

4.2.1识别精度评价

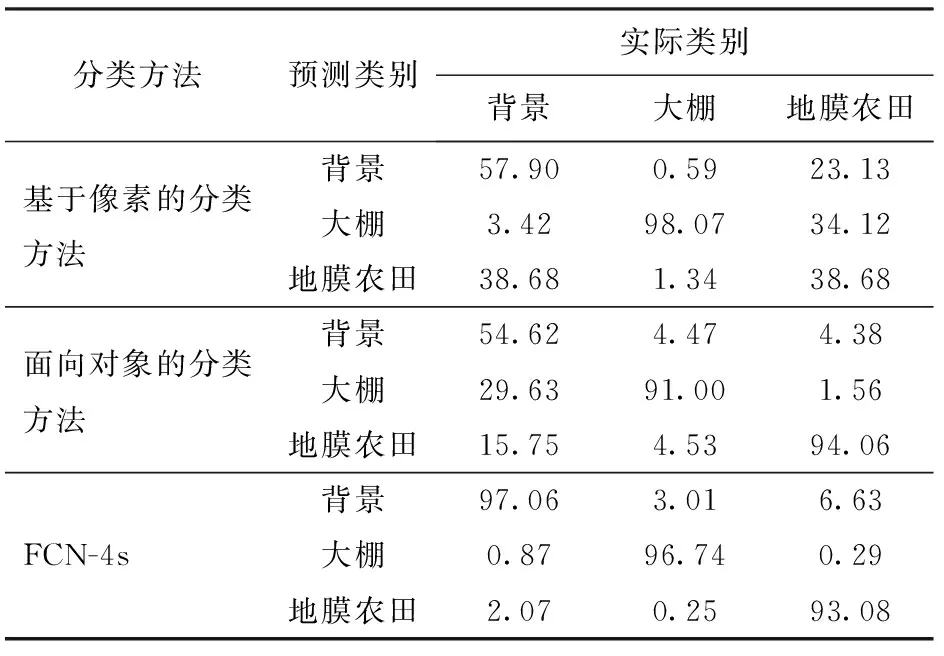

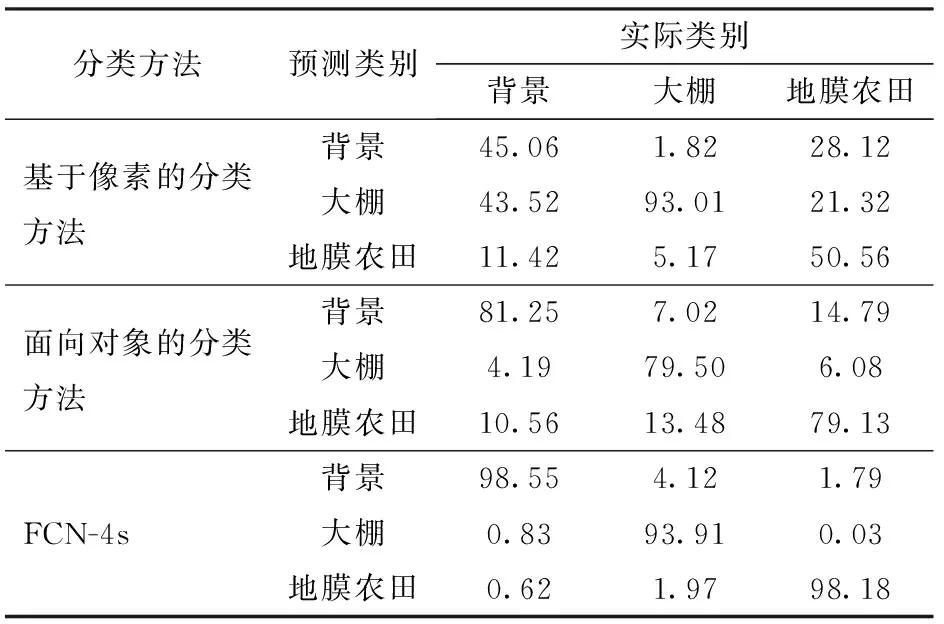

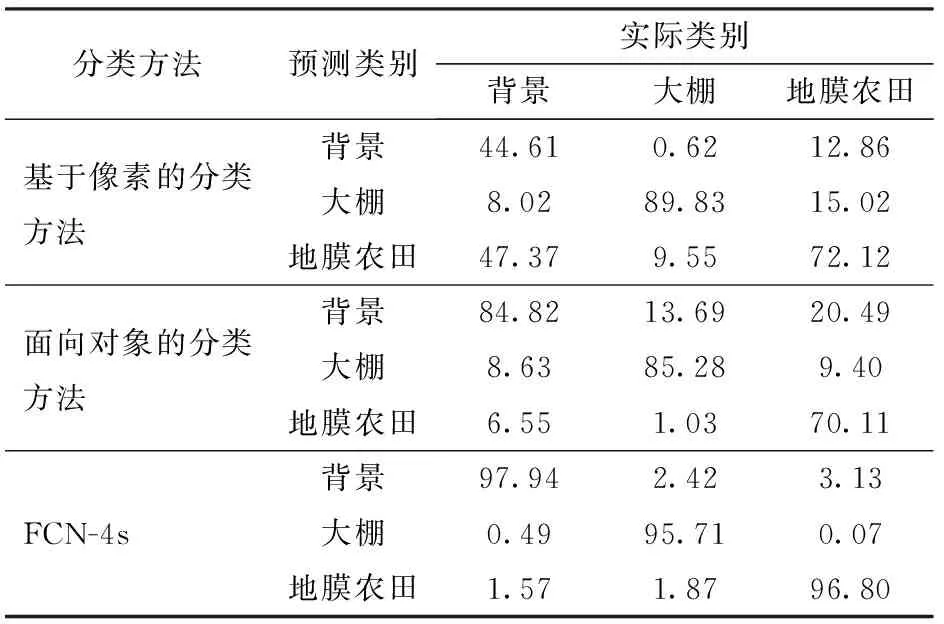

采用混淆矩阵的方法进行分析,混淆矩阵的行代表分类器预测出的类别,列代表实际类别。由表4~6可知,对于测试区域1、2、3,FCN-4s对背景的识别精度为97.06%、98.55%、97.94%,对大棚识别精度为96.74%、93.91%、95.71%,对地膜农田识别精度为93.08%、98.18%、96.80%。而基于像素的分类方法对于大棚的识别效果较好,但对于背景和地膜农田效果较差,两者存在大量错分现象。面向对象的分类方法相比基于像素的分类方法对地膜农田识别精度有明显提升,但对背景类识别效果依旧较差,主要原因是背景类(包含裸地和未覆盖地膜的农田)与地膜农田特征相近,增加了错分的可能。实验结果证明,本文FCN-4s模型识别效果明显优于上述两种方法,对背景和地膜农田的错分情况有显著改善。

4.2.2识别速度评价

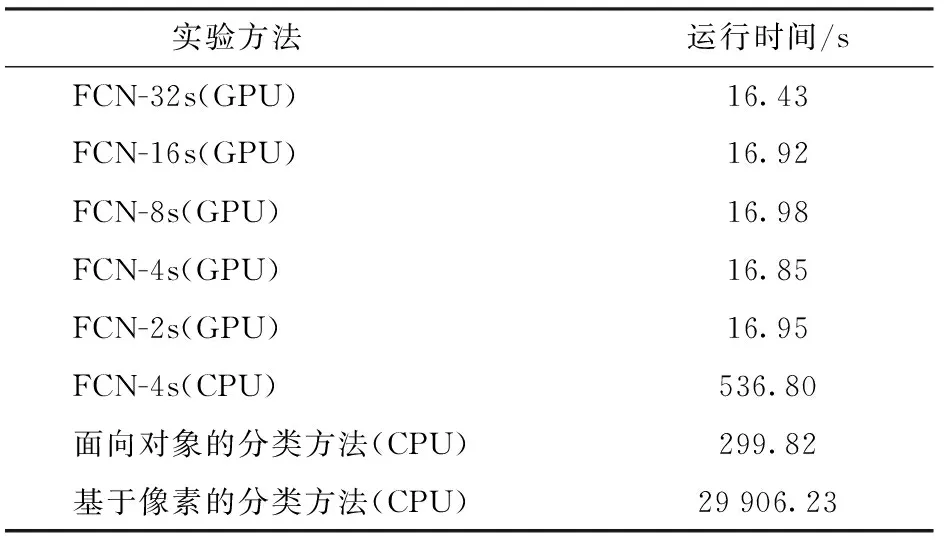

为验证模型的识别效率,将5种FCN模型分别对测试集进行100次实验,统计运行时间,并与基于像素的分类方法、面向对象的分类方法进行比较。相比ENVI和eCognition遥感软件,本文方法采用GPU加速对模型的训练和识别。由表7可知,5种FCN模型运行时间均明显小于面向对象的分类方法和基于像素的分类方法的运行时间。通过对比5种FCN模型的平均运行时间,FCN-32s模型用时最少,为16.43 s,FCN-4s次之,为16.85 s。同时统计了整体正确率最高的FCN-4s模型不进行GPU加速的平均运行时间,为536.80 s。因此利用GPU加速能够有效地提升模型的识别速度。

表4 测试区域1实验结果的混淆矩阵Tab.4 Confusion matrix of experiment results in test region 1 %

表5 测试区域2实验结果的混淆矩阵Tab.5 Confusion matrix of experiment results in test region 2 %

表6 测试区域3实验结果的混淆矩阵Tab.6 Confusion matrix of experiment results in test region 3 %

5 结论

(1)利用无人机采集高分辨率、低成本的航拍影像弥补了卫星遥感影像分辨率低、成本高、获取周期长的缺点。提出一种基于深度学习的大棚及地膜农田无人机监测方法,利用全卷积神经网络自动提取和学习图像的颜色、纹理、形状等特征,避免了传统分类方法复杂的特征选择过程,实现模型端到端训练。

表7 各方法的平均运行时间Tab.7 Average runtime of each method

(2)采用多尺度的特征融合方法,实现了5种FCN模型,通过实验选择出识别效果最好的FCN模型:FCN-4s。该模型通过融合适量底层细节信息特征,得到了较好的识别效果,对于测试区域1、2、3,本方法的平均整体正确率为97%,明显高于基于像素分类方法和面向对象的分类方法,对大棚及地膜农田有较好的识别效果。

(3)本文方法识别速度较快,利用GPU加速等手段优化了模型的识别速度,运行时间明显小于基于像素的分类方法和面向对象的分类方法的运行时间。

(4)研究结果表明,本方法能够满足对大棚和地膜农田监测的要求,具有广泛的应用前景。

1 王勉. 高效设施农业发展现状及趋势分析[J]. 经济论坛, 2012, 2(2): 108-111.

WANG Mian.The development status and trend of high efficiency facility agriculture[J].Economic Forum,2012,2(2):108-111.(in Chinese)

2 李中华, 王国占, 齐飞. 我国设施农业发展现状及发展思路[J]. 中国农机化, 2012,34(1): 7-10.

LI Zhonghua,WANG Guozhan,QI Fei.Current situation and thinking of development of protected agriculture in China[J].Chinese Agricultural Mechanization,2012,34(1):7-10.(in Chinese)

3 赵爱琴, 魏秀菊, 朱明. 基于Meta-analysis 的中国马铃薯地膜覆盖产量效应分析[J].农业工程学报, 2015, 31(24):1-7.

ZHAO Aiqin,WEI Xiuju,ZHU Ming. Meta-analysis on impact of plastic film on potato yield in China[J]. Transactions of the CSAE, 2015, 31(24):1-7.(in Chinese)

4 AGUERA F, AGUILAR F J, AGUILAR M A. Using texture analysis to improve per-pixel classification of very high resolution images for mapping plastic greenhouses[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2008, 63(6): 635-646.

5 黄振国,陈仲新,刘芳清,等.基于HJ-1影像的大棚菜地遥感监测技术研究[J].中国农业资源与区划, 2013,34(5):102-106.

HUANG Zhen’guo,CHEN Zhongxin,LIU Fangqing, et al.Monitoring of greenhouse vegetables land using HJ-1 remotely-sensed imagery[J].Chinese Journal of Agricultural Resources and Regional Planning,2013,34(5):102-106.(in Chinese)

6 王志盼,张清凌,钱静,等.基于增强型水体指数的大棚遥感检测研究——以广东江门地区为例[J].集成技术,2017,6(2):12-21.

WANG Zhipan,ZHANG Qingling,QIAN Jing,et al.Greenhouse extraction based on the enhanced water index—a case study in Jiangmen of Guangdong[J].Journal of Integration Technology,2017,6(2):12-21.(in Chinese)

7 沙先丽.地膜农田遥感信息提取及覆膜地表温度反演[D]. 杭州:浙江大学, 2012.

SHA Xianli.A study on extraction of plastic-mulched landcover and in retrieval of mulched land surface temperature using remote sensing data[D].Hangzhou:Zhejiang University,2012.(in Chinese)

8 WATTS A C, AMBROSIA V G, HINKLEY E A. Unmanned aircraft systems in remote sensing and scientific research: classification and considerations of use[J]. Remote Sensing, 2012, 4(6): 1671-1692.

9 刘峰,刘素红,向阳.园地植被覆盖度的无人机遥感监测研究[J/OL].农业机械学报,2014,45(11):250-257. http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20141139&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2014.11.039.

LIU Feng,LIU Suhong,XIANG Yang.Study on monitoring fractional vegetation cover of garden plots by unmanned aerial vehicles[J/OL].Transactions of the Chinese Society for Agricultural Machinery,2014,45(11):250-257.(in Chinese)

10 HUNG C, XU Z, SUKKARIEH S. Feature learning based approach for weed classification using high resolution aerial images from a digital camera mounted on a UAV[J]. Remote Sensing, 2014, 6(12): 12037-12054.

11 鲁恒, 付萧, 贺一楠, 等. 基于迁移学习的无人机影像耕地信息提取方法[J/OL]. 农业机械学报, 2015, 46(12): 274-279.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20151237&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2015.12.037.

LU Heng,FU Xiao,HE Yi’nan,et al.Cultivated land information extraction from high resolution UAV images based on transfer learning[J/OL].Transactions of the Chinese Society for Agricultural Machinery,2015,46(12):274-279.(in Chinese)

12 韩文霆, 郭聪聪, 张立元,等. 基于无人机遥感的灌区土地利用与覆被分类方法[J/OL]. 农业机械学报, 2016, 47(11):270-277.http:∥www.j-csam.org/jcsam/ch/reader/view_abstract.aspx?flag=1&file_no=20161137&journal_id=jcsam.DOI:10.6041/j.issn.1000-1298.2016.11.037.

HAN Wenting,GUO Congcong,ZHANG Liyuan,et al.Classification method of land cover and irrigated farm land use based on UAV remote sensing in irrigation[J/OL].Transactions of the Chinese Society for Agricultural Machinery,2016,47(11):270-277.(in Chinese)

13 KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]∥Advances in Neural Information Processing Systems, 2012: 1097-1105.

14 HARIHARAN B, ARBELAEZ P,GIRSHICK R, et al. Simultaneous detection and segmentation[C]∥European Conference on Computer Vision. Springer International Publishing, 2014: 297-312.

15 LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

16 CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected crfs[C] ∥International Conference on Learning Representations (ICLR), 2015.

17 ZHENG S, JAYASUMANA S, ROMERAP B, et al. Conditional random fields as recurrent neural networks[C]∥Proceedings of the IEEE International Conference on Computer Vision,2015: 1529-1537.

18 SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]∥International Conference on Learning Representations (ICLR),2015.

19 SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

20 HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

21 ACHANTA R, SHAJI A, SMITH K, et al. SLIC Superpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282.

22 TOKUI S, OONO K, HIDO S, et al. Chainer: a next-generation open source framework for deep learning[C]∥Proceedings of workshop on machine learning systems (LearningSys) in the twenty-ninth annual conference on neural information processing systems (NIPS), 2015:1-6.

23 RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252.