基于立体图像显著区域的舒适亮度定量研究

2018-03-09李素梅朱兆琪

李素梅,朱兆琪

(天津大学电气自动化与信息工程学院,天津 300072)

近年来立体成像技术快速发展,然而,长时间观看立体图像/视频会导致观看者产生头痛、视觉疲劳等不适.立体图像内容的舒适与否关系到观看者的观看体验和生理健康,已成为立体显示技术急需解决的任务之一[1].

立体图像舒适度的研究分为3类:建立舒适度模型[2-5]的方法、结合脑电评价立体图像舒适度[6-8]和舒适度影响因素定量研究的方法.影响立体图像舒适度的因素有很多,如亮度、色度、对比度和视差等[9-13].国内外许多专家学者对影响立体图像舒适度的各种因素进行了研究.Kooi等[9]通过实验系统地研究了亮度、色度、对比度、视差等因素对图像舒适度的影响,得出当左右视图不匹配达到一定程度时会导致观看的不舒适.Jung等[10]基于人类深度感知,探究了立体图像中显著物体的视差大小对图像舒适度的影响,实验结果表明,显著物体的视差较大时图像具有很强的立体感,但是显著物体的大视差也会带来不舒适的体验.李小芳等[11]指出立体图像左右视图的亮度和颜色差异过大会引起观看者视觉疲劳.

目前,对立体图像舒适度的研究大都是定性的,部分文献对影响观看舒适度的各种因素进行了定量研究,但是,此类方法都是基于整幅图像进行研究[14-16]. 没有文献结合人眼视觉注意特性对影响立体图像舒适度的因素进行定量研究.因此,本文首次结合视觉注意机制定量研究了亮度因素对立体图像观看舒适度的影响.该工作首先采用视差图和平面图像显著图相结合的方法最终得到显著立体图像,并利用眼动仪实验验证了立体显著算法提取显著区域的正确性,然后采用改进的逐级逼近法进行主观实验,通过最小二乘法对实验数据进行拟合,得到显著立体图像的舒适亮度匹配图和差异图.

1 实 验

1.1 实验素材及设备

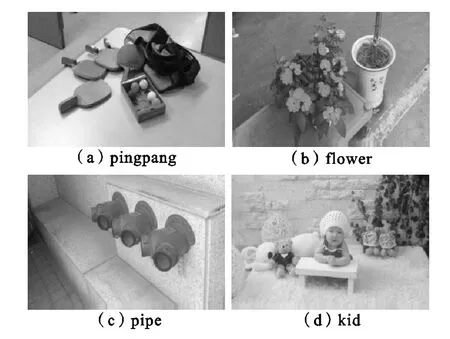

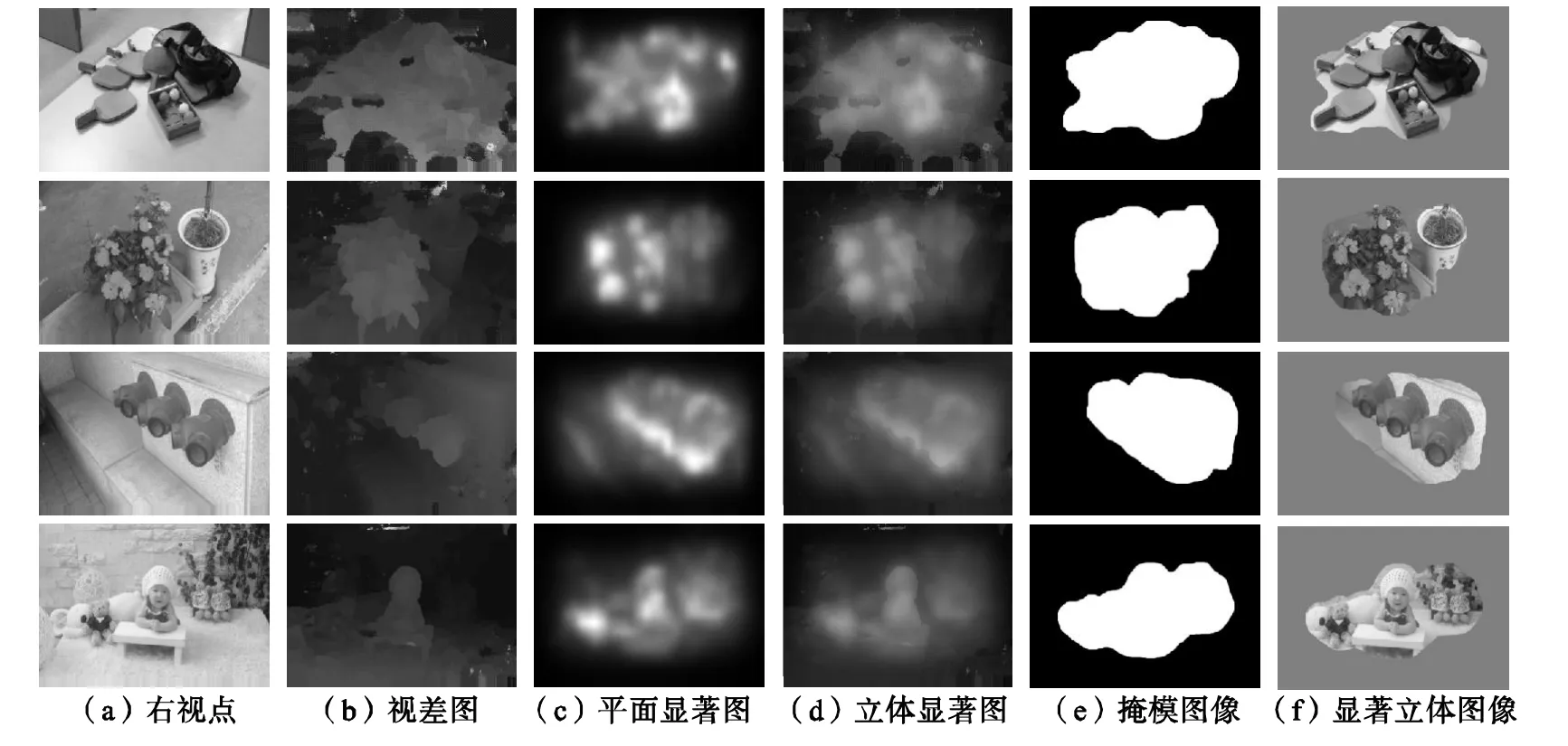

实验选用韩国先进科学技术院所提供的立体图像数据库作为立体图像样本数据集合[17].该图像库包含多种类型的图像(人类、树木、建筑等),由 120对分辨率为 1,920×1,080的立体图像组成,包括 62对室内场景和58幅室外场景.本文选取4幅源立体图像 pingpang、flower、pipe和 kid作为实验用图,如图1所示.这4幅立体图像的立体感强,有很好视觉舒适度.立体显示器采用冠捷(AOC)公司的 22,inch(55.88,cm)偏光式 3D立体显示器,眼动仪为德国SMI公司的iViewXRED.

图1 4幅源立体图像Fig.1 4 pairs of original stereoscopic images

1.2 实验条件及主观评价方法

实验选取双目视觉生理正常的被试者共 22人,其中男性 12人,女性 10人;有立体背景的 8人,没有立体背景的14人,且被试者主眼都是右眼.

为避免杂散光影响被试者的主观评价结果,实验需在暗室中进行[12].对于 22,inch(55.88,cm)全高清显示器,观看距离应为屏幕高度的3倍距离[18].

主观评价是实验定量研究的重要依据.实验前,先对被试者介绍实验评价的方法和评分等级,然后选取舒适度和场景不同的 10幅立体图像训练被试者,使被试者能够正确地理解判断,每次测试不超过30,min[19].测试采用双刺激方法,实验中,若同一被试者对同一立体图像给出相差 2级或者以上的评分时,此分值视为无效评分.根据ITU-R BT.1438立体图像主观评价推荐准则,立体图像舒的适度分为5个等级,如表 1所示.允许被试者给出半分的分值,计算舒适度良好的立体图像有效评分的平均值[18].

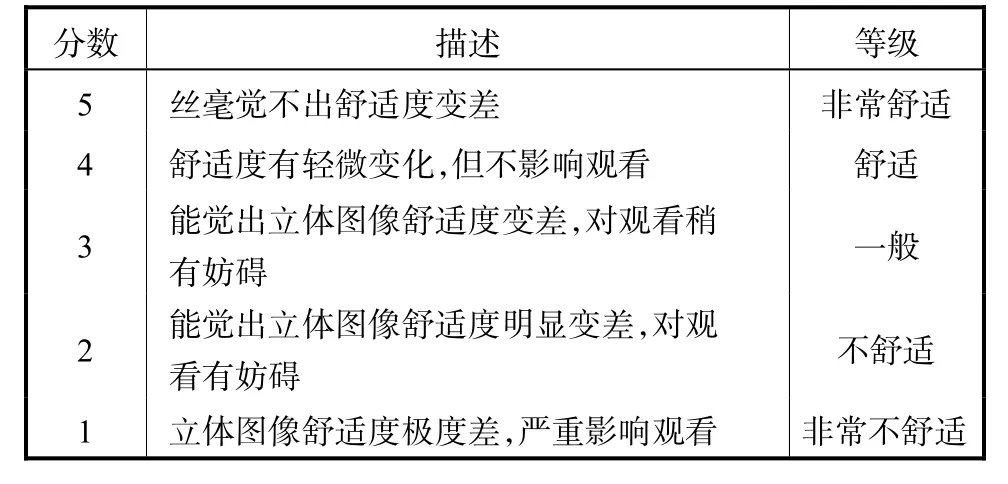

表1 立体图像舒适度主观评价等级Tab.1 Subjective evaluation level of the confort of stereoscopic images

1.3 实验方法

本文实验流程为:①显著立体图像获取,通过算法得到视觉显著区域,并得到显著立体图像;②主观实验,将显著立体图像进行亮度分级变换并进行主观实验;③数据筛选及分析.

1.3.1 显著立体图像的获取

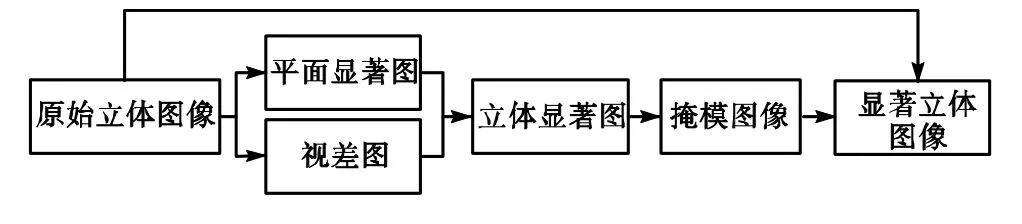

根据人眼的立体视觉注意特性,观察者会对图像中显著区域的内容更为关注[20],因此,可以采用显著立体图像的舒适度来反映整幅立体图像的舒适度情况.与平面图像相比,立体图像的视差特性和图像空间频率都会影响视觉舒适度[21].因此,本文通过立体图像视差图和平面显著图提取立体图像显著区域,最终获得显著立体图像.图 2给出显著立体图像的获取方法.

图2 显著立体图像的获取方法Fig.2 Method for obtaining saliency stereoscopic images

显著立体图像的获取分为左视点显著图与右视点显著图两部分,这里以右视点显著图像获取为例,左视点显著图采用同样的方法.

平面显著图通过图像本身的亮度、色度、对比度和空间频率等因素进行计算.本文采用 GBVS算法[22]得到右视点平面显著图,记为SMR(x,y).采用快速立体匹配算法[23]得到以右视点为基准的视差图,记为dR(x,y).

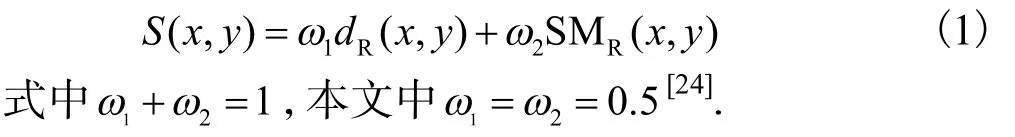

将SMR(x,y)和dR(x,y)加权求和得到立体显著图,如式(1)所示.

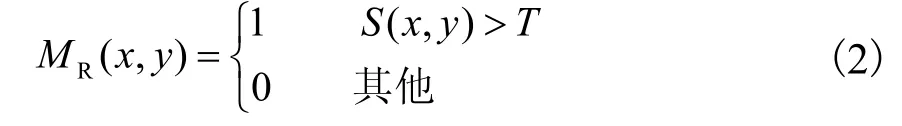

得到的立体显著图为 0~255灰度图像,像素点的灰度值大小表示原始图像中该像素点的显著值,立体显著图所得到像素的显著值分散,为了更明确地确定立体图像中像素点是否为显著点,需要对立体显著图S(x,y)中像素点进行显著与非显著像素分类.采用最大类间方差方法确定立体显著图S(x,y)的阈值T,通过该阈值得到二值化的立体显著图,即掩模图像如式(2)所示.

对于立体显著图S(x,y)的一点(x,y),若该像素点的值大于阈值T,则该像素点归为显著区域,反之则为非显著区域.最后将掩模图像与原始视点图像相乘得到显著立体图,如图3(f)所示.图3分别给出了 4组立体图像右视点、视差图、平面显著图、立体显著图、掩膜图像和显著立体图像.

图3 显著立体图提取图Fig.3 Map of obtaining saliency stereoscopic images

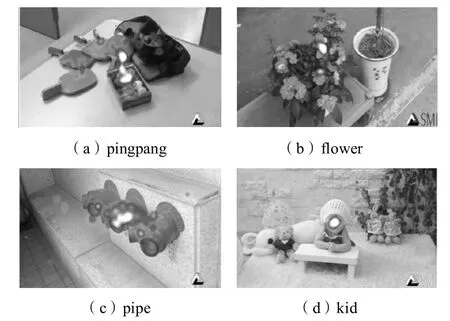

为了验证所得显著立体图像是否为真值,本文采用眼动仪对源立体图像的显著区域进行主观测量.每次实验前先进行校准实验和基准测量,当被试者对校准基准点的观测误差小于 1,°时进行实验.每张图片随机呈现且呈现时间为 5,s.图 4为眼动仪测量出的图像感兴趣区域的热图.

图4 眼动仪实验显著热图Fig.4 Salient hot map of eye tracker experiment

图 4中标记的不同灰度表示被试者关注的程度不同:白色标记的区域为被试者观看时间最长,也是最为显著的部分;灰色标记部分表示较为重要,被试者在实验中对此部分较为感兴趣;深色标记部分表示重要程度较低,但在实验中被试者也对深色标记部分进行了关注;无标记部分表示被试者在实验阶段内对此部分关注很少或没有关注,表示非显著区域.

通过将图 4眼动仪实验显著热图与图 3的立体显著图对比发现,本文算法获得的立体显著区域与主观实验的结果基本一致,表明该方法能够很好地提取立体图像的显著区域,且与主观实验的结论有很强的一致性.

1.3.2 主观实验

人类视觉能分辨的图像灰度等级约为62,所以对灰度等级为256的灰度图像,人类视觉在此灰度等级上平均能分辨的最小亮度为4[25].若以4为步长对立体图像左右视点进行亮度增强和降低的处理,可以各得到128幅亮度变化后的左右视图,左右视图两两组合后可以得到立体灰度图像有 16,384幅,立体图像过多,进行主观实验费事费力.

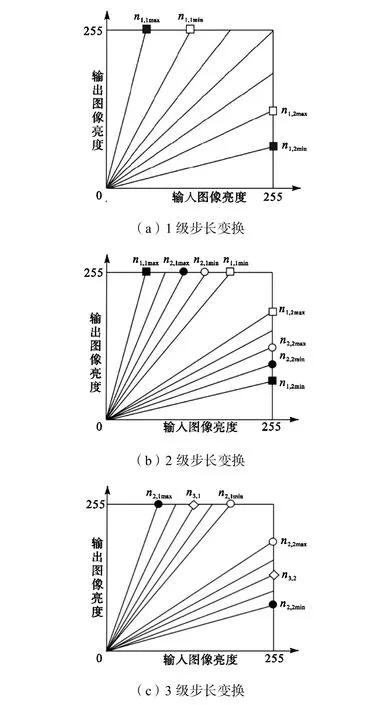

因此本文采用由粗到细的逐级逼近法[14]进行数据处理,该方法的中心思想是先以大步长分级找出立体图像舒适与不舒适亮度的2个边界;然后用小步长将2个亮度边界中间的亮度值细化,再次找出小步长舒适与不舒适的亮度边界;进行多次细化与实验,最终达到人眼的最小亮度分辨率,找出舒适与不舒适亮度的亮度值.

采用逐级逼近法,将步长逼近级数分为 3[14].采用3级步长对立体图像亮度进行线性变换.

实验使用 MATLAB2014,b处理立体图像,处理步骤如下.

步骤 1选取源立体图像,得到立体显著图并最终得到掩模图像.

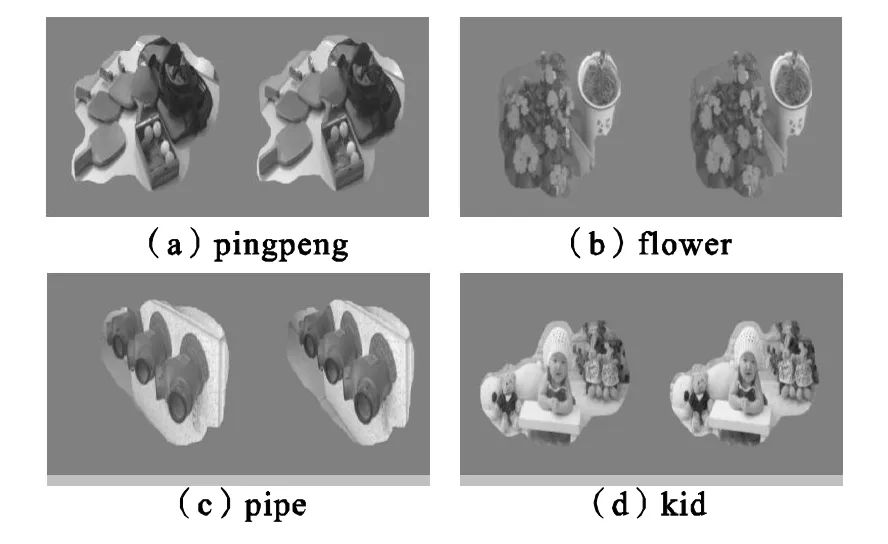

步骤 2将立体图像进行颜色空间变换,由RGB空间转换到 YUV颜色空间,提取出图像亮度Y.根据步骤1中的掩模图像确定图像的显著与非显著部分.显著区域为源立体图像中对应的像素,非显著部分用灰度为128的图像进行覆盖,如图5所示.

图5 显著立体图像Fig.5 Saliency stereoscopic images

步骤 3按图 6(a)对显著立体灰度图像中左右视点的显著部分按第1级步长进行线性变换,各得到9幅 1级左右灰度视图,两两组合后可以得到 81幅显著立体灰度图像.

步骤 4进行主观评分,去除无效评分,选取统计评分的立体灰度图像.

步骤 5分别记录 1级灰度变化后符合要求的左右灰度视图的最大和最小灰度值

步骤 6按图 6(b)对显著立体灰度图像中左右视图的显著部分按第2级步长进行线性变换,各得到10幅图像,两两组合共可以得到 100幅 2级立体图像,重复步骤4进行主观实验.

步骤 7分别记录第 2级灰度变化后符合要求的左右灰度视图的最大和最小灰度值

步骤 8图 6(c)对显著立体灰度图像中左右视图的显著部分按第 3级步长进行线性变换,各得到10幅图像,两两组合共可以得到 100幅 3级立体图像,重复步骤4进行主观实验.

图6 图像亮度3级步长逼近Fig.6 Three-step approximation of image brightness

步骤 9分别记录 3级灰度变化后符合要求的左右灰度视图的最大和最小灰度值n3,1、n3,2.

采用 3级步长逼近法共得到281幅立体灰度图像,远小于理论上极限法得到的立体灰度图像数量,大大减少了实验的数量,而且也能得到很好的实验结果.

2 实验数据分析

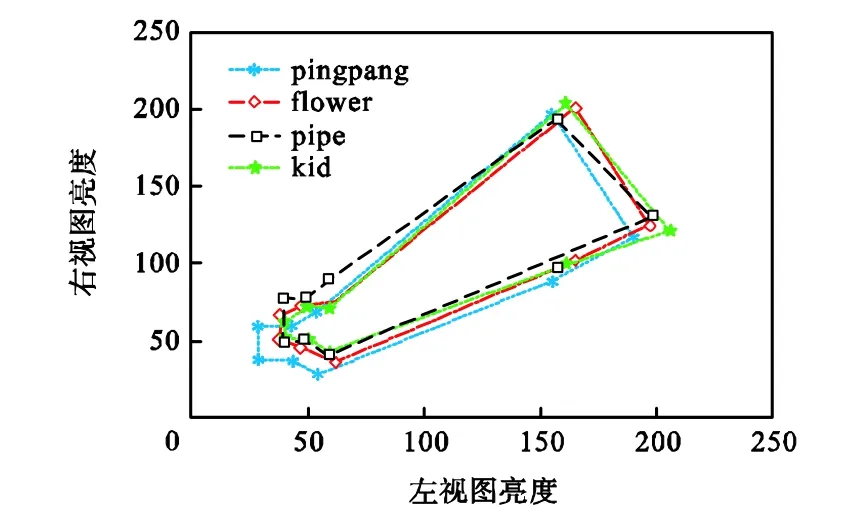

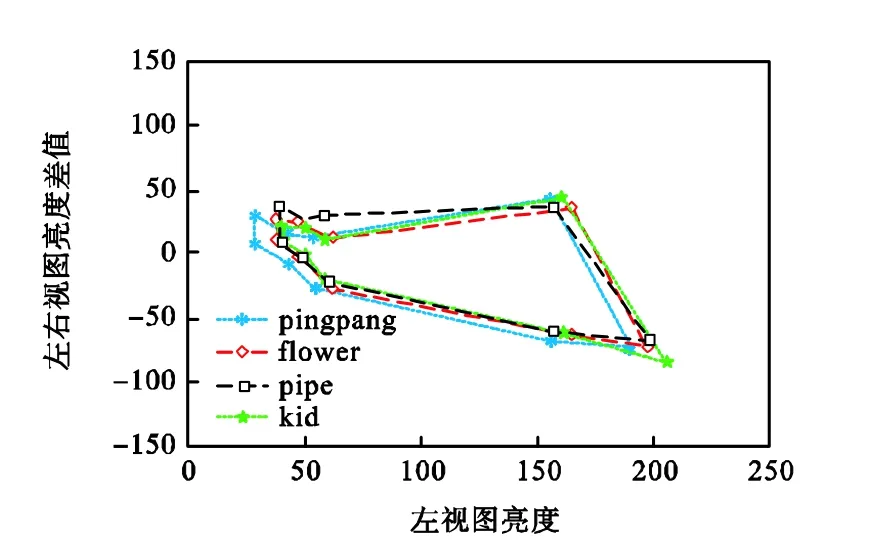

对实验数据采用最小二乘分段线性拟合来进行处理[26],其基本思想是将所测数据用分段的直线来逼近以便获得相应的数学模型,而直线段的拟合仍采用最小二乘法.运用最小二乘法对 4组实验数据进行处理,得到 4幅不同的亮度匹配图和亮度差异图,见图7~图10.

图7 4组立体图像舒适亮度匹配图Fig.7 Comfortable brightness matching map of four groups of stereoscopic images

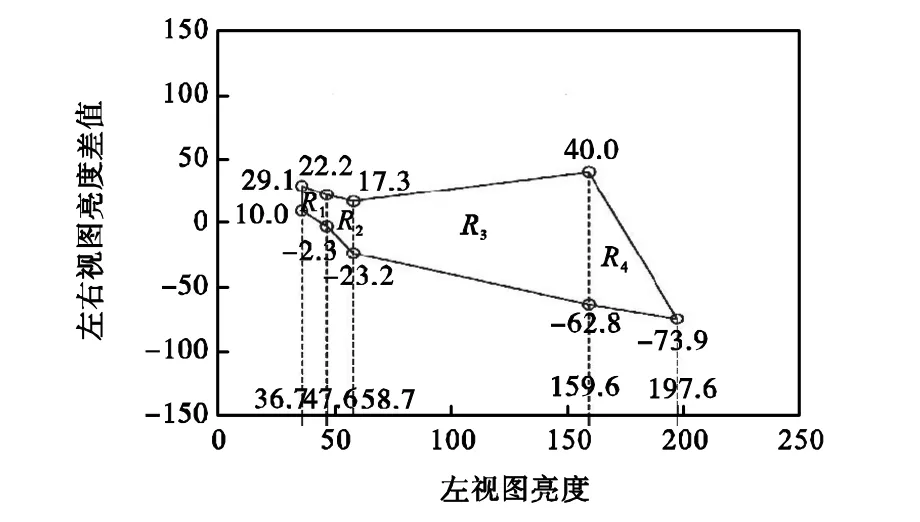

图8 4组立体图像舒适亮度差异图Fig.8 Comfortable brightness matching map of four groups of stereoscopic images

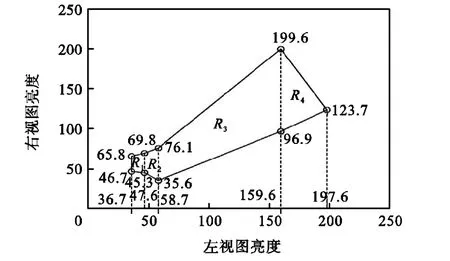

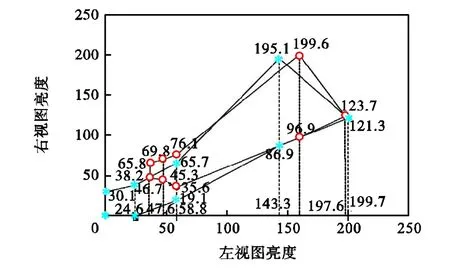

图9 立体图像舒适亮度匹配图Fig.9 Comfortable brightness matching map of stereoscopic images

图7为4组立体图像舒适亮度匹配图,横坐标为左视点显著区域的平均亮度,纵坐标为右视点显著区域的平均亮度值.图中分段直线包围的区域表示左右视图显著区域的平均亮度.在此范围中,立体图像成像后舒适度良好.图 8为 4组立体图像舒适亮度差异图,表示当立体图像舒适度良好时右视点显著区域亮度与左视点显著区域亮度的差值范围,水平轴(过纵轴零点水平线)表示左右视点显著区域亮度相同.水平轴上方表示右视点显著区域比左视点显著区域亮度大,水平轴下方表示右视点显著区域比左视点显著区域亮度低.

图10 立体图像舒适亮度差异图Fig.10 Comfortable brightness difference map of stereoscopic images

为了使本文的方案具有普适性,对图 7、图 8所示的 4组立体图像舒适亮度匹配图和差异图的实验数据进行平均,分别得到立体图像舒适亮度匹配图和差异图,如图 9、图 10所示.将图 9与图 10中直线包围区域分为4个部分.

(2) 在R1区域,亮度过低.人在观看图像时对于过低亮度的忍耐度有一定的阈值,当图像亮度低于阈值时,观看者在观看时感到明显的不适.左眼的最低亮度阈值为 35.3,右眼的亮度阈值为 44.3,而且在低亮度区域双眼能够融合的亮度差也较小.

(3) 随着左右视点显著区域亮度的增加,双眼的融合极限逐渐增大,在R2区域,随着左眼亮度的增加,右眼对于较暗的图像的融合极限会比R1时低,这是由于左视点较为明亮,即使右视点不是很明亮也能在大脑中融合成亮度适合的图像,而且具有良好的观看舒适度.

(4) 在区域R3,图像的亮度继续增加,人对亮度变化的敏感度较R2减弱,所以在该区域左右视图融合极限差继续增大.

(5) 随着亮度增大到一定范围,高亮度的刺激会使人感到不适.随着左视点亮度增加,右视点的亮度适应范围逐渐减小,最终收缩到一个最大亮度极值.

图9的对角线不对称,图10的水平轴也不对称.这主要是因为人在感知事物时左右眼有所差异.图10中水平轴上半部面积小于下半部的面积,这是因为被试者是右眼为主眼,主眼对辅眼有抑制作用,因此右视图的亮度不能高于左视图太多,但右视点亮度可以比左视点低很多,这种现象在图像亮度增大到一定程度后更为明显.

3 结果验证

文献[14]在没有考虑视觉显著性的情况下定量研究亮度因素对视觉舒适度的影响,曲线如图 11星号连接直线所示.图 11中的圆圈连接直线代表本文结果.可以看出,两曲线所包围的亮度范围基本一致,说明显著区域的舒适度能够代表整幅立体图像的舒适度,与理论一致. 2个结果所不同的是本文的最低亮度并非从0开始,因为当亮度为0或过低时,此时图像为全黑或亮度太低,看不出图像所显示的具体内容,测量的图像的舒适得分过低.本文结果更加符合人眼的视觉感受.

图11 本文实验结果与文献[14]结果对比Fig.11 Comparison between experimental results and Ref.[14] results

4 结 语

本文基于视觉注意机制通过主观定量实验研究了亮度变化对舒适度的影响机制,相比于未考虑视觉注意机制的实验,本文结果更能体现人眼的视觉感受.但是,影响立体图像/视频舒适度的因素有很多,有待进一步研究其他因素(色度、饱和度、对比度等)对观看舒适度的影响,完善整个理论体系.

[1] Chen Hungshing,Huang Chungcheng,Luo Mingronnier. Visual comfort in 2D/3D modes of glasses-type stereoscopic displays[J].Journal of the Society for Information Display,2013,21(2):94-102.

[2] Zhang Wei,Qu Chenfei,Ma Lin. Learning structure of stereoscopic image for no-reference quality assessment with convolution neural network[J].Pattern Recognition,2016,59:176-187.

[3] Chen M J,Cormack L K,Bovik A C. No-reference quality assessment of natural stereopairs[J].IEEE Transactions on Image Processing,2013,22(9):3379-3391.

[4] Shao Feng,Lin Weisi,Wang S,et al. Learning receptive fields and quality lookups for blind assessment of stereoscopic images[J].IEEE Transactions on Cybemetics,2016,46(3):730-743.

[5] Shao Feng,Tian Weijun,Lin Weisi. Learning sparse representation for no-reference quality assessment of multiply-distorted stereoscopic images[J].IEEE Transactions on Multimedia,2017,19(8):1821-1836.

[6] 沈丽丽,刘海鹏,王 丛,等. 旋转偏差对立体显示舒适度影响的 ERP研究[J]. 天津大学学报:自然科学与工程技术版,2017,50(4):385-390.Shen Lili,Liu Haipeng,Wang Cong,et al. Study on ERP for the effect of rotation distortions on visual comfort[J].Journal of Tianjin University:Science and Technology,2017,50(4):385-390(in Chinese).

[7] 岳广辉,侯春萍,沈丽丽,等. 尺寸偏差对立体观看舒适度影响的 ERP研究[J]. 天津大学学报:自然科学与工程技术版,2016,49(12):1262-1267.Yue Guanghui,Hou Chunping,Shen Lili,et al. ERP study on the discomfort induced by size mismatch between left view and right view[J].Journal of Tianjin University:Science and Technology,2016,49(12):1262-1267(in Chinese).

[8] 沈丽丽,刘海鹏,王 丛,等. 亮度偏差对立体显示舒适度影响的 ERP研究[J]. 天津大学学报:自然科学与工程技术版,2016,49(12):1243-1247.Shen Lili,Liu Haipeng,Wang Cong,et al. ERP study on the effect of brightness deviations on stereo visual comfort[J].Journal of Tianjin University:Science and Technology,2016,49(12):1243-1247(in Chinese).

[9] Kooi F L,Toet A. Visual comfort of binocular and 3D displays [J].Displays,2004,25(2/3):99-108.

[10] Jung Cheolkon,Wang Shuai. Visual comfort assessment in stereoscopic 3D images using salient object disparity[J].Electronics Letters,2014,51(6):482-484.

[11] 李小方,王琼华,李大海,等. 自由立体显示器观看视疲劳[J]. 液晶与显示,2008,23(4):464-467.Li Xiaofang,Wang Qionghua,Li Dahai,et al.Viewer’s visual fatigue in autostereoscopic display [J].Chinese Journal of Liquid Crystals and Displays,2008,23(4):464-467(in Chinese).

[12] Quan H T,Barkowsky M,Callet P L. The importance of visual attention in improving the 3D-TV viewing experience:Overview and new perspectives[J].IEEE Transactions on Broadcasting,2011,57(2):421-431.

[13] Shin D H,Lee S H,Kim E S. Optical display of true 3D objects in depth-priority integral imaging using an active sensor[J].Optics Communications,2007,275(2):330-334.

[14] 臧艳军,李素梅,卫津津,等. 影响立体图像舒适度的亮度范围测定[J]. 电子测量技术,2012,35(2):59-64.Zang Yanjun,Li Sumei,Wei Jinjin,et al. Measurement of the range of the brightness parameter influencing the comfort of stereoscopic images[J].Electronic Measurement Technology,2012,35(2):59-64(in Chinese).

[15] 刘 畅,李素梅,朱 丹,等. 色度对立体图像视觉舒适度影响的定量研究[J]. 光电子·激光,2014,25(1):178-185.Liu Chang,Li Sumei,Zhu Dan,et al. Quantitative research of the hue parameter influence on the visual comfort of stereoscopic images[J].Journal of Optoelectronics·Laser,2014,25(1):178-185(in Chinese).

[16] 李素梅,付贝贝,臧艳军,等. 影响立体图像舒适度的饱和度范围的测定[J]. 天津大学学报,2012,45(8):669-676.Li Sumei,Fu Beibei,Zang Yanjun,et al. Measurement of the range of saturation parameter influencing the comfort of stereoscopic images[J].Journal of Tianjin University,2012,45(8):669-676(in Chinese).

[17] Jung Yongju,Sohn Hosik,Lee Seong-Il,et al. Predicting visual discomfort of stereoscopic images using human attention model[J].IEEE Transactions on Circuits & Systems for Video Technology,2013,23(12):2077-2082.

[18] ITU-R BT 1438 Subjective Assessment of Stereoscopic Television Pictures[S]. Switzerland:TTU-R,2000.

[19] 国家广播电视总局. GB/T 7401—1087 彩色电视图像质量主观评价方法[S]. 北京:中国标准出版社,1987.The State Administration of Radio Film and Television.GB/T 7401—1987 Method of Subjective Assessment of Quality of Color TV Pictures[S]. Beijing:China Standards Press,1987(in Chinese).

[20] 王 飞. 基于上下文和背景的视觉显著性检测[D]. 大连:大连理工大学信息与通信工程学院,2013.Wang Fei. Visual Saliency Detection Based on Context and Background[D]. Dalian:School of Information and Communication Engineering,Dalian University of Technology,2013(in Chinese).

[21] 姜求平,邵 枫,郁 梅,等. 基于视觉重要区域的立体图像视觉舒适度客观评价方法[J]. 电子与信息学报,2014,36(4):875-881.Jiang Qiuping,Shao Feng,Yu Mei,et al. An objective stereoscopic image visual comfort assessment metric based on visual important regions[J].Chinese Journal of Electronics and Information Technology,2014,36(4):875-881(in Chinese).

[22] Harel J,Koch C,Perona P,et al.Graph-Based Visual Saliency[M]. Vancouver:MIT Press,2007.

[23] Hosni A,Rhemann C,Bleyer M,et al. Fast costvolume filtering for visual correspondence and beyond[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2012,35(2):504-511.

[24] Wang Junle,da Silva M P,Callet P L,et al. Computational model of stereoscopic 3D visual saliency[J].IEEE Transactions on Image Processing,2013,22(6):2151-2165.

[25] 田杰华,顾晓东,汪源源. 利用人眼视觉特性的低比特率小波图像压缩[J]. 仪器仪表学报,2010,31(11):2515-2520.Tian Jiehua,Gu Xiaodong,Wang Yuanyuan. Low bit rate image compression using human visual characteristics[J].Chinese Journal of Scientific Instrument,2010,31(11):2515-2520(in Chinese).

[26] 田 垅,刘宗田. 最小二乘法分段直线拟合[J]. 计算机科学,2012,39(增1):482-484.Tian Long,Liu Zongtian. Least square piecewise linear fitting[J].Computer Science,2012,39(Suppl,1):482-484(in Chinese).