基于改进LDA模型的离群评论选择

2018-02-01董振涛

董振涛

摘要:评论文本中的词符合幂律分布,使LDA模型词的分布偏向高频词,导致主题相似度大,表达能力下降。提出幂函数加权LDA(Latent Dirichlet Allocation)模型以提高低频词的表达能力。使用iForest算法,选择出与众不同且具有价值的评论集合。实验结果表明,选择的评论子集特征覆盖率较高,且有较高的平均信息量。

关键词:LDA;iForest;特征覆盖率;平均信息量

DOIDOI:10.11907/rjdk.172218

中图分类号:TP301

文献标识码:A文章编号文章编号:16727800(2018)001003803

Abstract:The words in review text conform to the power law distribution, which makes the distribution of LDA model tends to highfrequency words. Topics similarity is large and expression ability drops. Therefore, a power law function weighted LDA (Latent Dirichlet Allocation) model is proposed to improve the expressive power of lowfrequency words. Finally, iForest algorithm is used to select a different and valuable set of comments. Experimental results show that the feature coverage of selected comment subsets is higher and it has higher average information.

Key Words:LDA; iForest; feature; coverage; average information

0引言

網络购物已成为人们生活不可或缺的一部分。用户在购买商品前,往往喜欢浏览商品评论,从而了解商品的具体信息。但随着评论数量的急剧增长,用户浏览并分析这些信息变得不现实[1],大量的评论造成信息过载[2]。因此,从大量的评论中选出一组具有代表性的评论子集展示给用户变得愈加重要,评论选择也成为学者的研究热点。Tsaparas等[3]把评论选择转化为一个最大特征覆盖率问题,使用改进的贪心算法[4]选择评论子集,但容易选择出内容过长的评论。Ganesan等[5]提出基于ngram模型获取评论总结,从大量的评论中总结出具有代表性和可读性的短语,此种方式结果过于简洁,反映的信息较片面。有学者提出根据商品的特征评分和获得支持的得分对评论进行质量排名,取TopN个评论作为评论子集,确保其质量优良[6],但也不能完全排除选中长评论的可能。上述方法易受高频词的影响,忽视低频且重要的词,因此本文提出幂函数加权LDA模型的评论选择方法,提高低频词的表达能力,从而找出一组较特殊的且信息量较高的评论推送给用户。

1问题定义

本文提出的幂函数加权LDA模型,将评论文本转化为空间向量,使用高效的IForest算法找出特殊的、有意义的、与众不同的评论子集。

定义R为评论集,R={r1,r2,…,rn},n为评论个数,这些评论涵盖了用户关注的全部商品特征A={a1,a2,…,am},m为给定的特征词个数。评论选择的任务就是从R个评论中选择K个评论作为子集,S={r1,r2,…,rk},SR且kn。

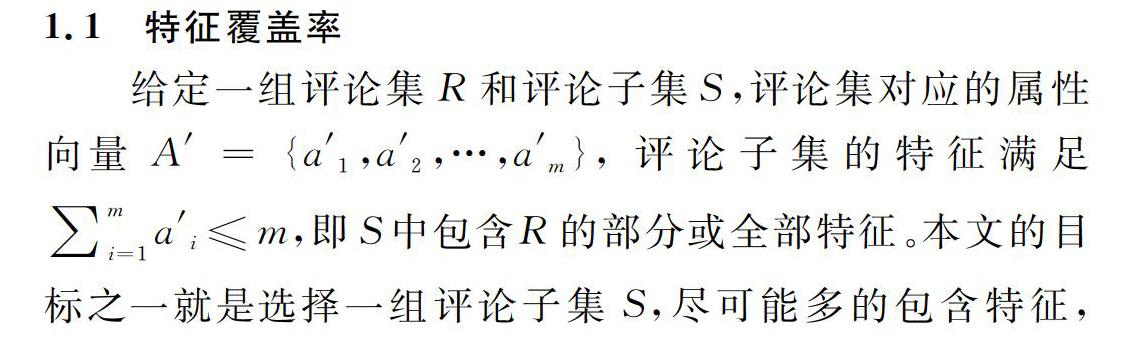

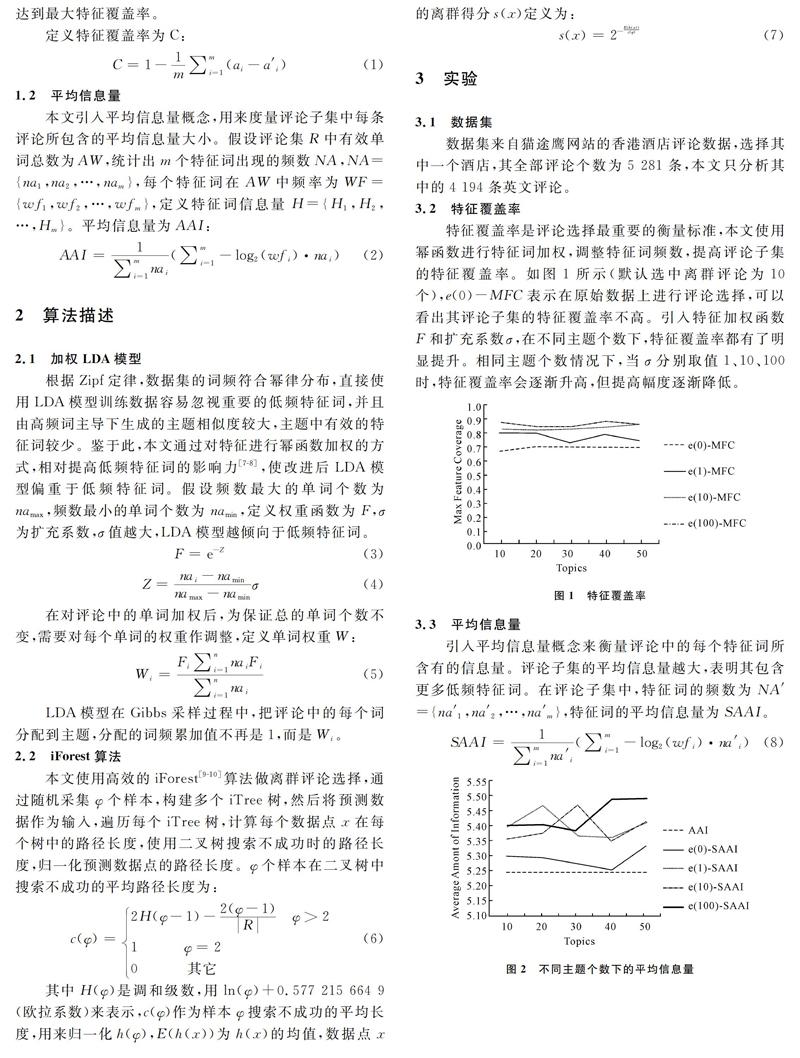

图2中,AAI表示全部评论特征词的平均信息量。SAAI表示评论子集中特征词的平均信息量。引入幂函数特征词加权后,评论子集特征词的平均信息量高于SAAI,说明评论子集包含更多的低频特征词。在相同的

主题数下,随着σ增大,平均信息量不一定增加。未引入加权函数和扩充系数时,评论子集的平均信息量与主题个数无关。引入加权函数和扩充系数后,每个扩充系数都对应一个较优的主题数,使评论子集平均信息量最大。

4结语

传统LDA模型难以兼顾有意义且重要的低频特征词,因此提出一种幂函数加权LDA模型用于评论选择。引入特征加权函数和扩充系数,调整词频权重,兼顾了低频特征词,不仅提高了评论子集的平均信息量,而且提高了特征覆盖率。

参考文献:

[1]LAPPAS T, CROVELLA M, TERZI E. Selecting a characteristic set of reviews[C].ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. ACM,2012:832840.

[2]NGUYEN T S, LAUW H W, TSAPARAS P. Review selection using microreviews[J]. Knowledge & Data Engineering IEEE Transactions on,2015,27(4):10981111.

[3]TSAPARAS P, NTOULAS A, TERZI E. Selecting a comprehensive set of reviews[C]. ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, San Diego, Ca, Usa, August. DBLP,2011:168176.

[4]LU Y, ZHAI C X, SUNDARESAN N. Rated aspect summarization of short comments[C]. Rated Aspect Summarization of Short Comments Yue,2009:131140.

[5]GANESAN K, ZHAI C X, VIEGAS E. Micropinion generation:an unsupervised approach to generating ultraconcise summaries of opinions[EB/OL]. http://academic.research.microsoft.com/ 2012:869878.

[6]余文喆,沙朝锋,何晓丰,等.考虑观点多样性的评论选择问题[J].计算机研究与发展,2015,52(5):10501060.

[7]张志飞,苗夺谦,高灿.基于LDA主题模型的短文本分类方法[J].计算机应用,2013,33(6):15871590.

[8]张小平,周雪忠,黄厚宽,等.一种改进的LDA主题模型[J].北京交通大学学报,2010,34(2):111114.

[9]LIU F T, KAI M T, ZHOU Z H. Isolationbased anomaly detection[J]. Acm Transactions on Knowledge Discovery from Data,2012,6(1):139.

[10]LIU F T, KAI M T, ZHOU Z H. Isolation forest[C]. Eighth IEEE International Conference on Data Mining. IEEE,2008:413422.

(责任编辑:杜能钢)