杀手机器人:未来无人战争之忧

2017-11-02杨智杰

杨智杰

致命性自主武器系统足以构成第三次武器革命的威胁——前两次革命分别是火药和核武器。这种技术一旦开发成功,将有可能把战争冲突升级至从未有过的规模,而且会达到人类难以控制的速度。

“我能和你们一起吗?”2078年的天狼星6B行星上,手拿泰迪熊的小男孩孤零零地站在危机四伏的废墟里对联盟军人求助,画面温情。但他们很快就发现,这个男孩竟然是由联盟研制的电子杀人武器“尖叫者”(screamer)自我进化而成的。故事从此刻开始紧张起来,原先用来绞杀敌人的小型机器人乔装来到主人面前,它的武器锯齿圆轮飞向了人类。

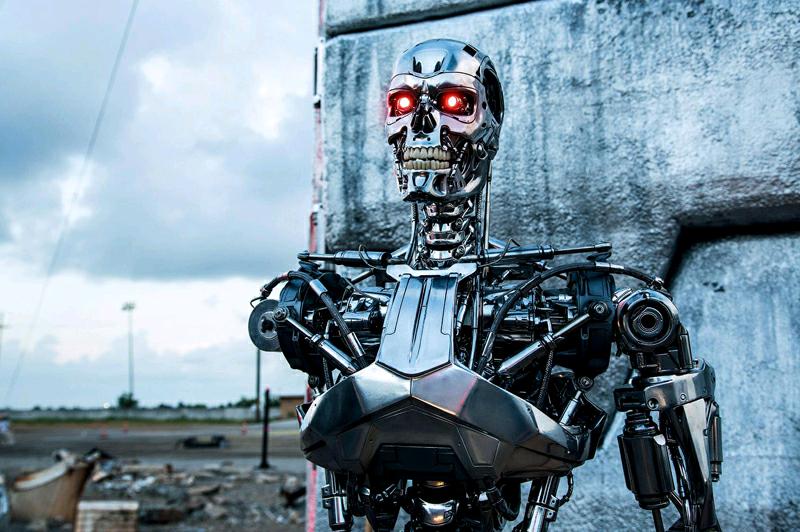

这是1995年好莱坞推出的电影《异形终结》的一幕。 从上世纪后期至今,《西部世界》《终结者》《我,机器人》等科幻电影和小说就开始展现人类设计并主导的“杀手机器人”最终成为反叛者,拥有独立意识,从战争的辅助工具转变为与人类为敌的杀戮者。

耶鲁大学生物伦理学研究员瓦拉赫等人在《道德机器:如何教会机器人辨明是非》一书中提到,人工智能技术最有前途的应用领域有三个:军用机器人,以减少人力投入和伤亡;性爱机器人,满足单身人士的生理需求以降低性犯罪率;工业机器人,以应对人口老龄化带来的用工荒。

然而,人们在享受机器人带来的进步的同时,也从未停止过担心。尤其是在进入21世纪的第二个十年以后, AlphaGo战胜世界围棋冠军,国际知名技术公司开发的无人驾驶汽车纷纷上路……

随着人工智能的不断发展,人们对军事领域“杀手机器人”的担忧也由虚构空间开始转向了真实世界。

未来的无人战争

今年8月20日,在墨尔本举行的2017国际人工智能联合大会上,包括美国特斯拉电动汽车公司CEO伊隆·马斯克、DeepMind联合创始人穆斯塔法·苏莱曼在内的116位机器人和人工智能公司创始人发表公开信,呼吁联合国在国际范围内禁止“致命性自主武器系统”的使用。

公开信指出,致命性自主武器系统足以构成第三次武器革命的威胁——前两次革命分别是火药和核武器。这种技术一旦开发成功,将有可能把战争冲突升级至从未有过的规模,而且会达到人类难以控制的速度。公开信的签署者们认为,致命性自主武器可能成为独裁者和恐怖分子残害无辜的手段,或者被黑客挟持。

致命性自主武器系统实际上是一种军用机器人,它可以不经过人类干预,自主选择和攻击包括人员和装备在内的军事目标,所以也被叫做“杀手机器人”。目前,拥有“人格”的智能技术尚未被从科幻电影搬到现实中,但是与此有关的技术的确正在朝着这个方向发展。

当然,无人武器系统并不等同于致命性自主武器,它还包括自动化武器和遥控武器。军事科学院系统工程研究院曹华阳博士及其团队较早就开始关注这个领域的相关问题,他们在最近发表的论文《致命性自主武器系统的定义方法》中区分了“自动化”和“自主性”的概念。

自动化武器,以自足完备和独立的方式运行,在设定好的可控环境中严格执行预编程行动或序列。它们的攻击目标、攻击决策以及攻击方式都是由人类预先设定的。遥控武器,一般由战区之外的操作员控制着进行战斗,可以被固定在一处,也可以自行移动。而自主性武器的特殊之处是,在某些关键性的能力(如决定人类的生命)方面,机器可能给出并执行自己的决策,而不是按照人类预先设定好的程序或者人类远程的遥控来执行。

实际上,目前的军事武器技术已经不止停留在自动化水平上。北京一名不愿透露姓名的军事专家对《中国新闻周刊》介绍,在自动化时期,例如美军舰艇上的“密集阵系统”,可以实现对攻击范围内所有目标无差别地发起自动打击。而目前的人工智能技術已经可以进一步做到对目标进行识别,在武器系统内对不同目标采取不同反应。

电影《终结者:创世纪》剧照。

例如,2016年8月,美军测试了一款6旋翼小型无人机,该系统安装了人工智能软件,不需人类操纵即可自行搜寻并识别村庄里手持AK-47冲锋枪的人。

据上述军事专家介绍,具备无人特征的武器的初级形态是由人类全程遥控的,目前技术先进的国家已经掌握这一水平的技术,如遥控无人机、遥控炮台、遥控战车等。

自主程度中等的半自动武器,在面对一些简单问题时,不需要人类指挥即可自行解决,只在面对复杂环境和关键问题时需要人类控制。当前美国的SSV地面战车、德国的MV4爆炸物处理机器人即可以实现这类效果。除此之外,军事领域比较知名的半自动武器还有韩国三星生产的SGR-A1哨兵机器人、英国的Taranis无人机、俄罗斯的Uran-9坦克机器人、美国的Sea Hunter自主战舰等。

自主程度最高的则是全自主武器,它可以自行在战场上执行完整的任务,但目前还没有具备这种能力的武器系统出现。

伴随着机器人武器的发展和扩散,国外有军事专家和机器人专家预测,在20到30年内,人类就可以开发出号称“杀手机器人”的全自主武器。

有人认为,在未来,致命性自主武器系统如果应用于战争,在军事方面会起到许多正面作用。例如,降低己方士兵的风险,降低人与人之间近距离战争的代价。此外,自主武器系统也省去了军人的薪水、住房、养老、医疗等开销,又在速度、准确性上高于人类,而且不用休息。有别于人类战斗员会在战场上出现心理和情绪波动的特点,人工智能武器更稳定,并且能够抵达人类不可及之处,完成搜救和保护任务。

西安政治学院军事法学系教授宋新平分析,致命性自主武器的运用,意味着自然人在武装冲突中直接发挥的作用越来越小,武器所发挥的作用则越来越大,将影响并改变未来战场的战斗员构成与战斗能力的变化,特别是这种武器的集群式运用,对未来作战的指挥体制、力量运用、供给保障等方面将产生革命性影响。endprint

争议“杀手机器人”

但是,随着致命性自主武器系统的发展,它所带来的争议也越来越强烈。

首先,有人担忧,机器打仗使得人员伤亡大大减少,反过来又会降低战争发动的门槛,武装冲突发生的机会会增加,而战争的人员损失将从战斗员转移到交火区域的平民。

其次,如同所有战争中的武器一样,致命性自主武器系统要运用在战争中,必须符合《日内瓦公约》,即国际人道法。反对者认为,该武器系统违反国际人道法中的“区分原则”,即机器人武器很难做到和人类一样区分平民与战斗员、有战斗能力的战斗员和丧失战斗能力的战斗员(如伤者、病者及战俘),以及作战人员和携带轻武器从事非战斗任务的人员。

在伦理方面,致命性自主武器运用于未来的武装冲突中,这意味着将剥夺自然人生命的权利交给非自然人。有学者认为,这是将人的生命和人格尊严交给机器来判定,不具有平等性,也是对人类生命权以及人格尊严的侮辱。

法律上的责任更是不能忽略。自主武器兼具“战斗员”和“战斗武器”两种角色,如果它违背国际人道法,国际社会将面临如何追究责任的问题,而被追究的主体应该是设计者、制造者、操作者还是机器本身?

今年8月发出的公开信不是伊隆·马斯克等人第一次对致命性自主武器系统提出警示。早在2015年,同样在国际人工智能联合大会上,物理学家斯蒂芬·霍金、苹果联合创始人史蒂夫·沃兹尼亚克等1000多名人工智能领域专家联合谴责人工智能时代的军备竞赛,呼吁禁止自主武器。容易引发军备竞赛、威胁世界和平,是反对者担忧的原因之一。

但是,也有人认为以上反对意见作为禁用致命性自主武器的理由站不住脚。研究人工智能哲学的复旦大学教授徐英瑾在《技术与正义:未来战争中的人工智能》一文中进行了反驳。比如,对于“无人智能武器的出现,会使得杀戮变得更为容易,因此,也会使得军事暴力在未来变得更为频繁”的说法,徐英瑾提出,按照殺戮效率提高会对和平构成威胁的逻辑,那是否为了降低杀戮效率,就制造尽量劣质的枪支,鼓励士兵降低击中率?这显然是荒谬的,相反,人工智能技术运用于军事,会使得人类作战意图得到更精确的贯彻,可使得正义战争快速结束。

徐英瑾也不同意军用机器人的杀戮无心理压力的说法,他认为,一些设计者会在软件层面模拟出“怜悯”等人类情绪,故杀戮效率高并不等于滥杀无辜。

徐英瑾也不赞同自主武器系统会造成战争门槛降低的说法。他认为,即使没有致命性自主武器,西方军事强国与弱国相比已经拥有巨大的军事优势,但是发动战争还要考虑各国宪法以及政治和经济因素。任何战争都无法避免,特别计较机器带来的误伤,是设置了双重标准。相反,高度自主化技术可能还会减少误伤。

正在海上进行试验的美国SeaHunter自主战舰。

关于致命性自主武器的讨论是伴随着近些年人工智能技术的快速进步而出现的。2012年,人权观察组织发表《失去人性:反对杀人机器人》的报告,呼吁世界各国政府禁止全自主武器系统。同时,美国、英国、日本等国家也从2012年起对本国自主武器研发情况进行讨论和规定。联合国《特定常规武器公约》缔约国自2014年起,即以非正式专家会议的形式专门讨论致命性自主武器系统。

人工智能公司、国际组织纷纷呼吁禁止致命性自主武器系统,但现状是,至今国际社会仍然没有就致命性自主武器系统问题达成统一认识,甚至还没有统一的定义。

据曹华阳等人分析,各国间存在分歧的根本原因在于各自的国家利益。智能化、无人化武器已经在现代军事行动中展现出特有的优势,美、英、以色列等技术先进的国家不希望其自主武器系统相关装备和技术的发展受到限制,因而倾向于将致命性自主武器限定为“未来的武器系统”,从而避免现有无人装备受到军备控制。

而自主武器系统技术门槛高、经费投入大,中小发展中国家难以超越,为避免在未来战争中陷入有人装备对抗无人系统的不利局面,它们则期望将致命性自主武器的范畴扩大,并通过限制性条款制约此类武器的部署和应用,古巴等国更是在致命性自主武器定义尚未明确的情况下就要求禁止该系统。

联合国《特定常规武器公约》成员国已经建立了一个致命性自主武器系统的政府专家小组,这个小组的第一次会议预定将于今年11月召开。伊隆·马斯克等公开信签署者希望专家小组努力寻求方法,防止这类武器的军备竞赛,保护平民免受武器滥用的伤害,避免这些技术给世界的未来带来严重的后果。endprint