基于Oriented FAST和 M AD的特征匹配图像自动配准∗

2017-10-16孙启湲朱菲菲

燕 磊 孙启湲 朱菲菲

基于Oriented FAST和 M AD的特征匹配图像自动配准∗

燕 磊1,2孙启湲1,2朱菲菲1,2

(1.天津市先进机电系统设计与智能控制重点实验室 天津 300384)(2.天津理工大学机械工程学院 天津 300384)

针对双目摄像机所获取的两幅具有平移变换的图像提出了一种基于Oriented FAST和平均绝对差值法(MAD)进行特征匹配的自动配准算法。应用FAST特征提取算法检测图像中的角点、边缘特征,并应用灰度质心计算每个特征点的方位角,使用方位角作为特征描述符筛选出待配准图像的候选匹配点队列,然后利用MAD对特征点邻域进行匹配,后续处理采用交叉过滤、随机采样一致算法(Random Sample Consensus,RANSAC)去除误匹配点并求出两幅图像的仿射变换矩阵。实验结果表明,该算法可以准确高效地实现两幅图像的自动配准。

图像配准;FAST特征;MAD匹配

AbstractAn automatic image registration algorithm based on Oriented FAST and Mean Absolute Differences(MAD)was pro⁃posed for binocular-camera images with translational transformation.In this algorithm,FAST algorithm was used to detect feature points,intensity centroid method was used to calculate the key-point orientation which was lately used to screen out candidate matching points,then MAD was used to match those candidate points,finally mismatched points were eliminated by Cross Filter and RANSAC algorithm during which the affine transform matrix between the images was obtained.Experiments demonstrated the feasibility of this method.

Key Wordsimage registration,FAST features,MADmatching

Class NumberTP391

1 引言

目前图像配准技术在视觉测量和视觉三维重建领域已经得到广泛应用[1~3],利用双目摄像机获取两幅具有视差的图像(以下称为左视图和右视图),利用左右视图中对应点的视差值根据三角测量原理[4]可以计算出空间点的三维坐标。高效准确的图像配准技术是计算左右视图对应点视差的基础,论文受到ORB(Oriented FAST and Rotated BRIEF)算法的启发,利用FAST算法提取图像特征,使用灰度质心计算特征点的方位角,然后利用此方位角筛选出两幅图像中可能的匹配对,应用平均绝对差值法(Mean Absolute Differences,MAD)实现图像配准。

2 基于O riented FAST和MAD的图像配准算法

本文提出算法的总体框架如图1所示,它主要由 FAST[5~6]特征点提取(利用 Harris响应值筛选显著特征点,计算特征点方位角)、特征匹配(利用方位角筛选匹配对,运用MAD匹配)和变换参数估计几个部分组成。

图1 算法总体框架

2.1 Oriented FAST特征检测

ORB(Oriented FAST and Rotated BRIEF)[6~7]建立在FAST特征点检测器和BRIEF[8]特征描述子基础上,FAST具有良好的性能和很低的计算量,但不具有旋转不变性。ORB为FAST检测器附加了一个快速而准确的方向元件,称为Oriented FAST,使所描述的特征具备了旋转不变性。Oriented FAST首先在图像上检测FAST-9特征点,FAST没有对特征点的角度信息进行度量,并且对边缘点有很高的响应值,因此使用Harris特征点响应值对检测出的特征进行降序排序,响应值依次递减,选取前N个特征点作为待匹配点集合。

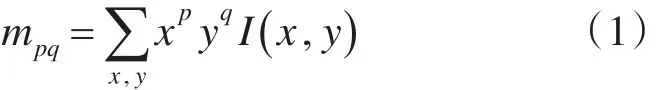

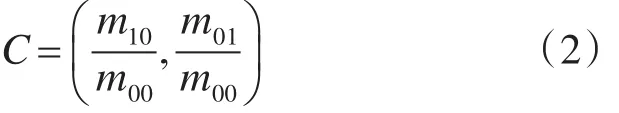

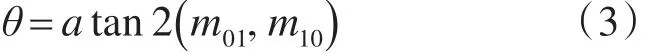

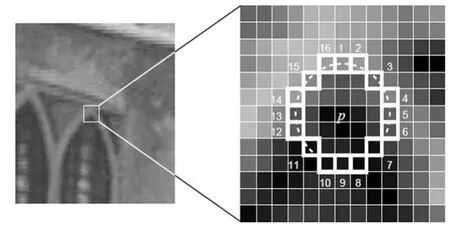

然后Oriented FAST采用灰度质心[9]来计算特征点的方位角。假设角点区域的灰度质心与区域中心有一个偏移量,该偏移向量可以用来计算方位。我们把FAST特征检测器的环形区域(图2)称为特征点斑块,Rosin定义了一个图像斑块区域的矩:

使用图像矩,斑块区域的灰度质心表示为

由此可得斑块的方位角:

θ 的取值范围在-180°~180°之间,表示质心到中心点连线与x轴的夹角。假设特征点斑块的半径为r,则x,y的取值范围是[-r,r]。

图2 图片区域中的12点分段测试角点检测

由于双目摄像机所拍摄的图像间存在平移变换和微小的旋转变换,受到ORB算法的启发,使用Oriented FAST分别在两幅图像中提取特征点,然后计算每个点的方位角。假设两幅图像间的旋转角度为Δα(Δα≤t),t为设定阈值,用参考图像的每个特征点遍历待配准图像的特征点,把方位角差值的绝对值小于所设阈值的点列为候选匹配点(如式4),存储到参考图像该特征点的候选匹配点队列中,这样可以缩小特征点匹配的搜索范围,理论上可以有效提高匹配效率:

其中,t表示阈值,Pi, Pj'分别是两图像的特征点,两点的状态为1则将点Pj'列为点Pi的候选匹配点,状态为0则略过并继续下面的遍历。

2.2 平均绝对差值模板匹配

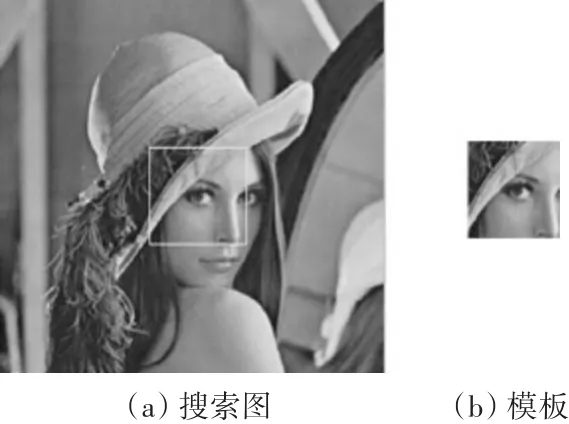

设S(x ,y )是大小为 m×n的搜索图像(图3(a)),T(x ,y )是大小为 M×N 的模板图像(图3(b)),目的是在(a)中找到与(b)匹配的区域的坐标。

平均绝对差值法(Mean Absolute Differences,MAD)[10~12]是 Leese 在 1971 年提出的一种匹配算法,是模式识别中的常用算法。该算法的思想简单,具有较高的匹配精度,广泛用于图像匹配。

图3 灰度模板匹配

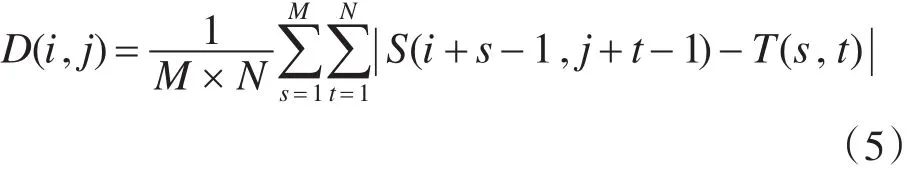

该算法的思路是,在搜索图S中,以像素点(i,j)为左上角,取M×N大小的子图,计算其与模板的相似度,遍历整个搜索图,在所有能够得到的子图中找到与模板图最相似的子图作为最终匹配结果。MAD算法的相似性测度公式如下:

其中,1≤i≤m-M+1,1≤j≤n-N+1

显然平均绝对差D(i,j)越小表明越相似,故只需找到最小的D(i,j)即可确定正确匹配的子图坐标。该算法的优点是运算过程简单,匹配精度高;缺点是运算量偏大,对噪声非常敏感。针对以上问题,以特征点坐标作为模板的中心(此处采用15×15的模板尺寸),只对上节中得到的参考图像特征点与其候选匹配点队列进行模板匹配,将平均绝对差最小的点对作为正确匹配。这样一方面避免了遍历每个像素,大大减少了运算量,另一方面用方位角和模板匹配双重筛选减小了噪声点的干扰作用。

2.3 利用交叉过滤和重投影消除误匹配点

从上面得到的匹配点对难免有误匹配现象,原因是,比如参考图像检测得到225个特征点,待配准图像检测得200个特征点,在用参考图像的每个特征点去遍历待配准图像的特征点时,将得到225个候选匹配点对,其中显然是有误匹配的点,换句话说,即出现了参考图像上多个点与带配准图像的同一个点相匹配的现象。因此采用交叉过滤法,即两幅图像(称为图像1和图像2),首先用图像1遍历图像2得到匹配集合S1,再用图像2遍历图像1得到匹配集合S2,取S1∩S2作为进一步处理的候选匹配集。

在实验中发现由于场景图像存在重复的纹理,造成误匹配现象。基于此,采用RANSAC[13]算法计算两图像的单应矩阵,把待配准图像特征点映射到参考图像上去,计算对应点之间的重投影误差,把误差小于设定阈值的点对定为正确匹配。经过以上过程去除了剩余的误匹配,最终得到两幅图像的变换参数。

3 实验结果与分析

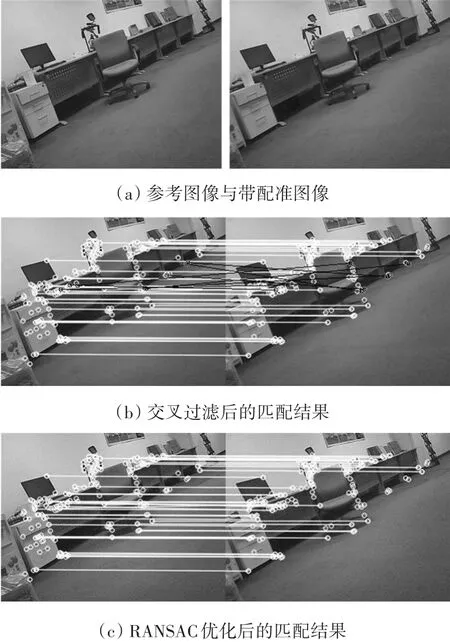

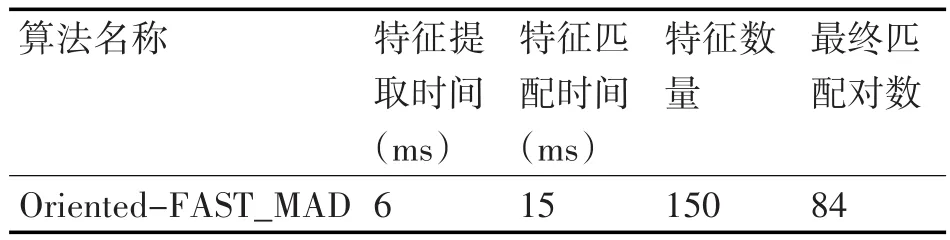

在Intel core i5 2.6 GHz CPU 4.0 Gbit RAM的PC机上采用C++编程实现了本文提出的算法,针对大量双目摄像机获取的图像进行了实验(限于篇幅下文仅给出一组实验结果),并对算法的配准性能进行了分析。实验中双目摄像机经过标定后的平均重投影误差为0.25像素,达到了亚像素级。下图4(a)是左右摄像机拍摄的大小为320×240像素的图像,对它们进行特征提取和特征匹配,图4(b)为经过交叉过滤后的匹配图像,在图中可以明显看到有几处误匹配的地方(黑线标出),图4(c)为经过RANSAC算法优化后的最终匹配结果,具体实验数据如表1所示。

图4 特征提取与匹配实验

表1 特征提取与匹配实验数据

由表1看到该算法特征提取时间为6ms,特征匹配时间为15ms,以上时间计算均为多次实验的平均值,总时间平均为21ms,对于双目摄像机所获取的视频流,本算法可以满足实时匹配的要求。

4 结语

论文受到ORB算法启发提出了一种将Orient⁃ed FAST与平均绝对差值法(MAD)相结合进行图像配准的方法,针对双目摄像机所获取的具有平移变换的两幅图像进行了特征提取和匹配实验,实验证明本算法可以准确而快速地完成特征提取和特征匹配,能够满足视频流实时性要求。该算法的不足之处是只在两摄像机存在平移变换时能够有效匹配,不具有旋转不变性,因此将算法进一步改进使其对存在旋转变换的图像配准具有鲁棒性是未来研究的方向。

[1] 张开玉.基于改进SURF的双目立体视觉三维重建[D].太原:太原理工大学,2013:11-16.

ZHANG Kaiyu.Three Dimensional Reconstruction of Bin⁃ocular Stereo Vision Based on Improved SURF[D].Taiyu⁃an:Taiyuan University of Technology,2013:11-16.

[2]佟帅,徐晓刚,易成涛,等.基于视觉的三维重建技术综述[J].计算机应用研究,2011(7):2411-2417.

TONG Shuai,XU Xiaogang,YI Chengtao,et al.Overview on vision-based 3D reconstruction[J].Application Re⁃search of Computers,2011(7):2411-2417.

[3]全燕鸣,黎淑梅,麦青群.基于双目视觉的工件尺寸在机三维测量[J].光学精密工程,2013(4):1054-1061.

QUAN Yanming,LI Shumei,MAI Qingqun.On-machine 3D measurement of workpiece dimensions based on binoc⁃ular vision[J].Optics and Precision Engineering,2013(4):1054-1061.

[4]马颂德,张正友.计算机视觉[M].北京:科学出版社,1998:72-94.

MA Songde,ZHANG Zhengyou.Computer Vision:Foun⁃dation of Theory of computation and algorithms[M].Bei⁃jing:Science Press,1998:72-94.

[5]Rosten E,Porter R,Drummond T.Faster and better:a ma⁃chine learning approach to corner detection.[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2008,32(1):105-119.

[6]Rublee E,Rabaud V,Konolige K,et al.ORB:An efficient alternative to SIFT or SURF[C]//IEEE International Con⁃ference on Computer Vision.IEEE,2011:2564-2571.

[7]李小红,谢成明,贾易臻,等.基于ORB特征的快速目标检测算法[J].电子测量与仪器学报,2013(5):455-460.

LI Xiaohong,XIE Chengming,JIA Yizheng,et al.Rapid moving object detection algorithm based on ORB features[J].Journal of Electronic Measurement and Instrument,2013(5):455-460.

[8]Calonder M,Lepetit V,Strecha C,et al.BRIEF:Binary Robust Independent Elementary Features[C]//Computer Vision-ECCV 2010,European Conference on Computer Vision,Heraklion,Crete,Greece,September 5-11,2010,Proceedings,2010:778-792.

[9]Rosin P L.Measuring Corner Properties[J].Computer Vi⁃sion&Image Understanding,1999,73(2):291-307.

[10]赵启.图像匹配算法研究[D].西安:西安电子科技大学,2013:7-16.

ZHAO Qi.Research on Algorithm of Image Matching[D].Xi’an:Xidian University,2013:7-16.

[11]陈皓,马彩文,陈岳承,等.基于灰度统计的快速模板匹配算法[J].光子学报,2009(6):1586-1590.

CHEN Hao,MA Caiwen,CHEN Yuecheng,et al.Fast Template Matching Algorithm Based on Image Gray Sta⁃tistic[J].Acta Photonica Sinica,2009(6):1586-1590.

[12]Barnea D I,Silverman H F.A Class of Algorithms for Fast Digital Image Registration[J].IEEE Transactions on Computers,1972,C-21(2):179-186.

[13]Fischler M A,Bolles R C.Random sample consensus:a paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the Acm,1981,24(6):381-395.

CNKI推出《中国高被引图书年报》

日前,中国知网(CNKI)中国科学文献计量评价研究中心推出了一套《中国高被引图书年报》,该报告基于中国大陆建国以来出版的422万余本图书被近3年国内期刊、博硕、会议论文的引用频次,分学科、分时段遴选高被引优秀学术图书予以发布。据研制方介绍,他们统计并分析了2013-2015年中国学术期刊813万余篇、中国博硕士学位论文101万余篇、中国重要会议论文39万余篇,累计引文达1451万条。根据统计数据,422万本图书至少被引1次的图书达72万本。研制方根据中国图书馆分类法,将72万本图书划分为105个学科,分1949-2009年和2010-2014年两个时间段,分别遴选被引最高的TOP10%图书,共计选出70911本优秀图书收入《中国被高引图书年报》。统计数据显示,这7万本被高引优秀图书虽然只占全部图书的1.68%,却获得67.4%的总被引频次,可见这些图书质量上乘,在同类图书中发挥了更加重要的作用。该报告还首次发布各科学“学科h指数”排名前20的出版单位的评价指标,对客观评价出版社的社会效益—特别是学术出版物的社会效益具有重要的参考价值。

该报告从图书被引用的角度出发,评价图书的学术影响力,弥补了以销量和借阅等指标无法准确评价学术图书的缺憾,科学、客观地评价了图书、图书作者以及出版单位对各科学发展的贡献。

《中国高被引图书年报》把建国以来出版图书全部纳入评价范围属国内首创,是全面、客观评价图书学术影响力的工具,填补了目前图书学术水平定量评价的空白,在帮助图书馆建设特色馆藏和提高服务水平、帮助出版管理部门了解我国学术出版物现状、帮助科研机构科研管理、帮助读者购买和阅读图书等方面,均具有较强的参考价值,也为出版社评估出版业绩、决策再版图书、策划学科选题提供有用的信息。

《中国高被引图书年报》由《中国学术期刊(光盘版)》电子杂志社有限公司出版。该产品的形式为光盘电子出版物,分为理学、工学、农学、医学、人文科学和社会科学6个分卷,随盘赠送图书,欢迎您咨询、订购。咨询电话:010-82710850 82895056转8599,email:aspt@cnki.net

An Autom atic Image Registration M ethod Based on O riented FAST and MAD Features M atching

YAN Lei1,2SUN Qiyuan1,2ZHU Feifei1,2

(1.Key Laboratory of Advanced Mechanical and Electrical Systems Design and Intelligent Control of Tianjin,Tianjin 300384)(2.School of Mechanical Engineering,Tianjin University of Technology,Tianjin 300384)

TP391

10.3969/j.issn.1672-9722.2017.09.035

2017年3月10日,

2017年4月21日

燕磊,男,硕士研究生,研究方向:机器视觉。孙启湲,男,博士,教授,研究方向:机器视觉。朱菲菲,女,硕士研究生,研究方向:多元信息融合。