新式交互设备在人机交互技术课程中的应用

2017-09-28沈莹张林

沈莹++张林

摘 要:人机交互是一门研究如何设计、评估和实现交互式系统及相关知识的学科。为了让学生深入了解新式的人机交互方式,在课程实践环节引入新式交互设备,学生对新设备表现出浓厚的兴趣,利用这些设备自行设计许多新颖的应用软件,开拓思路,增加开发经验,提高自学新知识的能力。文章对上述课程实践进行阐述。

关键词:人机交互;人机交互设备;新型交互设备;Kinect;Leap motion

1 背 景

人机交互(human-computer interaction)是一门研究如何设计、评估和实现交互式系统及相关知识的学科[1]。人机交互是计算机学科中的传统学科,从计算机诞生的第一天起,人们就在考虑如何设计出更好的人机交互方式。传统的鼠标键盘等交互设备已经不能满足用户的需求,人们希望能够高效便捷地对电脑进行操作,因此诞生了语音交互、手势交互和动作交互等新颖的交互技术。另外人机交互也不局限于某种单一的交互方式,而是多种交互方式并存,共同完成交互任务。

作为一门专业基础课,用户交互技术课程在教学内容上结合软件工程概念,目的在于培养学生理解用户交互界面设计的原则,掌握新式用户交互技术的原理,能够自行设计开发基于新式交互技术的应用程序,使学生在相关行业领域中具有更高的创新性和竞争性。传统的人机交互课程往往局限于介绍认知模型、设计界面元素等知识点,不能引导学生进行实例开发,更不要说接触日新月异的新式交互设备。为了让学生更加深刻地了解人机交互技术的最新进展,可以在课程中引入多种新式交互设备,包括Kinect、Leap motion、智能手表、VR设备等,并基于这些设备设计相应的实验和项目。

2 新式交互设备

人机交互方式经历了命令行交互阶段、图形用户界面交互阶段和自然和諧的交互阶段[2]。在命令行交互阶段,由于计算机价格昂贵、普及性不高,与计算机进行交互的是专业的程序员。随着硬件成本的降低,计算机进入了千家万户,面向普通用户的软件越来越多,命令行界面也逐渐发展为图形界面,并且界面上的交互元素种类日渐丰富和美观。由于图形界面易于理解,操作简单,因此目前这种交互形式占据了主导地位,成为使用各种软件的主要手段。

为了适应人们的娱乐、教育、购物及社交需求,许多新式交互设备开始崭露头角。这些设备彻底改变了传统的人机交互概念,现在我们可以通过手势、动作、语音等更自然的方式来操作计算机,这些提高了交互的效率,增加了交互的趣味性,最终使得人与计算机的关系变得更加紧密。新型交互设备的出现使得人机交互方式进入一个新阶段,为这门学科带来了新挑战。

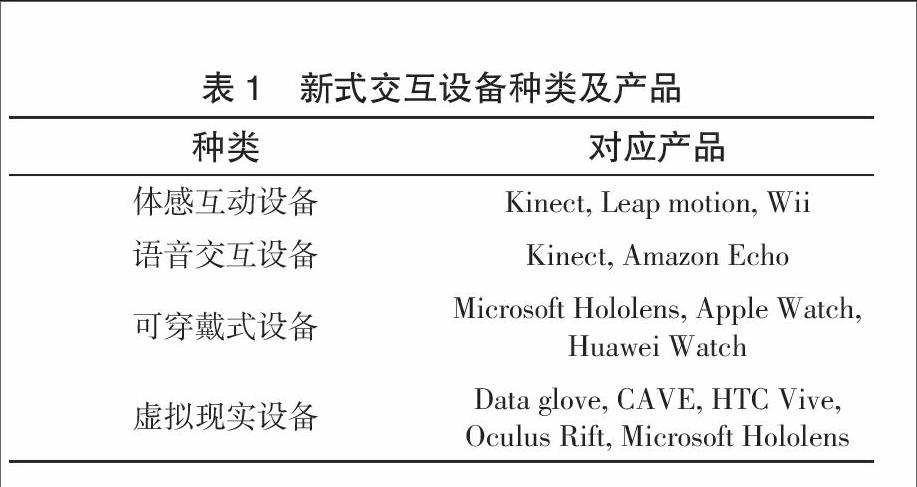

新式交互设备可以分为体感互动设备、语音交互设备、可穿戴式设备、虚拟现实设备等。每种类型的设备包含的具体产品见表1。由于分类并不是相互独立的,因此某些设备会同时出现在不同分类中。

2.1 体感互动设备

Kinect是微软开发的Xbox360主机的周边设备。Kinect里安装了3个镜头,中间的镜头是RGB彩色摄像机,用来获取物体的彩色图像。左边镜头是红外线CMOS 摄影机,右边镜头是红外线发射器。这3个镜头配合工作可以采集到视场中物体的彩色信息和深度信息。Kinect附带的软件可以识别使用Kinect的玩家,最多能识别6个人。除此之外,Kinect还能获取人的全部关节(joint),从而得到玩家的骨架模型。另外,人的手部关节也一样能被识别出来(包括所有指尖和关节),因此,Kinect也可以作为手势识别的设备使用。

Kinect已从1.0版本升级到了2.0版本,目前主要作为参与游戏互动的工具,但是考虑到Kinect的强大功能,除游戏以外其他的应用(例如教育培训)也在利用它完成不同的功能需求。

Leap motion是一款体感控制器。它通过红外线追踪手部移动,并且准确识别出手指的各个关节和骨骼位置。Leap motion与Kinect类似,但是只能进行手势识别。通过Leap motion,用户可以通过双手动作来操作计算机。跟传统的鼠标键盘输入相比,Leap motion的使用显然更加自然有趣。

2.2 语音交互设备

随着深度学习的出现,语音识别算法的识别精度越来越高,最近在数据库上的测试甚至超过了人类水平,因此语音识别软件变得非常普及[3-4]。这种交互方式虽然不需要特殊的设备支持,但是仍有些新出现的语音交互设备值得关注。亚马逊最近推出了一个名为Echo的设备,用户可以将智能家居中的电器连上Echo,通过命令Echo完成对电器的自动化操作。另外前面介绍的Kinect除了包含深度相机外,还有一个语音识别装置,Kinect附带的驱动软件能够记录用户声音并且分析用户命令。

2.3 可穿戴式设备

由于可穿戴式设备体积小,使用简单,功能强大,它们受到了广大用户的青睐。目前最热门的产品要数智能手表,另外微软也推出了一款用于混合现实的眼镜Hololens。

无论是智能手表还是混合现实眼镜,可穿戴式设备的使用还是离不开动作交互和语音交互技术,因此这种新式交互设备实际是体感互动设备和语音交互设备的混合体。

2.4 虚拟现实设备

虚拟现实设备为用户构建出3D虚拟环境,用户通过操作手柄与虚拟环境互动。此类设备包括虚拟头盔、沉浸式虚拟现实系统(CAVE)等。虚拟头盔需要戴在用户头部,头盔里的目镜为用户投影3D虚拟环境,头盔内的运动感知装置捕捉用户头部运动,尤其是头部转动方向。CAVE利用立体投影构造出高级虚拟仿真环境,用户借助虚拟现实交互设备(例如数据手套、Google Glass、位置跟踪器等)获得身临其境的沉浸式感受。虚拟现实设备为用户提供了更加逼真的使用环境,使得用户体验更舒适。

3 新式交互设备在课程中的应用

为了将新式交互设备引入到用户交互技术课程中去,我们设计了3个课程实践项目让学生参与。整个课程采取“知识点教学+算法代码实现+实例开发”的形式[5]。课堂教学教授学生各种交互技术的基本算法,如手势识别算法、语音识别算法等。实验课上教师会提供学生以上算法的代码框架,要求学生进行代码修改,理解不同参数的意义,观察代码修改引起的识别效果的变化。最后,学生分组利用Kinect和Leap motion开发包或者语音识别开发平台进行项目实例开发,学会搭建基本环境,最终实现一个完整的系统。endprint

3.1 基于Kinect的交互式游戏开发

Kinect能够识别用户身体的各个关节,然后根据关节节点重构出一个虚拟人物,通过追踪用户的动作,使得该虚拟人物能在3D环境中完成各种任务。在本实验中,我们首先会教授学生学会安装和使用Kinect 2.0,并构建出3D虚拟环境及用户的骨架模型。然后学生需要完成一个用户与虚拟环境互动的功能,例如推箱子或者粉刷墙壁。此实验涉及的知识点主要有Kinect的使用与编程、Unity3D编程、基于ICP算法的点集匹配等。

3.2 基于Leap motion的手势识别系统

Leap motion是传统交互工具例如鼠标键盘的替代者,只需挥动一只手指即可浏览网页、阅读文章、翻看照片,还有播放音乐。即使不使用任何画笔或笔刷,用指尖即可以绘画,涂鸦和设计。Leap motion安装非常简单,只需通过USB接入电脑。在本实验中,学生需要安装Leap motion的软件开发包,成功检测到手的形状和位置,为不同的手势定义对应的操作,取代鼠标和键盘的输入功能。另外学生需要合理安排界面元素,使得用户与电脑的交互能够符合人的直觉。

3.3 基于智能手机的语音识别系统

利用谷歌语音开发包或者科大讯飞语音开发平台开发一款基于智能手机的语音识别系统。该系统至少包含3个功能,例如拨打电话、写短信、查询天气或者交通等。在本实验中,学生需要安装语音识别开发包,了解不同功能的接口定义,规划需要实现的功能,合理設计交互界面,使得语音交互更加有效。此实验涉及的知识点主要有HMM算法、GMM算法和深度学习的入门知识。

4 教学成果展示

4.1 Survival in sky

Survival in sky是一款基于Kinect和Unity3D开发的互动游戏。该游戏模拟一个驾驶员跟随救生舱下落的场景,救生舱不断地出现漏洞,驾驶员需要及时修补漏洞保证自身安全,否则游戏失败(见图1)。玩家需要利用四肢动作操纵游戏角色与虚拟环境进行交互(即补漏洞)。学生利用Unity3D软件搭建3D虚拟场景,同时调用Kinect驱动程序识别玩家动作。

4.2 基于Leap motion的躲避游戏

学生利用C#和Leap motion驱动程序开发了一款躲避游戏,该游戏中,玩家需要操纵途中橙色点在界面中移动,每个关卡会出现不同数量的黄色点在界面上随机移动,玩家要操纵橙色点避开黄色点。关卡级别越高,黄色点个数越多,游戏难度越大。橙色点的移动方向由Leap motion识别出的玩家手的移动方向决定。

4.3 Chatting Robot

Chatting Robot是一款基于ISO平台的语音识别软件。用户可以通过键盘输入或者语音输入命令。在语音识别功能中,当用户说完命令后,该软件自动提交语音命令并执行。该软件支持拨打电话、新闻查看、翻译、天气查询、菜谱查询、列车信息查询,甚至支持针对特殊人群的功能(如返回网游信息、qq信息等)。

5 结 语

通过将新式人机交互设备引入用户交互技术课程,我们取得了丰硕的教学成果,主要表现在学生对这门课兴趣的提升以及优质项目的完成。通过学生设计的项目,我们也掌握了学生的兴趣点所在,有利于下一步对实验内容的改进。目前本课程已购买的设备包括Kinect、Leap motion、Apple Watch、暴风魔镜等。在接下来的教学中,我们计划继续购买虚拟头盔、数据手套、Hololens等设备,并且基于这些新设备再设计出更有趣的项目让学生去实践。

参考文献:

[1] Hewett T T, Baecker R, Card S. ACM SIGCHI curricula for human-computer interaction [EB/OL]. [2017-04-16]. http://citeseerx.ist.psu.edu/showciting?cid=1387837.

[2] 孟祥旭. 人机交互基础教程[M]. 2版. 北京: 清华大学出版社, 2010.

[3] Hinton G, Deng L, Yu D, et al. Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J]. IEEE Signal Processing Magazine, 2012, 29(6): 82-97.

[4] Saon G. Reaching new records in speech recognition [EB/OL]. [2017-04-16]. https://www.ibm.com/blogs/watson/2017/03/reaching-new-records-in-speech-recognition/.

[5] 沈莹. 用户交互技术 [EB/OL]. [2017-04-16]. http://sse.tongji.edu.cn/yingshen/course/HCI2017Spring/index.html.

(编辑:彭远红)endprint