基于弱监督预训练深度模型的微博情感分析

2017-07-18万圣贤兰艳艳郭嘉丰程学旗

万圣贤,兰艳艳,郭嘉丰,程学旗

(1. 中国科学院计算技术研究所 中国科学院网络数据科学与技术重点实验室,北京 100190; 2. 中国科学院大学,北京 100190)

基于弱监督预训练深度模型的微博情感分析

万圣贤1,2,兰艳艳1,2,郭嘉丰1,2,程学旗1,2

(1. 中国科学院计算技术研究所 中国科学院网络数据科学与技术重点实验室,北京 100190; 2. 中国科学院大学,北京 100190)

微博情感分析对于商业事务和政治选举等应用非常重要。传统的做法主要基于浅层机器学习模型,对人工提取的特征有较大的依赖,而微博情感特征往往难以提取。深度学习可以自动学习层次化的特征,并被用于解决情感分析问题。随着新的深度学习技术的提出,人们发现只要提供足够多的监督数据,就能训练出好的深度模型。然而,在微博情感分析中,通常监督数据都非常少。微博中广泛存在着弱监督数据。该文提出基于弱监督数据的“预训练—微调整”训练框架(distant pretrain-finetune),使用弱监督数据对深度模型进行预训练,然后使用监督数据进行微调整。这种做法的好处是可以利用弱监督数据学习到一个初始的模型,然后利用监督数据来进一步改善模型并克服弱监督数据存在的一些问题。我们在新浪微博数据上进行的实验表明,这种做法可以在监督数据较少的情况下使用深度学习,并取得比浅层模型更好的效果。

情感分析;深度学习;弱监督;预训练-微调整

1 引言

随着互联网的发展,人们越来越多的在网上表达自己对于各种商品或者政治人物的评价与看法,因此情感分析在商业事务及政治选举等应用中起到越来越重要的作用。目前情感分析领域效果最好的方法是监督学习和半监督学习[1],常用的模型包括支持向量机(SVM)、逻辑回归等。然而,这些模型通常都是浅层模型,浅层模型依赖于人工提取的特征,而且不能高效的表达数据中较为复杂的模式[2]。人类表达情感的方式是复杂的,常常包含否定、双重否定及其他的语言模式,此外在微博中人们的语言表达也非常的不规范,因此微博情感特征往往很难人工提取。相对于浅层模型,深度学习可以自动从原始数据中学习层次化的特征,能够更高效的表达数据中包含的复杂模式。因此,深度学习方法在情感分析领域的应用得到了广泛关注[3-6]。

深度模型通常很难训练。Hinton等人[7]提出贪婪的逐层无监督预训练(greedy layer-wise unsupervised pre-train)的方式,利用无监督数据对深度模型进行初始化,从而降低了深度模型的训练难度。近年来,随着新的深度学习技术的不断提出,比如rectifier激活函数及dropout训练方式等,人们发现只要监督数据足够多,就能训练出一个好的深度模型。然而,在微博情感分析领域,获取大规模跨领域的监督数据通常非常困难。因此,如何在少量监督数据情况下有效发挥深度模型的优势完成情感分析任务仍然是一个研究难题。

互联网上广泛存在着弱监督数据(distant supervision),比如,网络用户在发布文字的同时可能配上相应的表情符号或者打分信息。基于这些表情符号和用户打分,我们可以大概判断用户发布的文字中所包含的情感倾向性。因此,弱监督数据是很容易获得的,数据规模也比较大。它们可以作为监督数据的一种有效的补充。当然,弱监督数据也存在一些问题,首先,弱监督数据中容易包含噪声,其次,很多场景中的弱监督数据大部分是不区分领域的,所以缺少领域特定的信息。因此,直接使用弱监督数据训练得到的效果在具体领域的应用上效果也不够好。

为了结合弱监督数据规模大和监督数据精度高的优点来训练深度模型,本文提出了基于弱监督数据的“预训练—微调整”训练框架(distant pretrain-finetune, distant-PT-FT),首先使用弱监督数据对深度模型进行预训练,得到一个初始的深度模型,然后使用特定领域的少量监督数据对深度模型进行微调整。这种方法是Hinton等人提出的预训练思想[7]和弱监督数据的结合,好处是既在深度模型的训练过程中有效利用了弱监督信息,又在对深度模型进行微调整的过程利用监督数据进一步改善模型,对弱监督数据中包含的噪声进行更正的同时也引入了领域特定的信息。本文基于大规模的微博数据进行了实验,并在人工标注的数据集上进行评价。我们发现,由于引入了大规模的弱监督信息,模型效果相对于只使用监督数据取得了非常大的提升,本文提出的训练方式比简单的混合这两种监督信息进行训练的方式能进一步发挥深度模型的优势,从而取得了更好的效果。

本文的组织如下: 第二节介绍常用的深度学习模型以及训练方法;第三节主要介绍我们提出的Distant-PT-FT框架;在第四节中,我们基于新浪微博数据进行了相关实验并对结果进行分析;第五节介绍情感分析与深度学习的相关工作;最后,对本文进行总结。

2 深度神经网络与训练方法

深度学习是近年来兴起的机器学习技术,并在很多领域取得突破。常用的深度模型包括深度神经网络(DNN)、卷积神经网络(CNN)和堆叠自编码器(stacked auto-encoder)等。本章主要介绍和本文最相关的深度学习技术。

2.1 深度神经网络

深度神经网络(DNN)是最常用的深度模型之一。DNN是一个层次化结构,一个K层的DNN包括输入层(H1) 、隐藏层(H2~K-1)及输出层(HK)。DNN的输入层接收一个固定维度的向量x∈RnH1并输出到下一层,其中,nHk表示第k层的节点数。隐藏层的输入是上一层的输出,其对输入进行一个线性变换然后再执行逐元素的(element-wise)非线性函数,也就是激活函数,得到该层的输出hk,传统的激活函数包括双曲正切(tanh)等,如式(1)所示。

hk=tanh (Wkhk-1+bk)

(1)

其中,Wk∈RnHkXnHk-1和bk∈RnHk×1是第k层的参数。输出层是softmax层,输出每个类别的概率,即式(2):

(2)

DNN通常使用随机梯度下降(SGD)结合后向传播(BP)的方式进行训练。

在情感分析等常见文本分类任务中,每篇文档可以先通过向量空间模型表达为一个固定维度的向量,然后输入到DNN中,所以DNN输入层的节点数就是所使用的词表的长度,DNN的输出层上的每个节点对应一个类别,在本文中我们将微博情感分析任务定义为一个二分类问题,所以输出层的维度是2。在本文的工作中,DNN是我们使用的基本深度模型。然而,本文提出的框架并不局限于此模型。

2.2 贪婪的逐层无监督预训练

包括DNN在内的很多深度模型的训练难度很高,一方面,训练过程求解的是一个非凸的优化问题,容易陷入局部最优解;另一方面,深度模型通常表达能力很强,很容易过拟合。Hinton等人[7]提出贪婪的逐层无监督预训练的算法,首先利用浅层的无监督的受限玻尔兹曼机(RBM)从输入层到输出层逐层对深度模型的参数进行预训练,从而将深度模型的参数初始化到一个合适的地方,然后再使用传统的监督训练方法对模型参数进行进一步的优化,也就是微调整。分析表明,利用无监督的数据对深度模型的训练起到了很好的正则作用[8]。这种方法降低了深度学习模型的训练难度,使得深度模型取得更好的效果,在早期的深度学习中起到了重要的作用。

2.3rectifier和dropout

近年来,新的深度学习技术被不断提出,Glorot等人[9]提出使用rectifier函数作为激活函数,rectifier的函数形式是f(x)=max (0,x)。rectifier相对于tanh、logistic等传统激活函数,在优化上更有优势,它能使SGD过程中参数的梯度更好的后向传播。此外,Hinton等人[10]还提出了dropout的训练方式,在训练中随机对网络节点进行丢弃(drop),这种方式可以有效的减轻神经网络的过拟合。

人们发现,只要监督数据足够多,直接使用rectifier结合dropout就能训练出好的深度模型,而不需要进行无监督预训练过程[9]。然而,在情感分析中,监督数据通常较为稀缺,但是大规模弱监督数据则容易获得。弱监督数据和监督数据有着同样的格式,可以使用同样的训练方法(rectifier和dropout)进行深度神经网络的训练,但是,弱监督数据并不能直接替代监督数据。因此,本文将预训练的思想和弱监督数据结合起来,提出了基于弱监督数据的“预训练—微调整”框架。

3 基于弱监督数据的“预训练—微调整”训练框架

在微博情感分析的场景中,监督数据通常比较稀缺。一方面,精确的人工标注的监督数据往往获取代价较大;另一方面,情感分析还面临一个领域适应问题,主要是因为情感的表达在不同的领域有不同的模式,不同领域之间情感词的使用可能有很大的不同,而且同一个情感词在不同领域可能表达完全相反的情感,这要求我们针对不同的领域标注不同的数据。这些因素都给大规模获取监督数据带来很大的困难。为了解决这个问题,很多工作提出使用弱监督数据[11-16]。

弱监督数据是指数据的监督信息并不是由严格的人工标注得到的,而是通过一些其他的相关信息推断出来的。比如,在微博客网站中,网站提供表情符号的功能,用户发布文字消息的时候常常伴随着一个表达内心情绪的表情符号,通过表情符号我们可以推断文字所表达的情感极性;在商品评论网站中,用户评论信息也常常伴随着商品评分,根据评分也可以推断用户评论的情感极性。这种数据在互联网上大量存在,获取难度比人工标注的数据低很多,因此可以轻易地获得大规模的弱监督数据。于是,我们可以考虑使用大规模的弱监督数据来训练深度模型。

然而,弱监督数据也存在一些问题。首先,这些数据包含大量的噪声,这些噪声会对模型的训练带来很大的负面影响;其次,这些数据通常比较杂乱,没有针对特定的情感领域,所以也没有体现领域特定的信息。因此,单独使用弱监督数据进行模型训练并不能取得足够好的效果。

为了有效的利用大量的弱监督数据及每个领域中少量的监督数据进行深度模型的训练,本文借鉴了第三节中介绍的预训练策略,提出了基于弱监督数据的“预训练-微调整”训练框架(distantPT-FT)。之前的预训练方法是基于无监督数据的,只能利用数据本身的一些结构信息。distantPT-FT使用弱监督数据来进行预训练: 首先基于弱监督数据训练得到初始的深度模型,然后在此模型的基础上再使用每个领域特定的监督数据进行微调整。弱监督数据和监督数据有着同样的格式,可以采用和监督数据一样的训练方法。因此,distantPT-FT框架的实现就是先使用弱监督数据对模型训练到一定程度后,再采用监督数据继续进行训练,具体算法见算法1。此外,由于弱监督数据量非常大,因此不需要再进行无监督数据的预训练。

算法1distant PT-FT

输入: 弱监督数据Dd,监督数据Ds。

输出: 模型参数θ。

1. 随机初始化参数θrand,使用Dd训练得到θd。

2. 使用θd作为参数初始化及参数先验,使用Ds训练得到θ。

3. 返回θ。

此外,为了更好的利用预训练得到的初始模型,我们也提出了另一种模型参数正则化的方式。正则化是机器学习中用于控制模型过拟合的方法,从概率的角度,正则化可以认为是一种对于模型参数的先验知识。通常使用的正则包括L2正则(也称为权重衰减,weightdecay)。L2正则意味着人们对模型参数的先验知识是模型参数服从高斯分布。通常我们认为该高斯分布的均值是0,方差是通过超参数来手工调整的。参数的优化目标为式(3)。

(3)

其中,θ为模型参数。在distantPT-FT框架中,我们提出以预训练阶段得到的模型参数作为微调整阶段模型参数的高斯先验的均值,也就是期望约束微调整阶段的参数不要偏离预训练阶段得到的参数太远。实验中,我们把两种L2正则方式结合使用,也就是优化目标为式(4)。

(4)

其中,θd为弱监督数据预训练得到的模型初始参数。

4 实验

本节先介绍我们使用的微博数据集,然后介绍DNN的参数设置及不同的基准方法。在第一个实验中我们将对比各种模型和训练方式的效果,最后展示了数据规模对结果的影响。

4.1 数据集

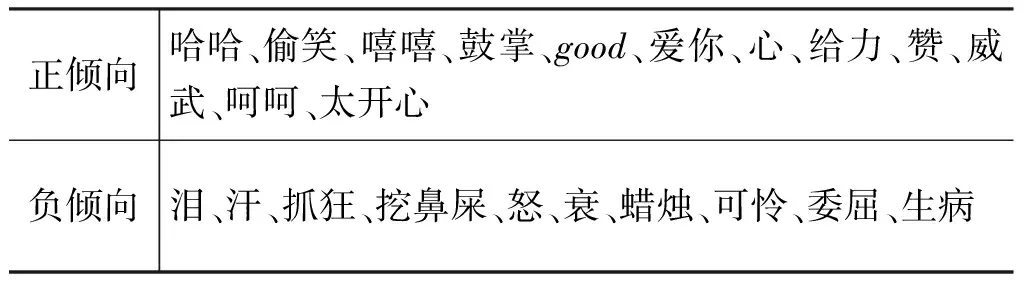

我们从新浪微博中收集了从2013-05-01到2013-06-30两个月的消息数据,共 2亿条消息。为了获取弱监督信息,我们使用新浪微博提供的表情符号。新浪微博提供了几十种不同的表情符号,表达人类各种各样的情绪。这里我们把情感分析定义为一个二分类问题,也就是给定一条微博判断其情感是正倾向还是负倾向。因此我们手工提取了20个具有较明确的正、负情感倾向的表情符号,见表1。我们从所有消息中随机选取了160万条(正、负各80万条)包含正、负倾向表情符号的消息作为我们的弱监督数据集。

表1 收集弱监督数据时使用的表情符号

为了评价实验结果,我们手工标注了5 000条微博,主要包括“三星”、“翡翠”和“保险”三个领域。每一条消息由三个标注者进行标注并最终投票决定。然而,某些领域存在正、负类别严重不平衡的问题。最终,我们使用“三星”这个领域来进行评价,这个领域共包含了1 700条正、负类别平衡的标注数据。我们把标注数据随机划分成800条、400条和500条,分别作为训练集、验证集和测试集。

我们首先使用ICTCLAS*http://ictclas.nlpir.org/对以上所有的消息进行了分词。然后采用和文献[3]类似的方式,根据单词的文档频率(document frequency)选取在整个数据集中出现最频繁的5 000个单词作为词表,将文档表示为一个5 000维的二值向量,如果单词在文档中出现,则该单词对应的维度的值为1,否则为0。

4.2 参数设置

我们使用的网络结构为[5 000, 200, 200, 200, 2],也就是输入层有5 000个节点,三个隐层各有200个节点,输出层有两个节点。这是一种常用的网络结构,由于更大的隐层节点数会给计算量带来很大的增加,而在初始实验中,我们发现隐层节点数设置到200以后,模型的效果并没有明显的改善,因此我们并没有使用更大的网络。

我们使用SGD结合BP的方式来对网络进行训练,每批数据的大小(batch size)设置为10,输入层不采用dropout,所有隐层的dropout概率设置为0.5。学习速率是根据验证集的效果动态调整的,在预训练阶段每训练10 000批数据或者在微调整阶段每训练完一遍所有监督数据之后,如果验证集效果变差,则对学习速率进行衰减(乘以0.8)。在预训练阶段结束后,我们根据验证集上的最好效果,选择相应的模型再继续进行微调整阶段的训练。我们对模型参数同时采用了前述的两种L2正则方式。这些超参数都是根据验证集进行调节的,预训练阶段和微调整阶段使用的是不同的超参数。

4.3 基准方法

为了验证distant PT-FT的效果,我们选择了一些基准方法进行对比。从模型的角度,我们选择线性SVM和LR作为基准模型,这些都是情感分类中常用的模型,我们使用了LIBLINEAR*http://www.csie.ntu.edu.tw/~cjlin/liblinear/的模型实现。从训练方式的角度,我们对比了以下四种训练方式。

(1) label: 只使用监督数据进行训练。

(2) distant: 只使用弱监督数据进行训练。

(3) label+distant: 把弱监督数据和监督数据直接合并作为训练数据,由于弱监督数据和监督数据的规模差别太大,我们按一定倍数复制监督数据,复制的倍数也是作为超参数进行人工调整的。

(4) distant PT-FT: 本文提出的基于弱监督数据的“预训练—微调整”训练框架。

以上前三种训练方式都分别针对所有模型进行训练,最后一种方式用于训练DNN。我们使用分类准确率作为评价指标,即式(5)。

(5)

4.4 实验结果分析

不同模型及训练方式的情感分类准确率如图1所示。我们发现单独使用弱监督数据直接训练得到的模型已经取得了和小规模监督数据相近的准确率,这说明在缺少监督数据的情况下,弱监督数据的确是一个有效的替代。然而,从另外一个角度来看,虽然使用了大量的弱监督数据,模型效果依然只相当于少量的监督数据的,这也说明弱监督数据存在很大的噪声,其质量比起监督数据还有较大的差距。

图1 不同模型及训练方式的情感分类准确率

在只使用监督数据的时候,LR、SVM和DNN的效果差别不大,而DNN的表达能力强很多,因此在小规模数据情况下,DNN的优势并没有得到充分发挥。然而,在只使用弱监督数据的情况下,尽管数据规模很大,DNN的效果提升依然不明显,我们认为这是由弱监督数据和目标领域数据之间存在的差异,以及弱监督数据中存在的噪声导致的,深层模型由于具有较强的拟合能力,反而可能过分拟合了弱监督数据中存在的噪声,而简单的模型抗噪声能力更强。

尽管弱监督数据和监督数据单独训练的结果都不是太好,但是如果我们把两者合并起来训练,不管是浅层模型还是深度学习模型效果都能有很大的提升,所以,弱监督数据和监督数据各有利弊,两者可以有效的相互辅助。

在使用了本文提出的distantPT-FT训练框架之后,DNN的效果进一步得到提升并更加显著的超过了浅层模型。这说明在微调整的过程中,监督数据对深度模型的训练起到了很大的作用,能够帮助克服深度模型对噪声等其他因素的过拟合,从而提升了深度模型的效果。这种方式和直接把弱监督数据及监督数据混合到一起之后进行训练的方式相比,尽管利用了同样的信息,但是效果却有很大不同,因此,distantPT-FT框架可以更好的利用这两种数据。

总的来说,distantPT-FT训练框架对深度模型有很大的效果提升,而且在大规模数据的情况下,深度模型的效果明显优于浅层模型。

4.5 数据规模对结果的影响

本节中,我们分析数据的不同规模对最终结果的影响。我们先使用所有的弱监督数据,观察不同监督数据规模的影响,然后,我们使用所有的监督数据,观察不同弱监督数据规模的影响,实验结果见图2。

在图2(a)中,不管在有没有弱监督数据的情况下,监督数据量的增加都能稳定的提升最终效果,这说明为了得到较高的准确率,监督数据的作用是弱监督数据无法替代的。在监督数据较少的情况下,弱监督数据的作用是很大的,利用了弱监督信息的模型效果明显高于仅使用监督数据的模型。

图2 数据规模对结果的影响

在图2(b)中,我们发现在仅仅使用弱监督数据的情况下,随着数据规模的增长,DNN的表现并不是非常稳定。然而,在结合了监督数据之后,DNN的最终效果随着弱监督数据规模的增长而稳定增长,这也说明监督数据的引入可以有效的克服弱监督数据可能引入的噪声等问题,从而能够更好的利用大规模的弱监督数据。

5 相关工作

为了解决情感分析中获取监督数据困难的问题,Go等人[11]首先提出使用推特上的弱监督数据来训练情感分析模型,发现弱监督数据是情感分析模型很好的训练数据源。紧接着又涌现出一批基于弱监督数据的情感分析工作[12-15],这些工作都是直接利用弱监督数据作为训练数据,文献[16]指出弱监督数据存在大量噪声的问题,并尝试结合使用弱监督数据与监督数据,他们使用监督数据训练一个用于情感分析的语言模型,然后使用弱监督数据对语言模型进行平滑。

近年来,深度学习越来越多的被应用于文本表达学习[17-18]及情感分析[3-4,6,9,19]。文献[3]采用了堆叠自编码器作为特征提取器并在无监督的数据上进行训练,基于抽取到的特征利用SVM进行分类,实验发现深度模型抽取到的特征具有更好的跨领域性。文献[4]使用DBN结合主动学习的策略进行情感分类。文献[9]首次将rectifier节点的神经网络用于情感分析,并取得很好的效果。这几个工作仍然是基于无监督的数据进行特征提取或者预训练。文献[6,19]中尝试利用弱监督数据进行深度模型的训练,文献[6]利用弱监督信息指导DBN进行文档表达学习,学习得到的表达可以作为特征用于情感分类。文献[19]利用弱监督信息指导单词表达的学习,让学到的单词表达可以包含情感信息。

6 总结和未来工作

深度模型越来越广泛的被用于包括图像和语音识别在内的很多应用中,并取得当前最好效果。训练深度模型在情感分析领域面临的问题是很难得到大规模的监督数据。为解决该问题,本文提出了基于弱监督数据的“预训练-微调整”训练框架,首先使用弱监督数据预训练深度模型,然后再使用监督数据对其进行微调整。基于大规模微博数据的实验表明,使用本文提出的训练方式, 能够更好的结合弱监督和监督这两种数据的优势, 使深度模型取得比浅层模型更好的效果。

目前,DNN这种通用的深度模型在情感分析上的效果并没有很大的突破,其中一个重要的原因是这些深度模型并没有针对单词序列进行建模,模型的输入都是基于词袋模型假设的。下一步,我们考虑将本文提出的训练框架应用在其他建模了单词序列的深度模型中。

[1]BoPang,LillianLee.Opinionminingandsentimentanalysis[J].FoundationsandTrends(R)inInformationRetrieval, 2008, 2(1-2): 1-135.

[2]YoshuaBengio.LearningdeeparchitecturesforAI[J].Foundationsandtrends(R)inMachineLearning, 2009, 2(1):1-127.

[3]XavierGlorot,AntoineBordes,YoshuaBengio.Domainadaptationforlarge-scalesentimentclassification:Adeeplearningapproach[C]//ProceedingsofICML, 2011:513-520.

[4]ShusenZhou,QingcaiChen,XiaolongWang.Activedeeplearningmethodforsemi-supervisedsentimentclassification[C]//ProceedingsofCOLING, 2010:1515-1523.

[5]RichardSocher,AlexPerelygin,JeanYWurew,etal.RecursivedeepmodelsforsemanticcompositionalityoverasentimentTreebank[C]//ProceedingsofEMNLP, 2013: 1631-1642.

[6]DuyuTang,BingQin,TingLiu,etal.LearningsentencerepresentationforemotionclassificationonmicroblogsNat[C]//ProceedingsofNaturalLanguageProcessingandChineseComputing, 2013:212-223.

[7]GeoffreyE.Hinton,RuslanR.Salakhutdinov.Reducingthedimensionalityofdatawithneuralnetworks[J].Science, 2006, 313(5786):504-507.

[8]DumitruErhan,PierreAntoineManzagol,YoshuaBengio,etal.TheDifficultyofTrainingDeepArchitecturesandtheEffectofUnsupervisedPre-Training[C]//ProceedingsofAISTATS, 2009:153-160.

[9]XavierGlorot,AntoineBordes,YoshuaBengio.DeepSparseRectifierNeuralNetworks[C]//ProceedingsofAISTATS,2011:315-323.

[10]GeoffreyEHinton,NitishSrivastava,AlexKrizhevsky,etal.Improvingneuralnetworksbypreventingco-adaptationoffeaturedetectors[arXiv]. 2012.arXivpreprintarXiv:1207.0580.

[11]AlecGo,RichaBhayani,LeiHuang.Twittersentimentclassificationusingdistantsupervision[R].CS224NProjectReport:Stanford, 2009.

[12]LucianoBarbosa,JunlanFeng.Robustsentimentdetectionontwitterfrombiasedandnoisydata[C]//Proceedingsofthe23rdInternationalConferenceonComputationalLinguistics, 2010:36-44.

[13]DmitryDavidov,OrenTsur,AriRappoport.Enhancedsentimentlearningusingtwitterhashtagsandsmileys[C]//Proceedingsofthe23rdInternationalConferenceonComputationalLinguistics, 2010:241-249.

[14]JichangZhao,LiDong,JunjieWu,etal.Moodlens:anemoticon-basedsentimentanalysissystemforchinesetweets[C]//ProceedingsofKDD, 2012:1528-1531.

[15]AlexanderPak,PatrickParoubek.TwitterasaCorpusforSentimentAnalysisandOpinionMining[C]//ProceedingsofLREc, 2010:1320-1326.

[16]KunLinLiu,WuJunLi,MinyiGuo.Emoticonsmoothedlanguagemodelsfortwittersentimentanalysis[C]//ProceedingsofAAAI, 2012:1678-1684.

[17]Marc’AurelioRanzato,MartinSzummer.Semi-supervisedlearningofcompactdocumentrepresentationswithdeepnetworks[C]//ProceedingsofICML, 2008:792-799.

[18]RuslanSalakhutdinov,GeoffreyHinton.Semantichashing[J].InternationalJournalofApproximateReasoning, 2009, 50(7):969-978.

[19]DuyuTang,FuruWei,NanYang,etal.LearningSentiment-SpecificWordEmbeddingforTwitterSentimentClassification[C]//ProceedingsofACL, 2014:1555-1565.

PretrainDeepModelsbyDistantSupervisionforWeiboSentimentAnalysis

WAN Shengxian1,2, LAN Yanyan1,2, GUO Jiafeng1,2, CHENG Xueqi1,2

(1. CAS Key Laboratory of Network Data Science and Technology, Institute of Computing Technology, Chinese Academy of Sciences, Beijing 100190, China;2. University of Chinese Academy of Sciences, Beijing 100190, China)

Sentiment analysis (SA) is important in many applications such as commercial business and political election. The state-of-the-art methods of SA are based on shallow machine learning models. These methods are heavily dependent on feature engineering, however, the features for Weibo SA are difficult to be extracted manually. Deep learning (DL) can learn hierarchical representations from raw data automatically and has been applied for SA. Recently proposed DL techniques shown that one can train deep models successfully given enough supervised data. However, in Weibo SA, supervised data are usually too scarce. It is easy to obtain large scale distant supervision data in Weibo. In this paper, we proposed to pre-train deep models by distant supervision and used supervised data to fine-tune the deep models. This approach could take the advantages of distant supervision to learn good initial models while using supervised data to improve the models and to correct the errors brought by distant supervision. Experimental results on Sina Weibo dataset show that we can train deep models with small scale supervised data and obtain better results than shallow models.

sentiment analysis; deep learning; distant supervision; pretrain-finetune

万圣贤(1989—),博士研究生,主要研究领域为文本挖掘与深度学习。

兰艳艳(1982—),博士,副研究员,主要研究领域为统计机器学习、排序学习和信息检索。

郭嘉丰(1980—),博士,副研究员,主要研究领域为信息检索与数据挖掘。

1003-0077(2017)03-0191-07

2014-09-15定稿日期: 2015-12-10

973基金项目(2014CB34040401,2012CB316303);国家自然科学基金(61232010,61472401,61433014,61425016,61203298);中国科学院青年创新促进会(20144310,2016102)

TP391

: A