基于激光反射率的点云与图像自动融合

2017-07-01赵玲娜花向红

赵玲娜,花向红,刘 闯,李 万

(1.武汉大学 测绘学院,湖北 武汉 430079;2.地球空间信息技术协同创新中心,湖北 武汉 430079;3.武汉大学 灾害监测与防治研究中心,湖北 武汉 430079;4.武汉大学 测绘遥感信息工程国家重点实验室,湖北 武汉 430079)

基于激光反射率的点云与图像自动融合

赵玲娜1,2,3,花向红1,2,3,刘 闯1,2,3,李 万4

(1.武汉大学 测绘学院,湖北 武汉 430079;2.地球空间信息技术协同创新中心,湖北 武汉 430079;3.武汉大学 灾害监测与防治研究中心,湖北 武汉 430079;4.武汉大学 测绘遥感信息工程国家重点实验室,湖北 武汉 430079)

提出一个基于激光反射率的点云图像自动融合算法,数字图像与点云反射率图像特征点匹配,得到数字图像特征点像点坐标和相应物点物方空间坐标对,采用直接线性变换算法(DLT)建立点云数据反投影至二维图像点的投影模型,实现点云图像自动融合,得到目标表面的全面信息,包括物体表面三维坐标和纹理信息。自动地实现点云图像融合,无需人工参与,提高效率和准确率,同时结合实验验证该算法的可行性。

激光反射率;点云反射率图像;图像特征点匹配;点云反投影模型;点云图像融合

三维激光扫描仪可以获取高精度的点云3D坐标和强度信息,图像则是场景2D高分辨率真彩色信息的直观展示。两者的融合实现客观世界的3D真彩色表达,推动多个行业和应用,如虚拟图书馆、游戏娱乐应用、建筑物展示和恢复、考古、虚拟现实以及旅游业的前进和发展。因此,点云图像融合成为目前备受关注的重要问题。

目前点云图像融合主要集中在时间匹配和后处理特征匹配上,时间匹配自动化程度高,但是精度较差且对设备要求高;更加通用的基于特征匹配的方法又可分为两种:一种是确定点云数据和图像的转换模型,进行叠加;另一种通过控制点进行摄像机标定,借助相机内外参数确定点云和图像的相互关系。McAllister et.al.[1](1999)提出一种基于点云深度图像的融合算法,匹配深度图像和数字图像的特征线,确定两者的转换关系,该方法的局限是相机和激光扫描仪需在同一位置。Lensch et.al.[2](2001)提出一种基于轮廓线的自动融合方法,该方法只适用于整张相片只包含单一结构物体的点云图像融合。Peter K.Allen et.al.[3](2003)通过点云平面分割分离出建筑物点云边界线,与图像特征线匹配,计算点云与图像的仿射变换矩阵,该方法可适应于结构复杂具有鲜明线特征的古迹建筑物,而且分割阈值需要人工设定。Al-Manasir K et.al.[4](2006)首先利用安装摄像机的三维激光扫描仪同时对贴了靶标的场景拍照和获取点云,采用主动视觉相机序列标定解算相机的位置和姿态,之后确定相机和扫描仪的空间转换关系。该方法需要相机固定在扫描仪上,且需要空间靶标,主动视觉自标定过程也比较复杂。邓非等人[5](2007)提出一种利用立体像对匹配点和点云坐标配准的融合算法,该算法首先利用立体像对求解若干图像特征点的三维坐标,人工参与找出对应的点云坐标求出初始变换矩阵,之后用ICP算法进行精确配准。Aguilera D G et.al.[6](2007)和李知达[7](2014)采用了基于深度图像的点云数字图像融合算法,通过深度图像和数字图像特征点匹配,确定若干空间坐标和像素坐标对,然后摄像机标定求解相机参数,最后将点云数据投影到二维图像。由于深度和真彩色表达的信息不同,该方法对于颜色变化明显但表面平整的场景并不适用。Liang Y et.al.[8](2016)利用数字图像的相机模型将点云数据反投影到图像平面,生成反射率图像,然后借助同名点通过仿射变换实现点云图像融合。该方法需要预先知道数字图像的相机模型,而且反投影参数设置不当会导致反射率图像产生空洞。因此,本文提出一种基于激光反射率的点云图像自动融合算法,通过实验验证了该方法的可行性和实用性。

1 算法原理与实现流程

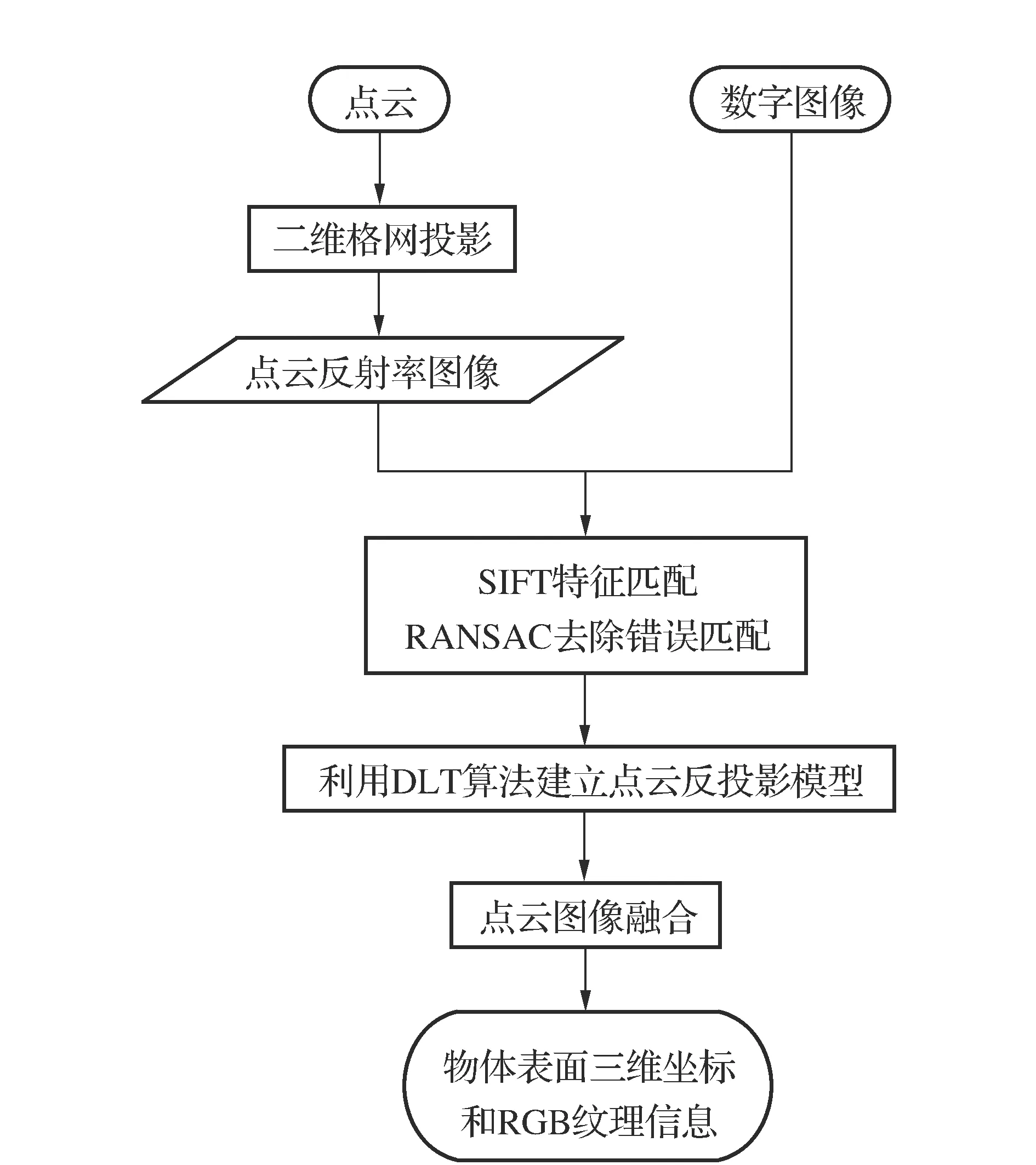

如图1所示,基于激光反射率的点云图像自动融合算法的基本思想是:首先,将点云数据沿着激光束方向投影到平面,可选大概对应图像中心点的激光束方向为该面法向量,按照图像的大小将平面格网化,每个小格网由像素坐标、空间坐标和反射率(x,y,X,Y,Z,Reflectance)表示,生成反射率图像;第二,进行图像SIFT特征点匹配,将反射率图像特征点的三维坐标传递给数字图像的同名特征点,得到数字图像特征点像点坐标和相应物点物方空间坐标对(2D-3D);第三,采用考虑畸变信息的非线性直接线性变换(DLT)算法建立点云数据反投影至二维图像点的投影模型,解算每个点云坐标对应的图像像素坐标,并将最邻近像素RGB信息赋予点云。

图1 点云图像融合算法流程

1.1 点云反射率图像生成

三维激光扫描仪的激光波段为近红外,所以扫描仪获取的反射率信息表达的是物体表面对近红外线的反射能力;图像的RGB反映了投射在光敏面元上的光强信息,通过统计学的方法可以近似确定RGB和反射率的函数关系[9]。

原始点云(X,Y,Z,Reflectance,…)转化为2D反射率图像(x,y,Reflectance)本质是将三维坐标投影到2D平面的问题。由于图像是由规则阵列的亮度值表示,因此需要对投影后的数据按照格网化分,本文的点云数据与数字图像场景基本吻合,所以格网分辨率由图像尺寸决定,避免人工参与过程。

1)确定投影面:选取场景中心区域一点的点云坐标(x,y,z),投影面的法向量为n=(a,b,c)=(x,y,z),选取离扫描仪最远一点作为该投影面上一点以确定其平面方程:ax+by+cz+d=0;

2)计算点云投影后坐标:沿着激光发射方向将点云数据投影到平面上,沿着激光束的方向而不是垂直投影,可能会导致反射率图像弯曲变形,但避免投影后出现格网空洞,且图像变形并不影响下一步的特征匹配。激光束方向可由每个点坐标(X,Y,Z)i表示,记投影后的点云(X′,Y′,Z′,Reflectance)i。

3)生成点云反射率图像:将平面点云按照数字图像的尺寸划分为m×n个小矩形格网,每个格网内有若干个点,取最靠近格网中心的点云反射率的值作为该格网的亮度值,最后整体归一化至(0~255)。并记录最靠近格网中心的点坐标,生成的反射率图像的每个像素由一个6维向量(x,y,X,Y,Z,Reflectance)i(i=1,2,…,m×n)描述,其中,(x,y)是像素坐标,(X,Y,Z,Reflectance)i是点云信息。

1.2 图像特征点匹配

图像特征点匹配目的是寻找反射率图像和数字图像的同名点,传递匹配点三维坐标至数字图像,达到不需要布设控制点和人工参与就可以得到数字图像特征点像点坐标和相应物点物方空间坐标对的目的。

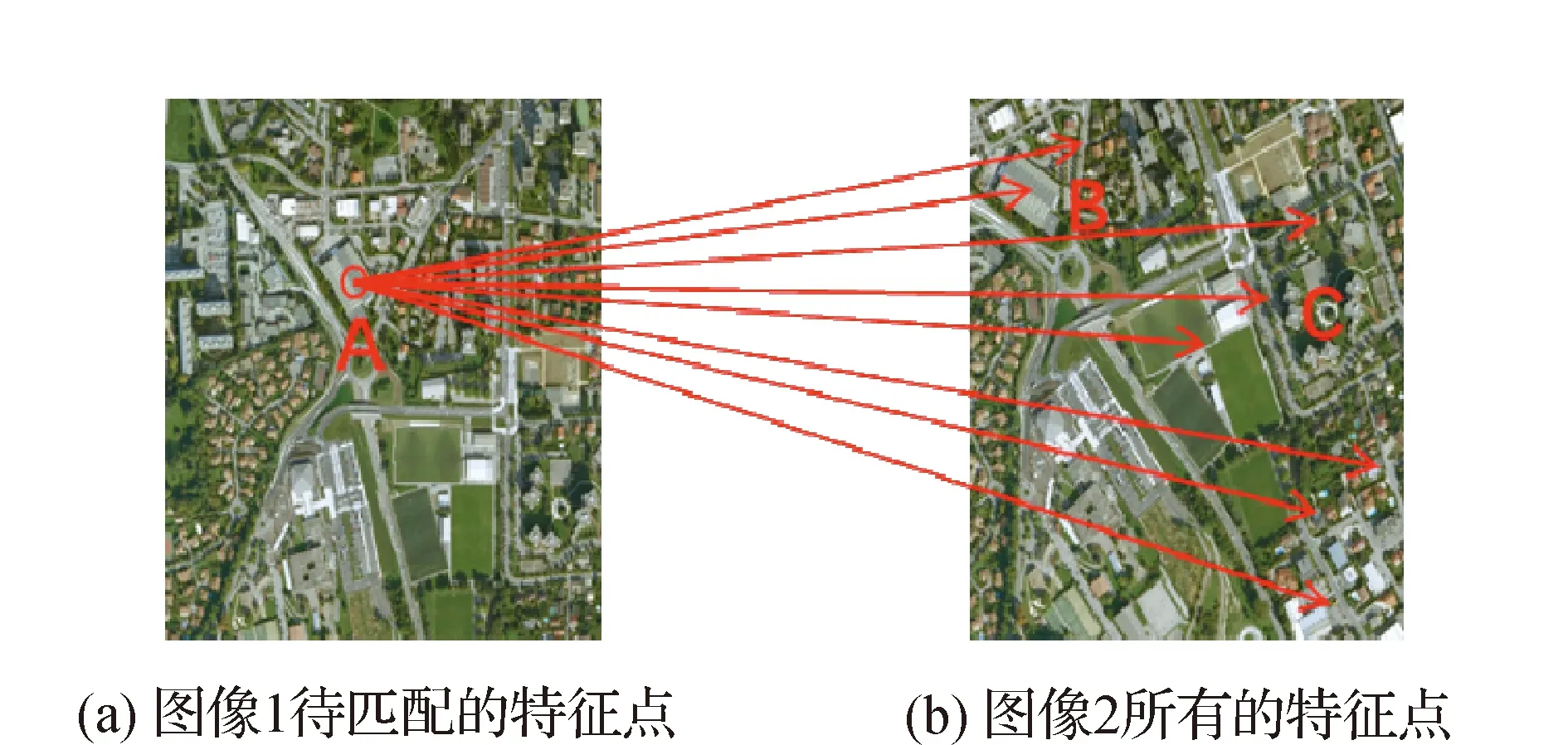

图像匹配采用经典的具有鲁棒性的尺度不变特征变换(Scale Invariant Feature Transform,SIFT)算法[10],该算法可以提取具有旋转变化具有不变性,对光照变化和图像变形具有较强适应性的特征点,并用128维特征描述符表示。不同图像同名点匹配是通过计算特征描述符之间的欧氏距离进行,有

d(A,B)=d(B,A)=

(1)

如图2所示,AB,AC分别表示图像(a)上A点到图像(b)所有特征点的最小和次小距离。则特征点匹配判定准则为

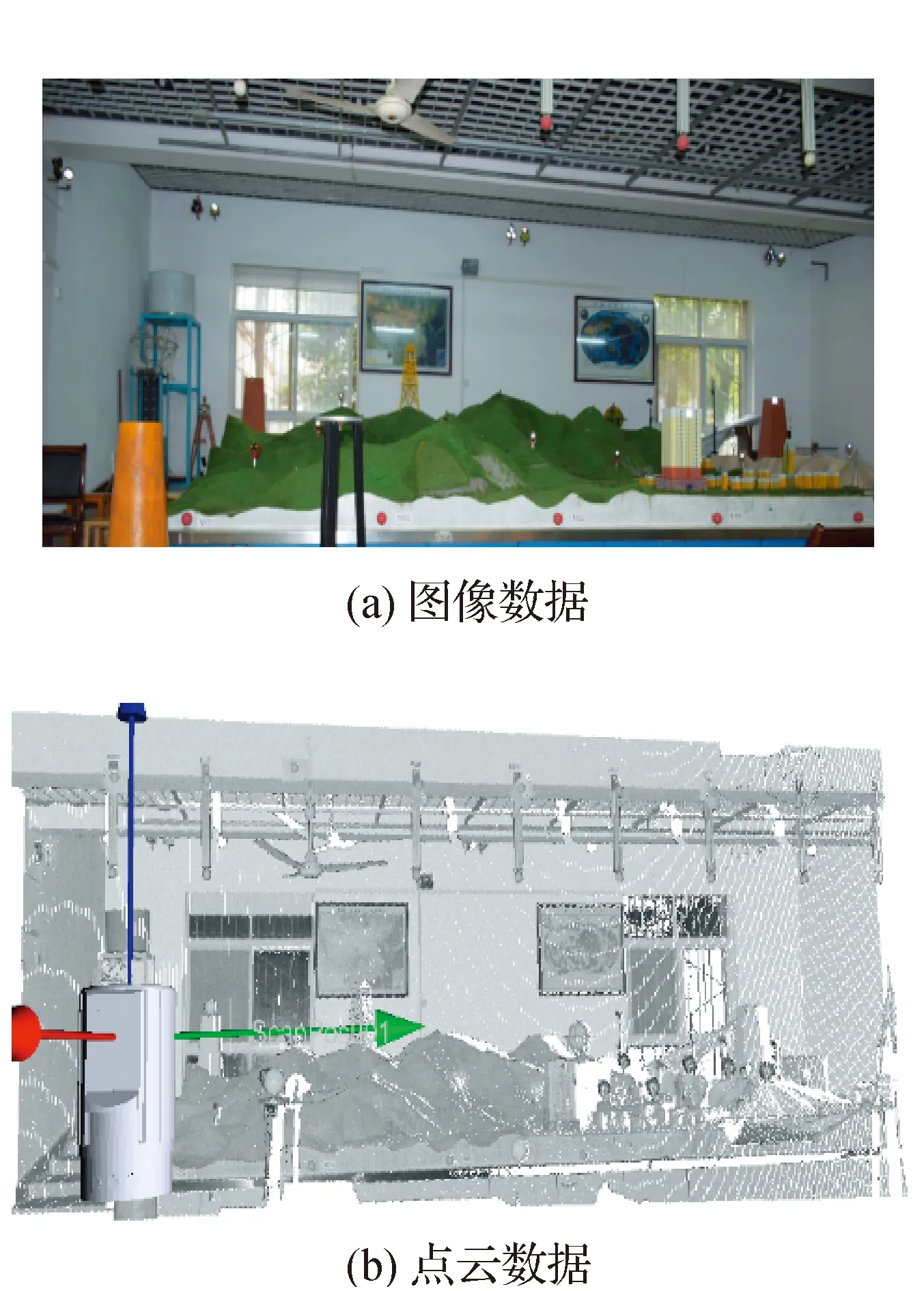

即最小和次小距离的比值小于某一阈值t(经验值为0.8)。这种方法可以高效快捷的找到同名点,但还需要用其他方法剔除误匹配,通常采用随机抽样一致(RANdom SAmpling Consensus,RANSAC)算法[11]。 图2 特征点SIFT描述符欧氏距离 1.3 点云反投影模型建立 直接线性变换(Direct Linear Transformation,DLT)是在不需要相片内外方位元素初始值的情况下快速建立像点坐标和相应物点物方空间坐标之间函数关系的算法,适用于非测量摄像机的数据处理。反射率图像和数字图像匹配特征点(xd,yd,X,Y,Z)j,建立点云反投影模型。 根据文献[13],线性DLT的基本关系式为 (2) 式中:(x,y)为数字图像的像素坐标,(X,Y,Z)为匹配得到的像点对应的物方空间坐标,是相机参数的函数表达式[13]。11个参数需要至少6个已知像素坐标和三维空间坐标的控制点,解得各参数的近似值。 考虑到镜头畸变,包括径向和切向畸变,像点坐标存在非线性改正数Δx,Δy,仅用式(2)求解的参数进行点云图像数据融合,求得的像素坐标在图片边缘区域误差较大,因此本文采用非线性DLT求解点云反投影至像点坐标的模型,即式(3)和式(4)。 (3) Δx=(x-x0)(k1r2+k2r4)+P1[r2+ 2(x-x0)2]+2P2(x-x0)(y-y0), Δy=(y-y0)(k1r2+k2r4)+P2[r2+ 2(y-y0)2]+2P1(x-x0)(y-y0). (4) 1.4 点云图像融合 由式(3)和式(4)可知,点云图像融合是已知反投影模型和点云数据求解像素坐标,先利用式(2)求像点近似坐标(x0,y0) ,再利用不动点迭代[14]求解像素坐标的精确数值(x,y)。 如图3所示[15],点云反投影到图像平面后的像素坐标不一定是整数,取最临近的像素为该点云的反投影像点坐标,将对应像素的RGB赋予点云,实现点云RGB纹理贴图,得到实验目标表面的全面信息,完成点云图像自动融合。 图3 相机针孔模型 2.1 实验方案 为验证基于激光反射率的点云图像自动融合算法的可行性,采用RIEGL VZ-4000三维激光扫描仪获取点云数据,点位分辨率为0.01 m;采用尼康D5300相机拍摄相片,尺寸为2 698像素×1 800像素,实验场地及采集数据如图4所示。 图4 实验场地及点云图像数据 2.2 数据处理与初步分析 如图4所示,取图4(b)(点云中心坐标(-9.198,0.810,0.017)作为反射率图像投影面的法向量。令离扫描仪最远的一点(-12.367,6.805,0.403)落在投影面上,从而确定投影面,然后将点云数据沿着激光束的方向进行投影。按照数字图像的尺寸,生成格网2 698像素×1 800像素的深度图像和反射率图像,如图 5和图 6所示。 图5 深度图像 图6 反射率图像 由图5和图6可以看出点云生成的反射率图像比深度图像更加符合数字图像的特征变化。用SIFT特征点匹配算法寻找深度图像和反射率图像与数字图像的同名点,并用RANSAC消除匹配误差,结果如图7和图8所示。 图7 数字图像和点云深度图像同名点匹配 图8 数字图像和点云反射率图像同名点匹配 由图7和图8表明:深度图像和数字图像灰度值表示的意义不同,所以特征点无法准确匹配,只适用于文献[6]和文献[7]所述的结构简单规则的场景。反射率图像则可以很好的与数字图像特征点匹配,如图8所示,用sift算法共得到了29对匹配特征点,然后采用RANSAC算法通过最小化变换矩阵代价函数剔除4对错误匹配[16]。 将匹配特征点的数字图像像素坐标及其对应空间坐标(xd,yd,X,Y,Z)j带入式(3)和式(4)求解反投影模型的15个参数值,见图9点云RGB纹理贴图。 将所有点云数据按照反投影模型求解对应的像素坐标,进行数据融合见表1。融合后的点云RGB纹理贴图如图9所示。 图9 点云RGB纹理贴图 表1 DLT得到像素坐标和对应空间坐标函数转换模型参数 由图9可以看出:点云RGB纹理贴图效果比较理想,图中出现的空白有两种原因:一是,高反射率的物体如玻璃,棱镜等产生的高斯现象,这种点云数据严重偏离真实坐标,需要在数据预处理中剔除;另一种是由于三维激光扫描仪和相机的位置和视角不同,反投影到图像平面的点云会产生遮挡和覆盖,覆盖部分由于前面的点云优先显示,遮挡部分激光无法到达,因此没有对应的图像平面上的像素点。总之,本文的融合算法得到的结果比较理想。 2.3 融合精度分析 为了进一步从数据上分析融合精度,本文人工选取相对均匀分布的16个点来验证融合精度,如图10所示。点云反投影到图像平面的像素坐标误差,按照误差的大小进行排序,如表2所示。 图10 融合精度分析点位分布 点号控制点数据融合数据误差点云坐标/m像素坐标像素坐标XYZxyxydx2+dy214-11 319-0 6410 5751032 026737 93491031 591738 30610 57189110-8 0051 0550 1311486 974784 0551486 322784 28890 69267411-7 7951 627-0 0511671 089839 0551669 715838 7791 4005687-5 3031 002-0 7321673 0941109 0161671 3351107 8642 10240213-11 304-0 6331 6941037 078510 01821036 371507 67532 44736112-9 0062 40 0891789 135822 9741786 622822 27372 60902515-11 834 3721 6841986 01562 9871982 825563 74313 2743791-4 381-0 8090 947643 52824 615645 769521 108824 1613346-5 182-0 122-0 7261101 4791108 0261105 5681107 0464 204982-4 5490 7320 9561636 308112 1691632 739114 84244 4597916-11 8414 3710 5721985 984771 97141981 03770 40445 196155-5 069-1 242-0 727470 93751109 068474 61361105 3035 2618443-4 6361 5260 9472077 125162 4792067 192167 929811 330438-5 422 142-0 73221891107 9222176 9821102 8413 047864-4 7292 3420 9512485 729206 9062461 746212 581924 646049-5 543 274-0 7272646 011104 9532612 9731093 55934 94719 由表2的像素点为误差可知,越靠近边缘的点,如点4和点9,误差越大,这与相机畸变模型有关,越靠近边缘的点变形越大。由于数字图像的尺寸可以变化,像素坐标误差只是相对值,因此,还需要分析空间坐标误差,控制点像素坐标对应的融合后的三维空间坐标按照误差大小排序,如表3所示。 表3 目标表面三维空间坐标误差 由表 3可以看出:越靠近边缘的点位误差越大,在非边缘区域的融合精度可控制在mm级,表 3与表 2 的排序差别是因为点云是三维数据,投影误差对应的是二维数据,精度最差的点4,是由于投影误差过大,再结合空间信息可知,4点靶标球的像素坐标匹配了后面墙面的点云数据。因此,采用本文的自动融合算法时可拍摄多张的数字图像,选取非边缘区域的融合结果。 本文提出了一个基于激光反射率的点云图像自动融合算法,以反射率图像为媒介,传递与数字图像的同名点的三维空间坐标,利用非线性直接线性变换算法确定点云数据反投影至二维图像的投影模型,实现点云图像融合过程,充分利用了三维激光扫描点云数据的反射率属性,不需要人工参与和额外控制点的布设。此外,由于反射率和图像RGB存在某种统计学转换关系,因此,对于任何形状和颜色的场景都能很好的确定反射率图像和数字图像的同名点对。对于提高点云纹理贴图、图像三维重建和相机标定效率都具有一定的参考意义。 [1] MCALLISTER D K,NYLAND L,POPESCU V,et al.Real-time rendering of real world environments[M]//Rendering Techniques’ 99.Springer Vienna,1999:145-160. [2] LENSCH H P A,HEIDRICH W,SEIDEL H P.A silhouette-based algorithm for texture registration and stitching[J].Graphical Models,2001,63(4):245-262. [3] ALLEN P K,TROCCOLI A,SMITH B,et al.New methods for digital modeling of historic sites[J].IEEE Computer Graphics and Applications,2003(6):32-41. [4] AL-MANASIR K,FRASER C S.Registration of terrestrial laser scanner data using imagery[J].The Photogrammetric Record,2006,21(115):255-268. [5] 邓非,张祖勋,张剑清.一种激光扫描数据与数码照片的配准方法[J].武汉大学学报(信息科学版),2007,32(4):290-292. [6] AGUILERA D G,GONZLVEZ P R,LAHOZ J G.Automatic co-registration of terrestrial laser scanner and digital camera for the generation of hybrids models[J].International Archives of Photogrammetry,Remote Sensing and Spatial Information Sciences,2007,36:162-168. [7] 李知达.基于 SIFT 算法的激光成像雷达点云图像与可见光图像的融合研究[D].西安:西安电子科技大学,2014. [8] LIANG Y,QIU Y,CUI T.Perspective Intensity Images for Co-Registration of Terrestrial Laser Scanner and Digital Camera[J].ISPRS-International Archives of the Photogrammetry,Remote Sensing and Spatial Information Sciences,2016:295-300. [9] HUDON M,GRUSON A.Shape and Reflectance from RGB-D Images using Time Sequential Illumination[C]VISIGRAPP,2016. [10] 杨晓敏,吴炜,卿粼波,等.图像特征点提取及匹配技术[J].光学精密工程,2009,17(9):2276. [11] 李寒,牛纪桢,郭禾.基于特征点的全自动无缝图像拼接方法[J].计算机工程与设计,2007,28(9):2083-2085. [12] 张颂德.张正友.计算机视觉——计算理论与算法基础[M].北京:科学出版社,1998. [13] 冯文灏.近景摄影测量:物体外形与运动状态的摄影法测定[M].武汉:武汉大学出版社,2002. [14] 颜庆津.数值分析[M].北京:北京航空航天大学出版社,2000. [15] BOSCH J,GRACIAS N,RIDAO P,et al.Omnidirectional underwater camera design and calibration[J].Sensors,2015,15(3):6033-6065. [16] 李寒,牛纪桢,郭禾.基于特征点的全自动无缝图像拼接方法[J].计算机工程与设计,2007,28(9):2083-2085. [责任编辑:李铭娜] Auto-fusion of point clouds and image based on laser reflectance ZHAO Lingna1,2,3,HUA Xianghong1,2,3,LIU Chuang1,2,3,LI Wan4 (1.School of Geodesy & Geomatics,Wuhan University,Wuhan 430079,China;2.Collaborative Innovation Center for Geospatial Technology,Wuhan 430079,China;3.Hazard Monitoring & Prevention Research Center,Wuhan University,Wuhan 430079,China;4.State Key Laboratory of Information Engineering in Surveying,Mapping and Remote Sensing,Wuhan 430079,China) This paper proposes an auto-fusion algorithm of point clouds and image based on laser reflectance.The physical spacial coordination of the image points is obtained in the way of digital image with the point clouds reflectance image feature matching.A re-projection model of point clouds to image points based on DLT can compute object surface 3D space coordinates and RGB.Without artificial participation,efficiently and accurately,the method implements automatically.Experimental result demonstrates the feasibility of the algorithm. laser reflectance;reflectance image;image features matching;re-projection model of point clouds;fusion of point clouds and image 2016-06-22 国家自然科学基金资助项目(41374011;41174010;41304001) 赵玲娜(1991-),女,硕士研究生 花向红(1963-),男,教授. 著录:赵玲娜,花向红,刘闯,等.基于激光反射率的点云与图像自动融合[J].测绘工程,2017,26(8):29-34,44. 10.19349/j.cnki.issn1006-7949.2017.08.007 P228 A 1006-7949(2017)08-0029-06

2 实验及结果分析

3 结 论