HDR视频算法优化及硬件实现

2017-05-13杜学亮张克宁姚春赫马淑芬

吴 安 金 西, 杜学亮 张克宁 姚春赫 马淑芬

1(中国科学院强耦合量子材料物理重点实验室(中国科学技术大学物理学院) 合肥 230026)2 (国家专用集成电路设计工程技术研究中心合肥分中心 合肥 230026) (wuan@mail.ustc.edu.cn)

HDR视频算法优化及硬件实现

吴 安1金 西1,2杜学亮2张克宁1姚春赫1马淑芬2

1(中国科学院强耦合量子材料物理重点实验室(中国科学技术大学物理学院) 合肥 230026)2(国家专用集成电路设计工程技术研究中心合肥分中心 合肥 230026) (wuan@mail.ustc.edu.cn)

高动态范围(high dynamic range,HDR)视频算法计算复杂度高,硬件实现需要大量逻辑和存储资源,且现有的算法难以满足高分辨率下的实时性要求.针对上述问题,提出一种优化的HDR视频流水线算法,同时利用FPGA的并行可重构特性,完成该算法的硬件实现.算法首先将相机响应函数内置于FPGA的查找表(look-up table, LUT)中,对3帧低动态范围(low dynamic range, LDR)图像进行合并,转换后的数据通过多路并行流水缓存在FPGA的BRAM中; 然后使用快速的全局色调映射算法将结果实时显示输出.最终算法在Xilinx Kintex-7开发板上实验通过,在120 MHz系统时钟频率下,对于1 920×1 080分辨率的视频流,处理速度达到65 f/s,满足了实时性要求.

现场可编程门阵列;高动态范围视频;色调映射;相机响应函数查找表;辉度图

HDR视频算法广泛应用于视频监控[1]、医疗成像[2]、汽车电子[3]、游戏渲染[4]、嵌入式系统[5-7]等领域.其算法主要包括HDR视频流生成算法、HDR视频编码算法和色调映射算法.区别于HDR图像算法,HDR视频算法要求更高的实时性,其算法在有限资源的硬件平台上实现问题一直没有很好地解决.

针对HDR视频算法优化及硬件实现,Kang等人[8]最早提出该算法的流水结构,并解决了前后2帧之间的图像配准问题,然而他们处理1帧分辨率为768×1 024的图像需要10 s,实现速度较慢;Mantiuk等人[9]提出一种向后兼容的HDR转MPEG-4视频压缩方法,该方法的核心是将浮点的像素流明值转换为10~11位的整数,再通过标准的MPEG-4压缩编码对视频进行压缩,其数据量庞大导致处理速度偏慢;Akyüz等人[10]提出了基于GPU平台的HDR视频算法,它使用Debevec等人[11]提出的方法恢复图像照度值,使用Reinhard等人[12]算法完成色调映射,HDR视频合成速度为65 f/s,色调映射速度为103 f/s,但其没有考虑加载纹理所需要的时间;Mann等人[13]设计了一种基于FPGA平台的HDR视频系统,该系统使用一组FIFO来缓存每帧图像的像素值,FIFO的数量等同于恢复HDR图像所需的LDR图像数量,视频获取速度可以达到120 f/s,但其视频分辨率较低;Lapray等人[14]在Mann基础上完成了分辨率为1 280×1 024、系统速度为60 f/s的HDR视频系统,能够满足实时显示需求,但其没有提出算法的流水线结构;近年来,国内学者针对HDR视频算法的硬件架构进行了深入研究,罗雪梅等人[15]利用色外观模型重新再现高动态范围图像;陈怀章等人[16]使用带有DMD和FPGA器件的实验平台来扩展成像的动态范围;周继权等人[17]采用相机阵列的方式实现HDR视频成像;赵再骞等人[18]利用GPU协处理器完成航天飞船交会对接时训练电视图像的HDR渲染.

上述方法均在一定程度上对HDR视频算法进行优化和改进,但仍无法满足当前嵌入式领域对HDR视频的实时性要求,本文在文献[10,13-14]的基础上提出一种细粒度并行流水结构的HDR视频算法,利用FPGA器件内置的LUT资源和BRAM资源等,对HDR视频算法进行优化并完成硬件实现.

1 HDR视频算法优化

1.1 HDR视频算法硬件实现瓶颈

当前HDR视频算法硬件实现主要的瓶颈在于:1)存储资源需求高.对于分辨率为1 920×1 080的彩色图像,采用RGBE格式对HDR视频帧数据进行存储,使用Reinhard色调映射算法需要消耗1 920×1 080×4 B=7.9 MB的片上存储资源来存储1帧图像,这对于片上存储资源有限的FPGA器件是不能接受的.2)实时性难以保证.HDR视频存储每个像素点的流明值,其动态范围在[2-128,2127](RGBE格式),大量的运算过程基于浮点值进行.因此,其算法不仅需要更多的存储资源,且需要调用FPGA器件内部的DSP资源对加法、乘法操作进行处理.对于分辨率为1 920×1 080的彩色图像,3帧LDR图像融合1帧HDR图像情况下,使用Debevec算法需要计算1 920×1 080×3×3×(2+1)=55 987 200次.在100 MHz时钟频率下,其需要0.559 872 s(1.8 f/s),无法满足实时性要求.

本文针对上述瓶颈对算法进行了优化,通过漏积分器参数自适应生成、相机响应函数查找表以及多级细粒度并行流水方法提高系统实时性瓶颈;通过压缩流明值编码的方式解决高存储资源需求瓶颈.针对已有算法,本文还提出了一种新的权值函数来降低成像过程叠加的噪声信号.

1.2 权值函数的选取和优化

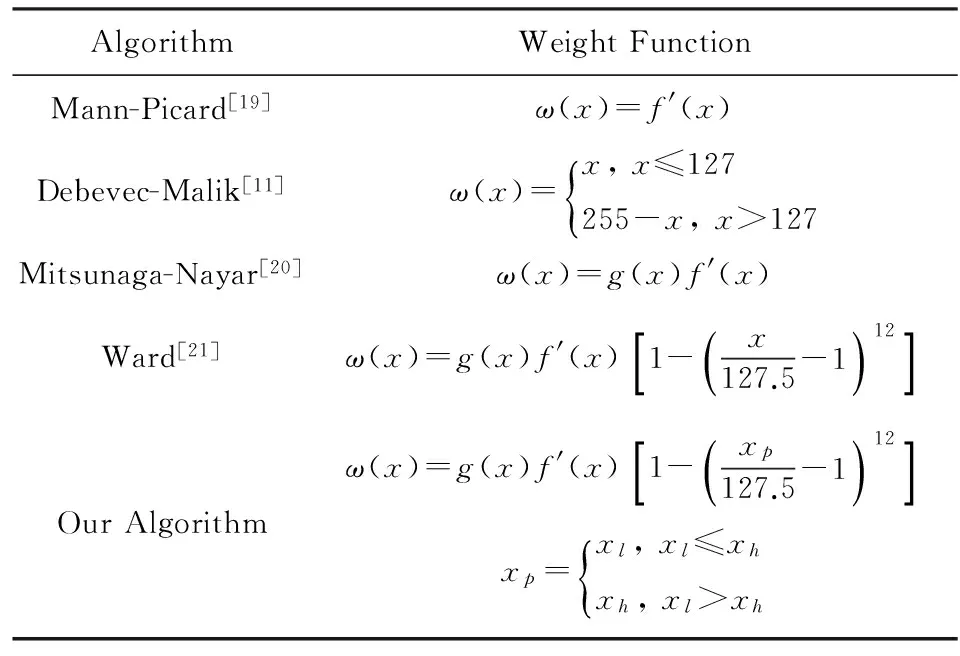

不同的权值函数影响HDR图像质量,恢复流明值的过程会同样将噪声信号叠加到结果中,权值函数可以有效地抑制成像过程叠加的噪声信号,另外还可以用来过滤掉图像中没有用的信息点.表1列举了4种最主流的权值函数,并将本文所选取的权值函数列在了最后.Mann和Picard[19]利用相机对光线变换的敏感度作为权值,其大小等于相机响应函数的微分;Debevec和Malik[11]使用简单的帽子函数作为权值,即计算当前像素值到0或255的绝对值;Mitsunaga和Nayar[20]为了改善信号放大时带来的信噪比(signal noise ratio, SNR)增大效应,将相机响应函数的微分乘以相机响应函数的反函数;Ward等人[21]在此基础上将权值函数乘以一个宽帽形过滤函数,用来过滤图像中的饱和点和噪声点.

尽管Ward算法可以有效地过滤掉图像中饱和点和噪声点,但是当某个像素值在靠近最大或最小值间有波动时,正常的像素点也会被当作无用的信息点过滤掉.例如1个像素点在高曝光图像中的像素值为253,由于噪声信号干扰,在低曝光图像中其像素值为255,导致该像素点对应的权值有显著的变化,最终在合成的HDR图像中该点色彩将偏向RGB其中1个颜色通道.针对Ward算法可能过滤掉正常像素点这一缺陷,本文在Ward算法基础上对像素值进行预判处理,对于高曝光点像素值低于低曝光点的情况,判定为低曝光点值存在噪声干扰,其值用高曝光点像素值代替,表1中给出了本文算法具体的公式.

Table1 Comparison of Different Weight Functions表1 不同权值函数选取对比

Note:f(x) indicates the camera response function, whileg(x) indicates the inverse function off(x).

对于N帧不同曝光度图像,每个像素点的流明值(Ei,j)计算为

(1)

其中,权值函数用ω(Zp,i,j)表示,Zp,i,j则表示第p帧LDR图像中第i行、第j列像素点对应的像素值.

1.3 色调映射算子的选取

采用局部色调映射算子(tone mapping operator,TMO)对图像的细节部分进行优化,算法运算复杂,且占用大量存储资源,其硬件实现难以做到实时处理.全局TMO对于每个像素的处理方法相同,算法运算简单,适用于硬件实现.然而,不同的全局TMO其硬件实现效果不同,且有些需要手动进行参数调整.文献[22-24]是目前广泛使用的3种全局色调映射算法.文献[22]以人眼感知特性为依据构造基于对数函数的色调映射算子,其算法需要调整显示最大亮度值、偏差值和最大曝光量值.对偏差值参数b的选择最为关键,其值的选取要保证映射的动态范围在显示设备可以接受的范围内,如果b值过大将会出现图片高亮区域的像素值溢出,导致图像出现失真点.一般情况下,偏差值取0.5~1.0之间.

针对失真点问题和参数手动调整问题,文献[23-24]基于摄影学原理构建色调映射算子,该算子也称为Reinhard算子.首先使用平均对数亮度作为key值对图像进行动态范围压缩,然后对对比度大的区域进行自动的曝光和遮光处理.该算法需要调整缩放参数α和最大纯白值参数Lwhite.相比于文献[22],该算法不会出现像素点失真,归一化过程简单,但压缩后的图像对比度较差,因此在进行动态压缩后需要再对局部区域进行自动曝光和遮光处理.文献[24]对参数计算方法进行了规定,使其算法可以根据图像自适应的选择参数.

此外,全局TMO还包括基于S曲线的算法[25]、基于直方图的算法[26]等.本文结合文献[22-23]算法的优点,完成色调映射算法的硬件实现.

1.4 色调映射算子的优化

文献[22]硬件实现简单,但图像容易出现失真,而文献[23]的流水线性能瓶颈在于平均亮度的计算上,其过程需要等待平均亮度计算完成才能进行下一步归一化流水,无法实现1帧7.9 MB数据的片上缓存,且该过程耗费大量时钟周期,不能满足实时性要求.

本文首先对自适应的对数公式进行重新调整,加入像素点钳位功能,解决出现随机像素点问题,针对Reinhard算子性能瓶颈,提出自适应的平均亮度选取方法,实现完全可并行处理的HDR视频优化算法.

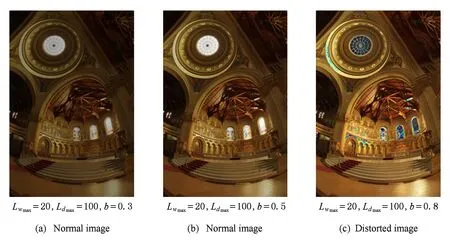

文献[18]的自适应对数算子为

(2)

其中,第1个乘积项为传统的对数压缩方法,为了提高压缩后图像的对比度,受Gamma校正方法的启发,本文在传统对数压缩公式基础上乘以第2个乘积项.其中,Lw/Lwmax比值衡量图像的对比度,lnb/ln 0.5为其权重.然而,该算子在Ldmax>100,b<0.5时,图像高亮区域的像素点第2个乘积项会大于1,最终导致Ld>1,引起图像失真.失真图像如图1所示,其中图1(a)(b)为正常的色调映射后图像,图1(c)为出现失真点和失真区域的不正常图像.需要对公式做重新的修改和钳位处理,本文对该算法优化为

(3)

式(3)等号右边第2个乘积项在0~1之间,因此图像不会出现失真点,且保留了图像对比度可以调整的功能.

文献[23-24]的摄影学TMO算子首先需要计算整幅图像的平均亮度值:

(4)

其中,Lw为真实世界亮度,δ是一个很小的量,其目的是为了保证lg公式的结果不为0.Lav表征整幅图像的亮度等级,而每个像素点的亮度值需要根据平均亮度值重新调整:

(5)

Fig. 1 Distorted image in adaptive TMO algorithm*The original test images come form Debevec homepage. http://www.pauldebevec.com/Research/HDR/#creating图1 自适应对数算法的饱和失真图像

参数α即为调整缩放参数,该值为整幅图片的亮度表征值.最终Reinhard算子归一化亮度值为

(6)

该算子结合传统的非线性动态压缩方法,将摄影学经验公式作为限制条件,Lwhite参数表征被映射到纯白色的最小亮度值.在Lwhite很大的情况下,第2项可以近似忽略.参数α可以自动计算得出:

α=0.18×22(B-A)(A+B),

A=Lmax-Lav,

B=Lav-Lmin.

(7)

本文采用对数方法和摄影学方法相结合的方式完成色调映射过程,既能保证压缩映射时不会出现失真点,也能保证图像有较好的对比度,本文算法的归一化亮度值为

(8)

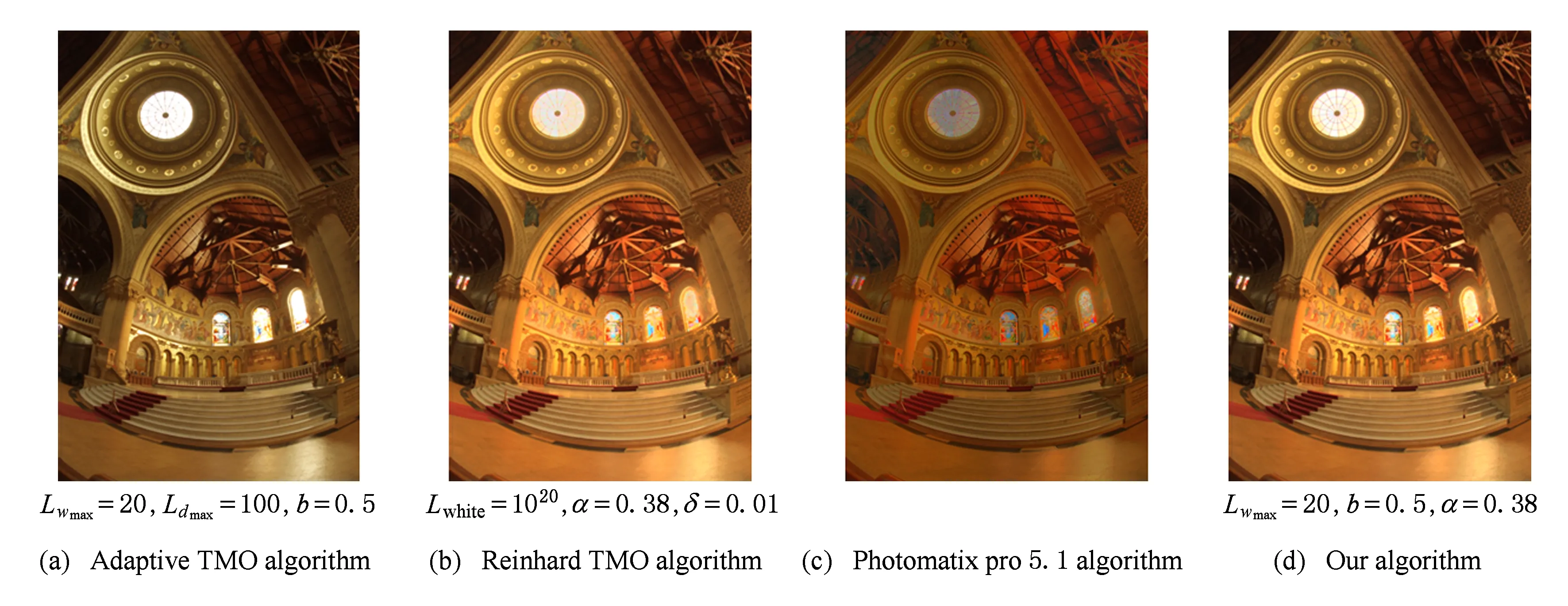

将自适应对数算法、摄影学算法、HDR工具软件Photomatix Pro 5.1版和本文算法显示结果进行对比,显示效果如图2所示.在参数不变的情况下计算本文算法效果,图2(a)整体偏暗,而图2(b)中天窗部分过于明亮,图2(d)中有效抑制了高亮部分,保证了很好的对比度,整体图像饱和度相比自适应对数算法要好很多.

Fig. 2 Comparison of four different tone mapping algorithms①图2 4种不同色调映射算法效果对比

然而,上述算法优化仍不适用视频影像的硬件实现,主要原因在于:1)该算法的大部分操作在浮点数下进行,FPGA内部浮点运算模块资源有限,不能完成大规模的浮点运算;2)该算法仍未解决每帧图像的平均亮度值和参数,实时性难以保证;3)在视频影像中,使用该算法往往会出现2帧之间的参数α,b相差巨大,导致视频出现闪烁(flicker)现象.

可以使用漏积分器(leaky integrator)模型来减小参数的巨大变换,从而减小色调映射后的HDR视频闪烁现象,上述另外2种问题将在硬件实现中予以解决.漏积分器模型相当于一个低通滤波器,减小帧和帧之间的快速参数变换,其计算公式为

An=(1-αA)An-1+αAA,

Bn=(1-αB)Bn-1+αBB,

Ln=(1-α)Ln-1+αL0.

(9)

如果只对参数α和B使用漏积分器模型,则当场景进行切换时因参数未及时变化导致视频亮度失真,因此对参数A和B进行积分处理,同时对参数B和平均亮度值L进行同样处理.其结果是使得各帧之间的参数变换减缓,从而使得视频图像不会产生剧烈变化.

2 HDR算法并行流水结构硬件实现

2.1 HDR算法并行流水结构系统总体架构

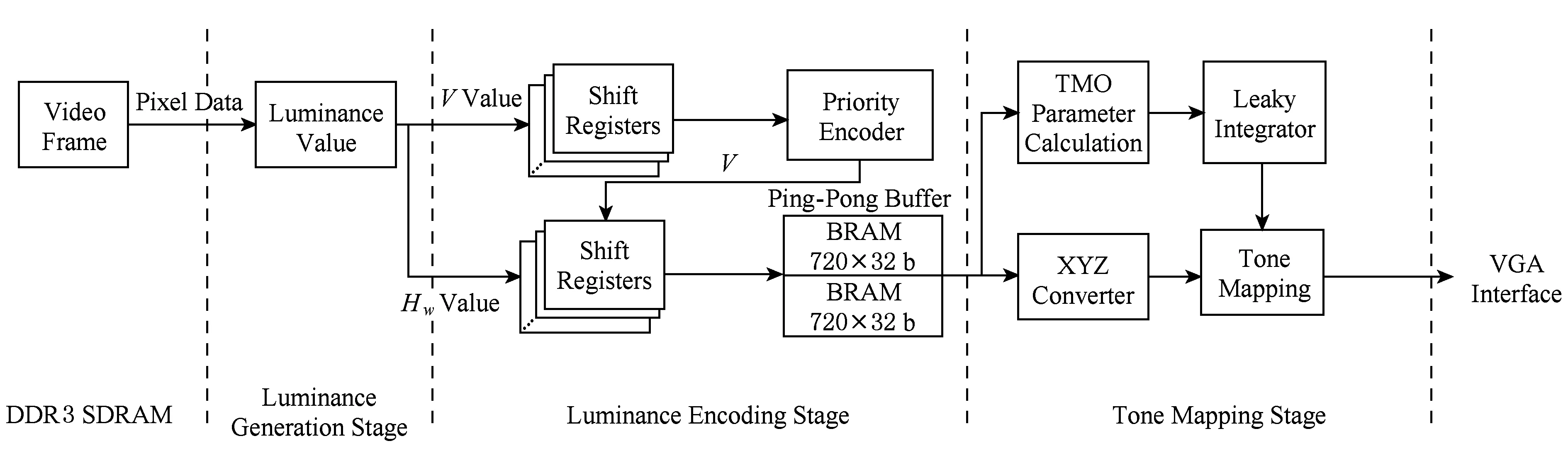

HDR算法并行流水结构系统总体架构如图3所示:

Fig. 3 Comparison of several different tone mapping algorithms图3 HDR视频流水线总体架构

实时处理过程分为3个阶段:

1) 流明值计算阶段.该阶段完成像素值和流明值的映射,本文在该阶段提出一种相机响应函数查找表结构.

2) 流明值压缩编码阶段.该阶段对多路通道的流明值进行压缩和浮点格式编码,同时将压缩后的帧数据存储在720×32 b双端口RAM的乒乓缓冲区.本文在该阶段提出一种压缩流明值编码方法.

3) 色调映射阶段.该阶段首先计算该帧图像的TMO参数,根据参数值完成色调映射过程,最终通过VGA接口实时显示出来.本文在该阶段对TMO算子进行2路融合处理,优化了生成视频的图像对比度,解决了图像失真问题.

2.2 流明值生成模块

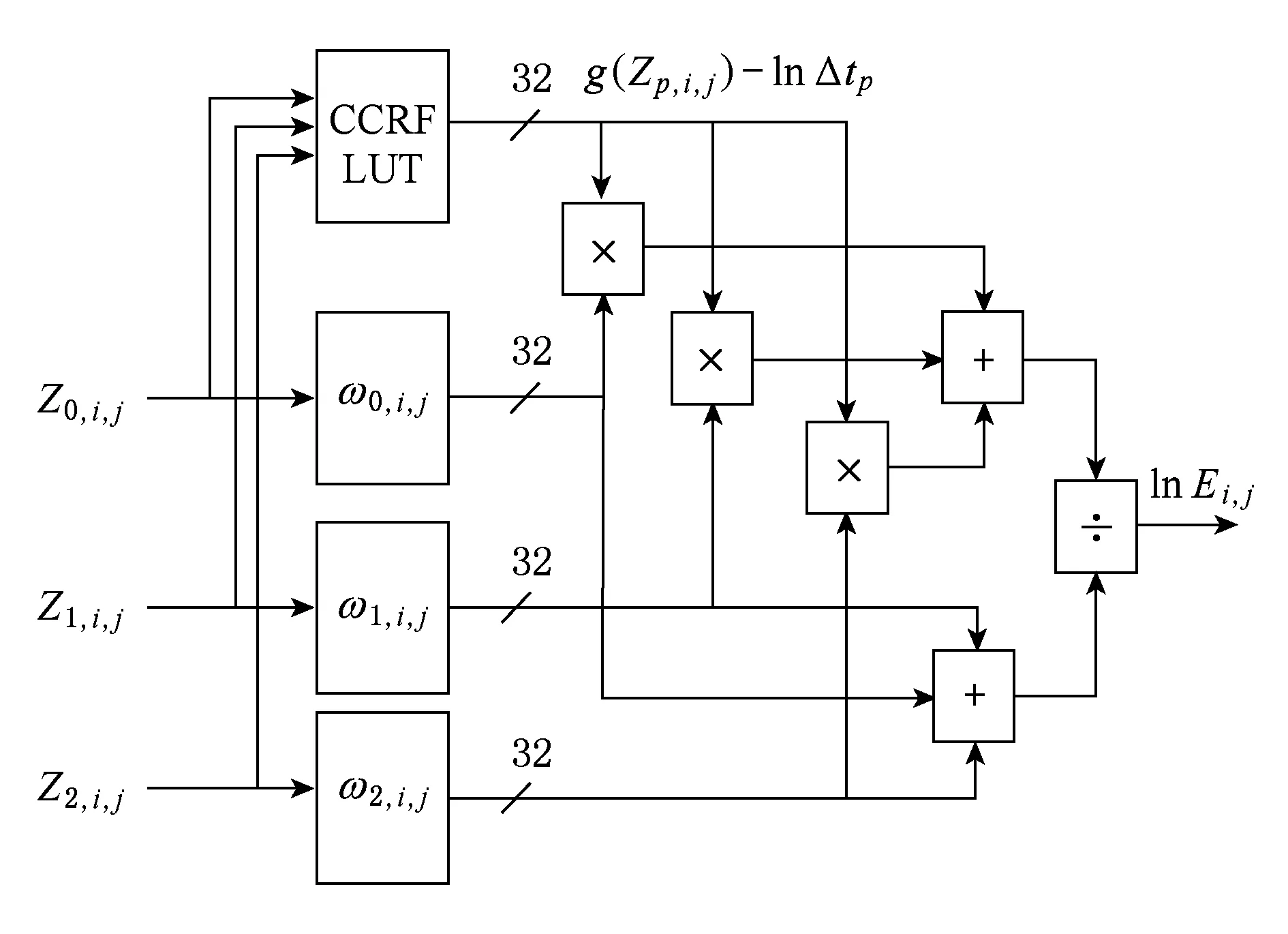

Fig. 4 The pipeline structure of radiance map图4 流明值生成模块并行流水结构

流明值的计算模块根据相机响应函数得到辉度值,再经过权值滤波器去除噪声和失真部分,最终根据式(1)计算流明值.该模块主要结构为相机响应函数查找表(comparametric camera response function,CCRF LUT)和权值函数查找表.利用FPGA器件本身具有的LUT特性,可以方便地构建上述2种查找表结构.该模块框架如图4所示.3帧不同曝光度的像素数据分别读入CCRF查找表和权值函数查找表,检索出来的辉度值通过加权平均电路重新计算得到较为真实的流明值.

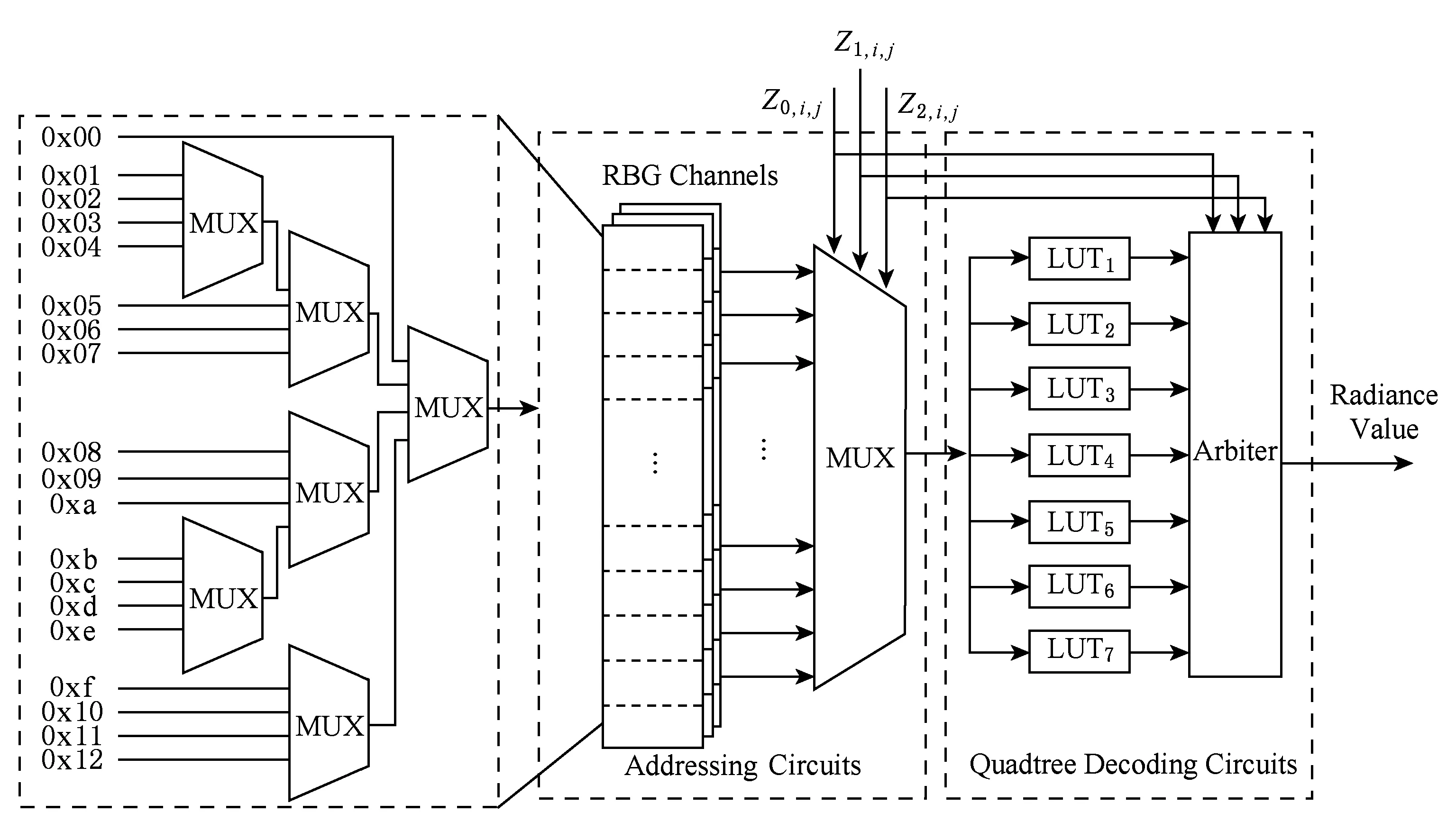

相机响应函数查找表的基本结构如图5所示,该查找表保存相机响应函数的像素值到辉度值的映射过程.对相机响应函数的曲线进行四叉树压缩编码,保证每1个树形结构的末端为1个像素值到辉度值的映射.Z0,i,j,Z1,i,j,Z2,i,j为相机响应函数的横坐标数值,寻址电路根据输入的Z0,i,j,Z1,i,j,Z2,i,j查找曲线中对应的纵坐标数值,通过四叉树解码电路输出.四叉树解码电路的每个LUT模块为FPGA最小查找表单元,多路选择器将编码值读入解码电路单元,经过LUT模块查找相应辉度值.由于查找表为固定结构,整个流明值生成模块只占用4拍的流水线时钟.

Fig. 5 CCRF LUT architecture图5 相机响应函数查找表结构

2.3 流明值编码模块

流明值编码模块采用定制的浮点格式进行压缩,压缩编码方式为8 b尾数加指数位.对18 b RAW格式视频数据进行压缩存储,存储方法计算为

v=fpe(Lw(x,y)≫8),

H(Lw(x,y))=(Lw(x,y)≫v)+v×28.

(10)

其中,fpe为1个优先级编码器,对数据的9~18位进行优先级编码,≫是移位操作.

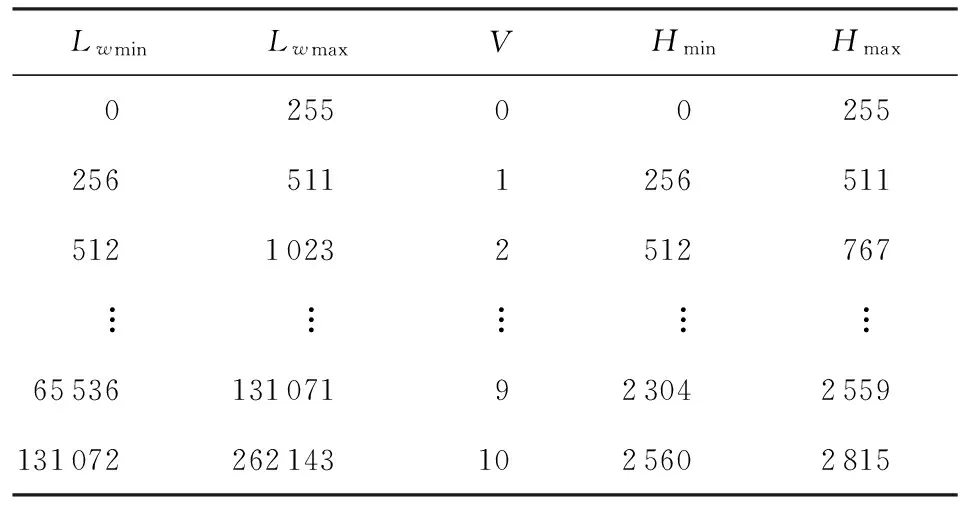

表2中说明了输入流明值和存储值之间的对应关系,最终RAM中存储的是Hw值.采用该存储方法只需要2 816个RAM存储空间来处理流明值的中间数据,而一般RAW格式需要262 144个RAM存储空间.本文算法大大节省了HDR视频在FPGA中所需要的存储资源.

Table 2 Data Structures in Radiance Map Module表2 流明值生成模块数值结构变换

2.4 色调映射模块

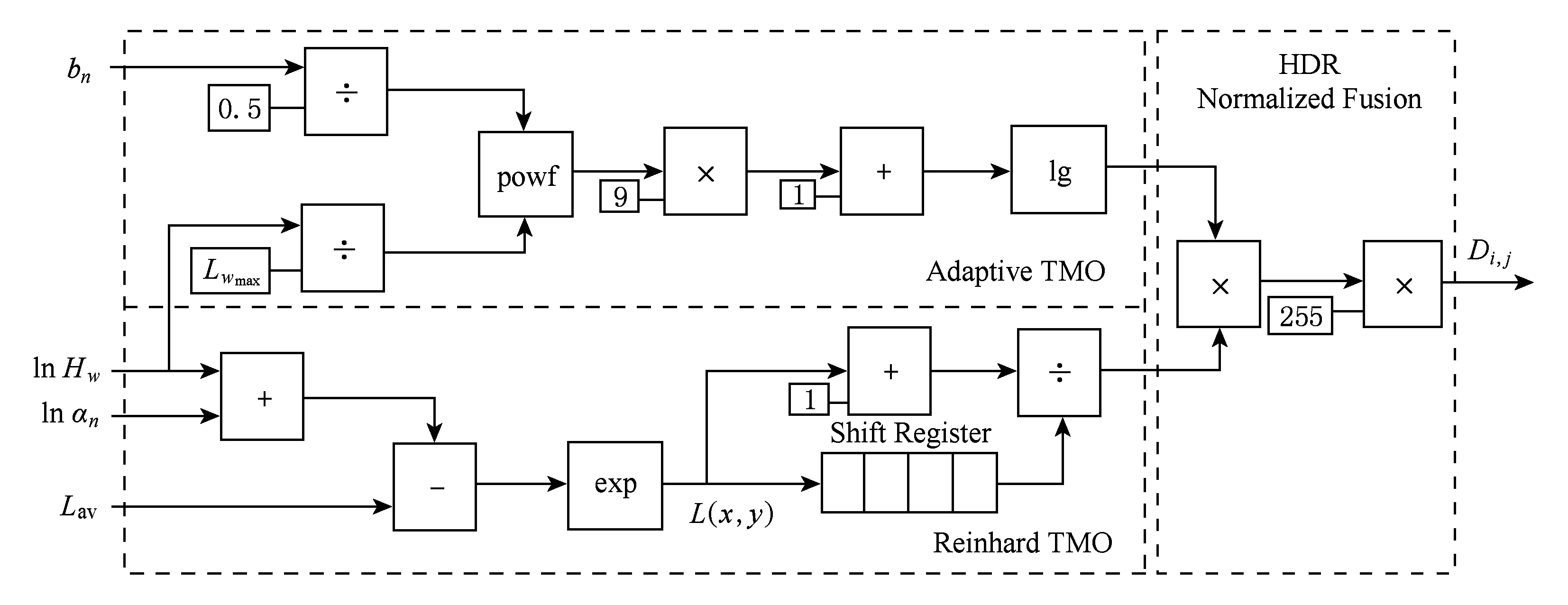

色调映射模块需要进行大量浮点值计算,因此其主要的运算单元通过调用FPGA器件的浮点运算单元实现.该模块有4个输入参数,如图6所示,其中bn,Lav和lnαw从漏积分器模块传入,lnHw为流明值编码模块输出.首先分别计算自适应对数方法归一化值和Reinhard方法归一化值,计算过程并行独立的完成;然后将2路结果融合为1路,完成最终24位真彩色像素输出.漏积分器参数αA,αB,αL为0~1之间的常量,本文取0.8.

该模块占用时间为最长路径消耗时间,自适应对数方法需要更长的时钟周期来完成计算,为了保证最终的归一化结果正确,在Reinhard模块加入移位寄存器组来保证时钟节拍的一致性.

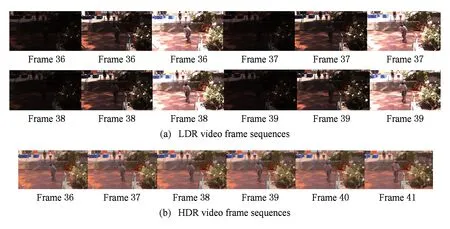

图7为HDR视频色调映射算法测试结果,图7(a)为3种不同曝光度的原始测试视频,本文只截取了第36帧到第39帧的视频帧图像;图7(b)经过本文色调映射算法处理后最终得到第36帧到第41帧的视频帧图像.

Fig. 6 Tone mapping algorithm for hardware implementation图6 色调映射算法硬件实现

Fig. 7 Video frame sequences results of tone mapping algorithm*The original test video comes form Kalantari homepage. http://www.ece.ucsb.edu/~psen/PaperPages/HDRVideo/图7 色调映射算法的视频帧效果显示

3 实验结果及分析

本文算法在Xilinx Kintex-7 KC705开发板上验证实现,利用单片XC7K325T-2FFG900C FPGA芯片,配合4 GB的DDR3内存作为原始视频和算法生成视频的片外存储介质,最终的视频结果利用GeForce GTX 550显卡实现输出.

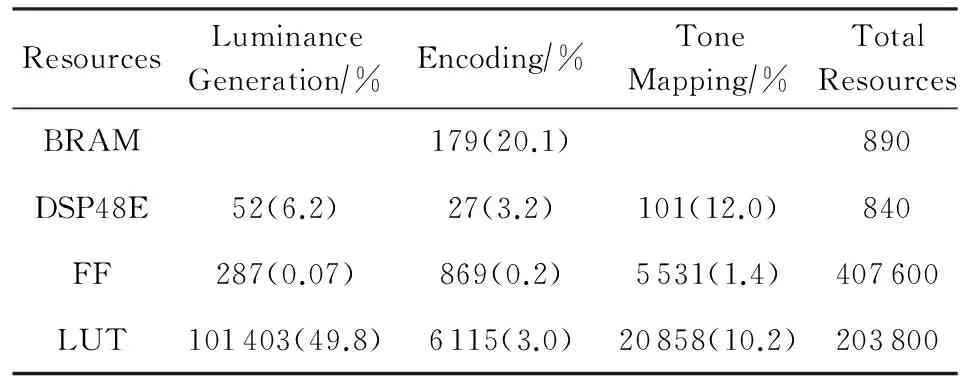

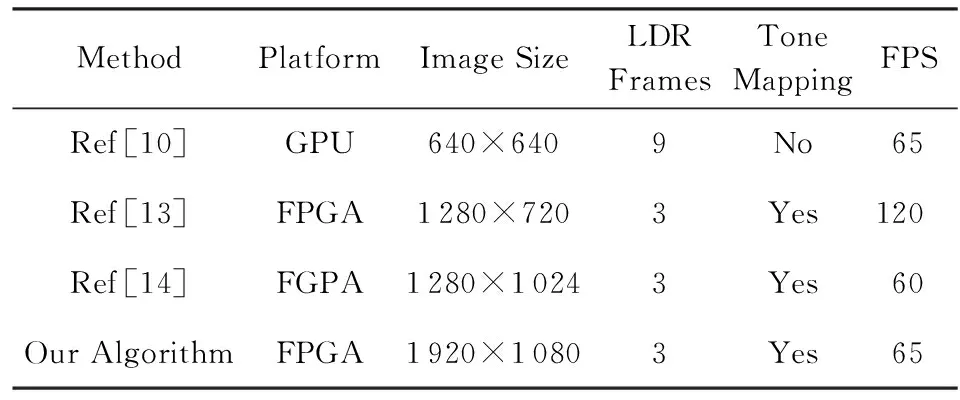

不同的相机,其相机响应函数不同,因此,需要预先对相机响应函数进行拟合,然后将得到的拟合曲线固定在FPGA的LUT结构中.利用FPGA软件工具Vivado13.3对各个模块进行综合和布局布线,使用iMPACT软件工具进行FGPA器件的烧写和擦除,同时使用ChipScope工具对测试信号进行检查.表3是本文算法最终使用FPGA资源情况.BRAM资源的消耗仅在压缩编码模块,而流明值生成模块占用了将近一半的LUT资源.DSP48E模块完成浮点数据处理,在色调映射模块调用最为密集.表4对其处理速度和其他文献进行了对比,在120 MHz的系统时钟下,对1 920×1 080分辨率的19.58 MB标准视频数据,可在15.3 ms内完成1帧视频图像的输出,帧率高达65.4 f/s.

Table 3 FPGA Resource Consumption in Kintex-7 KC705表3 Kintex-7 KC705 FGPA的资源利用率

由表4可以看出,近年来越来越多算法实现基于FPGA,GPU,DSP等硬件平台实现,基于CPU的方法由于算法处理速度较慢,应用面较窄,近年来已经不再有相关研究.同时,根据3帧图像恢复1帧高动态范围图像的方法已经成为主流,而在视频处理领域,低分辨率的图像合成方法已经研究的较为成熟.本文基于FGPA的方法具有成本低、可扩展性好、灵活性好等特点,同时不需要任何数据预处理的过程,可以完全做到现场数据的实时处理,适用于对实时性要求较高的嵌入式应用领域.

Table 4 Different Hardware Platform Performance List表4 不同硬件平台的HDR处理性能对比

4 结束语

针对HDR视频算法复杂度高的问题,本文采用了一种优化的HDR视频流水线算法,并针对FPGA器件进行了结构优化,实现了高分辨率的HDR视频实时处理.通过压缩流明值的方式解决了HDR视频算法中高存储资源的瓶颈.本文算法最终在Xilinx Kintex-7开发板上实现,对于1 920×1 080分辨率的视频流,处理速度可以达到65 f/s.

本文部分源代码和RTL级网表开源,代码内容可以在主页:http://home.ustc.edu.cn/~wuan下载,所有代码遵循LGPL v3协议.

[1]Natale D J, Baran M S, Tutwiler R L. High dynamic range (HDR) video processing for the exploitation of high bit-depth sensors in human-monitored surveillance[C] //Proc of the IEEE AIPR’14. Piscataway, NJ: IEEE, 2014: 1-6

[2]Köstler H, Stürmer M, Pohl T. Performance engineering to achieve real-time high dynamic range imaging[J]. Journal of Real-Time Image Processing, 2013, 44(3): 127-139

[3]Krawczyk G, Myszkowski K, Seidel H P. Perceptual effects in real-time tone mapping[C] //Proc of the 21st Spring Conf on Computer Graphics. New York: ACM, 2005: 195-202

[4]Luksch C. Realtime HDR rendering[OL]. 2007[2015-05-04]. https://www.cg.tuwien.ac.at/research/publications/2007/Luksch_2007_RHR/Luksch_2007_RHR-RealtimeHDR%20.pdf

[5]Belbachir A N, Schraml S, Mayerhofer M, et al. A novel HDR depth camera for real-time 3D 360° panoramic vision[C] //Proc of the IEEE CVPRW’14. Piscataway, NJ: IEEE, 2014: 425-432

[6]Kiser C, Reinhard E, Tocci M, et al. Real time automated tone mapping system for HDR video[C] //Proc of the IEEE IP’12. Piscataway, NJ: IEEE, 2012: 2749-2752

[7]Mann S, Lo R C H, Ovtcharov K, et al. Realtime HDR (high dynamic range) video for eyetap wearable computers, fpga-based seeing aids, and glasseyes (eyetaps)[C] //Proc of the 25th IEEE Canadian Conf on Electrical & Computer Engineering (CCECE). Piscataway, NJ: IEEE, 2012: 1-6

[8]Kang S B, Uyttendaele M, Winder S, et al. High dynamic range video[J]. ACM Trans on Graphics, 2003, 22(3): 319-325

[9]Mantiuk R, Efremov A, Myszkowski K, et al. Backward compatible high dynamic range MPEG video compression[J]. ACM Trans on Graphics, 2006, 25(3): 713-723

[10]Gençtav A, Akyüz A O. Evaluation of radiometric camera response recovery methods[C] //Proc of the ACM SIGGRAPH-2011. New York: ACM, 2011: 15-16

[11]Debevec P E, Malik J. Recovering high dynamic range radiance maps from photographs[C] //Proc of the ACM SIGGRAPH-2008. New York: ACM, 2008: 31-32

[12]Reinhard E, Stark M, Shirley P, et al. Photographic tone reproduction for digital images[J]. ACM Trans on Graphics, 2002, 21(3): 267-276

[13]Mann S, Lo R C H, Ovtcharov K, et al. Realtime HDR (high dynamic range) video for eyetap wearable computers, fpga-based seeing aids, and glasseyes (eyetaps)[C] //Proc of the 25th IEEE Canadian Conf on Electrical & Computer Engineering (CCECE). Piscataway, NJ: IEEE, 2012: 1-6

[14]Lapray P J, Heyrman B, Ginhac D. Hardware-based smart camera for recovering high dynamic range video from multiple exposures[J]. Optical Engineering, 2014, 53(10): 1-10

[15]Luo Xuemei, Wang Yifeng, Zeng Ping. High dynamic range image reproduction based on color appearance mapping[J]. Journal of Computer Research and Development, 2013, 50(8): 1787-1796 (in Chinese)(罗雪梅, 王义峰, 曾平. 色外观匹配的高动态范围图像再现[J]. 计算机研究与发展, 2013, 50(8): 1787-1796)

[16]Chen Huaizhang, Wang Yanjie, Sun Honghai. High dynamic range imaging detection based on DMD and image sensor[J]. Infrared and Laser Engineering, 2013, 42(12): 3402-3409 (in Chinese)(陈怀章, 王延杰, 孙宏海. DMD结合图像传感器的高动态场景成像探测[J]. 红外与激光工程, 2013, 42(12): 3402-3409)

[17]Zhou Jiquan, Wang Qing. Camera array-based HDR image synthesis method[J]. Application Research of Computers, 2013, 30(9): 2859-2860 (in Chinese)(周继权, 王庆. 基于相机阵列的高动态范围图像合成方法[J]. 计算机应用研究, 2013, 30(9): 2859-2860)

[18]Zhao Zaiqian, Chao Jiangang, Wang Jinkun. Real-time HDR rendering for simulated TV-graphics of rendezvous and docking in astronaut training[J]. Journal of Computer-Aided Design & Computer Graphics, 2015, 27(2): 279-286 (in Chinese)(赵再骞, 晁建刚, 王金坤. 交会对接航天员训练电视图像实时高动态范围渲染[J]. 计算机辅助设计与图形学学报, 2015, 27(2): 279-286)

[19]Mann S, Picard R W. On Being ‘Undigital’with digital cameras: Extending dynamic range by combining differently exposed pictures[C] //Proc of the 48th IEEE Annual Conf on Computing Section. Piscataway, NJ: IEEE, 1994: 422-428

[20]Mitsunaga T, Nayar S K. Radiometric self calibration[C] //Proc of the IEEE CSCCVPR’99. Piscataway, NJ: IEEE, 1999: 374-380

[21]Reinhard E, Ward G, Debevec P, et al. High Dynamic Range Imaging: Acquisition, Display, and Image-Based Lighting[M]. San Francisco, CA: Morgan Kaufmann, 2010

[22]Drago F, Myszkowski K, Annen T, et al. Adaptive logarithmic mapping for displaying high contrast scenes[J]. Computer Graphics Forum, 2003, 22(3): 419-426

[23]Reinhard E, Stark M, Shirley P, et al. Photographic tone reproduction for digital images[J]. ACM Trans on Graphics, 2002, 21(3): 267-276

[24]Reinhard E, Devlin K. Dynamic range reduction inspired by photoreceptor physiology[J]. IEEE Trans on Visualization and Computer Graphics, 2005, 11(1): 13-24

[25]Huang M, Huang H, Chan Z. An S-function based of tone reproduction algorithm for digital photographic[J]. IEEE Trans on Image Proeessing, 2003, 6(7): 230-234

[26]Pouli T, Reinhard E. Progressive histogram reshaping for creative color transfer and tone reproduction[C] //Proc of the 8th Int Symp on Non-Photorealistic Animation and Rendering. New York: ACM, 2010: 81-90

Optimizing and Implementing the High Dynamic Range Video Algorithom

Wu An1, Jin Xi1,2, Du Xueliang2, Zhang Kening1, Yao Chunhe1, and Ma Shufen2

1(Key Laboratory of Strongly-Coupled Quantum Matter Physics (School of Physical Sciences, University of Science and Technology of China), Chinese Academy of Sciences, Hefei 230026)2(Hefei Branch Center of National ASIC Design Engineering Technology Research Center, Hefei 230026)

In contrast to the HDR image processing algorithm, the computation complexity of HDR video processing algorithm make the hardware implementation consume much more logics and storage resources, which poses an enormous obstacle for the existing algorithms to achieve real-time processing. As a consequence, a new algorithm for real-time hardware implementation is demanded. In this paper, we propose a fully pipelined hardware system processing HDR video in real-time, which takes advantage of parallel configurable characteristics of FPGA. Our system obtains a series of low dynamic range (LDR) images adopting varying exposure time algorithm and places their camera response curves in the FPGA look-up table (LUT). Then the translated float data is stored in the BRAM or FIFO modules in parallel pipeline. Finally, the image is displayed in the device by adopting rapid global Tone Mapping algorithm. The entire HDR video processing system is realized in Xilinx Kintex-7 FPGA board. Results show that the processing efficiency can reach 65 f/s for the 1 920×1 080 resolution video when the system clock rate is 120 MHz, which is sufficient for the real-time processing requirements.

FPGA; high dynamic range video (HDR); tone mapping; comparametric camera response function LUT (CCRF LUT); radiance map

Wu An, born in 1990. PhD. His main research interests include SoC design technology, VLSI design technology, VLSI design and FPGA-based hardware accelerator design.

Jin Xi, born in 1970. Associate professor and PhD supervisor. His main research interests include SoC design technology, VLSI design, computer-aided design meth-odologies for SoC system integration and FPGA-based hardware structure design.

Du Xueliang, born in 1982. PhD, associate professor. His main research interests include high-performance SoC design, DSP design and FPGA-based prototyping.

Zhang Kening, born in 1992. Master candidate. His main research interests include SoC design technology, image processing and FPGA-based hardware accelerator design.

Yao Chunhe, born in 1994. Master candidate. His main research interests include image processing algorithm design and high-speed vision chip design.

Ma Shufen, born in 1993. Master. Her main research interests include image processing and 3D model retriecval.

2016-03-06;

2016-06-30

中国科学院战略性先导科技专项课题(XDA06010402-4) This work was supported by the State Priority Research Program of the Chinese Academy of Sciences (XDA06010402-4).

金西(jinxi@ustc.edu.cn)

TP391