多尺度时空上下文目标跟踪

2017-03-23李泽仁吴仰玉

李泽仁,纪 峰,常 霞,吴仰玉

多尺度时空上下文目标跟踪

李泽仁,纪 峰,常 霞,吴仰玉

(北方民族大学 数学与信息科学学院,宁夏 银川 750021)

相关滤波器在视觉目标跟踪中得到了广泛应用,针对复杂场景下目标跟踪容易出现跟踪漂移的问题,以及现有多尺度跟踪算法计算量大的问题,本文提出一种实时的多尺度目标跟踪方法。首先由时空上下文模型输出目标位置置信图完成目标定位,再在尺度空间上训练相关滤波器完成目标尺度估计,最后基于目标位置和尺度提出了一种新的时空上下文模型更新机制,避免了模型更新错误。实验表明:该方法在尺度变化、局部遮挡、目标姿态变化等情况下均能完成鲁棒跟踪,跟踪正确率较原始时空上下文跟踪算法提高了38.4%。

目标跟踪;时空上下文;多尺度

0 引言

目标跟踪是当前计算机视觉领域内的一个基础性研究课题,其任务是在视频图像中的每一帧中估计出目标位置[1],尽管近几年目标跟踪取得了很大进展,但诸如光照变化、目标尺度变化、目标被遮挡等各种因素的干扰,使得设计一个能适应复杂场景的目标跟踪方法依然是一个非常具有挑战性的课题。根据目标在线模型,当前目标跟踪可分为生成式跟踪算法[2-4]和判别式跟踪算法[5-8]。

生成式跟踪算法通过特征提取完成目标模型构建,然后利用在线学习到的目标模型基于最小重构误差,在目标局部区域搜索完成目标定位。判别式跟踪算法主要利用当前的检测技术,利用目标作为正样本、背景作为负样本训练一个分类器,通过在线更新的分类器判别输出置信度最高的样本作为目标在当前帧的位置。

近年来相关滤波器技术[9]在目标跟踪中得到了广泛应用,基于此文献[10]在贝叶斯框架下利用时空上下文(spatio-temporal context, STC)来完成目标跟踪,在实时性和准确性上都取得了不错效果。然而,STC跟踪器采用全局模板更新目标在线模型,在目标尺度发生变化以及目标被遮挡等情况下容易发生更新错误,进而导致跟踪漂移。

针对以上问题,本文在利用时空上下文模型完成目标定位的基础上,在尺度空间上训练相关滤波器完成目标尺度估计,提出了一种尺度自适应的目标跟踪方法。同时基于目标位置和尺度提出了一种新的时空上下文模型更新机制,减少了遮挡等外界干扰带来的模型更新错误,提高了目标跟踪的准确率。

1 时空上下文跟踪器(STC)

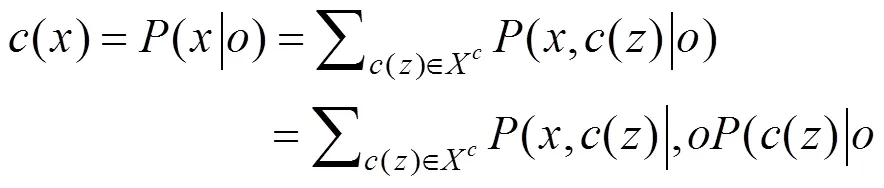

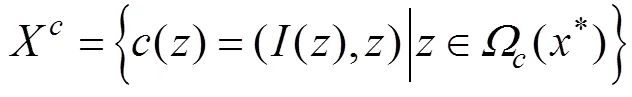

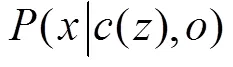

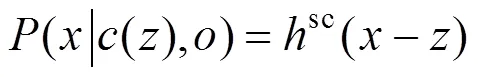

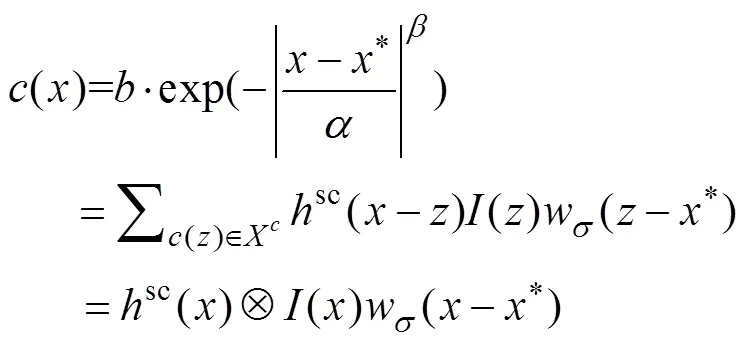

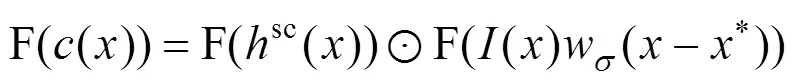

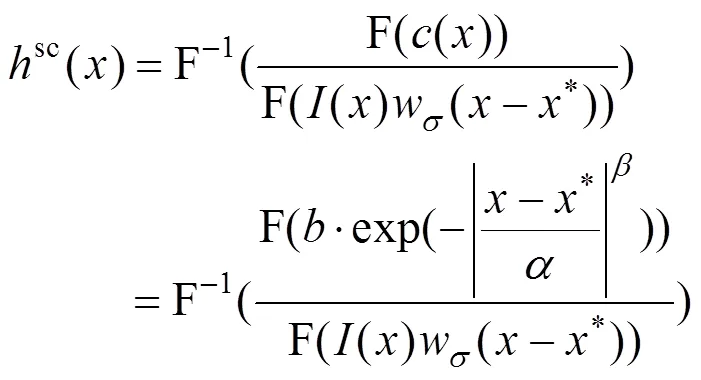

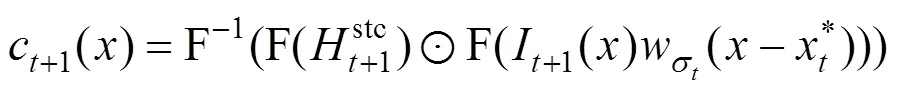

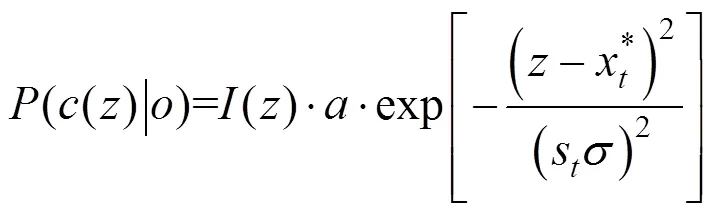

STC跟踪器将跟踪问题看成是在每一帧的目标置信图()中的目标定位问题。基于贝叶斯框架,()可以表示为:

(2)

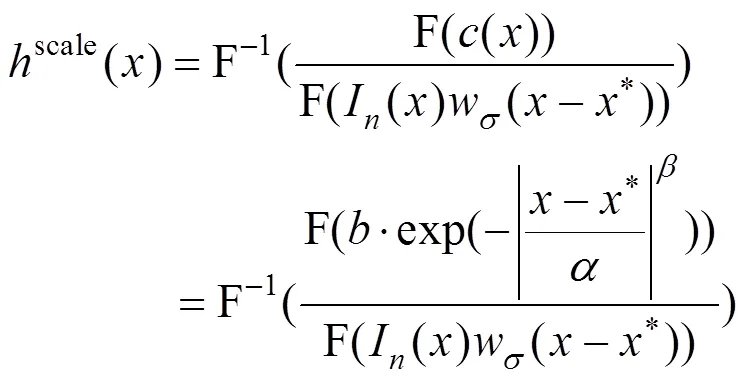

式中:s(-*)是图像特征的权重函数;是归一化参数;是尺度参数。

因为边缘包含背景信息的可能性较大,因此式(1)中目标置信图()定义为:

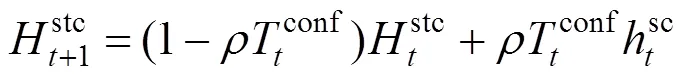

H+1stc=(1-)Hstc+hstc(8)

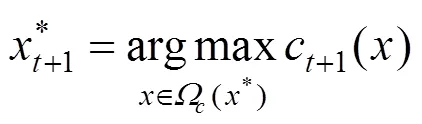

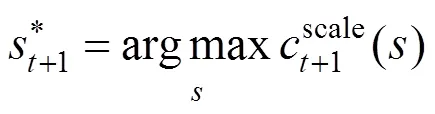

在目标位置置信图中寻找最大值,则最大值对应位置即为当前帧目标位置:

从以上的分析可以发现,STC跟踪器采用快速傅里叶变换将原本在空域中进行的特征提取等操作转换到频域中进行,大大提高了目标跟踪的实时性,但由于其采用全局信息更新目标在线模型,一旦目标出现尺度变化以及目标遮挡等情况,势必会引入更多的更新错误,进而最终引发跟踪漂移。

2 本文算法

针对以上存在的问题,本文提出如下改进策略:在STC模型完成目标定位的基础上,为了给出目标精确的尺度变化,在尺度空间上训练一个独立的相关滤波器。结合目标位置和尺度对时空上下文模型进行更新,避免引入模型更新错误。

2.1 相关滤波器尺度估计

现有的多尺度跟踪算法多采用目标尺度穷举搜索的方式,在获得尺度估计的同时,计算量也随着候选尺度的个数大大提高,难以满足实时应用的需求,本文基于相关滤波器的高效性,提出一种全新的快速尺度估计策略,大大提高了多尺度跟踪算法的实时性。

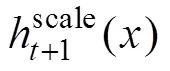

至此即完成了目标定位和尺度估计,基于此本文提出了一种自适应的时空上下文模型更新机制,以适应目标的尺度变化等各种外观变化。

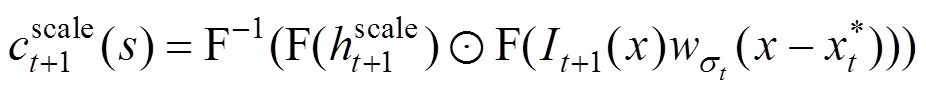

2.2 时空上下文模型自适应更新

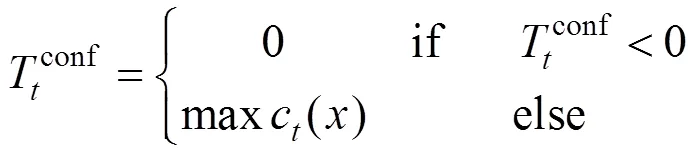

式(8)表明:STC跟踪器采用固定的学习率对时空上下文模型进行更新,一旦目标被遮挡或出现剧烈的姿态变化等,容易将错误的目标信息更新到上下文模型中,考虑到当前帧置信图中极大值反应了目标受到外界因素干扰的程度,本文采用如下的模型更新机制:

2.3 算法描述

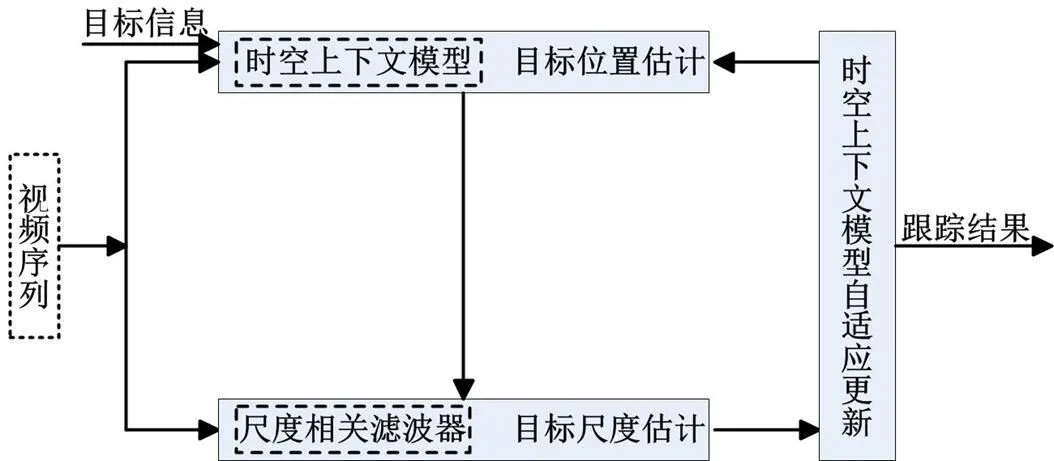

结合2.1的目标尺度估计和2.2的时空上下文模型更新,本文的目标跟踪算法的流程图描述如图1所示。

图1 本文算法框架图

3 实验与结果分析

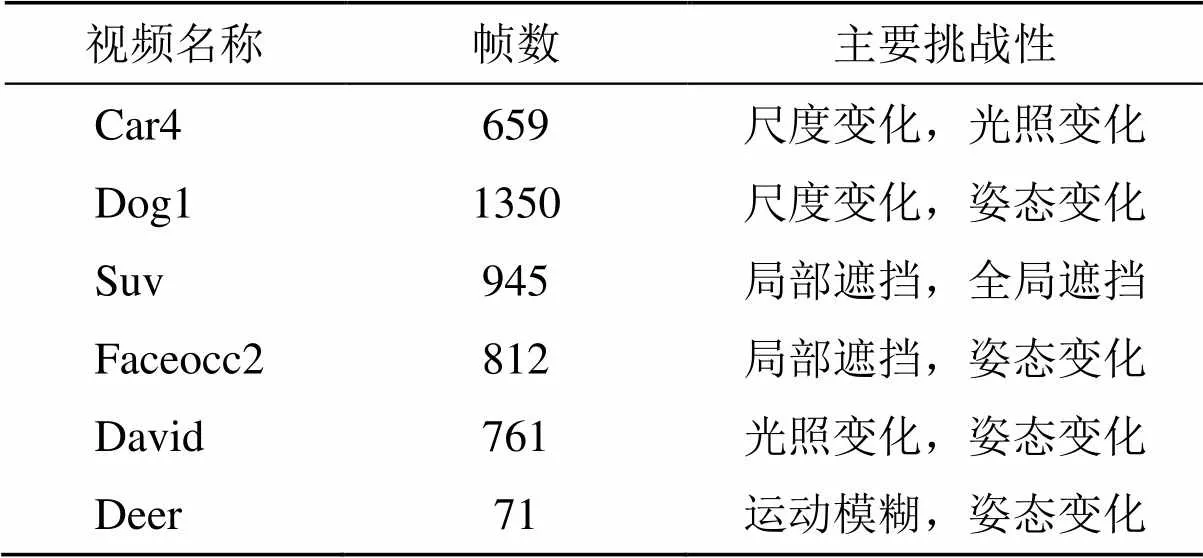

实验采用常见的6段具有诸如尺度变化、光照变化和姿态变化遮挡等不同挑战性的视频序列,并与原始STC算法[10]以及压缩感知跟踪算法CT[8]、多示例学习跟踪算法MIL[6]进行对比实验,对比算法采用文献[10]的参数设置。实验视频帧数共计4598帧,其不同的挑战性如表1所示。

3.1 评估标准

表1 测试视频的主要挑战性

3.2 结果分析

3.2.1 定量分析

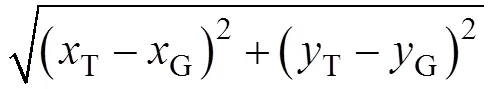

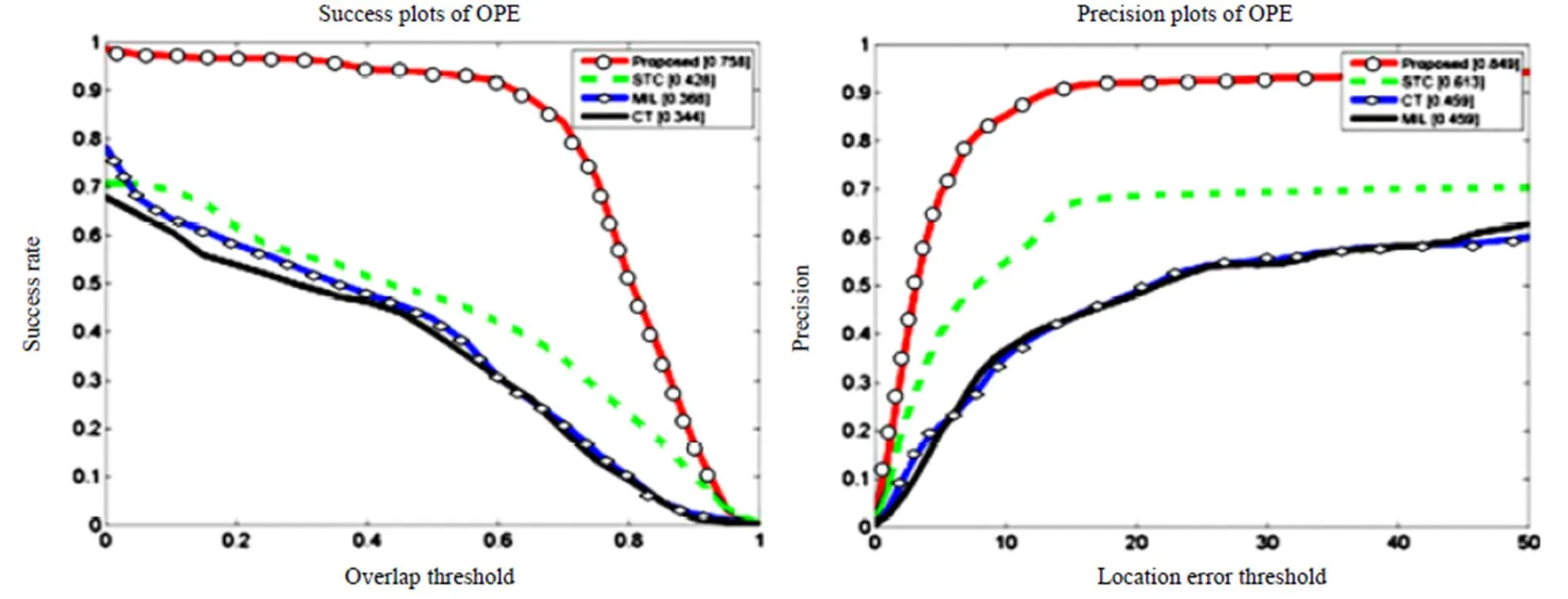

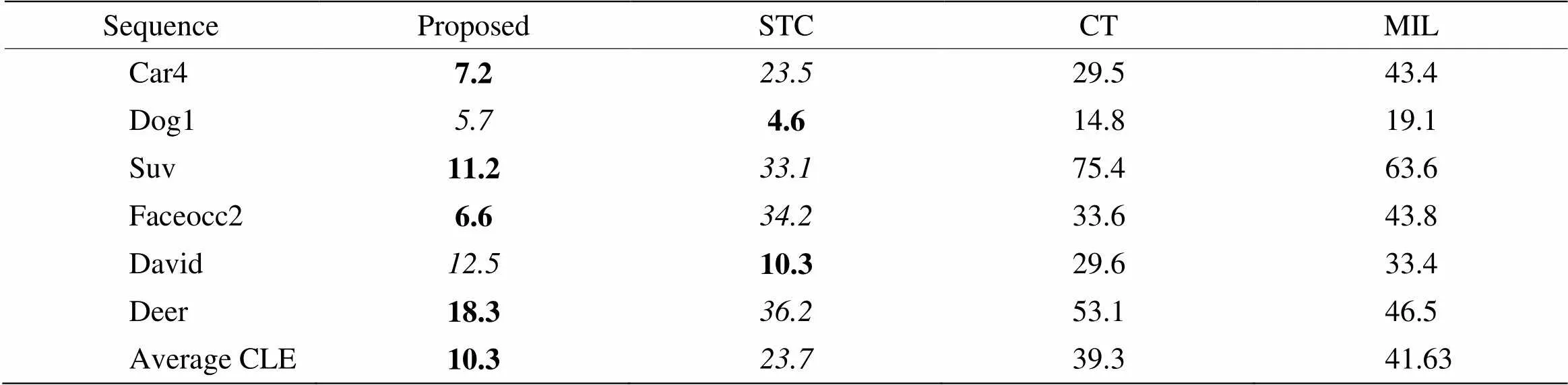

图2展示了所有算法的整体性能,红色(圆形线)代表本文算法的结果,绿色(虚线)、黑色(实线)、和蓝色(菱形线)分别代表STC、CT和MIL的跟踪结果)。本文的多尺度时空上下文跟踪方法(Proposed)在正确率曲线和成功率曲线中均排名第一。在成功率曲线中,本文方法的AUC(area under curve)值比原STC方法提高了0.329,在正确率曲线中,本文方法较原STC方法提高了38.4%,充分验证了本文的多尺度估计和模型自适应更新机制的有效性。表2给出了算法在各个视频序列中的平均中心位置误差对比,其中黑体代表最佳性能,斜体代表次优性能,可见本文方法在各类具有不同挑战性的视频中均有不错的表现,所有测试视频的平均中心位置误差为10.3pixel,优于其他算法。

由于本文算法采用了尺度相关滤波器进行尺度估计,并添加了模型自适应更新机制,算法计算量较原始STC算法有所提升。表3给出了所有评估算法的平均跟踪速度对比,可见本文算法较STC的350FPS的平均跟踪速度有所降低,但107FPS的跟踪速度依然可以满足实时应用的要求。

3.2.2 定性分析

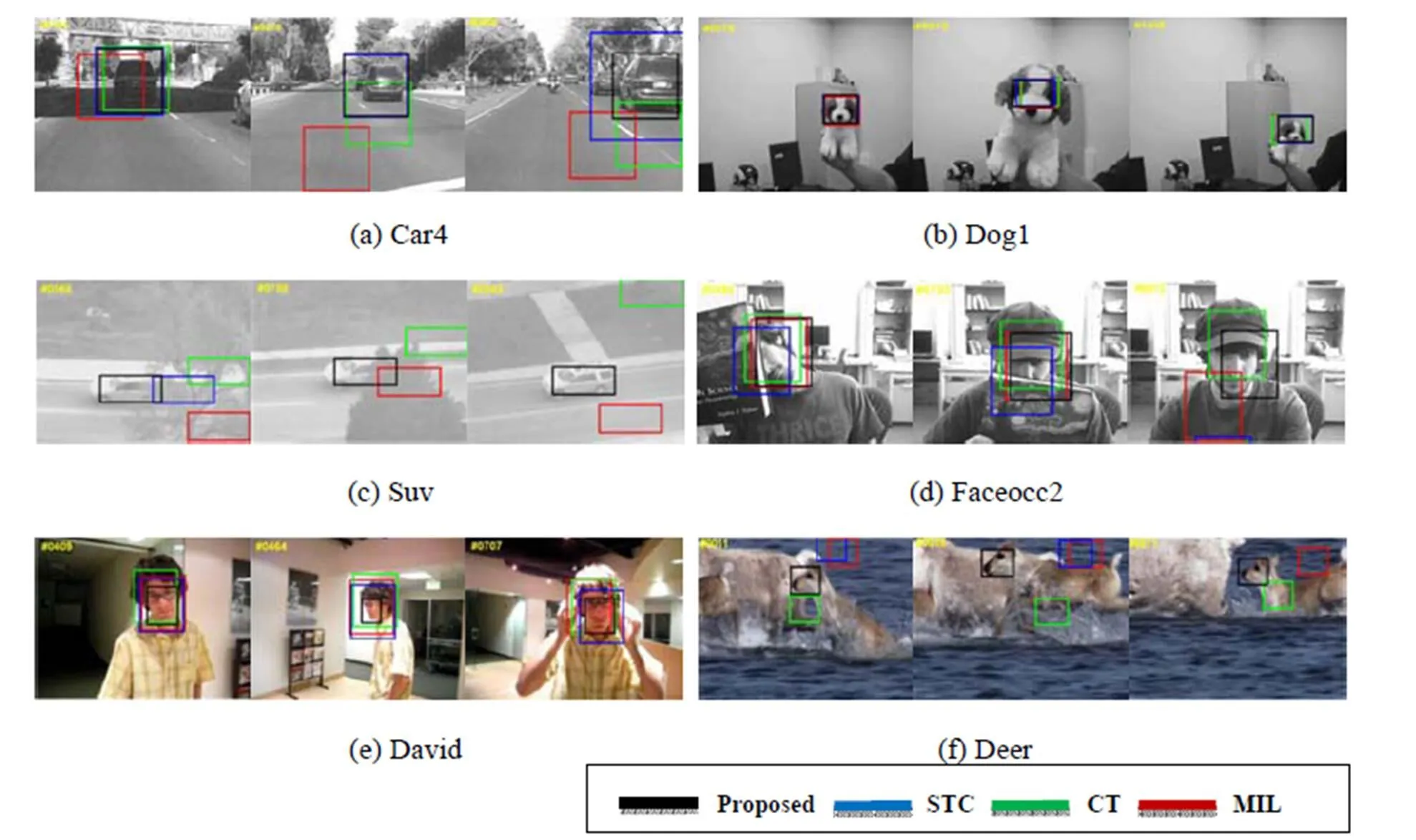

图3给出了各种算法在所有测试视频上的部分跟踪结果(黑色矩形框代表本文算法的跟踪结果,蓝色、绿色和红色分别代表STC、CT和MIL的跟踪结果)。(注:该彩色原图详见《红外技术》网站的电子版)下面将结合各类视频的不同挑战性对算法的性能进行分析。

图2 整体性能的成功率曲线和正确率曲线

表2 算法平均中心位置误差对比/pixel

表3 算法平均跟踪速度对比

图3 不同算法的部分跟踪结果

1)尺度变化:Car4序列和David序列展示了本文算法对目标尺度变化的适应性,在Car4序列中随着摄像头与目标的距离不断变化,目标尺度经历了一个由大到小再不断变大的过程,可以发现本文算法可以很好地捕捉到目标的尺度变化,而STC算法则在跟踪框变大后无法再捕捉到目标尺度变小的过程(如图3(a)所示);在David序列中,目标在第464帧转身的过程中目标尺度变小,只有本文算法捕捉到了这种变化,跟踪框自适应地进行了调整,充分验证了本文算法相关滤波器尺度估计的有效性。

2)全局和局部遮挡:Suv序列和Faceocc2序列展示了本文算法的抗遮挡能力,在Suv序列中,目标分别经历了3段不同程度的树木遮挡,第206帧左右第一次遮挡后,CT和MIL已经丢失目标,STC的跟踪结果与目标中心位置距离越来越大,而本文方法由于采用了自适应的模型更新机制,能较好抑制背景信息,因此在遮挡后依然能够定位到目标,在Faceocc2序列中人脸受到了不同程度的遮挡,第730帧左右人脸被书本和帽子遮挡后STC发生跟踪漂移,只有本文方法和CT方法取得了较好的跟踪结果。

3)光照变化和姿态变化:目标的各种外观变化会影响目标在线模型的更新,Car4序列和David序列中出现了不同程度的光照变化,Dog1序列和David序列中的目标经历了不同程度的姿态变化,由于本文方法采用不同的尺度参数和自适应的学习率对目标外围的背景信息进行抑制,减少了模型的错误更新,因此取得了较好的跟踪效果。

4)快速运动和运动模糊:Deer序列中由于目标运动较快带来了不同程度的运动模糊,STC、CT和MIL在第10帧左右即开始偏移目标,第18帧左右则完全丢失目标,只有本文方法成功完成了整个跟踪任务,充分显示了时空上下文模型自适应地更新目标信息的高效性。

4 结论

针对现有多尺度目标跟踪算法难以满足实时应用的问题,本文提出了一种高效的尺度自适应目标跟踪算法。在时空上下文跟踪器的基础上,基于相关滤波器的高效性,提出了一种新的目标尺度估计方法。结合目标位置和尺度,自适应更新时空上下文模型,减少了模型错误更新,较好地保留了目标信息。最后通过具有不同挑战性的测试视频进行实验,表明:本文方法在尺度变化、局部遮挡、目标姿态变化等情况下均能完成鲁棒跟踪,跟踪正确率较原始时空上下文跟踪算法提高了38.4%。实验中我们发现当目标丢失并重新出现在场景中时本文算法的跟踪效果并不理想,下一步拟结合目标重检测机制对本文算法进行改进。

[1] Emilio M. Video:[M]. Queen Mary University of London, UK, 2012: 15-24

[2] Ross D, Lim J, Lin R, et al. Incremental learning for robust visual tracking[C]//, 2008: 125-141.

[3] MEI X, LING H. Robust visual tracking and vehicle classification via sparse representation[J]., 2011, 33(11): 2259-2272.

[4] LI H, SHEN C, SHI Q. Real-time visual tracking using compressive sensing[C]/, 2011: 1305-1312.

[5] Grabner H, Leistner C, Bischof H. Semi-supervised On-Line Boosting for Robust Tracking[C]//, 2008, Part I: 234-247.

[6] Babenko B, YANG M H, Belongie S. Robust object tracking with online multiple instance learning[J]., 2011, 33: 1619-1632.

[7] Kalal Z, Matas J, Mikolajczyk K. Tracking-learning-detection[J]., 2012, 34(7): 1409-1422.

[8] ZHANG K H, ZHANG L, YANG M H. Real-time compressive tracking[C]//, 2012: 864-877.

[9] David S Bolme, J Ross Beveridge, Bruce A Draper, et al. Visual object tracking using adaptive correlation filters[C]//, 2010: 2544-2550.

[10] ZHANG K H, ZHANG L, LIU Q S, et al. Fast visual tracking via dense spatio-temporal context learning[C]//, 2014: 127-141.

[11] WU Y, Lim J, YANG M H. Online object tracking: a benchmark[C]//, 2013: 2411-2418.

Multi-scale Object Tracking Based on Spatio-temporal Context

LI Zeren,JI Feng,CHANG Xia,WU Yangyu

(,,750021,)

Correlation filter has been great applied in visual tracking. Aiming at the drift problem in complex situations, a multiple scale tracking method is proposed. Firstly, spatio-temporal context model is used to output the precise location of object by the confidence map. Secondly, the scale estimation is obtained by a trained correlation filter. Finally, based on the new location and scale, a new update mechanism of the spatio-temporal context model is proposed. Experimental results show that the proposed algorithm can complete the robust tracking under the condition of scale changes, partial occlusion, pose variations, etc. Tracking precision is improved by 38.4% compared with the original spatio-temporal context tracking method.

object tracking,spatio-temporal context,scale update

TP391

A

1001-8891(2017)06-0535-06

2016-08-29;

2016-09-01.

李泽仁(1987-),男,安徽阜阳人,硕士研究生,研究方向为计算机图形图像处理。

国家自然科学基金(61440044,61102008);北方民族大学科研项目(2014XYZ04)。