基于自适应背景模板与空间先验的显著性物体检测方法

2017-03-12林华锋李静刘国栋梁大川李东民

林华锋 李静 刘国栋 梁大川 李东民

显著性检测是指模拟人类的视觉检测机制,采用计算机视觉方法在一幅图像中通过抑制图像中冗余繁杂的背景信息提取出人们感兴趣的物体.近年来,显著性物体检测的研究引起众多学者的兴趣,提出了许多显著性检测方法[1−6],并将其广泛地应用于图像分割[7]、目标识别[8−9]、图像检索[10]和图像分类[11]等多个领域.

根据显著性物体与背景区域具有较高对比度这一假设,Cheng等[12]提出了基于“对比优先”的显著性检测模型.当一个显著性物体包含多个对比度较大区域时,该方法不能完整地提取显著性物体.根据图像边界区域更有可能是背景这一假设,Li等[3,13−16]提出了基于“背景优先”的显著性检测模型.该类显著性检测方法将图像边界作为背景区域,通过计算每个区域与背景区域的相异度获取显著图.但当显著性物体在背景区域中所占比例过大时,检测结果会有所偏差,同时最终的显著图中相邻显著性区域往往具有不连续显著值.

针对以上显著性模型存在的问题,结合显著性物体具有颜色稀有性与空间分布聚集性等特征,本文提出了一种显著性物体检测方法,能够有效检测位于图像边缘的显著性物体.该方法包含三个步骤:1)根据显著性物体的颜色稀有性,提出了一种基于自适应背景模板的显著性检测方法,获取基于自适应背景模板的显著图.该方法将图像边缘区域作为原始背景区域,当显著性物体位于图像边缘时,原始背景区域中不可避免地会存在一些显著区域.因此本文提出了一种自适应背景选择策略,能够有效去除背景区域中的显著区域,并将筛选后的背景区域作为自适应背景模板.通过计算超像素块与背景模板之间的相异度,获取基于自适应背景模板的显著图.由于获取的显著图中属于同一显著性物体的相邻超像素块的显著值不具有连续性,因此设计了一种基于K-means的传播机制对其进行了优化,保证区域显著性的一致性.2)根据显著性物体的空间分布聚集性,提出了一种基于目标中心优先与背景模板抑制的显著性检测方法,获取基于空间先验的显著图.该方法可增强位于边缘区域的显著物体的显著性,同时抑制背景区域的显著性,使对比效果更加明显.3)将获得的两种显著图进行融合得到最终的显著图.

本文结构安排如下:第1节介绍显著性物体检测方法的相关研究工作;第2节介绍本文提出的基于自适应背景模板与空间先验的显著性物体检测方法;第3节介绍本文方法与其他算法在标准数据集上的对比结果,对方法中各个组成部分进行评测,并将提出的算法用于基于Web的协同显著性检测;第4节总结本文并讨论进一步的研究方向.

1 相关工作

由于显著性检测算法繁多,本节主要介绍基于“对比优先”与“背景优先”模型的显著性检测算法.其他显著性检测算法可参考文献[17],该文献详细介绍了40种不同显著性检测算法及其性能.

基于“对比优先”模型的显著性算法可划分为基于局部的显著性检测算法与基于全局的显著性检测算法两大类.基于局部的方法通常假设某区域与其邻域存在某种可量化的区分性.Itti等[18]根据人眼视觉特性,采用高斯金字塔非均匀采样方法生成多个尺度图像.针对每个尺度图像,通过计算颜色、亮度、方向等底层特征的中心–周围对比度得到相应的显著图,融合多个尺度图像生成的显著图获取最终显著图.Ma等[19]等根据局部分块在CIELuv空间上的颜色对比度,并结合模糊膨胀的方法计算像素点的显著,进而提出了基于模糊增长模型的显著性检测算法.Achanta等[20]采用多尺度双窗口的形式,以内外窗口的像素点在CIELab空间的距离作为显著性度量,采用频率调谐方法获取相应的显著图.但是,该方法只考虑了一阶颜色特征,不足以分析复杂多变的自然图像.Rahtu等[21]采用贝叶斯框架,计算局部中心与外围边缘像素点之间正规化的颜色对比度,得到显著图.但仅仅基于局部特征,往往突出物体边缘或较小的局部物体,目标内部显著值缺失.基于全局的显著性检测算法根据显著性物体的独特性获取相应的显著图.Cheng等[22]使用稀疏直方图简化图像颜色,采用基于图的分割方法将图像划分为多个区域,根据与待测区域的空间距离越近对该区域显著值的贡献越大这一假设,利用空间位置距离加权的颜色对比度之和来衡量图像区域的显著性.Perazzi等[23]采用一种基于对比度的显著性检测滤波器,通过区域唯一性以及空间分布估计图像的显著性.然而,上述方法虽然简单有效,但是位于显著性目标内部的像素点可能被忽略,不能均匀的检测出来.Margolin[24]首先将图像划分为多个超像素块,并对其进行主成分分析,将获取的主成分之间的差异定义为模式可区分性,通过结合全局颜色对比度,获取相应的显著图.Yan等[25]通过将图像划分为多尺度图层,针对每个图层计算其颜色特征与空间特征的对比度,融合多个图层生成的显著图获取最终显著图.该方法能够保证显著性目标的一致性与完整性,但当显著性目标较小时,会将显著性目标当做背景融入到背景区域.Shen等[26]将图像表示成某特征空间下的低秩矩阵(非显著性区域)和稀疏噪声(显著性区域)的合成,并结合高层先验知识,获取显著区域.

近年来,越来越多的自下而上的方法偏向于通过选择图像的边缘作为背景种子来构建显著性图.与基于“对比优先”的显著性检测模型不同,基于“背景优先”的显著性检测模型先确定背景区域,通过计算每个区域与背景区域的相异度获取显著图.Wei等[2]通过分析背景区域的特征,基于背景先验,即边缘与连接性,将每一个区域与图像边缘的最短距离定义为其显著性值,进而提出基于测地线距离的显著性检测模型.Zhu等[27]根据图像区域的空间分布,利用边缘连接性提出了一种容错的显著性检测模型.Li等[3,16]采用稠密与稀疏重构误差模型获取相应的显著图,然后利用传播机制对获取的显著图进行一致性优化,利用贝叶斯算法对优化后的显著图进行融合.Yang等[13]通过流形排序计算每个区域图像边缘的相关性,并将其作为每个区域的显著性值,进而提出了基于流行排序的显著性检测模型.Jiang等[14]将图像中的每个超像素块映射为马尔科夫链的状态,计算状态之间的转移时间,并将其作为该超像素块的显著性值,进而提出了基于吸收马尔科夫链的显著性检测模型.Xi等[28]通过计算图像中每个超像素块同位于图像边缘区域超像素块的颜色对比度获取初始显著图,利用提出的显著图优化方法计算图像中每个像素点的显著值,进而提出了一种基于背景优先的显著性检测模型.Qin等[29]通过计算图像中每个超像素块与背景区域的对比度,获取显著性图,然后提出了一种新型的基于元胞自动机的传播机制,对超像素块的显著性值进行动态更新,获取最终的显著图.

2 本文方法

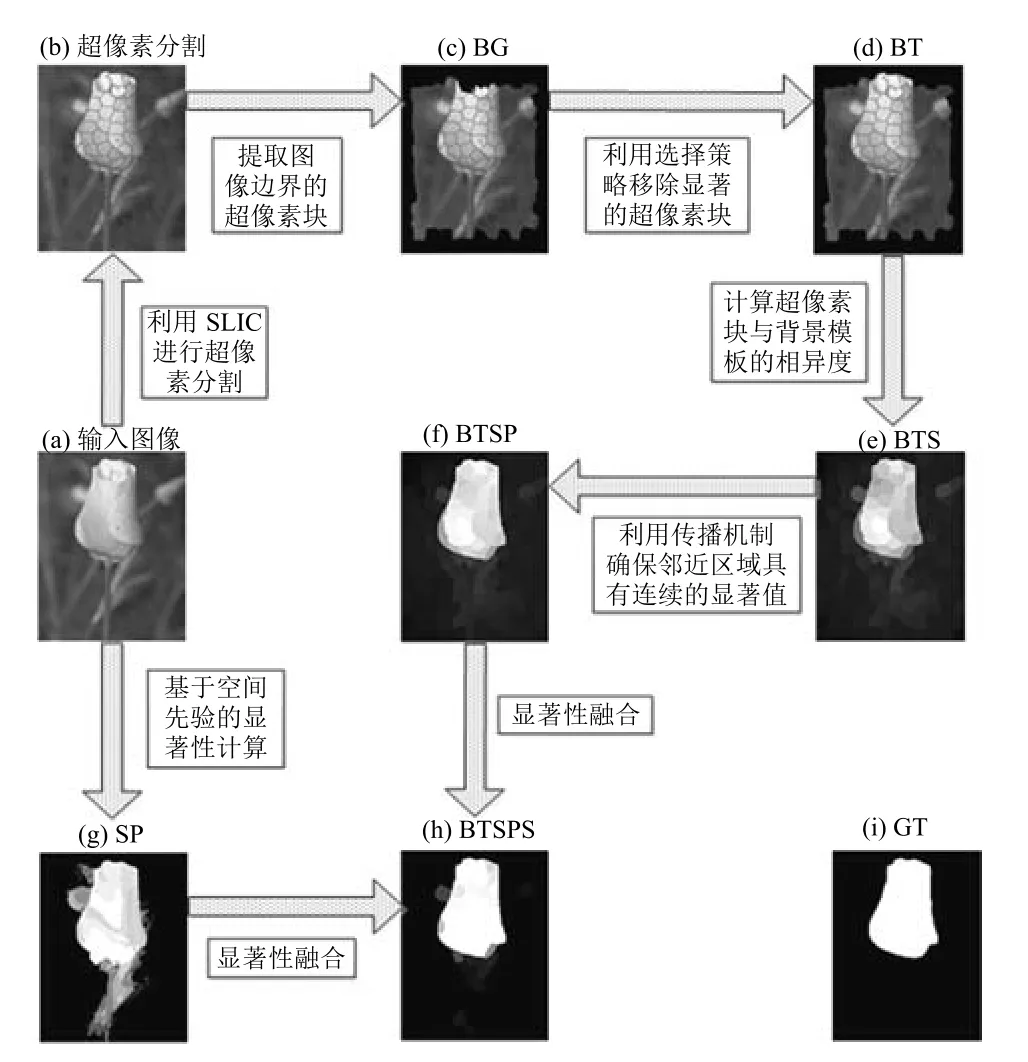

本节对提出的显著性物体检测方法SCB进行详细介绍.图1为SCB的总体框架图.其中,BG是原始背景区域;BT是背景模板;BTS是基于背景模板抑制的显著图.BTSP是传播的BTS;SP是基于空间先验的显著图;BTSPS是最终的显著图;GT是人工分割图.

图1 SCB框架图Fig.1 The framework of SCB salient detection method

SCB根据显著性物体的颜色稀有性与空间分布聚集性获取了基于自适应背景模板的显著图与基于空间先验的显著图,通过融合两种显著图获取最终显著图.对给定的输入图像,先利用SLIC[30]超像素分割算法将输入图像分割成超像素块.基于自适应背景模板的显著性物体检测方法提取位于图像四周边界的超像素块构建原始背景区域,并使用自适应选择策略,去除原始背景区域中显著的超像素块.将筛选后的超像素块作为自适应背景模板,通过计算每个超像素块与自适应背景模板的相异度,获取基于自适应背景模板的显著图.为保证属于同一显著性物体的超像素块具有连续的显著值,使用K-means传播机制对自适应模板的显著图进行优化.为增强位于图像边缘显著性物体的显著性并抑制背景区域显著性,提出了一种基于目标中心优先与背景模板抑制的空间先验方法,获取基于空间先验的显著图.最终,融合优化后的基于自适应背景模板的显著图与基于空间先验的显著图,获取最终的显著图.

2.1 基于自适应背景模板的显著图

通过实验对比发现,与基于“对比优先”模型的显著性物体检测方法相比,基于“背景优先”模型的显著性检测算法的性能更好.因此,根据显著性物体的颜色特征稀有性,提出了一种基于“背景优先”模型的显著性检测方法,即基于自适应背景模板的显著性检测方法,获取基于自适应背景模板的显著图.

2.1.1 特征提取与超像素分割

Lab是最接近于人类视觉的一种均匀颜色空间,能够同时反映图像的亮度特征与颜色特征.空间位置特征能够反映像素点的空间分布.因此,首先提取输入图像I中每个像素点的Lab特征与空间位置特征.根据提取的特征,利用SLIC分割算法将图像I分割成超像素块,其中N表示超像素块的个数.对于任一超像素块可表示为一个5维的特征向量,由其包含的像素点的平均颜色特征和空间位置坐标构成.超像素块由具有相似特征的像素点组成,基于超像素块的显著性物体检测能够有效提高显著性物体检测的效率.

2.1.2 自适应背景模板构造

根据图像四周的边界区域最有可能是背景这一特点[3],通过提取位于四周边界的超像素块构造原始背景区域Ibr.当显著性物体位于图像边界时,背景区域中不可避免地包含显著的超像素块.大部分基于“背景优先”模型的方法直接利用原始背景区域进行显著性计算[3],导致显著性检测结果会有所偏差.为了提高显著性物体检测的鲁棒性,本文提出了一种基于对比准则与联通性准则的自适应选择策略,用于从原始背景区域中移除显著的超像素块,并将筛选后背景区域称为自适应背景模板.

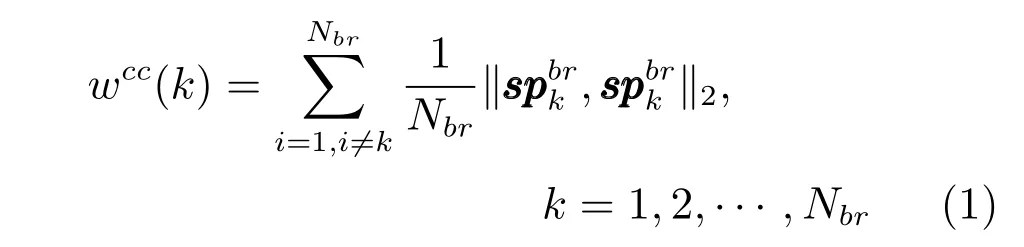

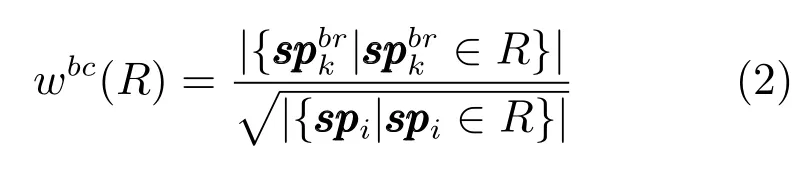

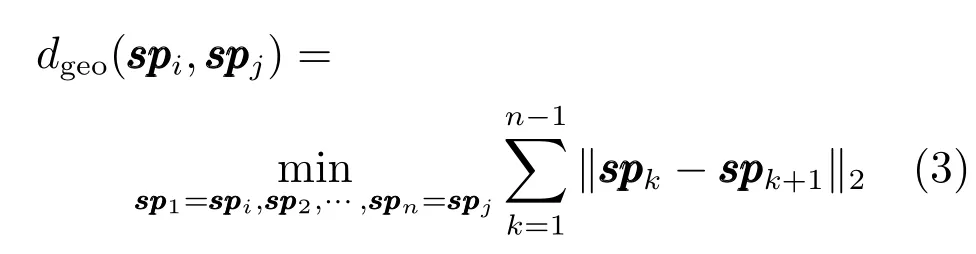

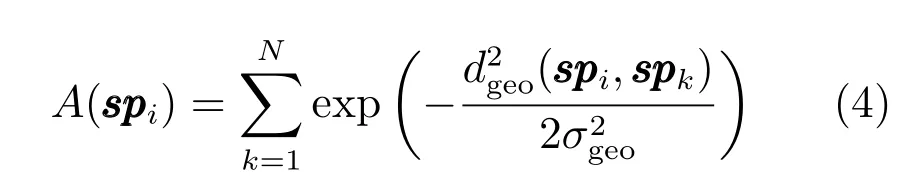

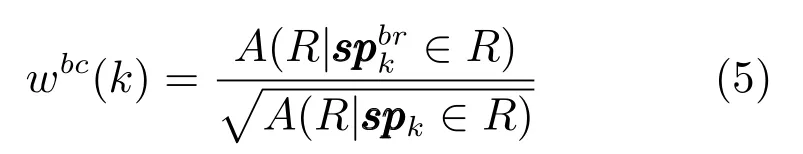

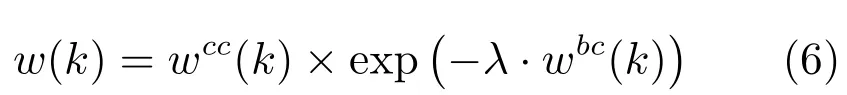

1)对比准则.根据显著的超像素块与背景超像素块之间的颜色相异度远远大于两个背景超像素块之间的颜色相异度,移除原始背景区域中的显著超像素块,计算每个边界超像素块的对比权值:

2)连通性准则.根据背景区域更容易连通图像边界这一特点,移除原始背景区域中的显著超像素块.将区域R与图像边界相交区域的面积与整个区域面积平方根的商定义为R的连通性.

通过观察可知,即使显著性物体位于图像边界,显著性物体与图像边界相交区域的面积远小于整个显著性物体的面积.因此,如果一个超像素块是显著的,其所属区域的连通性值一定远远小于背景超像素块所属区域的连通性值.使用无向加权图[26]将超像素块划分为多个区域,两个超像素块与之间的测地线距离被定义为无向图中最短路径上所有边的权值和.

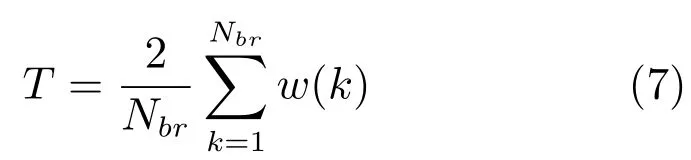

根据式(7),计算原始背景区域中所有超像素块权值的自适应阈值T[12]

2.1.3 显著性计算

如果一个超像素块与自适应背景模板的空间距离越近,那么自适应背景模板对该超像素块显著值的影响就越大[12].因此,将空间位置距离加权的颜色对比度之和定义为超像素块的显著值:

图2 基于自适应背景模板的显著图Fig.2 Saliency maps based on adaptive background template

2.1.4 显著性优化

显著性物体可能是由不同特征的显著性超像素块组合而成,因此,在获取的基于背景模板的显著图中,属于同一显著性物体的相邻超像素块的显著值往往具有不连续性.为保证显著性物体的区域一致性,提出基于K-means聚类算法的传播机制对基于自适应背景模板的显著图进行一致性优化.

首先,利用K-means算法将超像素块划分为K个聚类,聚类中心为.如果根据经验直接设置聚类个数或者仅仅利用超像素块之间的颜色对比度进行聚类,都可能将具有相似颜色特征的像素块划分到不同的聚类中.为解决上述问题,从两个方面对K-means算法进行优化.1)根据图像颜色特征的直方图分布情况,自适应地获取聚类个数.与文献[12]类似,将图像的颜色特征由256个颜色值量化为12个颜色信道,计算相应的颜色直方图,保留高频颜色特征,并使其至少覆盖95%的图像像素点,剩余的颜色特征由直方图中距离最近的颜色代替.由于量化后的每个颜色信道均可视为一个聚类,因此可将图像的高频颜色特征所包含的信道数目作为聚类个数K,其中1≤K≤12.2)利用空间位置距离加权的颜色特征进行聚类.由于显著性目标包含的像素点不仅具有相似的颜色特征,而且在空间位置分布上具有聚集性.因此,利用加权的颜色对比度进行K-means聚类.

对于属于聚类Ck的两个相邻[31]的超像素块与,它们的影响因子可定义为

其中,Ω(i)为超像素块的2层邻居[29],即与超像素块的直接相邻的超像素块以及与这些超像素块相邻的超像素块.为了归一化影响因子矩阵,构建一个度量矩阵

对于聚类Ck中的超像素块, 其优化后的显著性值可定义为

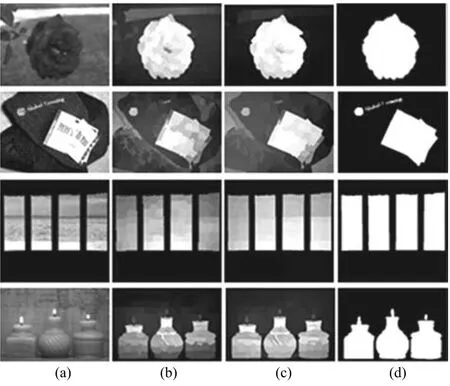

其中,ai,j是由式(11)计算得到的超像素块与的影响因子参数.µ1与µ2分别为周围超像素块显著值以及现有超像素块显著值的平衡参数.为超像素块邻居超像素块的数目.图3给出了利用传播机制优化后的基于自适应背景模板的显著图.图3(a)为输入图像;图3(b)为基于背景模板的显著图;图3(c)为优化显著图;图3(d)为人工分割图.通过对比图3(b)与图3(c)可知,引入传播机制后的显著性物体具有连续的显著值,呈现区域一致性.由此可见,基于K-means聚类算法的传播机制能够有效地优化基于自适应背景模板的显著图,获取更加准确的显著性物体.

图3 利用传播机制优化基于自适应背景模板显著图Fig.3 Saliency maps based on propagation mechanism

2.2 基于空间先验的显著图

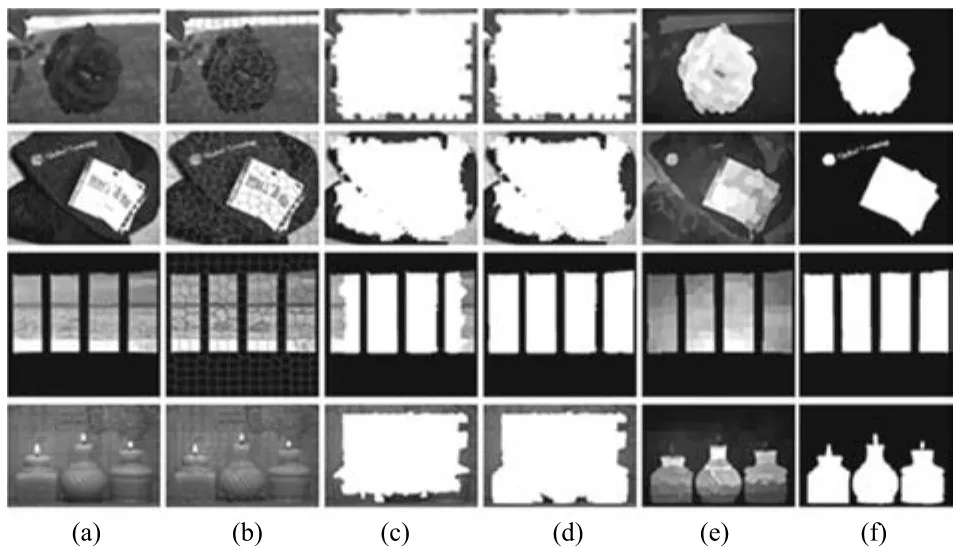

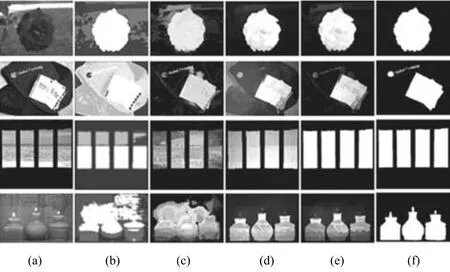

人类视觉系统更多地关注图像中心的区域[32],这被称之为“中心优先”准则.基于“中心优先”准则的空间先验通常用于增强位于图像中心的显著性物体(例如图4(b)中的第1行的花朵).但该方法也会抑制位于图像边缘的显著性物体的显著值(例如图4(b)中的第4行的蜡烛底座),增强位于图像中心的背景区域(例如图4(b)中的第2行的衣服),这显然不是显著性检测所期望的结果.为解决这一问题,本文提出一种改进的基于中心优先与背景模板抑制的空间先验方法,同时考虑了“中心优先”准则与“背景模板抑制”准则,可有效增强位于图像边缘显著性物体的显著性,同时抑制位于图像中心的背景区域.对于输入图像的像素点pi,其空间先验显著值定义为

其中,(xi,yi)和(xk,yk)分别表示像素点pi和pk的坐标,(µx,µy)表示图像中心,η表示图像“中心优先”准则和“背景模板抑制”准则的平衡参数.对于式(13),等号右侧第1项表示图像“中心优先”准则,第2项表示“背景模板抑制”准则.

图4 基于空间先验显著图Fig.4 Saliency maps based on spatial prior

图4显示了基于空间先验的显著性检测.图4(a)为输入图像;图4(b)为基于“中心优先”准则的显著图;图4(c)为基于提出的空间先验准则的显著图;图4(d)为利用传播机制优化的基于自适应背景模板显著图;图4(e)为最终的显著图;图4(f)为人工分割图.对比图4(b)与图4(c)可知,无论显著性物体是位于图像中心还是图像边界,提出的空间先验方法均能有效增强显著性物体的显著值,同时抑制了背景区域的显著值.

2.3 显著图融合

目前常用的显著图或特征融合方法有线性融合[18]和基于像素的点乘融合等[3].经过实验对比,线性融合能够提高显著性检测的查全率,而点乘融合能够有效抑制显著图中的背景区域,提高显著性检测的查准率.本文更关注显著性检测的准确率,因此采用点乘融合优化后的基于自适应背景模板的显著图与基于空间先验的显著图.

融合得到的最终显著图如图4(e)所示.本文提出的显著性检测方法SCB详细步骤如下:

算法1.基于自适应背景模板与空间先验的显著性检测方法

输入.输入图像I,超像素块个数N,聚类个数K,参数σgeo,σc,µ1,µ2.

输出.显著图S.

1.基于选择策略的自适应背景模板

1.1利用SLIC算法将输入图像I分割为N个超像素块;

1.2提取图像四周边界,构建原始背景区域Ibr;

For背景区域的超像素块

1.3根据式(1)与式(5),计算对比权值与联通性权值;

1.4根据式(6),计算最终权值w(k);

1.5根据式(7),获取自适应阈值T;

Ifw(k)>Tdo

1.6从背景区域Ibr中移除超像素块;

End If

End For

1.7利用筛选后的超像素块,构建背景模板Nbt;

1.8根据式(8),计算基于背景模板的显著值;

1.9利用K-means聚类算法,将超像素块集合聚成K个聚类;

1.10根据式(11),获取传播矩阵A;

1.11根据式(12),计算传播显著值Spr.

2.基于中心优先与背景模板抑制的空间先验

2.1根据式(13),计算基于空间先验显著值;

2.2根据式(14),计算最终显著值Si,获取相应的显著图S.

3 实验结果与分析

3.1 数据集介绍

在四个数据集上对提出的方法进行评估.这四个数据集是:MSRA-1000[20]、SOD[33]、ECSSD[25]及构建的新数据集—复杂背景数据集(CBD).

MSRA-1000数据集是应用最广泛的数据集,共包含1000幅显著性物体突出并且与背景颜色对比度非常明显的图像.该数据集的人工分割图将图像划分为物体区域与背景区域两部分,显著性物体的轮廓非常清晰,精确到像素级.SOD数据集是一个更具挑战的数据集,共包含300张图像,每张图像往往包含多个显著性物体,且物体的大小与位置不一.该数据集的人工分割图由文献[2]提供.ECSSD数据集包含1000张结构复杂的图像.其中,结构复杂指的是图像中的显著性物体或者背景区域包含多个对比度明显的区域.

为验证提出的显著性检测方法的性能,构建了一个新的数据集.首先,收集SED2[34]、PASCAL-1500[35]与HKU-IS[36]三个数据集.依据以下三个原则挑选更有挑战性的图像:1)显著性物体位于图像边界的图像;2)包含多个显著性物体的图像;3)包含复杂背景的图像.

3.2 参数设置与评估标准

为了获取更好的显著性检测结果,针对公式中的参数做了比较实验.实验表明,式(4)中的参数σgeo在区间[5,15]时,表现出很强的稳定性.因此固定参数σgeo=10,式(9)中的参数被设置为0.1,式(12)中的平衡参数µ1与µ2均被设置为0.5,式(13)中的平衡参数η被设置为1.

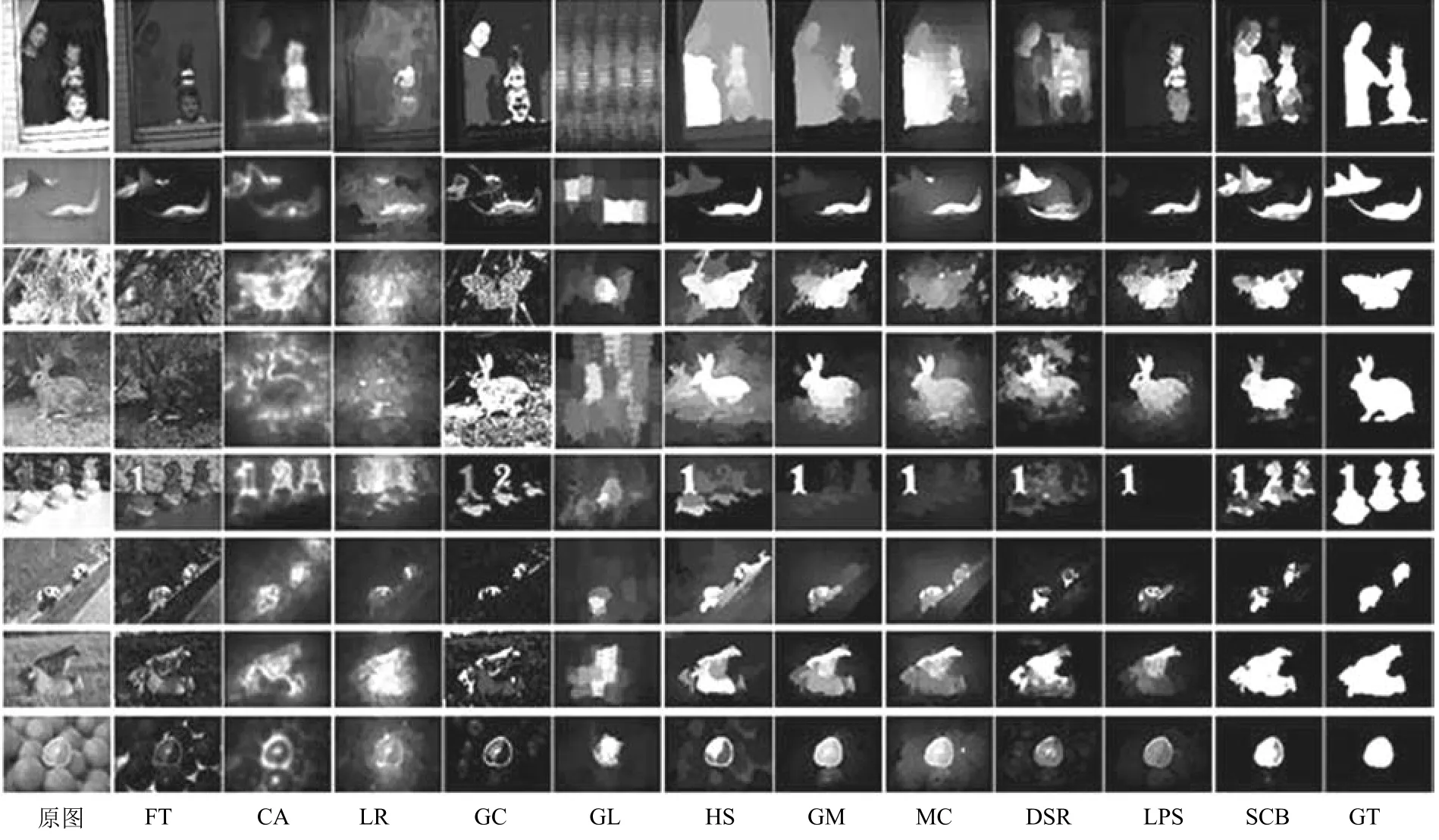

通过对比显著图的准确率(Precision)–召回率(Recall)曲线、准确率–召回率–F-measure值柱状图[17](F-measure柱状图)与平均绝对误差(Mean absolute error,MAE)柱状图来评价显著性检测的性能.针对显著性模型产生的显著图用阈值进行分割,其中阈值的取值范围为0~255.由此可以得到256个平均的准确率与召回率,以横轴为召回率,纵轴为准确率,将这些点平滑地连接起来,产生准确率–召回率曲线.不同于准确率–召回率曲线,在绘制准确率–召回率–F-measure值柱状图时,利用每幅图像的自适应阈值[20]T对图像进行分割.

其中,参数W与H分别表示图像的宽度与高度.对每个数据集中的显著图,计算他们的平均准确率与召回率.根据式(16)计算平均的F-measure值.

F-measure值用于综合评价准确率与召回率,为了强调准确率的重要性,设置β2为0.3[13,20].

平均绝对误差通过对比显著图与人工分割图的差异来评价显著性模型[22].根据式(17),计算每个输入图像的MAE,利用计算出的MAE均值绘制柱状图.

3.3 实验对比结果

为验证提出的显著性检测方法SCB的性能,在4个数据集上与14种经典算法进行对比,包括LC06[37]、SR07[38]、FT09[20]、CA10[39]、LR12[26]、HS13[25]、DSR13[3]、GC13[22]、GM13[13]、MC13[14]、GL14[40]、HC15[12]、RC15[12]与 LPS15[41]. 其中,算法LC、SR、FT、HC与RC的代码由文献[12]提供.所有显著性检测模型获取的显著图都被标准化到[0,255].

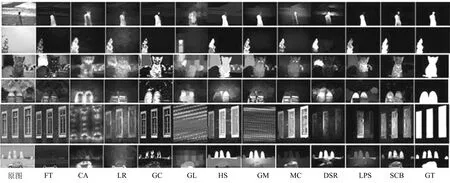

针对显著性物体位于图像边缘的图像,图5显示了显著图的视觉比较结果.其中,前6种算法是基于“对比优先”准则的显著性检测模型,后4种算法与提出的SCB算法都是基于“背景优先”准则的显著性检测模型.最后一列为人工分割图.通过实验发现,与其他显著性检测算法相比,提出的显著性检测方法SCB能够完整地检测位于边界的显著性物体,取得更加准确的显著图,明显优于其他算法.

图5 针对显著性物体位于图像边缘的图像,显著图的视觉比较结果Fig.5 Visual comparison of previous methods,our method and ground truth for the image whose salient object locates at the border

为了全面评估提出的SCB方法的性能,从4个数据集中挑选具有挑战性的图像进行显著性物体检测[42−43].其中,前两行图像包含多个显著性物体,第3行和第4行图像具有复杂的背景,第5行和第6行图像的显著性物体包含复杂的结构,最后两行图像的显著性物体与背景区域间的对比度较低.针对挑战性的图像,图6显示了显著图的视觉对比结果.实验结果表明,提出的SCB方法不仅能够完整地检测出显著性物体,而且能够有效地抑制背景区域,优于其他显著性算法.

图6 显著图的视觉比较结果Fig.6 Visual comparison of previous methods,our method and ground truth

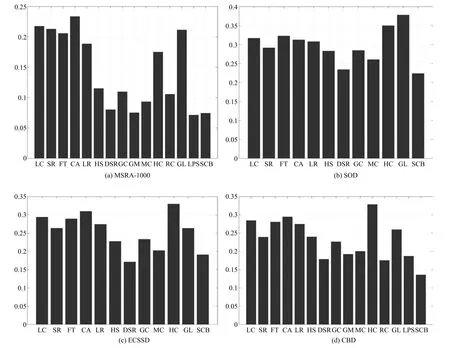

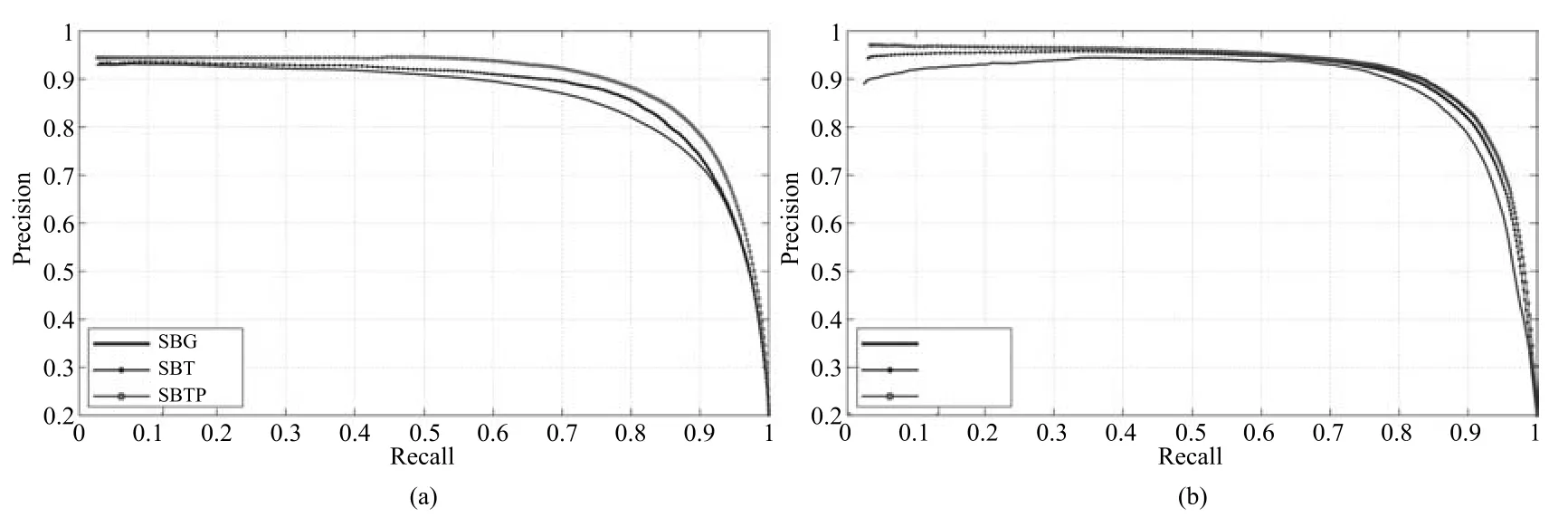

图7根据准确率–召回率曲线与F-measure值柱状图两个评价标准对显著性检测模型进行对比分析.针对MSRA-1000数据集,提出的SCB方法明显优于大部分显著性检测算法,例如GC、CA、FT等.但是,由于该数据集中图像的显著性物体较为简单,而提出的显著性检测方法更适合于复杂场景的图像.因此,提出的SCB方法的准确率–召回率曲线与F-measure值柱状图都略逊于DSR、GM 与MC等算法.针对SOD数据集,提出的SCB方法与DSR、MC都取得较好的准确率–召回率曲线,但是SCB的F-measure值分别比算法DSR与算法MC高出3.1%和3.0%.对于ECSSD数据集,提出的SCB方法、HS、DSR与MC等算法都取得较好的准确率–召回率曲线与F-measure值柱状图.针对提出的数据集CBD,提出的SCB取得了75.3%的准确率、69.8%的召回率,远远高于准确率为71.5%、召回率为64.0%的MC算法,明显超过现有的显著性检测模型.主要是因为构建的CBD数据集中的图像具有较为复杂的场景,例如,显著性物体位于图像边缘、多个显著性物体、显著性物体包含多个对比度明显的区域等.

图8根据MAE柱状图这一评价标准对显著性检测模型进行对比分析.针对MSRA-1000数据集,提出的SCB方法的MAE值为0.074,仅次于MAE为0.071的算法LPS.针对ECSSD数据集,只有SCB方法与DSR方法的MAE值低于0.2,但是DSR算法取得最低的MAE值.针对SOD数据集与CBD数据集,提出的SCB方法分别取得0.2235与0.135的MAE值,远远低于其他的显著性检测方法.由此可见,提出的显著性检测方法能够有效地抑制背景区域.

图9进一步分析了提出的SCB方法的各个组成部分的作用与贡献,例如自适应背景模板与空间先验.

由图9(a)可知,与基于原始背景区域的显著图相比,基于自适应背景模板的显著图取得更好的准确率–召回率曲线.提出的传播机制也能够有效地优化基于自适应背景模板的显著图,提高显著性检测的性能.图9(b)对比了基于“中心优先”准则的空间先验,基于“背景模板抑制”的空间先验以及提出的空间先验方法.通过比较可知,提出的空间先验方法取得最好的性能.

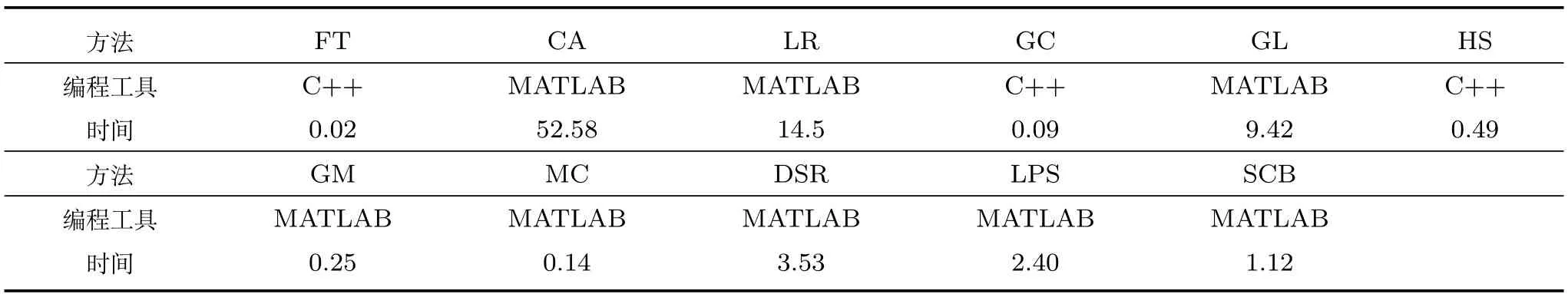

表1显示了显著性检测模型在数据集CBD上平均处理一幅图像所需的时间.实验借助MATLAB工具在Intel Core i3-3220处理器,4GB内存的硬件环境下进行.其中,超像素分割的时间不计入处理时间.提出的SCB算法每幅图像平均检测时间为1.12s.

3.4 基于Web的协同显著性检测系统

协同显著性检测是从一组图像中发现其间共有的显著性物体.全局分布特征用来衡量每个图像区域在一组图像中的分布情况,是协同显著性检测的一个重要的全局指标.如果同一个区域均匀地分布在每一个图像,则该区域将会获得更大的全局分布特征权值.在提出的SCB方法中,引入全局分布特征,提出相应的协同显著性检测算法,用于协同显著性物体检测,获取协同显著图.

图7 不同算法的准确率–召回率曲线与F-measure值柱状图Fig.7 Quantitative results of the precision/recall curves and F-measure metrics

图8 针对MSRA-1000、SOD、ECSSD与CBD数据集,不同显著性检测方法的MAE柱状图Fig.8 Quantitative results of the MAE value of MSRA-1000,SOD,ECSSD and CBD

图9 针对MSRA-1000数据集,提出的SCB方法各个组成部分的准确率–召回率曲线Fig.9 Quantitative results of each component of SCB method in MSRA-1000 dataset

表1 平均检测时间对比表Table 1 The table of contrast result in running times

图10 针对Co-saliency pairs数据集,基于Web的协同显著图Fig.10 The co-saliency map based on web in co-saliency pairs dataset

随着互联网的普及,本文构建了一个可以在线访问的基于Web的协同显著性检测系统.利用高质量的开源Web开发框架Django,建立Web应用,将提出的协同显著性检测算法封装到Web应用中.用户通过Web浏览器访问构建的基于Web的协同显著性检测系统,针对用户输入的多幅图像,Django调用提出的协同显著性算法进行处理,并将处理结果返回至Web浏览器.本文从Co-saliency Pairs数据集[44]中挑选4组图像,其中每组图像包含2张图像.分别对每组图像进行协同显著性物体检测,如图10所示.

4 结论

本文提出一种基于自适应背景模板与空间先验的超像素级的显著性检测方法.通过在4个数据集上与现有的显著性模型对比,针对显著性物体位于图像边界的图像、背景比较复杂的图像和包含多个显著物体的图像,提出的SCB方法能够取得更好的性能.但是当显著性物体与背景模板的颜色特征十分相似时,提出的显著性检测算法不能完整地检测显著性物体.针对提出算法的不足之处,未来工作的主要目标是通过引入更多的底层特征来优化SCB方法,并降低显著性检测的运行时间.

1 Qian Sheng,Chen Zong-Hai,Lin Ming-Qiang,Zhang Chen-Bin.Saliency detection based on conditional random fi eld and image segmentation.Acta Automatica Sinica,2015,41(4):711−724(钱生,陈宗海,林名强,张陈斌.基于条件随机场和图像分割的显著性检测.自动化学报,2015,41(4):711−724)

2 Wei Y C,Wen F,Zhu W,Sun J.Geodesic saliency using background priors.In:Proceedings of the 12th European Conference on Computer Vision.Berlin,Germany:Springer,2012.29−42

3 Li X H,Lu H C,Zhang L H.Saliency detection via dense and sparse reconstruction.In:Proceedings of the 2013 IEEE International Conference on Computer Vision.Sydney,Australia:IEEE,2013.2976−2983

4 Wang K Z,Lin L,Lu J B,Li C L,Shi K Y.PISA:pixelwise image saliency by aggregating complementary appearance contrast measures with edge-preserving coherence.IEEE Transactions on Image Processing,2015,24(10):3019−3033

5 Wang L J,Lu H C,Ruan X,Yang M H.Deep networks for saliency detection via local estimation and global search.In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,USA:IEEE,2015.3183−3192

6 Mauthner T,Possegger H,Waltner G,Bischof H.Encoding based saliency detection for videos and images.In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,USA:IEEE,2015.2494−2502

7 Jain S D,Grauman K.Active image segmentation propagation.In:Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas,Nevada,USA:IEEE,2016.2864−2873

8 Yu G,Yuan J S,Liu Z C.Propagative Hough voting for human activity detection and recognition.IEEE Transactions on Circuits and Systems for Video Technology,2015,25(1):87−98

9 Horbert E,Garc´ıa G M,Frintrop S,Leibe B.Sequencelevel object candidates based on saliency for generic object recognition on mobile systems.In:Proceedings of the 2015 IEEE International Conference on Robotics and Automation.Seattle,Washington,USA:IEEE,2015.127−134

10 Yang X Y,Qian X M,Xue Y.Scalable mobile image retrieval by exploring contextual saliency.IEEE Transactions on Image Processing,2015,24(6):1709−1721

11 Lei B Y,Tan E L,Chen S P,Ni D,Wang T F.Saliencydriven image classi fi cation method based on histogram mining and image score.Pattern Recognition,2015,48(8):2567−2580

12 Cheng M M,Mitra N J,Huang X L,Torr P H S,Hu S M.Global contrast based salient region detection.IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3):569−582

13 Yang C,Zhang L H,Lu H C,Ruan X,Yang M H.Saliency detection via graph-based manifold ranking.In:Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition.Portland,OR,USA:IEEE,2013.3166−3173

14 Jiang B W,Zhang L H,Lu H C,Yang C,Yang M H.Saliency detection via absorbing Markov chain.In:Proceedings of the 2013 IEEE International Conference on Computer Vision.Sydney,Australia:IEEE,2013.1665−1672

15 Jiang H Z,Wang J D,Yuan Z J,Wu Y,Zheng N N,Li S P.Salient object detection:a discriminative regional feature integration approach.In:Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition.Portland,OR,USA:IEEE,2013.2083−2090

16 Lu H C,Li X H,Zhang L H,Ruan X,Yang M H.Dense and sparse reconstruction error based saliency descriptor.IEEE Transactions on Image Processing,2016,25(4):1592−1603

17 Borji A,Sihite D N,Itti L.Salient object detection:a benchmark.In:Proceedings of the 12th European Conference on Computer Vision.Berlin,Germany:Springer,2012.414−429

18 Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis.IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254−1259

19 Ma Y F,Zhang H J.Contrast-based image attention analysis by using fuzzy growing.In:Proceedings of the 11th ACM International Conference on Multimedia.Berkeley,USA:ACM,2003.374−381

20 Achanta R,Hemami S,Estrada F,Susstrunk S.Frequencytuned salient region detection.In:Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami Beach,USA:IEEE,2009.1597−1604

21 Rahtu E,Kannala J,Salo M,Heikkil¨a J.Segmenting salient objects from images and videos.In:Proceedings of the 11th European Conference on Computer Vision.Crete,Greece:Springer,2010.366−379

22 Cheng M M,Warrell J,Lin W Y,Zheng S,Vineet V,Crook N.Efficient salient region detection with soft image abstraction.In:Proceedings of the 2013 IEEE International Conference on Computer Vision.Sydney,Australia:IEEE,2013.1529−1536

23 Perazzi F,Kr¨ahenbu¨hl P,Pritch Y,Hornung A.Saliency fi lters:contrast based fi ltering for salient region detection.In:Proceedings of the 2012 IEEE International Conference on Computer Vision and Pattern Recognition.Providence,USA:IEEE,2012.733−740

24 Margolin R,Tal A,Zelnik-Manor L.What makes a patch distinct?In:Proceedings of the 2013 IEEE International Conference on Computer Vision and Pattern Recognition.Sydney,Australia:IEEE,2013.1139−1146

25 Yan Q,Xu L,Shi J P,Jia J Y.Hierarchical saliency detection.In:Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition.Portland,OR,USA:IEEE,2013.1155−1162

26 Shen X H,Wu Y.A uni fi ed approach to salient object detection via low rank matrix recovery.In:Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition.Providence,RI,USA:IEEE,2012.853−860

27 Zhu W J,Liang S,Wei Y C,Sun J.Saliency optimization from robust background detection.In:Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus,OH,USA:IEEE,2014.2814−2821

28 Xi T,Fang Y,Lin W,Zhang Y.Improved salient object detection based on background priors.In:Proceedings of the 2015 Paci fi c Rim Conference on Multimedia.Gwangju,Korea:Springer,2015.411−420

29 Qin Y,Lu H C,Xu Y Q,Wang H.Saliency detection via cellular automata.In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,USA:IEEE,2015.110−119

30 Achanta R,Shaji A,Smith K,Lucchi A,Fua P,S¨usstrunk S.SLIC superpixels compared to state-of-the-art superpixel methods.IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(11):2274−2282

31 Zhang L,Yang C,Lu H,Xiang R,Yang M H.Ranking saliency.IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(9):1892−1904

32 Judd T,Ehinger K,Durand F,Torralba A.Learning to predict where humans look.In:Proceedings of the 12th International Conference on Computer Vision.Kyoto,Japan:IEEE,2009.2106−2113

33 Movahedi V,Elder J H.Design and perceptual validation of performance measures for salient object segmentation.In:Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.San Francisco,CA,USA:IEEE,2010.49−56

34 Alpert S,Galun M,Brandt A,Basri R.Image segmentation by probabilistic bottom-up aggregation and cue integration.IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(2):315−327

35 Zou W B,Kpalma K,Liu Z,Ronsin J.Segmentation driven low-rank matrix recovery for saliency detection.In:Proceedings of the 24th British Machine Vision Conference.Bristol,UK:IEEE,2013.1−13

36 Li G B,Yu Y Z.Visual saliency based on multiscale deep features.In:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,USA:IEEE,2015.5455−5463

37 Zhai Y,Shah M.Visual attention detection in video sequences using spatiotemporal cues.In:Proceedings of the 14th ACM International Conference on Multimedia.New York,USA:ACM,2006.815−824

38 Hou X,Zhang L.Saliency detection:a spectral residual approach.In:Proceedings of the 2007 IEEE Conference on Computer Vision and Pattern Recognition.Minneapolis,Minnesota,USA:IEEE,2007.1−8

39 Goferman S,Zelnik-Manor L,Tal A.Context-aware saliency detection.IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(10):1915−1926

40 Tong N,Lu H C,Zhang Y,Ruan X.Salient object detection via global and local cues.Pattern Recognition,2015,48(10):3258−3267

41 Li H Y,Lu H C,Lin Z,Shen X H,Price B.Inner and inter label propagation:salient object detection in the wild.IEEE Transactions on Image Processing,2015,24(10):3176−3186

42 Xu Wei,Tang Zhen-Min.Exploiting hierarchical prior estimation for salient object detection.Acta Automatica Sinica,2015,41(4):799−812(徐威,唐振民.利用层次先验估计的显著性目标检测.自动化学报,2015,41(4):799−812)

43 Yang Sai,Zhao Chun-Xia,Xu Wei.A novel salient object detection method using bag-of-features.Acta Automatica Sinica,2016,42(8):1259−1273(杨赛,赵春霞,徐威.一种基于词袋模型的新的显著性目标检测方法.自动化学报,2016,42(8):1259−1273)

44 Li H L,Ngan K N.A co-saliency model of image pairs.IEEE Transactions on Image Processing,2011,20(12):3365−3375

猜你喜欢

杂志排行

自动化学报的其它文章

- Convolutional Sparse Coding in Gradient Domain for MRI Reconstruction

- 视频中旋转与尺度不变的人体分割方法

- Bayesian Saliency Detection for RGB-D Images

- Interactive Multi-label Image Segmentation With Multi-layer Tumors Automata

- 双时间尺度下的设备随机退化建模与剩余寿命预测方法

- Robust H∞Consensus Control for High-order Discrete-time Multi-agent Systems With Parameter Uncertainties and External Disturbances