基于回归的指纹方向场估计

2017-02-22戴晓薇赵启军

戴晓薇,赵启军

(四川大学 计算机学院 视觉合成图形图像技术国防重点学科实验室,四川 成都 610065)

基于回归的指纹方向场估计

戴晓薇,赵启军

(四川大学 计算机学院 视觉合成图形图像技术国防重点学科实验室,四川 成都 610065)

指纹方向场对指纹的奇异点检测、特征提取和匹配、分类识别等至关重要。可靠地估计指纹方向场至今为止仍是一个具有挑战性的问题。现有方法一般先估计初始方向场,再对其进行去噪或者正则化处理。受最新的深度学习技术的启发,提出一种基于回归的端到端指纹方向场估计算法。该算法直接建立指纹图像块的纹理特征与其中心位置的脊线方向之间的映射关系。利用总变差模型分解指纹图像,以去除噪音的干扰;将指纹图像分成若干块,并利用深度卷积神经网络学习这些块的纹理特征与其中心位置脊线方向之间的回归函数。为评估文中算法的有效性,使用NIST SD14数据库中的指纹作为训练数据,在FVC2002和FVC2004数据库上进行测试。实验结果表明:与已有的算法相比,该算法不仅简单易操作,而且具备较好的抗噪能力,可以准确地估计出奇异点及其周围的方向场,能够有效提高指纹识别率。

指纹方向场;卷积神经网络;回归;总变差模型

0 引 言

随着身份识别的电子化和移动化,传统的身份表示(如密码、卡等)已经不足以确认其真实身份。卡可能会丢失或者被盗取,密码在大多数情况下也可以被猜测到,两者均不具备不可复制性。生物特征识别是指利用个体独特的生理特征(比如指纹、人脸、虹膜等)和独特的行为特征(比如语音等)进行个体身份的自动识别[1-2]。这些生物特征由于在身份识别上具有唯一性和不可复制性等优势,近年来受到广泛的研究和关注。

自动指纹识别[1-2]作为一种重要的生物特征识别技术,因其易获取、可操作性强、成本低和可靠性强等优点,在司法、政府、商业、金融等各个领域得到了越来越广泛的应用。自动指纹识别系统[1](Automated Fingerprint Identification Systems,AFISs)一般包括:指纹获取、图像增强、特征提取和匹配等多个部分。指纹方向场是指纹的一种基础特征,描述了脊线和谷线的方向信息,可用于图像增强、指纹匹配等,对后续的识别至关重要。因此,正确地估计方向场是指纹自动识别系统中最重要的环节之一。

研究人员已经提出了大量的指纹方向场估计方法。这些方法主要可以分成以下4类:基于梯度的方法[1]、基于模型的方法[3-6]、基于字典的方法[7-9]和基于学习的方法[10]。

基于梯度的方法通常是在图像上进行差分运算,所以对图像质量很敏感。因为指尖表面会有污垢、潮湿、折皱和伤痕等,所以采集到的指纹图像会产生噪声,该方法就会随着指纹图像质量的退化而变得困难。

基于模型的方法主要是考虑指纹方向场的全局约束条件对方向场进行数学建模。Sherlock等[3]提出零极模型,该模型基于奇异点(也就是core点和delta点)的位置对指纹方向场进行建模。可是,当指纹没有奇异点或者不能准确地检测奇异点时,该方法就会失效。Zhou等[4]提出联合模型,该方法集成了多项式模型和点变化模型来重构方向场。多项式用于描述全局方向场,点变化模型则用于细化奇异点周围的方向场。Li等[5]使用高阶相位模型建模方向场。首先,将指纹图像划分为几个不同的区域。然后,在不同的区域使用分段线性相位重构方向场。上述这些模型存在着一个共同的限制:为了细化模型算子,要求提供奇异点。但是,从含有噪声的指纹图像中可靠地检测奇异点本身就是一项困难的工作。更重要的是,现有的奇异点检测算法绝大部分是基于方向场的。Wang等[6]提出了基于三角多项式的方向场模型(FOMFE),该模型不需要提供奇异点。在奇异点周围,阶数越高越准确。然而,如果阶数设置太高,图像噪声也会引起FOMFE产生不合理的估计。

相比较基于模型的方法,基于字典的方法具有更好的泛化能力。首先,使用传统的方法估计初始方向场。接着,利用字典对初始方向场进行纠正。然而,这类方法的性能依赖于大规模多样化的字典,往往计算代价较高。

Cao等[10]提出基于学习的方法,训练卷积神经网络作为分类模型,预测方向场的类别。因为方向场的类别是通过聚类得到的,所以,在高曲率区域的方向场并不能准确估计。

上述方法有一个共同点就是:首先估计指纹初始方向场,然后再对初始方向场进行正则细化(或去噪)。常用的估计方法有梯度方法[1]和傅里叶分析[11]等,这些初始估计方法对图像质量很敏感,而后续处理的效果又很大程度上依赖于初始估计的准确性。考虑到这些问题,文中尝试在指纹图像到方向场之间建立端到端的回归关系,不受估计初始方向场的约束。

1 基于回归的指纹方向场估计

1.1 算法概述

卷积神经网络可以直接从输入图像学习到各种不同的特征。近年来,卷积神经网络在处理各类问题上均表现出了优越的性能[12-13]。受到这些启发,选用卷积神经网络作为回归函数。在这个回归函数中,自变量是图像patch,而非整张图像。原因是:

(1)通常指纹方向场的分辨率都以块(block)为单位;

(2)考虑更多的上下文信息,可以更准确有效地估计方向场;

(3)对于给定的网络结构,能接收的输入图像大小是固定的,不同的指纹图像其大小可能不同,而把图像划分成大小固定的patch,逐patch估计其方向场则可以避免这个问题。

该回归函数的因变量是(sin2θ,cos2θ),其中θ表示patch中心位置的方向值。

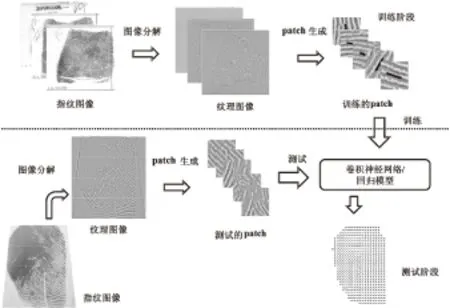

卷积神经网络作为回归函数,很明显该算法由两部分组成,即训练阶段和测试阶段,如图1所示。训练阶段的主要任务是通过训练样本对模型进行训练,以得到可用于方向场估计的回归模型。测试阶段则是利用已有的模型,对指纹图像进行方向场估计。

图1 算法流程图

训练阶段:首先,应用总变差模型(TotalVariation,TV)[14-15]对数据集中的指纹图像进行预处理(即卡通纹理分解)。因为卡通图像包含了大部分不相关的内容和结构噪声,所以,选择纹理图像用于后续步骤。接着,纹理图像按预定的大小划分patch。最后,将这些划分好的patch以及对应的方向值作为回归模型的输入和监督信息,进行训练。

测试阶段:对待测试的数据与训练数据做同样的预处理,不同的是其方向值未知,也就是需要通过回归模型解得。首先,对待估计的指纹图像进行卡通纹理分解;接着,对生成的纹理图像划分patch,并将这些patch输入到已训练好的回归模型估计其方向场。

1.2 总变差模型

对于给定的图像函数y,可以分解成y=u+v形式。其中,u表示分段光滑的卡通图像;v表示振动的纹理图像。通常来说,该图像分解通过极小化总变差得到[14-15]:

min{TV(u)|‖u-y‖B≤ε}

(1)

其中,TV(u)表示u的总变差;‖·‖B是范数,保真项‖u-y‖B使得u尽可能接近原图像y。

在指纹图像中,指纹图案是由脊线和谷线交错组成,符合纹理图像v的振动特性。非指纹成分通常含有平滑的内表面,这些特性与卡通图像u相似。原始图像以及其对应的纹理和卡通图像如图2所示。

图2 指纹图像

可以观察到:卡通图像含有大量的背景噪声,指纹的谷脊线信息大部分被包含在纹理图像中,所以使用纹理图像进行后续的工作,而把卡通图像丢弃。

1.3 构建回归模型

待估计方向场的纹理图像按大小np×np像素(pixel)、非重叠地进行分块(block)。假设纹理patch的大小是nb×nb块(block),估计该patch的中心块(centerblock)的方向。文中用卷积神经网络(ConvolutionalNeutralNetwork)作为回归函数。该函数的输入是方向场待估计的纹理patch,输出是(sin2θR,cos2θR)。其中,θR表示估计的方向值。为了避免0↔π之间的不连续性,在实际的指纹方向场表示通常采用二倍角2θ的形式[16]。

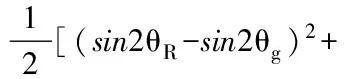

训练卷积神经网络需要的输入是纹理patch和(sin2θg,cos2θg),θg表示真实的方向值,(sin2θg,cos2θg)是回归目标值。训练网络采用的损失函数是估计值(sin2θR,cos2θR)和(sin2θg,cos2θg)目标值之间的距离,如式(2):

(2)

1.4 卷积神经网络结构

文中回归模型采用的卷积神经网络结构如图3所示。

图3 卷积神经网络的结构

图中,大小为56×56像素的纹理patch作为卷积神经网络的输入,第一个卷积层(Convolutionallayer,C1)有96个大小为11×11的卷积核,卷积步长为2。激活函数采用ReLU函数(f(x)=max(0,x)),该函数已经被证明在模拟神经元输出时,比Sigmoid函数有更好的拟合效果[17]。除了最后的全连接层(Fully-connectedlayer,F)外,每个卷积层后都接有ReLU函数。

第一个卷积层产生96个特征谱(大小23×23)分别进入池化层(pooling)。常用的池化操作有平均池化和最大池化,文中采用最大池化(Max-poolinglayer,M1)。把每一个特征谱分割成不重叠的区域,每一个子区域(3×3矩形区域)都输出最大值,池化的步长为2。C2、M2和C3由此类推。该网络结构是在MatConvNet工具箱上实现的。

1.5 方向场估计

给定一张指纹灰度图像。首先,对其按1.2描述的方法进行预处理;然后,通过回归模型(已训练的卷积神经网络)逐patch地估计其中心块的方向场;最后,将这些估计的方向场结合起来,就是这张指纹图像对应的方向场。由网络输出的结果计算方向场,公式如下:

(3)

2 实验设计与分析

2.1 训练数据

文中回归模型的训练样本来自NIST(National Institute of Standard and Technology) Special Database 14,简称NIST SD14。NIST SD14是由滚动指纹图像组成的数据库,该库中的图像是800×768像素的灰度图像。从NISTSD14中取前1 000张指纹图像(即F0000001~F0001000),对每张图像进行如下处理:

(1)使用TV模型[14-15]对指纹图像进行卡通纹理分解,得到纹理图像。

(2)纹理图像分块:大小为np×np像素,非重叠的分块。

(3)以块为单位,对纹理图像划分patch:大小为nb×nb块,步长为1块,重叠地划分纹理patch(即patch的大小(nb×np)×(nb×np)像素,np=8)。

由此产生约2 000 000纹理patch用于卷积神经网络的训练。

2.2 评估标准

FAR(False Acceptance Rate,错误接受率)和FRR(False Rejection Rate,错误拒绝率)是用来评估生物特征识别算法性能的主要参数。FAR是由于输入的生物特征与数据库中已注册的模板错误地匹配,把非授权人错误授权的概率。FAR通常用百分比表示,描述的是无效输入被接收的概率。FRR是由于输入的生物特征与数据库中已注册的模板匹配失败,把授权人错误拒绝的概率。FRR通常也用百分比表示,描述的是有效输入被拒绝的概率。一个生物特征识别系统应该具有较低的FAR和FRR,但这两者呈反比关系。因此,系统研发者通常要对它们进行平衡。

2.3 评估与分析

文中算法分别在数据库FVC2002 DB1、FVC2002 DB2、FVC2004 DB1和FVC2004 DB2四个数据库上进行测试。每个数据库均含有a、b两个子库,a库有100个不同ID的手指,每个手指注册有8张指纹图像,所以a库有8×100=800张指纹图像;b库有10个不同ID的手指,每个手指也注册有8张指纹图像,故有8×10=80张指纹图像。

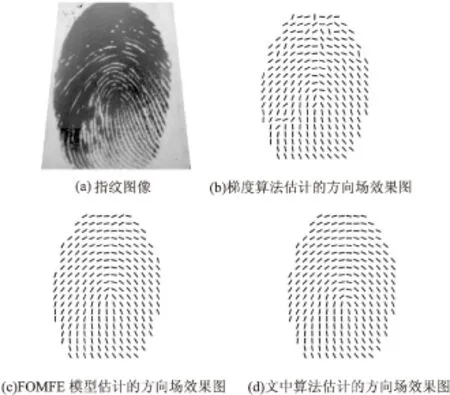

由于指纹本身和采集等原因,得到的指纹图像不可避免地存在或多或少的噪声,如图4(a)。梯度方法[1]对噪声较为敏感,在缺乏纹理信息的黑色粘连区域,估计出的方向场错乱无章,如图4(b)所示。而FOMFE[6]模型和文中算法仍可以估计出粘连区域的方向场(见图4(c)、(d))。FOMFE模型想要准确地估计高曲率区域(特别是,奇异点周围)的方向场需要设置较高的阶数,但高阶数也会带来其他区域的错误估计。因此,恰当的参数设置就变得很关键。文中算法则不存在类似的问题,即使在奇异点及其周围也可以准确地估计出方向值。如图5所示,在奇异点及其周围,FOMFE模型存在明显的偏差。

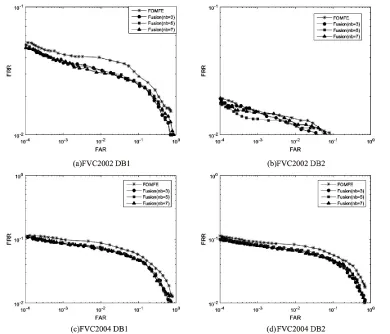

文中从两个方面进行评估:一方面是考虑patch大小对文中算法的影响(nb取值分别为3、5和7),由于不同大小的patch作为卷积神经网络的输入,网络的结构会有微小的差别,大体的网络结构如图3所示。另一方面,比较仅使用FOMFE和匹配分数融合(文中算法与FOMFE模型各自处理得到的两组匹配分数进行融合)这两种策略对识别性能的影响。

图4 实验对比(1)

图5 实验对比(2)

评估实验的步骤为:

(1)估计指纹图像的方向场。

(2)根据已估计出的方向场,使用Gabor滤波器[18]对指纹图像进行增强。

(3)使用现有的指纹识别商业软件VeriFingerSDK6.6为基准,评估增强后的指纹图像的识别率,从而反映出指纹方向场估计的准确程度。利用ROC(ReceiverOperatingCharacteristic)曲线[19]描述算法的性能。

如图6所示,FOMFE在四个数据库上的FAR和FRR值均大于匹配分数融合得到的结果。由此可见,文中算法有效地提高了自动指纹识别系统的识别率,且不同的patch大小对于算法性能没有明显的影响。

3 结束语

文中提出一种基于卷积神经网络的回归模型用于指纹方向场的估计。相比于传统的梯度算法和FOMFE模型,该算法可以更好地估计指纹的方向场,表明了回归模型在指纹方向场估计方面的可行性。下一步的工作可以模拟指纹图像中常见的噪声,并把这些噪声叠加在训练样本上,提高模型的泛化能力。

图6 ROC曲线

[1]MaltoniD,MaioD,JainA,etal.Handbookoffingerprintrecognition[M].[s.l.]:SpringerScience&BusinessMedia,2009.

[2] 王蕴红,谭铁牛.现代身份鉴别新技术—生物特征识别技术[J].中国基础科学,2000(9):4-10.

[3]SherlockBG,MonroDM.Amodelforinterpretingfingerprinttopology[J].PatternRecognition,1993,26(7):1047-1055.

[4]GuJ,ZhouJ,ZhangD.Acombinationmodelfororientationfieldoffingerprints[J].PatternRecognition,2004,37(3):543-553.

[5]LiJ,YauWY,WangH.Constrainednonlinearmodelsoffingerprintorientationswithprediction[J].PatternRecognition,2006,39(1):102-114.

[6]WangY,HuJ,PhillipsD.Afingerprintorientationmodelba-sedon2DFourierexpansion(FOMFE)anditsapplicationtosingular-pointdetectionandfingerprintindexing[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2007,29(4):573-585.

[7]FengJ,ZhouJ,JainAK.Orientationfieldestimationforlatentfingerprintenhancement[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2013,35(4):925-940.

[8]YangX,FengJ,ZhouJ.Localizeddictionariesbasedorientationfieldestimationforlatentfingerprints[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2014,36(5):955-969.

[9]CaoK,LiuE,JainAK.Segmentationandenhancementoflatentfingerprints:acoarsetofineridgestructuredictionary[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2014,36(9):1847-1859.

[10]CaoK,JainAK.Latentorientationfieldestimationviaconvolutionalneuralnetwork[C]//Internationalconferenceonbiometrics.[s.l.]:IEEE,2015:349-356.

[11]ChikkerurS,CartwrightAN,GovindarajuV.FingerprintenhancementusingSTFTanalysis[J].PatternRecognition,2007,40(1):198-211.

[12]KrizhevskyA,SutskeverI,HintonGE.Imagenetclassificationwithdeepconvolutionalneuralnetworks[C]//Advancesinneuralinformationprocessingsystems.[s.l.]:[s.n.],2012:1097-1105.

[13]SunY,ChenY,WangX,etal.Deeplearningfacerepresentationbyjointidentification-verification[C]//Advancesinneuralinformationprocessingsystems.[s.l.]:[s.n.],2014:1988-1996.

[14] 王际朝.一种组合总变差和4阶偏微分方程的图像去噪模型[J].中国图象图形学报,2008,13(8):1443-1446.

[15]ChambolleA.Analgorithmfortotalvariationminimizationandapplications[J].JournalofMathematicalImagingandVision,2004,20(1-2):89-97.

[16]ZhangN,ZangY,YangX,etal.Adaptiveorientationmodelfittingforlatentoverlappedfingerprintsseparation[J].IEEETransactionsonInformationForensicsandSecurity,2014,9(10):1547-1556.

[17]DahlGE,SainathTN,HintonGE.ImprovingdeepneuralnetworksforLVCSRusingrectifiedlinearunitsanddropout[C]//IEEEinternationalconferenceonacoustics,speechandsignalprocessing.[s.l.]:IEEE,2013:8609-8613.

[18]HongL,WanY,JainA.Fingerprintimageenhancement:algorithmandperformanceevaluation[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,1998,20(8):777-789.

[19]RossA,JainA.Informationfusioninbiometrics[J].PatternRecognitionLetters,2003,24(13):2115-2125.

Fingerprint Orientation Field Estimation Based on Regression

DAI Xiao-wei,ZHAO Qi-jun

(National Key Laboratory of Fundamental Science on Synthetic Vision,School of Computer Science, Sichuan University,Chengdu 610065,China)

Fingerprint orientation filed is crucial for fingerprint singularity detection,feature extraction and matching,classification and recognition,etc..Many methods have been proposed for estimating fingerprint orientation field,mostly in two steps:estimation and regularization (or de-noising).Yet,motivated by emerging deep learning techniques,a regression-based end-to-end fingerprint orientation field estimation method is proposed.It directly estimates the ridge orientation at the center of a fingerprint image patch through a regression function from the texture feature of the image patch.Given a fingerprint image,the total variation model is applied to decompose it into cartoon and texture components.Then the texture component is divided into patches,using a Deep Convolutional Neural Network (DCNN) to estimate the ridge orientation at the center of each patch.The fingerprint images in NIST SD14 are adopted as training data to learn the DCNN-based regression function,and evaluate the proposed method on the FVC2002 and FVC2004 databases.The experimental results indicate that compared with the existing algorithms,the algorithm is simple and easy to operate,and has better anti-noise ability,which can accurately estimate the orientation field of singular point and its surroundings,and effectively raise the fingerprint recognition rate.

fingerprint orientation field;convolutional neural network;regression;total variation model

2016-03-25

2016-06-29

时间:2017-01-04

国家自然科学基金资助项目(61202161)

戴晓薇(1991-),女,硕士研究生,研究方向为图像处理与合成;赵启军,副教授,硕士生导师,研究方向为生物特征识别、视频监控与分析等。

http://www.cnki.net/kcms/detail/61.1450.TP.20170104.1039.064.html

TP301

A

1673-629X(2017)01-0001-05

10.3969/j.issn.1673-629X.2017.01.001