虚拟现实及触觉交互技术:趋势与瓶颈

2017-02-14帅立国

帅立国

【摘要】虚拟现实是当前的前沿和热点。本文阐述了虚拟现实的概念、发展历程、虚拟现实系统及部分关键技术,并对虚拟现实、增强现实、介导现实和混合现实等概念的内涵进行了溯源和诠释。虚拟现实在内涵上既有交集又各有特异性,难以简单地用包含或被包含关系去进行描述。触觉技术对于虚拟现实系统的交互性具有重要价值,在阐述虚拟现实系统的基础上,论文进一步介绍了触觉交互涉及的触觉传感和触觉显示技术及相关产品。论文最后讨论了制约虚拟现实发展的一些关键技术瓶颈。

【关键词】虚拟现实 触觉交互 增强现实 介导现实 混合现实

【中图分类号】 TP24 【文献标识码】A

【DOI】10.16619/j.cnki.rmltxsqy.2016.24.005

虚拟现实是以视觉表达为主体的一种艺术表现形式。视觉艺术在人类历史进程中发挥着重要的作用,古老的壁画、西汉的皮影,以及近现代的影视艺术等,无一不是社会历史阶段经济生活及科技水平的写照,承载着人类文明的精华。艺术源于生活而高于生活,它们既记录了社会生活的方方面面,也寄托了人们对美好生活和未来的憧憬,既可以生动地展现故事情节,又能够为人们带来视觉观感的享受。虚拟现实是一种可以让人们体验虚拟空间并与之交互的三维环境模拟系统,是视觉表达最为完美的艺术表现形式,具有很强的沉浸感,可以带来梦幻般的多感官体验。

什么是虚拟现实

虚拟现实对应的英文关键词是virtual reality,意指虚拟的现实,可以理解为计算机再现的“现实”。虚拟现实有两层含义,第一它是“现实”,是真实的;第二它是虚拟的,既可以是假的“现实”,可以是数字化的“现实”,也可以是计算机构造的“现实”,这个假的“现实”所依赖的平台是一个由计算机模拟生成的三维的虚拟空间,这个空间可以提供视觉、听觉、触觉、味觉及嗅觉等感官的全方位的模拟,可以让使用者如同置身于一个完全真实的三维环境中,可以及时、无限制地观察三维空间内的事物。

多感知性、沉浸性、交互性和构想性被认为是虚拟现实最为显著的几个典型特征。所谓多感知性是指置身虚拟现实环境中的主体除可以通过视觉观察三维空间外,至少还应该能够通过听觉、触觉、味觉或嗅觉中的一种或几种感知三维空间中的事物,并与之交互。理想的虚拟现实应该具备人类所具有的一切感知功能,但受技术限制,目前虚拟现实能够提供的感知功能极为有限。通常情况下,虚拟现实系统都会提供视觉和听觉感知,而其他感觉功能则相对少见。随着触觉显示技术的进步,近年来已出现为虚拟现实系统提供触觉感知功能的触觉手套和力反馈装置,预计未来的3~5年内,触觉功能很可能会和视觉和听觉功能一样成为虚拟现实系统的基本配置。嗅觉和味觉的技术发展相对滞后,由于涉及到人体感官的化学反应,且主要为气体和液体刺激,嗅觉和味觉技术突破的难度较大,除个别特例外,难以被广泛应用。

沉浸性又称为临场感,强调用户体验的真实性,置身于虚拟现实环境中的主体,所感所知应和现实世界中的体验近乎一致,难以分辨真假,虚拟环境中的事物不仅视觉真实,听觉和触觉也是真实的,甚至嗅觉和味觉的体验也和现实世界一致。

交互性强调虚拟环境中事物的可操作性,以及操作过程中交互的实时性和自然程度。例如,用户用手直接抓取模拟环境中的虚拟物体时,手应有触碰到物体的感觉,进一步地,当用户抓住虚拟物体后,应能够感觉到物体的重量,被抓的物体还能够随着手的移动而移动。

构想性强调虚拟现实应具有广阔的可想像空间,可拓宽人类的认知范围,不仅可再现真实存在的环境,也可以随意构想客观不存在的对象甚至是不可能发生的环境。

以上是虚拟现实比较典型的几个特征,随着AR和MR的到来,虚拟现实的特征可能会有所调整和扩展。虚拟现实是融合了视觉、听觉、触觉、嗅觉、味觉等诸多感官的输入和输出的可交互系统,将能够带给人们全真的身临其境的感觉。

虚拟现实简史

虚拟现实是一个逐渐形成的概念,其技术方法由远及近是一个不断进步、并在内涵上不断调整和丰富的过程。人类的社会活动中很早就出现了虚拟现实的萌芽。始于十九世纪的全景壁画应该是最早的虚拟现实,它可以覆盖观众的全部视野,使其感到正在亲临某个历史事件或者场景。1838年,Charles Wheatstone发现人类大脑对三维对象的感知是通过两只眼睛获取的两个二维图像合成得到的,进一步的研究表明,通过发明的体视镜观看两个并排的图片,可以让大脑获得关于图片对象的深度感和沉浸感。该方法沿用至今,是谷歌纸盒和当前低成本虚拟现实头戴式显示器的技术基础。

1929年,Edward Link发明了可能是最早商业化的飞行模拟器“Link教练机”(专利1931)。上世纪30年代,科幻作家Stanley G.Weinbaum出版了第一本探讨虚拟现实的科幻小说“Pygmalion的眼镜”。1956年,摄影师Morton Heilig发明了包含全部感官刺激的街机剧院Sensorama(专利1962),该街机包含3D显示器、立体扬声器、振动椅、气味发生器和风扇。除街机剧院外,1960年,Morton Heilig还发明了称为Telesphere Mask(专利1960)的头部显示器,这是最早的头盔显示器(HMD),虽然当时尚无运动跟踪,但该头盔集合了视觉、声音、动作和气味等多种感知技术。

1961年,Philco公司的科莫和布莱恩开发了首个带有运动跟踪的HMD原型样机。该样机整合了一个磁运动跟踪系统,并为每只眼睛配置了连接到闭路摄像机的视频显示器。1965年,Ivan Sutherland首次提出了“终极显示”的概念,即通过技术手段模拟真假难辨的“现实”。“终极显示”基于一个包括运动追踪、触觉反馈、语音识别,甚至全息技术的头戴式显示器,并利用计算机技术构造了实时的虚拟世界,籍此实现用户与虚拟世界中的物体的交互。Ivan Sutherland认为计算机屏幕并不只是显示信息的方式,而是一个通向虚拟世界的窗口,最终可实现在视觉、听觉、触觉以及移动和交互方面的真实感觉。

1966年,GAF三维魔景机Viewmaster问世,其内置的立体镜可将同一场景的两个具有视差的图像合成为一个三维图像。

1968年,Ivan Sutherland和他的学生Bob Sproull创造了第一个与电脑(不是摄像机)相连的头戴显示器Sword of Damocles(达摩克利斯之剑),该发明具有里程碑意义,是人类历史上首个计算机图形驱动系统。

1969年,艺术家Myron Kruegere创作了一系列称为“人工现实”的互动艺术作品。他的研究工作最终导致了VIDEO PLACE的发展,该技术可以使相隔几英里远的人们体验到计算机生成的环境并相互交流。

1980年,可穿戴设备之父Steve Mann,发明了一个笨拙的可与头盔相连的背包式计算机Eye Tap,它利用分束器将场景同时发送给用户以及与计算机相连的摄像头,从而实现数据的实时融合。Steve Mann后来对Eye Tap进行了改进,实现了小型化。

1984,Jaron Lanier的公司设计了RB2第一个商业化VR控制系统,配有数据手套,允许用户对在头盔中显示的虚拟对象进行“twist and turn”操作,但整个系统的费用高达50000美元或更多。

1987年,可视化编程实验室(VPL)的创始人Jaron Lanier创造了“虚拟现实”术语。VPL公司是第一家售卖虚拟现实眼镜的公司,先后开发了数据手套和EyePhone头显等一系列虚拟现实装置。

1991年,虚拟世界组织发行了一系列游戏和机器。游戏者穿戴虚拟现实眼镜后可以身临其境地在游戏机的3D环境中游戏,系统迟滞少于50毫秒,并可通过网络将多个单元联接在一起实现多人游戏。

1992年,第一部建立在虚拟空间的影片The Lawnmower Man(割草者)问世,该影片实现了虚拟现实概念的普及。电影中使用了VPL研究实验室的虚拟现实设备。

1993年,Sega在消费电子展上发布了全景眼镜及四款游戏。全景眼镜为环绕式,帽舌部位配置了液晶显示屏并具有头部跟踪和立体声。市场反应平静,由于体验过于真实,游戏玩家可能伤害自己,该项目最终被封存。

1999年,Wachowski siblings的电影黑客帝国(The Matrix)热映,带来了很强的文化冲击,使得模拟现实成为焦点。

2009年,Kickstarter众筹网站平台推出,Oculus VR创始人Palmer Luckey成功地通过该平台从10000名支持者那里筹集了近250万美元,成为典型的众筹成功故事之一。Oculus Rift具有两个目镜,并具有陀螺仪控制的视角,游戏沉浸感大幅提升,Oculus Rift可以通过DVI、HDMI、micro USB接口连接电脑或游戏机,并推出了配套的开发工具包。

近年来,通信技术的进步极大地改善了网络条件,也引发了移动互联设备(MID,Mobile Internet Device)特别是手机终端的极度繁荣,作为MID终端的高端手机基本具备了展示虚拟现实场景的硬件条件和软件能力。2013年,以Oculus Rift为代表,基于手机平台的虚拟头戴式显示器开始风靡全球,而Google则更是推出了基于个人手机的Card Board纸盒版VR眼镜,为VR普及做出了重大贡献。目前,虚拟现实已经深入人心,各类VR发明正如雨后春笋般地被创造出来,相关公司和产品也正以燎原之势在全国各地兴起。

虚拟现实类别(VR、AR、MR)

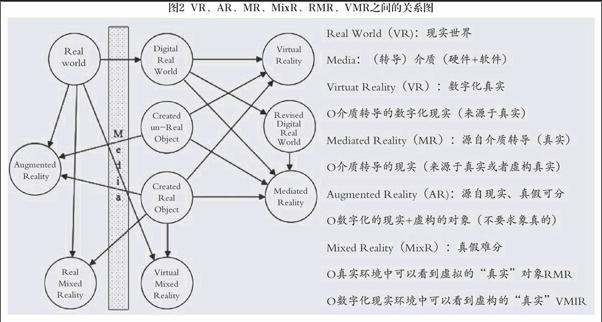

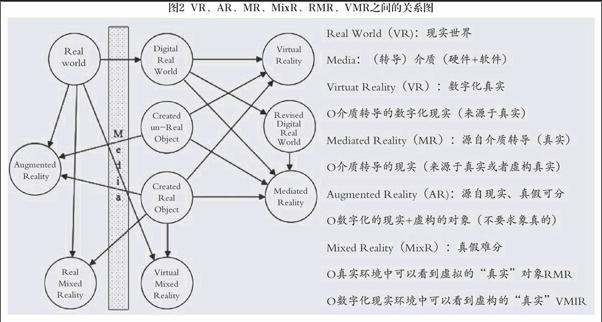

从发展历程来看,虚拟现实先后经历了数字化现实到增强现实再到混合现实三个重要阶段。这三个阶段相互交错,发展进程中涉及到的概念主要包括Virtual Reality(VR,狭义的“虚拟现实”),Augmented Reality(AR,增强现实),Mediated Reality(MR,介导现实)和Mixed Reality(MixR,混合现实)等。1994年,计算机图形学之父Steve Mann在“Mediated Reality”①文章中首次提出了“Mediated Reality-MR”概念,并以图示方式对VR,AR和MR的内涵和相互关系进行了描述,如图1所示。

图1中,user前方的弧形是an ideal light space glass,它是一个能够感知光信号并据此转导发射光线的眼镜,比如由摄像头和显示器组合而成的眼镜等,可以实时地获取光学影像,并将其通过摄像头呈现给user,某种意义上,人们佩戴的近视眼镜也可以算是ideal light space glass。这里,ideal light space glass充当着将real objects显示给user的媒介(介质),其作用相当于影像转导。图1中,现实世界中的real objects有三种方式被user“看”到,左侧Virtual Reality图中,ideal light space glass将real objects直接成像并呈现给user;右侧Mediated Reality图中,ideal light space glass并没有将real objects直接成像呈现给user,而是在获取real objects影像并经过一定的处理后再呈现给user(图中为左右翻转处理);中间Augment Reality图中,user同时看到了两幅影像,一个是直接来自real objects的影像,另一个是来自ideal light space glass的影像,这时,ideal light space glass不仅要能够呈现影像给user,还应该具备让user穿透并看到real objects的能力,典型的案例如运用在航空器上充当飞行辅助仪器的挡风玻璃(up-head displayer抬头/平视显示器),飞行员透过玻璃观察舱外景物时,可以同时看到叠加在外景上的字符、图像等信息。投射焦距位于玻璃前方,飞行员几乎不用调整焦距即可随时察看飞行参数。

由Steve Mann的描述可以看出,VR和MR都是介质转导的影像,不同之处在于,VR中间介质对影像不做处理,所显示的“现实”是real objects的再现,不过随着计算机技术的发展,目前VR中的“现实”也可以是计算机构造的现实,但无论哪种方式,其“现实”必须具有高度的真实性;MR中,中间介质所转导的“现实”可以是real objects的再现,也可以不是,但应该包含real objects的部分或全部要素,是基于real objects的“现实”,由此可见,早期出现的VR实际上只是MR的一个特例。而AR则是既有介质转导的影像,又有实际real objects的影像,是两者的叠加。AR最早于1993年提出②,其技术方法是在所采集的真实世界的三维影像的基础上,通过图像技术在三维空间中叠加(去除)虚拟对象或者虚拟环境,从而营造一种特别的视觉效果,2016年7月推出的PokeMon Go游戏就因其有趣的风格和独特的视觉效果而迅速风靡全球。AR是真实世界和虚拟世界的集成,并具有较好的交互性,可广泛应用于教育、影视、娱乐等领域。

除Steve Mann所描述的VR、AR和MR外,近年来还出现了一种混合现实(Mixed Reality)的虚拟现实概念,由于Mediated Reality被称为MR,为避免歧义,Mixed Reality可称为MixR。混合现实是虚拟空间和真实空间的完美融合,亦虚亦实,亦幻亦真。

混合现实是同时包含真实世界和虚拟世界中的对象或环境的现实,是真假难分的虚拟“现实”,包括将虚拟对象投射到真实环境当中的混合现实RMR(Real MixR),以及将真实对象或环境数字化后与虚拟对象或环境融合形成的数字化混合现实VMR(Virtual MR)。RMR模式中,“虚拟”真实地“存在”着,可以营造一种真实的“虚幻”,MixR所依赖的不是依附于人眼的3D眼镜和头戴式显示器等装备,而是环境投射设备,代表了虚拟现实的最高水平,是虚拟现实发展的最高境界。

图2以图例的方式表示出了虚拟现实相关概念之间的相互关系。

虚拟现实的相关概念在内涵上存在一定的差异,他们之间很难简单地用包含的方法去描述。简单地说,MR强调所看到的是介质转导的影像,VR中所看到的是逼真的假象,AR有真有假,但可以分清真假,而MixR中有真有假,但真假难辨。

虚拟现实系统

一个完整的虚拟现实系统主要包括软件、硬件平台、传感输入、显示输出等几个部分。其中,软件和硬件平台是虚拟现实系统的核心和控制中枢,它能够把视觉、听觉、触觉、味觉、嗅觉所涉及的输入输出数据和控制指令等整合在一起构成一个有机的整体,实时地响应来自操作者的外部输入,并控制外设及时地调整输出以作用于操作者的感官,进而实现完美的人际交互。其系统架构如图3所示。

图中,用于感知现实世界中的对象和环境的传感器主要包括视觉、听觉、触觉、嗅觉和味觉传感器,和用于环境监测和虚拟交互的传感器如温度、湿度传感器以及位置传感器等,相应地,在虚拟环境中,也存在和五官相对应的各种类型的显示器如视觉显示器、听觉显示器、触觉显示器、味觉显示器和嗅觉显示器,用于环境调节的温度调节器、湿度调节器以及其他各类控制器等。操作者沉浸于虚拟视觉的故事情节中时,可能会存在位置移动、姿态改变、动作抓取等行为,这些动作发生后,会影响现实中相应传感器的输出,系统监测到传感器信号的改变后,将实时地调整输出控制信号,以使得操作者所感知的影像、声音、力感、味觉和嗅觉等随之调整和改变,如此往复,直至操作者完成或中止虚拟空间的体验。

常用的与视觉输入相关的传感器主要包括影像、数据和控制三类,其中,影像类的传感器主要为用于3D拍摄的图像传感器,数据类的传感器为用于几何体建模的3D扫描器(包括机械、光学和激光),控制类的传感器包括用于获取绝对坐标的位置跟踪器和用于获取相对坐标的数据手套,指令类的传感器主要包括形态识别作为控制指令的动作捕捉系统,眼球动作作为控制指令的眼动仪。

听觉输入的传感器主要为立体声话筒和麦克风等,目的在于采集声音数据,并确定音源的空间位置信息。

触觉输入的传感器主要为用于接触觉判断的视觉传感器、接触传感器和滑觉传感器等,以及用于运动交互时能够给出力的大小和方向等矢量信息的力觉传感器。

味觉输入相关的传感器主要为化学传感器,味觉输入也可以通过目标识别,再由专家系统生成与目标几何形态对应的味觉地图的方式实现。

嗅觉输入相关的传感器主要为化学传感器,当气味源头的空间位置信息以及散发气味的物体明确时,气味相关的嗅觉输入也可由专家系统给出,当气味源头不明时,嗅觉输入只能通过分布式气体传感器采集。

在输出方面,视觉影像的输出主要包括穿戴类的3D眼镜和数字头盔显示器,以及可裸眼观看的立体显示器和立体投影机等。特别要说的是,虚拟现实系统的输出在特定的应用中也可通过3D打印机以实物的形式输出。

触觉显示方面,其输出方式主要包括以触感输出为特征的触觉手套及相关的接触觉显示器,以力感和运动觉输出为特征的力反馈装置,如Delta和Phantom等,这方面可市售的产品较多,但价格大多非常昂贵。

听觉显示相关的设备主要为各类声音输出装置,如音箱和立体声耳机等。人耳对声音的感知是一个非常复杂的过程,不仅涉及到耳蜗,还涉及外耳、耳骨和耳毛等。头显的耳机通常是把声波直接传送至中耳,其音源3D重现的技术难度较大。

味觉相关的输出设备为与虚拟物体对应的“味觉变形体”,能够动态调整其几何形态使其与虚拟物体一致,并能够对各位置处的酸甜苦辣咸等味觉特征进行调整和改变。

嗅觉相关的输出设备为分布式气味发生器。味觉和嗅觉输出设备是全真虚拟现实系统技术实现的难点,目前尚无成熟的技术方案。

除分离式输入输出方式外,虚拟现实应用中还存在一些融合了输入、输出和控制系统及软件的一体机,如Smart眼镜、立体视频眼镜和3D手机等,实际上,普通的近视眼镜也可以看作是一个输入输出设备,只是普通眼镜中并无控制系统和软件。

完美的虚拟现实系统只有软硬件系统平台是不够的,在应用层面,当前领域内面临的最大困难可能在内容方面,再好的设备,如果没有精彩的故事情节去演绎和诠释,只是一个毫无生气的冰冷的装置。美好的故事可以赋予虚拟现实系统以灵魂,这方面有赖文学作家和影视创作者的关注和介入。

头显vs裸眼

人类的两只眼睛位于面部不同位置,两只眼睛所看到的画面是不同的,这导致了“平行视差”③的产生,这两个具有“平行视差”的画面经大脑解析后可以形成具有三维感的立体空间。

虚拟现实中,为了让人眼能看到虚拟的三维空间,人们需要通过技术手段使得两只眼睛所观看到的影像也具有一定的“平行视差”才行,这样的技术手段主要为3D眼镜和3D头盔显示器及裸眼3D显示技术。

现有的3D眼镜主要用于观看显示器所播放的3D影像,其类型主要包括色差式3D、青红色3D、偏光式3D、快门式3D、不闪式3D等,头戴式3D显示器与3D眼镜的不同在于它将眼镜和显示器集成为一个整体,并配置有空间跟踪定位器以及时调整视场输出从而营造具有真实立体感的虚拟空间,沉浸感极强。头戴式3D显示器由于封装在较小的空间中,所以多采用左右眼视场分离的左右格式显示方法,如Oculus rift、Gear VR、3Glasses、HMZ-T、HTC Vive、暴风魔镜等,除左右格式显示方法外,近年来还发展了一种视网膜投影技术,该技术主要包括两种方式,一是将影像直接投射到视网膜上,二是将光线投射到视网膜上,并通过扫描方式形成影像,代表性产品主要包括Magic Leap、Glyph、Brother等;此外,微软2015年还推出了基于全息方法的Hololens头戴式增强现实显示器,成功地将虚拟和现实融合在一起,Hololens的镜片是透明的,戴上之后可以看到外部的世界,但是这个透明的镜片还是一个显示器,能够在看到的真实世界上叠加3D动画,从而产生一种虚实结合的效果。除3D显示外,3D眼镜和3D头戴式显示器通常还会配置两类传感器,一是用于感测环境的环境感测系统,可用来感测静态对象、动态对象、人和照明、大气等外部环境;二是用于感测用户动作和意图的用户感测系统,包括语音、手势、红外感测、陀螺仪以及相机等,以优化用户体验并实现交互。3D眼镜和头戴显示器虽然普及率较高,并在3D影院和游戏娱乐领域得到了广泛应用,仍存在以下几个方面的不足:1)眼镜或显示器需要随身携带,不方便;2)3D头戴式显示器较重,不舒服;3)眩光,容易视觉疲劳;4)单人视场独占模式,难以互动娱乐;5)难以与真实空间交互;6)难以规避来自真实空间的障碍物和意外等风险。

裸眼3D是当前国内外的前沿和研究热点,其独特的视觉效果极大地激发了人们的研究热情。早在1985年,德国科学家Reinhard Boerner在海因里希赫兹研究所(Heinrich Hertz Institute,HHI)即通过透镜创建了自由立体显示④,在1990年,HHI开发出了支持单人观看的立体原型机,英国Reality Vision公司很早就提出了全息自由立体显示的概念,2009年,美国PureDepth公司研究开发了多层显示技术(Multi-Layer Display, MLD),多层LCD排列可分别显示前景与后景,形成前后深度感,Magic Leap公司则研究了采用光纤向视网膜投射四维数字光场并辅之以定位跟踪的裸眼3D技术,Magic Leap技术上可行,并已获得大额资金资助,其中来自Google等公司的资金甚至高达5.42亿美元。

能够实现裸眼3D显示的技术包括狭缝式液晶光栅、光屏障式3D技术、柱状透镜技术、指向光源技术以及多层显示技术等⑤⑥⑦⑧。其中,狭缝式液晶光栅技术在屏幕前设置了一个狭缝式光栅,应该由左眼看到的图像显示在液晶屏上时,不透明的条纹会遮挡右眼,同理,应该由右眼看到的图像显示在液晶屏上时,不透明的条纹会遮挡左眼,从而通过将左眼和右眼的可视画面分开以实现3D显示;光屏障式3D技术与之类似,该技术通过使用开关液晶屏+偏振膜+高分子液晶层来形成一个90度角的垂直条纹系列,从而达到正面视觉上的立体3D效果;柱状透镜技术则是采用类似水面折射的原理来实现3D显示;指向光源技术属于时分裸眼3D技术,是将图像以奇偶帧交错排序方式,分别反射给左右眼,形成左右眼的视差,从而实现3D显示;多层显示技术通过一定间隔重叠的两块液晶面板实现3D显示,与柱状透镜技术相比,该技术不会导致眩晕、头疼及眼睛疲劳,可组合显示文字,可视角度大,具有一定优越性。除上述技术外,与裸眼3D相关的技术还包括:1)四面锥全息投影方法⑨;2)将空气分子选择性电离的激光等离子体发射(Laser plasma emission)方法⑩;3)借助水幕、雾幕和水蒸气幕并依赖投影技术的裸眼3D方法,如Helio display空气成像技术?,该技术包括一台投影机和一个空气屏幕系统,空气屏幕系统可以制造出由水蒸气形成的雾墙,当采用背投技术将影像投映至雾墙上时,观看者看到的将会是漂浮在空气中的影像,这些影像虽然是二维平面图像,但由于空气墙分子的不均衡运动,可呈现类似3D图像的质感,该技术已有市售产品,但价格昂贵,单台约18000美元;4)2016年Kino-mo公司在CES展览上展示的采用高速旋转的LED叶片形成空间三维影像的方法等。

裸眼3D摆脱了佩戴器具的束缚,仍存在一定的局限性。裸眼3D显示的市场空间巨大,该技术除应用于娱乐、影视等领域外,还可广泛应用于科研、航空、医学、文物展示、旅游健身、地产展示、军事模拟等领域,如美军开发的空军任务支援系统和海军特种作战部队计划和演习系统、虚拟博物馆,以及被广泛应用在卖场和交通枢纽等场所的裸眼3D广告机等。

日本对3D显示产业非常重视,于2003年先后成立了以电视厂商为主的3D Consortium、HODIC、TAO以及3D Business Promotion Consortium等组织,并联合200多家公司共同研发3D显示技术和产品;韩国也制定了宏伟的3D技术与产业发展规划,于2015年实现了裸眼3D TV商用化,并计划于2020年开发出全息显示产品;美国继2005~2007年实施了基于触觉和裸眼3D技术的数字虚拟人计划后,NASA于2014年启动了由Joseph Grant领导的为期3年的以提升商用飞行器安全为目标的高精度裸眼3D飞行座舱项目,预计2016年底可完成原型样机。NASA预测,除飞行领域外,医疗3D可视化方面的需求每年可达20亿美元,游戏和家居方面则可能更高。

我国政府对3D显示技术的发展极为重视。2015年11月10日,国家主席习近平到英国帝国理工学院访问时,特地试戴体验了3D眼镜;李克强总理多次明确要求加大对虚拟现实产业的投入。此外,企业界对虚拟现实的投资热情近年来也是日渐高涨,目前国内80%以上的大公司均已直接或间接地涉足3D显示领域,如华为、中兴通讯、乐视科技、网易、TCL、淘宝、迅雷等。

虚拟现实中的触觉交互技术

触觉交互对于虚拟现实具有重要意义。人类的好奇心决定了人们在看到物体的同时天生就有一种想摸一摸的冲动,此外,触觉交互还可以帮助人们在体验虚拟空间时与虚拟对象进行实时的互动,以获得逼真的体验,从而高质量地完成培训或操作控制。触觉交互在技术层面主要涉及触觉传感和触觉显示两个方面。

触觉传感技术。虚拟现实中,操作主体与虚拟对象或环境进行交互所涉及的传感可以分为二类,一是虚拟传感器,二是实体传感器。当虚拟对象或环境已被数字建模,其几何外观已三维重构且在虚拟空间中已有精确坐标时,主体与虚拟对象的交互需要实时地计算肢体与虚拟对象和环境之间的距离,虚拟现实系统中可设计专门的算法程序应用于距离的分析计算,其作用相当于一个虚拟的“接触觉传感器”,类似地,如果有算法可通过影像分析计算得到虚拟对象的材质类别或表面细节特征,并进一步估算其导热系数和表面粗糙度,则可由此分别构造一个虚拟的“温度传感器”和一个虚拟的“纹理特征传感器”。实体传感器是指实物类型的触觉传感器。当操作主体有一个随动的机械手臂且触觉交互的虚拟对象也有对应的实物对象时,虚拟对象可不需要精确建模而只是简单的VR拍摄即可,此时,操作主体与虚拟对象的交互实际上是操作主体控制下的机械手臂与实际物体的交互,可通过触觉传感器感知机械手臂与物体的交互过程,并实时反馈给虚拟环境中的操作主体,以帮助操作者获得全真的触觉体验。实物类的触觉传感器主要包括接触觉、压力觉、温度觉、纹理觉等。

实物类的触觉传感器可以分为点接触型触觉传感器、面接触型触觉传感器和滑觉传感器。其中,点接触型触觉传感器主要用于判别传感器与目标之间的接触状态,可以测量接触力的大小,也可以只是简单地用0或1表示是否接触,点接触型触觉传感器在躲避障碍物,控制机械手的运动等方面具有重要价值;面接触型触觉传感器由点接触型触觉传感器以阵列方式组合而成,用于测量传感器区域垂直作用力的分布情况,并可形成敏感面与物体相互作用时的触觉图像,在自主机器人应用中,面接触型触觉传感器常常面积较大,以更好地完成环境探测、目标识别和精确操控,近年来,随着仿生机器人的兴起,面接触型触觉传感器与人工皮肤常常以一体化的方式出现,并更多地强调柔顺性;滑觉传感器主要用于测量物体与传感器之间的相对运动趋势,可以是专门的滑觉传感器,也可以由触觉传感器解析得到。此外,作为实际应用中的现实需求,热觉也常常被组合到触觉传感器中。

本质上,现实世界中的触觉交互是一个力的相互作用过程,触觉传感器所感知的物理量是接触力,传感器的作用在于响应接触力的变化,并采集交互过程中的力参数。接触力参数采集方法较多,常用方法主要包括机械式、压阻式、压电式、电容式、电磁式、光纤式及生物信号式等。特别地,接触过程中的位置改变也可通过光学方法进行检测,由此衍生了间接测量接触状态的光电式触觉传感器,比如光电二极管等。上述传感器中,电容、压阻、压电和光电类触觉传感器由于简单经济往往在实际应用中被优先选用。

全局检测、多维力检测,以及微型化、智能化和网络化是当前触觉传感器的趋势。全局触感方面,触觉传感器通常覆盖很大区域,以用于表面形状和表面特性的检测。PVDF、碳纤维?和光纤是比较理想的材料,PVDF可以方便地被制造成大面积的“人工皮肤”,碳纤维和光纤可以通过编织工艺构造大面积可穿戴的柔顺型触觉传感器,以用于任意表面的触觉测量,并测量多维接触力分布。多维力检测方面,1984年,Kinoshita等即已关注3D目标的感觉以及传感器设计问题?;2010年,日本Van A H等人利用MEMS技术研制成功用于机器人指部的三维力触觉传感器?。国内高校和机构对多维力的检测也非常关注,2009年中科院合肥智能机械研究所研制成功三维力柔性触觉传感器,实现了对三维力的检测?。2014年,浙江大学Yu Ping等开发成功一种可检测X(4N)、Y(4N)和Z(20N)方向的触觉传感器?。触觉传感器的微型化、智能化和网络化是虚拟现实和现代机器人系统的迫切需求,带有微处理器的触觉传感器能够在探测现场即时采集和处理数据,并实时地与外界进行数据交互。未来触觉传感器除具备基本的触觉传感功能外,还将具备自诊断、校准和测试等附加功能,2011年,Muroyama等报告了LSI微型触觉传感器系统的研制工作?。此外,多模感知也是触觉传感器的一个方向。在人工皮肤中内置一层可以检测温度变化的传感器以实现热觉检测是可行的做法。2014年,Wettels等报告了一种可用于目标设别和抓取作业的指型触觉传感器阵列,该传感器可以象人类皮肤一样具有感知力、热和微振动的能力?。此外,Sohgawa M?也报告了一种采用MEMS悬臂梁的多功能触觉传感器,该传感器不仅能够探测到目标的接近,而且能够检测接触、滑移和表面纹理等情况。

在性能指标方面,触觉传感器尚无统一标准。工业应用中,触觉传感器应具有较好的强度,重复性好、噪声低、迟滞小、鲁棒性好、不易受环境影响而损坏。

触觉显示技术。触觉显示是与触觉传感相对应的一个概念。触觉传感可以获取物体之间相互作用的接触情况和力的大小,触觉显示则能够把这种接触情况和力的大小显示还原出来,让有知觉能力的主体知晓和掌握相互作用情况,进而更好地完成操控作业或进行决策。

触觉显示源于主从机器人领域,其目的是把远地从机械手侧的接触情况在本地主机械手侧进行还原,以便主机械手侧的操作者能够获得远地机械手作业时的真实感觉。主从机器人领域的触觉显示最初被称为触觉临场感或者触觉再现,后来随着虚拟现实应用的兴起,触觉再现作为一个概念逐渐被触觉显示所取代。

触觉显示主要有两种方式,一是视觉显示,二是基于物理刺激的触觉显示。触觉信息的视觉显示在早期有些价值,由于需要额外的显示屏并占用操作者的视觉资源,逐渐被弃用。在基于物理刺激的触觉显示方面,早期的技术手段主要包括顶针刺激、气动刺激、振动刺激和电刺激。其中,1)顶针刺激通过压电、电磁、形状记忆合金(SMA)和气动等多种方式驱动的顶针阵列实现,顶针可以停留在上下两个位置,也可以在垂直方向上振动,以给皮肤施加压力和振动。2)气动刺激是将具有一定压力的气体通过泵阀和管道施加到人体皮肤上,使人产生接触到物体的感觉。气动刺激包括喷气、气囊、气环和气针等多种形式。气动刺激带宽和分辨率很低,操作者容易产生肌肉疲劳并因此减低感觉能力。3)振动刺激使用钝针、音圈或压电晶体等产生振动。振动触觉装置体积小、带宽高,是一种应用广泛的触觉刺激方式。振动触觉技术较为成熟,并能以触觉图像序列快速刷新的方式实现“触觉电影”。4)电刺激是将电脉冲施加到用户指端的微小电极上从而形成触感觉。电触觉能够在没有机械激励的情况下产生压力或震动感觉。电刺激触觉体积小、重量轻,不足之处在于动态范围较小,易引起电刺痛等不舒服的感觉。除此之外,近年来,研究人员还发展了一些新颖的技术手段,如超声刺激、电流变液、磁流变液和射流刺激?等。

力的显示和反馈一直是领域内的一大难题,早期的作用力显示是借助机械手臂完成的,机械手臂一方面通过级联的臂杆为指爪提供空间定位,另一方面也借助机械手臂的基座完成相互作用力的显示。由于需要机械手臂并需要精确的控制,这样的力反馈装置价格极其昂贵,通常只在实验室及特别场所使用,2005年左右,有机构推出了桌面型触觉力显示器,如delta和phantom等,大幅降低了力反馈显示装置的成本和价格,但价格仍高达20万元左右,难以为普通消费者所承受。Delta是Force Dimension公司研制的多自由度多功能力反馈系统,可在较大的工作空间内实现大范围作用力的反馈,实现对运动知觉,以及触摸玻璃或者海绵等物品时触感的高保真、高品质显示。Omega是低成本的桌面型力反馈设备。Omega采用铝制构件,减少了惯性效应,Omega可产生持续的12.0牛顿的作用力,闭环强度为每毫米14.5牛顿。Phantom是SensAble Technologies推出的力反馈系统。Phantom力反馈装置可以提供沿x轴、y轴和z轴的力反馈,以及偏航、俯仰和侧滚等,可模拟虚拟碰撞、反作用力和转矩等不同的感觉。Phantom力反馈装置可帮助操作者完成精准的3D对象操作,并能够提供虚拟装配、虚拟样机、维护路径规划、远程操作以及分子模拟等多种形式的力感觉探索。

除上述点触觉力反馈外,业内还推出了以指爪控制为特征的手套型触觉反馈控制器,该类控制器通过固定于指爪外侧的外骨骼机构限制指爪自由度,从而提供力反馈。典型方案包括Mcgill、Cyber和Dexmo等。手套型触觉反馈的特点在于通过指爪控制提供力感觉,由于结构简单,成本极大降低,但力反馈通常只限于局部应用。

近年来,受虚拟现实氛围的影响,很多个人爱好者和公司介入了力感觉显示的研究和产品开发中,并推出了多种概念产品如Gloveone、Impacto和IMotion等。随着陀螺仪和视觉定位等技术发展,触觉反馈手套有望克服自由空间定位的难题,成为极有前途的发展方向,并彻底解决触觉显示应用层面成本高昂的难题,成为和视觉显示器一样的廉价产品。100多年前,人们无法想象视觉显示器能取得今天这样的辉煌成就,从单色到彩色,从模糊到清晰,从小到大,无一不凝聚着人类智慧的精华。如同古人难以想象如今视觉显示器的成就一样,虽然我们今天也难以想象未来触觉显示器会取得怎样的成绩,但纵观视觉显示器的发展历史,有理由相信,随着人们对完美触觉的不懈追求,未来触觉显示器一定会达到更高的层次和水平,并在工业领域和日常生活中获得广泛应用。

虚拟现实技术瓶颈

总体来说,当前虚拟现实技术发展的主要受限如如下几个瓶颈:

环境和对象3D建模。虚拟现实系统具有两个坐标空间,一是现实世界的坐标空间,而是虚拟世界中的坐标空间,当操作者和虚拟空间交互时,操作者身处现实世界的绝对空间中,而交互的对象则处于虚拟空间中,两个空间中坐标系必须建立某种映射关系,才能实现操作者对虚拟对象的精确操控。

当操作者完成操作后,使操作者视觉上感觉到交互效果的方式有二种,一是人在绝对空间中移动时,虚拟空间相对于绝对空间保持静止;二是操作者相对于绝对空间保持静止,而虚拟空间通过场景切换使虚拟空间相对于绝对空间在动。

由于操作者与虚拟空间的交互可遍历整个空间及所有的对象,这就要求虚拟现实系统需要准备虚拟环境和对象的全部三维模型,当虚拟对象和环境是以计算机合成的方式建立时,数据准备比较容易,而当这些对象或环境来自现实世界时,数据准备将成为一个困难,因为现实世界中无论对象还是环境,其外观和几何尺寸的获取只能通过3D扫描的方式获取,由于现实环境的复杂,以及对象可能较多,数据准备不仅过程漫长,而且数据量极大。

海量数据通信。拟现实交互中,无论是图像传感器的数据获取还是立体显示中的场景显示,均涉及大量的影像数据的传输,特别地,由于交互过程会伴随操作者虚拟视场的转换,该过程中涉及大量的数据计算和和影像传输,数据量极大。

当系统中存在多个交互对象时,其数据传输量将急剧增长,不仅要求硬件系统性能一流,对数据传输提出了极高要求,如果数据传输过程中出现迟滞,将严重影响操作者的用户体验,从当前的网络条件来看,这方面的保障不容乐观。

虚拟传感器。现有的虚拟现实多为视频拍摄的影像,影像中的立体对象和环境,虽然可以通过视觉观察,但是却难以用于直接触觉探索,由于没有立体对象和环境的几何尺寸参数,很难计算判断操作者与立体对象之间的位置关系以及触碰情况。为了给操作者提供触觉交互时的感觉,需要利用图像算法和专家系统等进行分析并编写程序设计专门的可探测接触状态、作用力方向大小、材质类别和纹理特征等多种“虚拟传感器”,以帮助操作者获得较好的触觉体验。目前这方面的研究工作有限,尚无成熟的算法可借鉴。

裸眼3D显示。相对于头戴式显示器,裸眼3D具有明显的优越性,但是其仍存在若干目前尚无法解决的困难,主要表现在:1)操作者需要被限制在特定的区域,移动位置时,图像会出现反视、重影、失真等,严重影响舒适度;2)存在眩晕感,使用者观看时间稍长就可能头晕,用户体验很差;3)水幕和雾幕类裸眼显示影响真实感和视场环境;4)LED叶片法生成裸眼影像时,成像质量较差;5)空气分子等离子体显示等难以显示彩色影像;6)裸眼3D电视和LED叶片法裸眼显示中,由于物理或视场障碍,操作者自身无法走进虚拟空间,并以触觉方式与之交互。

三维耳机。人只有两个耳朵,但对于现实世界中的音源却具有很好的方位识别能力,能够轻松分辨音源的左右、前后、上下和远近等,这主要归功于耳朵是一个功能强大的器官,人耳的耳蜗、耳廓,甚至耳毛耳骨等均参与了声音处理和音源的识别过程,人耳不仅可以侦测到音源到达人耳时的强度和相位差异,而且还能鉴别声音在不同位置时的环境回波差异等,因为这些差异,大脑才有能力对音源方位进行准确判断。尽管立体声技术已取得较大进展,但人耳机制非常复杂,目前仍难以通过音响设施完全还原现场声音。特别是虚拟现实中多使用耳机作为声音显示设备,由于无法激励外耳,其效果更差。

味觉嗅觉显示。味觉相关的输出设备为与虚拟物体对应的“味觉变形体”。“味觉变形体”需要动态调整其几何形态使其与虚拟物体一致,并能够对各位置处的酸甜苦辣咸等味觉特征进行调整和改变,不仅体积要小,而且能动态调整几何形状,并要求具有较好的实时性,难度极大。嗅觉输出和味觉输出一样都是以化学反应为特征的刺激装置,还存在着适宜刺激和安全性等方面的要求,目前尚无成熟可行的技术方案。

2016年注定是虚拟现实发展史上不平凡的一年。从国家领导人到普通百姓,都在关注着VR的技术进步和发展机遇,从中央部委到地方政府,都在关心着VR的产业发展和政策扶持,从东部沿海到西部内陆,VR企业如雨后春笋般创立,一个接一个的VR产品也正在被开发出来。可以想见,VR产业将很快迎来高速发展期,在未来像手机和网络一样完全融入我们的生活,渗透到社会经济的方方面面。

虚拟现实的未来或许会是一个遍布全球的综合性平台,自然人自出生起就在虚拟世界的理想国中拥有一个唯一的身份并终身相随,某种程度上,虚拟现实的世界可看作是与现实世界平行的“宇宙”空间,人们在其中可拥有属于自己的虚拟社会生活和生存空间,人们可以有虚拟的货币,可以工作挣工资,可以买房做生意,不过也可能犯罪,甚至出现血腥事件。虚拟世界中,可能也需要伦理和法律层面的诸多约束,以规范人们在虚拟世界中的行为。由于虚拟生活对个体心理和行为方面可能的影响,这方面的研究以及现实世界对虚拟世界的法律约束等探索宜尽早提上日程。

注释

SMann, S., "Mediated Reality", Linux Jounal, 1999: 59(5), pp. 1-21.

Earnshaw, R.A., Gigante, M.A. and Jones, H., Virtual Reality Systems, Manhattan: Academic Press, 1993, pp. 15-28.

Hiraoka, K., "Three-dimensional image display system using binocular parallax", Free Patents Online, US, 1989.

Borner, R. "Autostereoscopic 3D-imaging by front and rear projection and on flat panel displays", Displays, 1993, 14(1), pp. 39-46.

谷俊、陶宇虹、王琼华、李大海:《基于双狭缝光栅的裸眼三维立体投影机》,《激光与光电子学进展》, 2009年第46期,第 31~33页。

Dodgson, N.A., "Autostereoscopic 3D displays", Computer, 2005. 38(8), pp. 31-36.

Woodgate,G.J., Ezra, D. and Holliman, N.S., "Observer-tracking autostereoscopic 3D display systems", Proceedings of SPIE, 1997, 3012(69), pp. 187-198.

张兴、郑成武、李宁、周兴丹、李正强:《液晶材料与 3D 显示》,《液晶与显示》,2012年第27期,第448~455页。

Deng, Y., Ciriza, V., "Multi-layer display", 2009, United States Patent, 8643567.

Ozaki, M., Kato, J. and Kawata, S., "Surface-Plasmon Holography with White-Light Illumination", Science, 2011, 332(6026), pp. 218-220.

Hunter:《你也可以制造“海市蜃楼”!——Heliodisplay 气体投影显示器》,《微型计算机》,2005年第22期,第64~65页。

Park, C.S., Park J., Lee D.W., "A piezoresistive tactile sensor based on carbon fibers and polymer substrates", Microelectronic Engineering, 2009, 86( 4-6) , pp. 1250-1253.

Kinoshita, G. and Hattori, K., "Tactile sensor design and tactile sensing on 3D objects", Journal of Robotic Systems, 1985, 2, pp. 41-52.

VA, H.O., Dao, D.V., Sugiyama, S., Hirai, S., “Design of a small-scale tactile sensor with three sensing points for using in robotic fingertips”, IEEE International Conference on Robotics and Automation (ICRA), Alaska, 2010, pp. 4855-4860.

徐菲、黄英、丁俊香等:《一种新型三维力柔性阵列触觉传感器研究》,《传感技术学报》,2009, 22(11),第1542~1546页。

Yu, P, "Development of a Compliant Magnetic 3-D Tactile Sensor with AMR Elements", Lecture Notes in Computer Science, 2014(8918), pp. 484-491.

Muroyama M., Makihata M., Nakano Y. et al, "Development of an LSI for tactile sensor systems on the whole-body of robots", IEEE Transactions on Sensors and Micromachines, 2011,131(8), pp. 302-309.

Wettels N., Fishel J.A., Loeb G.E., "Multimodal tactile sensor. The Human Hand as an Inspiration for Robot Hand Development", Springer Tracts in Advanced Robotics, part Ⅱ, 2014(95) , pp. 405-429.

Sohgawa M., Watanabe K., Kanashima T., Okuyama M., "Texture measurement and identification of object surface by MEMS tactile sensor". Sensors, 2014, 44(6), pp. 1706 -1709.

责 编∕杨昀贇