技术与K—12学校的有效融合:基本条件与评价量规

2016-11-10海伦·克朗普顿米海尔·N·吉安纳克斯布兰顿·M·巴特勒洛蕾塔·乌尔默

海伦·克朗普顿 米海尔·N·吉安纳克斯 布兰顿·M·巴特勒 洛蕾塔·乌尔默

【摘 要】 技术的使用对提高学生学习质量有巨大潜力——这点是学界共识。然而,由于存在某些障碍和缺乏指导,在很多K-12学校中技术的用途非常有限。本研究旨在为K-12教育采用和融合技术提供一套基于研究的准则。研究者首先组织具有教学和技术背景的专家参加专题讨论并收集最佳实践经验,然后由专家组成的焦点小组采用亲和图方法进行归类。研究结果包括一套设计原则和一个评价量规。这个评价量规用于自我评估K-12教育采用和融合数字化技术的情况,而设计原则用于指导评价量规的编制,因此,我们的评价量规也体现了这些原则。本研究的结果对于从事教学研究的学者、教师、课程设计者和学校行政管理者应该有指导作用。

【关键词】 标准;技术融合;最佳实践;设计原则;评价量规

【中图分类号】 G420 【文献标识码】 B 【文章编号】 1009—458x(2016)08—0027—10

导读:(信息/数字化)技术与(基础)教育的融合,不管是从政策(政府)层面、学校(管理)层面抑或是教与学(实际应用)成效层面讲,都具有重大现实意义。从历史的角度看,技术在教育领域的应用经历了一个渐变的过程:从一味强调硬件建设(缩小技术鸿沟)、教师个人层面的技术应用、学科层面的技术应用到技术与教育(深度)融合。可以说,我们在每一个发展阶段都付出了代价,也吸取了经验教训,因此我们对技术与教育的关系才有越来越深入和全面的理解,最终提出两者必须深度融合这个目标。换言之,技术应用之于教育应该是一种常态。只有达到这种状态,我们才能真正从教育的特点和规律或者说从人类认知特点和规律的角度最大限度发挥技术促进学习的优势和潜能。

其实人们并不是到了今天才认识到技术与教育相融合的重要性。过去20年,不断有学者提出类似观点。比如,早在1998年,教育技术领域先行者、美国学者马克·沃舒尔(Mark Warshauer)就指出:“计算机应该成为语言学习和运用必不可少的工具,如同书本、笔和图书馆一样,而不是一种特殊的工具;我们没有所谓的‘书本辅助语言学习(book-assisted language learning),没有‘笔辅助语言学习(pen-assisted language learning),也没有‘图书馆辅助语言学习(library-assisted language learning),因此,只有计算机的使用与语言学习和运用密不可分,才不再有‘计算机辅助语言学习(computer-assisted language learning)的说法。”①2003年,英国学者史蒂芬·巴克斯(Stephen Bax)用“常态化”(normalization)指“学生和老师把计算机的使用作为教与学的一个有机组成部分,就像使用笔和书本一样,自然不过,不会引起特别的关注,也没有夸大它的作用”。②后来他和同事安德里亚·钱伯斯(Andrea Chambers)还专门研究“常态化”的障碍。③无独有偶,澳大利亚《远程教育》主编索姆·奈杜(Som Naidu)博士在2015(第十四届)中国国际远程教育大会上的发言中也谈到他对中国学界的热词——“‘互联网+教育”的看法,他说鉴于今天互联网已经成为我们生活和工作的一部分或不可或缺的工具,我们完全没有必要用“互联网+”或“基于因特网”这一类的表述修饰“教育”,这样可能反而会禁锢我们的思维,妨碍我们从教育的角度设计技术的用途。

然而,虽然今天的教育利益相关各方都已经认识到技术与(基础)教育融合的重要性,对于这种融合的基本条件也取得一些共识(起码是一定范围内或背景下的共识),对影响融合的障碍也有了一定了解,但是,技术在(基础)教育中的实际应用情况以及促进教育质量提高的实效似乎与理想的目标还有一段明显距离。“在很多学校中数字化技术的用途仍然非常有限,远远落后于社会对技术的接受程度。”从相关研究和国际组织、政府部门等的调查报告看,这似乎是一种普遍现象,各国情况大同小异,未见具有普及推广价值的经验和模式。那么,“为什么会出现这种局面呢?一种合乎逻辑的观点是:学校使用技术的人不懂得如何评估本校是否满足这些基本条件。”鉴于此,以海伦·克朗普顿博士为首的研究小组开展了一项研究,目的是“制订一套设计原则,以指导编制自我评估K-12教育采用和融合数字化技术情况的评价量规”和“运用这些设计原则编制一个评价量规”,希望这项研究既有助于“客观评估技术与K-12教育融合的现状,也有助于用户发现不足并明确今后努力方向”。

本研究以美国国际教育技术协会(International Society for Technology in Education)此前所提出并被广泛认可的技术与教育融合的14个基本条件为基础,组织12位有不同专长背景的业界专业人士以焦点小组专题研讨的形式深入讨论这些基本条件的实际内容以及如何评估不同融合程度。研究者根据这些专家的意见、建议、实践经验等归纳了评价量规的6条设计原则,并以此为指导组织专家们制订了一个评价量规。当然,诚如文中所指出的,这个评价量规和这些设计原则虽然从理论上讲可行性较高,但仍需通过实际应用(尤其是在不同国家和不同教育环境下的应用)加以检验和完善。我们希望这篇文章能给中国研究者和实践者一些有益启示。

本文第一作者海伦·克朗普顿博士对于本刊“国际论坛”栏目的读者来讲应该不陌生,她和国际移动学习协会副会长、英国伍尔弗汉普顿大学(University of Wolverhampton)教授约翰·特拉克斯勒(John Traxler)合作为本刊撰写过两篇文章。④⑤她本人曾在英国和美国的中小学当过教师,学士和硕士专业均是小学教育,后来又获得教育技术和数学教育博士学位。最近几年,克朗普顿博士的研究成果频频见诸很多有影响力的学术期刊和学术会议,仅2015年就与约翰·特拉克斯勒教授合作主编两本专著:《移动学习与数学:基础、设计和案例》⑥和《移动学习与STEM:实践案例》⑦,并多次应邀在英国国内及其他国家讲学并为包括联合国教科文组织和国际电信联盟在内的国际组织以及其他学术机构提供顾问咨询。由于在移动学习方面的突出贡献,她从2012年以来连续4年获得“美国总统义工服务奖”(The President's Volunteer Service Award)。本文其他3位作者也均在学术领域有各自的建树。

我们衷心感谢4位博士选择《中国远程教育》发表这项研究成果!(肖俊洪)

一、引言

许多教育工作者及政府都提倡在K-12教育中应用数字化技术(如,Bereiter&Scardamlia, 2006; Common Core State Standards Initiative, 2010; Greenhow &Robelia, 2009; Jonassen, Howland, Marra, &Crismond, 2008)。数字化技术的使用有助于学生更好掌握领域知识(domain knowledge)、批判性思维技能和问题解决技能(Lock & Redmond, 2006; Zach & Agosto, 2009)。然而,虽然如此,在很多学校中数字化技术的用途仍很有限,远落后于社会对技术的接受程度(Crompton, 2013)。

由于某些限制和障碍,技术在学校没有得到应有的应用(Becker, 2000; Hramiak&Boulton, 2013),比如,教师对在教学中使用技术的态度和看法(Crompton, 2011),技术的便利性、技术支持和培训(Hew & Brush, 2007)以及资金问题(Rogers, 2000)都会影响技术的教育用途。学校必须具备哪些基本条件才能保证技术的顺利应用?对于这个问题,学者们(如Becker, 2000; Ely, 1999; Honey, Culp, &Carrigg, 2000; ISTE, 2009; Norris, Smolka, &Soloway, 2000; Shuldman, 2004; Zhao, Pugh, Sheldon, & Byers, 2002)纷纷提出相关的基本条件。但是,虽然我们知道必须具备什么条件才能实现技术与教育的融合,技术在很多学校中依然没有得到充分应用(Crompton, 2013)。为什么会出现这种局面呢?一种合乎逻辑的观点是:学校使用技术的人不懂得如何评估本校是否满足这些基本条件。

针对目前学校使用技术的窘况,我们开展了这项研究,目的有二:① 制订一套设计原则以指导编制自我评估K-12教育采用和融合数字化技术情况的评价量规;② 运用这些设计原则编制一个评价量规。

下面首先回顾相关文献,随后详细介绍本研究采用的方法,呈现研究结果(即设计原则和评价量规)并进行必要阐释,最后将讨论本研究的局限与启示。

二、文献回顾

1. 技术融合的障碍

技术与教育融合指的是技术使用被融入教育的情况(Norris et al., 2000)。斯图亚特、米尔斯和雷穆斯(Stuart, Mills, & Remus, 2009)认为学校领导的观点决定了技术能否成功融入该校。如果学校领导对使用技术持肯定态度,该校的技术融合情况会好于领导持消极态度的学校。拉泽吉(Razaghi, 2014)的研究表明有7种障碍影响技术与教育的成功融合:① 人的因素(比如自信心、态度和技能);② 设施/设备因素(比如对学校设施不了解和使用受限以及没有配备足够的电脑和软件);③ 技术因素(比如质量不佳、不能正常使用的技术);④ 文化因素(比如家庭恪守传统和习惯、过度的因特网过滤);⑤ 专业技术能力因素(比如教师不能制作电子内容);⑥ 工资和额外福利因素(比如是否使用信息技术不影响教师的收入)和⑦ 财政因素(技术设备成本高昂)。

其他一些研究也在不同程度地印证上述结论。宾吉姆拉斯(Bingimlas, 2009)根据相关研究(Grabe&Grabe, 2007)从教师和学校的层面探究影响技术融合的障碍。教师方面的障碍包括教师缺乏信心、抵制变革和态度消极;学校方面的障碍包括给教师的时间、技术便利性、有效培训和技术支持等方面的不足。早年的一些研究也发现类似障碍。比如,罗杰斯(Rogers, 2000)认为技术与K-12教育的融合面临6大障碍,包括:① 利益相关各方的态度和看法;② 员工专业发展;③ 技术的配备和便利性; ④ 技术支持;⑤ 资金和⑥ 时间。

2. 基本条件

研究者不但分析技术与教育融合的障碍而且还研究了学校成功应用技术的必要条件。一个机构能否成功融合技术牵涉很多人、过程、观点和技术。所有这些都是技术与教育融合的基本条件。为了了解具体的基本条件,贝克(Becker, 2000)研究了技术融合的模范学校,发现这些模范学校有全职技术协调员,提供技术支持和教学法支持,其教师有中等以上计算机知识和技能,接受正式专业发展培训,有足够计算机可供使用,时间有保证。诺里斯等(Norris et al., 2000)在回顾相关文献的基础上总结促进学校有效融合技术的条件。他们发现最有效利用技术的学校在技术、时间、教师培训、课程大纲的科学设计和支持服务人员等方面均有保证。同期的另一篇文献回顾(Honey et al., 2000)表明技术与教育有效融合必须具备6个条件:时间、专业发展、技术资源、明确教育目标、技术评估和领导才能。

国际教育技术协会(International Society for Technology in Education,简称ISTE)在2007- 2009年间提出了技术与教育融合的14个基本条件,包括:共同愿景、授权于利益相关者、实施计划、稳定和足够的资金、平等机会、技能人才、持续专业学习、技术支持、课程框架、以学生为中心的学习、考核与评估、社区参与、支持政策和支持性外部环境(ISTE, 2009)。国际教育技术协会的这些基本条件很有代表性,集中体现了相关研究的成果,因此本研究采用这些基本条件。

3. 评价量规

虽然我们已经知道技术与教育融合必须具备这些条件,然而时至今日数字化技术在很多学校中仍然没有得到应有的应用,远远落后于社会对技术的接受程度(Crompton, 2013)。之所以出现这种局面,原因可能是我们未能很好理解这些基本条件在具体环境下究竟是指什么。研究表明,评价量规有助于促进我们的理解(Penny & Murphy, 2009)。评价量规是一种描述性评分评价工具(Egodawatte, 2010; Moskal, 2000; Oakleaf, 2009),不但能够清楚表明评估的重点(Moskal, 2000)而且还对绩效标准进行质性(qualitative)描述(Tierney & Simon, 2004)。

鲁斯特(Rust, 2002)发现用户友好型的评价量规能清楚表述标准,因此有助于用户开展自我评价。哈德逊(Hudson, 2005)主张应该根据预期学习结果制订具体评价指标。波帕姆(Popham, 1997)提出评价量规必须包含两个方面内容:绩效标准和等级。绩效标准指可以观察到的事物,而等级则是指满足绩效标准的不同程度。

三、研究方法

1. 数据收集:专家专题讨论

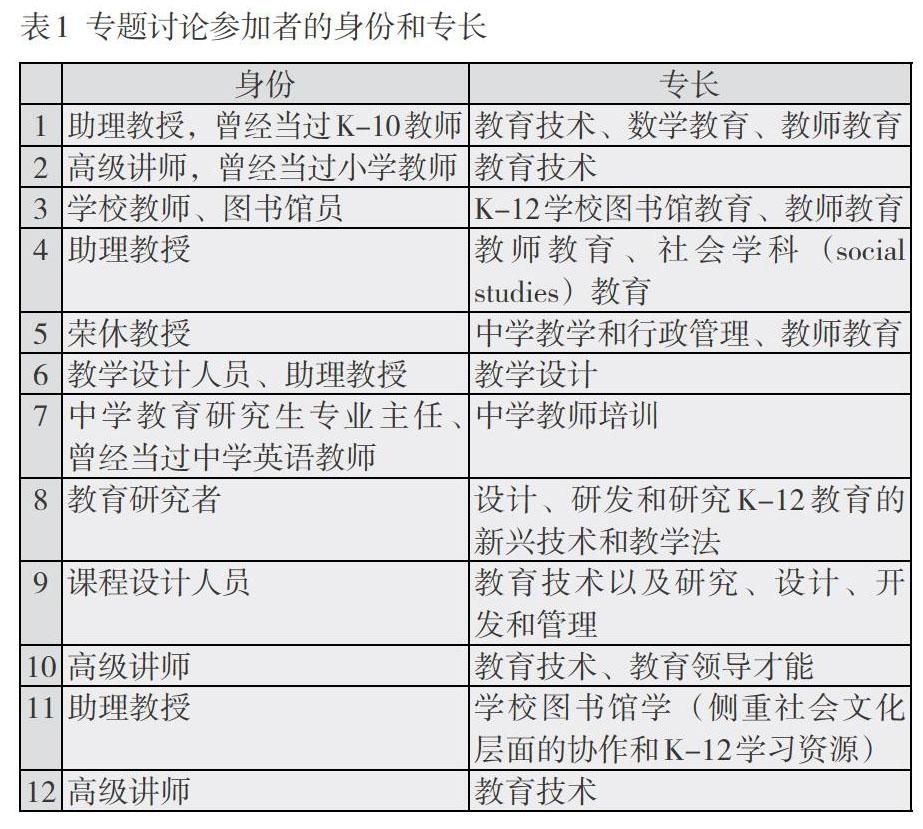

12位从事技术和K-12教育工作的专业人士参加了6场专题讨论,每场历时2个小时。本研究是在一所研究型大学开展的(McCormick, 2001)。表1介绍这些专业人士的身份和专长。

专题讨论的目的是给专家们提供头脑风暴的机会,使他们能围绕K-12学校有效利用技术促进学生学习的基本条件集思广益,分享自己的想法、最佳实践经验和指导原则等。具体说来,我们要求参加专题讨论的专业人士对国际教育技术协会的14个基本条件逐一进行讨论,重点是如何在实践中体现这些条件。换言之,我们应该能够在K-12教育环境中观察到什么才能确信这些条件得以实现了?与此同时,我们还要求与会者探讨如何表述技术与教育的不同融合程度以及本课题的结果如何进一步提高学校教师和管理者使用技术的动力和热情。

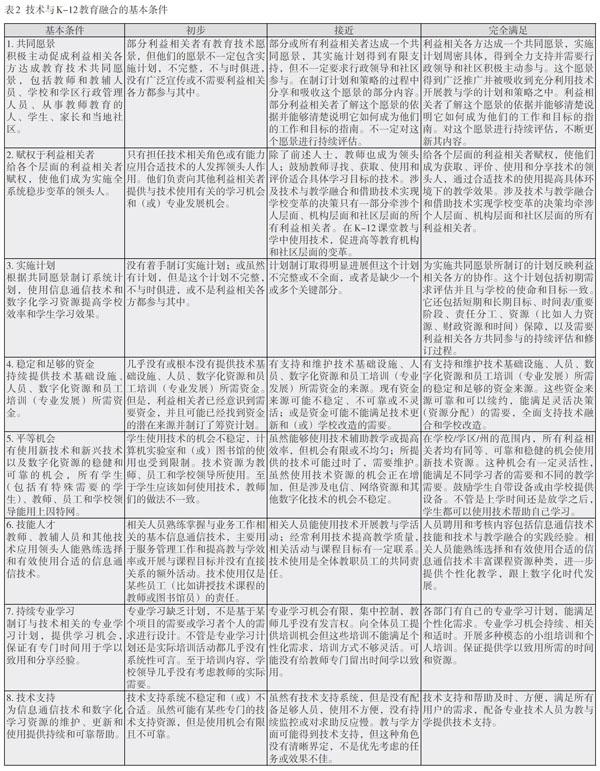

为了使技术与K-12学校融合的基本条件更加具体化,专家们编制了一个评价量规,该量规有4栏,第1栏是基本条件,其他栏目分别描述在何种程度实现了基本条件(融合):“初步”“接近”和“完全满足”。专家们对这些项目进行深入讨论并取得共识。不管是分组讨论还是全体讨论,我们均进行录音并将录音转换为文字。我们从这些讨论内容中归纳总结了主要设计原则并运用这些原则指导评价量规的编制。

2. 数据分析:归纳总结设计原则和编制评价量规

12位专家被分成4个焦点小组(focus group),每组3人(Gibbs, 2012; Moyle, 2006)。本文第一作者担任专题讨论主持人,其任务是通过提出问题引发与会者开展头脑风暴并确保所有意见记录在案。主持人为全体专家准备了一份电子壁报,运用亲和图法(affinity diagram)将专家们的最佳实践经验和意见等分门别类(Maguire & Bevan, 2002)。每个小组对每一个基本条件讨论20-30分钟,14个基本条件必须全部经过这样的讨论过程。

以焦点小组形式收集素材有利于激发集体智慧并取得共识(Gibbs, 2012; Moyle, 2006),而亲和图则是对意见/观点进行整理组织的一种工具,尤其是适合在庞杂数据中对素材进行提炼和分门别类(Maguire & Bevan, 2002)。很多情况下,若焦点小组包括不同学科的成员,即关键的利益相关各方,那么往往能够取得最佳结果。亲和图法是一个迭代过程,由3个循环往复的步骤组成:记录每一个观点(意见)、寻找似乎有关联的观点(意见)、对观点(意见)进行分类。最终我们整理出一份经过修订、更加严谨的实际做法/观点(意见),进一步理顺它们间的关系。在专题讨论结束后的一次全体会议上(历时约30分钟),各个焦点小组重点汇报各自的专题讨论结果。

为了保证我们的评价量规体现专题讨论达成共识的设计原则,我们4位作者认真研究了讨论内容,包括分组讨论和全体会议的内容,然后运用扎根理论方法对讨论内容进行编码(Strauss & Corbin, 1998)。首先,我们对第一、二次专题讨论和电子壁报上的评论进行开放式编码,目的在于发现关键词语并予以标注。然后,专家们的原话提供了合适的描述性编码术语,因此我们选择了原生代码(in vivo codes)(Holloway, 2008)。接着,研究者运用迭代和归纳法分析了全部讨论内容。在提取了初始代码之后便进行中级编码,我们反复讨论比较原始素材,不断完善编码结果(详见下一节)。

四、研究结果

如上所述,本研究有两个目的:① 制订自我评估K-12教育采用和融合数字化技术情况的评价量规的设计原则;② 运用这些设计原则编制一个评价量规。

1. 评价量规设计原则

我们运用扎根理论的持续比较法(constant comparative method)(Strauss & Corbin, 1998)分析收集到的数据(讨论内容),从中归纳出6条设计原则。它们分别是:迭代评估、避免重叠、统一语言、与时俱进、简洁和普遍性。

(1)迭代评估

专家们希望这个评价量规不是用于呈现基本条件的大致内容。对于使用这个评价量规进行自我评估的人而言,他们必须明白在满足相关要求之后还要继续努力以维持良好水准。这点很重要,因此,为了突出这一点,我们在评价量规相应之处强调对照基本条件的评估是一个持续过程。比如,在“完全满足”“考核与评估”基本条件一栏(见表2),有两处提到迭代评估:“……日常经常启动并评估这些程序,不断完善。有证明表明信息通信技术和数字化资源与教学有效融合,持续评估融合情况,不断改进完善。”

(2)避免重叠

如上所述,每个焦点小组必须对14个基本条件逐一进行讨论,但是在讨论某一个基本条件的过程中很容易牵扯其他问题(基本条件),偏离中心话题(即没有集中讨论某一个基本条件)。比如,在讨论“共同愿景”时,一个专家在电子壁报上写道:“不少讨论与另外一个基本条件‘实施计划重叠了,我们应该加以区分,集中讨论愿景。”显然,这个观点是对的,因为“实施计划”单独成为一个基本条件,因此不应该在讨论“共同愿景”的时候涉及“实施计划”的问题。因为大家意识到这种情况很容易发生,因此在编制评价量规的时候特别注意各个项目的内容仅聚焦某一个基本条件,避免出现内容重叠。

(3)统一语言

如上所述,一共有12位专业人士参加专题讨论。在讨论过程中,有时会出现大家用不同术语谈论同一件事的情况。由此可见,统一规范评价量规的相关用语很有必要,以避免表述混乱。

(4)与时俱进

技术一直处于发展之中,技术在学校中的用途正在经历快速变化,与技术有关的用语也在快速变化,因此,我们认为评价量规的语言应该是时下现代社会最新用语,否则,过不了几年这个评价量规的语言就显得过时了。比如,“技能人才”这个基本条件中,我们使用了“数字化时代”这种表述(见表2)。一开始我们用的是“21世纪”,有一个专家提出质疑,他说:“我个人宁愿放弃‘21世纪这种表述,我主张把它改为‘数字化时代。21世纪现在已经过去10多年了,因此,‘21世纪是一种过时的表述。”经过大家的讨论,最终我们决定放弃“21世纪”这种表述,改用“数字化时代”。克朗普顿(Crompton, 2013)不无惋惜地指出在采用数字化技术方面学校落后于社会。我们强调与时俱进使用现代用语,这可能有助于更新教师的语言,使他们在今后碰到这些“新”语言的时候不会望而却步,最终可能有助于缩小学校与社会之间的数字鸿沟。

(5)简洁

蒂尔尼和西蒙(Tierney & Simon, 2004)指出对绩效进行质性描述的重要性。我们的评价量规包含质性描述,但是根据鲁斯特(Rust, 2002)的“用户友好”原则,描述应该避免冗长,因此我们尽量做到简明扼要。

(6)普遍性

普遍性与简洁相关。我们的评价量规旨在服务各种类型的K-12学校(包括私立的、特殊的、主流的和其他各种类型的学校),甚至还可能为高等教育机构所采用。另外,因为这些基本条件在国际上得到广泛使用,专家们意识到北美以外的学校有不同的教育基础设施。因此,我们在表述绩效标准的时候尽量避免仅针对某一(些)具体学校的情况,否则有可能适合某些学校但却不适合其他学校。当然,适当的针对性还是必要的,这样才能使这个评价量规的个人用户、团体或组织用户能够对照绩效评价标准对号入座评估自己学校的情况。

2. 基本条件评价量规

我们的评价量规使用方便(见表2)。这个评价量规最靠右的一栏描述完全满足某一个基本条件的观测点。比如,完全满足第一个基本条件“共同愿景”的观测点是利益相关各方能够清楚说明这个愿景如何指导他们的工作以及是否对这个愿景进行迭代评估。“共同愿景”这个基本条件的一个物品(artifact)是清晰描述共同愿景的计划书。哈德逊(Hudson, 2005)与蒂尔尼和西蒙(Tierney & Simon, 2004)认为评价指标必须具体,而波帕姆(Popham, 1997)则认为具体的绩效标准应该是可以观察到的,因此,我们要求这些观测点必须建立在实际行动和物品上。此外,我们把是否满足基本条件分为3个等级:“初步”“接近”和“完全满足”(分别是第二、三和四栏),方便用户对照这些标准进行自我评估。波帕姆(Popham, 1997)认为分级评价对评价量规而言是必不可少的。这个评价量规非常详细,有助于K-12教师和研究者评估技术与教育融合的情况和发现自己学校的潜在问题。这个评价量规还有助于用户发现学校在技术使用的方便性方面的问题(比如计算机实验室和/或图书馆设施)以及教师在要求学生使用技术开展学习方面可能存在的不一致做法。

五、讨论

本研究是K-12教育工作者和有各种专长背景的学者紧密协作的结果。上一节所阐述的设计原则和评价量规得益于专家们的集思广益和最佳实践经验,并且经过了验证和整理(焦点小组、亲和图),这在一定程度上保证其效度。技术与教育的融合及其评估牵涉众多利益相关者,而本研究的参与者则代表这些群体(比如技术专家、学科专家和K-12教师),换言之,本研究的参与者代表这个评价量规的服务对象。这点是我们编制的评价量规和设计原则(比如“统一语言”和“普遍性”原则)与先前相关研究不同之处。

虽然我们早已知道技术与教育融合的基本条件,但是今天的技术仍然没有被有效融合到K-12学校中(Crompton, 2013)。导致这种局面的原因多种多样,但是我们有理由认为主要原因是利益相关各方不懂得如何有效对照基本条件评估自己学校的技术融合情况。他们可能不清楚这些基本条件具体包含哪些内容。用户不但可以使用我们的评价量规评估自己学校的情况,他们还可以运用这个评价量规的设计原则编制适合具体教育环境的评价量规,以达成更有效促进技术与教育融合的目的。

根据相关指导原则(Egodawatte, 2010; Hudson, 2005; Moskal, 2000; Oakleaf, 2009; Penny & Murphy, 2009; Popham, 1997; Rust, 2002; Tierney & Simon, 2004)并遵循我们自己归纳总结出来的设计原则,我们编制了这个评价量规。它是一种描述性分级评价工具,其绩效标准清晰界定。本研究在实践和政策层面有诸多启示。

任何评价量规所提供的信息都会直接影响具体评估观测点和(或)物品的确定。换言之,它指导评估者寻找观测点。此外,如果某个教育机构处于“初步”或“接近”满足基本条件的水平,一个设计科学的评价量规(不管是本研究的评价量规还是运用本研究设计原则编制的其他评价量规)必将能指导评估对象采取进一步措施落实基本条件,最终达到“完全满足”基本条件的水平。

评价量规可供政府官员、决策者、教学设计者、实践者和家长使用,帮助他们更好地了解技术与教育的融合需具备什么条件,以及就本研究而言,教育机构需要具备什么条件才能最大限度地发挥数字化技术扩大K-12教育环境下的学习机会和提高学习效果的能力及潜在优势。虽然本研究不是针对技术与高等教育的融合,但是我们的评价量规和设计原则在多数情况下同样可以适用于高等教育环境。

本研究的结果有助于促进技术与K-12教育的融合,但也有一些局限。比如,一个重要缺陷是研究过程缺乏学生的声音。当然,不可否认,参加本研究的专家们接触过数以千计的学生,有丰富教学经验,因此,从某种程度上弥补了缺乏学生声音的不足。另外,虽然参加本研究的专家们代表不同利益相关者,我们希望有更多教育界人士评审这个评价量规及其设计原则,并提出改进意见,使我们的评价量规和设计原则更加稳健。我们拟通过这个评价量规的实际应用,进一步收集世界各地教育工作者的意见和建议,使之得到不断完善。我们也期望在不同教育环境中检验这些设计原则的适用性。本课题的下一阶段工作将通过各种质性和量化方法完善这个评价量规及其设计原则。

六、结束语

本研究旨在制订技术与K-12教育融合评价量规的设计原则并运用这些原则编制一个评价量规。我们从所收集到的素材中归纳总结了6条设计原则——迭代评估、避免重叠、统一语言、与时俱进、简洁和普遍性,并据此编制了一个可用于自我评估的评价量规。如上所述,这个评价量规使用方便,表述清晰,既能客观评估技术与K-12教育融合的现状,也有助于用户发现不足并明确今后努力方向。我们相信本研究的成果对教育(尤其是K-12教育)利益相关各方有现实指导意义。

[参考文献]

Becker, H. J. (2000). Findings from the teaching, learning, and computing survey: Is Larry Cuban right? Education Policy Analysis Archives, 8(51), 1-35.

Bereiter, C., &Scardamlia, M. (2006). Education for the knowledge age. In P.A. Alexanders & P. H. Winne (Eds.), Handbook of Educational Psychology (2nd ed., pp. 695-713). Mahwah, NJ: Lawrence Erlbaum.

Bingimlas, K. A., (2009). Barriers to the successful integration of ICT in teaching and learning environments: A review of the literature. Eurasia Journal of Mathematics, Science and Technology Education 5(3), 235-245.

Common Core State Standards Initiative. (2010, June). Reaching higher: The common core state standards validation committee. A report from the National Governors Association center for best practices and the council of chief state school officers. Retrieved December 30, 2014,from http : // www.corestandards.org / assets / CommonCoreReport_6.10.pdf

Crompton, H. (2011). Mathematics in the age of technology: There is a place for technology in the mathematics classroom. Journal of the Research Center for Educational Technology, 7(1), 54-66.

Crompton, H. (2013). A historical overview of mobile learning: Toward learner-centered education. In Z. L. Berge & L. Y. Muilenburg (Eds.), Handbook of mobile learning (pp. 3-14). Florence, KY: Routledge.

Egodawatte, G. (2010). A rubric to self-assess and peer-assess mathematical problem solving tasks of college students. ActaDidacticaNapocensia 3(1), 78.

Ely, D. P. (1999). Conditions that facilitate the implementation of educational technology innovations. Educational Technology, 39, 23-27.

Gibbs, A. (2012) Focus groups and group interviews. In J. Arthur, M. Waring, R. Coe, & L. V. Hedges (Eds) Research methods and methodologies in education. (pp. 186-192). Thousand Oaks: Sage.

Grabe, M. &Grabe, C. (2007). Integrating technology for meaningful learning. Boston; Houghton Mifflin.

Greenhow, C., &Robelia, B. (2009). Web 2.0 and classroom research: What path should we take now? Educational Researcher, 38(4), 246-259.

Hew, K. F. & Brush, T. (2007). Integrating technology into k-12 teaching and learning: Current knowledge gaps and recommendations for future research. Education Technology Research Development 55, 223-252.

Holloway, I. (2008). A-Z of qualitative research in healthcare (2nded.). Oxford: Blackwell.

Honey, M., Culp, K. M., Carrigg, F. (2000). Perspectives on technology and educational research: Lessons from the past and present, Educational Computing Research, 23(1), 5-14.

Hramiak, A. &Boulton, H. (2013). Escalating the use of Web 2.0 technology in secondary schools in the United Kingdom: Barriers and enablers beyond teacher training. The Electronic Journal of e-Learning 11(2) 91-100.

Hudson, P. (2005). Analysing pre-service teachers rubrics for assessing students learning in primary science education. In Proceedings of the Australian Curriculum Studies Association, University of the Sunshine Coast, Queensland, Australia. Retrieved May 9, 2014 from http://eprints.qut.edu.au/secure/00002102/05/1._Assessment_paper_ ACSA.doc

International Society for Technology in Education (ISTE), (2009). Essential Conditions. Retrieved May 9, 2014 from http://www.iste.org/docs/pdfs/netsessentialconditions.pdf?sfvrsn=2

Jonassen, D., Howland, J., Marra, R., &Crismond, D. (2008). Meaningful learning with technology (3rd ed.). Upper Saddle River, NJ: Pearson.

Lock, J. V., & Redmond, P. (2006). International online collaboration. Modeling online learning and teaching. MERLOT Journal of Online Learning and Teaching, 2(4), 233-247.

Maguire, M. and Bevan, N. (2002). User requirements analysis: A review of supporting methods. In Proc. IFIP 17th World Computer Congress. Kluwer Academic Publishers, 133-148.

McCormick, A. C. (Ed.; 2001). The Carnegie classification of institutions of higher education,2000 edition. Menlo Park, CA: The Carnegie Foundation for the Advancement of Teaching.

Moskal, B. M. (2000). Scoring rubrics: What, when, and how? Practical Assessment research & Evaluation 7(25).

Moyle, K. (2006). Using emerging technologies in focus group interviews. In S. N. Hesse-Biber (Ed). The handbook of emerging technologies in social research. (pp. 320-341). New York: Oxford University Press.

Norris, C., Smolka, J., &Soloway, E. (2000). Extracting value from research: A guide for the perplexed. Technology & Learning, 20(11), 45-48.

Oakleaf, M. (2009). Using rubrics to assess information literacy: An examination of methodology and inter-rater reliability. Journal of the American Society of Information Science and Technology 60(5), 969-983.

Penny, L., & Murphy, E. (2009). Rubrics for designing and evaluating online asynchronous discussions. British Journal of Educational Technology 5(40), 804-820.

Popham, W. J. (1997). Whats wrong-and whats right-with rubrics. Educational Leadership 55, 72-75.

Razaghi, M. E. (2014). To identify and explain the barriers to application of information technology (IT) in physical education courses in schools (case study). Journal of Sport Sciences 5(2), 1-10.

Rogers, P. L. (2000). Barriers to adopting emerging technologies in education. Journal of Educational Computing Research, 22(4), 455-472.

Rust, C. (2002). The impact of assessment on student learning: How can the research literature practically help to inform the development of departmental assessment strategies and learner-centered assessment practices? Active Learning in Higher Education 3(2), 145-158.

Shuldman, M. (2004). Superintendent Conceptions of Institutional Conditions that Impact Teacher Technology Integration. Journal of Research on Technology in Education, 4(36), 319-343.

Strauss, A., & Corbin, J. M. (1998). Basics of qualitative research: Techniques and procedures for developing grounded theory (2nd ed.). Thousand Oaks, CA: Sage.

Stuart, L. H., Mills, A. M., & Remus, U. (2009). School leaders, ICT competence and championing innovations. Computers and Education, 53(3), 733-741.

Tierney, R., & Simon, M. (2004). Whats still wrong with rubrics: Focusing on the consistency of performance criteria across scale levels. Practical Assessment Research & Evaluation 9(2). Retrieved from http://pareonline.net/

Zach, L., & Agosto, D. E. (2009). Using the online learning environment to develop real-life collaboration and knowledge-sharing skills: A theoretical discussion and framework for online course design. MERLOT Journal of Online Learning and Teaching, 5(4).

Zhao, Y., Pugh, K., Sheldon, S. & Byers, J. L. (2002). Conditions for classroom technology innovations. Teachers College Record 3(104), 482-515.

收稿日期:2016-03-21

定稿日期:2016-03-25

作者简介:海伦·克朗普顿(Helen Crompton)博士,美国弗吉尼亚州欧道明大学(Old Dominion University)达登教育学院(Darden College of Education)教学技术助理教授,联合国教科文组织和国际电信联盟 (移动学习) 顾问。

米海尔·N·吉安纳克斯(Michail N. Giannakos)博士,挪威科技大学(Norwegian University of Science and Technology)计算机与信息科学系副教授。

布兰顿·M·巴特勒(Brandon M. Butler)博士,美国弗吉尼亚州欧道明大学达登教育学院社会学科教育副教授。

洛蕾塔·H·乌尔默(Loreta H. Ulmer)博士,美国弗吉尼亚州欧道明大学学习与教学中心教学技术助理教授。

译者简介:肖俊洪,汕头广播电视大学教授,Distance Education (Taylor & Francis)期刊副主编,System: An International Journal of Educational Technology and Applied Linguistics (Elsevier)编委。

责任编辑 郝 丹