基于人眼注视非穿戴自然人机交互*

2016-10-13王佳雯管业鹏

王佳雯,管业鹏

(上海大学通信与信息工程学院,上海200444)

基于人眼注视非穿戴自然人机交互*

王佳雯,管业鹏*

(上海大学通信与信息工程学院,上海200444)

提出了一种基于人眼注视的非穿戴自然人机交互新方法。基于人体生物结构特征,采用主动形状模型确定人眼轮廓特征点,并根据HSV色彩空间构建人眼特征直方图,采用粒子滤波法,对人眼目标跟踪与定位。基于最大三角化划分人眼轮廓特征,构建人眼几何模型,通过图像帧间均值滤波,确定人眼注视交互目标,实现非穿戴的人机交互,满足用户交互的灵活性、舒适性和自由性等要求。通过实验对比,验证了该方法有效、可行。

人机交互;非穿戴;三角化划分;人眼几何模型;人眼注视

随着计算机应用的日益普及,人机交互技术已成为人们工作、学习与生活的重要组成部分,研究“以人为中心”的自然、和谐与高效的人机交互技术,日益受到人们的高度重视[1]。

目前,使用常规输入设备(如键盘、鼠标和触摸屏等)进行输入的人机交互过程,不仅单调、呆板,且具有一定的局限性。随着计算机技术的迅猛发展,交互方式更加多元化,出现了Kinect、Xtion Pro、Leap Motion以及Google Glass等基于视觉、听觉、触觉及其多模态(亦称为通道)的体感交互设备。其中,Ki⁃nect、Xtion Pro虽可获取稳定的人体骨架点,但有效确定人体侧面骨架以及人体的细微关节点(如手指尖)困难;Leap Motion虽可获取稳定的手指尖位置,但仅能进行有限近距离的人机交互;Google Glass虽集成了触摸与语音信号,但交互方式为穿戴式,在一定程度上制约了人机交互的灵活性和自由性。

在人类信息的获取中,Mehrabian[2]认为93%来自于非言语。在非言语人类交互中,人脸面部特征不仅可传达丰富的视觉信息,且可通过人脸朝向显性或隐性地表达目标。基于人脸朝向的人机交互方法的关键之一,是如何有效确定人脸朝向。目前已提出了较多人脸朝向确定方法,其中,Zhang等人[4]基于机器学习各方向的人脸朝向检测器,进行人脸朝向识别,该方法虽可适用于低分辨率图像,但随着检测器的增加,训练样本分类难度将显著增加,同时,因相邻检测器之间存在串扰,导致难以有效应用于实际人机交互中;Heo和Savvides[5]基于3D人脸训练数据,获取二维投影人脸形状,利用二维人脸五官特征点,构建人脸模型估计人脸朝向,但因仅利用面部五官特征,而未充分利用人脸其他特征点,因此其人脸朝向的有效性低;Yang等人[6]基于2D/3D方向梯度直方图,通过样本训练和学习,确定人脸朝向,但该方法仅能粗略估计有限人脸朝向。在上述人脸朝向确定方法[3-6]中,均通过机器学习、训练,不仅受训练样本因素影响,且运算复杂。为克服上述不足,Beymer等人[7]采用归一化互相关和外观匹配模板,确定数据库中已有人脸朝向,但该法仅能估计离散面部朝向,且增加模板将导致计算更加耗时,因而难满足人机交互要求。其他学者虽也提出了其它不同人脸朝向确定方法[8-10],但因人脸易受多种非可控因素(如姿态、表情、光照等)影响,因此,采用人脸朝向进行人机交互,其交互性能并不理想。

相对于人脸朝向,采用视线进行人机交互则更加迅捷。其中,程成等人[11]采用线性预测眼动检测与跟踪方法,估计用户视线方向,选取前方液晶显示屏上的虚拟目标;Sugano等人[12]基于高斯过程回归,建立眼睛图像与视线交互点之间的映射关系,获取交互用户在所观察图片上的注视点。上述基于视线人机交互方法[11-12],由于微小的眼球移动,将产生较大的视线变化。为克服上述不足,基于多模态人机交互方法[13-14],则利用多种感知模态的互补性。其中,Tu等人[13]基于手势和面部朝向,控制机器人头部旋转;Carrino等人[14]则基于手势和语音与智能家居进行多模态交互,但在交互过程中,用户需穿戴摄像机与麦克风于用户手臂上,从而在一定程度上限制了用户交互的自然性和灵活性要求。

由上述分析知,目前虽已提出了基于不同交互模态或其组合的多种人机交互方法,但大多均假定交互场景中仅存在单一交互用户,且场景环境或条件可控,并限定用户仅能在指定的有限范围内活动与交互,从而在很大程度上制约了用户交互的自由性与灵活性。

针对上述不足,提出了一种新颖的基于人眼注视的非穿戴自然人机交互新方法。实验结果表明,该方法有效、可行,用户无需佩戴任何标记,通过其人眼注视方向的改变,快速控制桌面音乐播放器。

1 人眼定位与跟踪

由于主动形状模型ASM(Active Shape Model)[15]可根据人脸姿态定位人眼特征点,并适应场景光照变化,因此,文中基于ASM[15]定位人眼轮廓特征点。

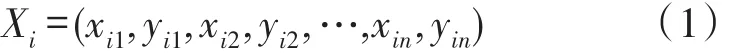

设人眼样本i的眼部具有n个特征点组成如下形状向量:

式中,(xij,yi)j分别表示第i个样本的第j个特征点坐标。

为得到n个特征点的形状变化规律,对每一样本形状向量缩放、平移和旋转,并将样本做如下归一化:

式中,P=[p1,p2,…,p2n]为主成分轴,bi[=bi1,bi2,…,bi2n]为主成分轴加权值,即人眼形状参数。

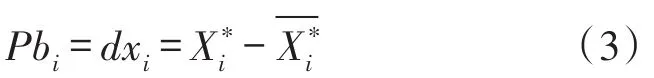

基于Viola-Jones方法[16]进行人眼检测搜索,并根据此人眼矩形拟合框的大小及位置,初始化缩放、旋转以及平移参数,得到如下初始形状特征点向量Xi:

式中,Pm[=p1,p2,…,pm]为经PCA降维后的前m主成分轴,bm为经PCA降维后的前m主成分轴的加权值。

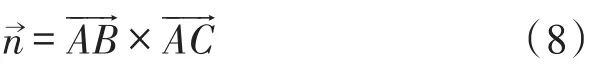

当人脸姿态发生变化时,根据式(4),对人眼特征点轮廓线法线方向搜索最佳特征点位置,并调整姿态参数(S,θ,t)以及形状参数bm,以更新形状模型。基于上述方法,提取的人眼轮廓特征点如图1(b)。

图1 人眼轮廓特征点提取

为提高基于ASM[15]人眼轮廓特征点定位的时效性,根据HSV色彩空间中的色调分量H、饱和度分量S对光照不敏感[17],建立8级色彩(H,S)分量直方图以及根据HSV色彩空间中的亮度分量V,对人眼目标区域建立8级方向梯度直方图以描述人眼目标区域的空间位置信息。按下式获取融合色彩(H、S)直方图和亮度(V)灰度梯度方向直方图的人眼特征直方图qr:

其中,C为规一化系数:

基于上述人眼特征直方图qr,采用粒子滤波方法[18],对人眼目标进行动态跟踪与定位。

2 基于人眼注视方向的目标识别

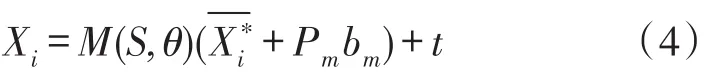

基于人眼轮廓特征点处于同一平面,根据上述确定的人眼轮廓特征点(如图1(b)),选取人眼N个轮廓特征点,描述人眼轮廓特征信息,并对N个人眼轮廓特征点进行编号(如图2(a)),以确保人眼轮廓特征间的相对位置关系不因人脸姿态变化而变化。根据3点唯一确定一空间平面,将编号的轮廓特征点进行最大三角化划分,以降低计算复杂度。同时,在三角化划分过程中,三角形不重复且三角形的3个顶点均匀分布在人眼轮廓线上,将所划成的N个三角形,构成N个相互独立的空间平面(如图2(b))。

式中,(A,B,C)为三角形的3个顶点,N为轮廓特征点的个数分别为取下底和上顶运算符,M为划分后的三角形的数量即集合的总数。

分别对三角形划分后的每一个三角形,求出其所在平面的法向量:

式中,n为三角形所在平面法向量,AB和AC为三角形所在平面的向量,×为向量叉乘运算符。

图2 基于人眼轮廓特征点的网格化

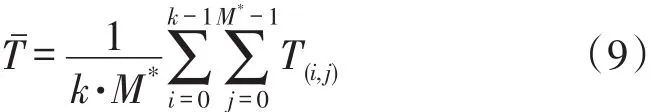

由于脸部以及人眼不可避免地存在波动,导致基于人眼部位不同三角形求得的交互目标空间点,难汇聚到同一交互点。为克服上述影响,采用剔除极值法,剔除基于M个三角形所确定的TM点中最大和最小各20%的数据T,保留剩余的M*个TM*点。同时,为克服因人眼注视在图像帧之间的交互目标点T波动,对k帧图像的T点做如下帧间均值滤波,以确定稳定的人眼注视交互目标空间点Tˉ:

式中,T(i,j)为基于当前图像帧的前第i帧的第j个三角形平面求解出的交互目标空间点,k为帧间均值滤波帧数(将后续讨论、说明)。

3 实验结果与分析

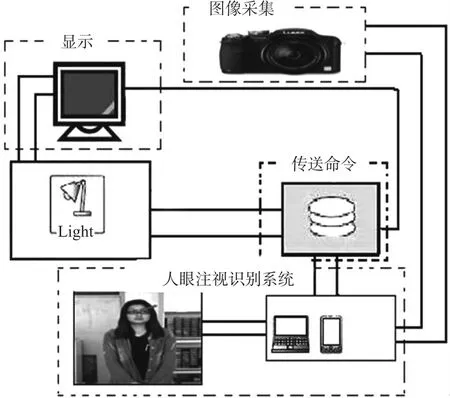

为验证所提方法的有效性,基于如图3所示的实验装置进行实验,并采用多人工作与学习的实验室作为人机交互场景。场景中的用户无需佩戴任何有助于特征识别的标志物,按照各自交互习惯,通过其人眼注视方向,控制音乐播放器。

图3 基于人眼注视人机交互实验装置示意图

3.1参数讨论与分析

由上述分析知:式(9)中的滤波帧数k对注视交互目标的确定存在一定程度影响,取值过大易导致交互目标空间点-T收敛慢,取值过小则易引起交互目标空间点-T不稳定。

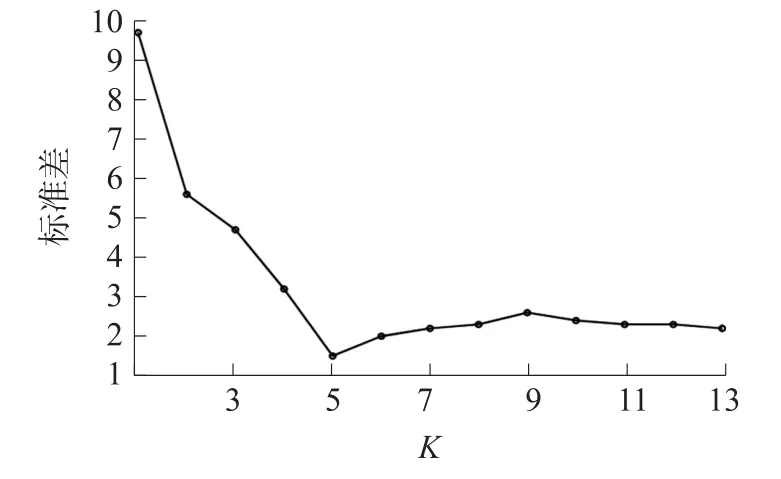

为获取合适的k值,基于图3所示的实验装置进行实验。采用交互目标空间点-T的标准差,表征交互目标空间点的稳定性。标准差越小,表明交互目标空间点越稳定。其中,所得实验结果如图4。

图4 注视交互目标空间点标准差随参数k的变化

由图4知,当k=5时,交互目标空间点T-标准差最小,且当k>5后,交互目标空间点T-标准差变化幅度趋于稳定。因此,取k=5,并在实验中保持不变。

3.2交互目标识别结果分析

为验证所提方法在实际交互场景下确定交互目标的有效性,基于OpenCV,Pentium E3400 2.60GHz双核CPU,4.00GB RAM PC机,VS2010 C/C++编译环境,进行基于人眼注视交互的音乐播放器响应实验。其中,部分实验结果如图5~图6所示。

图5 不同尺度下的人眼注视音乐播放器交互响应结果

图5中交互用户位于不同位置,通过其人眼注视桌面音乐播放交互屏的不同控件,自左至右,由上至下,分别控制音乐播放器的播放、音量加、音量减和暂停。

由图5部分交互结果知:交互用户处于不同位置,通过其人眼注视方向,有效地控制了音乐播放器的相应响应。

图6中的交互用户,通过其人眼注视桌面音乐播放交互屏的不同控件时,分别受到交互用户背面的日光灯及其右侧窗口自然光及其镜面反射光等光照变化影响。在上述不利光照因素影响下,由图6部分交互结果知:交互用户通过其人眼注视方向,有效地确定了音乐播放器的播放、音量加、音量减和暂停(见图6自左至右,由上至下交互响应结果)。

图6 不同光照下的人眼注视音乐播放器交互响应结果

上述部分实验结果,定性地表明本文方法有效、可行。

为进一步定量评价所提方法有效性,在同一实验环境下,分别与文献[11,13]进行基于分辨率为640 pixel×480 pixels的视频图像的交互目标识别和每帧处理耗时统计的实验对比,对比结果如表1所示。

表1 不同交互方法定量对比

由表1实验对比结果知,所提方法具有高的交互目标识别率和快速的交互时效性。主要原因分析如下:文献[11]通过提取眼球瞳孔及角膜对红外光的反光点位置,根据观察者头部位置进行映射函数标定,确定瞳孔-反光点向量的注视点位置。由于眼球瞳孔及其角膜位置的有效获取与光源及其光照条件关联,且映射函数的有效标定,在很大程度上取决于交互用户头部姿态的有效确定;文献[13]基于面部识别和手势动作进行人机交互,根据交互用户眼和嘴唇中心确定头部姿态,因此,其头部姿态的有效性,在很大程度上取决于人眼和嘴唇中心的有效确定,且所采用的手势动作因存在多样性与多义性,因此,其交互目标的识别率低且交互时间长;而所提方法则基于人眼注视进行交互时,采用最大三角化划分人眼轮廓特征,构建人眼几何模型并确定人眼注视方向,用户交互真实意图与人的视线方向一致性强,因而,交互目标的识别率高且交互响应快捷。

4 结论

针对目前人机交互方法存在的不足,提出了一种基于人眼注视的非穿戴自然人机交互新方法,用户无需佩戴任何标记,且其活动不受约束,满足交互活动的舒适性和自然性要求。基于人类生物结构特征,采用ASM确定人眼轮廓特征点,并根据HSV色彩空间中的各色彩和亮度信息,构建综合反映人眼纹理及其空间位置的人眼特征直方图,采用粒子滤波方法,对人眼目标进行动态跟踪与定位,提高人眼轮廓特征点定位的时效性。利用最大三角化划分人眼轮廓特征,构建人眼几何模型并确定人眼注视方向,提高人机交互的活动自由度。通过图像帧间的均值滤波确定人眼注视交互目标,以提高基于人眼注视人机交互的正确性和鲁棒性。实验结果表明,该方法有效、可行。

[1]管业鹏.基于多模态视觉特征的自然人机交互[J].电子学报,2013,41(11):2223-2229.

[2]Mehrabian A.Communication without Words[J].Psychology To⁃day,1968,2(4):53-56.

[3]Ma Y,Konishi Y,Kinoshita K,et al.Sparse Bayesian Regression for Head Pose Estimation[C]//Proceedings of International Con⁃ference on Pattern Recognition,2006,3:507-510.

[4]Zhang Z,Hu Y,Liu M,et al.Head Pose Estimation in Seminar Room Using Multi View Face Detectors[C]//Proceedings of Inter⁃national Conference on Multimodal Technologies for Perception of Humans,2007:299-304.

[5]Heo J,Savvides M.Generic 3D Face Pose Estimation Using Fa⁃cial Shapes[C]//Proceedings of International Conference on Bio⁃metrics,2011:1-8.

[6]Yang J L,Liang W,Jia Y D.Face Pose Estimation with Combined 2D and 3D HOG Features[C]//Proceedings of IEEE Conference on Pattern Recognition,2012:2492-2495.

[7]Beymer D J.Face Recognition under Varying Pose[C]//Proceed⁃ings of IEEE Conference on Computer Vision and Pattern Recog⁃nition,1994:756-761.

[8]ChengLP,HsiaoFI,.LiuYT,etal.iRotate:AutomaticScreenRota⁃tion Based on Face Orientation[C]//Proceedings of SIGCHI Confer⁃enceonHumanFactorsinComputingSystems,2012:2203-2210.

[9]Ratsamee P,Mae Y,Ohara K,et al.Social Navigation Model Based on Human Intention Analysis Using Face Orientation[C]// Proceedings of IEEE/RSJ International Conference on Intelligent Robots and Systems,2013:1682-1687.

[10]Dong N,Zeng X,Guan L.Face Orientation Detection Using Histo⁃gram of Optimized Local Binary pattern[M].The Era of Interac⁃tive Media,2013:77-87.

[11]程成,杜菁菁,蓝飞翔.眼动交互的实时线性算法构造和实现[J].电子学报,2009,37(B04):12-15.

[12]Sugano Y,Matsushita Y,Sato Y.Appearance-Based Gaze Estima⁃tion Using Visual Saliency[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(2):329-341.

[13]Tu Y J,Kao C C,Lin H Y.Human Computer Interaction Using Face and Gesture Recognition[C]//Proceedings of IEEE Interna⁃tional Conference on Signal and Information Processing,2013:1-8.

[14]Carrino S,Péclat A,Mugellini E,et al.Humans and Smart Envi⁃ronments:A Novel Multimodal Interaction Approach[C]//Proceed⁃ings of ACM International Conference on Multimodal Interfaces,2011:105-112.

[15]Cootes T F,Taylor C J,Cooper D H,et al.Active Shape Models-Their Training and Application[J].Computer Vision and Image Understanding,1995,61(1):38-59.

[16]Viola P,Jones M.Robust Real-Time Face Detection[J].Interna⁃tional Journal of Computer Vision,2004,57(2):137-154.

[17]Guan Y P.Spatio-Temporal Motion Based Foreground Segmenta⁃tion and Shadow Suppression[J].IET Computer Vision,2010,4 (1):50-60.

[18]Liu J,Liu D,Dauwels J,et al.3D Human Motion Tracking by Ex⁃emplar-Based Conditional Particle Filter[J].Processing Signal,2015,110(S1):164-177.

王佳雯(1993-),女,浙江慈溪人,上海大学通信与信息工程学院本科生,主要感兴趣研究方向为智能人机交互与视频监控;

管业鹏(1967-),男,湖北孝感人,上海大学通信与信息工程学院教授,博导,主要感兴趣方向为智能人机交互、大数据科学计算与决策、计算机视觉与模式识别等,ypguan@shu.edu.cn。

Gazing Based Non-Wearable and Natural Human-Computer Interaction*

WANG Jiawen,GUAN Yepeng*

(School of Communication and Information Engineering,Shanghai University,Shanghai 200444,China)

A novel non-wearable and natural human-computer interaction(HCI)method has been proposed based on eye gazing.According to human being biological structure characteristics,an active shape model is employed to locate some feature points in the eye profile.A histogram of eye feature has been built according to the HSV color space.A particle filter method has been adopted to track and locate the eye.A 2D eye geometric model is constructed based on the maximal triangulation of the eye contour features.A temporal median filter strategy has been developed to determine a stable gazing interactive target.Non-wearable and natural HCI modal is realized in which the user can move flexibly both in comfort and freedom interactive ways.Experiment results indicate that the developed approach is efficient and can be used to natural non-wearable HCI.

human-computer interaction;non-wearable;triangulation;eye geometric model;eye gazing

R339.14;TP242.62

A

1005-9490(2016)02-0253-05

EEACC:7510D;6140C10.3969/j.issn.1005-9490.2016.02.004

项目来源:国家自然科学基金项目(11176016,60872117);高等学校博士学科点专项科研基金项目(20123108110014)

2015-05-12修改日期:2015-06-24