图像自动标注技术研究进展

2016-09-29刘梦迪陈燕俐陈蕾

刘梦迪 陈燕俐 陈蕾

摘要:现有图像自动标注技术算法可以大致划分为基于语义的标注算法、基于矩阵分解的标注算法、基于概率的标注算法以及基于图学习的标注算法等四大类。介绍了各类别中具有代表性的图像自动标注算法,分析了这些算法的问题模型及其功能特点,并归纳了图像自动标注算法中主要的优化求解方法及算法评价中常用的图像数据集和性能评价指标。最后,指出了图像自动标注技术目前存在的主要问题,并且提出了这些问题的解决思路。分析结果表明,对于图像自动标注技术的研究,可充分利用现有算法的优势互补,或借助多学科交叉的优势,寻找更有效的算法。

关键词:图像检索;图像自动标注;标签填补;标签去噪;标签预测

中图分类号:TN911.73; TP391.413

文献标志码:A

0引言

随着数码技术和互联网技术的迅速发展,出现了大量的社会化多媒体共享平台,海量的图像资源被用户共享到这些平台上,人类进入了大数据时代。在如此大规模的图像资源中,为了有效地管理和查询所需资源,图像检索技术出现在人们的视线中,成为了计算机领域的研究热点之一。计算机领域的研究人员从不同角度对其进行了大量研究。20世纪70年代末期,基于文本的图像检索(Text-Based Image Retrieval, TBIR)技术[1]作为最早的图像检索技术出现。TBIR的图像标签需要手工标注,面对图像数据库的增长,消耗大量人力和物力资源,不适用于图像数量巨大的数据库。不过当时获取图像设备比较昂贵,图像集数目比较小,早期的TBIR技术能够满足当时的需求。

20世纪90年代初,为了克服TBIR技术的缺陷,出现了基于内容的图像检索(Content-Based Image Retrieval, CBIR)技术[2],CBIR可以自动提取图像视觉特性,不需要人工干预,并且使用计算机自动实现对颜色、形状、纹理等低层视觉特征的提取和存储。低层视觉特征主要是从颜色特征、纹理特征、形状特征和空间关系特征这4方面[3]进行特征提取。针对不同的应用情况,CBIR可以采用任意不同的特征或特征组合来描述图像的视觉内容,但是,CBIR仍然存在一些问题:底层视觉特征多样性使刻画较强的视觉特征成为难题,而且在低层视觉特征和高层语义特征之间存在“语义鸿沟”的缺陷。

进入21世纪以来,互联网技术发展迅速,网页数量成倍增长,图像资源成倍增加。TBIR技术的巨大工作量和CBIR技术的“语义鸿沟”对图像检索的影响逐渐变大,它们已经不能很好地满足用户进行图像检索的需求。于是,Kulkarni[4]从关联性的思想出发,提出了基于联想的图像检索(Association-Based Image Retrieval, ABIR)技术。ABIR技术采用双向联想记忆模型来存储图像的关联关系[5]。ABIR技术不够成熟,不太适用于实际应用。由于用户习惯于使用标签进行需求查询,并且现有的互联网搜索引擎大都是提供基于文本的图像检索;但是人工标注的高代价、主观性和不完整性影响了图像标注的精确性,使得图像检索的效率降低。为了解决这一问题,图像自动标注(Automatic Image Annotation, AIA)技术逐渐发展起来,并成为了诸多研究者关注的热点。AIA技术[6]可以利用已标注的图像集或其他可获得的信息自动学习语义概念空间与视觉特征空间的关系模型,并用此模型标注未知语义的图像;而且通过在图像的高层语义特征和底层特征之间建立一种映射关系,它可以解决一定程度的“语义鸿沟”问题。互联网图像自动标注技术的难点主要集中在3方面:1)互联网标注者的复杂性。图像标签的标注者为互联网用户,他们来自不同的国家、拥有不同的文化背景和不同的性格特点,这些差异导致图像标注因人而异,从而决定了图像和标签之间的复杂对应关系,增加了图像标注问题的复杂性。2)互联网图像标签的缺失性和多义性。互联网用户往往对图像标注不完整,这大大降低了图像检索的精确度。标签也具有一词多义性和多词一义性,导致标签语义的丰富性,从而进一步加大了图像标注问题的难度。3)互联网图像视觉内容的多样性。不同的互联网用户因各种自身因素和外部因素的影响,使同一标签呈现出不同的图像视觉内容,这使得图像和标签之间的对应关系更加复杂。

本文根据学习方法的不同,将现有算法划分为基于语义的图像自动标注算法、基于矩阵分解的图像自动标注算法、基于概率的图像自动标注算法以及基于图学习的图像自动标注算法等,并分别介绍了各类方法中代表性算法的问题模型及其功能特点。然后给出了图像自动标注算法中主要的优化求解方法及算法评价中常用的图像数据集和性能评价指标,最后探讨了自动图像标注技术目前存在的主要问题及其解决思路。

1图像自动标注问题模型

假设I={xi∈Ri=1,2,…,n}表示图像集合,其中n表示图像数目。∈{0,1}n×m是一个二值矩阵,表示用户所提供的初始图像标签矩阵,如果标签tj标注图像xi,则ij=1,否则为0。T∈Rn×m表示最终修正的图像标签矩阵,其中m表示图像集中标签的数量。V∈Rn×d表示图像特征矩阵,其中d表示图像集中特征的数量。R∈Rm×m表示图像标签之间语义相似度组成的矩阵,Rij≥0表示标签ti和标签tj之间的语义相似度。S∈Rn×n表示图像间的视觉相似度组成的矩阵,Sij≥0表示图像xi和图像xj之间的视觉相似度。 μ、α、 β和ρ都是可调参数。

1.1基于语义的图像自动标注模型

基于语义的图像自动标注,可以利用WordNet[7]的结构化语义信息衡量词汇之间的关系,从而更好地选择适合图像内容的语义词汇,以及去除冗余的语义词。

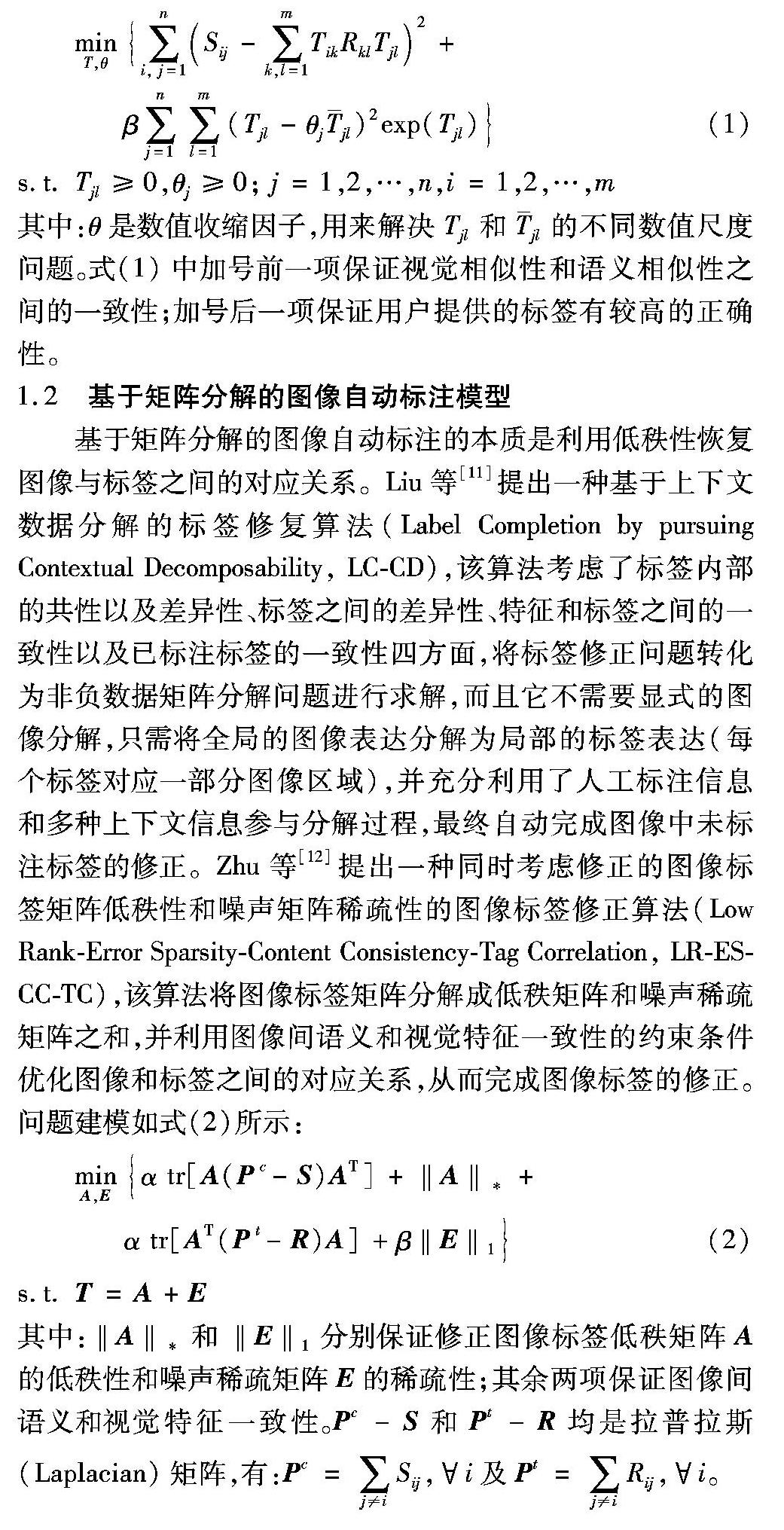

Jin等[8]提出了一种基于WordNet的图像自动标注算法(WordNet Model, WNM)。该算法根据基于翻译模型(Translation Model, TM)的方法得到每幅图像的候选标注词汇,并使用多种基于WordNet的语义度量计算每个词汇与其他所有词汇之间的语义相关度,然后根据标注结果之间的语义一致性来确定最终标注结果。Lee等[9]通过考虑标签分类和标签间的关联性提出了一种模块化标签修正算法(Modular Approach towards Tag Refinement, TR-MA),该算法先利用WordNet语义词典技术依据标签的性质将标签分为“where”“when”“who”“what”和“how”五大类,然后根据不同性质的标签使用不同标签修正方法的思想,对“what”类利用近邻投票策略计算标签之间的关联性,从而区别出与图像不相关标签并找到相关标签。Liu等[10]提出一种图像重标记方案(Image Retagging, IRetagging),该方案先利用WordNet设计有效的视觉辞典过滤掉与视觉内容无关的标签,再利用设计的优化算法对标签修正,然后利用WordNet的词汇树结构得到每个标签的同义词和上位词对其进行扩充,从而实现标签的填补与去噪,得到高质量图像标签的集合。标签修正问题建模如式(1)所示:

其中:θ是数值收缩因子,用来解决Tjl和jl的不同数值尺度问题。式(1)中加号前一项保证视觉相似性和语义相似性之间的一致性;加号后一项保证用户提供的标签有较高的正确性。

1.2基于矩阵分解的图像自动标注模型

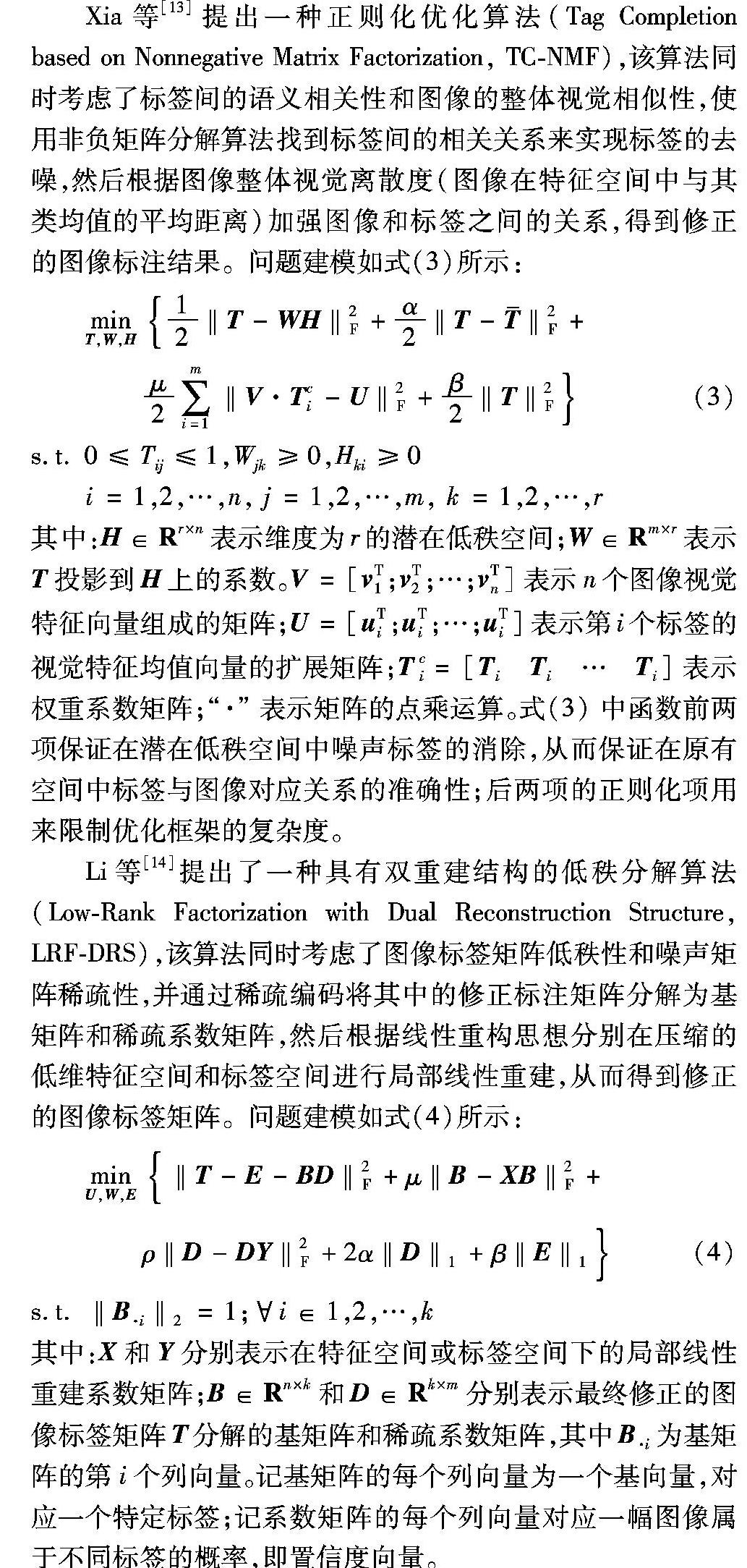

基于矩阵分解的图像自动标注的本质是利用低秩性恢复图像与标签之间的对应关系。Liu等[11]提出一种基于上下文数据分解的标签修复算法(Label Completion by pursuing Contextual Decomposability, LC-CD),该算法考虑了标签内部的共性以及差异性、标签之间的差异性、特征和标签之间的一致性以及已标注标签的一致性四方面,将标签修正问题转化为非负数据矩阵分解问题进行求解,而且它不需要显式的图像分解,只需将全局的图像表达分解为局部的标签表达(每个标签对应一部分图像区域),并充分利用了人工标注信息和多种上下文信息参与分解过程,最终自动完成图像中未标注标签的修正。Zhu等[12]提出一种同时考虑修正的图像标签矩阵低秩性和噪声矩阵稀疏性的图像标签修正算法(Low Rank-Error Sparsity-Content Consistency-Tag Correlation, LR-ES-CC-TC),该算法将图像标签矩阵分解成低秩矩阵和噪声稀疏矩阵之和,并利用图像间语义和视觉特征一致性的约束条件优化图像和标签之间的对应关系,从而完成图像标签的修正。问题建模如式(2)所示:

Xia等[13]提出一种正则化优化算法(Tag Completion based on Nonnegative Matrix Factorization, TC-NMF),该算法同时考虑了标签间的语义相关性和图像的整体视觉相似性,使用非负矩阵分解算法找到标签间的相关关系来实现标签的去噪,然后根据图像整体视觉离散度(图像在特征空间中与其类均值的平均距离)加强图像和标签之间的关系,得到修正的图像标注结果。问题建模如式(3)所示:

其中:H∈Rr×n表示维度为r的潜在低秩空间;W∈Rm×r表示T投影到H上的系数。V=[vT1;vT2;…;vTn]表示n个图像视觉特征向量组成的矩阵;U=[uTi;uTi;…;uTi]表示第i个标签的视觉特征均值向量的扩展矩阵;Tci=[TiTi…Ti]表示权重系数矩阵;“·”表示矩阵的点乘运算。式(3)中函数前两项保证在潜在低秩空间中噪声标签的消除,从而保证在原有空间中标签与图像对应关系的准确性;后两项的正则化项用来限制优化框架的复杂度。

Li等[14]提出了一种具有双重建结构的低秩分解算法(Low-Rank Factorization with Dual Reconstruction Structure, LRF-DRS),该算法同时考虑了图像标签矩阵低秩性和噪声矩阵稀疏性,并通过稀疏编码将其中的修正标注矩阵分解为基矩阵和稀疏系数矩阵,然后根据线性重构思想分别在压缩的低维特征空间和标签空间进行局部线性重建,从而得到修正的图像标签矩阵。问题建模如式(4)所示:

其中:X和Y分别表示在特征空间或标签空间下的局部线性重建系数矩阵;B∈Rn×k和D∈Rk×m分别表示最终修正的图像标签矩阵T分解的基矩阵和稀疏系数矩阵,其中B·i为基矩阵的第i个列向量。记基矩阵的每个列向量为一个基向量,对应一个特定标签;记系数矩阵的每个列向量对应一幅图像属于不同标签的概率,即置信度向量。

1.3基于概率的图像自动标注模型

基于概率的图像自动标注是通过概率统计分析图像特征和图像标签之间的共生概率关系,并以此进行图像的语义标注。Xu等[15]提出一种基于主题模型的标签修正(Tag Refinement using Topic Model, TR-TM)算法,该算法先利用正则化潜在狄利克雷分布(regularized Latent Dirichlet Allocation, rLDA)[16]图模型以一种迭代的方式联合评估标签相似性和标签关联性,然后使用k近邻算法得到相关度较高的标签,实现图像标签修正。Liu等[17]提出一种基于随机游走的标签排序(Tag Ranking based on Random Walk, RWTR)进行标签修正,该算法先用一种概率的方法估计初始图像标签相关度;然后在描述标签间关系的标签图中进行随机游走传播标签之间的相关度;最后根据相关度得分进行标签排序,保留得分高的标签并移除得分低的标签。

Lee等[18]提出一种使用概率估计方法的标签修正算法(Tag Refinement in an Image Folksonomy, TRIF),该算法先利用k近邻算法寻找一定相似图像构建每幅图像的视觉分类(Visual Folksonomy),然后在该图像的视觉分类中统计标签的分布规律和共现关系,利用统计信息推导出图像和标签之间的概率关系,并根据它们的概率与设定阈值之间的关系来清理与图像内容无关的标签。Xia等[19]提出一种基于双层聚类标签优化算法(Tag Refinement based on Bi-Layer Clustering, TR-BLC)。该算法先根据使用归一化Google距离度量的标签间相关性将图像集合分组,再通过使用稀疏近邻传播(Affinity Propagation, AP)聚类算法[20]将融合视觉相似性和语义相似性的相似图像分为更小的分组,然后对每一组图像使用共现频率和标签间的相关性建立标签与图像子集的概率关系,最后利用改进的Fisher准则判断出与图像内容无关的标签,完成图像标签的修正。该算法增强了低频出现的正确标签与图像的相关度,从而提高了图像标签的去噪能力。

1.4基于图学习的图像自动标注模型

基于图学习的图像自动标注属于半监督学习算法,即已知标注的训练数据和未知标注的测试数据一起参加图学习的算法。卢汉清等[21]提出一种基于图学习的图像标注(Image Annotation based on Graph Learning, IA-GL)算法。该算法同时考虑了图像间视觉一致性和语义一致性,它利用图像间视觉相似性构建以图像为节点的图,完成图像间视觉相似性在已标注图像到未知标注图像的传播,然后利用标注间语义关联性构建以词为节点的图完成图像标注的修正,得到最终标注结果。Liu等[22]提出一种基于图学习模型的图像标注(Two-phrases Graph Learning Model, TGLM)算法,该算法利用最近邻生成链(Nearest Spanning Chain, NSC)方法构建基于图像的图模型,然后和文献[21]中算法一样使用两个步骤进行连续学习,即基于图像的图学习获得初始图像标注和基于词汇的图学习获得图像最终标注结果。

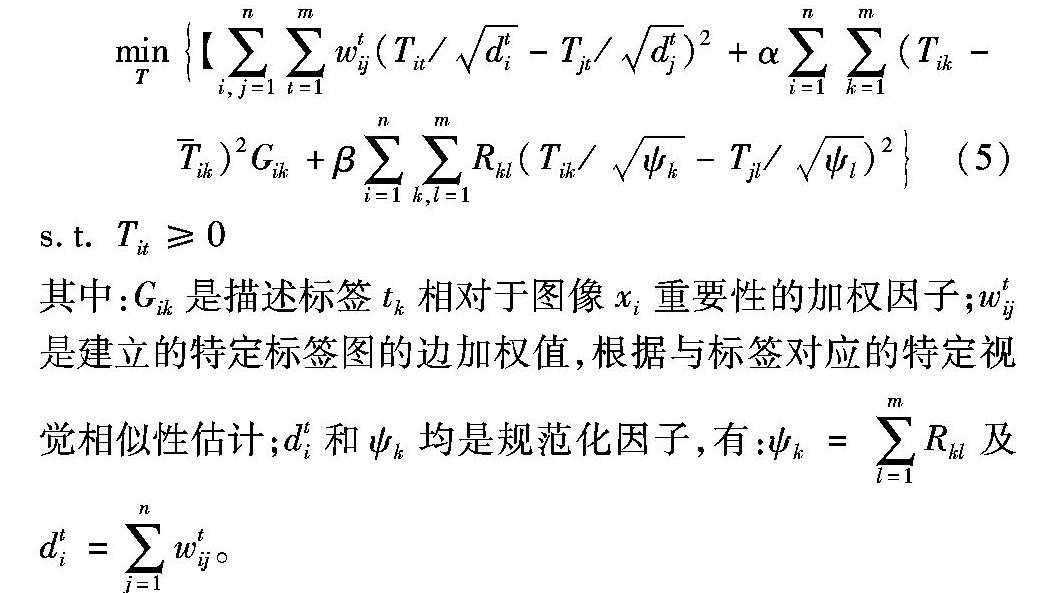

Liu等[23]对文献[17]进行改进,融入标签间的相互关系,并利用图学习的思想提出一种基于协同标记传播的标签修正(Tag Refinement based on Collaborative Tag Propagation, TR-CTP)算法。该算法将协同图像标签修正问题转化为图正则化优化问题,它先利用特定标签图像与特定标签的视觉词汇表建立相对于某一特定标签的图像相互关系,然后在多个特定标签图之间以协同的方式传播进行图像标签修正,进一步提高图像标签的质量。问题建模如式(5)所示:

Feng等[24]提出一种噪声矩阵恢复(Tag Completion by Matrix Recovery, TCMR)算法。该算法从一个未知的图像标签矩阵中选取观察标签样本,并引入图拉普拉斯统计图像特征和标签之间的依赖性,从而得到修正的图像标签矩阵,它同时实现了标签的填补和去噪。问题建模如式(6)所示:

1.5其他图像自动标注模型

Lin等[25]提出了一种线性稀疏重建(Linear Sparse Reconstructions, LSR)方案。该方案同时考虑了图像间相似性、图像标签间关联性和标签间共现性,并在稀疏性的制约下分别对初始图像标签矩阵进行特定图像和特定标签线性稀疏重建,然后根据加权线性合并策略将得到的两个图像标签矩阵进行合并,得到最终修正的图像标注结果。LSR算法可以进行已部分标注图像的补全(直推式方法)和未知标注图像的补全(归纳方法)。之后Lin等[26]又提出了一种提高效率的双视图LSR(Dual-view LSR, DLSR)方案。该方案在重建图像视图时引入重建图像时的加权向量和初始标记向量之间的差异来增加视觉上相似的图像,并对得到的两项重构标记结果进行有效的标准化和合并,得到最终图像标注结果。这两种方案均使用图像间的视觉相似性和语义相似性重建图像,使用标签间共现性重建标签,它们均可以被用来预测缺失的相关标签,从而填补图像的标签。

Wang等[27]提出一种针对图像标签补全和预测的哈希(Hashing codes for Tag Completion and Prediction, HashTCP)算法,该算法利用汉明距离对所有观测图像和标签构建紧凑的哈希编码,把标签或图像相似性问题转化为哈希编码相似性问题进行求解,实现对观测图像缺失标签的补全及对新加入图像的标签预测。问题建模如式(7)所示:

Wu等[28]提出了一种标签矩阵补全(Tag Matrix Completion, TMC)算法,该算法同时考虑图像间视觉相似性和标签间关联性,并在稀疏性的制约下,通过最小化每幅图像的标签与图像视觉内容之间的差异进行标签的补全。问题建模如式(8)所示:

Znaidia等[29]提出一种基于近邻投票和Belief理论[30]的标签补全(Tag Completion based on Belief Theory and Neighbor Voting, TC-BT-NV)算法,该算法先利用k近邻算法获取指定图像的近邻,然后根据Belief理论[30]进行近邻投票,保留标签列表中与该图像相关的标签并预测出更相关的标签,完成标签的补全。

除此之外,最近几年深度学习算法作为解决“语义鸿沟”问题的有效方法,逐步被应用到图像领域中。2012年,Krizhevsky等[31]提出一种深层次卷积神经网络(Convolutional Neural Network, CNN)结构,该结构通过使用修正线性单元(Rectified Linear Unit, ReLU)引入非线性、多图形处理器(Graphics Processing Unit, GPU)训练、局部相应正则化及重叠池提高模型训练速度,其在ImageNet评测上取得巨大突破,将结果错误率从26%降低到15%。Ciresan等[32]提出一种用于图像分类的多列深度神经网络(Multi-column Deep Neural Network, MCDNN)结构,该结构先利用GPU对分为多块的输入图像中每块训练多个深神经列,然后平均所有独立DNN输出得到结果。Srivastava等[33]提出一种基于深度信念网络(Deep Belief Network, DBN)模型的算法,该算法通过探索多模深度信念网络来学习图像标注中的表示,并通过融合含有共享隐藏表示的多个数据源来完成图像检索。Feng等[34]提出一种用于跨模式检索的通信受限玻尔兹曼机(Correspondence Restricted Boltzmann Machine, Corr-RBM)结构,该结构先将文本和图像输入投影到同一表示空间中,然后利用距离度量对待查询文本或图像和所有候选图像或文本之间的相似性进行排序,得到最终结果。杨阳等[35]提出一种深度学习的图像自动标注算法(Image Auto-annotation based on Deep Learning, IA-DL),该算法先根据深度神经元网络构建一个图像自动标注专用模型,并利用图像标签的词频信息改进深度学习模型的监督信息,得到基本图像标注结果,然后利用标记词汇的共生关系与词频先验知识来改善已得到的图像标注结果。

1.6各图像自动标注模型的对比

各图像自动标注模型的功能特点如表1所示,其中:标签填补指对已部分标注图像进行缺失标签补全;标签去噪指去除与图像对应关系有错误的标签,即那些无法描述图像视觉内容的标签;标签预测指对无标注图像进行自动标注。

2图像自动标注问题求解

分析现有图像自动标注问题的求解算法的设计技巧不难发现,目前面向图像自动标注问题求解的优化算法以一阶算法居多,具有代表性算法包括:坐标下降(Coordinate Descent, CD)算法、梯度下降(Gradient Descent, GD)算法、次梯度下降(Subgradient Descent, SD)算法、加速近邻梯度(Accelerated Proximal Gradient, APG)算法、交替方向乘子(Alternating Direction Method of Multipliers, ADMM)法等。

坐标下降算法、梯度下降算法、次梯度下降算法和加速近邻梯度算法求解的优化问题均为典型的无约束优化问题:

坐标下降算法具有如下特点:1)如果函数是凸光滑的,那么算法保证收敛;2)如果函数是非光滑的,那么算法不一定收敛;3)如果非光滑部分是可分离的,那么算法也能保证收敛,如

3图像自动标注算法评价

3.1常用图像数据集

为了进行算法的性能分析,不同类型的图像数据集被公布出来,这有效降低了研究者的工作难度,使得算法性能分析更易进行。常用的图像数据集有COREL数据集、LabelMe数据集、MSRC数据集、MIRFlickr数据集、NUS-WIDE数据集和IAPR TC-12数据集等。表2从图像数据集大小、标注类型等几个方面进行对比。

COREL数据集[36]是由商业公司COREL发布的图像数据集。为了适应不同的需求,从原始的大量图像中抽取部分图像,分别组成了COREL5K(含有5000幅图像)和COREL30K(含有30000幅图像)。本数据集中图像的标注信息是人工提供的且都是基于整幅图像的,而且给出的标注信息有具体的对象类别、场景、地点等。

LabelMe数据集[37]是由麻省理工学院计算机科学与人工智能实验室发布的,主要用来为图像自动标注算法提供训练和测试数据集。该数据集由众多志愿者进行标注,并获得了较为完整的标注结果。LabelMe数据集共有4053幅图像和65017个对象,分为训练图像数据集(包括2920幅,其中若干图像标注不完整)和测试图像数据集(包括1133幅图像,这些图像的标注较为完整)。

MSRC数据集[38]是由微软剑桥研究院发布的,主要是用来为自动对象分割和对象识别算法提供训练和测试数据集。为了能为对象分割算法提供支持,该数据集中所有图像都是使用像素级别(Pixel-Wise Level)的人工标注信息,即每个像素点都标注了对应的对象类别。该数据集共发布了两个版本:第一个版本中包含240幅图像和9个对象;第二个版本中包含591幅图像和23个对象,其中有21个对象比较常用。

MIRFlickr数据集[39]是由荷兰莱顿大学LIACS媒体实验室提供的数据库。该数据集中的图像标注信息由人工提供并含有30个标签,它比较适合于图像检索的评价。在选用该数据集时,经常选用两种大小的图像子集,分别为MIRFlickr25K和MIRFlickr1M。

NUS-WIDE数据集[40]是由新加坡国立大学的LMS媒体搜索实验提供的数据库。该数据集也是通过收集Flickr图像而构建的大规模图像数据集。该数据集是利用人工进行大量的图像标注的,并且提供了81个标签的图像标注结果。除此之外,该数据集还提供了基于数据集图像的视觉特征,如144维的颜色特征、尺度不变特征转换(Scale-Invariant Feature Transform,SIFT)特征等6种低水平的视觉特征。

IAPR TC-12数据集[41]是由国际模式识别协会(the International Association for Pattern Recognition, IAPR)TC-12技术委员会负责创建的图像数据集。原始的IAPR TC-12数据集包含20000幅自然图像,这些图像的内容涵盖了运动、人物、动物、景观和当代生活中很多方面内容。该数据集最初用作跨语言图像检索的测试平台,其中图像的初始文本信息是由英语、德语和西班牙语三种语言给定的自由文本语句。为了使IAPR TC-12数据集适合于图像标注研究,MAKADIA对原始的数据集进行改进,仅保留了英语语言的自由文本描述,并通过自然语言处理技术从中抽取自由文本中的名词词汇作为标签;同时剔除了两类图像,包括灰度图像和超低频词汇关联的图像[42]。改进后的IAPR TC-12数据集包括19805幅图像,分为训练图像数据集(包括17825幅图像)和测试图像数据集(包括1980幅图像)。整个图像集包括291个标注词汇,每幅图像平均包括4.7个词汇。

上述几种图像数据集各有特色,可以适应于不同的应用场景。从表2中可以看出,规模最大的MIRFlickr图像数据集已经达到百万级别,但是提供的标注类别数并不多。由此可以看出,数目越大的图像集越难以提供较丰富的标注信息。而像COREL数据集这些较小的数据集花费的标注代价较小,并且能提供较完整的标注信息,因此在现有绝大多数影响较大的标注算法中常被用来评价算法性能。

3.2算法性能评价指标

为了评价图像自动标注算法的性能,需要一定的性能评价准则。分析现有图像自动标注算法的性能评价指标不难发现,目前常用的评价指标有查准率(Precision)、查全率(Recall)和F1-Score、P@N(Precision@N)、平均查准率(Average Precision, AP)和平均查准率的均值(Mean Average Precision, MAP)、AP@N(Average Precision@N)以及归一化折扣累积增益(Normalized Discounted Cumulative Gain, NDCG)[43]等。

1)查准率、查全率和F1-Score。

查准率用来衡量标签查询图像的准确度,查全率用来衡量标签查询图像的成功度。根据图像和标签之间的关系,图像标注结果可以分为四种情况,如表3所示。

4结语

本文对现有图像自动标注算法进行了分析,包括算法的问题模型、问题求解方法以及算法评价中常用的图像数据集和性能评价指标等。纵观图像自动标注的发展历程,大都是根据人们对图像检索的需求,合理地在已有的算法的目标函数基础上进行改进或直接设计出新的算法,大致思想都是从图像和标签之间的各种关系出发,最小化图像自动标注过程中产生的各种误差等。

尽管研究者们已经提出了诸多图像自动标注算法,并且这些算法在其各自的数据集上表现出了良好的性能,但它们仍然存在如下不足:

1)现有图像标注算法往往无法同时兼顾标签补全和标签预测,引入机器学习领域流行的迁移学习理论或许是一种不错的解决思路。

2)现有图像自动标注算法在图像标注较丰富(或缺失的标签较少)的情形下性能表现良好;但对于那些只有极少量图像标注的情形性能将急剧下降,已有部分学者开始考虑引入机器学习领域中的主动学习技术来丰富部分图像的标签,通过主动地从用户获取知识来提高算法性能。

3)现有图像自动标注算法大多只利用了图像标签矩阵的低秩性,没有考虑图像标签矩阵所固有的稀疏性,从而一定程度上影响了算法性能,在对图像自动标注问题建模时如果能同时考虑图像标签矩阵的稀疏性与低秩性应该是一种不错的选择。

4)现有图像自动标注技术处理的问题规模有限,无法满足人们对大规模社交图像进行检索的实际需求,为了适应更大问题规模,可以将现有算法在并行环境下进行拓展。在并行实现环境的选取上,源于加州伯克利大学的Spark是近年来大数据处理的新锐代表,已经在批处理、流计算、机器学习、图计算等一系列领域得到广泛应用,尤其适用于需要多次迭代计算的图像自动标注算法,将极有可能成为图像自动标注技术首选的并行实现平台。

参考文献:

[1]DATTA R, JOSHI D, LI J, et al. Image retrieval: ideas, influ-ences, and trends of the new age [J]. ACM Computing Surveys, 2008, 40(2): Article No. 5.

[2]SMEULDERS A W M, WORRING M, SANTINI S, et al. Content-based image retrieval at the end of the early years [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(12): 1349-1380.

[3]DESELAERS T, KEYSERS D, NEY H. Features for image retrieval: an experimental comparison [J]. Information Retrieval, 2008, 11(2): 77-107.

[4]KULKARNI A. Association-based image retrieval [C]// Proceedings of the 2010 42nd Southeastern Symposium on System Theory. Piscataway, NJ: IEEE, 2010: 30-34.

[5]CHEN L, YANG G, ZHANG Y, et al. Asymptotically stable multi-valued many-to-many associative memory neural network and its application in image retrieval [J]. Neural Network World, 2013, 2(13): 169-189.

[6]鲍泓,徐光美,冯松鹤,等.自动图像标注技术研究进展[J].计算机科学,2011,38(7):35-40.(BAO H, XU G M, FENG S H, et al. Advances in automatic image annotation [J]. Computer Science, 2011, 38(7): 35-40.)

[7]MILLER G A. WordNet: a lexical database for English [J]. Communications of the ACM, 1995, 38(11): 39-41.

[8]JIN Y, KHAN L, WANG L, et al. Image annotations by combining multiple evidence & WordNet [C]// Proceedings of the 13th Annual ACM International Conference on Multimedia. New York: ACM, 2005: 706-715.

[9]LEE S, DE NEVE W, RO Y M. Image tag refinement along the ‘what dimension using tag categorization and neighbor voting [C]// Proceedings of the 2010 IEEE International Conference on Multimedia and Expo. Piscataway, NJ: IEEE, 2010: 48-53.

[10]LIU D, HUA X S, YANG L, et al. Tag ranking [C]// Proceedings of the 18th International Conference on World Wide Web. New York: ACM, 2009: 351-360.

[11]LIU X, YAN S, CHUA T S, et al. Image label completion by pursuing contextual decomposability [J]. ACM Transactions on Multimedia Computing, Communications, and Applications, 2012, 8(2): Article No. 21.

[12]ZHU G, YAN S, MA Y. Image tag refinement towards low-rank, content-tag prior and error sparsity [C]// Proceedings of the 2010 International Conference on Multimedia. New York: ACM, 2010: 461-470.

[13]XIA Z, FENG X, PENG J, et al. A regularized optimization framework for tag completion and image retrieval [J]. Neurocomputing, 2015, 147: 500-508.

[14]LI X, ZHANG Y J, SHEN B, et al. Image tag completion by low-rank factorization with dual reconstruction structure preserved [C]// Proceedings of the 2014 IEEE International Conference on Image Processing. Piscataway, NJ: IEEE, 2014: 3062-3066.

[15]XU H, WANG J, HUA X S, et al. Tag refinement by regularized LDA [C]// Proceedings of the 17th ACM International Conference on Multimedia. New York: ACM, 2009: 573-576.

[16]JORDAN M I, BLEI D M, NG A Y. Latent Dirichlet allocation [J]. Journal of Machine Learning Research, 2003, 3: 465-473.

[17]LIU D, HUA X S, WANG M, et al. Image retagging [C]// Proceedings of the 2010 International Conference on Multimedia. New York: ACM, 2010: 491-500.

[18]LEE S, DE NEVE W, RO Y M. Tag refinement in an image folksonomy using visual similarity and tag co-occurrence statistics [J]. Signal Processing: Image Communication, 2010, 25(10): 761-773.

[19]XIA Z, FENG X, PENG J, et al. Content-irrelevant tag cleansing via bi-layer clustering and peer cooperation [J]. Journal of Signal Processing Systems, 2014, 81(1): 29-44.

[20]FREY B J, DUECK D. Clustering by passing messages between data points [J]. Science, 2007, 315(5814): 972-976.

[21]卢汉清,刘静.基于图学习的自动图像标注[J].计算机学报,2008,31(9):1629-1639.(LU H Q, LIU J. Image annotation based on graph learning [J]. Chinese Journal of Computers, 2008, 31(9): 1629-1639.)

[22]LIU J, LI M, LIU Q, et al. Image annotation via graph learning [J]. Pattern Recognition, 2009, 42(2): 218-228.

[23]LIU D, YAN S, HUA X S, et al. Image retagging using collaborative tag propagation [J]. IEEE Transactions on Multimedia, 2011, 13(4): 702-712.

[24]FENG Z, FENG S, JIN R, et al. Image tag completion by noisy matrix recovery [M]// ECCV 2014: Proceedings of the 13th European Conference on Computer Vision. Berlin: Springer, 2014: 424-438.

[25]LIN Z, DING G, HU M, et al. Image tag completion via image-specific and tag-specific linear sparse reconstructions [C]// Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2013: 1618-1625.

[26]LIN Z, DING G, HU M, et al. Image tag completion via dual-view linear sparse reconstructions [J]. Computer Vision and Image Understanding, 2014, 124: 42-60.

[27]WANG Q, RUAN L, ZHANG Z, et al. Learning compact hashing codes for efficient tag completion and prediction [C]// Proceedings of the 22nd ACM International Conference on Conference on Information & Knowledge Management. New York: ACM, 2013: 1789-1794.

[28]WU L, JIN R, JAIN A K. Tag completion for image retrieval [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(3): 716-727.

[29]ZNAIDIA A, LE BORGNE H, HUDELOT C. Tag completion based on belief theory and neighbor voting [C]// Proceedings of the 3rd ACM Conference on International Conference on Multimedia Retrieval. New York: ACM, 2013: 49-56.

[30]SHAFER G. A Mathematical Theory of Evidence [M]. Princeton: Princeton University Press, 1976: 35-46.

[31]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks [C]// NIPS 2012: Advances in Neural Information Processing Systems. Cambridge: MIT Press, 2012: 1106-1114.

[32]CIRESAN D, MEIER U, SCHMIDHUBER J. Multi-column deep neural networks for image classification [C]// Proceedings of the 25th IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2012: 3642-3649.

[33]SRIVASTAVA N, SALAKHUTDINOV R. Learning representations for multimodal data with deep belief nets [C]// Proceedings of the 29th International Conference on Machine Learning Workshop. New York: ACM, 2012: 1-8.

[34]FENG F X, LI R F, WANG X J. Deep correspondence restricted Boltzmann machine for cross-modal retrieval [J]. Neurocomputing, 2015, 154: 50-60.

[35]杨阳,张文生.基于深度学习的图像自动标注算法[J].数据采集与处理,2015,30(1):88-98.(YANG Y, ZHANG W S. Image auto-annotation based on deep learning [J]. Journal of Data Acquisition and Processing, 2015, 30(1):88-98.)

[36]DUYGULU P, BARNARD K, DE FREITAS J F G, et al. Object recognition as machine translation: Learning a lexicon for a fixed image vocabulary [C]// Proceedings of the 2002 European Conference on Computer Vision. Berlin: Springer, 2002: 97-112.

[37]RUSSELL B C, TORRALBA A, MURPHY K P, et al. LabelMe: a database and Web-based tool for image annotation [J]. International Journal of Computer Vision, 2008, 77(1/2/3): 157-173.

[38]SHOTTON J, WINN J, ROTHER C, et al. TextonBoost: joint appearance, shape and context modeling for multi-class object recognition and segmentation [C]// ECCV 2006: Proceedings of the 9th European Conference on Computer Vision. Berlin: Springer, 2006: 1-15.

[39]HUISKES M J, LEW M S. The MIR flickr retrieval evaluation [C]// Proceedings of the 1st ACM International Conference on Multimedia Information Retrieval. New York: ACM, 2008: 39-43.

[40]CHUA T S, TANG J, HONG R, et al. NUS-WIDE: a real-world Web image database from National University of Singapore [C]// Proceedings of the 2009 ACM International Conference on Image and Video Retrieval. New York: ACM, 2009: Article No. 48.

[41]GRUBINGER M, CLOUGH P, MLLER H, et al. The IAPR TC-12 benchmark: a new evaluation resource for visual information systems [C]// Proceedings of the 2006 International Workshop OntoImage Language Resources for Content-Based Image Retrieval. Genoa, Italy: [s.n.], 2006: 13-23.

http://tci.ncl.edu.tw/cgi-bin/gs32/gsweb.cgi?o=dnclret&s=id=%22TCI0002281631%22.&searchmode=basic&tcihsspage=tcisearch_opt2_search

http://xueshu.baidu.com/s?wd=paperuri%3A%28784279d707a6f51174a70106eeba4d1d%29&filter=sc_long_sign&tn=SE_xueshusource_2kduw22v&sc_vurl=http%3A%2F%2Fciteseerx.ist.psu.edu%2Fviewdoc%2Fdownload%3Bjsessionid%3DDD0E61692B0CFF7C88205F77BDC515B1%3Fdoi%3D10.1.1.175.3994%26rep%3Drep1%26type%3Dpdf&ie=utf-8&sc_us=10831976905929293321

[42]MAKADIA A, PAVLOVIC V, KUMAR S. Baselines for image annotation [J]. International Journal of Computer Vision, 2010, 90(1): 88-105.

[43]JRVELIN K, KEKLINEN J. Cumulated gain-based evaluation of IR techniques [J]. ACM Transactions on Information Systems, 2002, 20(4): 422-44.