虚拟界面自然交互模型与算法

2016-08-01冯志全梁丽伟徐治鹏

刘 慧, 冯志全, 梁丽伟, 徐治鹏

(1. 济南大学 信息科学与工程学院, 山东 济南 250022; 2. 山东省网络环境智能计算技术重点实验室, 山东 济南 250022)

虚拟界面自然交互模型与算法

刘慧1,2, 冯志全1,2, 梁丽伟1,2, 徐治鹏1,2

(1. 济南大学 信息科学与工程学院, 山东 济南 250022; 2. 山东省网络环境智能计算技术重点实验室, 山东 济南 250022)

摘要:针对基于视觉的手势交互界面中的“点石成金问题(Midas Touch Problem)”,提出虚拟界面的概念.采用统计分析的方法建立虚拟界面的认知基础,提出基于认知行为模型的虚拟界面构建算法,实现基于虚拟界面的示范应用.采用静态和动态2种方式构建虚拟界面,对已构建的虚拟界面进行分区,使得每个分区具有不同的功能,从而达到一种手势实现多个功能,降低用户记忆负荷的目的.实现虚拟界面的实时刷新功能,达到与人体亦步亦趋的效果.提出有效的虚拟界面感知方法,验证其交互能力及其解决“Midas Touch Problem”的积极效果.实验结果表明:虚拟界面不仅能够高效解决“Midas Touch Problem”, 还具有良好的用户体验.

关键词:虚拟界面;点石成金问题;自然交互;虚拟界面构建;虚拟界面刷新

手势交互作为一种自然的交互方式成为人机交互研究领域的一个热点[1-2].基于视觉的手势交互界面使用户摆脱了键盘、鼠标等输入设备的束缚,成为一种自然、无约束的交互方式[3-5],被广泛应用在智能空间、增强现实、普适计算等领域,逐渐成为国内外的研究热点[6-7].由于基于视觉的手势交互界面具有非接触性和模糊性等特点,用户的一些下意识的手势也会被解释成有效命令,所以在其交互过程中还存在一个问题即“MidasTouchProblem”.

武岳汇等[8]将该问题的解决办法大致总结为3类,分别是基于时间延迟的策略、基于空间接近的原则以及基于Widget提供交互上下文的方法.基于时间延迟的策略是由Jacob[9]提出的,其主要思想是通过计算手势控制界面上的光标在界面对象上停留时间的长短来判断该对象是否被选中.显然,该方法不够自然.Kato等[10]提出了基于空间接近原则的策略.该方法的主要思想是通过判断用户手持的Paddle与虚拟对象之间的距离来完成一系列的交互任务.缺点是由于Paddle与虚拟对象之间的距离不容易控制,也会产生误选的可能.Kjeldsen等[11]提出在手势动作和视觉界面widget之间建立一定的映射关系.由于每个界面widget具有一定的空间位置,可通过其提供的交互上下文来约束视觉交互行为.当系统需要很多Widget时,会加大用户的认知负荷.武岳汇等[8]提出了一个可扩展的视觉手势交互模型,该模型将手势交互分为选择性处理、分配性处理和集中处理3个阶段.虽然该算法可以解决“MidasTouchProblem”,但对于用户无关的训练应用,该方法的识别率不高.

本文在已有的研究基础上,提出基于虚拟界面的手势交互方法.该方法通过静态和动态2种方式构建虚拟界面,将虚拟界面进行分区,然后将虚拟界面作为输入界面与应用系统进行交互,有效解决了“MidasTouchProblem”.

1虚拟界面理论研究

1.1认知基础

认知是人认识外界事物的过程,体现了人最基本的心理过程.人对事物的认识,一般要经过从“不知”到“了解”,在从“了解”到“理解”的过程[12-13].在心理学中,认知是通过个体思维对信息进行处理的一种心理功能,是通过一系列像知觉、想象、形成概念或判断等心理活动来达到获取知识的过程.

研究认知理论并将其运用到人机交互领域中是一个新的研究方向,受到了众多学者和专家的关注.在基于视觉的手势交互中,人往往是按照自己的习惯进行操作的,人手的运动范围是人手所能到达的范围.按照认知理论,在手势交互过程中,人手的运动范围会遵循一定的规律.本文在基于Kinect智能电视控制平台上进行实验,探索人手运动范围的规律性.

1.2认知实验设计

在交互过程中,人手的运动范围是有规律可循的.本文通过设计认知实验来研究其中的规律.为了使得到的实验数据更具有普遍性和统计意义,实验对象选取了200名不同年龄段(19~27岁)、不同性别(男性110人,女性90人)、不同学历(研究生和本科生)、不同生活经验(35人有使用智能手势操作或智能电视的经历)的人.认知实验的平台是基于Kinect智能电视控制.在视频用播放器软件打开的情况下,让操作者均站在固定的位置,按照顺序依次完成以下6个任务:1)向左挥手减少视频音量;2)向右挥手增加视频音量;3)向上挥手切换上一个频道;4)向下挥手切换下一个频道;5)向前做前推动作使视频快进;6)向后做后拉动作使视频快退.6个手势动作完成即为任务结束.实验过程中操作者完全按照自己的操作习惯去操作.

记录每个实验者任务操作过程中人手运动的轨迹点集合,该轨迹点为Kinect获得的人手三维空间坐标.对手势轨迹点集合求取轴对齐包围盒(AABB),便得到一个3条边均与空间坐标轴平行并且能够将手势轨迹点集合内所有点包围在内的最小长方体或是立方体(以下均称为长方体).实验得到的最终数据为该长方体的长宽高的值.

1.3认知实验分析

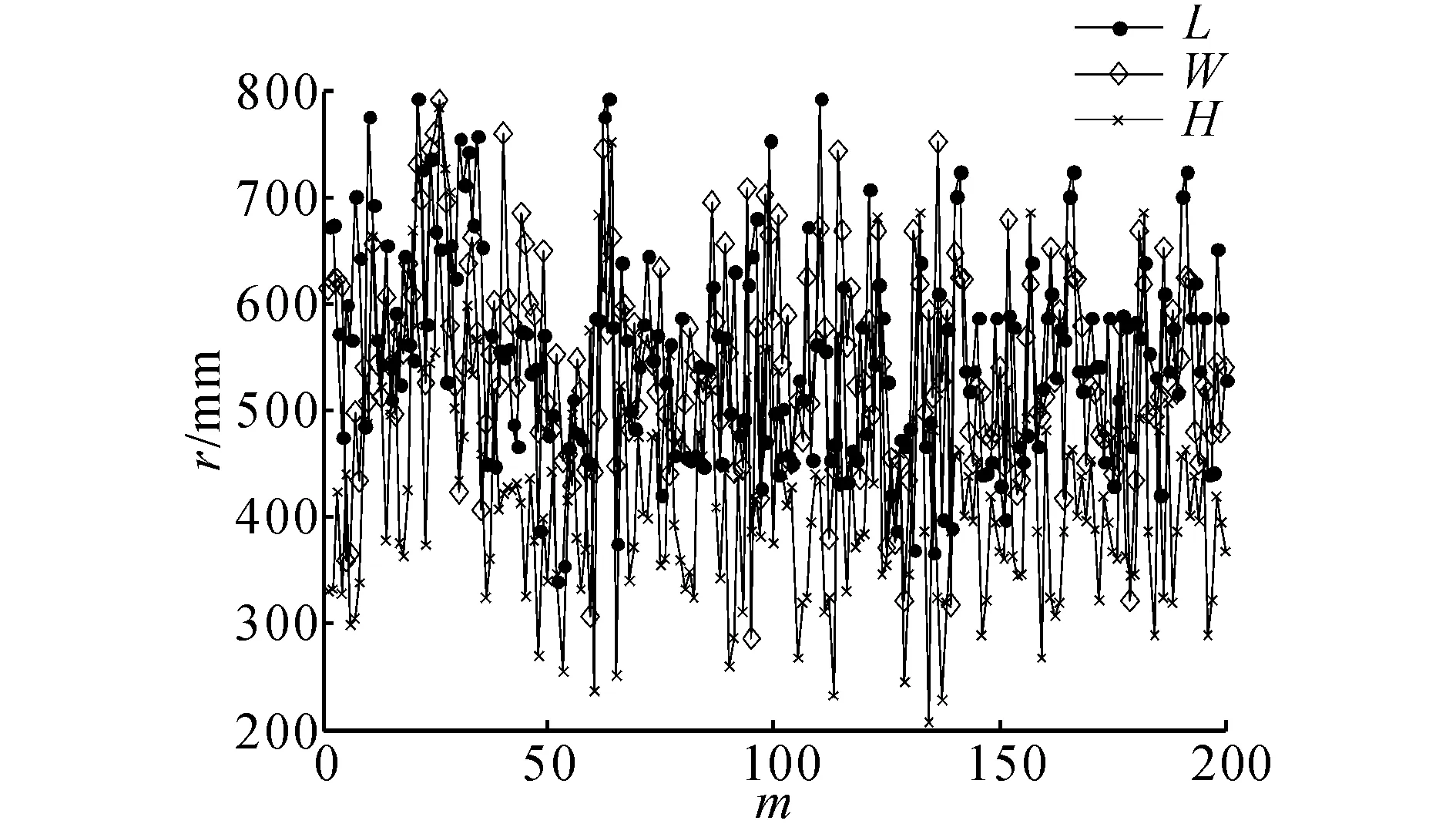

图1 手势运动范围图Fig.1 Range of hand gesture motion

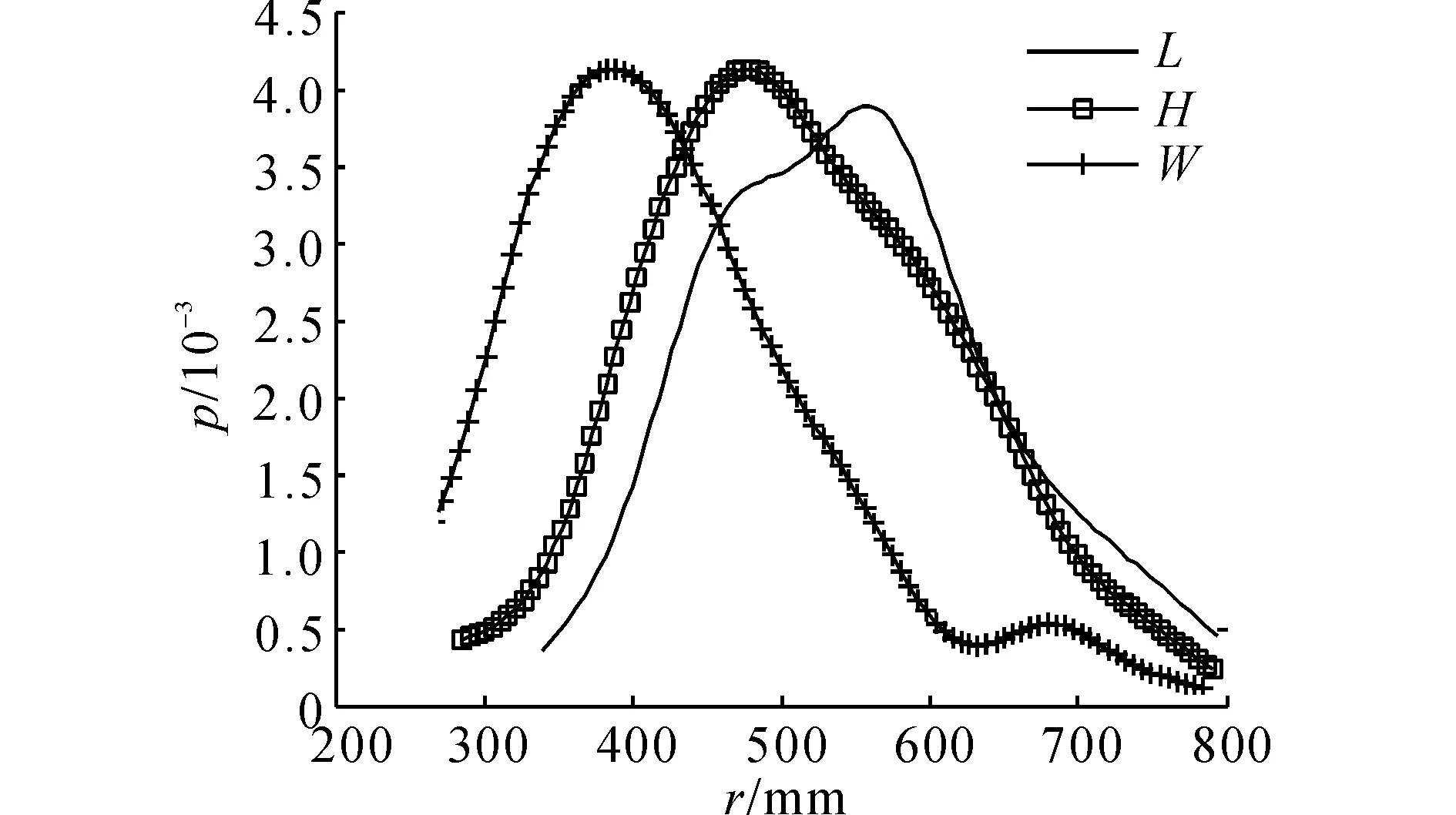

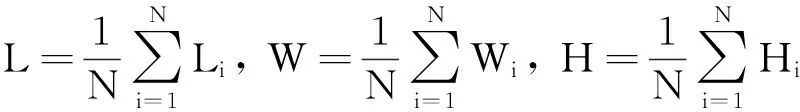

通过认知实验获得并实验数据,对数据进行分析.本文采用美国MathWork公司的Matlab软件对数据进行分析和统计.实验得到运动范围结果如图1所示.图中,m为实验操作者的人数,r为运动范围,L、W、H分别为所求长方体的长、宽、高的值.由图1可知,虽然不同长方体的长、宽和高的值不尽相同,但均在一定范围内.这表明虽然不同的人有不同的操作方式和交互方式,但操作区域大都在一定范围内,此范围也是极为相似的.该操作范围即体现了交互过程中人手运动的规律性.在交互过程中,人手的活动区域大都控制在一定范围内,此范围对于操作者来说是舒适和方便的.该范围即为本文所提出的虚拟界面,因此认知实验的设计为虚拟界面的存在和构建提供了理论和数据支持.所得长方体的长宽高范围的概率分布情况如图2所示.其中,p为概率.由图2所知,认知实验过程中所得到的长方体的长、宽和高的值均近似服从正态分布.虚拟界面在空间中的分布大致如图3所示.图3中人手周围的矩形框即为虚拟界面.

图2 长宽高的范围概率分布图Fig.2 Range probability distribution of length width and height

图3 虚拟界面效果图Fig.3 Distribution of virtual interface in space

本文用σL表示长度标准差,σW表示宽度标准差,σH表示高度标准差.按照式(1)计算L、W和H的值,按照式(2)计算σL、σW、σH的值.

(1)

(2)

其中,式(1)、(2)中Li、Wi、Hi分别表示在认知实验中,每个实验操作者所得到的操作范围的长宽高的值;N为参加认知实验的总人数.

经过计算得到L=551mm,W=423mm,H=542mm,σL=97mm,σW=107mm,σH=94mm.L、W和H的值将用到下一节虚拟界面的构建过程中.

2构建虚拟界面

2.1基于Kinect的手势分割与识别

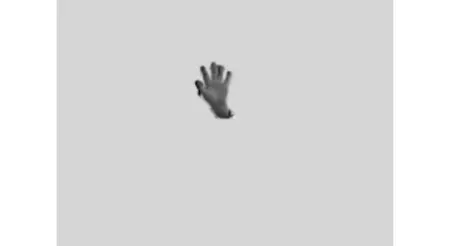

手势分割[14-16]是从复杂背景中将手势图像分离出来,只在前景中保留手势部分.手势分割的好坏将直接影响后续的手势识别效果.本课题采用微软的Kinect传感器获取深度数据,在此基础上利用人手的深度信息对手势进行分割,避免了光照、背景等因素的影响,提高了手势分割的鲁棒性[17].然后对分割结果进行去噪、腐蚀、膨胀等处理.手势分割结果如下图所示.

图4 Kinect手势分割结果图Fig.4 Result of hand gesture segmentation based on Kinect

手势识别[18]是人机交互领域中的一项关键技术.本文采用的是基于手势主方向和类-Hausdorff距离的手势识别算法[19].该算法主要是对空间手势的手势坐标点分布特征进行提取,然后利用类-Hausdorff作为相似性度量.实验结果表明,该算法对于手势的平移、旋转和缩放具有很好的鲁棒性,具有很强的稳定性和实用性.

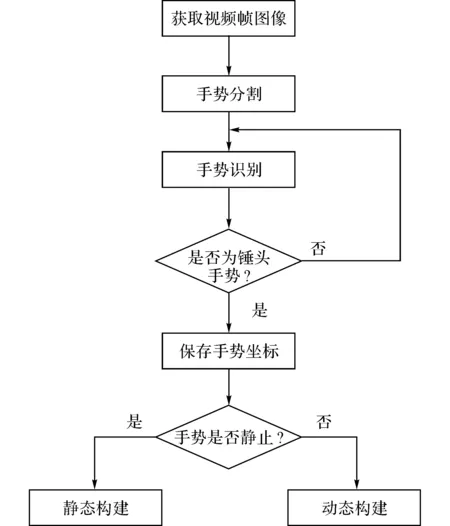

2.2构建虚拟界面的具体步骤

当今世界人体工程学受到了越来越多国家的重视,并且其应用领域也越来越广.以人为本作为人体工程学的基本思想,在科技快速发展的今天已经成为一种趋势[20-21].将“人-机-环境”系统作为一个整体来研究是现代人机工程学的研究方向,其目的是为人类创造出适合的产品和舒适的环境,从而达到“人-机-环境”和谐统一的目的.从人机工程学的角度出发,根据人的行为习惯,本文提出2种构建虚拟界面的方式,分别是静态构建和动态构建,旨在建立一种符合用户操作习惯并且能够增加用户舒适度的创建方式.动态构建虚拟界面的具体方法如下:操作者在空中按照自己的操作习惯随意画一个闭合的轨迹,此闭合轨迹的外接包围盒即为构建的虚拟界面.静态创建虚拟界面的方式如下:操作者将手自然抬起,做锤头手势,并在空中静止几秒后,在人手的周围,以人手为中心会自动建立一个虚拟界面.该虚拟界面的大小,可由前面认知实验的结论(所得到的长方体的长宽高的均值)来确定.这2种构建方式符合人的操作习惯,而且降低了操作者的操作负荷和认知负荷.这2种方式的共同特点是:需要事先对锤头手势进行识别.因此,本文将锤头手势作为构建虚拟界面的特定手势,这样可以避免一些无效手势命令.本文用下式来表示虚拟界面:

V={x1,x2,y1,y2,z1,z2}.

(3)

式中:x1、x2分别为在x方向上虚拟界面的最小值和最大值;y1、y2分别为在y方向上虚拟界面的最小值和最大值;z1、z2分别为在z方向上虚拟界面的最小值和最大值.构建虚拟界面的算法的框架流程图如图5所示.

图5 构建虚拟界面的框架流程图Fig.5 Framework of building virtual interface

构建虚拟界面的具体算法如下:

步骤1:获取摄像头所捕获到的视频帧图像.

步骤2:对视频帧图像进行手势分割,将人手从背景中分离出来.

步骤3:对分割后的手势图像进行识别,判断识别结果是否为锤头.若识别结果为锤头,记录下该帧手势的位置H,转到步骤4;若识别结果不是锤头,则转到步骤2.

步骤4:判断手势是否处于静止状态.若为静止状态,则可判断为此方式为静态创建虚拟界面,然后转为步骤5;若不是静止状态,则为动态创建虚拟界面的方式,转为步骤6;

步骤5:以H为中心,在其周围生成虚拟界面.虚拟界面各点的值可由以下公式求得:

(4)

式中:Hx、Hy、Hz分别为点H处的x、y、z方向的坐标值,L、W和H为认知实验中所得到的虚拟界面的值.

步骤6:保存每帧手势的空间坐标点到集合C中.

步骤7:判断手势是否静止.若静止,表明人手轨迹运动结束即动态构建虚拟界面的过程结束,转到步骤8;若手势非静止,则转到步骤6.

图6 虚拟界面在屏幕上的投影Fig.6 Projection of virtual interface on screen

步骤8:对集合C中的手势坐标点求轴对齐包围盒,得到的包围盒即为虚拟界面.

为了给读者一个直观的感受,虚拟界面在屏幕上的投影如图6所示.其中图中的矩形框即为学习过程中所得到的虚拟界面.

记人手在空间中的手势坐标为S,其在空间x、y和z方向的坐标值分别Sx、Sy、Sz.只有当Sx、Sy、Sz均满足下列条件时,手势命令才是有效的:

x1≤Sx≤x2,y1≤Sy≤y2,z1≤Sz≤z2.

(5)

3基于虚拟界面的手势交互

3.1虚拟界面分区算法

学习过程确定了虚拟界面的大小和位置,接下来是利用虚拟界面与3D场景进行交互.本文的交互任务主要为放大、缩小、旋转和移动三维物体.为了实现这4种常用的功能,本文提出了分区的概念,即对虚拟界面进行分区.本文将虚拟界面平均分成4个区域,每个区域具有不同的功能,从而用一种手势就可以完成所有的功能.分区后的虚拟界面以及个分区所具有的功能如图7所示.

图7 虚拟界面功能分布图Fig.7 Function distribution of virtual interface

具体分区及交互算法如下所述.

步骤1:按照下式计算虚拟界面的重心位置:

(6)

式中:xm、ym、zm分别为重心位置处的x坐标值、y坐标值和z坐标值.

步骤2:判断人手位于哪个功能区内.从摄像头实时获取每帧手势的Sx、Sy、Sz值,并对Sx、Sy、Sz进行判断.具体判断过程如下.

1) 判断是否满足式(7).若满足,则表明人手处于放大功能区,此时3D场景中三维物体的体积会变大.

x1≤Sx≤xm, y1≤Sy≤ym, z1≤Sz≤z2.

(7)

2) 判断是否满足公式(8).若满足,则表明人手处于缩小功能区,此时3D场景中三维物体体积会缩小.

xm≤Sx≤x2,y1≤Sy≤ym,z1≤Sz≤z2.

(8)

3) 判断是否满足公式(9).若满足,则表明人手处于旋转功能区,此时3D场景中的三维物体会按照一个固定的方向旋转一定角度.

x1≤Sx≤xm,ym≤Sy≤y2,z1≤Sz≤z2.

(9)

4) 判断是否满足公式(10).若满足,则表明人手处于移动功能区.通过判断人手的运动方向决定3D物体的移动方向.

xm≤Sx≤x2,ym≤Sy≤y2,z1≤Sz≤z2.

(10)

5) 如果以上条件都不满足,表明人手处于虚拟界面之外,此时无论人手怎么操作3D场景中的物体都不会有任何变化,即手势命令无效.

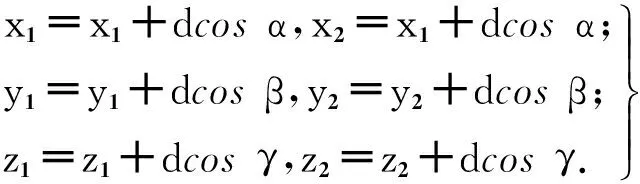

3.2虚拟界面的实时刷新移动

在交互过程中,有时用户需要更换位置进行操作.在这种情况下,本文规定之前学习好的虚拟接界面会根据用户移动的距离情况进行相应的同方向的移动,达到与用户亦步亦趋的效果.具体算法如下所述.

步骤1:记下虚拟界面学习完成时,人体的初始重心坐标P1.

步骤3:判断虚拟界面是否需要移动.判断d>s是否成立,s为事先定义的一常量,其推荐取值为200.若成立表明虚拟界面需要移动,然后根据公式(11)更新虚拟界面中的值;若不需要移动,则转到步骤2.

(11)

4实验结果及分析

本实验所用的普通个人计算机的基本配置如下:windows7系统,CPU为IntelXeonW3520,主频2.67GHz,内存8GB.

图8 操作界面与场景Fig.8 Operation interface and application scene

本文的实验操作场景和3D场景如图8所示:其中左上方是虚拟界面所对应的功能区图.当人手处于虚拟界面的不同功能区时,对应功能图标的周围会出现一个边框,表示用户此时所处的功能区域,给用户一种实时的反馈.当人手在虚拟界面之外时,系统会根据人手和虚拟界面的相对位置,在图片上给出相应的反馈.例如,当人手处于虚拟界面的下方时,左上方图中的下方会出现一红线,以此来告诉用户此时人手的位置.左中方是Kinect实时捕获到的用户操作场景.左下方为利用Kinect获得的深度信息对人手进行分割的结果.右边部分为虚拟场景,场景中的物体为一魔方.虚拟界面构建完成后,用户通过虚拟界面与虚拟场景中的魔方进行交互.

图9 操作者与场景交互过程Fig.9 Process of interaction between operator and scene

如图9所示为操作者通过虚拟界面与3D场景交互的过程.其中图9(a)显示了初始状态下3D场景中魔方的状态;图9(b)是人手处于移动功能区,此时魔方相对于初始位置向右进行了一段距离的移动;图9(c)为人手处于缩小功能区,此时魔方的体积在移动的基础上变小;图9(d)为人手处于放大功能区,在图9(c)的基础上魔方的体积进行了一定比例的放大;图9(e)为人手处于旋转功能区,可以看到魔方在图9(d)的基础上进行了一定角度的旋转;图9(f)为人手处于虚拟界面外时,3D场景中的魔方不会发生任何变化,与图9(e)的状态完全相同,即此时手势命令无效.

图10 虚拟界面的实时刷新过程Fig.10 Real-time refresh process of virtual interface

如图10所示为在交互过程中,虚拟界面的实时刷新变化.其中图(a)是虚拟界面学习完成时,虚拟界面在屏幕上的投影位置,即初始位置;图(b)是当人体向左平移一段距离时,虚拟界面的移动情况,结果为虚拟界面向左也移动了一定的距离;图(c)是当虚拟界面向左移动时,人手在旋转功能区使魔方进行一定角度的旋转;图(d)是当人体向右平移一段距离时,虚拟界面向右也移动了一段距离.图(e)是当虚拟界面向右移动时,人手在放大功能区使魔方的体积在原来的基础上变大.

由于本文研究的内容较新颖,与此相关的研究工作较少,本文只在时间和精度方面对本文算法进行评价.时间为虚拟界面学习过程中所消耗的时间,其中时间又分为静态建立虚拟界面所消耗的时间和动态建立虚拟界面所消耗的时间.精度为在通过虚拟界面与3D场景进行交互时,交互出错的次数(预先设置好任务即每次实验过程中需要与3D场景交互10次,也就是所有的功能共执行10次).选取30名实验者进行30次独立实验,分别计算每次实验时学习虚拟界面所用的时间和交互出错出现的次数.在30名操作者中,又平均分成2组,每组15个人.其中一组选用静态构建虚拟界面的方式对虚拟界面进行构建,另外一组选用动态构建虚拟界面的方式进行构建虚拟界面.对实验过程中得到的数据利用Matlab软件进行作图,得到的结果图如图11和12所示.

图11 学习虚拟界面所需要的时间统计Fig.11 Time statistics of learning virtual interface

图12 交互过程中出错次数Fig.12 Error times in process of interaction

虚拟界面学习过程中的时间统计如图11所示.图中,t为每个实验操作者构建虚拟界面所需要的时间,j为静态构建虚拟界面的方式,u为动态构建虚拟界面的方式.由图11可知,静态构建虚拟界面所需要的时间明显少于动态构建虚拟界面所需要的时间.这是因为静态构建虚拟界面时,操作者不需要通过在空中画轨迹来确定虚拟界面的大小.通过对每一组所得到的数据计算平均值,得到静态构建虚拟界面所需的平均时间为2 502ms,动态构建虚拟界面所需的平均时间为4 950ms.精度统计图如图12所示.图中,n为每个实验操作者在实验过程中交互出错的次数.由图12可知,在所有的实验中,虽然每次实验都有不同的操作者完成,但交互出错的次数基本在1~3次.由此表明,使用本算法操作者能够很好与系统进行交互,能够很顺利地完成操作任务.

此外,本文还把用户体验作为对本文算法的一个评价标准.为了方便描述,将基于虚拟界面的系统称为虚拟界面系统(virtualinterfacesystem,VIS);将与之相对应的无虚拟界面的系统则称之为无虚拟界面系统(nonevirtualinterfacesystem,NVIS).随机选取50名不同专业、不同年龄、不同性别的本科生和研究生作为实验者,在实验场景和交互任务完全相同的VIS和NVIS系统上进行实验.本实验场景如上面所讲到的为3D场景中的立方体.实验任务为将放大、缩小、旋转和移动功能共操作10次.本文将从疲劳度、努力程度、愉悦度和可行性这4个方面对使用VIS的系统和使用NVIS的系统进行评价.其中,疲劳度为操作过程中,操作者的辛苦程度;努力程度为为完成交互任务,操作者需要付出多少的努力;愉悦度为使用系统时,用户所感到的愉悦程度;可行性为对于用户来说,系统的可行程度.其中疲劳度和努力程度分数越低表示系统越好,可行性和愉悦度分数越高表示系统越好.实验者做完实验后,会为他们发放一份调查问卷.调查问卷的主要内容是请操作者根据之前的操作过程,从切身感受出发,从疲劳度、努力程度、愉悦度和可行性方面对这2个不同的系统分别进行打分.具体的打分标准为满分均为100分,然后求各个性能在不同算法中的平均分,用户体验评价结果如图13所示.图中,s为分数,每一组中,左面的矩形为VIS,右面的矩形为NVIS.由图可知在疲劳度和努力程度方面,基于VIS的系统优势尤其明显.这是因为与基于NVIS的系统相比,基于VIS系统的操作空间被限制到了某个特定的范围内也就是虚拟界面内,这样操作者在小范围内就可以完成整个操作任务而不需要移动身体或者努力伸长胳膊才能达到目的.由于虚拟界面的存在防止了下意识的手势触发命令,在愉悦度和可行度方面,基于VIS的系统也具有一定的优势.

图13 用户体验评价结果图Fig.13 Result of user experience evaluation

5结语

本文提出的虚拟界面概念有效解决了在基于视觉的手势交互界面中出现的“MidasTouchProblem”.主要创新点在于:使用大量的统计实验构建“虚拟界面”的认知基础;提出了一种基于认知行为模型的虚拟界面构建算法;实现了一个基于虚拟界面的示范应用.从实验结果来看,虚拟界面的存在不仅能有效解决“MidasTouchProblem”,而且减少了用户的操作负荷,具有良好的用户体验.同时,本文也存在一定的不足.例如,交互任务和操作场景有点单一.由于受手势分割等条件的限制,怎样使虚拟界面无处不在并分布在空间中的任一位置或物体的表面是下一个研究重点.

参考文献(References):

[1] 武霞,张崎,许艳旭.手势识别研究发展现状综述[J].电子科学,2013,26(6): 171-174.

WUXia,ZHANGQi,XUYan-xu.Anoverviewofhandgesturerecognition[J].ElectronicScienceandTechnology, 2013, 26(6): 171-174.

[2] 冯志全,蒋彦.手势识别研究综述[J].济南大学学报:自然科学版,2013,27(4): 336-341.

FENGZhi-quan,JIANGYan.Asurveyofhandgesturerecognition[J].JournalofUniversityofJinan:ScienceandTechnology, 2013, 27(4): 336-341.

[3] 邬大鹏.基于视觉的手势识别及人机交互研究[D].南京:南京航空航天大学,2010.

WUDa-peng.Researchonvision-basedgesturerecognitionandhuman-compurtinteraction[D].Nanjing:NanjingUniversityofAeronauticsandAstronautics, 2010.

[4] 方旭亮. 基于计算机视觉的手势交互系统研究与设计 [D]. 杭州:浙江大学,2008.

FANGXu-liang.Theresearchanddesignofgestureinteractivesystembasedoncomputervision[D].Hangzhou:ZhejiangUniversity, 2008.

[5] 陈子毫.基于深度信息的手势检测与跟踪[D]. 广州:华南理工大学,2012.

CHENZi-hao.Handdetectionandtrackingbasedondepthmaps[D].Guangzhou:SouthChinaUniversityofTechnology, 2012.

[6] 王辉.基于视觉的实时手势跟踪与识别及其在人机交互中的应用[D].杭州:浙江大学, 2008.

WANGHui.Visionbasedreal-timegesturetrackingandrecognitionanditsapplicationinhuman-computerinteractiontechniques[D].Hangzhou:ZhejiangUniversity, 2008.

[7] 武汇岳,张凤军,刘玉进,等.基于视觉的互动游戏手势界面工具箱[J].软件学报,2011,22(5): 1067-1081.

WUYue-hui,ZHANGFeng-jun,LIUYu-jin,etal.Vision-basedgestureinterfacetoolkintforinteractivegames[J].JournalofSoftware, 2011,22(5): 1067-1081.

[8] 武汇岳,张凤军,刘玉进,等.基于视觉的手势界面关键技术研究[J].计算机学报,2009,32(10): 2030-2041.WUYue-hui,ZHANGFeng-jun,LIUYu-jin,etal.Researchonkeyissueofvision-basedgestureinterfaces[J].ChineseJournalofComputers, 2009, 32(10): 2030-2041.

[9]JACOBRJK.Eyemovement-basedhuman-computerinteractiontechniques:towardnon-commandinterfaces[J].InAdvancesinHuman-ComputerInteraction. 1993,4: 151-19.

[10]KATOH,BILLINGHURSTM,POUPYREVI,etal.Virtualobjectmanipulationonatable-topARenvironment[C]∥IEEEandACMInternationalSymposiumonAugmentedReality, 2000. (ISAR2000)Proceedings,Munich:IEEE, 2000: 111-119.

[11]KJELDSENR,LEVASA,PINHANEZC.Dynamicallyreconfigurablevision-baseduserinterfaces[J].MachineVisionandApplications, 2004, 16(1): 6-12.

[12] 张清华,周玉兰,滕海涛.基于粒计算的认知模型[J].重庆邮电大学学报:自然科学版,2009,21(4): 494-501.

ZHANGQing-hua,ZHOUYu-lan,TENGHai-tao.Cognitionmodelbasedongranularcomputing[J].JournalofChongqingUniversityofPostsandTelecommunications:NaturalScienceEdition. 2009, 21(4): 494-501.

[13] 林燕.基于多模型融合的人手三维跟踪研究[D].济南:济南大学,2012.

LINYan.Researchon3Dhandtrackingbasedonmulti-modelfusion[D].Jinan:UniversityJinan,2012.

[14] 刘松涛,殷福亮.基于图割的图像分割方法及其新进展[J].自动化学报,2012,38(6): 911-922.

LIUSong-tao,YINFu-liang.Thebasicprincipleanditsnewadvanceofimagesegmentationmethodsbasedongraphcuts[J].ActaAutomaticasinica, 2012,38(6): 911-922.

[15] 许新征,丁世飞,史忠植,等.图像分割的新理论和新方法[J].电子学报,2010,38(增1): 76-82.

XUXin-zheng,DINGShi-fei,SHIZhong-zhi,etal.Newtheoriesandmethodsofimagesegmentation[J].ACTAElectronicaSinica, 2010, 38(Suppl.1): 76-82.

[16] 莫舒. 基于视觉的手势分割算法的研究[D]. 广州:华南理工大学,2012.

MOShu.Handgesturesegmentationalgorithmbasedonvision[D].Guangzhou:SouthChinaUniversityofTechnology, 2012.

[17] 闵凡文.基于认知行为模型库和Kinect平台的实时手势跟踪算法研究[D].济南:济南大学,2014.

MINFan-wen.Researchonreal-timehandtrackingalgorithmbasedoncognitive-behavioralmodellibraryandKinect[D].Jinan:UniversityofJinan, 2014.

[18] 周航.基于计算机视觉的手势识别系统研究[D]. 北京:北京交通大学,2008.

ZHOUHang.Studiesonthegesturerecognitionsystembasedoncomputervision[D].Beijing:BeijingJiaotongUniversity, 2008.

[19] 杨学文,冯志全,黄忠柱,等. 结合手势主方向和类-Hausdorff距离的手势识别[J]. 计算机辅助设计与图形学学报. 2016,28(1): 75-81.

YANGXue-wen,FENGZhi-quan,HUANGZhong-zhu,etal.Gesturegecognitionbasedoncombiningmaindirectionofgestureandhausdorff-likedistance[J].JournalofComputer-AidedDesignandComputerGraphics, 2016, 28(1): 75-81.

[20] 王湃.人体工程学及其未来[J].中国环境管理干部学院学报,2003, 13(2): 71-73.

WANGPai.Humanengineeringscienceanditsfuture[J].JOURNALOFEMCC, 2003, 13(2): 71-73.

[21] 杨春青.人体工程学的应用研究[J].艺术与设计:理论,2009(7): 154-155.YANGChun-qing.Thestudyofapplicationofergonomics[J].ArtandDesign:Theory, 2009(7): 154-155.

收稿日期:2015-10-10.

基金项目:国家自然科学基金资助项目(61472163);山东省重点研发计划资助项目(2015GGX101025).

作者简介:刘慧(1990—),女,硕士生,从事虚拟现实与人机交互研究.ORCID: 0000-0003-1999-6162. E-mail:893964326@qq.com 通信联系人:冯志全,男,教授,博导.ORCID: 0000-0001-7588-7417. Email:ise_fengzq@ujn.edu.cn

DOI:10.3785/j.issn.1008-973X.2016.06.022

中图分类号:TP 391

文献标志码:A

文章编号:1008-973X(2016)06-1167-09

Naturalinteractionmodelandalgorithmbasedonvirtualinterface

LIUHui1,2,FENGZhi-quan1,2,LIANGLi-wei1,2,XUZhi-peng1,2

(1. Department of Information Science and Engineering, University Jinan, Jinan 250022, China;2. Shandong Provincial Key Laboratory of Network Based Intelligent Computing, Jinan 250022, China)

Abstract:The concept of virtual interface was proposed aiming at the “Midas Touch Problem” that occured in gesture interaction interfaces based vision. The statistical analysis method was used to establish the cognitive basis of virtual interface, and virtual interface construction algorithm was proposed based on cognitive behavioral model. Then a demonstration application based on virtual interface was implemented. Two methods including the static and dynamic ways were applied to construct the virtual interface. The virtual interface was divided into several regions averagely and each region was endowed with different functions. Therefore, multiple functions could be realized by only one kind of gesture, which reduced the memory load of users. The function of real-time refresh of virtual interface was achieved, which was the same effect as the human body. The effective perception method of virtual interface was put forward, and the interactive ability and positive effect of solving “Midas Touch Problem” were verified. The experimental results show that the proposed virtual interface not only solves the “Midas Touch Problem” efficiently, but also has a good user experience.

Key words:virtual interface; Midas Touch Problem; natural interaction; building of virtual interface; refresh of virtual interface