基于分块LBP和鲁棒核编码的人脸识别

2016-06-23钟欢虹欧阳宁莫建文

袁 华,钟欢虹,欧阳宁,莫建文

(桂林电子科技大学 信息与通信学院,广西 桂林 541004)

基于分块LBP和鲁棒核编码的人脸识别

袁华,钟欢虹,欧阳宁,莫建文

(桂林电子科技大学 信息与通信学院,广西 桂林 541004)

摘要:针对人脸识别中的遮挡和姿态偏转等问题,提出了一种基于分块LBP和鲁棒核编码(Robust Kernel Coding, RKC)的人脸识别算法,简称LBP-RKC算法。该算法首先对人脸图像进行多级分块的LBP特征提取,得到图像的每一块统计直方图特征。然后,将特征投影到核空间中,在核空间中建立一个鲁棒的回归模型来处理图像中的异常值,并利用迭代重加权算法求解该模型。最后,计算测试样本的每一块核表示重构残差并进行分类识别。实验表明,提出的LBP-RKC算法在处理遮挡、姿态偏转等人脸问题时能取得很好的识别效果,同时算法效率较高。

关键词:人脸识别;遮挡;分块;局部二值模式;核编码

人脸识别是一种基于面部特征来识别人类的生物识别技术,广泛应用于计算机视觉和模式识别领域。然而,人脸识别中仍有许多难题未解决,例如遮挡、表情变化、姿态偏转等。近年来,稀疏表示方法被成功运用于人脸识别中,Wright等[1]提出基于稀疏表示分类(Sparse Representation based Classification,SRC)的人脸识别方法,通过所有训练样本的l1范数最小化的稀疏线性表示来表征测试样本。然而,稀疏表示中的l1范数约束条件使得计算非常复杂,部分学者开始质疑稀疏性在分类鉴别中的角色[2]。在文献[3]中发现了使用所有训练样本的线性组合共同表示测试样本的思想,使得SRC成功应用于人脸识别分类,而不是l1范数的稀疏约束。同样,测试样本对异常值的鲁棒性来自残差的稀疏约束而不是系数。因此,协作表示分类(Collaborative Representation based Classification, CRC)[4]用l2范数替代l1范数在获得相似于SRC的识别率的同时,大大降低了计算复杂度。Yang等[5]提出了鲁棒稀疏编码算法(Robust Sparse Coding, RSC),该方法假设编码残差和系数是独立同分布的,寻求稀疏编码模型的最大似然解,该算法对人脸中的遮挡、伪装等问题具有比SRC更强的鲁棒性。

考虑到特征提取在人脸识别中的重要作用,众多学者从对图像特征的研究入手,相对于全局特征简单、粗糙的特征提取方法,局部特征通常对移位、光照表情变化、遮挡以及伪装表现出更好的效果。例如,Yang等[6]提出基于Gabor滤波器的特征提取方法,并结合稀疏表示应用于人脸识别中,取得了较好的识别效果。另一类广泛应用于人脸识别的局部特征是统计局部特征,如局部二值模式(LBP)直方图[7]。其主要思想是将一幅人脸图像看作是由一些小模块组成的,通过将人脸图像分割成若干子块,然后提取这些子块的统计特征,最后把所有块提取到的特征连接起来。

虽然这些特征提取算法和SRC/CRC/RSC等分类算法在人脸识别中已经取得了很好的效果,但是鲜有学者把它们结合起来以期取得更好的性能。文献[8]和文献[9]尝试把LBP特征和SRC结合起来,但是没有有效的表示模型来处理人脸遮挡、姿态偏转等问题。受此启发,本文利用核函数可增大类别间的差分性的特性,提出一种基于分块LBP和鲁棒核编码模型的人脸识别算法。首先用LBP算子计算人脸图像的LBP特征谱,并将划分为互不重叠的区域统计其直方图;然后充分利用局部特征之间的鉴别信息提出一个RKC模型,采用一个鲁棒的回归函数来处理人脸图像中遮挡、姿态偏转等问题;最后,通过计算每一块的核表示重构残差来实现对样本的分类。

1相关知识

1.1LBP算子

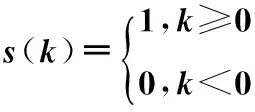

LBP算子因其计算简单和对图像纹理描述的有效性,通常被用于人脸图像的特征描述。假设局部区域图像的中心灰度值为gc,则区域图像的LBP值计算如下[10]

(1)

(2)

其中,LBPN,R表示半径为R的圆邻域内有N个像素点,gN是圆中心的相邻像素值。对于不同的(N,R)组合,将N个相邻的gN分别和gc做相减比较,大于gc的记为1,否则为0。对于不在中心的邻值的灰度值通过双线性插值来估计。

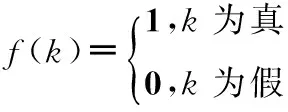

将图像的LBP值进行统计,即可画其直方图。假设图像的大小是m×n,得到每个像素(i,j)的LBP值以后,表示整幅图像统计特征的直方图计算如下

(3)

(4)

其中,u=N×(N-1)+3是LBP的不同模式[10]。

1.2SRC和CRC模型

文献[1]通过所有训练样本的l1正规化的稀疏表示来线性表征测试样本,以及文献[3]通过l2正规化的协作表示来表征测试样本,都取得了较好的效果。假设人脸库中有L类个体,第i类中包含ni(i=1,2,…,L)幅人脸图像,则第i类个体的训练样本矩阵表示为Xi=[xi(1),xi(2),…,xi(ni)]∈Rm×ni,i=1,2,…,L,其中,xi(j)∈Rm表示第i类的第j幅图像,m表示特征向量的维数。对于L类所有训练样本构成的矩阵X=[X1,X2,…,Xi,…,XL],给定一个待测试的样本y∈Rm,SRC或CRC模型定义为

(5)

(6)

1.3RSC算法

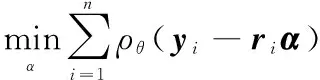

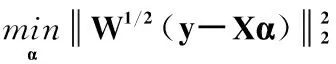

传统的稀疏编码中,假设残差服从高斯分布或拉普拉斯分布,但实际上,残差会偏离这两种分布,特别是在人脸处于伪装或遮挡情况下。为了得到一个鲁棒的稀疏编码模型,Yang等人[5]通过假设编码残差是独立同分布的,提出一种鲁棒的稀疏编码(RSC)模型

(7)

其中,σ是大于0的常数,yi表示测试样本y=[y1,y2,…,yn]T的第i个元素,ri是训练样本构成的字典X=[r1;r2;…;rn]的第i行,α为编码系数。把式(7)中的最小化问题转化为迭代加权稀疏编码问题,表示为

(8)

其中,W是对角权重矩阵,其对角元素是

(9)

(10)

2LBP-RKC算法

2.1分块LBP特征的提取

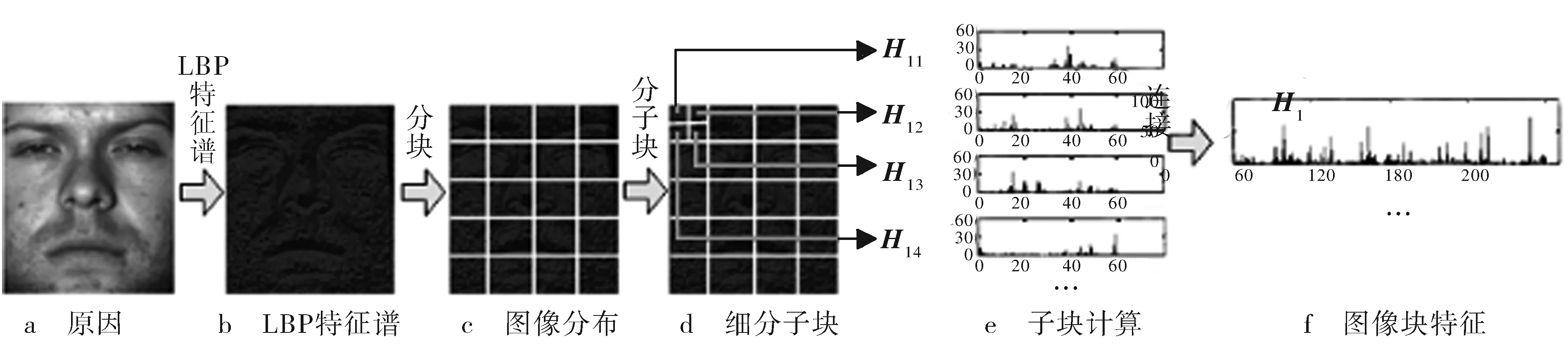

LBP具有很好的灰度不变和旋转不变的特点,较好地克服了图像移位、旋转和光照不均匀的问题,能有效地提取代表图像本质的特征,而对图像进行LBP分块特征提取更能表现出图像的局部细节。本文提取分块LBP特征的过程如图1所示。

图1 分块LBP特征提取流程图

算法主要步骤详细描述如下:

1)根据式(1)采用LBP8,2算子计算原始图像的LBP特征谱,得到如图1b所示的LBP特征谱。

2)将LBP特征谱划分为互不重叠的B(B=P×Q)块,如图1c所示。

3)每一块又进一步细分为4(4=2×2)个子块,如图1d所示,图中以第一块的细分为例。

4)根据式(3)统计各细分子块的LBP直方图H11,H12,H13,H14,如图1e所示。

5)将一个图像块中的细分子块的LBP直方图串联起来得到一个直方图序列H1,如图1f所示,以此作为该图像第一块的特征向量。

6)重复步骤3)~5)计算其他图像块的直方图序列,总共得到B个图像块后续应用的特征向量H1,H2,…,HB。

2.2RKC模型及求解

KZZ=φ(Z)Tφ(Z)

(11)

kZv=φ(Z)Tφ(v)

(12)

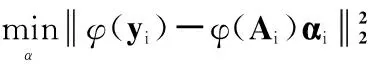

假设对一幅测试样本进行分块LBP特征提取后,得到B个子特征向量y1,y2,…,yB,其中yi(i=1,2,…,B)表示提取到的测试样本第i块的LBP特征向量。同样地对每一个训练样本提取子特征向量,Ai(i=1,2,…,B)表示由所有训练样本的第i块LBP特征向量组成的矩阵。以第i块为例,yi对应矩阵Ai在核空间中用SRC(p=1)或CRC(p=2)表示的模型为

(13)

其中,αi表示在核空间中的第i块对应的编码系数向量。假设从同一测试样本提取的不同块特征yi(i=1,2,…,B)对应矩阵Ai(i=1,2,…,B)有相同的表示形式,则结合一个测试样本的所有块特征的核表示模型可表示为

(14)

其中,α是测试样本y的编码系数向量。式(14)的核表示模型只有在残差服从高斯分布或拉普拉斯分布时才能确保其精确度[5]。然而在实际应用中,人脸通常存在遮挡或伪装等情况,这时候残差的分布可能偏离这两种分布,因此,式(14)的模型对存在异常像素的块鲁棒性不强。

(15)

(16)

be0为由e0决定的尺度限制;W是对角权重矩阵,其第i个对角元素为

Wi,i=w(e0,i)=ρ′(e0,i)/e0,i

(17)

根据以上分析,经转变,式(15)的RKC模型可用式(18)表示

(18)

结合测试样本的所有块特征,则上式变为

(19)

(21)

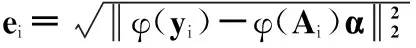

利用所有块的重构残差之和对测试样本y进行分类

(22)

2.3LBP-RKC算法流程

假设测试样本为y,训练样本共有c类,训练集为A=[A1,A2,…,Aj,…,Ac],本文提出的LBP-RKC人脸识别算法流程如下:

1)利用2.1节的分块LBP特征提取算法分别对测试样本和训练样本进行块特征提取,假设人脸被分为B块,得到测试样本的B个子特征向量y1,y2,…,yB,以及训练样本的B个子特征矩阵A1,A2,…Ai,…AB,其中Ai表示由所有训练样本的第i块子特征向量组成的矩阵。

3)给每一个图像块赋予初始权重为1,即wi=1,i=1,2,…,B。

5)计算每一块的重构残差

(23)

(24)

2.4算法复杂度分析

本文分别通过l1范数和l2范数来正规化编码系数执行算法,表示为LBP-RKC_l1和LBP-RKC_l2。LBP-RKC算法的计算复杂度主要集中在RKC的求解上,当人脸图像无遮挡时,每一块的权重wi可固定为1。此时LBP-RKC_l1可通过稀疏编码求解,标准稀疏编码的算法复杂度是ο(m2n1.5),其中m是人脸图像特征维数,n是训练样本个数,本文用文献[13]的L1LS算法求解LBP-RKC_l1模型,其计算复杂度为ο(m2n1.3),和SRC[1]的计算复杂度类似。LBP-RKC_l2可通过协同表示的最小二乘法求解,其计算复杂度为ο(n2), 其中n是训练样本个数。因此,在人脸无遮挡伪装情况下,即wi=1时,LBP-RKC_l2的时间复杂度比SRC要低很多。

3实验结果及分析

3.1AR和Extended Yale B数据库中的光照、表情变化实验

1)AR数据库上的实验

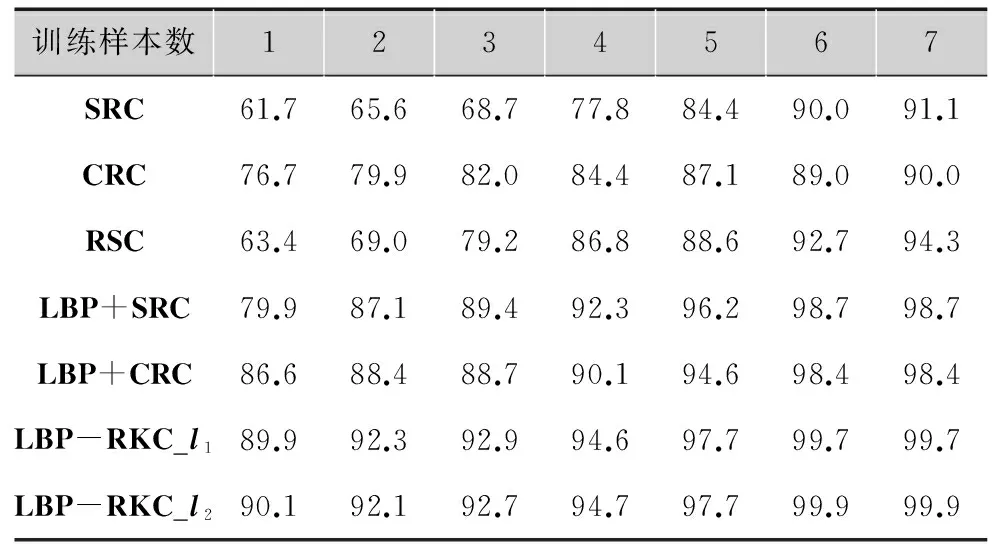

在AR人脸数据库中,选择50名男性和50名女性的人脸组成数据库子集,抽取每人的14幅光照、表情变化的人脸图像,其中7幅用来训练,另外7幅作为测试集。图像尺寸统一调整为83×60。表1显示在训练样本个数不同情况下多种算法的识别率比较。由表可看出,所提出的LBP-RKC算法在目标训练样本个数取不同值时均比其他算法识别率高,在AR数据库中可得到高达99.9%的识别率。LBP-RKC_l1和LBP-RKC_l2识别率类似,但LBP-RKC_l2运算时间短得多。

表1AR人脸库中各算法的识别率 %

训练样本数1234567SRC61.765.668.777.884.490.091.1CRC76.779.982.084.487.189.090.0RSC63.469.079.286.888.692.794.3LBP+SRC79.987.189.492.396.298.798.7LBP+CRC86.688.488.790.194.698.498.4LBP-RKC_l189.992.392.994.697.799.799.7LBP-RKC_l290.192.192.794.797.799.999.9

2)Extended Yale B数据库的实验

Extended Yale B人脸库由38个目标的2 414幅正面人脸组成,其中每人大约有64幅图像,来自64种实验光照条件。随机选择每人32幅作为训练数据,剩余32幅作为测试集,在测试集不变情况下,每次选取的训练样本个数不同进行4组实验(训练样本的个数分别选择每人6幅、12幅、24幅、32幅)。实验中图像均裁剪为96×84。表2所示为在Extended Yale B数据库中训练样本个数不同的情况下多种算法的识别率比较。由表可看出,本文提出的LBP-RKC算法取得了最好的识别率,在训练样本个数较少时(例如6和12),本文算法和其他算法对比平均提高6%左右。当选择较多训练样本时(例如24和32),本文算法几乎取得百分百的识别率,例如训练样本取32个时,LBP-RKC_l2达到99.3%的识别率。

表2Extended Yale B人脸库中各算法的识别率 %

训练样本数6122432SRC72.384.294.795.3CRC74.885.894.395.0RSC77.885.495.098.2LBP+SRC74.588.196.898.4LBP+CRC75.088.597.298.0LBP-RKC_l178.089.897.198.8LBP-RKC_l280.090.998.599.3

3.2FERET数据库中的姿态偏转和尺度变化实验

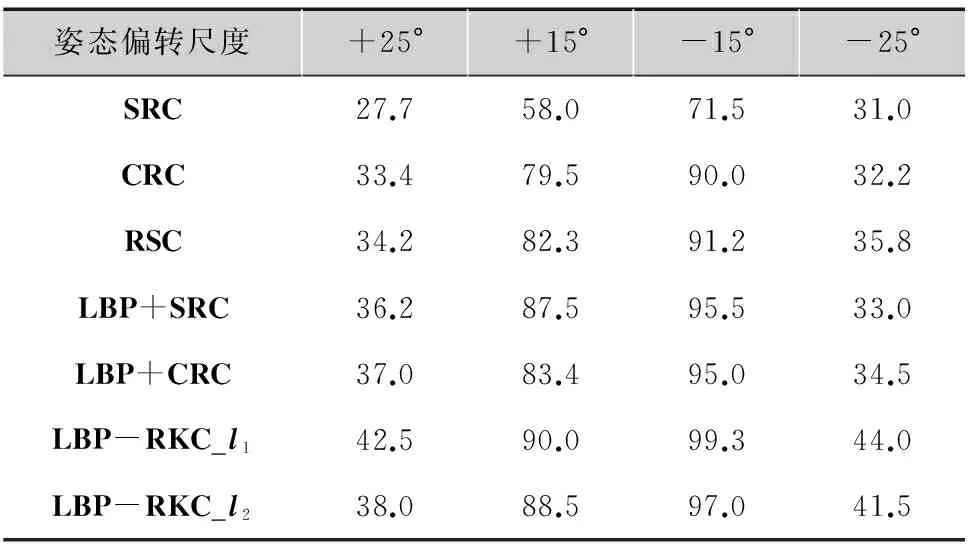

FERET数据库包含了表情、光照、不同尺度下的姿态变化人脸图像,本文实验选取200人的1 400张图像,每人7幅。图2为实验中某个目标的图像,从左到右分别为标准、表情变化、光照变化、偏转-25°、偏转-15°、偏转+15°、偏转+25°的7幅人脸图像。以前3幅图像作为训练集,4个偏转角度不同的图像分别作为4个测试集。图像均裁剪为80×80。表3所示为FERET数据库中姿态偏转尺度不同的情况下多种算法的识别率比较。由表可以看出,所提出的LBP-RKC算法识别率均优于其他算法,尤其是在测试集姿态偏转尺度较大时(+25°和-25°)明显提高。由于PCA算法对姿态偏转较为敏感,原始的SRC算法取得的识别率明显偏低。

图2 来自FERET数据库中某个目标的图像

3.3AR数据库中的遮挡伪装实验

本节将在AR数据库中测试LBP-RKC算法对遮挡的鲁棒性。AR数据库包含两个部分(Session1和Session2),每部分包含的人脸图像有:7幅光照表情变化、3幅眼睛遮挡、3幅围巾遮挡。选择50名男性和50名女性人脸作为实验对象,从session1选择每人4张光照表情变化的人脸图像作为训练集,Session1和Session2中有遮挡的人脸分别作为4个测试集。图像尺寸统一调整为83×60。实验中,LBP-RKC算法和RSC算法更新权重的最大迭代次数均设为10。4个测试集在不同算法中的识别结果如表4所示。由表可看出,LBP-RKC算法在所有测试集中均取得最好效果。在Session1中的2个测试集达到百分百的识别率,围巾遮挡比时新算法SRC、CRC和RSC分别高58.2%、55%、7.6%,眼镜遮挡分别高19.8%、20.2%、4.7%以上;而在Session2中眼镜遮挡和围巾遮挡至少比3种时新算法高6.7%和17.7%。LBP-RKC算法和LBP+SRC、LBP+CRC相比也有一定程度的提高,这是由于本文算法不仅通过提取分块的LBP特征突出局部细节,而且把低维数据投影到核空间中,增强不同类的差分能力,并且用模型处理图像中的异常值,减少其对分类的影响。

表3FERET人脸库中各算法的识别率%

姿态偏转尺度+25°+15°-15°-25°SRC27.758.071.531.0CRC33.479.590.032.2RSC34.282.391.235.8LBP+SRC36.287.595.533.0LBP+CRC37.083.495.034.5LBP-RKC_l142.590.099.344.0LBP-RKC_l238.088.597.041.5

表4AR人脸库中遮挡伪装下各算法的识率 %

算法Session1Session2眼镜遮挡围巾遮挡眼镜遮挡围巾遮挡SRC81.241.856.322.0CRC79.845.052.346.5RSC95.392.488.079.0LBP+SRC99.597.584.289.0LBP+CRC99.095.679.385.7LBP-RKC_l199.710094.796.7LBP-RKC_l210010094.496.7

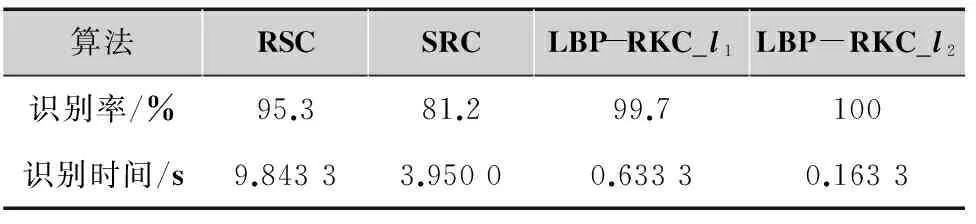

3.4识别时间比较

除了识别率,运行时间也是一个评估算法性能的重要标准。从2.4节的算法复杂度分析可知本文算法复杂度较低,下面在AR数据库上进行验证。实验平台为主频2.6 GHz的处理器,4 Gbyte内存,MATLAB R2013a版本仿真软件。实验分为两个,一个是3.1节中的AR数据库中的无遮挡实验(训练样本数为每人7幅),另一个是3.3节中的AR数据库中Session1部分有眼镜和围巾遮挡伪装的实验,对比算法包括SRC和RSC。

表5,6,7分别为AR数据库中无遮挡、眼镜遮挡、围巾遮挡下的对比结果,显示时间为识别一张测试图片的平均时间。由表可看出,RSC算法的识别率高于SRC,但是其识别时间比SRC长得到多,算法效率不高;而SRC在无遮挡情况下,其识别时间比LBP-RKC_l1快,但后者识别率明显高于前者,当在有遮挡时,SRC算法由于加入了一个单位矩阵来编码异常像素,其运算时间大大增加;LBP-RKC_l2可由最小二乘法求解,其时间复杂度最低,同时识别率也较高,证明了本文算法的高效性。

表5AR库中无遮挡时的识别率和时间对比

算法RSCSRCLBP-RKC_l1LBP-RKC_l2识别率/%95.794.799.799.9识别时间/s1.69430.37861.59420.0401

表6AR库Session1部分眼镜遮挡时的识别率和时间对比

算法RSCSRCLBP-RKC_l1LBP-RKC_l2识别率/%95.381.299.7100识别时间/s9.84333.95000.63330.1633

表7AR库Session1部分围巾遮挡时的识别率和时间对比

3.5实验分析

从以上识别率和识别时间的实验结果可知,本文提出的LBP-RKC算法不仅在光照表情变化、姿态偏转、遮挡伪装实验中取得了较高的识别准确率,同时也从时间上证明了其算法的高效率,原因有以下几点:

1)LBP-RKC算法首先进行了分块的LBP特征提取,有效地突出了图像的局部细节特征;

2)把数据投影到核空间中,增大了类别间的几何差距,加强了数据的线性可分性;

3)采用一个鲁棒的回归函数来处理人脸图像中的遮挡,姿态偏转等问题,对不同像素赋予不同的权重,如异常值分配较小的权重,降低它们对分类的负影响,在人脸分类识别中更具合理性;

4)在最后分类步骤中,利用不同块之间的残差之和进行判别分类,具有更强的分类决策能力。

4总结

本文结合鲁棒的稀疏编码算法,提出了一种LBP-RKC人脸识别算法。该算法的特点是在核空间中建立一个鲁棒的表示模型来处理图像的异常值(如遮挡、损坏、伪装时的像素),并采用多级分块LBP直方图特征作为人脸图像的局部统计特征,加强了图像的局部细节特征。通过在光照变化、表情变化、姿态偏转、块遮挡和伪装等不同条件下的人脸图像进行验证,本文算法均取得较好的识别效果,且运算效率较高。LBP-RKC算法适用于存在各种噪声和遮挡情况下的人脸图像,和当前的一些人脸识别算法相比,识别率也有了明显的提高,是一种能较好应用到实时人脸识别系统的算法。

参考文献:

[1]WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE transactions on pattern analysis and machine intelligence, 2009, 31(2): 210-227.

[2]RIGAMONTI R, BROWN M A, LEPETIT V. Are sparse representations really relevant for image classification?[C]// 2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). [S.l.]:IEEE Press, 2011: 1545-1552.

[3]ZHANG D, YANG M, FENG X. Sparse representation or collaborative representation: which helps face recognition?[C]// 2011 IEEE International Conference on Computer Vision (ICCV) . [S.l.]:IEEE Press, 2011: 471-478.

[4]ZHANG L, YANG M, FENG X, et al. Collaborative representation based classification for face recognition[EB/OL].[2015-05-27].http://perception.csl.illinois.edu/recognition/Files/CRC.pdf.

[5]YANG M, ZHANG D, YANG J. Robust sparse coding for face recognition[C]//2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) . [S.l.]:IEEE Press, 2011: 625-632.

[6]YANG M, ZHANG L, SHIU S C K, et al. Gabor feature based robust representation and classification for face recognition with Gabor occlusion dictionary[J]. Pattern recognition, 2013, 46(7): 1865-1878.

[7]AHONEN T, HADID A, PIETIKAINEN M. Face description with local binary patterns: Application to face recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2006, 28(12): 2037-2041.

[8]MIN R, DUGELAY J L. Improved combination of LBP and sparse representation based classification (SRC) for face recognition[C]//2011 IEEE International Conference on Multimedia and Expo (ICME) . [S.l.]:IEEE Press, 2011: 1-6.

[9]KANG C, LIAO S, XIANG S, et al. Kernel sparse representation with local patterns for face recognition[C]// 2011 18th IEEE International Conference on Image Processing (ICIP) . [S.l.]:IEEE Press, 2011: 3009-3012.

[10]OJALA T, PIETIKAI INEN M,MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. Pattern Analysis and machine intelligence, 2002, 24(7): 971-987.

[11]匡金骏, 熊庆宇, 柴毅. 基于核稀疏分类与多尺度分块旋转扩展的鲁棒图像识别[J]. 模式识别与人工智能,2013, 26(2): 129-135.

[12]GAO X, MIAO Z J. Generalized histogram intersection kernel for image classification[C]//2014 IEEE International Conference on Signal Processing (ICSP).[S.l.]:IEEE Press, 2014: 866-870.

[13]LEE H, BATTLE A, RAINA R, et al. Efficient sparse coding algorithm[C]//Proc. Neural Information and Processing Systems.[S.l.]:IEEE Press,2006.

[14]GAO X, MIAO Z J. Generalized histogram intersection kernel for image classification [C]// 2014 IEEE International Conference on Signal Processing (ICSP).[S.l.]:IEEE Press,2014: 866-870.

袁华(1975— ),讲师,硕士,主要研究方向为图像处理、智能信号处理;

钟欢虹(1989— ),女,硕士研究生,主要研究方向为人脸识别、图像信号处理;

欧阳宁(1972— ),硕士,教授,本文通信作者,主要研究方向为模式识别、智能信息处理、图像信号处理;

莫建文(1972— ),博士,副教授,主要研究方向为图像信号处理、模式识别。

责任编辑:闫雯雯

Face recognition based on block LBP and robust kernel coding

YUAN Hua, ZHONG Huanhong, OUYANG Ning, MO Jianwen

(SchoolofElectronicandTechnology,GuilinUniversityofElectronicTechnology,GuangxiGuilin541004,China)

Abstract:Focused on the issue of occlusion and pose rotate in face recognition, an improved face recognition method based on the block LBP and robust kernel coding is proposed, which is named LBP-RKC. Firstly, LBP-RKC algorithm extracted the multilevel blocking LBP features of face images, and the statistical histogram features of each block will be obtained. Then, projecting the features into a kernel space, a robust regression model is used to deal with the image outliers is built in the kernel space, and it uses the iteratively reweighted algorithm to solve this model. Finally, it classifies and recognizes the test sample by calculate kernel code reconstruction residual of each block. Experiments results show that the proposed algorithm LBP-RKC has a good recognition on dealing with the face images that have occlusion and pose rotate, and the efficiency of the algorithm is higher at the same time.

Key words:face recognition; occlusion; block; local binary pattern; kernel coding

中图分类号:TP391.41

文献标志码:A

DOI:10.16280/j.videoe.2016.02.023

基金项目:国家自然科学基金项目(61362021);广西自然科学基金项目(2014GXNSFDA118035;2013GXNSFDA019030;2013GXNSFAA019331;2012GXNSFBA053014)

作者简介:

收稿日期:2015-05-27

文献引用格式:袁华,钟欢虹,欧阳宁,等. 基于分块LBP和鲁棒核编码的人脸识别[J].电视技术,2016,40(2):119-126.

YUAN H, ZHONG H H, OUYANG N,et al. Face recognition based on block LBP and robust kernel coding[J].Video engineering, 2016,40(2):119-126.