技术与正义:未来战争中的人工智能

2016-05-14徐英瑾

【摘要】关于人工智能技术的军事化运用所可能造成的伦理学后效,既有的批评意见有:此类运用会钻现有国际军备管控条约的空隙并促发此类武器的全球扩散;会降低杀戮门槛,并导致更多平民死亡,等等。然而,这些批评意见往往对传统军事战术平台与人工智能化的战术平台设置双重了标准,并刻意夸大了后者对于改变全球安全局势的全局性意义。而要真正使得军用人工智能技术的伦理学后效能够满足人类现有的价值观体系,其主要举措并不在于去粗暴地禁止此类装备的研发,而恰恰在于如何使得此类设备具备人类意义上的“伦理推理能力”。而在该研发过程中,如何解决“各向同性问题”亦将成为研究重点。

【关键词】 军用机器人(技术) 人工智能 伦理学 各向同性 心灵状态指派

【中图分类号】TP18 【文献标识码】 A

【DOI】10.16619/j.cnki.rmltxsqy.2016.07.004

导论:军用人工智能系统提出的伦理学挑战

众所周知,人工智能技术的核心命意,乃是通过对于计算机的恰当编程,以使得相关设备能够在行为层面上表现出与人类类似的“智能性”。尽管关于什么样的行为可以被判为“智能的”,学界尚有不少的争议,但是一般人都不会反对这么一条评判意见:理想中的人工智能产品,应当能够在尽量减少人工干预的情况下,在相关工作环境中,按照用户的要求自主地完成各种任务。很显然,人工智能产品的这种特性,倘若真能实现,那么,其对于人力资源在各种生产活动中的地位,便会构成一种传统机器所难以比拟的“威胁”,此即:该技术不仅威胁到了传统体力劳动者的地位,而且也部分威胁到了作为新的有用信息产生者的脑力劳动者的地位。而这一点又使得人工智能技术自身与以通讯技术为代表的传统信息技术有了区别:在通讯技术中,技术承载者本身并不提供新的信息,而只是在传播信息方面提供便利;与之相比较,理想的人工智能技术平台则成为新的有用信息的供应节点。

虽然目前的人工智能技术离全面取代各行各业的人力资源依然有颇长的一段路要走,但是在一些人力资源相对稀缺的领域,这方面的社会需求已经非常强劲,甚至相关的某些应用实践也已经渐渐展开。在美国耶鲁大学的生物伦理学跨学科研究中心的研究员瓦拉赫(Wendell Wallach)与美国印第安纳大学的科学哲学与认知科学专家艾伦(Colin Allen)合写的《道德机器:如何教会机器人辨明是非》①一书第三章中,他们提到了人工智能技术的三个最有前途的应用领域:军用机器人(以便减少战争中的直接人力投入,以此避免己方军队伤亡);性爱机器人(以便以某种法律上许可的方式满足单身人士的生理欲望,并以此降低全社会的性犯罪率),以及工业机器人(以便应对因为人口老龄化所造成的用工荒)。不难想见,虽然人工智能技术在这三个领域的运用都会导致相关的伦理问题,但是军用人工智能系统所构成的伦理学问题是最为尖锐的,因为此类系统的任务就是直接杀戮生命,或为杀戮提供间接帮助。这自然也就牵涉到了特定军事暴力行为自身的合法性问题。美国空军退役上校,现于塔尔顿州立大学教授哲学与宗教的哈尔嘎斯(Matthew Hallgarth)就此写道:

军事冲突的语言即关于辩护(justification)的语言。军事冲突导致人员的死亡以及财产的受损,并造成各种形式的可以想象的大量伤害。不给理由就去做这些事情乃是疯狂的。不过,即使你有了理由去做了这些事情,如果同样的目标可以通过更少的人员与财产损失来达到,那么,相关的军事行动还是无法得到辩护。②

这段话的基本精神便是:(1)军事行动分为“得到有效辩护”与“未得到有效辩护的”两种;(2)军事行动所导致的破坏,在战争行为得到辩护的前提下,在伦理上便是可以被允许的;(3)不过,对于某个特定的军事行动的辩护本身的门槛很高,因为此类辩护需要比对战争行为与各种其他可能手段各自的损失/效益比,并证明相关军事行动的损失/效益比最低(譬如,在2004年9月3日结束的导致333名无辜人质死亡的“别斯兰人质事件”中,俄罗斯安全部队所采用的通过释放神经毒气、麻痹匪徒的方式来解救人质的行为是否能够得到合适的伦理学辩护,在相当程度上将取决于我们如何预估在不采用此类攻击方法的前提下人质所可能遭到的损失)。

不过,此类关于军事行动自身可辩护性的争鸣可谓古已有之,而军用人工智能系统的介入,又会在多大问题上会改变此类问题的性质呢?

这种改变主要体现在以下两个方面:理论方面与实践方面。

先来看实践方面。试想:如果别斯兰事件的处理者从人类士兵转为人工智能系统的话,那么,对于特定军事行动的决策将由机器自主完成。而在这样的情况下,相关行动的伦理学责任的承载者也就会随之成为一个问题——譬如:我们可以因为人类指挥官的错误军事决策而将其告上军事法庭,但是,我们又如何可能将犯下错误的机器人战士告上军事法庭呢?很显然,我们目前的法律系统还没有为处理此类问题做好准备。

再来看理论方面的问题。在人类指挥官发出命令或人类士兵执行命令的情形下,不必预设我们已经具备了关于这些军人的大脑运作的充分知识(因为即使在神经科学知识付诸阙如的古代,一个指挥官也应当知道他的士兵能够听懂并执行其命令)。与之相对比,由于机器人士兵的每一个元件与每一步算法都是人类设计者的产物,故而,我们根本就不能设想这样的机器人能够在“其设计者不知其如何运作”的前提下还能够按照设计者的要求去运作。这也就是说,恰恰是对于机器人战士的设计本身,倒逼着设计者们先从理论层面上弄清人类战士的伦理决策过程的各个细节——而不幸的是,无论是现有的伦理学的研究,还是现有的对于支持人类伦理决策过程的神经机制的研究,都还没有成熟到能够为“伦理决策的程序化编制”提供稳固的学理依托的地步。

读者或许会说,既然机器人战士的设计在实践上会造成麻烦,而在理论上又缺乏扎实的学术准备,我们又为何要费心发展此类技术呢?但这样的反驳其实并不是很有说服力。假设我们“穿越”回了达·芬奇的时代,并由此目睹了这位艺术大师兼工程学大师正在设计飞行器。请问,文艺复兴时代的欧洲法律体系,已经为飞行器的安全使用做好相关准备了吗?而当时的物理学发展,是否也已经为飞行器的设计提供了扎实的学术基础了呢?恐怕都没有。但是,我们却难以由此得出“达·芬奇在胡闹”的结论,因为没有他的这些勇敢的技术尝试,欧洲的科学技术就难以在日后发展到足以使得对于飞行器的设计与建造成为现实的地步。此外,相关的飞行器交通法规的出现与完善,也只有在相关交通工具的确已经成熟的前提下才有可能。所以说,实践与理论上的困难,并未构成阻碍我们制造军用人工智能系统的充分理由,相反还会在一定程度上构成相关技术努力的“激发器”(不过,关于如何克服这些具体的困难,显然还是有巨大的讨论空间的。详见后文)。

读者或许还会说:飞行器与军用机器人不同,前者可以用于战争目的,也可以用于和平目的,后者则只可以用于军事目的。因此,建造军用机器人从根本上就是反伦理的。不过,这依然是一个很薄弱的反驳意见。从手枪到核导弹,人类毕竟已经建造出了各种类型的武器弹药。缺乏对于运用这些武器的历史语境的考察,抽象地指责军火工业是“反伦理的”还是“有利于促进人类道德水平的”,恐怕都是毫无意义。而这个一般性的结论,也应当能适用于对于智能化武器的讨论中去。

而一些对智能武器特别抱有敌意的批评者或许会继续反驳说:我们并不反对制造一般意义的有人操控的武器,但是我们反对制造并且使用具有高度自主性(特别是具有自主开火权)的军用智能机器人,因为这类武器很特殊——而正是因为这种特殊性,才使得我们有理由禁止开发并且部署它们。

那么,究竟是军用智能机器人的哪些“特殊性”才使得它成为被禁止的理由呢?而这些理由是否能够站得住脚呢?

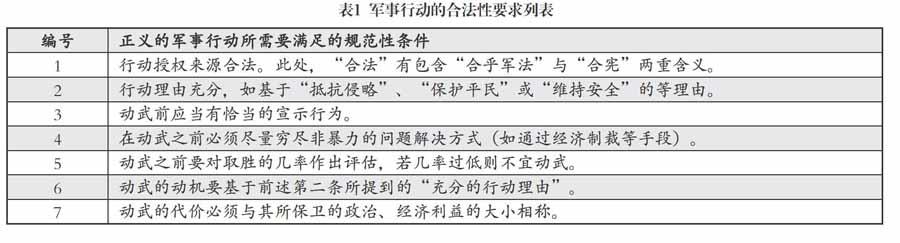

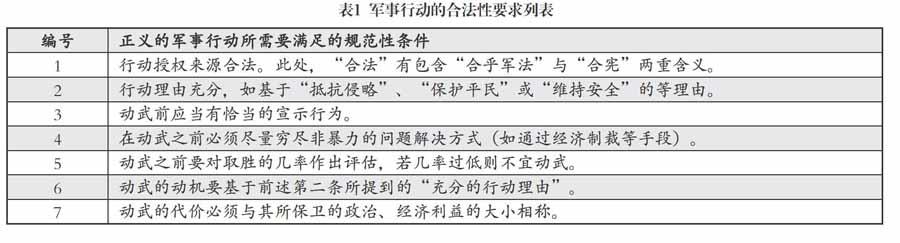

关于智能军用系统之伦理危害性的五个论证及其薄弱处

前面我们已经提及,从伦理学角度看,军事行动可分为“得到辩护的”与“未得到辩护”两类。这也正是俗称的“正义的”与“非正义的”军事行动之间的分别。哈尔嘎斯则将“正义的”军事行动所应当具备的规范性条件归结为七条(见表1③)。很显然,如果一个人试图论证智能军用系统的广泛运用能够使得对于这七条规范中的至少一部分更难被满足的话,那么,这样的论证结论就自然能够帮助其导出对于人工智能的军事运用的负面伦理学评估。反过来说,如果人工智能的军事运用的支持者能够证明此类产品的出现不足以对上述规范的满足构成明显的障碍的话,那么,上述负面评估的可靠性也就会由此抵消。

就上述七条规范性原则与人工智能系统的军事化运用之间的关系而言,笔者的大致意见是:这些规范主要关涉到了战争行为的宏观决策行为,而与个别作战人员的当下战术决策关系不大(譬如,特定的武装力量首脑以及其他政治支配力量对于战争理由的解释是否恰当,实际上与基层指战员的战术决策方式并无直接因果关系)。而就通常人的理解而言,人工智能技术对于现有武器的改造往往是针对战术兵器而言的,并以使之“无人化”为短期目标,而一般并不特别针对洲际导弹等战略兵器的改造(因为后者本来就已是“无人化”了)。在这样的情况下,人工智能技术的军事化所导致的战争样态的变化也只具有战术层次上的意义,而不会在更宏观的尺度上改变使得战争决策本身得以被给出的整个政治经济环境。由是观之,至少从原则上看,军用机器人的出现似乎并不会使得本来非正义的战争变得正义,也不会使得本来正义的战争变得不正义。此外,由于智能武器的研发本身,本来就有“使得军事打击更为精准化”与“降低人类士兵生命风险”这两大设计初衷,因此,它们的出现无疑还能够降低战争的损失,而由此提高战争的“人道指数”。故而,似乎并不存在着一些特别强的理由去促使伦理学家们为智能武器的出现打上负面的印象分。

不过,这样的粗略的回复显然不能够说服坚持为军用人工智能系统的伦理学面相“打负分”的伦理学家们。且看他们在下面所提出的更为细致的反驳意见,以及笔者对于这些意见的再反驳。

反驳意见一:无人智能武器的出现会钻现有的国际武器控制条约的空子,并由此使得世界和平更为脆弱。

此意见是德国的技术伦理学家阿尔特曼(Jürgen Altmann)提出的。④阿尔特曼提醒我们注意:战术兵器(如主战坦克)与战略兵器之间的界限,会在前者的数量被大量增加的情况下而变得模糊(比如,十个装甲师就可以被认为是一支战略性力量了),因此,人工智能技术与既有作战平台的结合物,只要乘以巨大的数量,就会导致战略能力的激增,对国与国之间的战略平衡造成威胁,并进而危害世界和平。他同时提醒我们注意:目前世界上现有的武器控制条约都没有对人工智能技术的广泛使用作出明确限定,这就为在这方面掌握技术优势的国家“钻条约的空子”大开了方便之门。以1990年通过的《常规武装力量裁减条约》(The Treaty on Conventional Armed Forces)为例,此条约对北约与俄罗斯所各自能够在欧洲部署的主战坦克、自行火炮、武装直升机等常规陆战战术平台的数量上限作出了规定,并允许条约签订国对彼此的条约执行情况进行互检。需要注意的是,该条约在字面上并没有谈及上述战术平台应当是有人驾驶的还是无人驾驶的,而只对相关作战平台的物理特征做出了规定(如“坦克重量必须在16.5吨以上”,等等)。在这样的情况下,无人驾驶的“类坦克兵器”或许就能通过“减重”而使得其摆脱“坦克”的名义标签,并由此得到不受条约控制的发展(需要注意的是,在减去三名到四名人类成员的前提下,此类“减重”在技术上并不困难)。

笔者的再反驳意见:没有任何一个军备控制条约能够覆盖未来兵器的可能的发展方向,而这一点即使在无人智能武器出现之前也是成立的。以1922年通过的《美英法意日五国关于限制海军军备条约》(或简称《五国公约》)为例:该条约对签约五列强的战列舰、巡洋舰等主要舰种的吨位分配以及相关武备(特别是舰载火炮与鱼雷武器)的性能上限均作出了规定。但是,这个条约并没有对在日后的海战中大放光彩的航空母舰的发展作出明确限制,而这一点也在客观上为各签约国(特别是日本与美国)日后的庞大航母编队的出现打下了伏笔。然而,若有人因为这一点“疏漏”,就提出“倘若人类当时就能够禁止各国研发航母,山本五十六就根本无法制定偷袭珍珠港的计划了”之类的议题,未免就显得过于天真了。纳粹德国在二战时期根本就没有一艘可用的航母(其“齐柏林”号航母直至战争结束时都未服役),但这似乎并没有阻止其研制出V-1与V-2导弹袭击伦敦——而与早在“一战”后期就已出现的早期航母相比,导弹武器当然更是在《五国公约》的文本草拟者头脑之外的事物了。这也就是说,既然任何军备控制条约都会有所遗漏,那么,即使现有的军备条约包含了限制智能武器使用的条款,也不能够保证条约草拟者所忽略的其他未来兵器(如可以小型化的电磁炮与激光炮)不会比无人智能武器带来更大的“战略失衡风险”。此外,从纯军事技术的角度看,阿尔特曼所设想的无人驾驶的自主性坦克与传统有人坦克之间的差异,其实要远远小于航母与战列舰之间的差异。航母毕竟是与战列舰在作战功能上非常不同的一类高端海战兵器,而抛开“有人无人”这一点不谈,无人坦克的作战功能与有人坦克是基本相同的。譬如,未来无人坦克的现有雏型——美军Robot-TALON-SWORDS系统(2007年服役)——所装备的M-240机枪或者40毫米榴弹发射器,并不会因为其被安装到了无人驾驶平台上,而在技术参数上有别于人类士兵手中的同型号武器。因此,即使此类无人驾驶战术平台在数量上被累积到了可观的数字,由此而为新技术拥有方所带来的战略优势也是有限的,并很容易被对方所具有的其他更具摧毁性的武器(如战术核武器)所抵消。由此看来,即使在无人智能武器被广泛运用的明日战场,对于世界和平最大的威胁依然还将会是核、生、化等既有的大规模杀伤性武器。而将武备控制的焦点转向人工智能的军事化运用,或许恰恰反而会诱使我们错过了国际军备控制问题的真正关节点。

反驳意见二:无人智能武器的出现,很可能会为此类的武器的全球扩散制造机缘,并由此使得世界的和平更为脆弱。

这一条反驳意见与上一条反驳意见有一定的意义关联,但是其重点是放在军控条约之外的军备仿制行为之上的。由帕恰克·林(Patrick Lin)所牵头的一个科技伦理研究团队,在由美国海军资助的研究报告《战争机器人的风险与相关的伦理议题》⑤中指出,即使美国军队所研制的军用机器人能够暂时取得战场上的战术优势,一旦此类装备被具有相当的逆向工程学仿制能力的敌方所俘获,那么,此类武器的扩散就会成为不可避免的事情。此外,考虑到任何一个此类军品的研发国都会觉得自己的研发行为具有政治上的正义性,所以,单纯的伦理学争辩将无法说服任何一方冻结此方面的研发行为。故而,全球范围内的人工智能军品研发竞赛也将无法避免。

笔者的再反驳意见:上述反驳意见其实已经夸大了反向工程学设计对于新技术的获取能力。相关技术理由有四:(甲)即使军用机器人被敌方俘获,使得其软件得以运作的源代码也未必能够得到技术能力相对有限的俘获方的成功解码;(乙)即使此类源代码被成功解码,被解码方修改源代码程序以升级原有武器的软件包的技术难度,也会远远小于重新设计相关武器的硬件平台的技术难度——而此类升级会立即使得解码方的解码成果变得意义甚微;(丙)我们或许不难设想:未来军用机器人本身的智能力量在很大程度上将依赖于存储于“云”中的大数据信息,故而,对于单个平台的俘获未必会对已经占有信息优势的一方构成真正的损害(除非俘获方可以“黑”入地方网络窃取情报——但要做到这一点,却未必以俘获地方战术机器人为前提);(丁)由于人工智能军品的广泛运用,会大大降低人类士兵被地方俘获的几率,因此,相关运用反而会降低经由被俘人员之口泄露军事机密的几率(因为无论从技术还是伦理角度上看,安置人工智能军品被俘后的自毁程序的难度,均要远小于教育人类士兵被俘后“宁死不屈”的难度)。

结合前面四方面分析,我们不难看出:如果人工智能兵器的俘获方本身不具备强大的人工智能产品的研发能力与数据采集方面的积累的话,此类俘获行动为其所带来的战术与战略优势恐怕都会是相对有限的——而反过来说,倘若其已经具备了这方面的很强的科研能力的话,那么,通过俘获敌方产品来提升自身武器性能的做法,意义也就不大了。故而,从人工智能军品的“可俘获性”之中,我们恐怕并不会立即推出相关技术的“易扩散性”。

反驳意见三:无人智能武器的出现,会使得杀戮变得更为容易,因此,也会使得军事暴力在未来变得更为频繁。

谢菲尔德大学的机器人与公共事务方面的专家沙克(Noel Sharkey)从战争心理学的角度,讨论了人类士兵直接参与的战争与未来由机器人所主导的战争之间的差别。他援引历史学家的研究成果指出,当人类士兵面对敌对方的其他人类士兵的时候,其杀戮行为会受到种种心理压力的制衡(如在二战的太平洋战场,有八成的美军步枪手在面对敌人时要么故意不放枪,要么故意将子弹打偏;而通过对于美国内战的盖茨堡战役中随机回收的27574支火枪的调查,历史学家还惊讶地发现:其中的九成枪支存在着重复装弹的问题——这就说明很多士兵只是在战场上装出向敌军射击的姿态)。⑥然而,军用机器人却不会在面对人类目标时具备同等的心理压力,因此,其杀戮行为也会变得更为冷酷而高效。此外,在机器人战士已经被广泛运用的前提下,战争决策人与实际的杀戮场面之间的“杀戮距离”也会被拉得很大,以至于残酷的战争场面已经难以对人类决策者的实际心理构成任何值得一提的影响。这同样亦使得阻碍战争决策发生的相关心理门槛变得更低,并使得决策者更容易趋向于使用军用机器人(而不是非暴力手段)来达到自己的政治、经济目的。

笔者的再反驳意见:

第一,如果有人认为机器人战士的广泛参战对于杀戮效率的提高会最终对和平构成威胁的话,那么,从逻辑上看,为了保卫和平,我们不仅要阻止机器人战士的参战,而且还要阻止任何别的手段去增加杀戮效率,甚至还要努力降低这种效率。由此导致的推论便是:保卫和平的最佳方式,就是制造出尽量劣质的枪支,在训练中鼓励士兵故意不击中目标,等等。但这显然是荒谬的。此外,在传统战争中,紧张、负罪感等心理压力对于人类战士心理困扰,本身就会贻误战机,并提升己方战友被敌人杀伤的概率,甚至是误操作武器伤害自身的概率(比如,南北战争时期前膛枪的弹药若被重复装填,其实是非常容易导致严重的炸膛事故的)。而在假设我们所参与的战争具有正义性的前提下,上述种种因素的浮现,显然只会促使邪恶势力更快地胜利,并由此反而降低全球的伦理水准。而反过来说,只要战争本身的正义性不成为问题,人工智能技术的军事运用,则会使得人类指挥员的作战意图可以得到更高效、更精准的贯彻,并使得具有正义性的战争早日胜利(笔者的这一意见参考了前文提到的帕恰克·林等人给出的调研报告的相关内容,但是笔者根据自己的意见对其原始表述作出了改写⑦)。

第二,甚至关于“军用机器人在进行杀戮时毫无心理压力”这一断语,我们也不能够给予充分的赞同。机器人的设计者当然不希望自己的产品会在战场中因为“紧张”而发生武器的误操作,但是,为了能够在复杂的战场环境中更为有效地进行针对不同行为的伦理后果的推理,一些设计者依然希望能够在软件层面上模拟出“怜悯”等人类情绪,以便使得机器人的行为输出能够接近富有正常感情的人类战士的输出(关于这一问题,后文还要详谈)。因此,即使此类军用机器人虽然在面对真正的敌人的时候会有更高的杀戮效率,但这也绝不意味着它们会“滥杀无辜”。

第三,至于人工智能的广泛运用是否会降低战争发动的门槛,则需要结合多重因素做全面评估。应当注意的是,即使在军用无人机技术还远远没有达到“无监督自主运作”的今天,对于精确制导弹药的广泛运用,早已使得以美国为代表的西方军事强国具备了针对弱国的巨大军事优势。但即使在这样的前提下,各国的宪法与相关的经济、政治考量,也会使得相关国家的领导人在军事决策问题上有所顾忌(如时下美国政府在打击伊斯兰国与干涉叙利亚局势时的瞻望犹豫态度,便可为明证)。而人工智能因素的介入是否会对既有的国际军事格局产生根本性的影响,则颇令人怀疑。其具体理由是:(甲)自主运作的无人军用平台自身的高昂价格与其所携带的灵巧弹药的高昂价格,依然会构成阻碍当事国轻启战端的经济因素;(乙)在军用人工智能技术使用国的对手是弱国的前提下,人工智能技术的加入对技术使用国的既有军事优势,并不会产生明显的“加分效应”,相反还会成为某种“边际效应”;(丙)而在相关技术的使用国的对手具备较强军事实力的前提下,后者也可以通过升级战略导弹等传统战略兵器的方式,来抵消掉人工智能技术所带来的微弱优势。总之,单就人工智能技术的加入这一因素而言,其使得全球战争变得更为频繁的几率是微乎其微的。

反驳意见四:无人智能武器的出现对于己方士兵生命的保护是以杀死更多的平民为代价的,因此从人道主义角度考量(而不是从狭隘的民族主义角度出发),这些武器的出现降低了全球的伦理水准。

这一意见是瑞典的科技伦理专家韦伯(Jutta Weber)给出的,为此该作者还专门提到了美国与以色列等国运用无人机技术进行反恐战争时,诸多无辜平民也被连带杀死的案例。⑧不过,这样的反驳是否经得起数据的考量,还需要更仔细的考证。

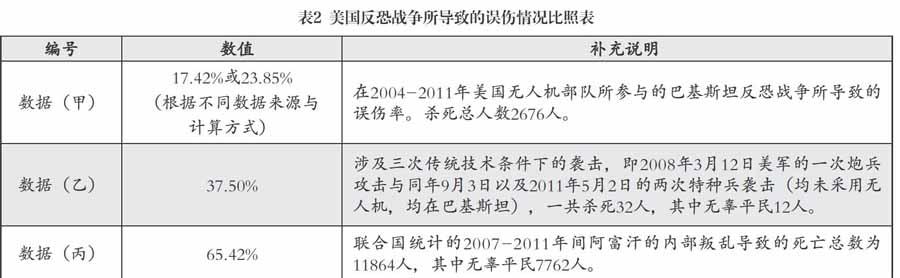

笔者的再反驳意见:美国政治学专家蒲牢(Avery Plaw)针对美军无人机部队在巴基斯坦以及阿富汗所从事的反恐战争,而进行了认真的伤亡估算。⑨根据此估算结果,笔者认为:前述对于无人军用平台“滥杀无辜”的指控,其实是在夸大其辞。具体理由如下:

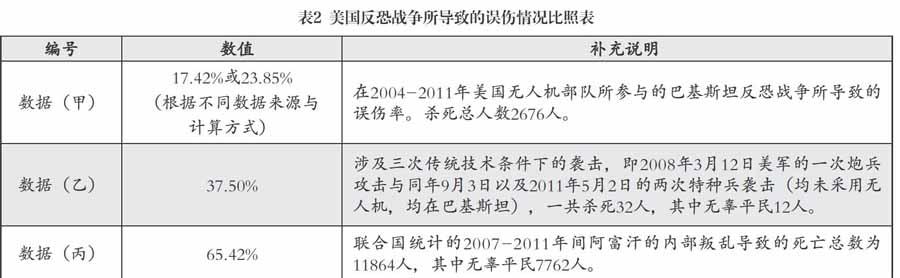

首先我们必须肯定,任何战争都难以避免平民的误伤,而仅仅因为看到平民被误伤就否定一切军事行动的合理性,我们就会转而去否定二战时期盟军轰炸德国与日本的合理性了(众所周知,在这些军事行动中被连累的无辜德日平民的数量,要远超在今日的阿富汗与巴基斯坦的反恐战争中被连累的平民数量)。反过来说,如果我们对有人飞机的轰炸所造成的误伤特别宽容,却特别计较于无人机打击所造成的误伤的话,那么,我们就已经犯下了“设置双重标准”的错误。而更一般地来看,根据所谓的“动武代价相称性原则”,要判断特定类型的军事行动(下面简称为“M”)所导致的误伤量是否达到了一个伦理上可以被接受的最高阈值,我们还需要比较三个数据之间的大小:

(甲)被行动M所误杀的平民占被其所杀死人员的总数(即被误杀者与被杀死的真正敌人之总和)的比例有多高?

(乙)如果M被悬置,而相关军事主体采用传统战争手段进行军事干预的话,那么,其误杀的平民占被其所杀死人员的总数的比例有多高?

(丙)如果相关军事主体什么事情也不做的话,那么,当地平民的死亡数在当地武装冲突所导致的总体死亡数中所占据的比例有多高?

很明显,套用到美国及其盟友所从事的反恐战争的具体语境之中,只要第三个数据明显高于前两个数据,这就说明美军及其盟军对于当地局势的干预,能够使得更多的平民从恐怖分子的枪口下得救(尽管这也难免使得一部分不走运的平民被误伤)。而如果第二个数据又明显高于第一个数据的话,这便会进一步证明运用无人军用平台从事这类军事打击的合理性。而蒲牢所提供的计算结果恰恰支持这种“甲小于乙小于丙”的排序方案(见表2⑩)。

从上面的分析来看,无人机的使用恰恰提升了阿富汗以及巴基斯坦地区的安全形势,拯救了更多良民的生命。另外需要注意的是,目前美军使用的“捕食者”等型号的无人机并不是真正意义上的人工智能产品,因为其运作还需要后方的人类遥控员进行远程指挥。由于遥控员与无人机之间的巨大空间阻隔,操纵信号的延迟便会时常发生,而很多不幸的误伤事件也是由此发生的。不难想见,在未来的人工智能军用平台的运作高度自主化的前提下,此类延迟时差就很可能会被基本消除,而由延迟时差问题所导致的误伤现象也会被进一步减少。从这个角度上说,人工智能化的兵器的“人道性指数”不仅会远超传统人操军用平台,而且也会超过今日的无人机。

反驳意见五:无人智能武器的出现,使得人类士兵的传统“武德”的存在成为冗余,并由此为人类社会的整体安全构成了某种隐患。

这个反驳意见的主要提出者乃是澳洲莫纳什大学的伦理学家斯帕若(Robert Sparrow)。?他具体提到了从属于传统军事组织的人类士兵所需要满足的四项“武德”要求:“勇气”(以使得战士能够直面死亡的威胁而勇往直前)、“忠诚”(以使得战士能够使得自己的利益服务于军事集体的利益)、“荣誉”(以使得战士能够在为军事组织作出奉献之后获得正面的心理反馈)、“仁慈”(以使得战士的军事暴力行为能够多少具备“文明”的面相,如不虐杀俘虏,不伤害平民,等等)。而在斯帕若看来,无论是今日的远程遥控飞机以还是未来的自主性机器人战士,其广泛运用都会使得上述“武德”被渐渐边缘化。具体而言,无论是操控无人机的行为还是给机器人战士下指令的行为,都不需要人类操作员面临任何生命风险,因此,新技术对于人类操作员在“勇气”与“忠诚”等方面的德性要求,也就会随之大大降低。此外,也正是因为武器操控人员与杀戮现场之间的距离足够远,因此,这种无风险的战争也会大大降低人类操作员的军人荣誉感,并使得其难以理解“仁慈”的价值(比如,只有在能够设身处地地思考敌人的处境的前提下,对于敌人的仁慈才是可能的——可远距离的操控却使得这种“设身处地”变成奢望)。而斯帕若的担忧则是:如果这些已经盛行几千年的军人武德被废弃的话,那么武装部队得以被凝结的精神基础也会随之动摇,而这一点又进一步会为人类未来社会的安全性造成不可估量的风险。

笔者的再反驳意见:在对于军用人工智能系统(或作为其当下“前身”的远程操控武器系统)的种种伦理学批判中,斯帕若的意见可谓卓尔不群。因为一般的批评者都已经在自己的立论上或隐或显地预设了和平主义的立场,而斯帕若则似乎是站在军人的传统价值观立场之上。但是,出于以下四点考量,笔者依然认为其批评意见并不能自圆其说:

第一,由于技术优势所导致的交战双方的技术不对称,其实是各个军事强国一直在努力获得的目标,而这种目标的暂时获得自然也就使得技术掌控方能够在“安全距离”之外任意杀戮自己的目标而不必承担风险。因此,传统武德的弱化,其实远在军用人工智能武器或远距离操控系统问世之前就已慢慢发生——譬如,早在1898年的恩图曼战役之后,英国陆军指挥官基钦纳勋爵就对其部属以损失47人代价,用机关枪消灭一万名苏丹战士的“战绩”感到“胜之不武”。?因此,从论证角度看,斯帕若的“武德衰减论”不仅适用于军用人工智能系统,而且也适用于任何能够带来非对称优势的军事科技。由此所导致的逻辑后果便是:我们不应当去发展任何能够带来非对称优势的军事科技,而应当全部回到“武德”最盛的中世纪时代中去,用冷兵器进行战争。但这个推论显然是荒谬的。

第二,斯帕若的论证模糊地提到了武德丧失后人类社会所面临的风险。但是他却没有详细说明这样的风险是什么。很显然,在冷兵器时代,由于武装人员的身体机能对于战斗的胜负至关重要,而“武德”又是维持此类身体机能的重要精神因素,所以,缺乏武德的群体在面对突然的军事威胁时其面临的生存风险的确是很大的(譬如,建康的梁朝士大夫们在548年开始的“侯景之乱”中,就是因为军事勇气匮乏,身体又缺乏基本锻炼,而几乎被叛军屠戮干净)。而在战争技术日益精进的今天,“武德”的衰微所可能导致的社群生存风险也便大大降低了,因为轻易就可以被操纵的武器可以使得妇女也具备强大的自卫能力——除非这些军事技术会莫名其妙地突然失传(但由于军事技术是内生于整个现代科技体系的,除非整个现代科技莫名其妙地崩溃,我们很难设想唯独军事技术会突然失传)。

第三,随着自主性军用机器人的大批服役,人类武装部队成员的职责自然会全面转向对于这些自动化设备的软硬件维护以及远程操控之上,而由此必然会导致部队人员开支的大规模缩减,以及各国国防经费的缩减。同时,武装人员的阶层色彩会从比较容易受到国家意识操控的农民战士,转向受过良好教育的中产白领,这样一来,以民粹主义为底色的军国主义宣传将渐渐失去阶级基础。这一点显然有利于促进全球和平指数的提高。

第四,“勇气”“忠诚”之类的人类德性当然还具有军事活动之外的更为宽泛的应用范围,因此它们不仅仅只能被视为“武德”的一部分。不难想见,在战争之外,商业与科技(乃至各类竞技体育比赛)等领域内的竞争也需要社会成员勇于克险、甘于奉献,因此,只要相关领域内的激励机制能够正常起效,武德的衰落未必会造成社会德性的全面退化。

由于篇幅限制,笔者只是挑选了现有英文文献中最具代表性的几个针对无人军用人工智能系统的伦理学面相的批评意见。从更高的层面上看,这些批评意见均在下述方面将读者引入了思维陷阱:第一,对传统军事战术平台与人工智能化的战术平台设置双重标准,即对前者导致的伦理学问题刻意规避,而对后者所可能导致的问题尽量放大;第二,没有意识到自身对于军用人工智能系统的批评意见也可以被运用到过往的军事技术进步之上,由此,既错过了对于前者的聚焦,又容易导出“反对一切军事技术进步”的极端推论;第三,忽视手段与目的之间的区别,将杀戮效率的提高与战争自身的目的或动机混为一谈;第四,刻意混淆作为战术兵器的军用人工智能系统与战略性兵器之间的界限,夸张前者对于改变全球安全局势的全局性意义。

然而,笔者对于上述批评意见的反驳,并不意味着我们就应当在研发军用人工智能系统时,抱着一种伦理学上的冷漠态度。正确的态度毋宁说是:我们既不能因为相关伦理学风险的存在而因噎废食,也不能因为有人因噎废食了而去对相关风险不管不顾。而正如本文“导论”部分所指出的,军用人工智能系统所导致的最棘手的两个问题是:第一,从理论角度看,如何为相关技术平台的“伦理决策的程序化编制”,提供稳固的学理依托?第二,从实践角度看,如何为那些已经具有高度自主性的军用人工智能系统所可能犯下的错误核定其责任归属?这也便是下节所要讨论的问题。

伦理推理的程序化及军用机器人误伤责任的判定

首先我们需要肯定的是,一个真正具有自主性的(即非远程遥控的)军用机器人肯定是具有伦理推理能力的,因此,去讨论是否要为这样的自主性军用平台去加装相关的伦理推理模块是没有意义的(在这里,我们将“伦理推理能力”宽泛地界定为对于“当下该做什么,又不该做什么”的判断能力)。而之所以这么说,则又是基于如下推理:

(1)与日常生活类似,大量的军事作战任务都会设置各种不同的作战目标(如摧毁敌军战车,但要保卫要点附近的油库,等等)。

(2)由于资源与时间的限制,以及预想中的作战环境所可能发生的改变,在特定的语境中,这些作战目标并不能被完全达成,因此就需要命令执行者在作战目标之中作出取舍。

(3)这就牵涉到被取舍对象的“优先度”排序问题。

(4)虽然系统很可能已经从指挥员那里得到了如何进行此类排序的一般原则(如:“在面对敌军众多装甲战车时,优先攻击主战坦克,然后攻击步兵战车”,等等),但在具体的语境中,如何灵活地执行这些标准却依然是需要某种变通的(比如,倘若系统发现敌军使用的新型步兵战车的车载反坦克导弹的威胁,其实并不小于敌军坦克的坦克炮的威胁,那么,系统应当首先攻击谁呢?)。

(5)上述变通能力是广义上的“伦理推理能力”的一个变种,也就是说,它在本质上就是按照一般的规范性原则,而在特定的语境中决定“什么该做什么不该做”的能力(在非军事语境中,这种能力的典型体现便是如何在特定语境中执行“紧急避险”“正当防卫”等抽象原则)。

(6)所以,自主性运作的军用技术平台是肯定具有特定的伦理推理能力的,否则,其运作就不是真正具有自主性的。

从纯战术角度看,让一个战术平台具有一定程度上的伦理推理能力,其意义是相当巨大的。这可使得相关平台能够在不与人类指挥员作出信息交换的前提下,根据稍纵即逝的战机迅速作出反应,以此提高作战效能,尽量避免因为人机互动而导致的战术失误,并最终为战术目的的达成作出正面贡献。但问题是:根据大多数人的道德直觉,我们必须使得军用机器人相关推理活动的输出,能够达到与人类战士相同(乃至更高)的正确率,否则我们就没有伦理上说得过去的理由将其投入实战。但是,我们又该如何使得看似死板的军用机器人具备这种“奇幻”的能力呢?

为了能够使得我们的讨论更为精细化,下面,就让我们从由前美国海军陆战队狙击手克里斯多夫·斯科特·凯尔(Christopher Scott Kyle,1974~2013)的自传体小说改编的电影《美国狙击手》(American Sniper)中抽取一个片段,以便更为形象地展现出在军事环境下所进行的伦理推理的一些基本特征。尔后,我们再回过头去讨论如何用计算机编程的办法去再现此类推理过程。

在这部电影的某个场景中,凯尔奉命用狙击步枪封锁巴格达的某街巷,时刻护卫在其视野内活动的战友。如果凯尔发现有恐暴分子对其战友做出能够威胁其安全的行动的话,那么,他是有权率先开枪将其击毙的。但这里的问题是:如何在芸芸众生之中,实时判断出哪些人是潜在的恐暴分子呢?如何避免误伤无辜群众呢?而在电影中出现的真实境况便是:一个当地小男孩,拾起了一支遗落在地上的RPG火箭筒——在这样的情况下,凯尔是否应当判断其为恐暴分子呢?这无疑让凯尔陷入了两难。如果说这孩子是恐暴分子的话,可是,按照常理,这么小的孩子成为恐暴分子的概率应当是很低的,而且,出于模仿成人行为的本性,他拿起火箭筒的行为或许只是出于嬉戏的心理;但如果听之任之的话,这孩子只要真的扣动扳机将火箭弹射出去,这一举动势必就会杀死正在附近闲聊的美军。那么,凯尔又该如何判断这个孩子摆弄武器的真实意图呢?

在上述场景中,凯尔所执行的任务显然有两个子目标:保护战友,以及避免误伤群众。而在孩子拾起火箭筒的那个瞬间,这两个任务之间的逻辑冲突便慢慢浮现出来了:尽管依据所谓的“排中律”,那个孩子要么是恐怖分子,要么就不是,但是在现实的语境中,凯尔是很难判断这样的一个手持危险武器的孩子到底是不是恐怖分子的,因为要彻底洞察目标意图的时间资源与社会资源恰恰是他所不具备的。在这样的情况下,他就必须在“保护战友”以及“避免误伤平民”之间作出快速的权重调整,并确定何者为其第一目标。虽然在电影中那个男孩由于扔掉了武器而使得两个目标都自动得到了实现,但倘若他没有这么做的话,他却很可能会被凯尔立即射杀(尽管他本人的主观意图或许一直是“开个玩笑”而已)。这样的话,对于凯尔来说,上级下达的“避免误伤平民”的作战意图或许就无法得到贯彻了。

现在我们转而思考这个问题:倘若凯尔不是一个真人,而是一个自主化运作的智能化狙击步枪射击系统(下面简称为“机器凯尔”),该系统又该如何面对这样的伦理学困境呢?

按照上面的分析,真人版凯尔所面对的最大的困扰就是如何知道那个小孩的真实意图,即如何知道他是不是“非战斗人员”。而机器凯尔显然也会面临同样的问题。很多熟悉人工智能的读者会说,这无非就是一个“模式识别”(pattern recognition)的问题。简言之:如果“模式识别”的结果裁定目标为非军事人员,那么就不该开火;反之则开火。

在笔者看来,该答案虽不能算错,但实在是过于简单了。不难想见,真人版凯尔的视觉系统与大脑也可以被视为一个“模式识别系统”,而在前述的场景中,为何同样的模式识别任务也会让真人版凯尔也感到为难呢?而在这样的情况下,我们又怎么能够指望人工设计的机器版凯尔,能够比通过自然演化而来的真人版凯尔的神经系统更好地判断出谁是“非军事人员”呢?由此看来,我们还需要对“模式识别”的技术细节作出更细致的探讨,以便确定使得机器凯尔的识别水平可以至少接近人类战士水准的具体技术路线。下面便是两条最可能被想到的技术路线:

第一,系统将所有同时满足下述三个条件的人员都视为潜在的恐暴分子:1、持有武器;2、未穿我军军服却身穿平民衣服;3、正在用武器指向身穿我军军服的人员,或者是别的平民。如果同时满足这三个条件,则系统有权对其开火。

第二,系统通过与贮存在“云”中的大数据信息进行信息交换,以便对每张看到的人脸进行人脸识别,最终确定谁是潜在的恐暴分子,并对其作出追踪。一旦发现其作出危险动作,可立即开火。

仔细思量一下,这两条技术路线都有漏洞。

第一条技术路线所牵扯出来的问题有:到底什么叫“武器”?日本武士刀肯定算武器吧,但是在电影《太阳帝国》(Empire of the Sun)中,一个已经投降的日本军人只是用武士刀帮助主人公吉姆切开苹果而已(因为当时两人手头恰好没有别的刀具),却被远处的盟军游击队误认为是在试图加害吉姆,而被开枪击毙。而用来砍香蕉的刀具肯定不算武器吧,但在1994年的卢旺达大屠杀中,此类砍刀却被广泛地用以进行残酷的种族清洗。这也就是说,什么算是“武器”什么不又不算,乃是根据特定的语境而被判定的,而这种“根据语境而进行灵活的语义指派”的能力,显然又是一种非常难以被算法化的识别能力(尽管也并非不可能被算法化)。此外,在复杂的城市治安战环境中,“是否穿平民衣服”也并不是判断恐暴分子的可靠指标。恐暴分子可能穿着偷来的或者仿制的我方军服浑水摸鱼,而己方的特工也可能身穿便衣潜伏在一般群众之中。而当系统自以为看到一个身穿平民衣服的人正在用武器指向一个穿我军军服的人的时候,真正发生的情况却或许是:一个伪装为平民的己方特工正试图消灭一个伪装为己方军人的恐暴分子。

再来看第二条技术路线。虽然目前的人脸识别技术与大数据处理技术都日趋成熟,但是基于以下理由,若仅仅凭借如上技术来判断谁是恐暴分子,恐怕依然是远远不够用的:1、将所有的恐暴分子的信息搜集齐备,基本上是不可能的(譬如,域外地区的人口信息的不完整性,以及恐暴集团成员的高流动性,都会为相关技术的运用制造困难);2、恐暴分子可能使用蒙脸等方式遮蔽脸部信息;3、而在特定光学条件下,系统对于人脸识别的难度也会陡增。

从心灵哲学与认知科学哲学的角度看,这两条技术路线(特别是前一条路线)自身的漏洞各自牵涉到了两个非常重要的哲学问题。第一个问题叫“心灵状态指派”(mental state attribution),第二个问题叫“各向同性”(isotropy)。前一个问题的实质是:如何从目标的外部行为判断出其内部心理状态(比如,某孩童摆弄武器的行为仅仅是出于嬉戏,还是出于真实的敌意)呢?这个问题之所以是具有哲学维度的,乃是因为:一方面,至少在哲学层面上,我们都已知道行为主义的理论(即那种将人类的精神意图系统还原为其外部行为的哲学理论)乃是成问题的(或说得更为学术化一点,我们很难给出对于从行为类型到意图类型的映射关系的完整函数刻画);而事情的另一方面却是:除了从外部行为判断一个目标的内部意图之外,自然的或者人工的识别系统似乎并没有什么别的渠道去了解相关的信息。这就构成了一个矛盾。而要解决这种“信息输入不足”的问题,唯一的办法就是诉诸于更多的背景信息——比如,在机器凯尔的例子中,关于“恐暴分子中青少年成员比例”的背景知识,恐怕就会对判断“眼前的目标是不是恐暴分子”起到莫大的作用。然而,对于更多信息量的牵涉,却会立即引发“各向同性问题”。

“各向同性”这个看似古怪的术语借自于物理学与化学,原指物体的物理、化学等方面的性质不会因方向的不同而有所变化的特性。而在信息科学与认知科学哲学中,该术语则转指这样的一个问题:既然某件事情与世界上所有的其他事情均有某种潜在相关性(这就类比于物理学家所说的“各向同性”),那么,在当下的问题求解语境中,信息处理系统到底又该如何对这些潜在的相关性进行遴选,以便能以最经济的方式来解决相关问题呢?譬如,中国茶叶的市场价格,究竟会不会对一个中东商人的心脏健康产生影响呢?尽管一般而言两者是不相关的,但在某种潜在的意义上,二者还是有可能发生间接的联系的(譬如,如果该商人在这个市场上已经投入了巨额资金,那么中国茶叶的跌价就会影响他的特定生理指标)。而由此引发的问题却是:对于特定的信息处理系统而言,它在判断某人心脏病发病的原因时,需要不需要考虑中国茶叶的市价呢?而如果中国茶叶的市价的确需要被考虑的话,那么它是否还要考察宋代的官窑与明代的宣德炉在香港拍卖市场上的价格呢?而如果系统如此不断地在巨大的信息检索空间中考察下去的话,它又如何可能在规定的时间内完成诊断呢?不难想见,此类“各向同性”问题亦会在战争环境下得到展现:“机器凯尔”究竟该怎么判断一把日本武士刀到底是与“文物展示”相关,还是与“暴力袭击”相关呢?它该怎么判断一把砍刀是用来砍香蕉的呢,还是用来砍人的呢?而更为麻烦的是,在复杂的城市治安战的环境下,某个物体(玻璃瓶、水管、砖头、门板,等等)都可以与暴力袭击发生潜在的关联,而要在这些潜在的关联之间找到最有可能实现的关联,则会牵涉到海量的计算,并由此使得实时的自动化作战系统的信息处理中心难以负担。?

不过,上面的技术困难并非“原则上无法解决的”,因此,它们的存在并不足以促使我们去永远禁止自主化军用平台拥有“开火权”。具体而言,关于如何驯服“各向同性问题”,温莎大学的哲学家兼认知科学家瓜里尼(Marcello Guarini)与美国海军下属的一个认知科学研究项目的主管贝洛(Paul Bello)在其合写的论文《机器人战争:从无平民的战场转移到充满平民的战场后吾辈所面临的挑战》?中便提出了相关的技术建议。其要点如下:

第一,为系统设置一个背景知识库K,在其中,系统会预先贮存大量常识知识,如“火箭筒会摧毁软皮军用车辆,却无法摧毁主战坦克”,等等。

第二,通过知觉模块与语义描述模块,获取对于当下场景的描述集S。如在机器凯尔的例子中,这指的便是对于其在视野中所看到的一切的描述。

第三,为系统设置一套逻辑推理规则,以便系统能够从S的一个子集与K的一个子集的逻辑合取中推出新的结论(譬如,从“有人拿起了火箭筒且瞄向了附近的悍马吉普车”与“火箭筒可以摧毁软皮军用车辆”之中,推出“有人有能力摧毁附近的悍马吉普车”)。

第四,以“K+S”为整个系统在处理当下问题时所凭倚的信息检索空间的最大限制,并由此将“各向同性问题”界定为:如何在“K+S”所规定的边界范围之内,尽量将系统的实际信息检索范围缩小到系统的运算负担与战术需求所允许的范围之内。

第五,关于如何缩小上述检索范围,有两个选项。选项甲(即大多数人工智能专家所采用的选项)即诉诸于所谓的“激发传播模型”,亦即假定“K+S”之中的各个记忆要素之间的传播网络是带有丰富的权重规定的(如:“甲要素”与“乙要素”之间的关联权重值较高,而与“丙要素”之间的关联权重值则较低)。这样一来,检索活动将仅仅沿着那些高权重的联系管道进行,而不再理睬那些低权重的管道。在这样的情况下,检索的范围就自然缩小。

第六,选项乙(也便是瓜里尼与贝洛所更为推荐的选项)则是这样的:设置一个“注意力磁”(attentional magnet)P(这是由系统的情绪模块所产生的一个命题),让其调动系统的注意力到P自身或与其有直接语义相关性的对象上去。同时,将在每一个认知回路中输入项(即P与S)与记忆库K之间互动的产物界定为“E”,也就是一个表征“紧急性程度”的新参数(该参数将只取“0”与“1”两个值)。具体而言,该参数取“1”时将激活系统的“杀戮动机激发器”,由此激活开火程序,反之则不会激活之。这也就是说,特定的信息检索机制将进一步启动系统的不同的命题态度(如动机、欲望)的自我指派机制,以便更有效地帮助系统自身作出“开火”与“不开火”之类的重要决定。

不难想见,如果瓜里尼与贝洛的上述算法描述思路被施用于前述“机器凯尔”的话,那么,对于其敌我识别的过程的最终输出而言,产生至关重要影响的便是两个参数:第一,系统的情绪模块产生了怎样的“注意力磁”以便将系统的注意力转向战场的哪些要素上去;第二,系统的内置背景知识是如何描述对象的一般威胁的,以便为系统的“伦理推理方向”提供必要的先验偏置。现在我们就来分别讨论这两个参数的确定机制。按照瓜里尼与贝洛的意见,就对于第一个参数的确定而言,系统的内置情绪模块的工作方式起到了非常明显的作用,因为“同情”之类的情绪会使得系统立即产生诸如“使得平民或者战友免受伤害”之类的内部指令(这也就是前面所说的“P”),并由此使得其计算资源被立即集中到相关的问题求解搜索方向上去。虽然就如何在人工智能系统实现此类“人工情绪”,瓜里尼与贝洛的讨论没有给出一个最终的答案,但从功能主义的抽象视角来看,任何一个能够将特定认知资源集中到特定方向上去的快速切换开关,都能够被视为一个“情绪提供阀”,并由此得到相关算法的模拟。而就对于第二个参数的确定而言,除了人类用户需要为机器提供尽量丰富而准确的关于治安战环境的常识性描述之外,系统设计者也期望系统能够通过机器学习等方式自主更新相关的知识,以便能够为时下的任务提供最为可靠的后台情报支持。

读者可能会问:倘若我们能够将上述技术环节全部实现的话,那么,我们是否能够期望“机器凯尔”不会误杀任何平民呢?很不幸,答案恐怕是否定的。请回顾一下我们在前面为“机器凯尔”所设置的工作目标:尽管我们希望其失误率能够等同于或者低于受过严格训练的人类精英狙击手的水准,但是我们并不期望它能够避免任何误判——因为世界上根本就不可能存在着任何完全不出错的信息处理系统(无论是人造的系统还是通过自然演化而来的系统)。具体而言,就上文所给出的关于“机器凯尔”的可能操作程序而言,其情绪模块或许就会因为彼此竞争的情绪供应(如对于战友的爱与对于平民的同情)而产生彼此冲突的自我指令,并由此使得系统的问题求解方向陷入混乱;而系统自身的背景知识的缺陷,也会使得其在进行伦理推理时陷入误区。但这里的问题却是:我们是否就要因为此类缺憾所导致的错误——无论是误杀平民的错误,还是坐视战友被杀而不管的错误——而否定“机器凯尔”的应用价值呢?依笔者浅见,恐怕这样的结论本身就犯下了某种“人类中心主义”的错误,因为人类战士所犯下的同类错误从来没有构成我们禁止使用人类战士的充分理由。为何我们要对机器战士提出更为苛刻的要求呢?

有的读者或许会说:即使“机器凯尔”的失误率要低于人类狙击手,只要其失误率没有被降到零,我们依然要禁止其投入实用:因为人类战士是法律上的责任主体,其一旦犯错了我们可以用军法对其进行惩罚——而用以惩罚机器人的法律规章现在还付诸阙如(而且去制定这样的新法律也会显得十分荒谬)。在这样的情况下,为了避免“出了错之后无法找到责任人”的尴尬,最好我们就不要自找麻烦地去部署“机器凯尔”之类的能够自主开火的智能兵器了。

笔者认为,上述批评意见的结论虽然是错的,但其推理内容却并非完全没有合理的成分。诚如洛克霍斯特(Gert-Jan Lokhorst)与霍芬(Jeroen van den Hoven)在论文《军用机器人的责任》?中所指出的,用军法去惩罚一个犯错的士兵的确是有意义的,因为这能够让这个士兵感到羞耻,并在部队中产生“以儆效尤”的效果。但用军法惩罚一台机器却是于事无补的,这既不能让其感到羞耻,也不会让别的机器感到害怕。而在后一种情形中,我们真正需要做的事情乃是:检讨此类事故发生的原因,并尽量杜绝此类错误再次发生的几率。

不过,这也并不是说一旦机器人战士发生误杀事件后,就不会有相关的法律诉讼发生了——因为即使是自主性机器人的运作,毕竟是以人类建造者与人类指挥官的活动为前提的。依据笔者的浅见,一旦此类错误发生后,相关的调查委员会就必须按照如下的排除程序展开“责任指派工作”:

1、排除电气故障意义上的机器硬件故障(若无法排除,寻找硬件的生产与维护部门);

2、检查发生事故前的机器代码运行情况,排除系统被黑客恶意入侵的情况(若无法排除,寻找攻击源,并调查为何反黑客入侵软件为何没有发挥作用);

3、检查系统得到的作战指令本身是否包含违背作战条例与反伦理的内容(若确定指令本身有问题,寻找发出此类指令的人类指挥员);

4、调查当时战争信息的实际复杂程度,是否越过了此类机器能够处理的战场信息的复杂程度的上限。如果的确超过了后者的上限,则调查人类指挥员是否可能预估到战争信息的复杂性已经超越了机器的信息处理能力。若指挥员有可能预估到此类情况,则调查为何指挥员不去指派人类战士来处理此类问题。

从上面列出的这个挂一漏万的责任确认流程上来看,确认一台犯错的军用机器人的背后的责任人的排查过程,在实质上与确认一把走火杀人的自动步枪背后的责任人的流程并无二致(尽管从技术上看,前者肯定要繁琐得多)。因此,即使会犯错的机器人投入了战场,我们也不会遇到“找不到负责者”这样的尴尬问题。换言之,“机器人不是责任主体”这句话即使是对的,也不构成我们禁止此类设备拥有开火权的充分理由。

有的读者或许还会反驳说:倘若经过缜密的调查,我们还是找不到误伤事件的责任人,又该如何呢?

面对这样的情况,笔者认为恰当的处理程序是:通过逼真的三维模拟重现技术,让优秀的人类战士在与被调查事故极为类似的环境下进行虚拟的问题处置,然后比对人类的表现与机器的表现。如果发现机器所犯下的错误是绝大多数人类战士都是可以避免的,那么这就说明相关系统的设计有重大缺憾,军方可以停止相关装备的使用,并责令生产厂家收回产品;如果我们发现即使是大多数人类战士也无法避免机器战士所犯下的错误,那么我们便有理由相信此类错误的发生乃是出于纯粹的“坏运气”。若是如此的话,那么就不该有任何人为此事负责。

虽然“坏运气”这一措辞或许未能满足一部分人的理智好奇心,但是需要指出的是,“武运”本身就是一切战争活动的有机组成部分之一。军用机器人的介入其实是无法消除战争中的“运气”成分的,就像历史上的航母、导弹的出现也未曾消灭“运气”一样。从经验角度看,在人类既有的战争实践中,被不知从哪里(很可能是从友军那里!)飞来的流弹射死的倒霉士兵不知道有几千、几万,但此类“坏运气”案例最终被纳入司法调查程序的又有几何呢?而谁又能够保证机器战士的介入,一定就会增加——而不是减少——这些不幸的发生呢?此外,从根本上说,消除所有这些误伤事件的最终解决方法,难道不正是“不去发动或者参与战争”吗?——但是,这个根本解决方案的执行者,难道不正是人类(而不是机器)吗?因此,面对那些的确很难被恰当归因的战场不幸,我们又有何充分的理由去迁怒于那些具有自主开火权的机器战士的出现呢?

非官方的“机器人战士”所带来的伦理风险

行文至此,笔者一直预设军用机器人的研发与使用主体都是“正常国家”。所谓“正常国家”,泛指各种国际公约的缔约国,而一般而言,这些国家对于人类的基本价值规范(如在战争中要尽量避免误伤平民)均有基本的尊重。也正因为上述预设,所以笔者还预设了:研发方在研发过程中会注重对于机器人的“伦理推理能力”的算法化,由此使得其行为输出能够尽量符合正常人的价值观。

但是,没有任何理由使得我们排除正常国家之外的行为主体去研发此类机器人的可能性。具体而言,具有相当程度的智力资源支持的恐暴组织,也可能去着力研发此类兵器,以便为针对平民的恐怖细节制造便利。需要注意的是,由于恐暴组织具有的价值观与正常人往往相反,所以,他们为机器人设置的“伦理算法”或许也是相反的。譬如,当我们希望机器人拥有的算法能够降低平民的伤亡的时候,而他们或许会希望机器人拥有的算法能够协助其杀死尽量多的平民。此外,由于“滥杀无辜”本身的技术难度要远远小于“精准打击”(因为前者的模式识别系统远要比后者来得简单与便宜),因此,恐暴分子的这种毫无道德底线的设计思路,反而可能使得其“产品”能够被更容易地制造出来,并由此为世界的和平带来一定的威胁。

但是,在笔者看来,即使上述威胁的存在是不容否认的,这一威胁也不构成我们去阻止“正常国家”研发智能军用机器人的理由。这又是因为:

其一,即使我们通过国际公约的方式,禁止了智能军用机器人的研发,这样的禁令也是对恐暴组织无效的,因为恐暴组织一向是无视任何国际公约的效力的。

其二,如果具备了正常的伦理推理能力的官方军用机器人不能够得到充分的发展与充分部署的话,那么这就等于让我们自行废弃了与恐怖分子作斗争的一种有力工具,这反而会降低动荡地区的安全指数。

第三,即使就恐怖分子所掌握的土造智能武器而言,若它们不与诸如炸药、有毒气体、枪支等传统武器联接,恐怕也不会对群众造成实质性的伤害。因此,对于此类武器的严格监控依然是阻止恐怖袭击发生的重要环节。与之相比较,对于智能编程技术的控制则显得较为困难,因为此类技术同时也被广泛运用于国民经济的各个领域。

细心的读者或许还会说,在官方许可的范围外自行改装军用机器人的,未必一定就是恐暴组织成员。譬如,如果人工智能技术的发展能够使得家用机器人走进千家万户的话,那么,至少在一些允许民众合法持枪的国家里(如美国),动手能力强的人类用户就可以自行将其改装为“武装版”,以便为自己提供一定的安全护卫。而由此所导致的治安局势的全面复杂化,则或许会使得传统的司法体系感到难以应对——譬如,如果此类民用版武装机器人泛滥的话,那么,很多谋杀案就可以通过伪装为“工业事故”的形式来进行,而警方在追索此类案件的线索时也会苦于取证之难(因为诸如“提取指纹或DNA”之类的传统取证手段,对于机器人来说是很难奏效)。这或许也会为大量“无头案”的产生打开方便之门,并由此使得整个社会的安全指数下降。

对于上述质疑,笔者也有如下几点回应:

第一,即使在允许公民合法持有枪支的美国(遑论不允许大多数平民持枪的其它国家),相关的立法部门也可以考虑通过立法禁止私人在没有国家特许的情况下将非武装机器人改装为武器机器人,以保证官方对于军用机器人技术的管控。

第二,建立民用机器人与特定用户的生物学信息之间的绑定制度,甚至可以考虑建立所有民用武器与特定用户的生物学信息之间的绑定制度(按照该制度,只有用户本人的生物学信息才可以开启此类设备的运作)。这就为犯罪分子利用他人的机器人作案制造了技术障碍。

第三,进一步研发民用机器人的伦理推理模块,使得其能够具备一定意义上的“是非明辨能力”,譬如,使得其能够自主判明一些典型的犯罪行为的性质。这样一来,这类机器人不仅能够抵制用户以外的罪犯的犯罪行为,甚至还可能对用户本人的犯罪行为进行抵制,并进而提高相关犯罪行为的技术门槛。

第四,虽然家用机器人的记忆库不可能不随着新信息的涌现而进行实施实时更新,立法部门依然需要责成生产厂家设置技术门槛,以防止用户对产品的伦理推理模块的基本算法进行修正(譬如,一旦发现用户做出了此类修正,机器人会立即向公共安全部门发出警报)。

而在上述种种举措之中,最具哲学、科学与技术方面的挑战性的,莫过于对于机器人自身的伦理推理能力的算法化(这也正是笔者在前节中花费大量篇幅予以讨论的问题)。而也恰恰经由这种算法化,吾辈才可能使得机器人成为“纯粹的工具”与“伦理主体”之间的某种过渡性质的人工制品,并由此使得其具备某种人类“德性”的雏型。

(本文系国家社科基金重大项目“基于信息技术哲学的当代认识论研究”成果,项目编号:15ZDB020)

注释

Wallach, W. and Allen, C., Moral Machines: Teaching Robots Right from Wrong, Oxford: Oxford University Press, 2010.

Hallgarth, M.W., "Just War Theory and Remote Military Technology: A Primer", in Strawser, B. J. (ed). Killing by Remote Control: The Ethics of an Unmanned Military, Oxford: Oxford University Press, p. 26.

此表根据上书(pp. 30-31)编制。

Altman, J., "Preventive Arms Control for Uninhabited Military Vehicles", in Capurro, R. and Nagenborg, M. (eds.), Ethics and Robotics, Heidelberg: Akademische Verlagesgesellschaft AKA GmbH, 2009, pp. 69-82.

Lin P. et al., "Robots in War: Issues of Risks and Ethics" , in Capurro, R. and Nagenborg, M. (eds.): Ethics and Robotics, Heidelberg: Akademische Verlagesgesellschaft AKA GmbH, 2009, pp. 49-67.特别是该书p. 62处的讨论,与正文讨论最为相关。

Sharkey, N., "Killing Made Easy: From Joysticks to Politics", in Lin, P. et al. (eds.), Robot Ethics: The Ethical and Social Implications of Robotics, Cambridge, Massachusetts: The MIT Press, 2012, pp. 111-118.与正文特别相关的讨论见pp. 111-112.

Lin P. et al., "Robots in War: Issues of Risks and Ethics" , in Capurro, R. and Nagenborg, M. (eds.), Ethics and Robotics, Heidelberg: Akademische Verlagesgesellschaft AKA GmbH, 2009, pp. 49-67.特别是该书p. 57处的讨论,与正文讨论最为相关。

Weber, J., "Robotic Warfare, Human Rights & the Rhetorics of Ethical Machines", in Capurro, R. and Nagenborg, M. (eds.), Ethics and Robotics, Heidelberg: Akademische Verlagesgesellschaft AKA GmbH, 2009, pp. 83-104.特别注意p. 88处的讨论。

Plaw, A., "Counting the Dead: The Proportionality of Predation in Pakistan", in Strawser, B. J. (ed), Killing by Remote Control: The Ethics of an Unmanned Military, Oxford: Oxford University Press, pp. 126-153.

此表的数字来源,参加上书pp. 138-139; p. 145; p. 148。

Sparrow, R., "War without Virtue?", in Strawser, B. J. (ed), Killing by Remote Control: The Ethics of an Unmanned Military, Oxford: Oxford University Press, pp. 84-105.

转引自[美]斯科特·安德森:《阿拉伯的劳伦斯:战争、谎言、帝国愚行与现代中东的形成》,陆大鹏译,北京:社会科学文献出版社,2014年,第78页。

“各向同性问题”的另外一个叫法是“框架问题”(The Frame Problem),对此,笔者曾在别的地方有过专门的技术化讨论。请参看:徐英瑾:《一个维特根斯坦主义者眼中的框架问题》,《逻辑学研究》2011年第二期,第93~137页;Xu, Yingjin and Wang,Pei, "The Frame Problem, the Relevance Problem, and a Package Solution to Both", Synthese, Volume 187, Issue 1 Supplement, pp. 43-72;徐英瑾:《心智、语言和机器——维特根斯坦哲学和人工智能科学的对话》,北京:人民出版社,2013年(特别是该书的第七章与第八章)。

Guarini, M. and Bello, P., "Robotic Warfare: Some Challenges in Moving from Noncivilian to Civilian Theaters", in Lin, P. et al. (eds.), Robot Ethics: The Ethical and Social Implications of Robotics, Cambridge, Massachusetts: The MIT Press, 2012, pp. 129-144.

Lokhorst, G-J. and Hoven, J., "Responsibility for Military Robots", in Lin, P. et al. (eds.), Robot Ethics: The Ethical and Social Implications of Robotics, Cambridge, Massachusetts: The MIT Press, 2012, pp. 145-156.

责 编/马冰莹

Abstract: Currently, the ethical after-effect due to the military use of artificial intelligence technology has evoked various criticisms from the ethical point of view, for example, "the deployment of these weapons would like to undermine the international arms control system and thereby facilitate the undesired proliferation of the relevant technologies", and "the deployment of them would like to make killing much easier and thereby threaten the lives of more noncombatants". However, these criticisms have often set double standards for evaluating the traditional military tactical platforms and the tactical platforms using artificial intelligence, and deliberately exaggerated the overall significance of the latter in changing the global security pattern. To truly make the ethical after-effect of the military use of artificial intelligence technology accord with the existing value system of the human world, the main measure is not to simply ban the R&D of such kind of equipment but to make such equipment have "ethical reasoning" in the sense of the humans. In the R&D process, how to solve the "isotropic" problem will also become the focus.

Keywords: military robotics (technology), artificial intelligence, ethics, isotropy, mental states attribution