核辐射环境增强现实应用发展初探

2016-04-06罗斌

罗 斌

(中国工程物理研究院计算机应用研究所,四川绵阳621999)

核辐射环境增强现实应用发展初探

罗 斌

(中国工程物理研究院计算机应用研究所,四川绵阳621999)

初步论述了增强现实技术在核辐射环境中的应用发展,首先阐述了增强现实的基本特性,分析了适用于核辐射环境应用的头部姿态跟踪、显示和人机交互等关键技术,描述了增强现实技术在核电站、辐射手套箱、反应堆等领域的应用发展现状,最后讨论了发展趋势和难点,并进行了总结。

增强现实;人机交互;核辐射环境

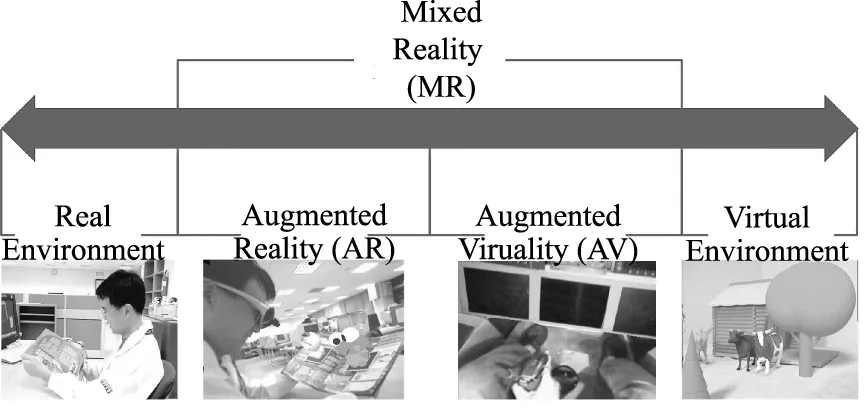

增强现实(Augmented Reality,AR)[1-4]是在用户观察的真实场景或者摄像机视频图像中添加计算机生成的文字、3D模型等信息,实现虚实融合视图的高级人机交互技术。其基本原理是使用头部姿态跟踪器提供的姿态信息精确地对准虚拟的物体和摄像机摄取的视频图像或者通过透射方式观看到的自然景象,当用户在转动或平移头部时,用户还能够在视频透射式或光学透射式头盔显示器(Head-mounted display,HMD)屏幕上观看到精确对准的虚实融合图像。Milgram等[5]使用一个横跨纯真实与纯虚拟之间的连续闭集对虚拟现实(Virtual Reality)、增强现实、增强虚拟(Augmented Virtuality)以及混合现实(Mixed Reality)进行清晰甄别,将增强现实描述为更接近于纯真实空间之间的一段连续空间,如图1所示。由于用户不仅可以与增强现实系统的虚拟物体进行交互,而且还可以与真实环境进行交互,这种高级人机交互能力促使增强现实不仅广泛应用于工业[6,7]、军事[8]、医学[9]、文化遗迹[10]、游戏娱乐[11]、导航[12]和教育[13]等领域,而且在核辐射环境中也具有巨大应用潜力。

在核科学领域,核辐射主要指由放射性物质以波或微粒形式发射出的一种能量,分为天然辐射和人工辐射,前者源自于宇宙射线、陆地辐射源和体内放射性物质,后者来自于放射性诊断和放射性治疗辐射源如X光,放射性药物、放射性废物、核武器爆炸以及核反应堆和加速器产生的照射等。核辐射环境是可产生核辐射的工作环境,本文特指为工业领域放射性物质的加工制造、存储、实验以及应用环境。放射性物质一般在封闭手套箱内进行加工,可利用核反应原理产生强辐射,或构建各种裂变反应堆产生核能,被应用于核电站、核动力潜艇和火箭、核装备等。核辐射环境的共同特点是安全第一,必须采取核辐射防护措施防止核辐射泄漏造成环境污染,防止强辐射射线进入人体内将对身体健康造成伤害,使人致病、致癌和致死。防辐射措施包括控制工作用户的受照射时间,增大与辐射源距离以及采用屏蔽物进行隔离等。此外,操作人员与核辐射环境构成一个闭环工作环境,操作人员也是影响核辐射环境安全的要因素。操作人员必须借助于工作手册熟悉和掌握工作流程,熟练操作设备,经过数年培训,才能上岗执行工作任务,也必须具备较强的技术能力和心理素质,不能出现任何操作失误,否则会造成重大经济损失甚至生命危险。因此,改善工作人员的工作环境,使得操作人员远离辐射环境,并结合使用增强现实技术对工作过程进行培训和引导,提高工作效率和缩短培训周期,增强核辐射环境的安全性具有现实意义。

图1 Milgram等的真实-虚拟连续闭集示意图Fig.1 Melgram’reality-virtuality continuum

目前,在国内很多大学和研究机构对增强现实进行了深入研究,但目前关于增强现实在核辐射环境中的应用还未见文献报道。本文对增强现实技术及其在核辐射环境中的应用发展进行初步讨论,首先介绍增强现实基本属性,然后分析适用于核辐射环境应用的增强现实关键技术,最后阐述增强现实在核辐射工业环境中的应用现状,讨论了发展趋势和技术难点。

1 增强现实基本属性

增强现实技术有其区别于虚拟现实的三大独特特性:(1)虚实融合; (2)实时交互;(3)三维注册。这三大属性支持增强现实在核辐射环境中的不同应用。

1.1 虚实融合

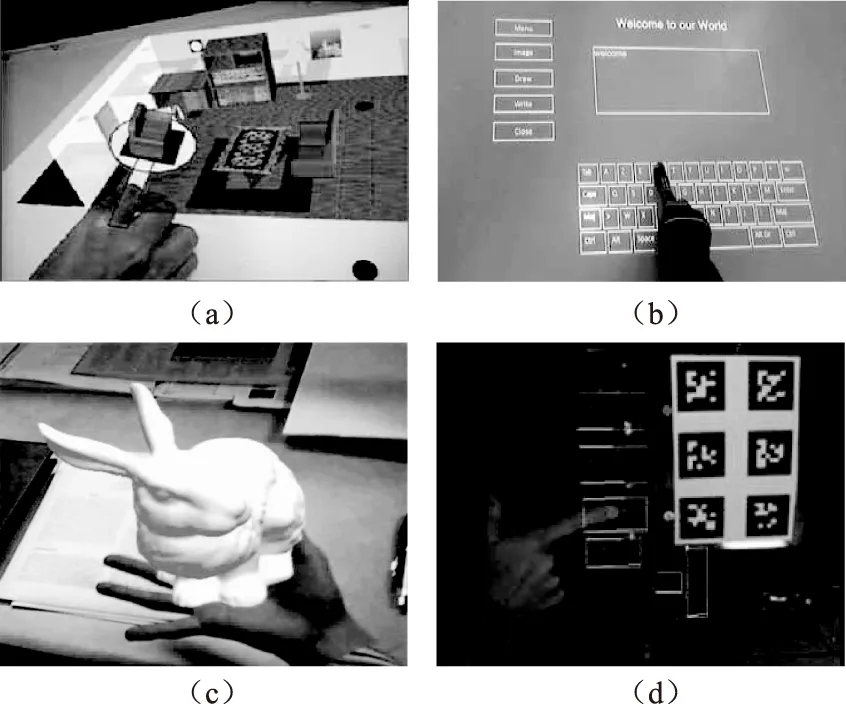

增强现实的虚实融合方式可分为三类。第一类是二维融合,即直接在视频图像上或者在虚拟的二维平面上添加文字、图片和动画等2D虚拟对象。这类虚实融合方式主要用于界面虚拟菜单[14],用于显示工艺流程手册,工具图片,以及工艺操作动画等,帮助用户在感知真实视频图像环境的同时,也能即时获得当前真实环境所需的信息,比如下一步的工艺操作,图像中操作设备的使用方法等,如图2(a)所示。第二类是三维融合,是在观察的真实物体上添加3D虚拟对象,并在真实物体移动旋转等的同时,虚拟对象实时地与真实物体对准在一起。这类融合方式主要用于显示三维模型,以及三维操作动作,比如旋转控制板上的按钮的等,如图1(b)所示。第三类融合方式是第一类与第二类的组合,即在用户观察的设备上显示虚拟信息,当用户观察视角变化时,显示的2D信息可以伴随真实物体产生移动,但是该虚拟的2D信息会始终面向用户,信息清晰度随观察视距变化而变化,视距越小越清晰,视距越大越模糊。

图2 增强现实虚实融合方式示意图Fig.2 virtual-real fusion of AR(a) 二维融合; (b) 三维融合

1.2 实时交互

增强现实的实时交互方式可分为两类。第一类是用户通过摄像机提供的图像与真实环境进行人机交互,其特点是不需要任何交互媒介,直接利用摄像机提供的视频作为交互接口,如图2所示。用户可以直接通过视频图像观察自己的交互动作,也可以在虚拟的二维或三维信息引导下进行操作动作,比如根据部件装配动画进行装配等。第二类是用户与虚实融合视图中的虚拟信息进行交互,可以单独使用标志板、人手势等交互媒介,也可以将人手势、语音等进行综合进行多模人机交互,详见2.3节具体讨论。

1.3 三维注册

三维注册是增强现实技术的核心特征,是指在不同观察视角条件下,通过实时跟踪用户的头部姿态,将头部姿态的投影矩阵与AR环境中虚拟摄像机的投影矩阵保持一致,实时对准虚拟的三维信息与真实的环境。实际应用中,由于头部快速运动或者头部姿态估计不精确等原因,虚拟物体并不会完全与真实环境精确对准。评价虚拟物体与真实环境对准的标准是注册误差[15],包括静态误差和动态误差,前者为描述空间域虚实物体之间的姿态之差,后者为描述时间域虚实物体之间的时间差。静态误差的来源包括光学元件畸变、姿态优化估计算法、视参数、标志物布局结构、图像噪声等,一般可采用标定摄像机内参数[16]获得光学元件畸变参数,采用有最小二乘法和随机抽样一致性等方法[17]优化姿态估计值等。动态误差的来源来自图像输入端和图像显示端的系统延迟,一般采用滤波方法[18]进行预测,减小动态延迟误差。

2 增强现实关键技术

构建一个面向核辐射环境应用的增强现实系统,重点需要考虑到系统用户的头部姿态跟踪、融合图像的显示、用户与系统的人机交互等关键技术问题,本小节重点介绍和分析核辐射环境AR应用的这几项关键技术。

2.1 头部姿态跟踪技术

头部姿态跟踪技术[19]包括机械、电磁、GPS、超声波视觉摄像机以及惯性传感器等硬件跟踪技术和混合跟踪技术,其中机械和电磁跟踪器在对跟踪较高的AR领域已较少使用。GPS是使用多个卫星估计用户绝对位置的全球导航系统,跟踪范围大,稳定性好,但无法在室内使用;超声波是根据超声波发射源信号到达接收器之间的时间差、相位差或声压差估计位置和方向,精度高,稳定性好,但需要超声波源,成本高,刷新率低,有遮挡;惯性传感器是使用惯性陀螺仪和微加速计来估计相对位置和方向,体积小、免遮挡,刷新率高,计算负载低,但内部漂浮导致精度下降;视觉跟踪器使用摄像机跟踪目标,利用计算机视觉技术计算摄像机姿态,分为标识(Marker)跟踪和免标识(Markerless)跟踪,前者使用LED[20],二维码[21],ARToolKit[21],AR-Tag[23]等作为摄像机跟踪目标,成本低廉,可测性好,高精度,稳定性好,遮挡,大范围内需布置大量标志板,提前测量标志板;后者使用边缘[24]、角点[25]和平面[26],特征不变量[27]等复杂自然特征作为摄像机跟踪目标,计算负载高,在动态环境下跟踪不稳定;混合跟踪器是是不同跟踪器的组合,可实现不同跟踪器之间的优势互补,实现大范围室内外跟踪,但需要复杂的标定和同步方法[28]。

核辐射增强现实环境下的跟踪方法选择取决于具体应用和跟踪范围。首先,辐射工业环境一般都处于室内,不能使用GPS,不能在环境中布置超声波源和摄像机等,只有惯性传感器,视觉摄像机和惯性-视觉混合跟踪器是比较合适的选择。其次,由于辐射环境中的场景特征比较复杂,使用自然特征跟踪方法,计算负载大,跟踪不稳定,因此使用标识物特征跟踪,能够同时确保低负载、高精度和稳定性。目前使用的ARToolKit等标志物适用于约3m以内的短距离跟踪;当跟踪距离扩大时,不可能在环境中放置大型方块标志板,但可以使用线型标志物[29],将线型标识安置在管线等长条型物体上,可有效扩大跟踪距离。能够同时进行短距离和长距离跟踪的方法是使用多尺度标志板[30],在长距离时跟踪该标志板的外圆特征,在短距离时跟踪该标志板的内圆特征。最后,在有遮挡的AR环境,可以选择使用摄像机-惯性混合传感器进行跟踪,既能够补偿惯性漂浮,又能够解决摄像机遮挡导致的跟踪失败问题。可见,在核辐射环境下,标志物跟踪是最适用的头部姿态跟踪方法。

2.2 显示技术

目前AR领域使用的显示设备包括计算机显示器、视网膜显示器、头盔显示器和手持设备等,其中头盔显示器又包括视频透射HMD、光学透射HMD[31]、投影式HMD(Head-Mounted Projective Displays,HMPD)[32]等。计算机显示器是最普通的AR显示器,视网膜显示器使用激光将虚实融合的图像合成在视网膜上,亮度好,电源能耗低、高分辨率,重量轻,目前实际应用还少;视频透射HMD则是将视频摄像机的真实视频图像与计算机生成的虚拟图形合并显示在HMD的屏幕上,虚实物体精确对准,高亮度,有时间延迟,图像分辨率受限制;光学透射HMD是将用户人眼观察到真实的自然场景与HMD上的虚拟图形合成为虚实融合场景,无时间延迟、无漂浮,无图像退化,但标定步骤复杂,同时观察虚实物体有难度;HMPD综合使用投影仪和折反射材料将虚拟图像投影到现实的真实环境实现融合,免遮挡,可多人观察融合图像,但需要在环境中安装设备;投影显示系统由投影机和显示屏幕构成,供多人观察融合图像;手持式设备包括指平板电脑、移动智能设备等,体积小、显示屏幕小、重量轻,工作模式可切换,但显示器屏幕小,手不能进行操作。AR显示技术的发展趋势是逐步向高分辨率、大视场、轻量级、完全真实感和交互感、便携式等方面发展[33]。

在核辐射特殊工作环境中使用视网膜显示器、光学投射HMD和HMPD是不现实的。在辐射材料封闭储存环境中,操作人员只能远程观察内部场景和进行远程操作,因此适合选择大型投影屏幕和计算机显示器作为远程显示终端。在核电站环境下,操作人员需要大范围工作,更适用于开发便携式AR系统,使用视频透射HMD和手持式显示器是合理选择;在核辐射手套箱环境下,操作人员工作区域小,且需要长时间工作,使用轻量级视频透射HMD是优化选择。

2.3 人机交互技术

用户与增强现实系统的人机交互主要表现在与虚拟物体之间的交互,它利用出现在真实环境中的标志物、手势、语音等作为交互媒介,通过建立真实物体运动与虚拟物体任务命令之间的映射关系,操作真实环境中的物体,自然直觉地与虚拟物体进行交互,执行用户定义的操作,如图3所示。标志物AR交互是用户手持标志物,或者在手上绑定标志物,使用摄像机识别标志物,比如启动菜单执行AR建模任务[34]。语音交互是将语音语义转换为任务命令,比如转换为文字显示以帮助聋哑人进行交流[35]。手势AR交互是通过识别手势进行交互,大致可分为三类方式。第一类是将彩色标志物绑定在手指上,使用摄像机跟踪标志物获得手指语义,实现虚拟拨号[36]和虚拟键盘操作[37]。第二类是3D自然手势交互,指用摄像机直接跟踪手指,直接在手上注册虚拟物体,当手移动旋转时虚拟物体随之运动[38,39]。第三类是使用摄像机直接跟踪手指/指尖运动,用手指/指尖实现与虚拟信息/物体的特定交互操作,比如用人手指尖拾取、移动和旋转虚拟物体[40-43],模拟鼠标交互行为[44],选择虚拟菜单执行任务操作等[45-47]。此外,集成语音和手势的多模交互在实际应用中得到用户更多青睐[48]。

图3 用户与AR虚拟物体进行交互Fig.3 AR interaction between users and virtual objects(a) 手持标定板交互; (b) 手指绑定彩色物体交互;(c) 3D手指交互; (d) 2D手指交互

在核辐射环境下,操作人员一般不使用自然手势与注册的虚拟物体进行直接的3D交互,更普遍的用法是通过识别手势、语音和标志板,并翻译为自己定义的命令释义,启动、终止某一任务操作,比如用手指模拟点击虚拟菜单驱动虚拟的三维物体运动。在反应堆远程操作应用中,由于操作用户已经脱离现场环境,远程操作人员适合使用传统的鼠标进行交互。在辐射手套箱特殊环境中,由于操作人员手戴防辐射手套进行操作,使用语音是最实用的任务交互方法,可以将防辐射手套颜色制作为与人手相似的皮肤色,直接跟踪手套皮肤色,获得防辐射手套指尖像素位置,实现与应用系统二维虚拟对象的交互。在核电站便携式或移动式AR应用中,交互方法的选择较多,可以使用摄像机跟踪裸手、彩色标志物,或使用语音等。

3 应用现状

随着增强现实技术的不断发展进步,专家学者将增强现实基本属性与核辐射特殊环境紧密结合,促进了增强现实技术在核辐射环境中的应用研究,为操作人员带来现实的好处,包括让操作人员远离辐射环境,辅助工作人员进行材料加工、设备维护和远程操作,提高工作人员的工作效率和增强核辐射环境中工作人员的安全性。根据查阅的现有文献资料,本文从水下核动力堆检查、核电站维护、辐射材料加工制造等方面,介绍增强现实在核工业环境中的应用现状。

3.1 水下核动力堆检查

增强现实在核辐射工业环境中较早的应用是水下核动力堆。水下核动力堆主要利用核反应过程来推动潜艇等水下机械设备。通用研究开发中心的Corby和Nafis[49]开发了一套增强现实远程操作系统,用于执行水下核动力堆的预期检查、补给和修补储运损耗等任务。该系统利用CAD模型创建了一个实时合成的水下核反应堆虚实图像,显示了检查任务数据,包括当前的实时视频图像、过去的视频图像和检查报告,以及过去可靠的检查决策等数据,提高了操作人员检查任务的效率。

3.2 核电站维护

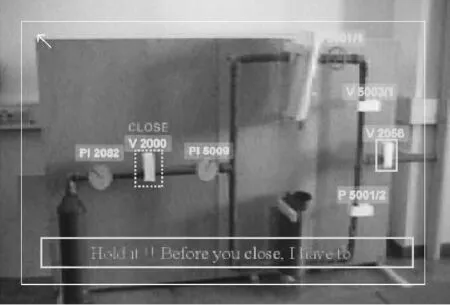

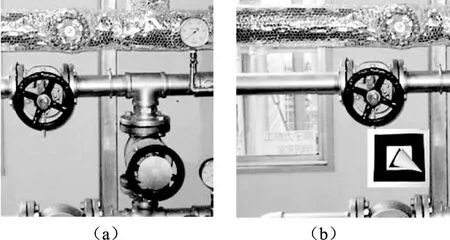

核电站利用核反应过程,构建发电堆产生电能,包括核材料、载热体以及相关的控制设施、防护设施和安全系统等。核电站的特点是设备繁多复杂、工作区域大,这给增强现实在核电站的应用带来很大困难。Fuchs等[50]使用基于模型的特征识别方法跟踪曲面和轮廓表面,开发了一个远程呈现操作系统,并与监督系统集成,让操作人员远程维护核电站的加压水反应堆。德国慕尼黑理工大学的Klinker等[51]开发了用于核电站氦激励装置维护的便携式增强现实系统,该系统验证了交互式电子手册(interactive electronic technical manuals,IETM)、IETM网络传输、语音识别分析和LCD平板等输入输出用户接口的实用性,实现了基于组件的系统集成,其界面如图4所示。日本京都大学能源科学研究院的Ishii和Shimoda等对增强现实技术在核电站的应用进行了长期研究,分析了适用于核电站的增强现实关键技术[52],提出了面向核电站应用的条形码标志物跟踪方法[29],将AR技术用于核电站的位置导航、危险区指示、不可见管线提示等维护任务[53],拆除核电站过期设备[54],并结合无线射频识别(Radio Frequency Identification,AFID)技术开发了核电站水隔离增强现实系统,实现了阀门指示、导航、确认和任务步骤管理等功能,使用虚拟信息引导操作人员执行阀门维护任务[55],如图5所示。最近,Leutert等[56]在核电站机器人远程操作中,使用增强现实技术在用户观察的场景中直接自觉地可视化复杂信息,以支持机器人的远程检查、环境交互等功能。

图4 核电站氦激励装置便携式AR系统Fig.4 Wearable NPP helium flushing AR system

图5 核电站水隔离AR系统Fig.5 NPP water isolation AR system(a) 指示阀门;(b) 指示阀门旋转方向

3.3 辐射材料加工制造

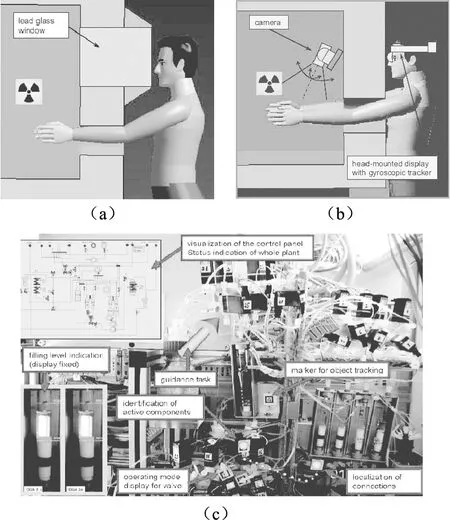

辐射手套箱是用于辐射材料加工的特殊封闭环境,它的特点是潜在的身体健康危险,加工工艺复杂,操作条件苛刻等。手套箱环境必须全封闭且箱体具有防辐射功能,操作人员必须手戴防辐射手套与辐射材料接触,在操作过程中会出现精神紧张和注意力不集中,导致操作失误的可能性也不可能彻底消除。当前操作人员必须借助于加工手册熟悉和掌握烦琐复杂的加工工艺流程,任何操作失误都可能损毁材料而导致重大经济损失。手套箱内部空间狭小,操作人员必须将戴防辐射手套的手通过操作孔伸入加工环境内进行操作,而且人手臂长度有限,在有限自由度运动空间内长时间操作,导致手臂酸痛疲劳和视觉疲劳。其次,操作人员在进行手工操作的同时,还必须透过观察孔观察内部区域。针对这些问题,德国慕尼黑理工大学[57]使用增强现实技术开发了医用辐射材料加工的手套箱增强现实系统,用于保护用户免受核放射材料的永久威胁,帮助操作人员完成严格而有压力的复杂任务。系统使用一个惯性头部跟踪器控制环境监视摄像机的姿态,确保手套箱外的操作人员能够通过HMD观察到手套箱内的大部分工作区域,并使用增强现实技术在工作区域添加核辐射、警告、危险区域等辅助信息,帮助操作人员处理工作任务、放松决策、减轻压力和增强操作舒适度。图6显示了该系统的工作环境、解决方案以及手套箱加工过程中的操作任务和控制面板的增强效果。

图6 AR在辐射手套箱中的应用Fig.6 AR applications for nuclear radioactive glove box(a) 手套箱操作环境; (b) 手套箱AR解决方案;(c) 手套箱内部场景的HMD增强视图

4 发展趋势

目前增强现实技术在核辐射环境中的应用还处于起步阶段,但鉴于增强现实技术在增强安全性和提高效率等方面的价值体现,增强现实技术在核辐射环境中的应用将会不断深入和发展,主要的发展趋势包括以下几点。

(1) 应用范围向各种反应堆等领域扩展。文献显示,目前增强现实核辐射环境的应用主要集中在核电站维护和辐射材料加工等方面,而进一步的方向包括各种反应堆应用,比如研究堆、动力堆、热室和辐照室等。使用增强现实技术,可以进行反应堆的布局设计、设备安装维护、实验原理演示和实验操作训练等,减少工作人员在反应堆环境中的辐射照射时间,提高操作的准确性等。

(2) 增强现实技术与知识数据库系统结合。目前的AR核辐射环境应用主要体现在远程操作、设备维护和操作引导等实验性研究,而比较实用的目标是构建基于知识数据的增强现实系统。这些知识数据库包括当前的环境传感器数据、任务流程、CAD模型,以往的操作过程或加工数据和专家的历史经验数据等。比如在辐射手套箱材料加工AR应用中,实现全工艺加工流程的虚拟培训和操作引导,实现历史操作数据和专家知识数据的管理和查询,为当前操作人员提供丰富的经验和正确的操作选择等。

(3) 增强现实与机器人结合。目前的AR辐射环境应用只是从一定程度上降低辐射材料对操作人员的健康威胁。使用机器人代替操作用户,让操作人员彻底远离合辐射环境,实现机器人远程呈现、任务操作、远程加工等是核辐射环境AR应用的长远目标。比如在核反应堆退役应用中,使用机器人进入封闭的辐射环境,利用AR交互接口实现核废弃材料的远程移动、搬运和处理。在辐射材料加工应用中,使用机器人远程搬运、装卸工件,远程控制数控机床进行材料加工等。

5 存在难题

目前,鉴于核辐射环境的特殊性,依然还存在一些难题需要进一步解决,以满足更实际的核辐射环境AR应用需求。这些难题包括以下几个方面。

(1) 核电站大范围区域内的海量标志物识别技术。开发实用的核电站维护AR系统,需要在诸多设备上安装数以千计的标志物,但是目前使用的ARToolKit、ARTag等标志板识别数目有限,而且它们的开发平台自成一系,无法同时集成到一个应用系统中,将标志板、AFID和二维码等目标进行组合是可选的解决途径,但还需要进一步研究和测试。

(2) 核反应堆环境下的机器人定位跟踪技术。使用机器人实现核反应堆封闭环境下的远程操作,需要对机器人的位置进行精确跟踪和定位。目前在机器人领域,集成摄像机与惯性传感器的即时定位与地图重建等技术[48]还无法实现室外复杂场景的跟踪定位,对于完全封闭、场景未知而且受光照影响的核反应堆环境进行跟踪定位就更为困难。

6 结论

增强现实技术经过二十多年发展已经取得重大进步,它与核辐射环境的特点紧密结合,促进了增强现实技术在核辐射环境中的应用,增强了核辐射工业环境的安全性。本文对增强现实在核辐射环境中的应用进行了初步论述,论述要点总结如下:

(1) 增强现实在核反应堆、核电站和辐射手套箱等核辐射环境中的应用目标各不相同,在核反应堆环境中主要用于远程操作,在核电站中主要用于便携式系统维护,在辐射手套箱中主要用于加工操作引导。增强现实进一步的应用方向是研究堆、动力堆等反应堆环境。

(2) 目前在不同核辐射环境中最稳定和实用的姿态跟踪方法是标志物跟踪方法,但对显示器的选择各不相同。投影显示器适合于核反应堆远程操作,轻量级HMD和手持式显示器适合于核电站便携式设备维护,而轻量级HMD适合于辐射手套箱材料加工。

(3) 不同核辐射环境对人机交互手段要求不同。核反应堆远程操作一般使用传统的鼠标键盘,而核电站和核辐射手套箱环境使用手势和语音进行交互更实用。

(4) 增强现实在核辐射环境中的发展趋势是与工作任务相关的知识数据库结合实现历史经验数据集成,长远目标是与机器人结合,使用机器人代替操作人员,实现辐射环境机器人的远程呈现、任务操作和远程加工等功能。

(5) 核辐射环境AR应用的现有难题是核电站大范围区域内的海量标志物识别技术,长远的技术难题是需要突破核反应堆环境下的机器人定位跟踪技术,实现封闭复杂的核反应堆环境的跟踪定位。

综上,增强现实技术在核辐射环境可发挥重要作用,它为改善当前核辐射环境工作条件,增强操作人员的安全性提供了独特的技术途径。伴随增强现实跟踪注册、人机交互、显示等关键技术及其机器人技术的不断发展,增强现实在核辐射环境中的应用必将更为实用和有效,未来实现核辐射环境下基于增强现实技术的机器人远程操作、远程维护和远程材料加工将不再是一个梦想,而是一个现实。

[1] Azuma R. A Survey of Augmented Reality,Presence:Teleoperators and Virtual Environments[J].1997,6(4):355- 385.

[2] Azuma R,Baillot Y,Behringer R,Feiner S,Julier S,Macintyre B .Recent Advances in Augmented Reality,Computer Graphics and Applications[J].2001,21(6):34-47.

[3] Feng Z,Duh H,Billinghurst M.:Trends in Augmented Reality Tracking,Interaction and Display:A Review of Ten Years of ISMAR[C].// Proc. of International Symposium on Mixed and Augmented Reality,2008:193-202.

[4] Jcarmigniani J,Furht B,Anisetti M,et al. Augmented reality technologies,systems and applications[J]. Multimedia Tools and Applications,2011(51):341-377.

[5] Milgram P,Kishino F . A Taxonomy of Mixed Reality Visual Displays,IEICE Transactions of Information Systems [J],1994,E77-D(12):1321- 1329.

[6] Morkos B,Taiber J,Summers J,et al. Mobile devices within manufacturing environment:a BWM applicability study[J]. Int J Interact Des Manuf.,2012(6):101-111.

[7] Novak-Marcincin J,Barna J,Ja nak M,Novakova-Marcincinova L,Fecova V. Production Processes with integration of CA data in augmented reality environment[C].//16th International Conference on IEEE Intelligent engineering Systems,Lisbon,Portugal:IEEE,2012:77-80.

[8] Julier S,Baillot Y,Lanzagorta M,et al. BARS:Balltlefield augmented reality system[C]. // NATO Symposium on Information Processing Techniques for Military Systems. Istanbul,Turkey:IEEE,2000:9-11.

[9] Kang X,Azizian M,Wilson E,et al. Stereoscopic augmented reality for laparoscopic surgery[J]. Surg. Endosc,2014(28):2227-2235.

[10] Kang J. ARteleport:digital reconstruction of historical and cultural-heritage sites using mobile augmented reality[C].// IEEE 2012 11th international conference on trust,s ecurity and privacy in computing and communications. IEEE,2012:1666-1675.

[11] Broll W,Lindt I,Herbst I,et al. Toward next-gen mobile AR games[J],IEEE Computer Graphics and Applications,IEEE,2008,28(4):40-48.

[12] Li M,Mahnkopf L,Kobbelt. The design of a segway ar-tactile navigation system[J]. Pervasive 2012,LNCS,2012(7319):161-178.

[13] Matsutomo S,Miyauchi T,Noguchi S,Yamashita H. Real-time visualization system of magnetic field utilizing augmented reality technology for education[J]. IEEE Transactions on magnetics. 2012,48(2):531-534.

[14] Lee H,Kim D,Woo W. Graphical menus using a mobile phone for wearable AR systems[C].//2011 international symposium on ubiquitous virtual reality. IEEE,2011:55-58.

[15] Holloway R L. Registration error analysis for augm-ented reality [J]. Presence:Teleoperators and Virtual Environments. 1997,6(4):413-432.

[16] Zhang Z Y. A flexible new technique for camera calibration[J]. IEEE Transaction on Pattern Analysis and Machine Intelligence [J],2000,22(11):1330-1334.

[17] Gelb A,Kasper J F,Nash R A,Price C F,Sutherland A. Applied Optimal Estimation[M]. Massachusetts,US:MIT Press Publication,2001.

[18] Welch G,Bishop G. An introduction to the Kalman filter[EB/OL],[2015-10-20]:http://www.sc. unc.edu/~welch/media/pdf/kalman_intro.pdf, March 5,2014.

[19] Baillot Y,Rolland J P,Goon A. A survey of tracking technology for virtual environments [R].Technical Report,University of Central Florida,Orlando FL,USA,1999.

[20] Kishino Y,Tsukamoto M,Sakane Y,et al. Realizing a visual marker using LEDs for wearable on distributed computing environment[C].// Proc. Of IEEE Int’l Conference on distributed computing systems workshops(Int’l Workshop on Smart Appliances and wearable computing(IWSAWC 2003)),IEEE,2003:314-319.

[21] Park N,Lee W,Woo W. Barcode-assisted planar object tracking method for mobile augmented reality[C].// 2011 International Symposium on Ubiquitous Virtual Reality. IEEE,2011:40-43.

[22] Kato H,Billinghurst M. Marker tracking and HMD calibration for a video-based augmented reality conferencing system[C].// Proceedings of the 2nd IEEE and ACM International Workshop on Augmented Reality(IWAR '99). San Francisco,CA,USA:IEEE,1999:85-94.

[23] Fiala M. ARTag,a fiducial marker system using digital techniques[C].//IEEE Computer Society Conference on Computer Vision and pattern Recognition(CVPR 2005),IEEE,2005:590- 596.

[24] Heath M,SarKar S,Sanocki T,Bowyer,K. Comparison of Edge Detectors:a Methodology and Initial Study,Computer Vision and Image Understanding [J],1998,69(1):38-54.

[25] Schmid C,Mohr R,Bauckhage C. Evaluation of Interest Point Detectors [J]. International Journal of Computer Vision[J],2000,37(2):151-172.

[26] Simon G,Fitzgibbon A,Zisserman A. Markerless Tracking using Planar Structures in the Scene[C].// Proc. of International Symposium on Augmented Reality. IEEE,2000:120-128.

[27] Lowe D G,Distinctive image features from scale- invariant features [J]. International Journal of Computer Vision,Springer,2004,60(2):91-110.

[28] 罗斌,王涌天,沈浩,吴志杰,刘越,增强现实混合跟踪技术综述[J].自动化学报,2013,39(8):1185-1201.

[29] Bian Z,Ishii,H,Shimoda H,Yoshikawa,H,Morishita Y,Kanehira Y,Izumi M. Development of a Tracking Method for Augmented Reality Applied to NPP Maintenance Work and its Experimental Evaluation[J]. IEICE TRANSACTIONS on Information and Systems,2007,E90-D(6):963-974.

[30] Ishii H,Yan W,Yang S,Shimoda H,Izumi M. Wide Area Tracking Method for Augmented Reality Supporting Nuclear Power Plant Maintenance Work[J].International Journal of Nuclear Safety and Simulation,2010,1(1):45-51.

[31] Rolland J P,Fuchs H. Optical Versus Video See-Through Head-Mounted Displays in Medical Visualization [J]. Presence:Teleoperators & Virtual Environments. 2000,9(3):287-309.

[32] Rolland J P,Biocca F,Hamza-Lup F,et al. Development of Head-Mounted Projection Displays for Distributed,Collaborative,Augmented Reality Applications.[J]. Presence:Teleoperators & Virtual Environments. 2005,14(5):528-549.

[33] Rolland J,Cakmakci O. The past,present,and future of head mounted display designs[C]. //SPIE Proceedings.Optical Design and Testing II. SPIE,2005:368-377.

[34] Piekarski W. 3D modeling with the Tinmith mobile outdoor augmented reality system [J]. IEEE Computer Graphics and Applications,2006,26(1):14-17.

[35] Mirzaei M R,Ghorshi S,Mortazavi M. Combining augmented reality and speech technologies to help deaf hand hard of hearing people[C]. //The 14th Symposium on virtual and augmented reality.ACM,2012:174 -181.

[36] Mistry P,Maes P. SixthSense:A wearable gestural interface[C]. //Proc. of SIGGRAPH Asia’ 09. Sketch,Yokohama,Japan:ACM,2009:85-92.

[37] Bellabi A,Benbelkacem S,Zenati-henda N,et al. Hand gesture interaction using color-based method for tabletop interfaces[C]//Proc. of IEEE 7th International Symposium on Intelligent Signal Processing. Floriana,Malta:IEEE,2011:1-5.

[38] Lee T,Hollerer T. Hybrid feature tracking and user interaction for marker-less augmented reality[C]//Proc. of the IEEE Virtual Reality. Reno,Nevada,USA:IEEE,2008:145-152.

[39] Choi J,Park H,Park J,et al. Bare-hand-based augmented reality interface on mobile phone [C].//Proc. of 10th IEEE International Symposium on Mixed and Augmented Reality. Basel,Switzerland:IEEE,2011:1-5.

[40] Kojima Y,Yasumuro Y,Sasaki H,et al. Hand manipulation of virtual objects in wear augmented reality[C].//Proc. of the 7th International Conference on Virtual Systems and Multimedia. Washington,DC,USA:IEEE,2001:463-469.

[41] Lee M,Green R,Billinhurst M. 3D natural hand interaction for AR applications[C].//Proc. of the 23rd International Conference on Image and Vision Computing New Zealand. Lincoln,New Zealand:IEEE,2008:1-6.

[42] Parker J R,Baumback M. User interface augmentation:vision and sound [C].//Proc. of International Conference on Information Technology:Coding and Computing.Las Vegas,Nevada,USA:IEEE,2004,vol.1:692-697.

[43] Lee B,Chun J. Interactive manipulation of augmented objects in marker-less AR using vision-based hand interaction[C].//Proc. of the 7th International Conference on Information Technology:New Generations. Las Vegas,Nevada,USA:IEEE,2010:398-403.

[44] McDonald C,Malik S,Roth G. Hand-based interaction in augmented reality[C].//Proc. of IEEE Int. Workshop HAVE,Haptic Virtual Environments and Their Applications. Ottawa,Ontario,Canada:IEEE,2002:55-59.

[45] Oka K,Sato Y,KoiKe H. Real-time fingertip tracking and gesture recognition [J]. IEEE Computer Graphics and Applications,2002,22(6):64-71.

[46] Heidemann G,Bax I,Bekel H. Multimodal interaction in an augmented reality scenario[C].//Proc. of the 6th International Conference on Multimodal Interface. State College,PA,USA:ACM,2004:53-60.

[47] Henderson S,Feiner S. Opportunistic tangible user interfaces for augmented reality[J]. IEEE Transactions on Visualization and Computer Graphics,2010,15(1):4-16.

[48] Siltanen S,Hakkarainen M,Korkalo O,et al. Multi- modal user interface for augmented reality[C]. //IEEE 7th Workshop on Multimedia Signal Processing. IEEE,2007:78-81.

[49] Corby Jr. N.R and Nafis C.A. Augmented reality telemanipulation system for nuclear reactor inspection[C].// SPIE on Telemanipulator and Telepresence Technologies. SPIE,1994:360-365.

[50] Fuchs P,Nashashibi F,Maman D. Assistance for tele-presence by stereovision-based augmented reality and interactivity in 3D space[J]. Presence:Teleoperators and Virtual Environments. 2012,11(5):515-535.

[51] Klinker G,Creighton O,Dutoit A H,et al. Augmented maintenance of power plants:a prototyping case study of a mobile AR system[C]. // Proceedings of IEEE and ACM International Symposium on Augmented Reality(ISAR 2001). IEEE,2001:124-133.

[52] Ishii H. Augmented reality:fundamentals and nuclear related applications [J]. Nuclear safety and simulation,2010,1(4):316-327.

[53] Ishii H,Bian Z,Fujino H,et al. Augmented reality applications for nuclear power plant maintenance work[C],International Symposium on Symbiotic Nuclear Power Systems for 21st Century(ISSNP),2007:262-268.

[54] Ishii H,Shimoda H,Nakai T,Izumi M,Bian Z,Morishita Y. Proposal and Evaluation of a Supporting Method for NPP Decommissioning Work by Augmented Reality[C].// The 12th World Multi-Conference on Systemics,Cybernetics,2008(6):157-162.

[55] Shimoda H,Ishii H,Yamazaki Y,et al. A support system for water system isolation task in NPP by using augmented reality and RFID[C]. // The IEEE 6th International Xonference on Nuclear Thermal Hydraulics,Operations and Safety(NUTHOS-6). Nara Japan,2004:4-8.

[56] Leutert F,Schilling K,Robotik L F,et al. Support of power plant telmaintenance with robots by augmented reality methods[C]. //2012 2nd International Conference on Applied Robotics of the Power Industry(CARPI),ETH Zurich,Switzerland,IEEE,2012:45-49.

[57] Eursch A. Increased Safety for Manual Tasks in the Field of Nuclear Science using the technology of augmented reality[C].// IEEE Nuclear Science Symposium Conference Record,IEEE,2007,2053-2059.

A primary survey of augmented reality applicationsfor nuclear radiation environments

LUO Bin

(Institute of Computer Application,China Academy of Physics and Engineering,Mianyang of SiChuan Prov.,621999,China)

A primary survey of augmented reality applications for nuclear radiation environments is presented. The element properties of augmented reality is introduced and the key technologies served within nuclear radiation environments are analyzed including head pose tracking,display and human-computer interaction,then the state-of-the-art applications of augmented reality are described in the fields of nuclear power plants,nuclear glove box and nuclear reactor,finally the pending problems and the development tendency are discussed and the summary is made.

Augmented reality;Human-computer interaction;Nuclear radiation environment

2015-12-20

中国工程物理研究院预先研究项目资助

罗 斌(1974—),男,侗族,贵州石阡人,高级工程师,博士,从事虚拟现实和增强现实技术研究

TP391,TL7

A

0258-0918(2016)04-0561-10