人眼检测技术研究进展*

2015-12-26常胜江孟春宁韩建民林淑玲

常胜江 孟春宁 韩建民 林淑玲

(1.南开大学现代光学研究所,天津,300071;2.公安海警学院电子技术系,宁波,315801)

人眼检测技术研究进展*

常胜江1孟春宁2韩建民2林淑玲2

(1.南开大学现代光学研究所,天津,300071;2.公安海警学院电子技术系,宁波,315801)

基于计算机视觉的人眼检测研究是人脸识别和视线追踪等技术的关键,具有重大的应用价值,并且对模式识别研究的发展有重要的理论意义。本文通过回顾人眼检测近20年来的主要研究成果,分别根据算法使用的模式识别原理及检测结果提出两种全新的人眼检测分类方法;然后按检测结果分类阐述了各种人眼检测方法的基本思想及其优缺点,并尝试通过不同的分类方法从不同的角度揭示各类算法的本质;最后分析总结了人眼检测研究的发展现状,展望了其应用前景及发展趋势。

人眼检测;人眼分割;人眼定位;虹膜定位

引 言

眼睛在人与人的自然交互中有着重要的意义,它通常能反映交互双方的意向以及认真、友善、诚恳或尊重的程度。尤其是在威严、敌对或爱恋等极端情况下,眼睛甚至可以传达“杀机”或“钟情”。因此,经过漫长进化形成的人类视觉对注视和面部表情的探知能力是非常优异而独特的,不仅识别的速度快,而且推广性极高,其机制研究至今仍是视觉科学的前沿课题。随着CMOS图像传感器和DSP器件的出现和发展,基于计算机视觉的无接触智能检测识别技术,已从一种长远的理想需要,变成了现实可行的应用目标,并有巨大的潜在市场。基于计算机视觉的人眼检测技术以非侵入性及便捷精确的特点使其在心理学[1]、认知科学[2]、医学生理学[3]、市场研究[4]、人机交互[5]及公共安全[6]等领域取得了广泛的应用。眼睛图像的独特性及眼睛的运动特点是人脸检测、人脸识别、虹膜识别、人眼跟踪、表情理解以及行为识别等技术的关键线索,同时人眼检测也是人脸识别、虹膜识别及人眼跟踪等技术的必要步骤,人眼检测的精度和速度将直接影响这些视觉应用技术的表现[7]。

基于计算机视觉的人眼检测,即在图像中找出人眼,严格地讲,检测应包含两个步骤:首先判断图像中有无人眼;如果有则定位人眼的位置。绝大部分人眼检测是在人脸图像的基础上进行的,而人脸中一定存在人眼,因此有时也将人眼检测称为人眼定位。经过几十年的研究取得了很多优秀的研究成果,但是个体差异、遮挡、视角、光照、尺度变化、噪声及图象分辨率等因素带给人眼检测的困难仍然存在。现有方法在一定程度上着重解决了其中一种或几种影响因素,使得人眼检测技术在很多领域取得成功的应用。本文综述了人眼检测领域近20年的主要研究成果,详细介绍了人眼检测方法中最具代表性的研究成果以及这些算法后续的改进情况,阐述了这些算法的基本思想及其优缺点,并对该领域的进一步发展作了初步的展望。

1 人眼检测算法分类

现有的人眼检测方法种类繁多,国内外研究人员从不同角度对人眼检测方法进行了初步分类,如唐琎等[8]按照明光的不同将人眼检测算法分为常光源下及特种光源下两类。徐来等[9]将人眼检测方法分为基于模板匹配、基于灰度投影、基于统计及基于知识四种方法。Hansen等[10]将现有人眼检测方法分为基于形状的、基于表观的以及混合方法三种,其分类方法的核心依据是建模所用的图像特征不同,例如基于表观的方法主要利用图像的整体纹理特征或其子集建模,而基于形状的方法主要依据角点或轮廓等形状特征。上述几种分类方法存在的主要问题是分类依据难以揭示检测算法本质、类间重叠问题突出等,本文尝试分别依据算法使用的模式识别原理及检测结果对人眼检测方法进行分类。由于检测也是一种模式识别问题,即将目标与背景分开的二分类问题,它与一般分类问题的不同仅在于检测涉及的两类数量悬殊。所以人眼检测方法可按其识别原理分为基于知识的方法和基于数据的方法两类。基于知识的方法是指根据人们已知的关于对象的知识,制定出若干描述特征与类别间关系的准则,使计算机按照这些准则决策未知样本的类别。基于数据的方法并不需要依靠人来制定决策规则,而是对一定数量的样本中的某些特征进行统计学习建立分类器。这两种方法的根本区别在于决策规则是由人根据自己的先验知识制定的还是由分类器根据给定的若干样本统计学习得到。

在人眼检测的应用中,不同的应用目标往往要求不同的检测结果,例如虹膜识别以及眼动跟踪技术需要精确的人眼位置及虹膜轮廓,而人脸识别和表情理解则往往并不需要非常精确的眼睛位置。因此,按照检测结果的精度可将人眼检测分为两大类:粗略的人眼检测和精确的人眼检测。粗略的人眼检测主要指人眼区域分割,并可利用分割出的眼睛窗口的中心估计眼睛位置;精确的人眼检测指人眼位置和轮廓检测,人眼位置通常由瞳孔或虹膜轮廓的中心确定。

2 粗略的人眼检测算法

人眼区域分割是一种粗略的人眼检测,其结果通常是一个包括人眼及少部分皮肤的矩形窗口。分割出的人眼区域可以用来估计眼睛位置,用于人脸检测、人脸识别或表情识别的辅助研究,还可以作为精确的人眼检测方法中必不可少的中间步骤。下面介绍几种常用的人眼区域分割方法。

2.1 基于人体测量学标准的方法

基于人体测量学标准的人眼区域分割是一种基于先验知识的方法,这种方法根据人们总结出的眼睛在人脸中的分布规律确定眼睛位置。Feng等[11]在精确定位人眼之前利用VerJak等[12]根据人体测量学标准提出的人脸模型分割出人眼区域。Wu等[13]利用眼睛区域灰度值比其附近皮肤区域低的特点结合人的双眼分布特点分割出眼睛区域。王文成等[14]利用水平积分投影函数结合“三庭五眼”的规则获取人眼区域。该方法的优点是简单、分割速度快,常用来确定人眼区域的大致范围,不足之处在于易受人脸检测结果的影响,且由于没有考虑不同人脸器官分布的差异,因此分割结果很粗略。

2.2 肤色模型

肤色模型也是一种基于先验知识的方法,多用于人脸检测[15-16]。由于眼睛区域在由肤色模型二值化的人脸图像中常表现为与周围皮肤异色的空洞,因此皮肤区域包围的空洞常作为可能的人眼区域。例如,Hsu等[17]在YCrCb空间中检测肤色区域,分别构造了色度空间和亮度空间的眼图,然后将两幅图做乘法运算,再通过一系列的形态学处理增强眼睛区域的亮度,最后结合阈值法分割出眼睛区域;Kumar等[18]利用阈值法在HSV颜色空间和归一化的RGB颜色空间中分割可能的眼睛区域;Stiefelhagen等[19]利用一种由归一化皮肤颜色的二维高斯分布组成的统计颜色模型里寻找肤色区域,将最大的连通肤色区域作为人脸,并在人脸的空洞中搜索可能的眼睛区域。肤色模型充分利用了人脸图像的颜色特点,曾经被很多研究者广泛使用[20]。但皮肤在不同光照条件下的外观差异非常大,且不同人种肤色差异更大,因此这种方法往往并不可靠。

2.3 基于对称性的方法

对称性是检测双眼的一个重要线索,利用这个线索检测人眼也是一种典型的基于知识的方法。Orazio等[21]利用两只眼睛对称分布的特点检测候选眼睛区域。考虑到人脸中眼睛、眉毛和嘴巴具有一定的径向对称性,Reisfeld等[22]设计了一个广义的对称算子,在人脸边缘图像中检测人眼和嘴巴中的关键点。Loy等[23]受广义对称算子的启发,在考虑到一个中心像素对其局部邻域影响的基础上,提出一种快速的径向对称变换算法,其实质是突出虹膜等具有圆对称特性的区域。王先梅等[24]将双眼区域扩展到双眉、双眼以及眉眼之间的对称性,并增加同侧眉毛与眼睛相对位置的先验知识,实现了眼睛区域定位。类似利用对称算子检测局部特征的方法受到很多研究者关注[25-26]。利用这种方法检测人眼时易受鼻孔等其他对称元素的干扰,且对遮挡较敏感。

2.4 基于时域信息的方法

基于时域信息的方法需要利用包含眼睛的视频序列图像,一般利用眨眼或眼动造成的相邻两帧图像中眼睛区域的变化为线索。这种方法假设在连续两帧图像中头部是固定不动的,然后用帧差法结合阈值法检测相邻帧图像的变化。Grauman等[27]对序列图像中相邻两帧图像进行差分,利用眨眼造成信息变化,再结合阈值法和人体测量学标准得到眼睛区域;Bhaskar等[28]用帧差法结合光流法实现了眨眼检测及人眼跟踪;Chau等[29]用形态学运算去除帧差法得到图像噪声以增强眼睛定位的鲁棒性,实现了人眼定位及眨眼检测。这种方法的优点是模型简单,计算复杂度低;缺点是光照变化、快速的头动及视频中的噪声等都会对其造成致命影响,且只适用于视频序列图像。

2.5 模板匹配法

模板匹配法是一种被广泛用于图像分割及模式识别的有效方法。模板匹配所依据的数据一般只有一个或几个模板,而基于数据的方法通常需要大量数据,因此可将已知模板理解为先验知识,模板匹配就可归为基于知识的方法。模板匹配法是根据已知模板图像各像素的灰度(或经某种变换后的图像),利用某种相似性度量规则搜索整幅图像寻找与模板相似的区域。计算相似度的方法有曼哈顿距离、欧氏距离、Hausdorff距离及相关系数匹配等。

曼哈顿距离和欧氏距离是最基本的距离度量方式,它们都是明考夫斯基距离的特殊形式,两个n维向量Xi和Xj间的明考夫斯基距离定义为

(1)

当q=1时,称为曼哈顿距离,又称“城市街区”距离或绝对值距离;当q=2时,称为欧几里德距离,即欧氏距离。点集A与点集B之间的Hausdorff距离(Hausdorff distance, HD)定义为

(2)

式中

(3)

(4)

Hausdorff距离度量了两个点集之间的最大不匹配程度,其值越小说明两点集越相似,由于不需要点与点之间一一对应,因此它对局部非刚性的扭曲及图像的局部遮挡等不敏感。为解决Hausdorff距离易受噪声影响的问题,研究人员先后提出了不同的改进算法。Huttenlocher等提出了部分Hausdorff距离(Partial hausdorff distance, PHD)[30],Sim等提出了最小截平方Hausdorff距离(Least trimmed square hausdorff distance, LTS-HD)[31],Dubuisson提出了平均Hausdorff距离(Modified Hausdorff distance, MHD)[32]。

Yuan等将平均Hausdorff距离与一种能够克服光照变化的八邻域变换算法相结合实现了人眼区域定位[33]。Jesorsky等[34]利用平均Hausdorff距离设计了人脸和人眼检测器,在检测出人脸后,利用二值化的边缘眼睛模型在人脸边缘图像中得到眼睛区域。

相关系数可以衡量两个随机变量的相关程度,相关系数的绝对值越大表示两者越相似。大小都为m×n的两幅图像S与T的相关系数(Normalized cross correlation, NCC)定义为

(5)

式中

(6)

Bhoi等[35]通过计算单个眼睛模板与人脸图像的相关系数定位出眼睛区域。Campadelli[36]首先利用Arbib等[37]提出的聚类方法将人脸图像中像素分成3类:背景、皮肤及剩余部分,然后将第3类中被皮肤包围的像素值置为1,其他均置为0,这样得到二值化的特征图像,选取二值化的双眼模板在特征图像中做相关系数匹配,选择0.7作为阈值检测眼睛区域。Wang等[38]利用同态滤波器构造了一种二值双眼模板,采用该模板在滤波得到的二值图像中做相关系数匹配得到候选人眼区域。

模板匹配法实现过程简便直观,且适用范围广泛,但利用模板匹配法分割眼睛区域存在的问题也很多,主要有:

(1)不同人的眼睛千差万别,同一人的眼睛在不同光照或视角下也有很大差异,甚至眼球的转动也会给匹配带来很大困难,所以很难选取出某个合适的眼睛模板使类内间距足够小而类间距离足够大。

(2)模板匹配过程非常耗时,难以达到实时处理的要求。

(3)难以解决尺度变化问题,即使人脸图像大小一致,不同人的眼睛大小也有很大差别。

(4)难以针对不同情况选择合适的相似度匹配方法,如光照变化对多数度量方法影响很大。

2.6 统计学习方法

基于统计学习的方法是当前模式识别领域最主要的方法,是典型的基于数据的方法。这种方法依据训练样本建立分类器,这一过程也称为学习过程。常用的方法有神经网络、支持向量机、隐马尔科夫模型、AdaBoost及子空间方法等。采用基于统计学习的方法解决模式分类问题具有普适性,因此可通过提取边缘、角点(如Harris角点[39])及斑点(如LoG算子[40]、SIFT[41])等局部特征并与统计学习方法结合,也可通过各种变换方法提取整体特征与统计学习方法结合构造分类器,以实现目标检测或识别。基于数据的统计学习方法以其高正确率、强鲁棒性的特点,已成功应用于包括人眼检测的各种目标检测领域,但是也存在训练数据的偏见性,学习模型中的参数选取困难等问题。

人工神经网络(Artificial neural networks, ANNs)是一种模仿人类神经网络的非线性统计数学模型,由节点和节点之间的连接构成。利用神经网络检测人眼的最简单方法是将待检人眼区域的每个像素值作为输入,输出为人眼或非人眼两类,这种做法计算复杂度非常高,且图像灰度值极易受光照变化影响。Reinders等利用微特征作为网络输入以克服不同人眼睛差别的影响,使用局部方向信息代替灰度值以克服光照影响,最后在输入神经网络前使用一种基于先验几何信息的概率方法处理微特征[42]。Motwani等先将人脸图像做小波变换,利用小波极值点邻域的小波系数作为神经网络的输入,训练了一个3层的BP神经网络用于人眼检测[43]。近期也有学者引入深度学习的思想,利用卷积神经网络实现人眼定位[44-45]。

支持向量机(Support vector machine, SVM)是基于统计学习中的VC维理论及结构风险最小化原理设计的一种机器学习方法。SVM能在有限的样本基础上最小化经验风险和置信范围。最小化置信范围可以降低模型的复杂性,从而降低类似神经网络训练中的过学习问题。Huang等[46]利用人眼区域中的所有像素值作为特征训练多项式核函数的SVM分类器,在图像中遍历所有可能的区域检测人眼。在人眼或人脸检测方面,ANNs和SVM更多地用来筛选由其他算法检测出的候选眼睛区域或者作为特征提取后的分类器[47]。Kim等[48]利用旋转不变的Zernike矩表示人眼模式,并作为特征训练SVM分类器,利用眼睛区域灰度值较低的特点估计候选人眼区域;Jee等[49]利用颜色、边缘等信息检测候选双眼区域,再用SVM验证候选区域是否为人眼;Zhu等[50]在主动红外光照明下的人脸视频序列中,采用帧差法获取候选亮瞳,再用SVM在候选瞳孔中识别真正的瞳孔。

隐马尔可夫模型(Hidden Markov models, HMMS)是一种描述时变信号序列的统计分析模型,HMM中的状态是不可见的,但可以知道受状态影响的某些变量。王洪群等[51]考虑到HMM能够处理任意长度的时序,并且状态无需精确观测即可实现分类的优点,用虹膜网格采样法提取特征作为观测符号,将不同半径下采样得到的观测符号构成观测序列训练模型参数用于人眼检测;Samaria等[52]将人脸特征信息整体编码成序列信息,训练HMM检测归一化的正面人脸中的人眼。

基于子空间方法就是通过某种变换方法将高维的目标图像映射到低维的子空间,然后再比较训练样本和测试样本的距离。最有代表性的就是主成分分析法(Principal component analysis, PCA)和线性判别分析(Linear discriminant analysis, LDA)。LDA以类内散度最小化、类间散度最大化的原则将模式样本投影到低维空间,而PCA是遵循方差最大化原则的无监督学习算法,训练的目的是寻找使投影后的数据有最大方差的方向。基于子空间的人眼检测方法的优势在于能够去除样本冗余信息,降低维度。通常的做法[53-54]是利用PCA做人眼图像的标准本征分析,将若干人眼训练数据建模得到本征眼,将待检测图像块投影到低维本征眼空间,通过比较与特征眼之间的距离判断是否人眼。近期Chen等为解决LDA在处理像检测这种二分类问题中不能提取足够多特征的缺点,提出一种改进的LDA算法:群判别分析,并在FERET,BioID,FRGC三个数据库中证明了其用于人眼检测的优势[55]。PCA以及LDA还通常作为标准的人脸识别算法衡量人眼检测的效果[56-57]。

压缩感知(Compressed sensing, CS)[58-59]是一种寻找欠定线性系统的稀疏解的技术。在信号处理问题中,压缩感知就是把高维空间中的信息投影到低维空间,实现信号压缩(或降维)。在模式分类问题中,待识别的模式可由特定的子空间或子流形表示,通过对大量训练样本的学习获取所有待识别模式的超完备子空间,然后通过解L1最优化问题设置重构误差阈值,实现分类或检测[60-61]。超完备字典的经典学习算法有K奇异值分解(K-mean singular value decomposition, K-SVD)迭代算法[62]和最优方向法(Method of optimal directions, MOD)迭代算法[63]。目前对这一新兴理论的研究已渗透到科学与工程技术的各个领域,Yang F[64]、Hu J[65]等很多研究者都已采用压缩感知理论实现了人眼检测。此外,一些通用的基于稀疏表达和压缩感知的模式识别框架[66-67]也可用于人眼检测。

AdaBoost(Adaptive Boosting)是一种融合多个弱分类器构建强分类器进行决策的方法,它能够在训练过程中根据弱分类器的分类错误率自适应地调整样本及分类器权重。Viola等[68]提出的基于Haar特征的AdaBoost人脸检测器是人脸检测乃至目标检测领域里程碑式的突破,积分图和级联结构(Cascade)的使用大幅提高了检测精度和速度,对人脸检测的第1和第2个Haar特征都涉及人眼区域。Hansen等[69]用类似Viola的方法设计了人眼检测器;Niu等[70]为提高类内间距较大的样本数据的分类能力,设计了分别针对正负样本的两个Cascade分类器实现人眼定位,在4个公共人脸库上验证了方法的有效性;针对Haar小波特征主要用于正面人脸中的人眼检测的问题,Wang等[71-72]提出使用一种递归非参判别特征,结合AdaBoost和非参数判别分析实现了人脸和人眼检测。基于Haar特征的AdaBoost人眼检测及其改进算法[73-75]是目前应用最为成功的方法之一。

3 精确的人眼检测方法

虹膜识别、注视方向估计、基于眼动的人机交互或行为识别等应用领域往往需要对人眼进行精确检测,以获取虹膜或瞳孔轮廓,甚至包括上下眼睑边缘,人眼位置由瞳孔或虹膜轮廓的中心确定,因此有时也称为虹膜或瞳孔检测(定位)。本文将常用方法归为4类:基于投影的方法、变形模板法、基于虹膜边缘提取的方法及基于瞳孔边缘提取的方法,其中前两种方法对图像质量要求并不高,但检测精度较低;后两种方法检测精度高但对图像质量要求高。

3.1 基于投影的方法

基于投影的方法利用人眼图像中几何投影的极值点确定人眼关键点,然后利用人眼关键点估计虹膜轮廓及人眼位置。投影方法依据人们的先验知识制定准则指导人眼检测,属于基于知识的方法。常用的投影方法有积分投影函数、方差投影函数、混合投影函数、区域投影函数及边缘投影函数等。

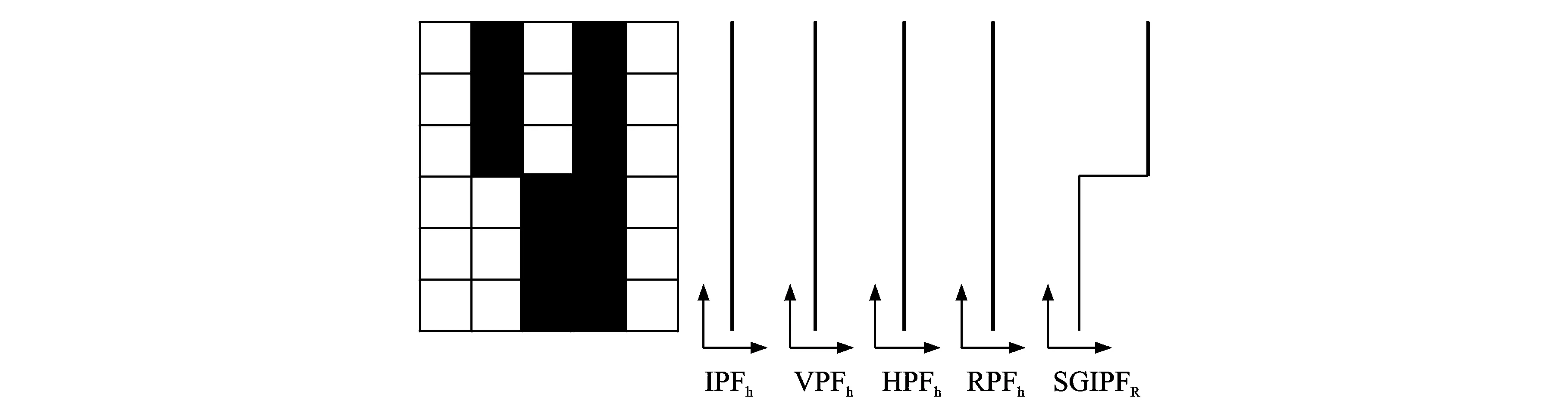

最基本的投影方法是积分投影函数(Integral projection function, IPF),水平方向和垂直方向上的IPF分别定义为

(7)

式中:I(x,y)为图像I中(x,y)处的像素灰度值。利用IPF检测人眼的依据是人眼区域灰度值较低。

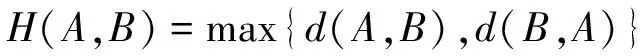

IPF能够刻画出图像中每一行(列)的均值,如果两行像素的均值相等,但每行的灰度变化情况不同,则IPF无法反映出这两行像素的区别,如图1所示。因此Feng等[11]提出方差投影函数(Variance projection function, VPF)方法, VPF能够在一定程度上反映图像中的变化,在由人体测量学标准估计出的眼睛窗口中,分别求出水平及垂直方向上的VPF曲线,利用投影曲线极值点估计出眼睛的6个关键点,最后利用这些关键点拟合出人眼轮廓。

图1 IPF,VPF 和HPF的比较Fig.1 Comparison of IPF, VPF and HPF

IPF反映各行的均值而VPF反映每行像素相对均值的变化情况,并不是所有情况下VPF都优于IPF,例如图1(b)所示的情况VPF便不能区分而IPF却可以,为此Zhou等[76]联合IPF和VPF构造出一种广义投影函数(Generalized projection function, GPF),定义为

(8)

式中:α控制IPF和VPF所占的权重,实验中α=0.6时定位效果最好,将α=0.6时的GPF称为混合投影函数(Hybrid projection function, HPF)。HPF实际上既利用了人眼区域灰度值低的特点又利用了人眼区域灰度值多变化的特点。

文献[14]认为传统积分投影的方法的投影曲线容易受噪声影响产生多个波谷或者波峰,提出区域投影函数(Region projection function, RPF)方法,即将眼睛窗口在水平或垂直方向等分为若干份,其中每份包括数行(列),将每一份的几行(列)的投影累加起来。这种方法存在的问题是将人眼区域划分为多少份并没有统一标准。郑颖等[77]提出最小邻域均值投影函数,用每个像素点邻域的均值代替该像素点的灰度值计算积分投影,以克服噪声干扰。Turkan等[78]提出一种边缘投影的方法,利用人脸上半部分的边缘投影的最大值确定人眼在垂直方向上的位置,并以此位置作为分割人眼的依据,这种方法的人眼区域分割结果非常粗略,极易受到眉毛等干扰,进一步影响在该区域投影确定人眼位置的结果。此外,在不同尺度、不同光照条件下获取理想的边缘图像是边缘提取算法的难点。

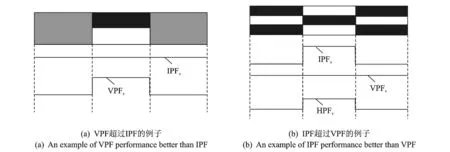

孟春宁等提出一种尺度不变梯度积分投影算法(Scale-invariant gradient integral projection function, SGIPF)用于人脸图像中的人眼区域分割[79]。该算法充分考虑到人眼作为人脸中最显著的区域,具有局部变化丰富的特点,能够将皮肤与白色巩膜、巩膜与虹膜以及虹膜与瞳孔或反射光斑之间的灰度变化累加起来,使得水平方向上的SGIPF能够在眼睛处取得明显的极值。如图2所示,SGIPF可以很好地反映出图中上下两部分的不同,而普通投影方法却无法有效地反映出局部灰度变化。基于投影的方法具有计算量小的优点,但易受光照、眉毛、眼睑和睫毛遮挡的影响。

图2 传统投影方法与SGIPF对比Fig.2 Comparison between SGIPF and other traditional projection methods

3.2 变形模板模型

Kass等[80]提出的主动轮廓模型(Active contour model, ACM),又称Snake模型,是一种自由式的变形模板模型,该模型是由一条包括若干控制点的连续闭合曲线构成,它的形状受内力(曲线连续性和平滑度)的约束,在外力(先验知识)及图像力(图像灰度及梯度信息)的作用下通过迭代收敛到显著的图像特征处。Snake模型可归类为基于先验知识的方法,国内外研究者[81-83]在利用Snake模型检测包括人眼位置在内的人脸显著特征点方面作了大量的工作。

在ACM的基础上,Yuille等[84]提出一种参数化的变形模板法,这种方法构造的眼睛模型包括代表眼睑的两条抛物线以及代表虹膜的一个圆,利用能量函数表征图像中的边缘、角点等信息,通过最小化能量函数寻找最优匹配实现人眼检测。相比于Snake模型,这种方法利用了更多的先验知识(目标的可能形状),可以克服Snake模型无法处理拓扑结构变化的问题。

主动形状模型(Active shape model, ASM)由Cootes等提出[85]。ASM首先利用主成分分析法对一定数量标记好的训练样本进行处理,将关键点的坐标连接成形状向量,进而建立一个统计形状模型,即点分布模型;然后对每个关键点的一定邻域范围内的像素建立局部纹理模型,在训练好的统计形状模型的约束下迭代寻找最优局部纹理模型匹配结果,从而实现检测。主动形状模型往往用来检测人脸特征点,也包括很多人眼中的关键点,如眼角点、虹膜与上下眼睑的交点等,利用这些特征点可以估计人眼位置[86-88]。专门针对人眼检测的研究也有很多,如张波等[89]针对ASM模型在实际检测过程中的姿态适应性较低且定位精度不高的问题,提出局部ASM模型增强ASM算法的姿态适应性,提高对眼睛区域的定位精度。

Cootes等[90]将形状和纹理融合在一起对训练样本进行统计分析,建立了既包含关键点坐标又包含纹理特征的主动表观模型(Active appearance model, AAM)。利用AAM及其改进算法检测人眼或人脸特征点的技术受到了很多研究者的关注[91-92]。ASM和AAM的关键是训练一定数量标记好的样本建立统计模型,因此可归类为基于数据的方法。

变形模板模型的优点是能够将灰度、梯度等图像信息与目标的特点等先验知识充分融合,能够定位包括眼角点在内的多个特征点。缺点是受初始位置及标记的训练样本影响较大,容易收敛到局部极值,对光照、表情、遮挡和尺度的鲁棒性不高,检测精度往往不如基于虹膜或瞳孔边缘提取的方法。

3.3 基于虹膜边缘提取的方法

这种方法一般用于自然光照明下的人眼图像,例如Kim等[93]利用边缘检测技术提取虹膜边缘,然后搜索两条孤立的虹膜边缘内的最长水平线,并以最长水平线的中心作为虹膜中心。Wang等[94]首先将眼睛区域图像二值化,再利用一种3×3的垂直边缘算子增强垂直的边缘,选择两条最长的垂直边缘作为虹膜边缘并将其拟合成椭圆,椭圆中心即眼睛位置;Zhang等[95]利用Canny算子获取眼睛区域的边缘图像,选择两条最长的垂直边缘作为虹膜边缘,并利用随机取样一致(Random sample consensus, RANSAC)算法[96]拟合出虹膜椭圆边界,以椭圆中心作为虹膜中心。在不同的光照条件及图像质量下均取得好的边缘检测效果是该方法最大的难点,也是边缘检测技术难以处理的问题。

基于虹膜边缘提取的方法可以在高质量人眼图像中精确定位虹膜轮廓及中心,无需额外红外光源照明,但是虹膜极易受眼睑及睫毛遮挡影响,不完整的虹膜边缘严重影响椭圆拟合结果。

3.4 基于瞳孔边缘提取的方法

一般情况下,虹膜常被眼睑遮挡,而瞳孔则不易受遮挡,瞳孔中心定位比检测不完整虹膜的中心更容易,也更精确。利用虹膜对红外光的反射特性,加入红外光源照明后瞳孔图像边缘更加清晰。Hough 变换和Daugman算子是最有代表性的检测瞳孔轮廓及中心的算法。

3.4.1 Hough变换

利用圆形Hough变换提取瞳孔边缘的技术广泛应用于虹膜识别技术中[97-99]。边缘提取是执行Hough变换的前提。圆形Hough变换定义为

(9)

式中:(xi,yi)为边缘图像中的边缘点,(xc,yc)为圆心坐标,r为圆半径,其中

(10)

(11)

如果参数为(xc,yc,r)的圆经过边缘点(xi,yi),则g(xi,yi,xc,yc,r)=0,此时H(xc,yc,r)获得一次累加,有多少个边缘点在参数为(xc,yc,r)的圆上,此圆就获得多少投票值。获得最多投票(即最大的H)的圆被认为是瞳孔边缘。

由于瞳孔边缘不易受眼睑遮挡,况且红外成像下瞳孔与周围虹膜的对比度非常高,因此用Hough变换检测瞳孔边缘效果要好于检测虹膜边缘,但其缺点是需要利用主动红外光获取清晰的瞳孔图像,易受头部姿态影响。Hough变换有时也用于提取虹膜边缘[100],但受图像质量、光照及眼睑遮挡影响,效果并不理想。孟春宁等[101]针对头戴式图像采集系统采集的高质量非红外眼部图像中虹膜遮挡情况、虹膜边缘轮廓形状及其梯度方向等特点,提出一种分段加权环形Hough变换算法定位跟踪虹膜,在一定程度上克服了图像质量及眼睑遮挡的影响,并在视线估计应用中取得了较好的结果。

3.4.2 Daugman算子

Daugman算子是由Daugman[102]提出的一种瞳孔(虹膜)边缘提取方法,利用瞳孔与虹膜间的高对比度及瞳孔近似圆形的特点设计了一种圆形微分积分算子定位瞳孔,该方法相比Hough变换无须边缘提取。该算子定义为

(12)

式中:I(x,y)为目标图像中的像素点;Gσ(r)为高斯平滑函数;r(x0,y0)定义一个三维迭代空间中的圆形积分路径。首先用高斯平滑函数对图像进行平滑滤波以消除噪声,然后再搜索不同圆心(x0,y0)及半径r对应的圆周上的归一化的积分值,最后计算每个圆周与其相邻圆周积分值的差分,将差分的极值处对应的圆周视为虹膜或瞳孔边缘。Daugman算子及其改进算法在高质量图像瞳孔及虹膜定位研究中被广泛采用[103-104]。

Daugman算子在目前产品化的虹膜识别设备中取得成功的应用。但该方法应用环境较为苛刻,需要红外照明下的高对比度人眼图像及较好的人眼区域分割结果,迭代的初始位置影响检测速度和精度,易受头部姿态、反射光斑及眼睑睫毛遮挡影响。针对不同应用背景的改进算法可部分克服上述问题,例如孟春宁等[105]受Daugman算子启发,针对低质量自然光照明下的眼部图像,提出一种基于矩形积分方差算子的方法检测虹膜轮廓及中心。该方法利用圆形虹膜轮廓的内接矩形表示虹膜,克服眼睑遮挡的影响;采用积分方差算子取代微分积分的方法,更好地迎合了虹膜区域灰度值较低且相对均匀的特点,矩形积分方差算子定义为

(13)

该方法在YaleB及FERET人脸库中对低质量虹膜图像取得了理想的检测结果。

3.4.3 Starburst算法

Starburst算法由Li等提出[106],这种方法首先用阈值法定位并去除瞳孔反射光斑,然后采用了一种新的迭代算法选择瞳孔边缘点,在该迭代过程中,每个点发出的射线的终止阈值选取是该算法的关键,这需要瞳孔与虹膜之间清晰的对比度作保障。最后利用RANSAC算法将瞳孔边缘点拟合成椭圆,椭圆中心即瞳孔中心。该方法在高质量图像中能精确获取瞳孔轮廓及中心,且无需使用边缘提取技术,但同样需要红外光照明下的高对比度人眼图像,且难以选择合适的终止阈值。

4 研究现状及发展趋势

4.1 研究现状分析及总结

粗略的人眼检测方法通常不需要高分辨率人脸图像,对成像设备及图像质量要求不高,除肤色模型要求彩色图像、基于时域信息的方法要求视频序列图像外,大多没有特殊要求。人眼检测结果为人眼区域或粗略的人眼位置,其应用目标主要是直接为人脸检测、人脸识别、表情识别以及人眼精确定位的粗略检测步骤等服务。基于测量学标准、肤色模型、基于对称性、基于时域信息以及模板匹配均可归类为基于知识的方法。这些方法依靠人的先验知识制定判断规则,无需复杂的理论及算法,因此大多具有计算复杂度低、易于操作的优点;但受个性差异、光照、视角等因素影响,简单的先验知识规则难以获取较好的鲁棒性。基于数据的方法虽然需要复杂的训练学习过程,但从大数据信息中可以学习到更加本质的特征,进而保证分类的鲁棒性及正确率。基于数据的统计学习方法在当前粗略的人眼检测技术中表现出无与伦比的优越性,成为该类方法的主流。例如基于Haar特征的AdaBoost人眼检测及其改进算法以其良好的鲁棒性及实时检测速度,成为当前应用最为成功的人眼检测算法之一。

精确的人眼检测算法对眼部图像质量要求较高,需要通过检测瞳孔或虹膜边缘得到精确的人眼位置。虹膜或瞳孔的形状、灰度特点等先验知识成为检测的关键线索。精确的人眼检测结果可直接为人眼(虹膜或瞳孔)跟踪、虹膜识别及注视估计等技术服务,这些技术日渐成为心理学、认知科学、医学、市场营销及人机交互等领域必不可少的工具。投影法对图像质量要求相对最低,检测精度也最低,但这种方法对成像设备要求低、计算量小,还可作为提高粗略人眼检测精度的补充方法或者作为精确人眼检测的中间步骤。变形模板模型将多种图像特征集成于能量函数中,具有严谨的理论模型,适用于包括人眼在内的各种图像特征的检测,虽然在实际操作过程中受初始位置及局部极值等因素影响,但各种改进算法仍然取得了成功的应用。基于虹膜及瞳孔边缘的算法对图像质量要求最高,检测结果也最为精确,主流虹膜识别系统及眼动仪中人眼检测多采用这种算法原理实现。其中基于虹膜边缘的方法易受制于眼睑遮挡的影响,基于瞳孔边缘的方法必需有主动红外光及响应特定波长的成像设备。

基于数据的方法及基于知识的方法分别在粗略和精确的人眼检测研究中占据主流地位。每种具体的方法都有其局限性,即便是缺陷明显的方法,仍可能在某些应用中有不可替代的作用。针对不同应用背景,通过合理折中正确率、精度、鲁棒性以及泛化性等要求,选择或设计合适的方法将是每个研究者不应忽视的问题。

4.2 人眼检测技术发展趋势

(1)多种算法融合,多种信息融合 采用单一种类算法的检测方法已经难以取得进一步突破,获得理想的结果往往需要在不同的步骤中融合多种算法或将一种算法的思想用于优化另一种算法。此外,理论和实验均可证明,将尽可能多的有效信息抽象成图像特征,并集成在同一个算法模型中,可以取得更好的效果。

(2)针对特定应用的特殊方法 针对不同的应用需求,设计合适的硬件系统,根据具体成像系统采集的图像设计合理的人眼检测算法。例如,针对红外光照明下瞳孔边缘清晰、反射光斑明显的图像特点设计的基于瞳孔边缘提取的系列方法即是取得成功应用的例子。基于眼动信息的行为识别技术是普适计算框架下一个全新的应用领域[107-108],用于行为识别的眼动信息精度要求低于注视方向研究需要的眼动信息,而服务于个人终端的应用目标又要求低廉的硬件成本。此种情况下便可考虑在适当牺牲精度的前提下降低硬件系统要求,选择合适的折中方案。

(3)基于数据的普适方法 当前,以深度学习为代表的基于数据的统计学习方法在特征提取、模式识别领域取得了突破性的进展[109-110]。尽可能地收集各种不同分辨率、光照、视角及尺度等条件下的不同人的眼部图像,利用机器学习模型抽象出更本质的特征,实现人眼检测或人眼特征点的识别。这是最理想的方法,也是实现人工智能的一个方面。

(4)低成本成像系统下的高精度检测方法 黄斑中央的中央凹的面积决定了人眼无需转动便能看清1°左右的视场内的景物,而当前大多商用眼动仪的精度都达到了0.5°左右,因此精度已不是当今眼动技术的难点,昂贵的价格才是限制眼动记录技术应用范围的关键因素。选择普通CCD或CMOS、简单的架构及摒弃红外照明是降低成本、拓宽应用范围的关键。同时,辅助红外光的采用虽然给检测算法带来便利,但其对人眼的伤害[111]及局限于室内环境的缺点限制了它的发展普及。低成本、低侵入性的人眼检测系统将大大拓宽其应用范围,但成本降低的同时给人眼检测算法带来更大的挑战。

5 结束语

基于计算机视觉的人眼检测研究几十年的发展历程是模式识别研究发展的一个缩影。对人眼检测的研究借鉴了众多模式识别、机器学习领域的算法;同时,专门用于人眼检测的方法以及其他方法在人眼库中的测试结果也极大地促进了模式识别理论的发展。近年来,基于人眼检测及眼动跟踪的应用在众多领域层出不穷,但存在的成本高、系统复杂等问题也日益突出。因此,对人眼检测进一步的研究仍具有很大的挑战性和十分重要的意义。

[1] De Vito S, Buonocore A, Bonnefon J F, et al. Eye movements disrupt episodic future thinking[J]. Memory, 2015, 23(6):796-805.

[2] Morris A P. Neuroscience: Tiny eye movements link vision and attention[J]. Current Biology, 2015,25(17):R769-R771.

[3] Molitor R J, Ko P C, Ally B A. Eye movements in Alzheimer′s disease[J]. Journal of Alzheimer′s Disease:JAD, 2015,44(1):1-12.

[4] Snyder E, Hurley R A, Tonkin C E, et al. An eye-tracking methodology for testing consumer preference of display trays in a simulated retail environment[J]. Journal of Applied Packaging Research, 2015,7(1):1-6.

[5] Salunkhe P, Patil A R. A review on device controlled using eye movement[J]. International Journal of Emerging Trends in Science and Technology, 2015,2(1):1773-1778.

[6] Sheela S V, Vijaya P A. Iris recognition methods-survey[J]. International Journal of Computer Applications, 2010,3(5):19-25.

[7] Dutta A, Günther M, El Shafey L, et al. Impact of eye detection error on face recognition performance[J]. IET Biometrics, 2015,4(3):137-150.

[8] 唐琎, 许海柱, 王力.图像中人眼检测技术综述[J].计算机应用研究,2008,25(4):961-966.

Tang Jin, Xu Haizhu, Wang Li. Survey on human eyes detection in images[J]. Application Research of Computers, 2008,25(4):961-966.

[9] 徐来, 周德龙.人眼检测技术的方法研究[J].计算机系统应用,2010(6):226-232.

Xu Lai, Zhou Delong. Technology of human eyes detection[J]. Computer Systems & Applications, 2010(6):226-232.

[10]Hansen D W, Ji Q. In the Eye of the beholder: A survey of models for eyes and gaze[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010,32(3):478-500.

[11]Feng G C, Yuen P C. Variance projection function and its application to eye detection for human face recognition[J]. Pattern Recognition Letters, 1998,19(9):899-906.

[13]Wu J, Zhou Z H. Efficient face candidates selector for face detection[J]. Pattern Recognition, 2003,36(5):1175-1186.

[14]王文成,常发亮. 一种基于区域投影的人眼精确定位方法[J]. 光电子·激光,2011,22(4):618-622.

Wang Wencheng, Chang Faliang. A precise eye localization method based on region projection[J]. Journal of Optoelectronics & Laser, 2011,22(4):618-622.

[15]Zarit B D, Super B J, Quek F K H. Comparison of five color models in skin pixel classification[C]∥Recognition, Analysis, and Tracking of Faces and Gestures in Real-Time Systems, International Workshop on. [S.l.]: IEEE, 1999:58-63.

[16]Vezhnevets V, Sazonov V, Andreeva A. A survey on pixel-based skin color detection techniques[J]. Proc Graphicon, 2003,3:85-92.

[17]Hsu R L, Abdel-Mottaleb M, Jain A K. Face detection in color images[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2002,24(5):696-706.

[18]Kumar R T, Raja S K, Ramakrishnan A G. Eye detection using color cues and projection functions[C]//Image Processing Proceedings International Conference on. [S.l.]: IEEE, 2002:337-340.

[19]Stiefelhagen R, Yang J, Waibel A. Tracking eyes and monitoring eye gaze[C]∥Proceedings of the Workshop on Perceptual User Interfaces. Banff, Ganada: [s.n.], 1997:98-100.

[20]杨秀芳, 戚银城, 李婷,等.基于YCb′Cr′肤色特征和Otsu算法的人眼定位优化方法[J].南京邮电大学学报:自然科学版, 2014,34(1): 99-102.

Yang Xiufang, Qi Yincheng, Li Ting, et al. Eye Localization optimization method based on YCb′Cr′ skin color feature and otsu algorithm[J]. Journal of Nanjing University of Posts & Telecommunications, 2014,34(1): 99-102.

[21]D′Orazio T, Leo M, Cicirelli G, et al. An algorithm for real time eye detection in face images[J]. Pattern Recognition, 2004 ICPR 2004 Proceedings of the 17th International Conference on. [S.l.]: IEEE, 2004:278-281.

[22]Reisfeld D, Yeshurun Y. Robust detection of facial features by generalized symmetry[C]∥Pattern Recognition, Conference A: Computer Vision and Applications Proceedings, 11th IAPR International Conference on. [S.l.]: IEEE, 1992:117-120.

[23]Loy G, Zelinsky A. Fast radial symmetry for detecting points of interest[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2003,25(8):959-973.

[24]王先梅, 迟健男, 王志良.基于2阶段区域匹配的驾驶员眼睛细定位算法[J].数据采集与处理,2010,25(5): 590-594.

Wang Xianmei, Chi Jiannan, Wang Zhiliang. Precise eye location based on two-stage region matching for driver fatigue detection[J]. Journal of Data Acquisition and Processing, 2010,25(5):590-594.

[25]Bokeloh M, Berner A, Wand M, et al. Symmetry detection using feature lines[C]//Computer Graphics Forum. [S.l.]: Blackwell Publishing Ltd, 2009,28(2):697-706.

[26]Chertok M, Keller Y. Spectral symmetry analysis[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2010,32(7):1227-1238.

[27]Grauman K, Betke M, Gips J, et al. Communication via eye blinks-detection and duration analysis in real time[C]//Computer Vision and Pattern Recognition, CVPR, Proceedings of the 2001 IEEE Computer Society Conference on. [S.l.]: IEEE, 2001:1010-1017.

[28]Bhaskar T N, Keat F T, Ranganath S, et al. Blink detection and eye tracking for eye localization[C]//TENCON 2003. Conference on Convergent Technologies for Asia-Pacific Region. [S.l.]: IEEE, 2003,2:821-824.

[29]Chau M, Betke M. Real time eye tracking and blink detection with usb cameras[J]. Boston University Computer Science, 2005,12:1-10.

[30]Huttenlocher D P, Klanderman G A, Rucklidge W J. Comparing images using the Hausdorff distance[J]. IEEE Transactions on PAMI, 1993, 15(9): 850-863.

[31]Sim D G, Kwon O K, Park R H. Object matching algorithm using robust Hausdorff distance measures[J]. IEEE Transactions on Image Processing, 1999,8(3):425-429.

[32]Dubuisson M P, Jain A K. A modified Hausdorff distance for object matching[C]∥Proc 12th Int Conf Pattern Recognition. Jerusalem, Israel: [s.n.], 1994: 566-568.

[33]Yuan J H. Eye location under different eye poses, scales, and illuminations[J]. Chinese Optics Letters, 2010,8(1):59-62.

[34]Jesorsky O, Kirchberg K J, Frischholz R W. Robust face detection using the Hausdorff distance[C]//Audio-and Video-Based Biometric Person Authentication. Berlin, Heidelberg: Springer, 2001:90-95.

[35]Bhoi N, Mohanty M N. Template matching based eye detection in facial image[J]. International Journal of Computer Applications, 2010,12(5):15-18.

[36]Campadelli P, Lanzarotti R. Localization of facial features and fiducial points[C]∥Processings of the International Conference Visualisation, Imaging and image Processing (VIIP2002). Malaga, Spagna: [s.n.], 2002:491-495.

[37]Luccheseyz L, Mitray S K. Color image segmentation: A state-of-the-art survey[C]∥Proceedings of the Indian National Science Academy (INSA-A). Delhi, Indian: Natl Sci Acad, 2001: 207-221.

[38]Wang Q, Yang J. Eye detection in facial images with unconstrained background[J]. Journal of Pattern Recognition Research, 2006,1(1):55-62.

[39]Harris C, Stephens M. A combined corner and edge detector[C]∥Proceedings of Alvey Vision Conference. Manchester, UK: [s.n.], 1988:15-50.

[40]Tuytelaars T, Mikolajczyk K. Local invariant feature detectors: A survey[J]. Foundations and Trends in Computer Graphics and Vision, 2008,3(3):177-280.

[41]Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004,60(2):91-110.

[42]Reinders M J T, Koch R W C, Gerbrands J J. Locating facial features in image sequences using neural networks[C]//Proceedings of the Second International Conference on IEEE Automatic Face and Gesture Recognition. [S.l.]: IEEE, 1996: 230-235.

[43]Motwani M, Motwani R, Harris J F C. Eye detection using wavelets and ANN[C]//Proceedings of Global Signal Processing Conferences and Expos for Industry. Galifornia: [s.n.], 2004: 27-30.

[44]Sun Y, Wang X, Tang X. Deep convolutional network cascade for facial point detection[C]//Computer Vision and Pattern Recognition (CVPR), 2013 IEEE Conference on. [S.l.]: IEEE, 2013: 3476-3483.

[45]杨海燕, 蒋新华, 聂作先, 等.基于并行卷积神经网络的人脸关键点定位方法研究[J].计算机应用研究, 2015,32(8):2517-2519.

Yang Haiyan, Jiang Xinhua, Nie Zuoxian. Facial key points location based on parallel convolutional neural network[J]. Application Research of Computers, 2015,32(8):2517-2519.

[46]Huang J, Shao X, Wechsler H. Face pose discrimination using support vector machines (SVM) [C]∥Proceedings of Fourteenth International Conference on IEEE Pattern Recognition. [S.l.]: IEEE, 1998:154-156.

[47]Benrachou D E, dos Santos F N, Boulebtateche B, et al. Online vision-based eye detection: LBP/SVM vs LBP/LSTM-RNN[C]//Controlo′ 2014-Proceedings of the 11th Portuguese Conference on Automatic Control. [S.l.]: Springer International Publishing, 2015:659-668.

[48]Kim H J, Kim W Y. Eye detection in facial images using zernike moments with SVM[J]. ETRI Journal, 2008,30(2):335-337.

[49]Jee H, Lee K, Pan S. Eye and face detection using SVM[C]//Proceedings of the 2004. IEEE Intelligent Sensors, Sensor Networks and Information Processing Conference. [S.l.]: IEEE, 2004:577-580.

[50]Zhu Z, Fujimura K, Ji Q. Real-time eye detection and tracking under various light conditions[C]∥Proceedings of the 2002 Symposium on Eye Tracking Research & Applications. [S.l.]: IEEE, 2002:139-144.

[51]王洪群,彭嘉雄,于秋则.采用动态 HMM 概率分布模型的人眼精确定位[J].中国图象图形学报,2006,11(1):26-32.

Wang Hongqun, Peng Jiaxiong, Yu Qiuze. A precise eye localization via a dynamic probability distribution HMM model[J]. Journal of Image & Graphics, 2006,11(1):26-32.

[52]Samaria F, Young S. HMM-based architecture for face identification[J]. Image and Vision Computing, 1994,12(8):537-543.

[53]Huang W, Mariani R. Face detection and precise eyes location[C]//Proceedings 15th International Conference on IEEE Pattern Recognition. [S.l.]: IEEE, 2000:722-727.

[54]Moghaddam B, Pentland A. Probabilistic visual learning for object representation[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 1997,19(7):696-710.

[55]Chen S, Liu C. Clustering-based discriminant analysis for eye detection[J]. Image Processing, IEEE Transactions on, 2014,23(4):1629-1638.

[56]Whitelam C, Jafri Z, Bourlai T. Multispectral eye detection: A preliminary study[C]∥Pattern Recognition (ICPR), 2010 20th International Conference on. [S.l.]: IEEE, 2010: 209-212.

[57]Wang P, Ji Q. Multi-view face and eye detection using discriminant features[J]. Computer Vision and Image Understanding, 2007,105(2):99-111.

[58]Candès E J, Romberg J, Tao T. Robust uncertainty principles: Exact signal reconstruction from highly incomplete frequency information[J]. Information Theory, IEEE Transactions on, 2006,52(2):489-509.

[59]Donoho D L. Compressed sensing[J]. Information Theory, IEEE Transactions on, 2006,52(4):1289-1306.

[60]Wright J, Yang A Y, Ganesh A, et al. Robust face recognition via sparse representation[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2009,31(2):210-227.

[61]Davenport M A, Duarte M F, Wakin M B, et al. The smashed filter for compressive classification and target recognition[C]//Proceedings of SPIE Computational Imaging. [S.l.]: SPIE, 2007:326-330.

[62]Aharon M, Elad M, Bruckstein A. K-SVD: An algorithm for designing overcomplete dictionaries for sparse representation[J]. IEEE Transactions on Signal Processing, 2006,54(11):4311-4322.

[63]Engan K, Aase S O, Husøy J H. Frame based signal compression using method of optimal directions (MOD)[C]//Circuits and Systems. Proceedings of the 1999 IEEE International Symposium on. [S.l.]: IEEE, 1999:1-4.

[64]Yang F, Huang J, Yang P, et al. Eye localization through multiscale sparse dictionaries[C]//Proceedings of IEEE International Conference on Automatic Face & Gesture Recognition and Workshops (FG 2011). [S.l.]: IEEE, 2011: 514-518.

[65]Hu J, Deng W, Guo J. Robust eye detection via sparse representation[C]//Network Infrastructure and Digital Content (IC-NIDC), 2012 3rd IEEE International Conference on. [S.l.]: IEEE, 2012:411-415.

[66]Liu H, Li S. Target detection using sparse representation with element and construction combination feature[J]. Instrumentation and Measurement, IEEE Transactions on, 2015,64(2):290-298.

[67]Agarwal S, Awan A, Roth D. Learning to detect objects in images via a sparse, part-based representation[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2004,26(11):1475-1490.

[68]Viola P, Jones M. Rapid object detection using a boosted cascade of simple features[C]//Computer Vision and Pattern Recognition, Proceedings of the 2001 IEEE Computer Society Conference on. [S.l.]: IEEE, 2001:511-518.

[69]Hansen D W, Hansen J P. Robustifying eye interaction[C]//Computer Vision and Pattern Recognition Workshop, CVPRW′06, Conference on. [S.l.]: IEEE, 2006:152-152.

[70]Niu Z, Shan S, Yan S, et al. 2d cascaded adaboost for eye localization[C]//Pattern Recognition, 18th International Conference on. [S.l.]: IEEE, 2006:1216-1219.

[71]Wang P, Green M B, Ji Q, et al. Automatic eye detection and its validation[C]//Computer Vision and Pattern Recognition-Workshops, IEEE Computer Society Conference on. [S.l.]: IEEE, 2005:164-164.

[72]Wang P, Ji Q. Learning discriminant features for multi-view face and eye detection[C]//Computer Vision and Pattern Recognition, IEEE Computer Society Conference on. [S.l.]: IEEE, 2005:373-379.

[73]Guo C, Ben X, Fu X, et al. Facial geometric feature for cascade eye detection[C]//Proceedings of the 2015 Chinese Intelligent Automation Conference. Berlin, Heidelberg: Springer, 2015:413-420.

[74]George A, Dasgupta A, Routray A. A framework for fast face and eye detection[EB/OL]. http://arxiv org/pdf/1505.03344.pdf, 2015-5-13.

[75]Rezaei M, Klette R. Novel adaptive eye detection and tracking for challenging lighting conditions[C]//Computer Vision-ACCV 2012 Workshops. Berlin Heidelberg: Springer, 2013:427-440.

[76]Zhou Z H, Geng X. Projection functions for eye detection[J]. Pattern Recognition, 2004,37(5):1049-1056.

[77]汪增福.最小邻域均值投影函数及其在眼睛定位中的应用[J].软件学报,2008,19:2322-2328.

Wang Zengfu. Minimal neighborhood mean projection function and its application to eye location[J]. Journal of Software, 2008,19(9):2322-2328.

[78]Türkan M, Pardas M, Cetin A E. Human eye localization using edge projections[C]∥2nd International Conference on Computer Vision Theory and Applications. Barcelona, Spain: [s.n.], 2007:410-415.

[79]孟春宁,白晋军,张太宁,等.基于梯度积分投影和最大期望算法的人眼定位[J].光电子·激光,2012,23(10):1971-1976.

Meng Chunning, Bai Jinjun, Zhang Taining, et al. Eye localization based on gradient integral projection and expectation-maximization algorithm [J]. Journal of Optoelectronics Laser, 2012,23(10):1971-1976.

[80]Kass M, Witkin A, Terzopoulos D. Snakes: Active contour models[J]. International Journal of Computer Vision, 1988,1(4):321-331.

[81]Huang C L, Chen C W. Human facial feature extraction for face interpretation and recognition[J]. Pattern Recognition, 1992,25(12):1435-1444.

[82]张志佳,张海峰,周纯冰,等.采用改进Snake模型的虹膜定位方法[J].红外与激光工程, 2011,40(4):767-771.

Zhang Zhijia, Zhang Haifeng, Zhou Chunbing, et al. Iris location method based on improved snake[J]. Infrared and Laser Engineering, 2011,40(4):767-771.

[83]Wu H, Yokoyama T, Pramadihanto D, et al. Face and facial feature extraction from color image [C]//Proceedings of the Second International Conference on IEEE Automatic Face and Gesture Recognition. [S.l.]: IEEE, 1996:345-350.

[84]Yuille A L, Hallinan P W, Cohen D S. Feature extraction from faces using deformable templates [J]. International Journal of Computer Vision, 1992,8(2):99-111.

[85]Cootes T F, Taylor C J. Active shape models—′smart snakes′[M]. London: Springer, 1992:266-275.

[86]万泉,徐斌,刘晓亮,等.基于 DirectShow 的人眼检测[J].计算机工程与设计,2015,36(7):1938-1943.

Wan Quan, Xu Bin, Liu Xiaoliang, et al. Eye detection based on directshow[J]. Computer Engineering and Design, 2015,36(7):1938-1943.

[87]Milborrow S, Nicolls F. Locating facial features with an extended active shape model[M]. Berlin, Heidelberg: Springer, 2008:504-513.

[88]Sun K, Wang H. A composite method to extract eye contour[C]//Affective Computing and Intelligent Interaction. Berlin, Heidelberg: Springer, 2005:112-118.

[89]张波,王文军,张伟,等.驾驶人眼睛局部区域定位算法[J].清华大学学报:自然科学版, 2015,54(6):756-762.

Zhang Bo, Wang Wenjun, Zhang Wei, et al. Driver′s eye region location algorithm[J]. Journal of Tsinghua University: Science and Technology, 2015,54(6):756-762.

[90]Cootes T F, Edwards G J, Taylor C J. Active appearance models[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2001,23(6):681-685.

[91]Ishikawa T, Baker S, Matthews I, et al. Passive driver gaze tracking with active appearance models[C]∥Proceedings of the 11th World Congress on Intelligent Transportation Systems. Nagoya, Japan: [s.n.], 2004:1-18.

[92]Hansen D W, Hansen J P, Nielsen M, et al. Eye typing using Markov and active appearance models[C]//Applications of Computer Vision, Proceedings of Sixth IEEE Workshop on. [S.l.]: IEEE, 2002:132-136.

[93]Kim K N, Ramakrishna R S. Vision-based eye-gaze tracking for human computer interface[C]//Systems, Man, and Cybernetics, IEEE SMC′99 Conference Proceedings. [S.l.]: IEEE, 1999:324-329.

[94]Wang J, Sung E, Venkateswarlu R. Eye gaze estimation from a single image of one eye[C]//Computer Vision 2003 Proceedings Ninth IEEE International Conference on. [S.l.]: IEEE, 2003:136-143.

[95]Zhang W, Zhang T N, Chang S J. Eye gaze estimation from the elliptical features of one iris[J]. Optical Engineering, 2011,50(4):047003-047003-9.

[96]Fischler M A, Bolles R C. Random sample consensus: A paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981,24(6):381-395.

[97]Wildes R P. Iris recognition: An emerging biometric technology[J]. Proceedings of the IEEE, 1997,85(9):1348-1363.

[98]康景磊,郭业才.基于蚁群和 Hough 变换的虹膜定位算法[J].计算机科学,2012(S3):384-385.

Kang Jinglei, Guo Yecai. Iris location algorithm based on ant colony and hough transform[J]. Computer Science, 2012(S3):384-385.

[99]Liu X, Bowyer K W, Flynn P J. Experiments with an improved iris segmentation algorithm[C]//Automatic Identification Advanced Technologies, 2005, Fourth IEEE Workshop on. [S.l.]: IEEE, 2005:118-123.

[100]Cherabit N, Chelali F Z, Djeradi A. A robust iris localization method of facial faces[C]//Multimedia Computing and Systems (ICMCS), 2011 International Conference on. [S.l.]: IEEE, 2011:1-5.

[101]孟春宁, 白晋军, 张太宁, 等. 基于低成本眼动记录系统的视线估计研究[J]. 光电子·激光, 2013,24(8):1600-1605.

Meng Chunning, Bai Jinjun, Zhang Taining, et al. Research on eye gaze estimation based on low-cost eye movement recorder[J]. Journal of Optoelectronics Laser, 2013,24(8):1600-1605.

[102]Daugman J G. High confidence visual recognition of persons by a test of statistical independence[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 1993,15(11):1148-1161.

[103]Daugman J. How iris recognition works[J]. Circuits and Systems for Video Technology, IEEE Transactions on, 2004,14(1):21-30.

[104]Shamsi M, Saad P B, Ibrahim S B, et al. Fast algorithm for iris localization using Daugman circular integro differential operator[C]//Soft Computing and Pattern Recognition, International Conference of. [S.l.]: IEEE, 2009:393-398.

[105]Meng C N, Zhang T N, Zhang P, et al. Fast and precise iris localization for low-resolution facial images[J]. Optical Engineering, 2012,51(7):1-10.

[106]Li D, Winfield D, Parkhurst D J. Starburst: A hybrid algorithm for video-based eye tracking combining feature-based and model-based approaches[C]//Computer Vision and Pattern Recognition-Workshops, IEEE Computer Society Conference on. [S.l.]: IEEE, 2005:79-79.

[107]Bulling A, Ward J A, Gellersen H, et al. Eye movement analysis for activity recognition using electrooculography[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2011,33(4):741-753.

[108]孟春宁,白晋军,张太宁,等.单摄像机下基于眼动分析的行为识别[J].物理学报,2013,62(17):174203-174203.

Men Chunning, Bai Jinjun, Zhang Taining, et al. Eye movement analysis for activity recognition based on one web camera[J].Acta Physica Sinica, 2013,62(17):174203-174203.

[109]Schmidhuber J. Deep learning in neural networks: An overview[J]. Neural Networks, 2015,61:85-117.

[110]He K, Zhang X, Ren S, et al. Delving deep into rectifiers: Surpassing human-level performance on imagenet classification[EB/OL]. http://arxiv.org/1502 01852, 2015-2-6.

[111]Muranko H J. Safety with lasers and other optical sources: A comprehensive handbook[J]. Journal of Occupational Medicine, 1981,23(9):307.

Survey of Eye Detection

Chang Shengjiang1, Meng Chunning2, Han Jianmin2, Lin Shuling2

(1. Institute of Modern Optics, Nankai University, Tianjin, 300071, China;2. Department of Electronic Technology, China Maritime Police Academy, Ningbo, 315801, China)

Research on eye detection based on computer vision is very critical to face recognition and gaze tracking. Furthermore, it is very important not only to related applications but also to the development of pattern recognition. Research findings on eye detection in recent 20 years are reviewed. Firstly, the existing classification methods are discussed and two new classification methods are proposed by recognition principle and detection results. Then, according to the detection results, the basic ideas, the advantages and the disadvantages of the eye detection methods are clarified. Meanwhile, the essence of all kinds of methods is tried to be revealed from different views and by different classification methods. Finally, the current situation of the eye detection research is analyzed and summarized, and the application prospect and development trend are discussed.

eye detection; eye segmentation; eye localization; iris localization

国家自然科学基金(61401105)资助项目。

2015-10-17;

2015-11-09

TP391.4;TN911.73

A

常胜江(1965- ),男,教授、博士生导师,研究方向:数字图像处理、模式识别,E-mail:sjchang@nankai.edu.cn。

孟春宁(1985- ),通讯作者,男,博士、讲师,研究方向:图像处理、模式识别、信息安全,E-mail:mengchunning123@163.com。

韩建民(1965- ),男,副教授,研究方向:信息安全。

林淑玲(1976- ),女,讲师,研究方向:信息安全。