融合梯度和色度信息的分块均值漂移目标跟踪*

2015-12-25唐继勇仲元昌张校臣赵国龙

唐继勇,仲元昌,张校臣,赵国龙

(1.重庆电子工程职业学院 计算机学院,重庆 401331;2.重庆大学 飞行器测控与通信教育部重点实验室,重庆 400044)

1 引言

目标跟踪作为计算机视觉领域的研究热点之一,在图像分割、目标识别、视频分析等领域已得到了广泛应用[1-2],均值漂移(Mean Shift,MS)算法最早于1975 年被Fukunaga 等人[3]提出,是一种非参数化迭代估计算法,随后在Cheng 等人[4]研究的基础上,Comaniciu 等人[5]将均值漂移算法引入了目标跟踪这一领域。

经典MS 目标跟踪算法仅采用RGB 颜色信息作为目标跟踪过程中的特征模型,虽然颜色特征对目标旋转、形变有较强的稳定性,但忽略了视频图像的空间信息,容易受到颜色相似或部分遮挡的干扰,从而导致经典MS 目标跟踪算法的跟踪准确性不佳[6-7]。为此,Adam 等人[8]涉及将所感兴趣的目标做了分块处理,每子块区域在最佳匹配位置做加权处理以估计最终目标位置信息。文献[9]利用分块目标区域来对遮挡问题进行处理,因此,在存在遮挡问题时,对目标区域划分为多个子块是一种有效的方法。许多学者认为多特征融合是解决均值漂移目标跟踪算法不足的有效方法[10-13],其中,文献[13]提出一种多特征融合跟踪方法,提取了颜色和LBP 纹理特征,并融合特征引入到Mean Shift 目标跟踪算法中,该算法可以有效解决单一颜色特征带来的跟踪准确度不高的缺陷。

受到文献[8-13]的启发,第一,考虑到Prewitt算子利用水平与垂直模板提取目标梯度信息具有结构信息,能克服颜色干扰的影响;第二,在颜色空间中,考虑到色度特征受光照较小的影响以及目标跟踪框分块能够增强特征的空间位置关系,并且能够有效解决遮挡问题,因此,本文提出一种融合Prewitt梯度和色度信息的分块均值漂移目标跟踪算法。由于跟踪框边界存在的有用信息较少且存在一定背景干扰,因此,为了减少边界背景干扰,在原跟踪框长宽缩减为原来90%的区域内进行分块处理,并提取色度特征和Prewitt 梯度幅值特征信息,利用Bhattacharyya 距离计算参考目标区域与候选区域间各个子块的相似性程度,根据相似程度融合相应子块的色度特征和梯度特征,在此基础上,将各子块采用串接的方式构造新的目标特征模型,最后,利用均值漂移原理迭代估计目标最终位置信息。对比实验表明,该算法提高了在颜色相似干扰场景下目标跟踪的准确性。

2 Mean Shift 目标跟踪原理

2.1 目标描述

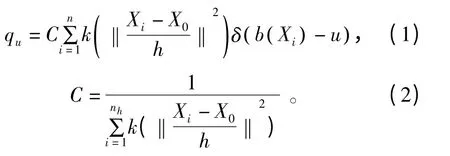

假定跟踪框内含有n个像素{ xi},i=1,2,…,n,每个像素对应的位置坐标矢量为{ Xi}i=1,2,…,n,X0表示参考目标跟踪框区域的中心位置坐标值,并将其特征空间量化为m 等级,则对于位置中心点坐标为X0的核函数直方图特征{ qu}u=1,2,…,m可由如下公式计算:

式中,C 是归一化系数;δ 为Kronecker delta 函数,即;u 表示特征空间量化后特征值的个数;b (Xi)表示坐标点Xi对应的像素值映射到特征空间;h 是跟踪窗带宽;k(·)采用Epanechnikov核函数[14],见公式(3),其目的是为了得到不同位置的权值,该权值与偏离中心点的距离成反比。

式中,r 是偏离所选中心点位置坐标的距离。类似地,对于中心位置坐标为Y0的候选区域,其候选区域跟踪框仍有n个位置坐标矢量{ Yi}i=1,2,…,n,则该区域的核函数直方图特征{pu(Y0)}u=1,2,…,m利用公式(1)可获得。

2.2 Mean Shift 位置估计

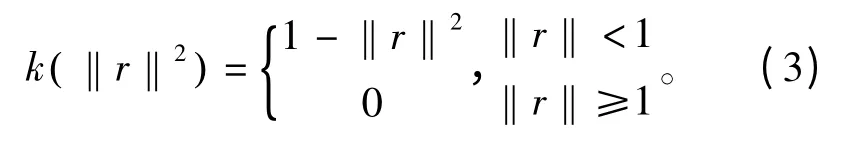

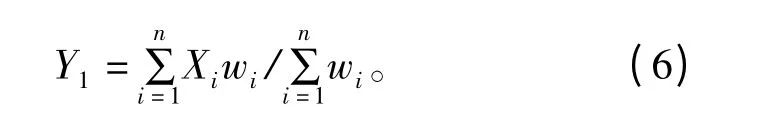

Mean Shift 目标跟踪算法估计目标位置信息的过程,其实质是计算Mean Shift 向量,并通过该向量迭代更新跟踪窗的中心位置信息,寻找参考目标区域与候选区域之间Bhattacharyya 系数的极大值,其所对应的候选区域是当前帧的跟踪结果。利用公式(4)计算偏移向量,将目标位置Y0移动到Y1:

式中,wi表示每个像素点的权重,表达式为

选择Epanechnikov 核将公式(4)表示为

3 分块融合的均值漂移目标跟踪算法

3.1 Prewitt 梯度幅值

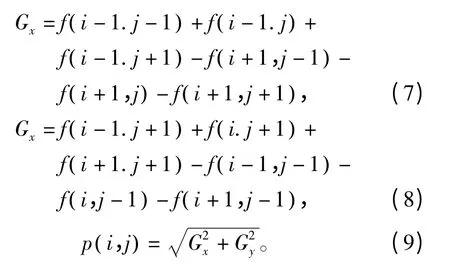

Prewitt 算子表示一阶微分的边缘检测算子,采用像素点上下、左右邻点的灰度像素差,能够在边界处达到极值检测边缘,去掉部分伪边缘,对噪声具有平滑作用[15]。

假设视频序列图像为f,建立3 ×3 模板,中心位置像素用f (i,j)表示,其邻域像素从左上角顺时针旋转依次用f (i-1,j-1)、f (i-1,j)、f (i-1,j+1)、f (i,j+1)、f (i+1,j +1)、f (i+1,j)、f (i+1,j-1)、f (i,j-1)。利用Prewitt 算子的水平与垂直模板计算出当前的检测值,见公式(7)~(8),其值用公式(9)计算所得:

3.2 融合梯度信息的分块均值漂移目标跟踪

由Mean Shift 目标跟踪原理分析可知,目标表示方法的优劣影响Mean Shift 目标跟踪性能。考虑到Prewitt 算子利用水平与垂直模板提取目标梯度信息具有结构信息化能够克服颜色干扰的影响,另一方面考虑目标跟踪框分块能够增强特征的空间位置关系,并且能够有效解决遮挡问题[9],也能将全局特征转化为局部特征来描述目标模型,故提出一种融合Prewitt 梯度信息的分块均值漂移目标跟踪算法。

3.2.1 分块处理

由于传统Mean Shift 目标跟踪算法采用的颜色特征是一种全局特征,为了更好地描述图像局部特征,对目标所在的矩形区域进行分块处理是一个不错的选择。利用矩形框画出所感兴趣的目标区域,由于所跟踪目标的大量有用信息处于跟踪框中间,越靠近跟踪框中心,其有用成分越多,而跟踪框边界的有用成分相对较少,含有大量的背景信息,背景信息的干扰也会使目标跟踪的性能下降。为了降低跟踪框边界背景对目标跟踪的干扰,在跟踪框的上下左右各自缩小5%,再在缩小后的区域内分成互不重叠的4个子块,如图1 所示。若长宽为2 的倍数,则均分视频图像,否则,在视频图像感兴趣的部分采用整除的方法选择分割点,构成4个子块。

图1 区域分块Fig.1 Area blocking

3.2.2 融合Prewitt 梯度信息的分块模型

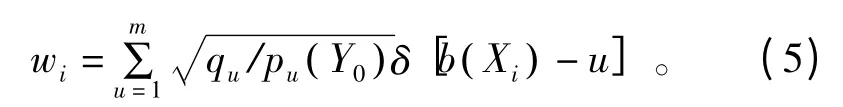

在3.2.1 节的基础上,在目标区域或候选区域上分别提取子块的色度颜色核函数直方图和梯度直方图,均采用量化等级为16,本文主要针对场景中存在颜色相似干扰的情况下,计算参考目标区域与候选区域对应子块的Bhattacharyya 系数,根据其系数设定一个规则来融合色度颜色特征与Prewitt 梯度幅值特征,建立每个子块新的特征模型。该融合规则依据这两种特征在跟踪过程中所作的贡献度来进行加权融合,见公式(10):

式中,i 表示子块数;α 和β 分别是颜色和梯度在跟踪过程中所作贡献的权值,满足α+β=1,其贡献越大,权值越大;分别是色度概率模型和梯度概率模型。假定色度颜色特征的相似度系数为A,梯度幅值特的相似度系数为B,由于本文主要考虑场景为颜色相似干扰的情况,因此,在存在相似颜色干扰的子块,虽然该子块的颜色相似度系数较梯度幅值相似度系数大,但是颜色特征受到较大的影响,因而颜色所作贡献较小,在融合策略下,应该赋予较小的权值,则颜色权值α=B/(A +B),梯度权值β=A/(A+B)。

在这样的融合规则下获得每个子块新的特征模型,再将每个子块利用首尾相连的方法构建新的目标特征模型,最后,利用Mean Shift 目标跟踪原理估计最终位置信息以完成目标跟踪。

3.2.3 算法步骤

综上所述,本文提出融合Prewitt 梯度信息的分块均值漂移目跟踪算法具体计算过程如下:

步骤1:初始化跟踪目标,利用3.2.1 节分块处理的方法划分跟踪框,在其每个子块内提取颜色特征与梯度信息特征,并利用等贡献值来构建参考目标模型,记录当前帧的位置信息;

步骤2:将前一帧位置信息作为当前帧的位置信息,在候选区域内提取每个子块的色度颜色特征与Prewitt 梯度特征,计算目标区域与候选区域间每个子块的相似性程度,并根据相似性程度设定一个融合规则,融合相应子块的色度特征和梯度幅值特征,在此基础上,将各子块构建的新特征模型通过串接方式形成新的目标模型;

步骤3:依据均值漂移目标跟踪的迭代原理,记录目标在当前位置Y0移动到新位置的信息Y1;

步骤4:计算目标区域与新位置的相似性程度ρ1,比较ρ1和ρ0,若ρ1<ρ0,更新位置信息,转到步骤2,否则,进行步骤5;

步骤5:读取下一帧,并记录当前帧估计的目标位置信息Y1,并采用原始跟踪框大小进行锁定目标,转到步骤2。

4 实验分析

为了验证场景中存在背景干扰时本文算法的性能,本文采用的实验平台是Microsoft visual Studio 2012 结合开源opencv2.4.0;硬件平台为Intel(R)Core(TM)2 Duo CPU T6500@2.10GHz 2.10 GHz 处理器,2.00 GB 安装内存(RAM)。选用的跟踪对象存在背景干扰、姿态变化或相似颜色遮挡的视频,并与文献[5]进行实验对比,以此说明本文算法的有效性。

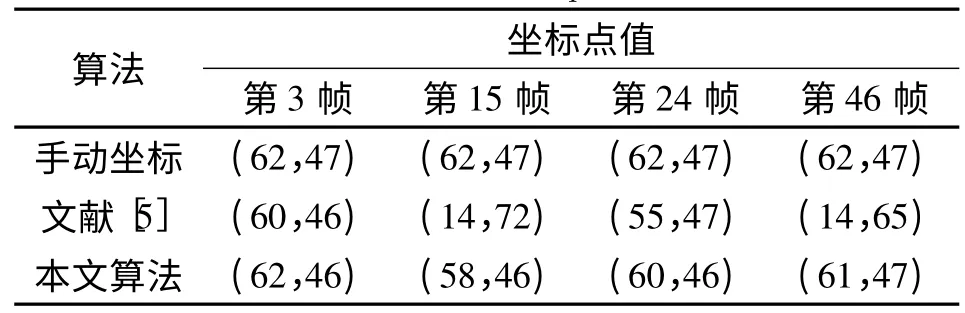

第1个视频图像序列的分辨率是128 ×96,共51 帧,所选的跟踪目标是人脸,选用的场景是利用自身手遮挡脸部位置,从右向左、在从左向右来回地在脸部位置前方移动。从左到右依次表示第3、15、24 以及46 帧的跟踪结果,图2 表示部分实验结果。

由于在跟踪人脸的过程中,人脸处于不移动的状态,但是出现了自身手遮挡人脸的情况,导致相似颜色的遮挡。虽然文献[5]采用了核函数来增加局部特征结构,但是颜色特征仍选用的是传统颜色,因此,文献[5]算法会产生巨大的偏差,甚至跟踪手的移动,跟踪框随之移动,导致丢失,见图2(a)所示。图2(b)表示本文算法,由于本文算法缩小跟踪框并采用能够表现结构特征的梯度信息在分块均值偏移原理下进行目标跟踪,由于未遮挡处在视频跟踪过程中所作的贡献度大,本文分块所做的作用即是表示每块跟踪相似性程度所得的权值大小不一,贡献越大其权值越大,可见本文算法能够有效跟踪目标,提高跟踪的准确度。

图2 第1个视频图像序列跟踪结果(从左到右依次是第3、15、24 以及46 帧)Fig.2 Tracking results of the first vedio sequence(they are frame 3,15,24 and 46 from left to right)

表1 和表2 分别是相应帧中心位置坐标点值及相应帧误差,表3 表示整段视频跟踪性能,由表可知,本文算法的准确度有所提高。

表1 第1个视频图像系列相应帧的中心位置坐标点值Table 1 Center coordinate point of the frame of the first video sequence

表2 第1个视频图像序列相应帧误差Table 2 Error of the frame of the first video sequence

表3 第1个视频图像系列跟踪性能Table 3 Tracking performance of the first video sequence

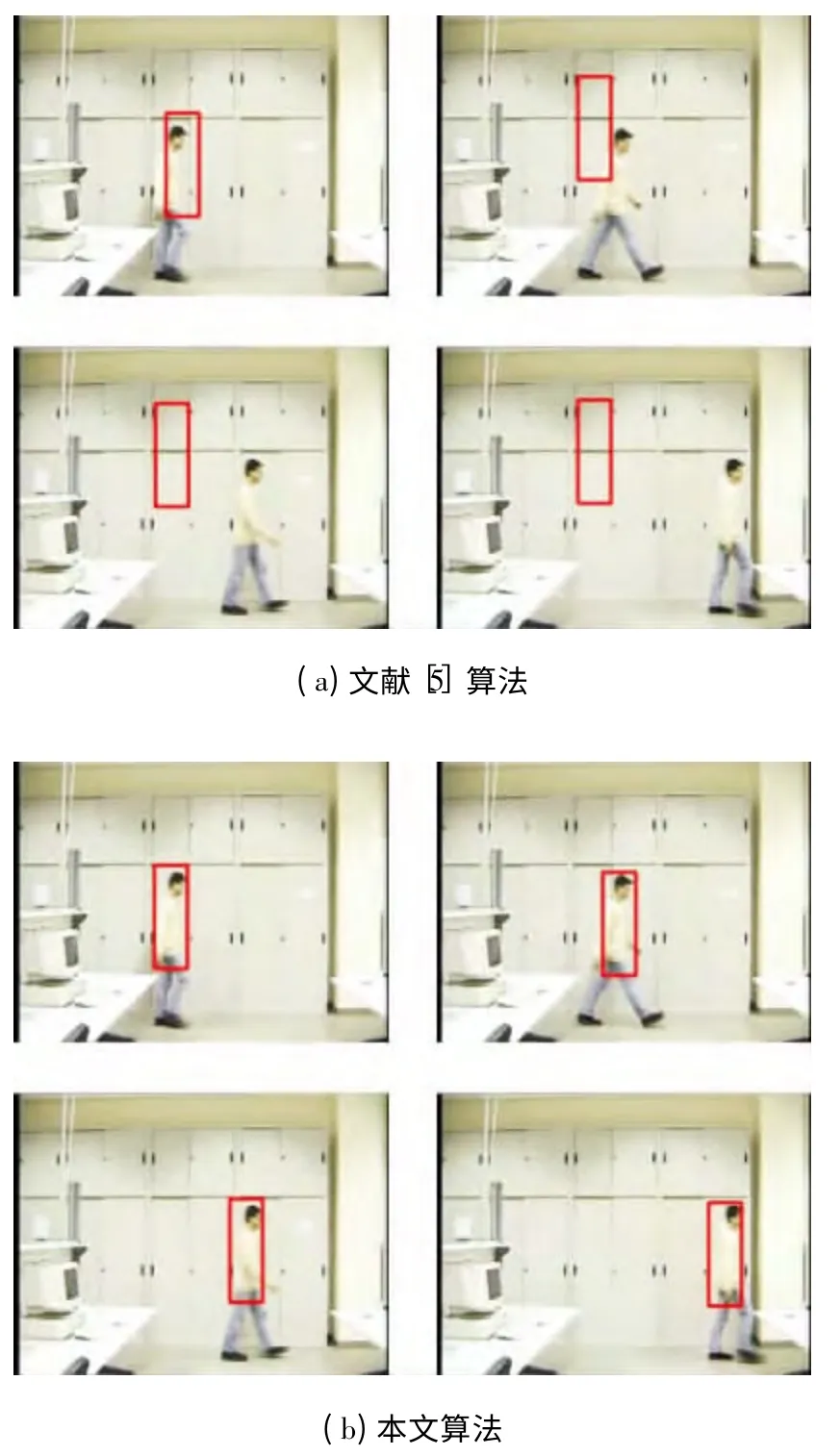

第2个视频图像序列的场景为室内环境下,截取整个视频的某一段视频部分作为实验分析部分,所感兴趣的对象时一个穿着颜色和背景颜色相似的人,部分实验结果选取了截取之后的第3、5、10 以及15 帧,如图3 所示。

图3 第2个视频图像序列跟踪结果(从左到右依次是第3、5、10 以及15 帧)Fig.3 Tracking results of the second vedio sequence(they are frame 3,5,10 and 15 from left to righ)

对比实验发现,由于文献[5]采用的传统颜色特征建模,忽略了目标颜色与背景颜色相似的影响,使得目标跟踪效果不佳,出现了偏差,甚至跟踪框与目标运动位置产生分离,使得跟踪丢失,见图3(a);本文算法在采用颜色信息建模的同时,提取了具有一定目标结构的梯度信息特征,使得在场景中存在背景颜色相似干扰时,可通过梯度特征到达对目标准确跟踪的效果,如图3(b)所示。表4 和表5 分别是相应帧中心位置坐标点值及相应帧误差,整个视频的跟踪性能见表6 所示。虽然计算复杂度增加了,但是由于目标特征表述的准确性,使得平均迭代次数减低,从而提高了时间效率。通过数据可以看出本文算法能够提高跟踪的准确度。

表4 第2个视频图像序列相应帧的中心位置坐标点值Fig.4 Center coordinate point of the frame of the second video sequence

表6 第2个视频图像序列跟踪性能Fig.6 Tracking performance of the second video sequence

5 结束语

本文针对当场景中存在相似颜色干扰时,文献[5]易导致目标跟踪产生偏差甚至丢失目标的问题,提出将分块和特征融合思想引入到MS 框架中。首先在跟踪框的长宽缩减为90%大小区域内,分成互不重叠的4个子块,并提取各子块的Prewitt 梯度特征和色度特征;其次,利用各子块的Bhattacharyya系数获得相应子块权值,并采用融合策略构造新子块特征,在此基础上,选择串接方式建立新特征模型;最后引入到MS 框架中实现目标跟踪。通过实验分析可知,在相似颜色干扰的情况下,本文算法较文献[5]的跟踪准确度提高了84%左右,在相似颜色干扰和遮挡的情况下,本文算法较文献[5]的跟踪准确度提高了72.1%左右,均能获得很好的目标跟踪效果。同时,由于目标表述的准确性,使得MS目标跟踪中迭代次数减少,因而提高了时间效率,可广泛适用于相似颜色场景中的目标跟踪。

[1]Yilmaz A,Shafique K,Sha H M.Target Tracking in airborne for ward looking in frared imagery[J].International Journal of Image and Vision Computing,2003,21(7):623-635.

[2]Chen K,Song K K,Kyoungho C,et al.Optimized meanshift target reference mo del based on improved pixel weighting in visual tracking[J].Journal of Electronics(China),2013,30(3):283-289.

[3]Fukunaga K,Hostetler L.The Estimation of The Gradient of A Density Function with Application in Pattern Recognition[J].IEEE Transactions on Information Theory,1975,21(1):32-40.

[4]Cheng Y Z.Mean Shift,mode secking,and clustering[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1995,17(8):790-799.

[5]Comaniciu D,Ramesh V,Meer P.Kernel-based object tracking[J].IEEE Transactions on Pattern Analysis and Machinee Intelligence,2003,25(5):564-575.

[6]董文会,常发亮,李天平.融合颜色直方图及SIFT 特征的自适应分块目标跟踪方法[J].电子与信息学报,2013,35(4):770-776.DONG Wenhui,CHANG Faliang,LI Tianping.Adaptive Fragments-based Target Tracking MethodFusing Color Histogram and SIFT Features[J].Journal of Electronics & Information Technology,2013,35(4):770-776.(in Chinese)

[7]顾幸方,茅耀斌,李秋洁.基于Mean Shift 的视觉目标跟踪算法综述[J].计算机科学,2012,39(12):16-24.GU Xingfang,MAO Yaobin,LI Qiujie,Survey on Visual Tracking Algorithms Based on Mean Shift[J].Computer Science,2012,39(12):16-24.(in Chinese)

[8]Adam A,Rivlin E.Shimshoni I.Robust fragments-based tracking using the integral histogram[C]//Proceedings of 2006 IEEE Conference on Computer Vision and Pattern Recognition.Los Alamitos:IEEE,2006:798-805.

[9]颜佳,吴敏渊,陈淑珍,等.应用Mean Shift 和分块的抗遮挡跟踪[J].光学精密工程,2010,18(6):1413-1420.YAN Jia,WU Minyuan,CHEN Shuzhen,et a1.Anti-occlusion tracking algorithm based on Mean Shift and fragments[J].Optics and Precision Engineering,2010,18(6):1413-1420.(in Chinese)

[10]倪琦,贺明,张国进,等.基于多特征融合的Mean Shift 跟踪算法[J].强激光与粒子束,2014,26(10):147-151.NI Qi,HE Ming,ZHANG Guojin,et a1.Tracking algorithm based on multi- feature fusion Mean Shift[J].High Power Laser and Particle Beams,2014,26(10):147-151.(in Chinese)

[11]丁业兵,李敬仕,方国涛,等.多特征连续自适应均值漂移人脸跟踪算法[J].计算机应用,2014,34(S2):276-279.DING Yebing,LI Jingshi,FANG Guotao,et a1.Multi-feature face tracking algorithm with continuously adaptive mean shift[J].Journal of Computer Applications,2014,34(S2):276-279.(in Chinese)

[12]张红颖,胡正.融合局部三值数量和色度信息的均值漂移跟踪[J].电子与信息学报,2014,36(3):624-631.ZHANG Hongying,HU Zheng.Mean Shift Tracking Method Combing Local Ternary Number with Hue Information[J].Journal of Electronics & Information Technology,2014,36(3):624-631.(in Chinese)

[13]姚原青,李峰,周书仁.基于颜色-纹理特征的目标跟踪[J].计算机工程与科学,2014,36(8):1581-1588.YAO Yuanqing,LI Feng,ZHOU Shuren.Target tracking based on color and the texture feature [J].Computer Engineering and Science,2014,36(8):1581- 1588.(in Chinese)

[14]Comaniciu D,Ramesh V,Meer P.Real-Time Tracking of NonRigid Objects using Mean Shift[C]//Proceedings of 2000 International Conference on Computer Vision and Pattern Recognition.Columbus,OH:IEEE,2000:142-149.

[15]Prewitt J M S,Mendelsohn M L.The Analysis of Cell Image[M].New York:Academy Science1966:1035-1053.