新型数据中心动力系统的研究和应用

2015-12-12李志锋刘文飞何其振

王 旭,李志锋,刘文飞,何其振

(中国移动通信集团南方基地,广东 广州 510640)

新型数据中心动力系统的研究和应用

王旭,李志锋,刘文飞,何其振

(中国移动通信集团南方基地,广东 广州 510640)

摘要:随着信息和互联网业务的迅速发展,国内外数据中心产业进入了快车道。数据中心部署着以动力系统为主的大量的基础设施,但传统技术和粗放的建设模式带来了投资、运维和能效等方面的低效率。为解决"高效率、高可靠、低成本"的瓶颈,文中通过研究供电、供冷系统的结构和工作原理,提出了一种新型的数据中心动力系统模式,并搭建试验机房和测试平台,验证了该模式的可行性。

关键词:数据中心;动力系统;高压直流;热传导;高效

0 引 言

随着企业和个人对互联网的需求增加,我国互联网、云计算和大数据产业加速发展,数据中心产业进入了大规模的规划建设阶段。高速发展的数据中心带来了巨大的能耗投入,已成为影响数据中心产业高效低成本运营的瓶颈。

2006年Christian Belady提出能源利用率(PUE)的概念,至今PUE已发展成为一个全球性的数据中心能耗标准。

PUE数值越小,表示数据中心的能源利用率越高,越符合低碳、节能的标准。

1 数据中心动力系统概述

1.1 系统构成

数据中心按照逻辑功能划分为机房设施系统、网络系统、资源系统、业务系统和管理系统[1],其中机房设施系统为数据中心提供机房、供电、空调、消防、安防、布线等。数据机房的动力系统属于机房设施系统,提供电力、冷却功能。

1.2 供电系统概述

1.2.1系统原理

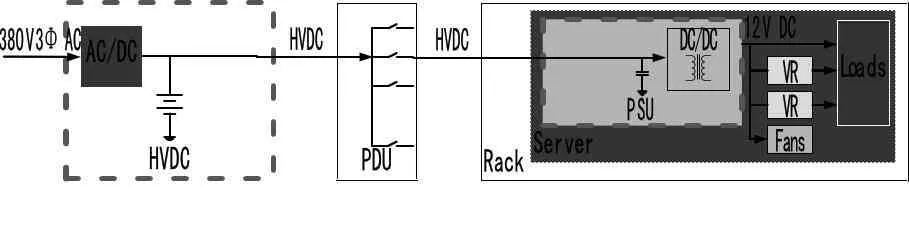

数据中心供电系统通常由输电、变电、配电、电源、机柜配电和服务器电源构成。实际工作中大部分机房直接引入380 V交流市电。为方便对比和研究,本文机房供电系统从机楼配电为起点,以服务器电源为终点进行讨论,如图1。

图1 机房供电系统组成

市电经过机楼配电进入楼层,由不间断电源(UPS)将380 V三相交流电整流为标称电压为384 V/480 V的直流电,分别供给蓄电池和逆变器,再转换为三路220 V单相交流电,经机柜配电单元(PDU)分配给服务器电源,最后再次经过整流和降压转换为12 V/5 V/3.3 V直流电源。

1.2.1能耗表现

传统电力损耗主要集中在远距离输电、变电上,而机房供电系统则以配电损耗(机楼配电、列间配电)、不间断电源损耗(IGBT整流、逆变、控制电路、隔离变压器)和谐波损耗(引起的线损和变压器额外损耗等)为主。其中不间断电源设备的损耗占绝大部分。

以最常见的UPS为例,其运行效率和负载率存在经验关系。UPS运行效率与负载率相关,并且低于某负载率后,效率突然下降,而在负载率>40%情况下,效率较高,约为92%。

以典型的2N结构电源拓扑为例, UPS单机负载率要求不大于25%,对应的运行效率约为85%,即使采用高频UPS等高效电源,其运行效率仍然在90%左右,即每100 kW的IT设备负载运行中,约10 kW电能额外消耗在了电源系统上。

1.3 空调系统概述

1.3.1系统原理

机房空调分为风冷和水冷两大类,小型机房专用空调多为风冷型,而具备一定规模的IDC数据中心多采用冷冻水式中央空调机组。

整个空调系统除了压缩机做工外,还经过了冷却水冷却、制冷剂冷凝、制冷剂蒸发、风柜降温四个热交换过程。另外,服务器自身通过风冷,将内部热量散发至机房空间。

1.3.2能耗表现

有关数据显现,数据中心能耗占比中空调系统能耗在数据中心总能耗中排名第二位,占40%左右,所以,从空调系统方面开展节能降耗就成为数据中心节能卓有成效的路径之一。以某运营商数据中心为例,业务生产机楼空调耗电量占比约为32%:冬季占比30.4%(2014年1月统计数据);夏季占比34.2%(2013年8月统计数据)。对比当前业内IDC空调能耗占比40%的平均水平具有优势,但仍存在较大的优化节能空间。

数据中心对服务器的冷却方式均采用传统的“空气冷却”,即首先冷却服务器机房的环境,使服务器机房的环境温度保持在19~25 ℃内,然后通过服务器的风扇将冷空气吸入,进一步降低服务器内电子元器件的温度。由于空气的比热和热传导率均低于水,所以单纯依靠风送冷散热,效率低,能耗大,机房CLF(数据中心中空调制冷系统耗能与IT设备耗能的比)值高。同时,由于设备元件发热不均衡、散热不精准,数据中心机房也面临着热岛效应、功率密度难以提高等诸多问题。

2 绿色动力系统研究

2.1 高压直流-交流混合供电系统

不间断电源设备自身能耗主要分为三类:空载损耗、比例损耗和平方损耗。空载损耗是指在0负载下UPS变压器、电容、控制电路、通讯电路等设备的固定损耗,与负载率无关,约占UPS损耗的40%以上;比例损耗主要随负载的增长成比例增长,由晶体管的开关、整流器的导通等损耗组成;平方损耗则是指随电流增长而增长的“I2R”损耗。

根据前文阐述的供电系统结构,电能在配电后端经过整流、逆变、整流、降压等多个环节由380 V交流变为12 V/5 V/3.3 V直流供给服务器各部件所需。由于冗余和负载率限制,电源工作在低效工况下。要提高供电系统效率,应从减少系统空载损耗、精简转换环节入手。

(1)高压直流

直流电网在1887年前仍然占主导地位,但自从乔治·威斯汀豪斯的西屋电气开始远距离传输交流电后,直流电网供电渐渐退出。数据中心供电系统存在着大量的交直流转换,服务器主要部件最终需要直流电。

系统中UPS直流母线常见标称电压为384 V(运行电压为432 V),服务器PSU升压斩波电路输出母线电压为400 V左右(与UPS直流母线电压相当),再经DC/DC变换至12 V输出。如果将逆变器移除,并简化服务器电源,得到如图2所示系统。

图2 简化了的直流供电系统一

UPS和HVDC供电系统对比如表1。

表1 UPS和HVDC对比

通过服务器电源定制化,可将PSU迁移至机架,与机架PDU集成后集中向服务器供给12 V直流电源,形成系统如图3。

机架电源的集中管理将PSU归入数据中心电源系统范畴,动力系统管理人员担负起PSU的运维,能够更加清晰地认识末端负载的运行情况,而业务系统运维人员也能够更加专注于自己的领域。

(2)电池组降容

在市电异常时数据中心不间断电源能提供毫秒级的应急电源切换能力,同时保证主后备电源启动前提供负载临时供电。所以与基站电源不同,数据中心往往配备了固定柴油发电机作为主后备电源,UPS/开关电源所承担的任务不再是提供数小时的通信电力供给,而是填补柴油发电机启动和市电恢复需要的短时供电切换间隙。

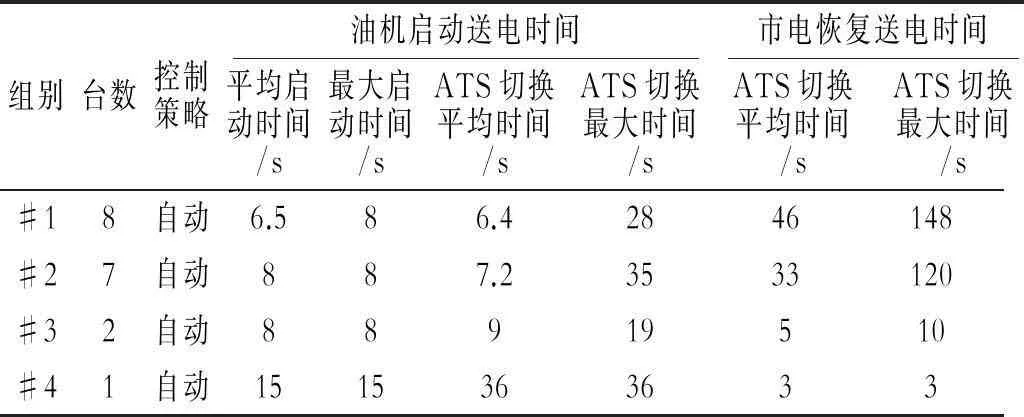

对某数据中心发电机组进行带载启动和恢复测试,得到数据如表2。

表2 发电器启动测试

根据柴油发电机组启动和市电切换的测试结果,并考虑到设备性能的差异性和维护人员在应急预案执行过程中熟练度,蓄电池10~15分钟容量配置完全可满足切换需求。根据蓄电池放电率/放电时间曲线,15分钟容量配置需要蓄电池组提供1~2C10倍率的放电电流。短时间大电流放电对蓄电池大电流放电能力提出了一定的要求,且超过30%的放电深度对蓄电池的寿命也造成影响。

铁锂电池的应用将会满足这样的发展趋势,可以2C10的电流充放电,最大可达到3C10。经试验,常温1C10充放电情况下,单体2 000次循环后容量仍大于80%,且能正常工作在55 ℃的外部环境下[2]。

蓄电池组降容对于建设投资和运维成本的降低直接而有效,包括系统投资轻量化,日常维护和周期性深度维护人工成本降低。同时节约大量的机房空间和电源系统充电功率占用的容量空间,间接提高了电源系统的可用率。

(3)混合供电

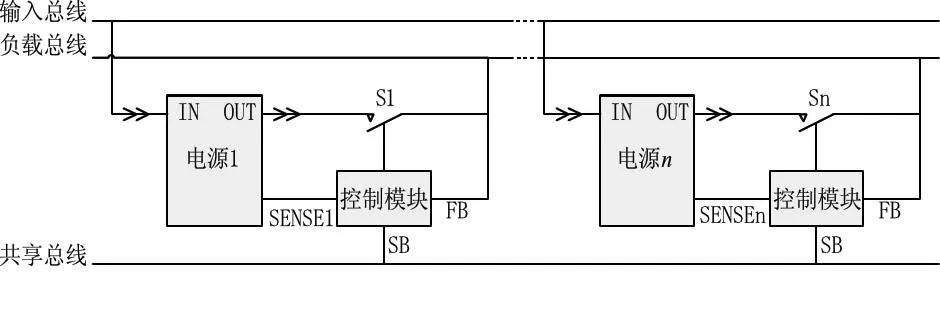

为保证电力供应的可靠,服务器自身形成了双电源冗余的供电结构如图4,还有一些服务器采用4个电源模块供电。

图4 服务器冗余电源结构

输入总线220 V,负载总线12 V,输出控制模块通过共享总线分配各自的输出功率,从而保障在单路故障时服务器工作不受断电影响。

服务器自身冗余电源的工作方式缓解了前端供电系统的冗余要求,即如果上级供电电源来自两个不同系统,两个系统不会或者极小可能同时发生故障,那么这两个供电系统并不需要部署成一模一样,可以尽可能发挥不同供电系统的特长,如一种供电方式在经济性上效果明显,而另一种在供电可靠性上占据优势。

高压直流技术、UPS技术大大提高了供电系统可靠性,虽然效率不断提高,但交直流转换难以克服功率器件不断通断过程中的各种损耗。交流市电直接供电又不能完全可靠,一类市电全年供电可用率>99.9 315%,全年<6 h的供电中断对于数据中心重要业务也是难以承受的。

市电直供和电源供电结合形成的系统如图5。

图5 交直流混合供电系统可靠性示意图

高压直流市电直供混合供电系统中,直流系统(48 V/240 V)在采用N+1的配置下,供电可靠性达到99.99 999%[3],中国移动的336 V标准仅电压等级不同,可靠性上几乎没有区别。而2013年广东省城市用户供电可用率为99.968%[4]。那么负载端供电系统可用率将达到8个9。

能耗方面,系统工作在交流市电主用、高压直流热备的运行方式下,正常情况下供电系统的电能损耗仅存在高压直流设备的静态损耗。而两套同样的高压直流设备组成的2N结构系统,其可用率仅提高了不到百亿分之1,但需要多一倍的电源投资,多占用一倍的机房空间资源,而且在后期的维护过程中,产生更多的人工、设备维保费用。

GreenGrid将服务器电源功耗划入IT设备总功耗[5],因为服务器电源损耗测量上存在困难。但其实高压直流技术为更高效的服务器电源策略提供了条件。

高压直流供电给服务器电源改造提供了可能,服务器电源经过PFC的Boost电路或者全桥变换器输出400 V左右的直流电,再经过DC/DC将电压转换为12 V输出。那么如果采用336 V高压直流供电技术,实际运行电压为378 V左右,完全可以将PFC的AC/DC模块精简,直接连接至DC/DC输入母线,从而进一步简化供电回路,降低了整个供电系统转换损耗。

2.2 散热系统

(1)机房热源

一台标称功率300~400 W的服务器,CPU功耗可以达到260 W左右,所以服务器80%的热量来自CPU。目前数据中心大量服务器机房采用精密空调或者风柜制冷,空气作为导热介质分别与服务器发热原件热交换,再和空调翅片进行热交换,散热目标不明确,导热效率明显较低。

如果能够改变原有“既冷环境,又冷设备”的高能耗、粗放式冷却模式,使服务器设备80%以上的热量直接通过有效散热方式导出室外,整体降低数据中心30%的能耗,同时有效解决机房热岛和功率密度低等问题。

(2)精确散热

数据中心散热系统以精确导热、直接换热、高效散热为目标,所以出现了通道隔离技术、水冷背板技术等。抛弃传统的设备热量完全通过机房环境散热,采用热管、水/制冷剂为介质,通过高效换热器件,形成热量通道,直接传导至室外,利用自然冷源散热。

通过“热管+液体冷却”方式将服务器主要元器件(CPU、DDR、硬盘等)的热量带到室外,主要是通过热管将服务器主要元器件热量传导至液体载冷剂,再由液体载冷剂将热量带到室外。由于服务器主要元器件温度较高(50~70 ℃),已经远高于夏季最高室外空气温度(广东夏季约35 ℃),所以通过大温差并利用热传导方式可以实现数据中心芯片级高效散热。

服务器主要部件(CPU)热量由热管传热至热管换热模块,换热模块内部与纯净水热交换。

内循环纯净水与外循环冷却水组成二级换热,服务器热量经纯净水带出机架,在板式换热器中与室外冷却水循环热交换。

由于核心发热量被排除,系统整体能效得到大幅提升:一是机房环境温度阈值可提升;二是机架功率密度可提升; 三是由于热传导系统动力能耗低,可以有效降低机房空调系统能耗。

3 绿色动力系统的应用

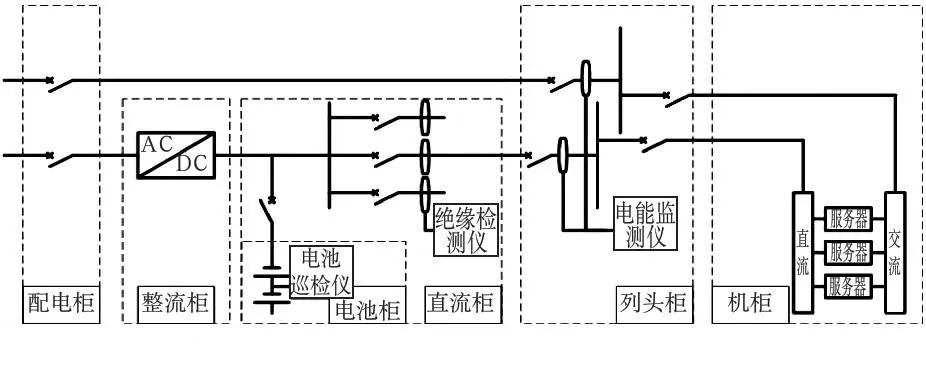

根据以上分析,本文搭建了一套试验系统如图6,设计容量为60 kW的IT设备,目前装机约20 kW(部分假负载)。

图6 绿色动力系统试验机房建设模型

3.1 供电系统

如图7所示,供电系统采用市电直供(主用)+高压直流(备用)混和供电,正常情况下仅存在高压直流静态功耗和蓄电池组的浮充功耗。

图7 市电直供+高压直流混合供电系统结构图

应用中部署了90 kW的高压直流设备(含充电功率),200 Ah蓄电池组保证约15分钟的紧急供电支撑。

服务器电源采用交直流通用电源,输入范围交流100 V~240 V/50~60 HZ,直流240 V/5 A。

3.2 散热系统

(1)服务器散热

在环境温度为30 ℃左右、水流量为0.5 L/min的条件下,采用冷却水散热,目标将CPU内核温度控制在70 ℃以内的安全温度,如图8。

图8 服务器散热系统

(2)机房散热

热量从服务器热管导出后,经内循环水路汇集,通过板式换热器与外循环水路进行热交换,然后送至室外冷却塔散热,水路动力由2台水泵提供动力,如图9。

图9 机房散热系统

3.3 监控系统

(1)监控对象

为了开展测试,监控系统部署了大量的传感器、智能仪表,主要监控内容如表3。

表3 监控数据

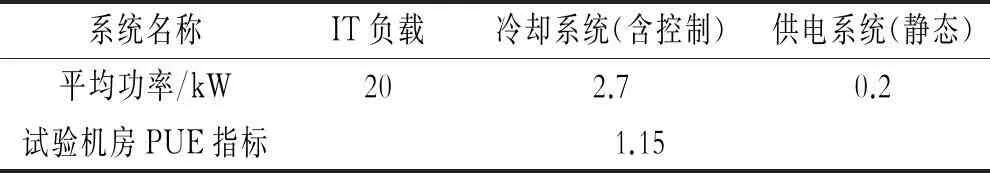

(2)测量结果

经测量,当前室外环境下,CPU保持在50 ℃以下,内存温度在60 ℃以下,机房整体运行在PUE=1.2左右,基本达到了设计目标。由于目前IT负载仅为20 kW左右(设计值的30%),预计IT负荷达到设计目标60 kW时,有更佳的能耗表现。

a.可靠性表现

利用SPECPOWER对服务器CPU进行100%压力测试(不间断运行时间约7~8 h),取一天的早中晚三个时间点的测量数据(取一天中温度较高的时间段),如表4。

表4 不同时间点CPU的环境数据测量

b.能效表现

测试时机房作为封闭环境,测试期间室内温度基本维持在30 ℃以内,4机架中间配置的精密行间空调处于备用状态,未达到辅助制冷门限。这种情况下的能效数据如表5。

表5 封闭环境下机房的能效数据

考虑到装机负荷提高后,服务器部分元器件也有一定的散热需求,届时启用辅助空调冷却,PUE值会略有上升,估算指标将维持在1.2~1.3。

4 结 论

本课题针对新型数据中心绿色动力系统,从供电系统、散热系统和监控系统三个组成部分论述了目前数据中心、数据机房在能耗上存在的一些问题;同时展开了理论分析和研究,提出了交流市电直供+高压直流混合供电模式、基于热传导技术的机房散热技术和更加主动的动环监控系统;最后将研究结果在试验机房实现,建成了一套小型的试验平台,经过初步的测试验证,达到了预期目标。

参考文献:

[1]YD/T 5193-2010.互联网数据中心(IDC)工程设计规范[S].2010.

[2]乔健,李志华. 铁锂电池在机房备电系统中的应用[J]. 2014 ,31:110-112.

[3]李典林. 数据中心的高压直流之路[Z].腾讯计算机系统网络平台,2012.

[4]中华人民共和国发改委经济运行调节局. 南方电网着力加强城市供电可靠性管理取得积极成效[EB/OL]. http://yxj.ndrc.gov.cn/gjyx/dl/201406/t20140624_616196.html.

[5]Harmonizing Global Metrics for Data Center Energy Efficiency[Z]. March 13 2014.

设计应用

Study and Application of a New Datacenter Power and Cooling System

WANG Xu, LI Zhi-feng, LIU Wen-fei, HE Qi-zhen

(Southern Base of China Mobile Communication Group, Guangzhou 510640, China)

Abstract:With the rapid development of information and Internet services, development of datacenter industry speeds up at home and abroad. There are large amounts of infrastructure in datacenters, mainly consisting of power and cooling system. But traditional technique and rough construction mode bring over low efficiency in aspects of investment, operation and maintenance and energy utilization. To solve the problem, this article presents research on structure and principle of power and cooling system, and then introduces a new model of them. A testing system is built and verifies the feasibility of the theory.

Key words:datacenter; power and cooling system; HVDC; heat transmission; high efficiency

中图分类号:TN86

文献标识码:A

文章编号:1009-3664(2015)02-0055-05