基于边权重的主题核心术语抽取

2015-05-30薛涵秦兵刘挺

薛涵 秦兵 刘挺

摘 要:术语抽取是层次体系构建的首要子任务。目前的术语抽取研究主要集中在文本语料并且混合多个主题,存在知识获取的瓶颈和术语表述的模糊与歧义的问题。为了解决这些问题,本文提出一种基于边权重的主题核心术语抽取方法,从社会化标签中抽取主题核心术语。考虑到社会化标签丰富的语义关联特征,本文提出结合具体主题的局部共现和资源集合中所有主题的全局语义相似度的边权重。新颖的边权重将传统的随机游走方法分解成多个主题相关的随机游走,并针对每个具体主题排序相关的候选术语。排序靠前的术语被抽取作为主题核心术语。实验结果表明本文提出的方法显著优于前人的相关工作。

关键词:术语抽取;社会化标签;主题核心术语抽取;主题相关的随机游走

中图分类号:TP391 文献标识号:A

Topic Key Term Extraction based on Edge Weight

XUE Han1,2, QIN Bing1, LIU Ting1

(1 School of Computer Science and Technology, Harbin Institute of Technology, Harbin 150001, China;2 Library, Harbin Engineering University, Harbin 150001, China)

Abstract: Term extraction is a primary subtask of hierarchy construction. Existing studies for term extraction mainly focus on text corpora and indiscriminately mix numerous topics, which may lead to a knowledge acquisition bottleneck and misconception. To deal with these problems, this paper proposes a method of topic key term extraction based on edge weight to extract topic key term from folksonomy. In view of semantic association characteristics of folksonomy, the edge weight which combines the local co-occurrence in a specific topic with the global semantic similarity over all the topic dimensions in the whole collection considered is proposed. The new edge weight can decompose a traditional random walk into multiple random walks specific to various topics, and each of these walks outputs a list of terms ordered on the basis of importance score. Then, the top-ranking terms are extracted as the topic key terms for each topic. Experiments show that the proposed method outperforms other state-of-the-art methods.

Keywords: Term Extraction; Folksonomy; Topic Key Term Extraction; Topic-Sensitive Random Walk

0 引言

作为层次体系构建的第一步,术语抽取是一项重要的子任务[1]。核心术语通常定义为可以概括语料所蕴含语义主题内容的一系列术语。语料往往包含多个主题,其中每个术语对于不同的主题会表达不同的含义。多个主题的共有术语在不同主题的重要性往往不同。混合主题衡量术语的重要性可能会导致某些不太常见或者新涌现出的主题核心术语无法被识别出来。例如,“牛仔”在“西部”主题中是核心术语,而在其他主题中则是非核心术语。混合多个主题构建的单一层次体系容易导致不同主题共有术语的模糊和歧义问题,在同一个层次体系中用完全不同的含义定义同一个术语是不准确的,然而忽略其中任何一个含义会导致无法完整诠释术语的含义。为此,本研究提出抽取主题核心术语,即根据从语料中学习得到的具体主题,抽取能够较好地概括和描述该主题的内容并与此主题下其他非核心术语密切相关的术语。例如,电影领域的主题核心术语通常有“喜剧”、“科幻”、“传记”等。主题核心术语抽取是许多自然语言处理任务的基础,例如,信息检索和导航、问答、推荐系统等。

目前核心术语抽取研究主要基于领域文本语料,但是发现能够准确描述专业性较强或者主题变化较快的文本语料并非易事[2]。即便可以,人工遍历所有的文本语料并且随时跟踪所有新出现的主题也几乎是不可能完成的任务。例如,对于常见的电影主题“喜剧”来说,找到形式化定义和描述“喜剧”主题的文本语料相对容易,但是对于不太常见的主题“Cult”,发现类似的文本语料则相对困难。但是,标签却可以用“Cult”、“非主流”、“小成本”等自然语言词汇更加轻松、自由地定义这样的主题。正因为如此,一些研究者开始探索和尝试使用社会化标签这种新兴的语料。社会化标签[3]允许拥有不同专业知识的大量互联网“草根”用户使用任意词汇(标签)自由标注感兴趣的资源并与他人分享,由于技术门槛低、用户易于使用,因此蕴含着丰富并且及时的互联网大众语义知识。互联网用户通过标注、分享标签,浏览他人标签的过程,形成异步反馈并逐渐达成共识。在这个过程中产生了丰富的显式和隐式关联。显式关联存在于通过标签关联的资源和用户之间,隐式关联存在于拥有相同兴趣或社区的用户之间,以及共享相同标签或者用户的资源之间。在资源、标签、用户三者之间的显式和隐式关联提供了潜在有价值的语义信息。标签作为候选术语,已经被广大用户人工抽取出来,从而避免了一系列自然语言处理任务如分词、词性标注、句法分析等。可见,社会化标签相对于由少量领域专家编撰和更新的文本语料来说能够克服知识获取的瓶颈。但是,从社会化标签中抽取主题核心术语至少面临两方面的挑战。第一,社会化标签仅仅按照出现频率简单排序并未区分主题。第二,标签由于大众标注的随意性和模糊性,质量差异很大。为了克服这些挑战,研究需要识别出主题,并按照主题排序和抽取出主题核心术语。

鉴于此,本文提出基于边权重的主题核心术语抽取方法。考虑到中文语法的复杂性和可用研究资源不足的问题,尝试从中文社会化标签数据出发开展研究,一来可以丰富中文研究资源和成果,二来可以体现社会化标签缓解知识获取瓶颈的优势。需要说明的是,提出的研究方法虽然基于中文数据源,但是无监督而且语言无关的,可以应用于更广泛的语料和其他任何语言。具体地,研究首先通过LDA模型,从社会化标签数据中发现隐含的主题,并学习得到候选术语的主题分布。然后,分析社会化标签的语义关联特征,提出由具体主题的局部共现信息和所有主题的全局语义相似度共同构成的边权重。进而,通过边权重改进PageRank[4]方法,将传统的随机游走方法分解成多个主题相关的随机游走,并针对每个具体主题排序相关的候选术语。最后,抽取排在最前面的候选术语作为主题核心术语。据现有成果所知,本研究工作在中文层次体系构建领域尚属首例。本文研究对方法进行较详细的分析,希望对此方向的未来研究有所助益。

1 基于边权重的主题核心术语抽取

基于边权重的主题核心术语抽取方法的核心思想是通过边权重的设计,将主题信息融入候选术语的重要性值传播。首先,可从社会化标签抽取资源集合S和标签集合(候选术语)V。由于标签反映了大众对资源的认识,在此仅仅将用户集合U的标签按照资源 组织成文档。然后,给出假设资源集合S存在主题集合Z,每个候选术语 属于多个语义主题,并且在不同主题下重要性不同。进而,研究从资源集合中识别出主题。对于每个主题,根据候选术语的主题分布,计算结合局部和全局语义相似度的边权重,并建立主题相关的候选术语组成的图(见第1.1节)。随后,再将一个传统的随机游走方法分解成多个主题相关的随机游走,并针对每个主题根据重要性值对候选术语排序(见第1.2节)。最后,排序靠前的术语被抽取出来作为每个主题的核心术语。

1.1 主题识别

本文选择使用无监督的机器学习技术从资源集合中识别出主题并获得每个候选术语的主题分布,而不是已标注的语义知识库(如,WordNet),因为其中的词汇并不能很好地覆盖社会化标签。机器学习中的隐含主题模型能够根据语料中词的共现信息推断隐含的主题。LDA[5]是隐含主题模型的代表,其中文档d中的每个词w的产生,是通过首先从d的主题分布θ中取出主题z,然后,从词的分布Ф中取出能代表主题z的词。θ和Ф分别来自共轭狄利克雷先验α和β。在此使用资源集合S作为LDA模型的输入,其中每个资源是由用户集合U对其打出的标签组成的文档。通过LDA,对于给定主题 ,则通过公式(1)获得每个候选术语 的主题分布 。

(1)

进而,又通过公式(2)和(3)分别计算出候选术语之间的局部和全局语义相似度。

(2)

(3)

代表候选术语wi和wj之间的局部语义相似度(见公式(2)),反映了候选术语对于具体主题的局部共现信息。其中, 计算为候选术语wi和wj在同一个资源 中共现并且属于同一个主题z的次数。 计算为候选术语wi和wj在同一个资源 中共现的次数。 代表候选术语wi和wj之间的全局语义相似度,通过将公式(1)代入公式(3)计算得到,定义为两个候选术语wi和wj在整个资源集合S中所有主题维度上的余弦相似度,反映了候选术语对于整个主题集合的全局语义相似度。

1.2 术语排序

PageRank[4]是计算网页重要性的著名图排序算法,也可以用于计算术语的重要性。如果有边存在于节点wi和wj之间,研究就用节点集合 和边集合 组成图 。其中,每个节点代表一个术语,每条边说明连接的两个术语的相关关系,wi和wj之间边的权重定义为 ,节点wi的出度定义为 。在PageRank中,词wi的重要性值通过迭代地运行公式(4)直到收敛获得。其中,衰减因子λ的取值范围为0到1,|V|是节点数。衰减因子说明每个节点有(1-λ)的概率随机跳转到图中的其他节点,同时有λ的概率随出度边跳转到相邻节点。

(4)

然而,传统的PageRank算法仅为每个术语保留唯一的重要性值。为了能够按照主题排序,传统PageRank的随机游走被分解成多个主题相关的随机游走,目的就是将术语的重要性值分解成与主题相关的重要性向量,准确记录术语对于不同主题的重要性。相关工作主要有Liu等人提出的方法[6]MTPR,主要思想是对于每个主题分别运行有偏好的PageRank算法,将公式(4)中第二项统一的随机跳转改为主题相关的随机跳转概率即偏好值 ,且 ,从三种备选中最终确定为 。对于主题z,MTPR计算候选术语的主题重要性值如公式(5)所示。其中,边权重 定义为两个候选术语在固定窗口大小中的共现次数。

(5)

Zhao等人的方法[7]McTPR认为与主题背景知识无关的传播会导致重要性值偏离主题,因而,基于MTPR的工作,进一步在边权重的设置上用与主题相关的背景知识建模重要性值传播,如公式(6)所示。其中,边权重 定义为两个候选术语在同属于主题z的微博中共现的次数。

(6)

受到前人相关工作的启发,研究认为在PageRank算法的边权重中融入主题信息能够将传统的随机游走分解成多个主题相关的随机游走,考虑到社会化标签丰富的显式和隐式关联特性,文中提出MeTPR方法,通过新颖的边权重如公式(7)所示,进一步改进主题相关的随机游走方法。

(7)

其中,权重因子ρ控制公式(2)表示的局部语义相似度和公式(3)表示的全局语义相似度两者的比重。通过新的边权重,主题术语的重要性传播不仅反映出两个术语在具体主题下资源组织结构上的局部共现信息,还反映出两个术语在所有主题下整个资源集合上的全局语义相似度。相应地,将公式(7)代入公式(6),迭代运行MeTPR直到收敛,得到为每个术语计算的主题相关的重要性值。最终,排序靠前的术语被抽取出来作为主题核心术语。

2 实验及分析

2.1 实验设置

研究从豆瓣电影网站收集实验所需的数据,豆瓣电影是一个流行的中文社交网站,允许注册用户提交与电影相关的信息,并与他人分享。实验获取截止到2012年6月,豆瓣电影网站用户对豆瓣Top250的电影打出的标签信息,共计1760个标签。经过去除停用词和噪声等预处理,最终获得1 737个标签作为候选术语。根据数据集的规模和人工经验的判断,实验中尝试10到100之间不同主题数目的设置学习LDA模型,并最终选择将初始主题数目设定为40。然后,随即运行LDA算法,并每隔1 000次迭代进行Gibbs取样一次。接着,在同样的数据集上将我们的方法与前人相关工作做比较。

(1)MTPR 代表Liu等人的方法[6],边权重计算为两个候选术语在同一个资源中共现的数目 ,偏好值通过公式(1)得到,候选术语对于不同主题的重要性通过迭代地运行公式(5)直到收敛后得到。

(2)McTPR 代表Zhao等人的方法[7],边权重计算为两个候选术语在同一个资源中共现并且属于同一个主题的数目 ,偏好值通过公式(1)计算得到,候选术语对于不同主题的重要性通过迭代地运行公式(6)直到收敛后得到。

(3)MeTPR 代表本文提出的方法,边权重和偏好值分别通过公式(7)和(1)计算得到,候选术语对于不同主题的重要性通过迭代地运行公式(6)直到收敛后得到。

研究中,终止运行上述方法的条件是仅当迭代次数达到100或者候选术语在相邻两次迭代中的重要性值差异小于0.000 001。有三个参数影响主题核心术语抽取方法,包括(1)衰减因子λ,用于对比方法中调节重要性传播通过出度边跳转到相邻候选术语(公式(5),(6)中的第一项)和随机跳转到任意候选术语(公式(5),(6)中的第二项)之间的比重。(2)权重因子ρ,在MeTPR中应用于边权重(公式(7)),用于控制两个候选术语之间的关于具体主题的局部共现和所有主题的全局语义相似度之间的比重。(3)阈值Q。当把Q应用于MTPR,McTPR,MeTPR三种方法时,如果两个候选术语之间的全局语义相似度小于Q,有针对地将移除这对术语之间的边。并且分别设定参数λ,ρ,Q的取值范围为从0.1到0.9,步长为0.1,这样每个参数就有9种候选取值。经过三个参数的排列组合,相应地就分别得到以上对比方法的729组实验结果。

2.2 评价标准

评价标准通过Pooling方法[8]构建完成。首先,社会化标签中不存在主题核心术语抽取的黄金标准;第二,人工识别出所有主题,并判断主题核心术语是不可能完成的任务。为此随机混合对比方法MTPR,McTPR,MeTPR的所有实验结果,并要求两个标注者独立标注。如果抽取结果中给出的是与具体主题相关的、较为抽象的、具有代表性的候选术语,就标注为1;否则,如果抽取结果中给出的是与具体主题不相关的,或者缺乏代表性、太过于具体的候选术语,就标注为0。仅当两个标注者都标注为1的候选术语才被认为是正确的主题核心术语,其他情况的候选术语均被认为是错误的结果。以“致我们终将逝去的青春”为例,对于这部电影和同类型的其他相关电影所属的主题来说,正确的主题核心术语可能是“青春”、“校园”、“爱情”等,而“2013”(上映时间)和有关电影具体属性的其他候选术语,如导演、演员等,在本文任务的评价中均应被标注为0。最终,将两个标注者共同认可的主题核心术语集合作为基于边权重的主题核心术语抽取任务评价的黄金标准(Kappa值为0.95)。

研究对主题核心术语抽取任务的评价策略包括经典的精确率(Precision)、召回率(Recall)、F1值(F1)(见公式(8)),以及两个考虑顺序的评价策略包括平均准确率(MAP:Mean Average Precision)(见公式(9))和平均排序倒数(MRR:Mean Reciprocal Rank)(见公式(10))。

(8)

其中, 代表通过某种方法抽取的正确主题核心术语的数目, 代表通过某种方法自动抽取的主题核心术语的总数, 代表根据黄金标准得到的主题核心术语的总数。这些评价策略均对所有主题求平均值。

进一步地,研究使用平均准确率(MAP)[7]来评价主题核心术语抽取的整体性能,如公式(9)所示。

(9)

其中,Z是主题集合。I(S)是一个示函数,当S为真时返回1,否则返回0。Mz,j代表对于主题z,通过方法M产生的第j个候选术语,score(.)是两个人工标注结果的平均值。Mz代表对于主题z,通过方法M产生的所有候选术语。NM,z,j代表对于主题z,通过方法M返回前j个候选术语中正确的主题核心术语的数目,Nz代表对于主题z,根据黄金标准得到正确的主题核心术语的总数。

平均排序倒数(MRR)[9],如公式(10)所示,用于评价对于每个主题来说第一个正确的主题核心术语所在的排序。对于主题z,rankz代表第一个正确的主题核心术语返回的位置。

(10)

2.3 与前人工作的对比

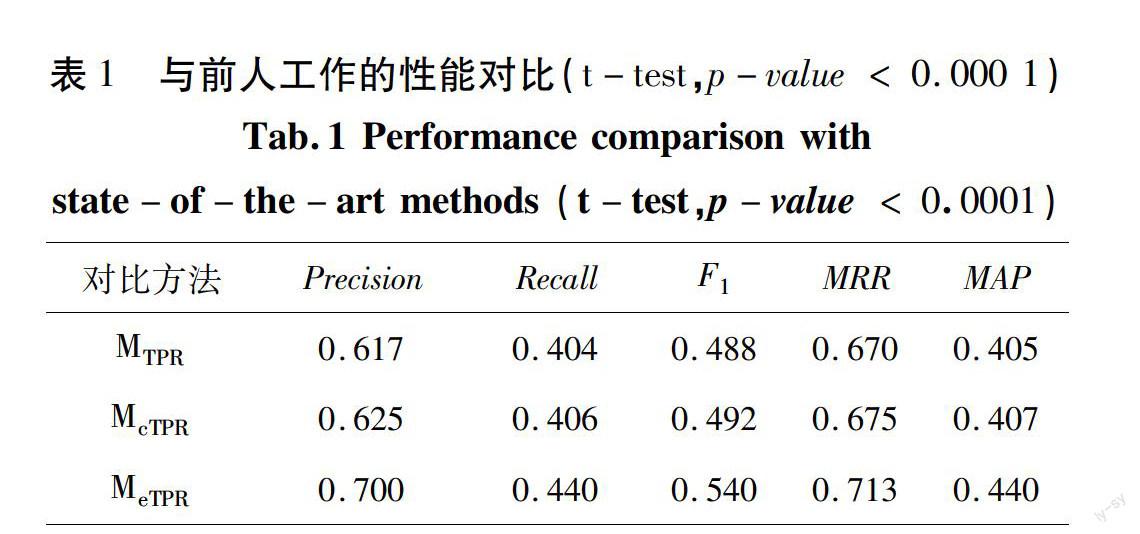

研究通过对影响方法性能的三个参数的穷举获取最优参数组合,得出提出的方法MeTPR与对比方法MTPR,McTPR在五项评价指标上的最优性能对比。如表1所示,本文提出的方法MeTPR在准确率上获得较大提升,比MTPR、McTPR两种对比方法分别提升8.3%、7.5%。在召回率、F1值、MRR、MAP四项评价指标上,MeTPR相对于其他两种对比方法的提升均超过3.3%。由于边权重的设置结合具体主题的局部共现信息和所有主题的全局语义相似度,MeTPR整体性能最好。McTPR由于在边权重的传播中考虑主题背景知识,性能好于在边权重中仅考虑候选术语共现次数的MTPR。但是,LDA算法对于初始主题数的设置,可能会给后续多个彼此独立的主题相关的随机游走带来不可避免的错误,因此未来需要考虑新的途径来改善这类核心术语抽取方法。

表1 与前人工作的性能对比(t-test,p-value < 0.0001)

Tab.1 Performance comparison with state-of-the-art methods (t-test,p-value < 0.0001)

对比方法 Precision Recall F1 MRR MAP

MTPR 0.617 0.404 0.488 0.670 0.405

McTPR 0.625 0.406 0.492 0.675 0.407

MeTPR 0.700 0.440 0.540 0.713 0.440

3 结束语

本文针对从社会化标签中抽取主题核心术语的任务,提出基于边权重的主题核心术语抽取方法。从社会化标签丰富的关联特性出发,提出结合具体主题的局部共现信息和所有主题的全局语义相似度共同构成的边权重。进而,通过新颖的边权重将传统PageRank的随机游走分解成多个主题相关的随机游走,经过候选术语的重要性传播,排序抽取出主题核心术语。在豆瓣电影数据集上的实验结果验证了所提出方法的有效性和健壮性。未来工作,将会通过探索更多社会化标签的数据源,同时结合对基于边权重的主题核心术语抽取方法的改进,进一步提高主题核心术语抽取的性能。

参考文献:

[1] CUI G, LU Q, LI W, et al. Automatic acquisition of attributes for ontology construction[C]//the 22nd International Conference,Hong Kong:ICCPOL,2009:248-259.

[2] LIU X, SONG Y, LIUiu S, et al. Automatic taxonomy construction from keywords[C]//Proceedings of the 18th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining,New York,NY,USA:ACM,2012:1433-1441.

[3] TRANT J. Studying social tagging and folksonomy: A review and framework [J]. Journal of Digital Information,2009,10(1):1-42.

[4] Page L, Brin S, Motwani R, et al. The Pagerank Citation Ranking: Bringing Order to the Web[R]. Stanford:Stanford Digital Library Technologies Project,1999:1-17.

[5] BLEI D M, NG A Y, JORDAN M I. Latent Dirichlet allocation[J]. Journal of Machine Learning Research,2003(3):993-1022.

[6] LIU Z Y, HUANG W Y, ZHENG Y B, et al. Automatic keyphrase extraction via topic decomposition[C]// Proceedings of the 2010 Conference on Empirical Methods in Natural Language Processing,Association for Computational Linguistics,Stroudsburg,PA,USA:ACL,2010:366-376.

[7] ZHAO X, JIANG J, HE J, et al. Topical keyphrase extraction from twitter[C]. Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies,Portland,OR,United states:ACL,2011:379-388.

[8] Voorhees E, Harman D, Standards N I, et al. TREC: Experiment and Evaluation in Information Retrieval[M]. Cambridge: MIT press,Boston,2005:1-567.

[9] VOORHEES E M. The TREC-8 question answering track report[C]//Proceedings of TREC, Gaithersburg,Maryland:NIST,1999:77-82.