基于SDN的云数据中心互联

2015-02-24马骥云南省工业和信息化委员会昆明650228

马骥(云南省工业和信息化委员会,昆明 650228)

基于SDN的云数据中心互联

马骥

(云南省工业和信息化委员会,昆明 650228)

摘 要本文首先分析了云数据中心的特点及DC间互联的业务需求;介绍了SDN技术应用于构建DCI的优势;对基于SDN实现多数据中心互联的方法进行探讨,对DCI流量控制进行了分析;最后对数据中心互联的发展趋势作了展望。

关键词云数据中心;数据中心互联;软件定义网络;广域网;流量工程

1 云数据中心及数据中心互联需求

1.1云数据中心

云数据中心是一种多租户共享计算、存储、网络和安全资源,利用云计算技术,自动化地按需提供各类云计算服务的数据中心架构,是随着云计算、物联网、大数据以及日趋增长的互联网应用而出现的新型数据中心。有别于传统数据中心基础设施和信息系统软硬件分离的局面,云数据中心利用虚拟化技术将计算资源、存储资源和网络资源进行资源池化,通过统一的云计算资源管理和资源调度平台向用户提供实时灵活配置、按需交付、弹性可伸缩及海量数据存储和处理的云服务。思科在其全球云计算产业分析与预测报告中指出:“到2016年全球云计算服务流量将为2011年的12倍,平均每年复合增长30%。全球近2/3的总工作负荷将在云端处理,云数据中心将成为大部分互联网流量的源头或终点”。未来的互联网将是以云数据中心为核心的网络,云数据中心已成为新一代数据中心的演进方向。网络作为获取云服务的通道已经成为云数据中心的核心组成,云网络面临以下需求和变化。

(1) 适应数据中心流量流向变化。

(2) 物理二层向逻辑二层转变。

(3) 网络架构扁平化需求。

(4) 适应大规模租户部署需求。

(5) 大数据对网络带宽的弹性需求。

1.2数据中心互联需求

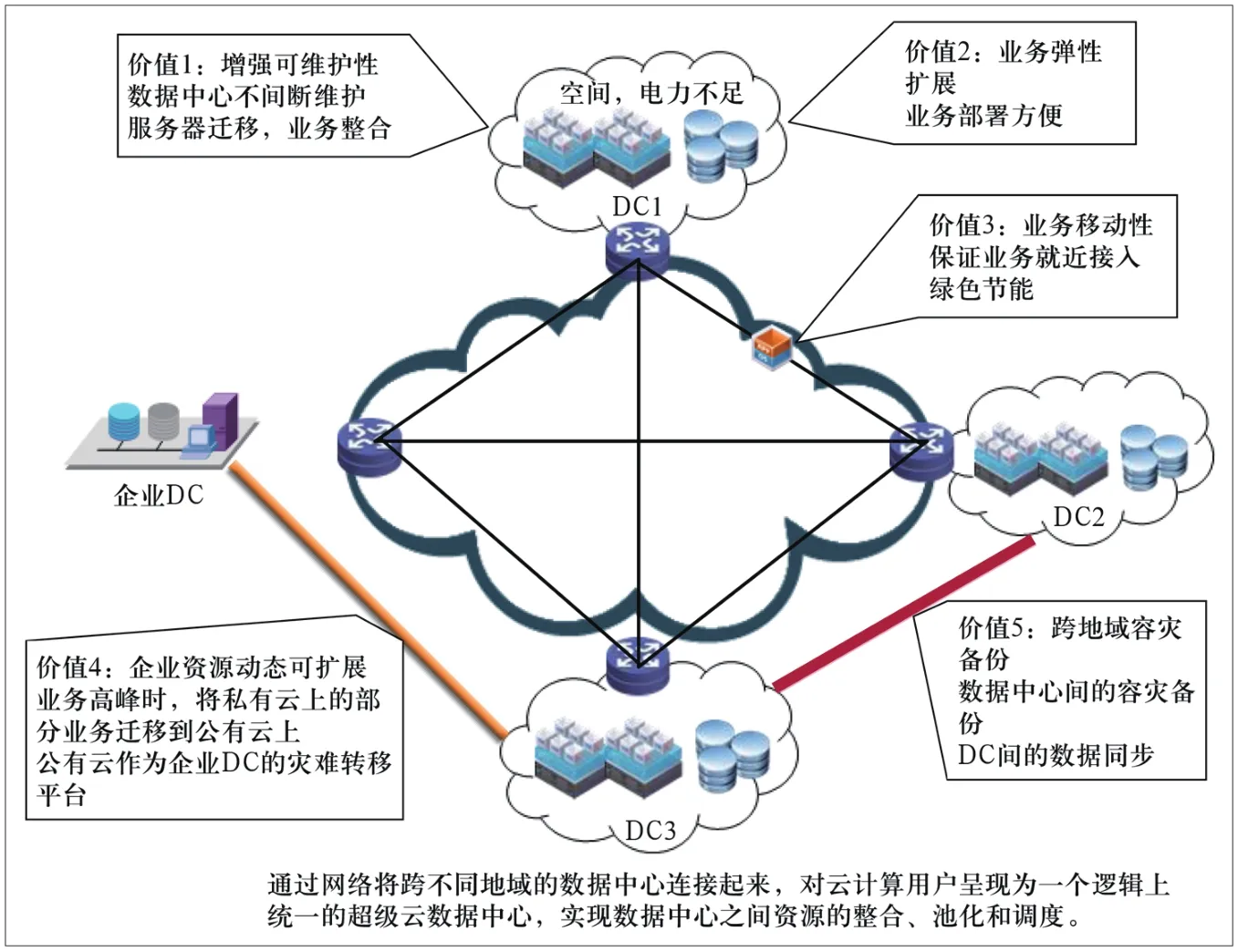

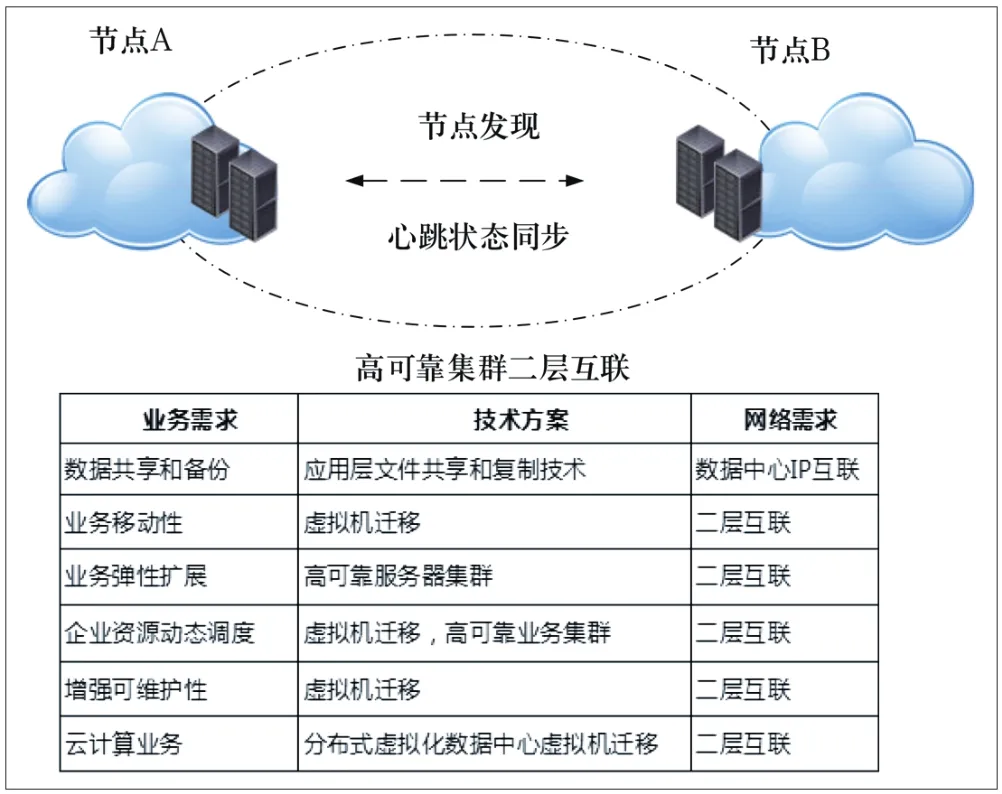

随着云计算、大数据的发展,互联网用户规模爆发式增长,带来网络流量的急剧膨胀。在云计算模式下,提高资源利用率、服务器高可用集群、虚拟机迁移、资源灵活调度、容灾备份、就近服务体验等新的业务需求,促进了DCI(Data Center Interconnection,数据中心互联)向更大规模发展。此外,面对复杂的网络结构以及数量庞大的网元设备,如何进行全局、高效、灵活的网络资源调度和管理也成为数据中心互联的关键业务指

标,其主要需求分析如图1、2所示。

(1)IDC资源利用率不均。

(2)数据中心间的实时数据灾备。

(3)跨数据中心的服务器高可用集群和虚拟机迁移。

(4)用户访问数据中心以及数据中心间互访。

(5)数据中心网络智能化、差异化需求。

图1 多数据中心互联需求与价值

图2 数据中心互联应用需求分析

2 SDN技术特点和优势

(1) 集中高效的网络管理和运维。

(2) 灵活组网与多路径转发。

(3) 智能的虚拟机部署和迁移。

(4) 海量虚拟租户支持。

(5) 计算+存储+网络的IaaS服务。

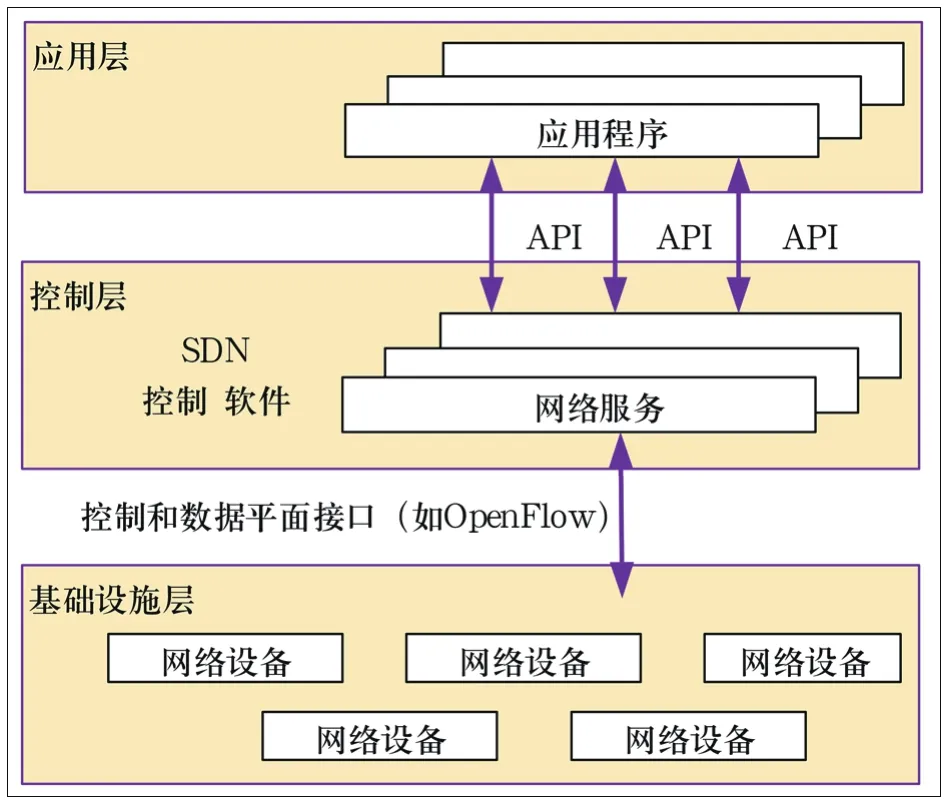

基于SDN具有集中控制、网络虚拟化和网络开放化的特点,很好地契合了数据中心互联的需求。集中化的全局控制,能够满足数据中心物理分散、逻辑集中的需求,实现统一的控制和集中的优化。网络虚拟化的特点可以让数据中心互联业务获得更多的网络和服务的创新;网络的开放性可以让数据中心互联应用创新更加便捷。因此,选择基于SDN对数据中心互联网络进行流量调度和资源管理是云服务提供商或运营商迈向智能化管道的重要途径。

3 数据中心互联方法

互联网流量急剧增长,单一数据中心规模膨胀,业务的过度集中使得单一数据中心的机房空间、供电等设施承担巨大压力,难以满足云服务的需求。另外,对拥有多个数据中心的云服务提供商来说,各数据中心的资源利用率差异大,总体利用率不高,数据中心的分散管理和维护,导致业务部署难度大,维护效率低。随着云计算、大数据和移动互联网的快速发展,数据中心的布局与用户的实际分布存在一定的差异,大量的数据通过公网传递,由于数据量的增大和波峰现象,网络时延、网络抖动及互联互通等方面会有不同程度的影响。要满足这些需求不仅要求在数据中心内实现大二层网络接入,而且要求在数据中心间也实现大范围二层网络扩展。

DCI是把地理分散的多个独立的云IDC通过大二

层网络互联起来,形成一个逻辑上虚拟化的超大型数据中心。数据中心互联后,能够为云服务提供商实现数据中心整合、业务统一运营、异地容灾备份、虚拟数据中心(VDC)、虚拟机迁移、节能减排等各方面提供条件,通过更靠近用户的分布式应用及业务的连续性为用户提供端到端的感知体验。

图3 ONF定义的SDN架构

3.1多数据中心互联方法

目前在技术上,实现DCI 的主要技术有两类。一类是基于MAC/二层网络的DCI技术,利用以太网的VPN技术或MAC in IP技术等,实现二层虚拟连接。主要代表有虚拟专用局域网业务(VPLS)/通用路由封装(GRE)承载VPLS、以太网的虚拟专用网(E-VPN)和叠加的传输虚拟化(OTV)3种。另一类是基于IP/三层网络的DCI技术,采用位置和ID分离的思想或采用边界网关协议(BGP)扩展的思想,主要代表有位置与标识分离协议(LISP)、虚拟子网两种。常用的大二层网络互联方法如下。

3.1.1 基于裸光纤或波分复用(DWDM)线路的二层互联

裸光纤或DWDM二层互联方案需要用户在现网中拥有光纤或传输资源,对用户要求较高,但从使用的角度来看,裸光纤或DWDM方案的性能是最优的。基于裸光纤或DWDM线路的二层互联方案有两种选择:Hub-Spoke方案和RRPP环网方案。前者的优点是基于最短路径转发,转发效率高;后者的优点则是环网天然的转发路径冗余设计,HA性能较高。

3.1.2 基于MPLS网络的二层互联

VPLS主要是基于MPLS技术实现,且在各站点间通过广播来学习MAC地址,是目前最常见的二层互联技术,由于标准化程度很高,在很多行业都已经广泛部署。目前,制约VPLS组网方案的主要因素是其配置管理较复杂,部署及运维管理难度较大,只有大型运营商客户拥有运维能力。而在VPLS的部署方案中,最复杂的就是CE双归属的部署。

3.1.3 基于IP网络的二层互联

当多个数据中心间只有IP互联网络时,可以借助VPLS over GRE来实现二层互联方案。VPLS技术方案本身需要在PE与对端PE间建立一条可承载多个虚链路(Pseudowire)的隧道,可以是MPLS或GRE隧道。VPLS over GRE(VPLSoGRE)方案在组网拓扑、二层环路避免等设计要素上,与基于MPLS隧道的VPLS的要求基本相同。

3.1.4 基于Overlay网络的二层互联

目前,新出现的大规模二层网络技术TRILL/ SPB/Fabric Path等,虽然能支持二层网络的良好扩展,但对网络设备有特殊要求,网络中的设备需要软硬件升级才能支持此类新技术,带来了部署成本的上升。因此,业界又提出了一种构建面向应用的逻辑网络——Overlay网络,为云业务提供支撑。Overlay网络是指建立在物理网络上的逻辑网络,具有独立的控制和转发平面,该网络中的结点可以看作通过虚拟或逻辑链路而连接起来的,对于连接在Overlay边缘设备之外的终端系统来说,物理网络是透明的,是一种实现数据中心大二层互联的主要技术。IETF在Overlay技术领域提出了VXLAN、NVGRE、STT 3类技术方案。

(1)VXLAN是将以太网报文封装成UDP报文进行隧道传输,UDP目的端口为已知端口,源端口可按流分配,标准5元组方式有利于在IP网络转发过程中

进行负载分担,隔离标识采用24 bit来表示,未知目的、广播、多播等网络流量均被封装为多播转发。

(2)NVGRE采用的是RFC2784和RFC2890所定义的GRE隧道协议。将以太网报文封装在GRE内进行隧道传输,隔离标识采用24 bit来表示,与VXLAN的主要区别在对流量的负载分担上,因为使用了GRE隧道封装,NVGRE使用了GRE扩展字段Flow ID进行流量负载分担,这就要求物理网络能够识别GRE隧道的扩展信息。

(3)STT是无状态传输协议,通过将以太网报文封装成TCP报文进行隧道传输,隔离标识采用64bit来表示。与VXLAN和NVGRE的主要区别是在隧道封装格式使用了无状态TCP,需要对传统TCP协议进行修改以适应NVGRE的传输。

就大部分数据中心内部情况看,通过在现有网络上叠加一个软件定义的逻辑网络,让原有网络尽量不做改造,而是通过定义其上的逻辑网络实现业务逻辑,从而解决原有数据中心的网络问题,极大的节省传统用户投资。因此,以VXLAN为代表的Overlay网络虚拟化架构已经成为目前多数厂商支持和采用的成熟方案。

3.2基于SDN的数据中心互联架构

数据中心之间互联网络具有流量大、突发性强、周期性强等特点,需要网络具备多路径转发与负载均衡、网络带宽按需提供、集中管理和全局控制的能力。DCI通常是广域网,建网成本高,需承载多租户、多业务,但目前的DCI受限于传统的分布式路由计算以及匮乏的网络整体资源,链路带宽利用率较低。引入SDN技术后,可通过部署统一的DCI网络控制器来收集各数据中心内部及数据中心之间网络流量的需求,对网络流量实现可视化运营。在全局集中管控下,进行统一的计算和调度、实施带宽灵活按需分配、最大程度优化网络、提升资源利用率。实践证明,Google已经在其数据中心之间应用了SDN技术,将数据中心之间的链路利用率提升至接近100%,成效显著。以下就基于SDN的数据中心互联架构进行分析说明。

基于SDN的数据中心互联架构,通常由DC内部实现VXLAN组网、DCI广域骨干网、DC间业务协同控制平台、云服务管理平台4个部分组成。

(1)在DC内部:在数据中心内部要求实现高带宽、低延时、可扩展的大二层网络。通常是部署SDN交换机,便于虚拟资源和网络策略的同步快速迁移,可以使网络和计算/存储资源更紧密的协同并能实现对全局资源的有效控制。采用虚拟交换机(vSwitch),实现基于物理网络的二层叠加网络技术(如VXLAN)。实现物理网络和虚拟网络互通的网关(以软件实现虚拟路由器、虚拟DHCP、NAT、防火墙、虚拟负载均衡、虚拟VPN)等功能;实现东西向三层互通的分布式路由器以及东西向流量隔离的分布式防火墙;实现数据中心内部网络配置、监控、编排、流量、自动化部署等控制。

(2)DCI广域网骨干:数据中心间网络可以选择:裸光纤、租用运营商MPLS/IP网络、城域承载网、Internet或者自建WAN等。根据选择的网络不同,匹配相应的互联技术,如自建WAN或者裸光纤网络的可扩展性和灵活性较强,互联技术选择广泛,租用运营商的MPLS/IP网络,建议同时租用运营商的VPN业务(VPLS、MPLS L3VPN、GRE VPN等)多种方式可以组合使用,如同城数据中心采用裸光纤或者自建WAN,异地采用租用运营商MPLS/IP网络,分支机构采用Internet等。裸光纤或DWDM二层互联方案需要用户在现网中拥有光纤或传输资源,对用户要求较高,但从使用的角度来看,裸光纤或DWDM方案的性能是最优的。在光纤资源足够的情况下,选择采用100Gbit/s波分复用传输系统进行物理层网络互联。对于同城两个数据中心的点对点互联时,由于互联网络比较简单,不会引入新的互联环路。但如果需要互联的同城云数据中心达到3个及以上时,采用裸纤普通的互联方式必然会引起互联网络的环路,在这种环境下,建议采用HUB-SPOKE星形组网模型。

(3)DCI业务协同控制器:在DCI广域网基础上,通过SDN控制器,将用户的网络策略集中在控制器端,

负责对整个DCI网络配置进行集中管理,并对VXLAN NVE转发器的流表转发控制。通过控制器的集中控制,部署流量工程等应用,有效地调整全网业务端到端的路径,从而达到网络资源的高效利用。通过控制器进行实时的故障上报和检测,并对业务的影响进行快速的预测和处理,简化网络运行管理,提高业务配置速度,实现网络的快速升级。管控平台以及互通节点之间采用统一的控制和同步协议,如Open Flow等南向接口,同时管控平台北向支持Restful API接口,实现业务快速定制和自动发放,南向支持OpenFlow/Netconf/CLI等接口,控制物理和虚拟网络。

(4)云管理平台:SDN控制器通过北向接口提供REST API服务与云管理平台的编排系统或是用户自行开发的应用系统接口进行对接,SDN控制器通过Restful API向上层云管理平台(如OpenStack、Cloud Stack)提供可编程API调用接口,向租户提供Self-Service,实现业务的自动化部署。以OpenStack为例,Neutron是OpenStack中的“网络即服务”子系统,它的作用在于帮助管理员创建、配置并管理软件定义网络体系。OpenStack通过Neutron API向用户和其他服务公开虚拟网络服务接口,包括网络、子网和端口,但它并不实际执行工作,而是由Neutron插件负责与底层基础架构交互,以便依据逻辑模型来传送流量,插件可看作是OpenStack API的一种后端实现。主流的SDN控制器大多已实现通过北向的Neutron Rest API 与OpenStack Neutron插件对接,OpenStack对网络层面的调度交由对接的控制器完成。

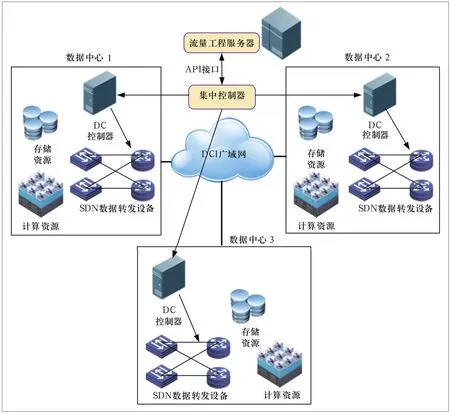

3.3跨数据中心流量管理

数据中心流量分为南北向流量和东西向流量。南北向以用户访问数据中心内容为主,东西向流量包括主要指数据中心内或跨数据中心同步、备份以及 CDN推送流量等。其中数据中心之间流量主要采用互联网承载。一方面,互联网流量突发性大的特征导致同步流量的网络质量无法保证;另一方面,按照现有路由协议,无法做到基于链路负载情况进行路由。因此存在部分链路拥塞,整网利用率不高的问题。SDN架构的流量工程组网方案可解决上述问题,并提高带宽利用率。SDN解决跨数据中心流量调度问题原理如图4所示。

图4 SDN跨数据中心流量调度

传统网络的路由计算要么是无带宽保证的IP路由计算,要么是有带宽要求的MPLS流量工程算法,这两种方式都是网络节点以自己为中心计算到达目的地的一条路径,这种路由计算模式很难获得全网最优路由,也带来了一些问题。IP路由计算完全基于网络拓扑,传统网络中有些节点可能无法拥有全网拓扑,只能进行局部最短路径计算。另一方面,网络拓扑的获取和维护依赖于分布式的网络拓扑传播机制(如OSPF、ISIS协议拓

扑传递)。当网络拓扑发生变化而新的拓扑还未传播到整网时,网络中必然有些节点还没更新拓扑,重新进行路由计算,还按照过时的网络拓扑在转发。

采用SDN架构实现集中式流量工程(TE)管理DCI多租户流量路径,计算出全网最优的流量路径部署方案。TE系统主要包括以下几部分。

(1)OF Controller:Openflow控制模块,TE子系统和网络层物理转发设备间采用Openflow协议,通过OF控制模块向物理设备下发流表,获取统计信息。

(2)Topology:全局性的拓扑资源数据库,具有全网物理拓扑、物理链路带宽容量等信息,是TE算法模块的资源基础。

(3)TE/SLA DB:维护了所有租户的不同SLA需求,各租户可同时向TE申请业务路径。

(4)TE算法:从全局资源优化角度出发,为不同租户提供灵活的业务路径计算,并且能支持租户不同类型的SLA需求、支持不同的优化目标。

(5)Tenant and Service Paths Management:租户信息管理以及业务路径管理,一方面为图形化界面操作提供依据;另一方面也是形成设备转发流表的基础。

(6)Open API:通过开放可编程接口,用户可以定义不同类型的SLA、不同的优化目标等。

TE系统还可以对租户的实时流量,业务路径以及全网资源使用情况进行监控和管理。

4 结束语

数据中心是支撑云计算发展的重要基础,传统的网络架构已无法适应云计算模式的需要,基于SDN理念的网络正向着更简单、更智能化的方向发展,未来将会衍生出一系列相对于现有路由协议更加轻量级、更易于管理的协议。为适应云计算、大数据和物联网的大规模数据增长及用户的云服务体验,使得DCI成为数据中心网络领域逐步演进的一个必然方向。利用软件定义网络技术提供全网视图的、感知业务的、开放的、可编程的数据中心互联网络,不仅能够满足云计算环境下的灾备、两地三中心、负载分担、热备双活、业务可迁移等业务需求,同时也可以实现用户流量在不同数据中心之间的灵活调配和优化,提高网络业务服务质量,提升用户的云服务体验。

参考文献

[1] Tbomas D N. 软件定义网络——SDN和OpenFlow解析[M]. 北京:人民邮电出版社,2014.

[2] 雷葆华. SDN核心技术剖析和实战指南[M]. 北京:电子工业出版社,2014.

[3] 郑叶采,陈世峻. 分布式数据中心的建设与管理[M]. 北京:清华大学出版社,2013.

[4] VXLAN:A Framework for Overlaying Virtualized Layer 2 Networks over Layer 3 Networks[EB/OL].[2013-11—17],https://tools.ietf. org/html/drafl—mahalingam—dutt—deops—vxlan一02.

Data center interconnect based on SDN

MA Ji

(Yunnan Provincial Industry and Information Technology Commission, Kunming 650228, China)

AbstractAt first, this paper analyzes the characteristics of cloud computing data center and DC interconnection between business needs, introduces the SDN technology is applied to the construction of DCI advantage, to explore the method for realizing multiple data center interconnect SDN based on, the DCI fl ow control are analyzed. Finally the development trend of Internet data center is prospected.

Keywordscloud internet data center; data center interconnect; software defi ned network; wide area network; traffi c engineering

收稿日期:2015-09-16

中图分类号TN915

文献标识码A

文章编号1008-5599(2015)11-0054-06