地震解释系统中集群并行存储系统研究与应用

2015-01-04侯朋辉中石化河南油田分公司石油物探技术研究院

侯朋辉/中石化河南油田分公司石油物探技术研究院

地震解释系统中集群并行存储系统研究与应用

侯朋辉/中石化河南油田分公司石油物探技术研究院

本文讨论了全局统一命名空间的集群并行并行存储系统在地震资料解释中的应用。针对高性能计算技术中地震资料解释系统中成功运用分布式并行存储系统、建立存储池、优化存储存取链路、基于全局统一命名空间对存储管理以及存储整合。

地震解释;集群;存储;并行存储;存储池

1、引言

随着地震勘探技术的发展,产生海量地震数据飞速的增长,对数据存储带来的挑战也是非常明显的,由此地震解释系统中对存储系统对高性能、稳定性、和可扩展性等也提出了更高等要求。运用集群并行存储技术、将存储资源池化、从而有效的优化存储链路、存储资源整合、存储I/O带宽性能、满足了地震解释对存储的新的需求。

2、集群并行存储构建

1)使用环境

河南油田物探院地震资料处理中心拥有多套计算机集群和近2PB的分布式集群并行存储系统。在本文中我们讨论一个地震资料解释项目应用分布式并行存储系统的案例。

在该地震解释项目中我们使用的地震资料解释硬件平台是31节点刀片服务器集群系统、并针对地震资料解释系统的需求对该集群系统环境进行了相应对优化。

存储系统使用BaseCluster分布式并行存储集群中抽取4个存储控制器提供200TB对存储系统。

所有的集群计算节点和存储系统全部采用全线速万兆网络连接。

2)BaseCluster并行存储简介

怡立BaseCluster并行存储系统,是一个集群设计和全局命名空间的基于对象的并行文件系统,采用并行共享文件系统,来统一管理存储,为在网的各类计算机主机提供统一的存储,当一个项目和工作组需要存储时,动态地分配所需存储空间,项目完成释放存储空间给其他项目使用,非常便捷。

怡立BaseCluster并行存储系统是一个多功能结构一体化存储解决方案,在每存储个设备上集成了并行存储控制器、磁盘阵列控制器、并行存储管理软件等,使用弹性Hash算法定位数据位置,摒弃元数据服务,高效稳定。在配置条带化的数据卷,所有并行存储控制器同时并行读写数据,具有很高的效率。

3)存储规划

在使用BaseCluster之前,要根据本单位的实际进行存储规划,把用户和所使用的空间(Volume)、数据块对应起来,以便设置和日后的维护。

BaseCluster并行存储的RAID控制器是基于空间的RAID技术,除了具有优越的读写性能外,在使用的灵活性方面也比较优秀。它可以在一个控制器里设置多个任意容量任意级别RAID组,所以我们只需考虑一个最小和最大的用户卷所需的数据块的大小设置。通过不同的chunk数据块,为用户生成不同容量的并行存储卷。

zoning规划:

每台并行存储分为两个zoning, 分别为zoning Group8、zoning Group9。

Zoning Group8包含1到12槽位磁盘驱动器、Master并行控制器、Master RAID控制器。

Group8的Zoning端口:phy0-phy3,phy12-phy23。

Zoning Group9包含13到24槽位磁盘驱动器、Slave并行控制器、Slave RAID控制器。

Group9的Zoning端口:phy4-phy7,phy24-phy35。

RAID规划:

每个zoning中化分一个RAID组,每个RAID组建立两个20TB的RAID卷和一个10TB的RAID卷。

生成用户卷规划见表2-1:

用户卷规划表2 -1

一般情况下,一个用户卷设定后,你可以在Volume管理中增加chunk的方式来增加用户卷的容量容量,在使用过程是不可以进行减少容量,更不能进行删除操作,这是防止管理员误删数据而设定的机制。如果你需要减少容量的话,需要先确认你当前的容量的数据量大小和你减少之后的存储容量大小是否能够匹配。也就是说你的数据能不在您的减少之后的存储设备里存储下的问题。

3、基于并行存储的统一命名空间的存储资源池化管理

通过存储资源池化,使得多个文件存储设备的环境中的文件访问和管理得以简化。如图3-1管理员除了可以管理目标为单个命名空间的文件映射,还可配置目标为统一全局命名空间的文件映射。此外,因为客户端通过全局命名空间访问文件,所以其文件可跨统一存储池中的多个设备存储。存储容量的这种联合,让组织可以高效利用存储容量,并集成现有基础架构中的各种存储技术,将文件的逻辑访问与文件的物理位置相脱离,使文件的物理位置变更能以对客户端系统透明的方式进行。因此,管理员在执行需对物理环境进行更改的管理任务时,仅会造成最少的中断和停机。

图3-1 管理界面

在本项目中我们将其中的两台并行存储划进一个存储池中,每台并行存储都具备双并行控制器,分别把每个控制器都加入到该存储池中,根据之前到规划,我们分别在存储池中到各个控制器里取不同到chunk数据块分别建立一个80TB的分布式卷,一个80TB的条带化卷和一个备份卷输出给用户使用。

4、并行存储在地震解释系统中的应用场景

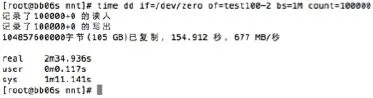

在最初测试我们把landmark 应用直接安装在BaseCluster集群并行存储系统之上并且把landmark地震工区也创建在BaseCluster集群并行存储系统之上。我打开任意大小的抛面时发现会比较慢的现象,我对系统进行里读写测试发现速度并不慢如图4-1。

图4-1 速度测试

后来我通过排查发现,landmark应用在运行时会频繁对向系统写入很小对log日志。每次写入并行存储都要进行哈希计算,从而影响里并行存储的性能。

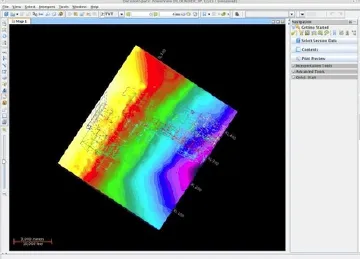

最后我们我们把landmark 应用安装在计算节点系统本地,只把landmark地震工区创建在BaseCluster集群并行存储系统之上。再打开范围大小内的地震剖面时就很理想。如图4-2

在该项目中我们,按照之前的规划,我们创建的的三个存储卷,我们把80TB的分布式卷用做lanmark的存储数据的主存储,另外80TB的条带化的存储,我们做做三维或者时在做jason应用的反演时用该存储卷,因为条带化的卷的I/O存取带宽较高,做三维或反演时用户体检较好。另外的20TB的备份卷,它具有自动对写入对数据进行分布式对备份复制功能,我们主要将该卷用做存储成果数据和安全级别较高的数据。

5、结束语

通过对并行存储在地震解释系统中的应用研究,不断的完善和改进了并行存储的使用方法过程并且优化了并行存储系统应用效果达到最优I/O,进一步提高了集群并行存储系统在地震解释系统中的利用率和工作效率。

图4-2 地震剖面图

[1] Rajkumar Buyya.郑纬民,石威,江东升等译.高性能集群[M].电子科技.2010.5

[2] 戴志敏.存储虚拟化技术研究[M ]高性能计算.2012.12

[3] 刘仲,章文嵩,王召福等.基于对象存储的集群存储系统[M].计算机工程与科学.2009.4