基于话题标签的微博主题挖掘

2015-01-02刘少鹏潘雅丽

李 敬,印 鉴,刘少鹏,潘雅丽

(中山大学信息科学与技术学院计算机科学系,广州510006)

1 概述

微博是一种新兴的社交网络服务,用户可以通过登录微博客户端来发布短文本消息,同时可以附带链接、图片和视频等多媒体资源,与好友进行信息的及时分享。海量微博数据蕴含着丰富的信息,从中挖掘出有效的微博主题,对信息提取与用户分析具有重要意义。

微博与传统文本(新闻、论文等)不同,作为短文本消息,微博中词项的共现信息匮乏,并且没有特定的语法结构,因此简单地套用传统文本主题挖掘的方法很难挖掘有用的微博主题[1]。针对微博的稀疏性和非结构化特点,近年来学者在研究潜在狄利克雷分布(Latent Dirichlet Allocation,LDA)[2]的基础上引入联系人的关系[3]、新闻链接[4]和时间信息[5]等外部信息来挖掘微博主题,并取得了较好成效。研究结果表明,微博本身隐含的用户信息与社交网络信息可以促进微博主题挖掘。然而目前研究并没有明确地从用户兴趣、用户互动和话题微博3种微博类型上将微博主题进行划分,无法同时挖掘出不同微博类型下的主题分布。

本文结合用户兴趣、会话标签(@)、转发标签(RT@)和话题标签(含有#hashtag),对不同微博类型进行主题划分分析,提出一个新的在微博平台下适用的话题标签主题模型HC-ATM(Hash Tag Conversation Author Topic Model),并给出与 HCATM相对应的Gibbs抽样推导结果。

2 相关工作

主题模型是近年来在文本挖掘领域最受关注的方法之一,是一种概率生成模型,它常被用于挖掘大规模文档集的潜在主题。主题模型挖掘的主题与人类对文本的理解较接近,体现出文本间的语义关系。

2.1 主题模型

LDA[2]作为主题模型的典型代表,避免了pLSI[6]中由于参数过多而导致的过拟合问题,同时还可以对训练集之外的文档进行概率估计。LDA将每篇文档看做是多个主题的概率分布,而其中的每个主题则是多个单词的概率分布。在LDA中,一篇文档内的单词是可交换的,文档与文档之间也是条件独立同分布的。在给定主题个数K的情况下,先生成每篇文档中单词的主题,然后再由主题分布生成该单词。根据LDA对文档生成过程的假设,可以使用参数估计方法反向推导概率模型,求得每个主题下的词项分布和每篇文档下的主题分布,进而揭示文档主题结构。常用的推导方法有变分贝叶斯[2]、Gibbs抽样[7]、期望值传播[8]等。

随着对主题模型的深入研究,衍生出了适用于各类具体应用的主题模型。文献[9]提出用于挖掘主题之间相关性的相关主题模型(Correlated Topic Model,CTM),文献[10]通过引入文档的作者信息,提出作者主题模型(Author Topic Model,ATM),此外还有结合时间信息对文档进行建模分析的主题模型 ToT(Topics over Time)[11]和 DTM(Dynamic Topic Models)[12]等。

2.2 微博主题挖掘

相比于传统文本,微博缺乏词项共现信息,数据十分稀疏,直接使用传统主题模型难以挖掘出有用的主题信息。研究者从不同角度出发,提出了适用于不同应用场景的微博主题模型。Labeled-LDA[13]是一个监督主题模型,它将微博内容映射到substance,style,status和 social 4 个维度,用以划分不同主题下的用户和微博。文献[14]结合用户兴趣、时间信息和背景信息,构建出与时间片序列相关的主题分布,将微博主题挖掘的结果用来分析、探测爆发性的新闻话题。微博LDA(Microblog LDA,MBLDA)[3]利用微博会话引入联系人关联关系,用于改善微博的主题挖掘效果。文献[13]通过最小化消息序列主题的预测误差来求解主题转移矩阵,用于预测用户未来微博的主题分布。文献[15]把每对词项的共现模式融入到文本生成过程中,得到适用于挖掘问答系统和微博的主题模型。文献[16]利用微博主题对用户进行建模,根据用户特征表示与微博特征的相似性程度对用户进行微博推荐。

由于微博的特殊性,当前模型倾向于关注用户内在兴趣,并没有充分利用微博中的会话、转发和话题标签,无法同时得到用户兴趣、用户互动和话题微博下的主题分布。文献[3]考虑了会话、转发标签,但是没有考虑话题标签,无法挖掘话题标签下的主题分布,也无法发现描述相同话题的话题标签。文献[13]主要是偏向于利用话题标签来对微博进行主题分析,无法获取用户之间互动的主题分布。

3 微博主题挖掘模型设计与实现

3.1 作者主题模型

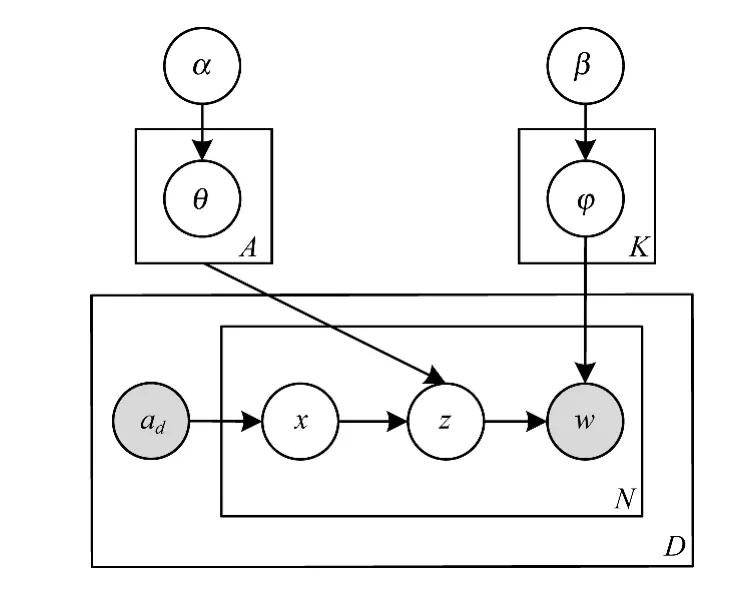

作者主题模型[11]认为每篇文章中的单词是由该篇文章的所有作者合力完成,其中每个作者都有自己的研究领域,因此不同作者拥有不同的主题分布。作者主题模型如图1所示。

图1 作者主题模型

在图1中,α和β为Dirichlet超参数;作者集合ad和文档单词w为可观察的变量。在ATM的文档生成过程中,首先生成每个主题z下的词项分布φz,然后对于文档中的每一个单词wi:从文档合作作者集合ad中以均匀分布选取出一个作者x,然后再从该作者的主题概率分布θx中抽取一个主题zi,接着由该主题下的词项分布φzi生成一个单词wi,直至生成整篇文档。ATM充分考虑了作者信息,挖掘出的作者主题分布在一定程度上代表了该作者的兴趣爱好。

3.2 话题标签主题模型

微博主题模型HC-ATM以ATM作为基模型,结合会话、转发标签和话题标签,对微博生成过程进行统一建模分析,构建出不同微博类别下的主题分布。

微博具有不同于传统文本的特性,其隐含的社交信息对微博主题发现具有一定的促进作用[3]。如含有会话标签(@)和含有转发标签(RT@)的微博:“@mashableHow much does the app charge?”与“RT@mashable the onion launches a new iphone app”。如果将2条微博分别作为独立的微博来分析微博主题,很难得出前一条微博中的“app”就是“a new iphone app”,而话题标签和转发标签所对应的用户mashable正是这2条微博的连接纽带。会话标签和转发标签揭示了微博之间的语义联系,能帮助主题模型更好地发现用户互动中的主题分布。

话题标签(#hashtag)是用户在发微博时给微博添加的自定义标记,表示该条微博的主题。话题标签具有一定的混淆性,不同标签可能指代相同的话题。不同用户给主题相同的微博添加的话题标签可以不同,因此提取出某一个无明显语义特征的话题标签(如话题“#tcot”)下的词项分布有助于发现具有相同语义信息的话题标签,进而可以对微博进行主题分析与标签推荐。

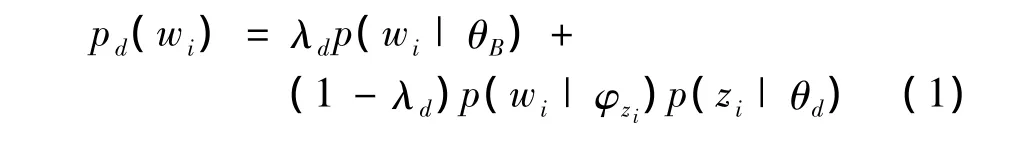

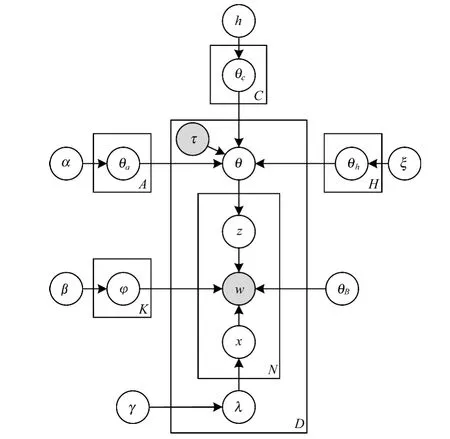

HC-ATM将微博分为3类:用户兴趣微博,用户互动微博和含有话题标签的微博。HC-ATM模型如图2所示,每条微博 d中每个单词 wi的生成概率为:

图2 HC-ATM模型

在HC-ATM中,将词频作为模型的背景分布θB,用于平滑模型。用以λd为参数的伯努利分布来确定微博中每个单词是否由背景分布生成。当xi=1时,则微博中的单词wi由背景分布θB生成;否则首先由微博主题分布θd抽取出一个主题zi,然后再由主题zi下的词项分布φzi生成该单词wi。模型生成过程如下:

(1)对每个主题抽样 φk~Dir(β),k∈[1,K];

(2)对每条微博 d∈[1,D]:

1)确定微博类型τd;

2)确定微博主题分布θd:

①若 τd=0,则微博主题分布为 θd= θh|θh~Dir(ξ);

②若 τd=1,则微博主题分布为 θd= θc|θc~Dir(η);

③否则微博主题分布为 θd=θa|θa~ Dir(α);

3)抽样 λd~Beta(γ);

4)对于每个词 wi∈[1,Nd]:

①抽样 xi~Bern(λd);

②若xi=0,则从 θd中抽取出隐含主题 zi~Multi(θd),生成单词 wi~Multi(φzi);

③若 xi=1,则生成单词 wi~Multi(θB)。

在HC-ATM的微博生成过程中,先生成每个主题z下的词项分布φz;接着判断该条微博是否含有话题标签#hashtag,若含有话题标签,即τd=0时,该条微博的主题分布θd由话题标签的主题分布θh决定;否则判断该条微博是否含有会话标签(@)或转发标签(RT@),若含有会话转发标签,即τd=1,该条微博的主题分布θd由用户互动主题分布θc决定;若不含有任何标签,即τd=2,则该条微博的主题分布θd由用户兴趣主题分布θa决定。然后从θd中抽取出单词的主题zi,最后再从φzi生成单词wi。

3.3 模型推导

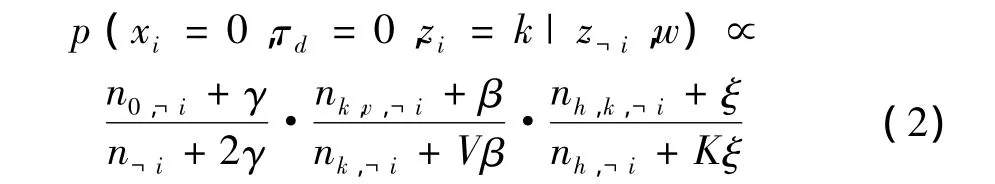

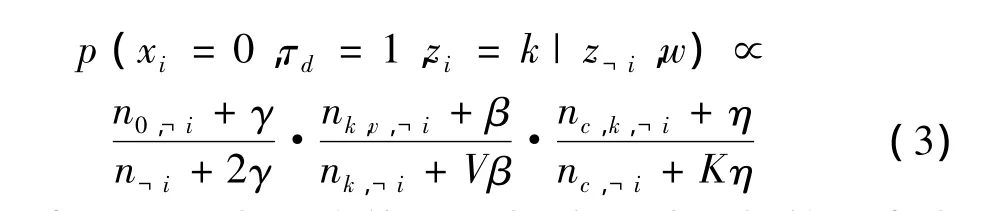

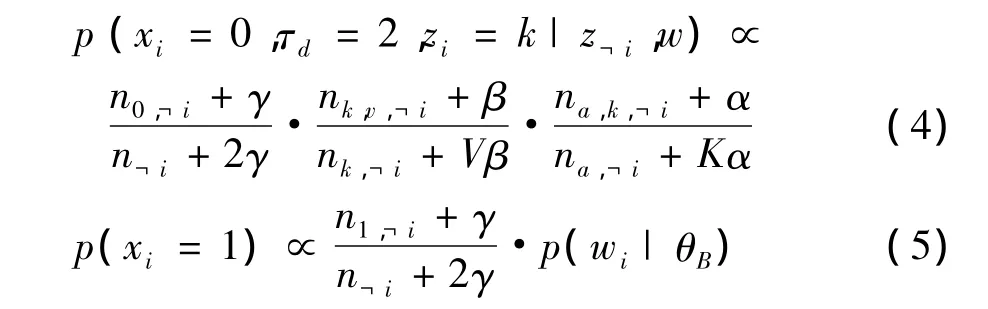

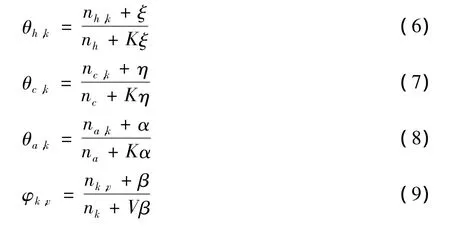

Gibbs抽样是马尔科夫链蒙特卡罗方法(Markov Chain Monte Carlo,MCMC)的特例,每次迭代只对联合分布中的一个维度进行抽样,而其他维度保持不变。Gibbs抽样常被用于概率模型的参数估计。HCATM的Gibbs抽样后验公式具体如下:

其中,V是词项个数;K是主题个数;z¬i表示除了单词i外所有单词的主题下标;w表示所有的单词;n0,¬i表示除了单词 i外,属于主题分布 θd的单词个数;n¬i表示除了单词i外的单词个数;假设wi=v,则nk,v,¬i表示除了单词 i外,词项 v 被分配给主题 k 的次数;nk,¬i表示除单词i外被分配给主题k的词的总数;nh,k,¬i表示除单词 i外,话题标签 h 中出现主题 k的次数;nh,¬i表示除单词i外,话题标签h中出现的所有主题总和。

其中,nc,k,¬i表示除单词 i外,会话转发标签 c 中出现主题k的次数;nc,¬i表示除单词i外,会话转发标签c中出现的所有主题总和。式(4)中的 na,·,¬i同理。

其中,n1,¬i表示属于背景分布中的单词个数。Gibbs抽样迭代直至收敛后,使用以下公式对 θh,θc,θa和φk进行估计:

其中,nh,k,nc,k和 na,k分别表示话题标签微博、会话转发微博和用户兴趣微博中出现主题k的次数;φk,v表示词项v被分配给主题k的次数;θh代表话题标签微博下的主题分布;θc代表会话转发微博下的主题分布;θa代表用户兴趣微博下的主题分布。

4 实验结果与分析

4.1 数据集与数据预处理

本文使用2009年9月-2010年1月的Twitter数据集[17-18],含有3 845 624条用户微博。微博消息含有大量没有实际意义的停用词,因此需要对微博数据集进行预处理,先使用已有的停用词表对微博数据进行去除停用词处理,接着采用Snowball算法对单词进行词干提取,将不同时态的单词归为统一的表示形式,随后去除低频单词和含有单词数较少的微博。经过预处理后,得到约1×105条微博作为实验数据集,数据集描述如表1所示。

表1 实验数据集

4.2 实验环境与参数设置

实验环境为 Windows 7操作系统,Intel Core 3.2 GHz处理器,内存容量为8 GB。实验选取ATM和MB-LDA作为比较实验,3个模型的主题数K设为100、超参数 α 和 αc设为 0.5、β 设为 0.01。HCATM 中的超参数η,ξ和γ都设置为0.5。

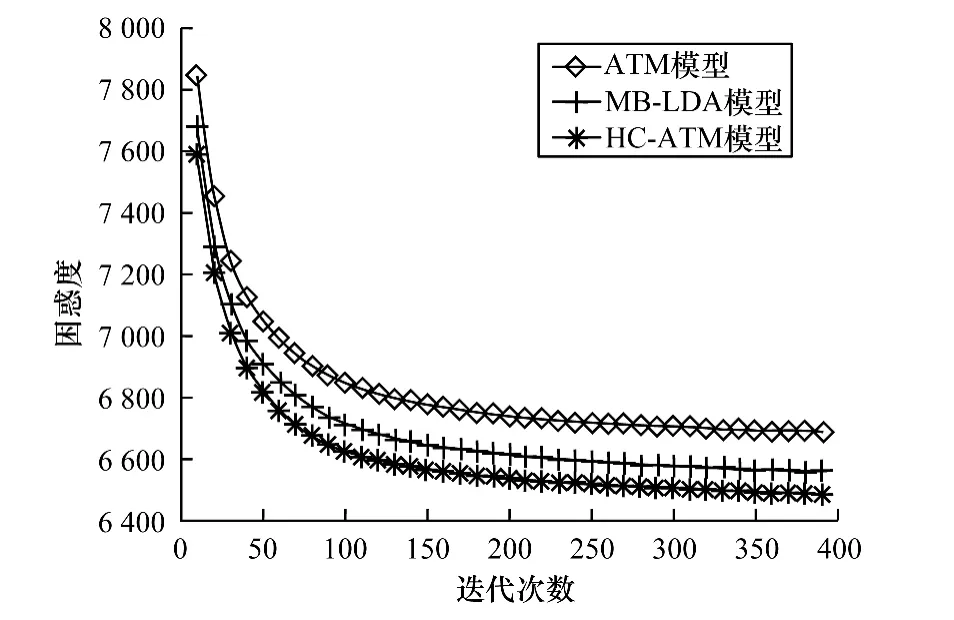

4.3 主题困惑度

困惑度(Perplexity)指标常被用于度量主题模型的性能,表示模型预测数据时的不确定性。困惑度指标越小,模型性能就越好。困惑度计算公式如下:

其中,Nd表示微博d中的词数;wd,i表示微博d中的第i个单词。ATM,MB-LDA和HC-ATM的困惑度比较如图3所示。可以看出,当迭代次数大于300时,3个模型的困惑度都趋于平稳状态,并且HCATM具有比ATM和MB-LDA更小的困惑度,证明了HC-ATM的可靠性。

图3 模型的主题困惑度比较

此外,主题模型的K值越大,模型越容易识别不同含义的潜在主题,具有更小的混惑度,但K值也不宜设置过大,否则会使模型挖掘出大量的垃圾主题,不利于在整体上把握微博数据的主要内容。

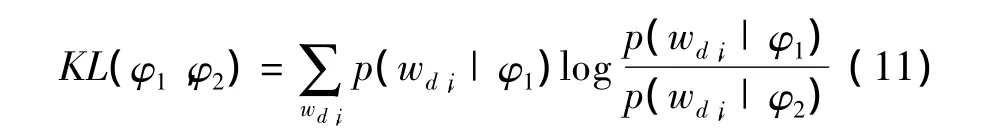

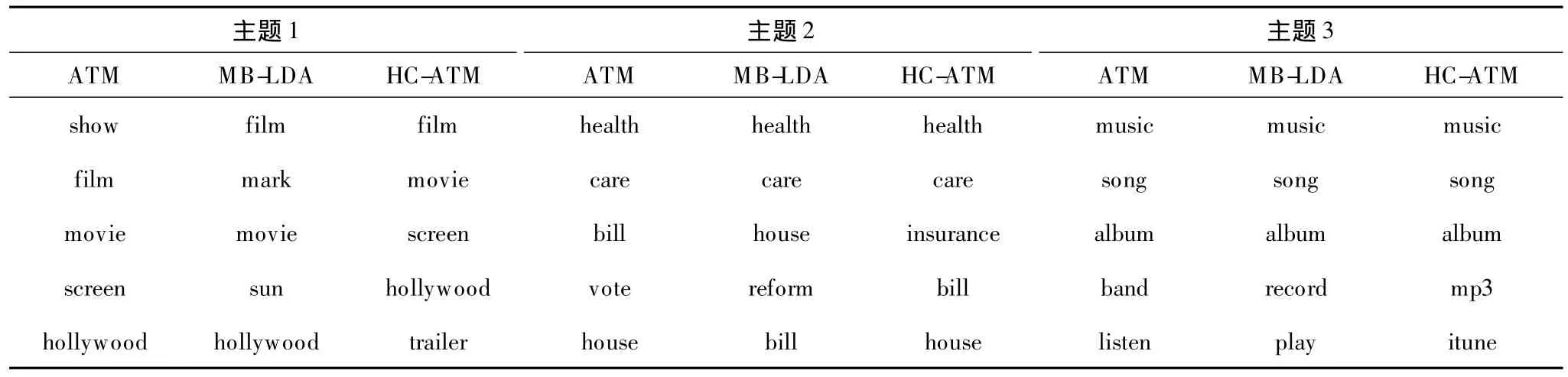

4.4 主题差异性

主题差异性是度量模型提取出的主题间的差异程度,抽取出的主题两两之间的差异性越大,说明主题越具有代表性。KL距离常用于度量2个概率分布间的差异程度,实验中使用KL距离来计算主题差异性。2个主题的差异性越大,KL距离越大;反之,KL距离越小。在极端情况下,主题间的KL距离为0,表示2个主题完全一致。KL距离计算公式为:

其中,wd,i表示微博 d中的第 i个单词;φ1和 φ2表示不同的主题。ATM,MB-LDA和HC-ATM 3个模型中两两主题之间的KL平均距离比较如表2所示。可以看出,HC-ATM的KL值相对较大,具有更好的主题差异性,说明了对微博进行分类建模能够帮助主题模型发现更具代表性的主题。

表2 模型KL距离比较

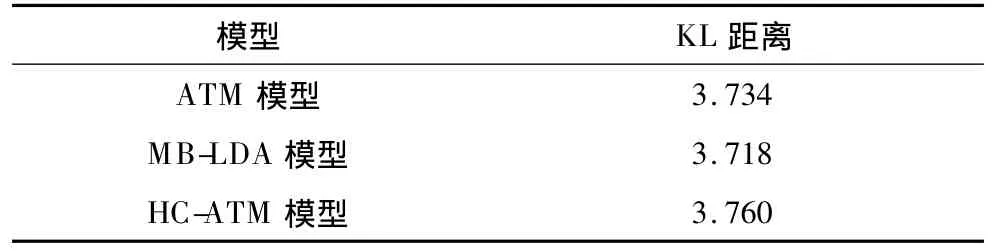

4.5 主题有效性

微博主题挖掘的目标是挖掘出有用的主题,主题是否有效,与主题下的词项分布有关。

人工判断词项与描述主题的相关程度,是评价主题模型有效性的方法。限于篇幅,表3只给出3个模型中都能找到的3个相同主题:主题1(电影相关),主题2(医疗法案相关),主题3(音乐相关),每个主题给出前5个出现概率最大的单词。可以看出,3个模型都能挖掘出具有一定代表性的主题,但HC-ATM具有更加接近人类对主题理解的表示。在主题1中,ATM得到概率最大的词项为show,如果光从该词出发,并不能很好地判断主题1是与电影相关的主题,而MB-LDA中出现的mark同样也不能显著地表示出主题1与电影主题的关系。

表3 主题有效性比较

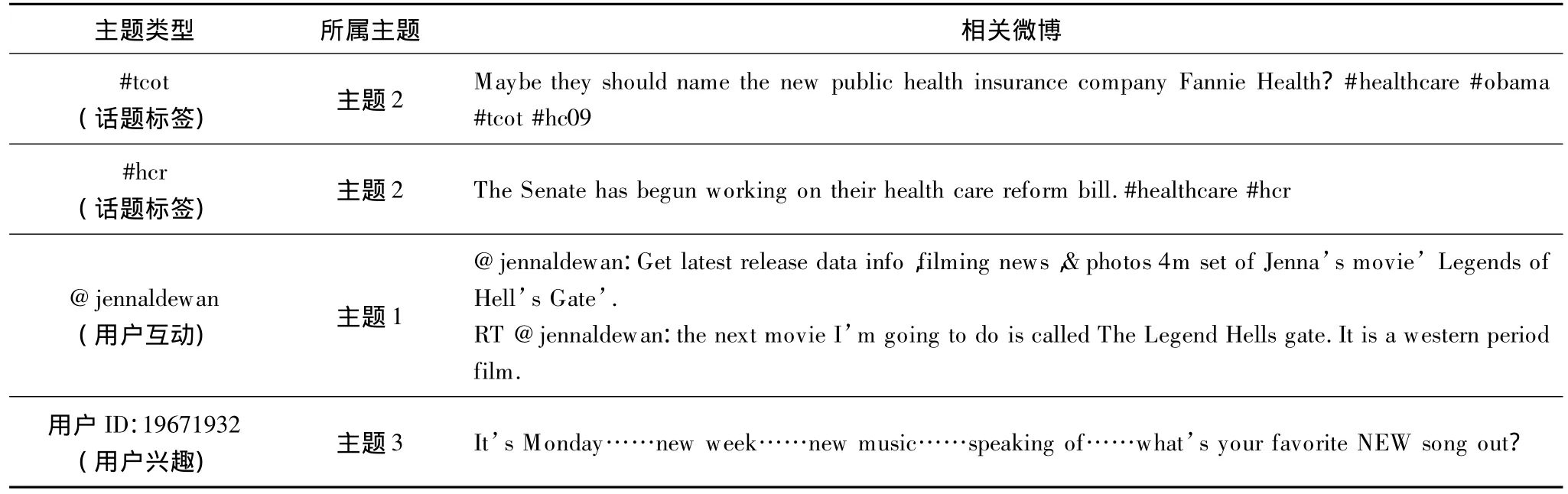

4.6 多类型主题分析

由HC-ATM分析出不同的主题类型如表4所示。通过分析话题标签下的主题可以发现微博中较热门的话题,并且可以得到相似主题的话题标签。不同用户的知识背景不同,对相同话题的标签描述页不同。如#tcot和#hcr都是属于医疗改革的话题标签,但仅从2个标签来看,无法确定这2个标签所描述的主题是相似的。

分析会话转发标签下的主题,可以得到用户之间互动的主题。如用户jennaldewan经常参与一些与电影相关的讨论,当有多条与用户jennaldewan进行互动的微博出现时,可以根据分析结果将与电影相关的微博评论排在靠前的位置,提高阅读评论的效率。

表4 多类型主题分析

由用户兴趣的主题分布,可以挖掘出用户的兴趣爱好,如用户ID:19 671 932的兴趣爱好为音乐,对该用户进行与音乐相关的微博推荐,并结合用户互动主题分布,扩展用户兴趣爱好,提供更为广泛的微博推荐。

5 结束语

本文对用户兴趣、用户互动和话题标签3种类型微博进行统一建模,提出一个新的主题模型HCATM。利用HC-ATM可以同时挖掘出不同微博类型下的主题分布,并能获得较好的主题质量。

由于本文主题个数确定,然而在实际应用中找到合适的主题个数需要一定人工经验,因此今后将对主题个数的自动获取进行研究,提高主题挖掘效率。

[1] Yan Xiaohui,Guo Jiafeng,Lan Yanyan,et al.A Biterm Topic Model for Short Texts[C]//Proceedings of the 22nd International Conference Companion on World Wide Web.Rio de Janeiro,Brazil:IW3C2 Press,2013:1445-1456.

[2] Blei D M,NgA Y,Jordan M I.LatentDirichlet Allocation[J].Journal of Machine Learning Research,2003,3(1):993-1022.

[3] 张晨逸,孙建伶,丁轶群.基于MB-LDA模型的微博主题挖掘[J].计算机研究与发展,2011,48(10):1795-1802.

[4] Zhao Xin,Jiang Jing,He Jing,et al.Comparing Twitter and Traditional Media Using Topic Models[C]//Proceedings of the 33rd European Conference on IR Research.Berlin,Germany:Springer-Verlag,2011:338-349.

[5] Hong Liangjie,Dom B,Gurumurthy S,et al.A Timedependent Topic Model for Multiple Text Streams[C]//Proceedings of the 17th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.New York,USA:ACM Press,2011:832-840.

[6] Deerwester S C,Dumais S T,Landauer T K,et al.Indexing by Latent Semantic Analysis[J].Journal of American Society for Information Science,1990,41(6):391-407.

[7] Griffiths T L,Steyvers M.Finding Scientific Topics[J].National Academy of Sciences of the United States of America,2004,101(S1):5228-5235.

[8] Minka T P,Lafferty J.Expectation-propagation for the Generative Aspect Model[C]//Proceeding of the 18th Conference on Uncertainty in Artificial Intelligence.Boston,USA:AUAI Press,2002:352-359.

[9] Blei D M,Lafferty J D.Correlated Topic Models[C]//Proceedings of NIPS’05.Cambridge,USA:MIT Press,2005:147-155.

[10] Steyvers M,Smyth P,Griffiths T.Probabilistic Authortopic Models for Information Discovery[C]//Proceedings of the 10th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.New York,USA:ACM Press,2004:306-315.

[11] Wang X,Mccallum A.Topics Over Time:A Non-Markov Continuous-time Model of Topical Trends[C]//Proceedings of the 12th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.New York,USA:ACM Press,2006:424-433.

[12] Blei D M,Lafferty J.Dynamic Topic Models[C]//Proceedings of the 23rd International Conference on Machine Learning.Pittsburgh,USA:IEEE Press,2006:113-120.

[13] Ramage D,Dumais S,Liebling D.Characterizing Microblogs with Topic Models[C]//Proceedings of the 4th International AAAI Conference on Weblogs and Social Media.Menlo Park,USA:AAAI Press,2010:130-137.

[14] Diao Q,Jiang J,Zhu F,et al.Finding Bursty Topics from Microblogs[C]//Proceedingsofthe50th Annual Meeting of the Association for Computational Linguistics.New York,USA:ACM Press,2012:536-544.

[15] Wang Y,Agichtein E,Benzi M.TM-LDA:Efficient Online Modeling of Latent Topic Transitions in Social Media[C]//Proceedingsofthe 18th International Conference on Knowledge Discovery and Data Mining.Beijing,China:[s.n.],2012:123-131.

[16] Khalid E A,Min X,Emily B F.Representing Documents Through Their Readers[C]//Proceedings of the 19th International Conference on Knowledge Discovery and Data Mining.New York,USA:ACM Press,2013:14-22.

[17] Cheng Z,Caverlee J,Lee K.You Are Where You Tweet:A Content-based Approach to Geo-locating Twitter Users[C]//Proceedings of the 19th ACM International Conference on Information and Knowledge Management.NewYork,USA:ACM Press,2010:759-768.

[18] 王 莎,张连明.基于标签的微博人脉网络挖掘算法和结构分析[J].计算机工程,2014,40(5):7-11.