大脑信息获取与信息加工的状态识别

2014-12-23吕胜富

周 宇,栗 觅,吕胜富

(1.北京工业大学 电子信息与控制工程学院,北京100124;2.辽宁石油化工大学 计算机与通信工程学院,辽宁 抚顺113001;3.磁共振成像脑信息学北京市重点实验室,北京100053)

0 引 言

大脑状态识别研究领域中,关于情感模型[1]、人脸表情识别[2,3]、语音信号情感识别[4-6]、情感仿生代理[7]等情感识别的研究较多,而涉及人类工作状态识别的研究较少。信息获取和信息加工状态属于工作状态中的2种基本脑功能状态,研究其识别问题对工作状态识别的研究具有一定帮助。

先前研究表明,不同的眼球运动状态表示人们在阅读时不同的视觉行为,这种不同的视觉行为反映了大脑处于不同的工作状态或思维状态[8-11]。人脑在信息加工时,首先从外界获取信息,然后进行信息整合处理。由于在获取外部视觉信息和整合加工信息时的脑工作状态不同,对应的眼动模式或许存在差异。统计图是人们日常生活十分重要的信息载体,统计图阅读过程中涉及多种大脑信息处理过程,其中最基本的信息处理包括信息获取 (值的提取)和信息加工 (关系比较)。本文研究基于眼动信号对以上2种信息处理过程进行识别的方法。通过分析信息获取和信息加工的眼动模式和瞳孔直径、眼跳距离、注视次数等眼动数据,使用SVM 分类器研究这2种信息处理过程的大脑状态识别问题。

1 眼动数据的获取

1.1 实验材料

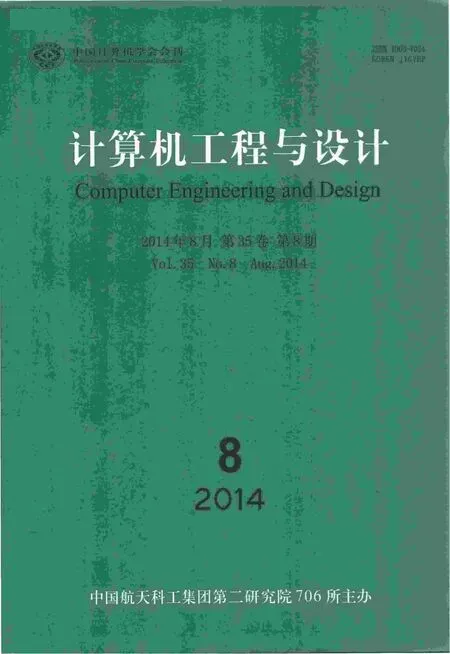

我们使用柱状统计图作为研究对象,分析和识别人们在阅读统计图时的信息获取和信息整合的眼动模式以及对应的大脑状态。统计图的理解过程中,主要包括2个基本的信息处理过程:①信息获取,即从统计图中提取统计信息,也称为值提取,其过程为:从统计图中的横轴获得项目名称,从纵轴中获得对应的统计值信息;②信息加工,即按照统计值的大小比较各个统计项目的大小,也称为关系比较。在一个统计图的理解过程中,这2个信息处理过程是交叉的,为了分析和识别值提取和关系比较的眼动模式的差异,我们分别设计了值提取和关系比较的统计图材料,如图1所示。值提取统计图中只有一个项目,被试在阅读的时候能够迅速获取该项目的值;关系比较统计图中有2个项目,被试在阅读的时候能够迅速比较出两者之间的关系。在每张统计图中,选用26个大写英文字母作为统计图中的项目名。每类图片的数量为120 张,所有图片的灰度、分辨率均相同,图片尺寸均为300×300像素。

图1 实验中的材料实例

1.2 眼动数据获取方法

24名大学生和研究生 (其中10 名女性,14 名男性,年龄25±2 岁)参加了本实验。所有参加者均为右利手,视力正常或校正后正常。本研究使用的设备是Tobii T120眼动仪,眼动信号的采样频率为120 Hz。实验材料呈现在分辨率为1024×768像素的17寸显示器上,刷新频率为60 Hz。参加者与屏幕之间的距离约为60 ms。实验过程为:首先呈现一张图片,1s后消失。然后,呈视另一张图片,要求被试判断该图片信息与前一张是否一致。判断结束后,呈视2s的黑屏,随后进行下一个任务。2类任务是有区别的,对于统计图值提取任务,要求判断二者所表达的统计信息是否相同;对于关系比较任务,要求判断二者的大小关系是否一致。眼动仪将全程记录眼睛的注视位置及其它眼动信息。

1.3 值提取与关系比较的眼动模式

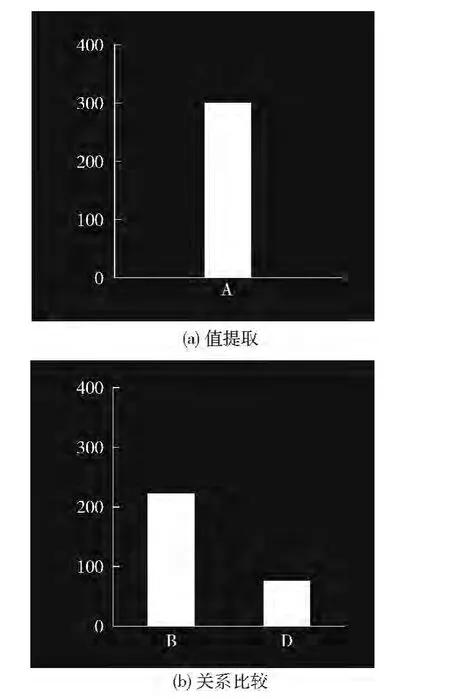

3名参加者的数据记录由于不完整而被剔除,因此,本研究使用了21 名参加者的数据。每名参加者共观看了240张图片,共采集到5040个注视任务的眼动数据,其中值提取任务和关系比较任务各占一半。剔除了极端数据(超过3倍标准差的数据,共剔除了9%)后,使用4585个任务的数据 (其中2280个值提取任务,2305个关系比较任务)进行分析。图2给出了实验所记录的值提取和关系比较任务的注视位置分布 (21名参试者)。

图2 眼动模式

图2中的轮廓线表明了注视点的主要分布范围。通过观察可知,值提取任务的注视点主要分布在柱状图、横轴和坐标轴的纵轴上 (如图2 (a)所示),而关系比较任务的注视点主要分布在柱状图和横轴上 (如图2 (b)所示)。2类任务注视点分布情况表明,值提取和关系比较2种信息处理过程具有不同的眼动模式。

2 特征提取与分类

2.1 特征提取

由实验采集的眼动数据可以获取多种眼动特征,其中较为常用的有瞳孔直径 (pupil diameter,PD)、眼跳距离(saccade distance,SD)、注视时间 (fixation count,FD)、注视次数 (fixation count,FC)。以瞳孔直径度量的瞳孔大小的变化能够客观的反应心理活动,如心理负荷,以及情感。在注视过程中,眼睛并非静止不动的,需要在感兴趣的区域之间持续移动来获取或加工信息。每次跳转的距离定义为眼跳距离。在2次眼跳之间,眼睛会处于相对静止,即产生了注视点。注视次数是对注视点个数的统计。注视时间为眼睛驻留在各个注视点的时间。

我们可以使用眼动装置获得人们在阅读一幅统计图的过程中各个注视点信息,包括每个注视点的注视点位置、瞳孔直径、注视时间。根据这些注视点信息可以区分不同的信息加工过程。特征提取是模式识别的首要工作,我们使用了整体特征提取和局部特征提取2种方法。整体特征提取是把整个统计图作为研究对象,统计注视点特征值;局部特征提取是把统计图按照值提取和关系比较的眼动模式的差异划分为不同的区域,统计各个区域的注视点特征值。局部特征提取在机器视觉等领域有着广泛的应用[12-14],其主要目的是选择不同模式下差异最大区域的特征作为分类的依据,因此特征提取区域的选择将十分关键。在本研究中,区域的界限是通过观察不同信息加工模式下注视点的分布特性来决定的。在值提取过程中,注视点主要分布在中间和左侧的坐标轴上,而在关系比较过程中,注视点主要分布在中间区域。因此选择左侧坐标轴作为局部特征提取的区域 (如图3所示)。局部特征提取时会出现眼跳距离特征无法获取的情况,因为连续2个注视点可能分别处于区域的内部和外部,因此在局部特征提取时不使用眼跳距离特征。由于注视点分布不同,2 种信息处理模式下在左侧坐标轴区域的注视时间会产生差异。因此。本研究所使用的特征值包括整体的平均瞳孔直径、平均眼跳距离以及注视次数,局部区域的 (左侧坐标轴区域)平均瞳孔直径、注视时间以及注视次数。

2.2 统计分析

图3 局部特征提取区域的划分

首先对2种信息处理产生的眼动特征进行统计分析,比较其差异性。表1给出了整体特征统计分析的结果。表1可以看出,值提取过程中的平均瞳孔直径显著大于关系比较时的平均瞳孔直径 (p<0.05);值提取过程中的平均眼跳距离显著大于关系比较时的平均眼跳距离 (p<0.000);而注视次数并无显著差异 (p=0.89)。

表1 值提取和关系比较整体眼动特征的统计分析结果

表2给出了局部特征统计分析的结果。其中,值提取过程中的平均瞳孔直径显著大于关系比较时的平均瞳孔直径 (p<0.001);值提取过程中的注视时间显著大于关系比较时的注视时间 (p<0.001);值提取过程中的注视点分布显著多于关系比较 (p<0.001)。结合表1的结果进行对比可知,局部获取的特征差异性更加显著。综合上述分析,统计图阅读中的值提取和关系比较过程具有不同的眼动模式,为给统计图理解过程中的2种不同的信息处理模式的脑状态分类提供了依据。

表2 值提取和关系比较局部眼动特征的统计分析结果

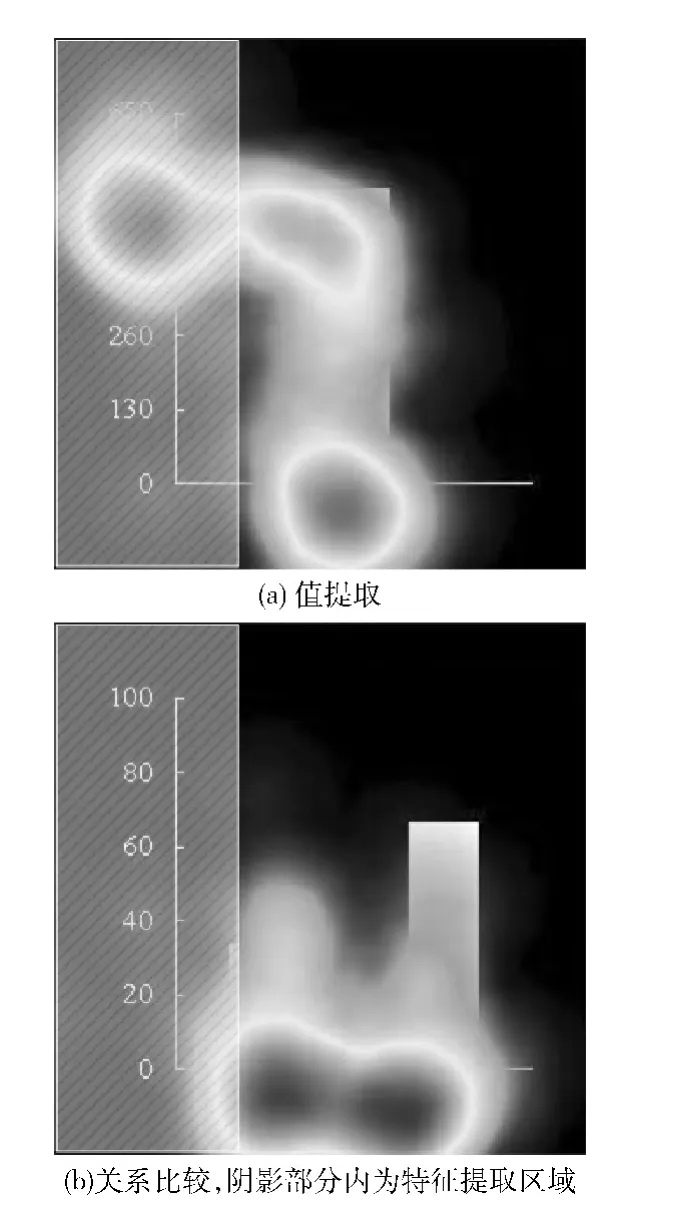

2.3 分类结果

我们使用基于RBF 核函数的SVM 对眼动特征进行分类,识别统计图阅读时大脑值提取和关系比较时的状态差异。基于各个特征的分类结果如图4所示。使用整体特征进行分类时 (如图4 (a)所示),识别率过低。使用局部特征的分类结果相比整体特征有了显著提高,其中基于瞳孔直径的分类正确率由57.59%提升至68.32%,基于注视次数的分类正确率由53.83%提升至84.75%,使用注视时间的分类正确率达到了86.55% (如图4 (b)所示)。

图4 基于单个特征的分类正确率

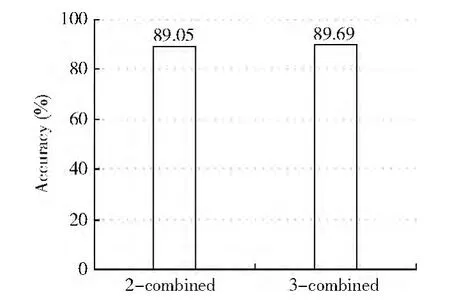

基于多种特征的分类相比单特征的分类具有多种优势,如对噪音更加稳定,可以解决非普遍性问题,并可以提高匹配正确率。这里,我们分别把局部的3个特征 (瞳孔直径、注视时间和注视次数)进行组合分类 (3特征组合,3-combined),以及把分类正确率较高的注视时间和注视次数特征进行组合分类 (2 特征组合,2-combined)。分类结果如图5所示,无论是3特征组合还是2特征组合,其分类正确率都高于单个特征的分类正确率。2 特征组合的分类正确率 (89.05%)相比于3 特征组合的分类正确率(89.69%)略低一点,加入瞳孔直径后对识别率的提高效果十分有限,这说明在使用组合特征进行分类时,选择单特征识别性能较好的特征较为关键。那么在实际应用过程中,应考虑具体的用途选用分类特征,如果识别系统追求速度,那么使用2特征实现分类较为合适;但是在对识别准确率要求较高的场合中,选择3特征进行分类较为合适。

图5 基于组合特征的分类正确率

3 结束语

本文研究结果表明,信息获取与信息加工2种脑功能状态具有不同的眼动模式。信息获取时需要进行全局搜索,注视点的分布呈现出发散性,而信息加工时往往仅针对局部信息,注视点的分布较为集中。基于眼动模式的差异,计算机能够通过眼动信号识别人类在阅读时处于信息获取状态还是信息加工状态,计算机实现复杂的脑功能状态识别能够提供更加智能化的人机交互应用。

[1]Karpouzis K,Caridakis G,Kessous L,et al.Modeling naturalistic affective states via facial,vocal and bodily expressions recognition [M].Artifical Intelligence for Human Computing.Berlin:Springer Berlin Heidelberg,2007:91-112.

[2]Xiao R,Zhao Q,Zhang D,et al.Facial expression recognition on multiple manifolds[J].Pattern Recognition,2011,44(1):107-116.

[3]Shan C,Gong S,McOwan PW.Facial expression recognition based on local binary patterns:A comprehensive study [J].Image and Vision Computing,2009,27 (6):803-816.

[4]Schuller B,Batliner A,Steidl S,et al.Recognising realistic emotions and affect in speech:State of the art and lessons learnt from the first challenge [J].Speech Communication,2011,53 (9):1062-1087.

[5]Batliner A,Steidl S,Schuller B,et al.Whodunnit-searching for the most important feature types signalling emotion-related user states in speech [J].Computer Speech & Language,2011,25 (1):4-28.

[6]Wu D,Parsons TD,Mower E,et al.Speech emotion estimation in 3Dspace[C]//IEEE International Conference on Multimedia and Expo.IEEE,2010:737-742.

[7]Becker-Asano C,Wachsmuth I.Affective computing with primary and secondary emotions in a virtual human [J].Autonomous Agents and Multi-Agent Systems,2010,20 (1):32-49.

[8]Rantanen V,Vanhala T,Tuisku O,et al.A wearable,wireless gaze tracker with integrated selection command source for human-computer interaction [J].IEEE Transactions on Information Technology in Biomedicine,2011,15 (5):795-801.

[9]Bulling A,Ward JA,Gellersen H,et al.Eye movement analysis for activity recognition using electrooculography [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33 (4):741-753.

[10]LI Mi,ZHONG Ning,LV Shengfu.A study about the characteristics of visual search on Web pages [J].Journal of Frontiers of Computer Science and Technology,2009,3 (6):649-655 (in Chinese). [栗觅,钟宁,吕胜富.Web页面信息的视觉搜索行为特征的研究 [J].计算机科学与探索,2009,3 (6):649-655.]

[11]LI Mi,ZHONG Ning,LV Shengfu.Exploring visual search and browsing strategies on Web pages using the eye-tracking[J].Journal of Beijing University of Technology,2011,37(5):773-779 (in Chinese).[栗觅,钟宁,吕胜富.Web页面视觉搜索与浏览策略的眼动研究 [J].北京工业大学学报,2011,37 (5):773-779.]

[10]Huang C,Liu Q,Yu S.Regions of interest extraction from color image based on visual saliency [J].The Journal of Supercomputing,2011,58 (1):20-33.

[11]Tan X,Triggs B.Enhanced local texture feature sets for face recognition under difficult lighting conditions[J].IEEE Transactions on Image Processing,2010,19 (6):1635-1650.

[12]Gao S,Tsang IW,Chia LT,et al.Local features are not lonely-Laplacian sparse coding for image classification [C]//IEEE Conference on Computer Vision and Pattern Recognition.IEEE,2010:3555-3561.