基于联合标定的图像分割

2014-09-06,,

,,

(哈尔滨工业大学机器人技术与系统国家重点实验室,黑龙江 哈尔滨 150001)

基于联合标定的图像分割

张腾飞,李瑞峰,王亮亮

(哈尔滨工业大学机器人技术与系统国家重点实验室,黑龙江 哈尔滨 150001)

针对普适环境下人体区域的提取问题,提出一种基于彩色摄像头和深度摄像头联合标定的图像分割方法。首先根据深度摄像头采集的深度信息易处理和受外界环境影响小的优点,利用大律法从深度图像中快速提取出人体区域;然后建立世界坐标系中彩色图像坐标系和深度图像坐标系的对应关系,实现彩色信息和深度信息的相对位置映射;最后根据分割的深度图像及其在彩色图像中的映射,在彩色图像中完成人体区域分割。通过在复杂背景和不同光照条件下的图像分割实验,验证了本方法具有良好的精度和鲁棒性。

普适环境;彩色图像;深度图像;联合标定;图像分割

0 引言

复杂背景及光照等交互场景的差异往往会直接影响人体区域的快速准确提取,其精度和鲁棒性对自然人机交互过程起着至关重要的作用。近年来,图像中人体区域的分割一直是人机交互领域研究的热点和难点[1-3]。研究的理论相对而言比较成熟,国内外普遍将图像分割方法分为基于区域的方法、基于边界的方法和数学形态学方法[4]。但是上述方法往往不能自动实现区域的分割,需要手动选取部分的待分割区域的像素点,实时性差、易受光照和复杂背景的影响。采用一种基于联合标定的人体区域提取方法,将人体区域从具有复杂背景的彩色图像和深度图像中同时分割出来。

1 分割流程

深度摄像头具有对深度信息采集速度快,受外界环境影响小的优点,所以在光照变化,交互环境具有复杂背景的情况下,其分割仍可以具有很好的鲁棒性和实时性。深度和彩色图像由Kinect摄像头采集得到,利用深度图像中提取的人体区域的距离信息,采用大津法在深度图像中选择合适的阈值,使得背景和目标之间的类间方差最大,达到错分概率最小,实现深度图像人体区域的快速提取;再对Kinect摄像头的深度摄像头和彩色摄像头进行联合标定,求得深度图像到彩色图像的转换矩阵,最后将深度图像中的人体区域通过转换矩阵对应到彩色图像中,即可完成彩色图像中人体区域的提取。分割方法的整个流程如图1所示。

图1 分割流程

2 摄像头标定

2.1 彩色摄像头标定

在彩色摄像头的单独标定过程中,内部参数的获得使用常用的棋盘格标定法进行标定,即张正友标定法,通过选取棋盘格标定板不同视角下的平面和彩色图像中的角点,对彩色摄像头内部参数进行标定[5]。从彩色摄像头坐标系到彩色图像坐标系的转换关系为:

(1)

[Xr,Yr,Zr]为空间中点在彩色摄像头坐标系下的坐标;[Ur,Vr]为点在彩色图像中的坐标;fx,fy,u0和v0为彩色摄像头的内部参数。

2.2 深度摄像头标定

深度摄像头的标定不同于一般摄像头的标定过程,自然光照射下无法从深度图像中区分色彩信息,图像角点无法获取,现有文献中还未有统一的标定方法。邓志红等人[6]提出镂空的棋盘格标定法,在深度图像中获取的角点效果较差,镂空区域的角点位置不稳定,标定结果的重复性差。Herrera D等人[7]选取室内较大物体,如桌子等,选取该物体在深度图像和彩色图像中的边缘点完成标定过程,但在深度图像和彩色图像中物体的边缘点难以准确对应及获取,同时为了获得多组匹配点,一般需要多次的切换视角。针对上述方法中存在的问题,采用一种更加实用,计算更加简便,结果更加准确的标定方法:深度摄像头的标定通过采集红外灯照射下的棋盘格的红外图像进行标定,如此检测到的角点位置更精确,角点数量更多,通过对多次标定结果的拟合,即可得到转换矩阵。

Kinect的深度摄像头是只对红外光成像的摄像头,深度图像中为距离信息,从直接采集的深度图像中无法区分彩色信息,导致无法提取角点。所以将Kinect的红外发射器挡住,另外用一束未经过编码的红外光照射棋盘格,则深度摄像头采集到的图像仍为彩色信息,但点的坐标对应关系并未发生改变。内部参数的获得仍然使用常用的棋盘格标定法进行标定,从深度摄像头坐标系到彩色图像坐标系的转换关系为:

(2)

(3)

Zd=d

(4)

[Xd,Yd,Zd]为空间中点在深度摄像头坐标系下的坐标;[Ud,Vd]为点在深度图像中的坐标;d为深度图像中像素点的深度值;Du,Dv,Dx,Dy为深度摄像头的内部参数。

2.3 联合标定

设定空间中S点在世界坐标系下坐标为[Xw,Yw,Zw];在彩色摄像头坐标系下坐标为[Xr,Yr,Zr],彩色摄像头的外参数矩阵中的旋转矩阵为Rr,平移向量为Tr;在深度摄像头坐标系下坐标为[Xd,Yd,Zd],深度摄像头的外参数矩阵中的旋转矩阵为Rd,平移向量为Td。则摄像头坐标系与世界坐标系间变换关系为:

(5)

(6)

通过选取同一视角下的深度图像与彩色图像进行标定,选择一张正面棋盘的标定图像即可得到Rr,Tr,Rd,Td。

则深度摄像头坐标系与彩色摄像头坐标系之间的转换矩阵为:

(7)

(8)

(9)

3 图像坐标转换

将式(1)~式(4)化为齐次坐标形式,得:

(10)

(11)

由式(7)、式(10)和式(11)可得:

(12)

将式(10)代入式(12)可得最终的坐标转换关系为:

(13)

fx,fy,u0,v0,Du,Dv,Dx,Dy在摄像头单独标定时已经得到,Zr可由式(12)得到,Rdtr与Tdtr在联合标定时得到。这样就得到了彩色图像与深度图像的坐标转换关系。

4 基于大律法的人体区域提取

大律法是由日本学者大律于1979年提出的,是一种自适应的阈值确定方法,又叫最大类间方差法,简称OTSU[8]。在深度图像中,人体区域和背景的深度值有明显的区分。因此,使用大律法选择最佳的分割阈值,该方法计算简单速度快,通过自适应阈值满足前景区域深度值和背景区域深度值之间的类间方差最大,将深度图像中的人体前景区域和背景区域两部分进行分割。

采集的深度图像中像素点的深度值可由该点的灰度值计算得到:

(14)

对深度图像Image,记为前景与背景的分割阈值,前景点数占图像比例为w0,平均深度为d0;背景点数占图像比例为w1,平均深度为d1。图像的总平均深度为:d=w0d0+w1d1。从最小深度值到最大深度值遍历t,当t使得值g=w0(μ0-t)2+w1(μ1-t)2最大时,t即为分割的最佳阈值。对大津法可作如下理解:该式实际上就是类间方差值,阈值t分割出的前景和背景2部分构成了整幅图像,而前景取值d0,概率为w0,背景取为d1,概率为w1,总均值为d,根据方差的定义即得该式。因方差是灰度分布均匀性的一种度量,方差值越大,说明构成图像的2部分差别越大, 当部分目标错分为背景或部分背景错分为目标都会导致2部分差别变小。因此,使类间方差最大的分割意味着错分概率最小。

将深度图像中得到的人体区域按式(13)的坐标转换关系映射到彩色图像中,对应点构成的图像即为彩色图像中的人体区域。

5 实验

5.1 摄像头标定

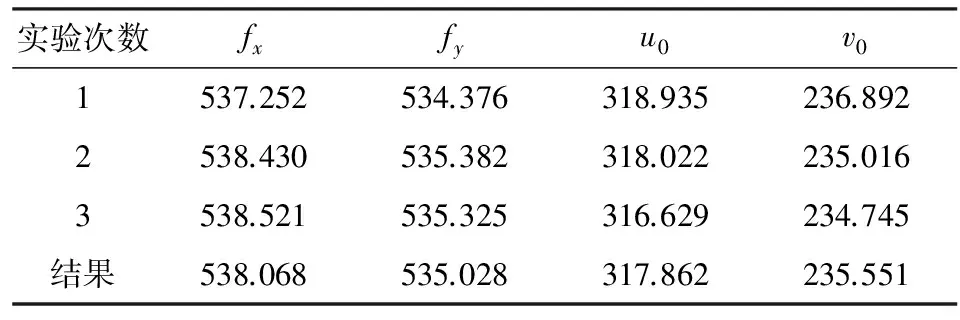

选取12张不在同的视角下拍摄的11×7的棋盘格得到彩色摄像头内部参数的标定结果如表1所示。

表1 彩色摄像头标定结果

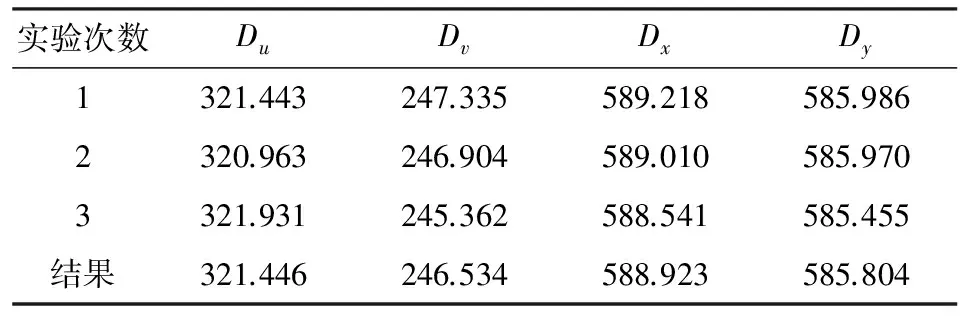

选取12张在不同的视角下拍摄的11×7的棋盘格得到深度摄像头内部参数的标定结果如表2所示。

表2 深度摄像头标定结果

选择一张正面棋盘同一视角下的深度图像与彩色图像进行标定,得到:

由于标定的时候,棋盘格间距按1mm来进行计算,所以,平移矩阵应乘以棋盘格间距为30mm。最终得到:

5.2 提取效果验证

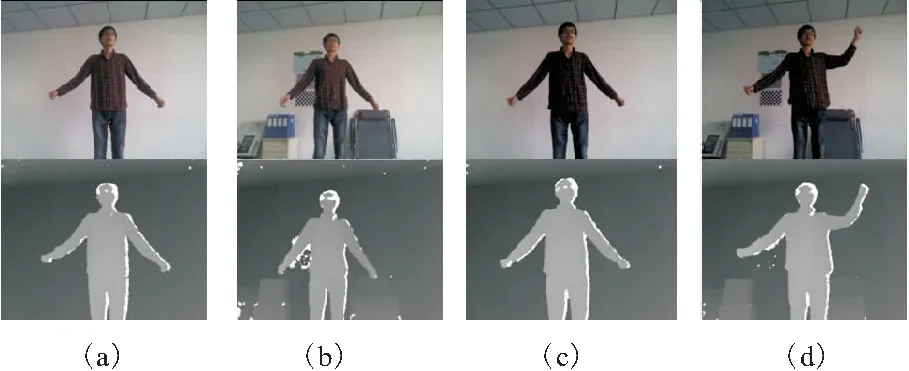

根据背景复杂程度和光照条件的不同将实验图片分为4组。①简单背景理想光照条件下的人体姿态,如图2a所示;②复杂背景和理想光照条件下的人体姿态,如图2b所示;③简单背景和较暗光照条件下的人体姿态,如图2c所示;④复杂背景和较暗光照条件下的人体姿态,如图2d所示。

图2 原始图像采集

分割效果如图3~图4所示。由图4的提取效果对比中可以看出,背景的复杂程度对提取效果几乎无影响,这是由于深度图像提取人体区域时,进行分割的阈值只与距离有关系,与人体和背景的色彩纹理没有关系。

同时可以看出,提取效果几乎不受光线的影响,甚至可以看到较暗光照下分割效果略微好于理想光照,这是由于深度图像的分割效果只与深度摄像头接收到的红外光线有关,光照较强时阳光中的红外线会对摄像头本身的红外光线产生一些影响,但从实验结果看到影响很小,可以忽略。

图3 深度图像分割效果

图4 彩色图像分割效果

6 结束语

针对彩色图像中人体区域提取较困难的问题,尝试将彩色图像与深度图像结合起来使用。在对彩色摄像头和深度摄像头联合标定的过程中,深度摄像头的标定方法不同于以往的方法,以往的方法往往实现起来较复杂,标定结果不可靠,利用未经编码的红外光照射棋盘格得到标定图像,实现起来更加容易,从提取效果来看标定的结果是精确可靠的。

提出的基于联合标定的人体区域提取方法,不仅适用于Kinect的2个独立的深度摄像头和彩色摄像头,也可以利用此方法,来实现对普适环境中人体区域的准确提取。

[1] Bruce J,Balch T,Veloso M.Fast and inexpensive color image segmentation for interactive robots[J].Intelligent Robots and Systems,2000.(IROS 2000).Proceedings,2000IEEE/RSJ International Conference on,2000(3):2061-2066.

[2] Cheng S C.Region-growing approach to color segmentation using 3D clustering and relaxation labeling[J].Vision,Image and Signal Processing,2003,150(4):270-276.

[3] Parker J R.Gray level thresholding in badly illuminated images[J].Pattern Analysis and Machine Intelligence,1991,13(8):813-819.

[4] 曹雏清.面向多方式人际交互的肢体动作识别研究[D].哈尔滨:哈尔滨工业大学,2012.

[5] 狄海进.基于三维视觉的手势跟踪及人机交互中的应用[D].南京:南京大学,2011.

[6] 邓志红,刘明阳,付梦印.一种改进的视觉传感器与激光测距雷达特征匹配点提取算法[J].光学技术,2010,36(1):43-47.

[8] 卜涛涛,卢超.图像分割算法研究[J].电脑知识与技术,2010,6(8):1944-1946.

Image Segmentation Based on Joint Calibration

ZANGTengfei,LIRuifeng,WANGLiangliang

(State Key Laboratory of Robotic and System,Harbin Institute of Technology,Harbin 150001,China)

Concerning the problem that it’s difficult to extract the body region under pervasive environment,we proposed an image segmentation method based on joint calibration of color camera and depth camera.In a complex environment indoors or outdoors,as a depth camera can capture information fast and won’t be affected by the environment,we use OTSU to extract body region from a depth image.Then we use the joint calibration method proposed in this article to get the body region from the color image.At last,by experiments of different backgrounds and illumination conditions,the validity of the method is verified.In this way,our method eliminates the effect of light and complex background on the extraction.Also,our method can extract dynamic or static body region quickly and accurately.Our method is robust and real-time.

pervasive environment;color image;depth image;joint calibration;image segmentation

2014-04-01

国家自然科学基金资助项目(61273339)

TP751

A

1001-2257(2014)08-0003-04

张腾飞(1990-),男,河北定州人,硕士研究生,研究方向为机器视觉;李瑞峰(1965-),男,山西大同人,教授,博士研究生导师,研究方向为智能服务机器人、先进工业机器人;王亮亮(1987-),男,山东临沂人,博士研究生,研究方向为机器视觉。