新变步长自适应算法及其时延估计性能*

2014-03-05叶挺朱赛男

叶挺,朱赛男

(1.南京信息工程大学中国气象局气溶胶与云降水重点开放实验室,南京 210044;2.南京信息工程大学 电子与信息工程学院,南京 210044)

1 引言

自适应滤波是现代信号处理的重要组成部分,被广泛应用在自适应时间延迟、自适应噪声消除等多个方面。由Widrow和Hoff提出的最小均方误差算法是自适应滤波算法中经典、有效的算法之一,结构简单,计算量少。但是,传统的固定步长参数无法在不同应用环境下达到收敛速度、跟踪速率和失调噪声之间的优化折衷。近几年,人们为了解决这问题,提出了各式各样的变步长最小均方误差(Least Mean Square,LMS)滤波算法[1-8]。R.D.Gitlin[1]曾提出了一种变步长自适应滤波算法,其步长因子随着迭代次数n的增加而逐渐减小,算法简单,但是只能应用在非时变系统中。覃景繁等人[2]根据步长因子与误差信号之间的非线性关系,提出了基于Sigmoid函数变步长自适应滤波算法,该算法具有较高的收敛速度,也可以应用在时变系统中,但是在误差e(n)接近于零处变化太大,不具有缓慢变化的特性。文献[3]建立了补偿因子与误差函数之间另一种新的非线性函数关系,它比已有Sigmoid函数简单且在参数稳定后具有缓慢变化的特性,但是在收敛速度上仍存在不足。

本文针对以上非线性函数的变步长滤波算法的收敛速度和稳态缓慢变化之间存在的矛盾,提出了一种新的变步长滤波算法,能更好解决加快收敛速度和减少稳态误差的矛盾。自适应时延估计[9]实验表明,新算法具有更好的性能。

2 新算法描述

文献[3]中LMS自适应滤波算法的步长更新公式为

考虑到 μ(n)=1-1/(1+exp(-αe(n)2))函数的形状和取值范围,新算法引入调节因子P,函数变为

当α固定时,函数的形状随 P的变化如图1所示。

图1 不同P值情况下函数的形状Fig.1 The shape of function with different P value

很明显,当P取较小值时,可以获得较快的收敛速度,但是达到零时,步长变化大;当P取较大值时,收敛速度慢,但是接近零时,步长变化缓慢,具有较小的稳态误差。为了实时地调节函数形状,获得较快的收敛速度和较小的稳态误差,令

即可满足上述的要求。由此得出步长的更新公式为

式中,参数r为0~1之间的常数,决定步长接近零时的平滑程度;参数λ为大于0的常数,当其他参数确定时,决定步长变化的快慢程度。参数α、β的设置与文献[3]一致,r越小,误差接近于零时,步长越平滑;λ越大,初始时收敛速度越快。r、λ的具体值可依据实际情况来设定。当α、β确定时,新算法的步长变化曲线与文献[3]的比较如图2所示。

图2 步长变化曲线Fig.2 Curve for step change γ

图2可见,根据实际情况选r、λ取值,新的步长调整方法较传统的变步长算法可获得更快的收敛速度和更平滑的稳态步长。

对于传统的变步长算法来说,都是以均方误差来调整步长的取值,但是均方误差忽略了独立噪声项的影响而很容易导致性能下降。所以,本文用当前误差与上一个的自相关来控制步长的更新,使得算法更好地接近最佳权值。所以,新算法的步长更新公式为

3 抗干扰处理

3.1 归一化处理

系统的失调与输入向量x(n)成正比,因此,当x(n)较大时,滤波器的失调噪声被严重放大[4]。为了解决这个问题,将权向量失调相对于输入向量x(n)的平方欧式范数进行“归一化”,即以μ(n)/PXX代替μ(n)。在输入较大范围的变化时,系统仍能保持稳定,归一化以后的变步长权系数迭代公式为

其中,参数 δ为小的正常数,它能解决输入向量x(n)较小时引起的数值计算问题[5]。

3.2 最大似然加权抑噪

在自适应时延估计算法中,自适应滤波器就相当于一个相移滤波器,其权向量的峰值位置即为时延估计值。当信噪比很小时,噪声的存在会导致滤波器权向量峰值位置的偏移,出现伪峰,影响时延估计的精度。解决的方法是通过对输入信号加权来改善信号的信噪比,或对信号进行预白化处理。由文献[10]可知,Roth加权法等价于维纳滤波,而平滑相干变换(Smooth Coherence Transform,SCOT)加权在Roth的基础上考虑到两个通道的影响;Eckart加权法是以输出信噪比最大作为优化的标准,但是要对信号和噪声谱进行额外的估计,加大了算法的复杂度;ML加权函数对大信噪比频段给予大的权值,小信噪比频段给予小的权值,从而大大抑制噪声的影响。所以,本文在变步长LMS算法中对自适应滤波器权向量应用最大似然(Maximum Likelihood,ML)加权,来突出峰值并平滑伪峰,降低噪声的影响。ML加权是按输入信号的信噪比进行加权,其加权函数为

将ML加权函数表示为两个自适应的Roth处理的组合形式,从而得到加权后的滤波器权向量为

在娱乐化老虎的过程中,人们的想象力发挥了很大作用。前些年大导演李安拍了个片子《少年派的奇幻漂流》,让我大饱眼福。据说影片中的虎就是象征“欲念”。但我反复看了之后,觉得还是别这么深刻理解才好,因为整部影片画面的华丽美感,远远盖过了哲思气息。

其中,傅里叶变换 w12(f,n)=F[w12(n)],w21(f,n)=F[w21(n)],w12(n)、w21(n)为传递函数,RML(n)的峰值位置是ML加权抑噪后时延估计值的3倍。

4 算法仿真结果与分析

为了验证新算法的正确性,对上述算法进行了自适应时延估计仿真实验。本文算法实验原理框图如图3所示。

图3 本文算法及ML加权抑噪的时延估计Fig.3 TDE based on ML-weighted noise suppression and the algorithm in this paper

设仿真条件:信号s(k)和噪声n1(k)和n2(k)均为零均值平稳随机序列,且三者互不相关;参考噪声输入为均值为1、方差为1的高斯白噪声;输入信号的长度为5000点,固定时延值D=10。自适应滤波器的阶数为15。权向量的初始值为0。

4.1 时间延迟估计

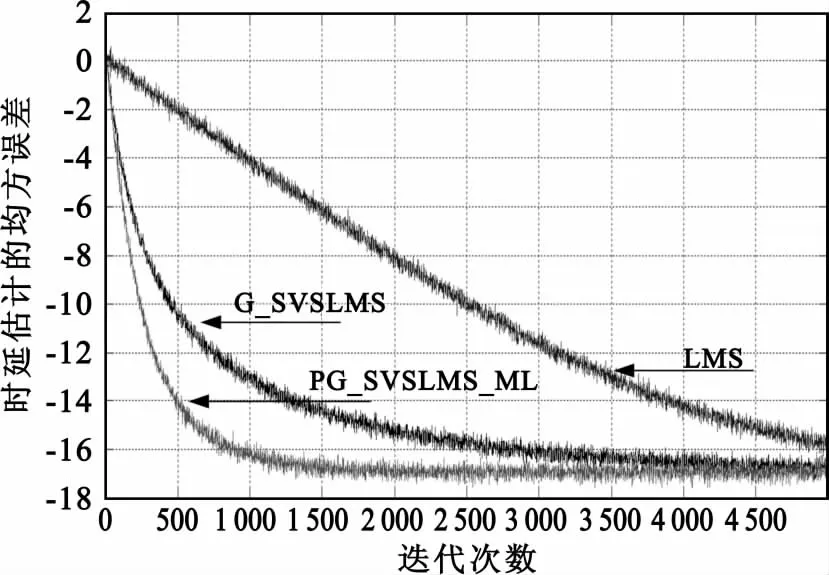

在上述实验的条件下,分别采用LMS、G_SVSLMS[3]和本文的PG_SVSLMS_ML两种时延估计方法对固定时延的两路信号进行时延估计。其中固定步长 μ=0.0005,G_SVSLMS 的参数 α =0.5,β=0.01,本文算法的参数为 α=0.5,β=0.008,γ=0.7,λ=5,SNR=15 dB。图4和图5所示为1000次蒙特卡洛实验结果的平均值。

由图4可见,3种方法都可以实现较准确的时延估计,但是本文提出的新算法可实现更快的收敛速度和较小的稳态误差。很明显,LMS的收敛速度最慢,而本文的算法比 G_SVSLMS算法提高了2000次。从图5可知,本文算法加权后,权向量的峰值更加突出,因而具有更好的抗噪性能。仿真结果表明,本文提出的新算法具有较好的收敛速度和抗噪性能。

图4 收敛曲线图Fig.4 Convergence curve

图5 LMS、G_SVSLMS和本文算法权值分布图Fig.5 Weight distribution for LMS,G_SVSLMS and the algorithm proposed

4.2 抗噪性能分析

为了验证本算法的抗干扰性,分别在不同的信噪比下对两路信号进行时延估计。其中,本文算法的参数为 α=0.5,β=0.001,γ=0.7,λ=5,所得结果为20次蒙特卡洛实验结果。仿真结果如图6和图7所示。

从图6可知,随着信噪比的降低,权向量峰值突出变得越来越不明显。从图7可知,当信噪比大于-1.5 dB时,在固定参数条件下,本文算法可快速地获得精确的时延估计值;当信噪比降到-3 dB时,时延估计值出现误差。

图6 本算法权矢量分布Fig.6 Weight distribution of the proposed algorithm

图7 本算法时延估计收敛曲线Fig.7 Convergence curve of the proposed algorithm

图8 参数调整后,信噪比-3 dB下权向量分布和时延估计收敛曲线Fig.8 The weight vector distribution and convergence curve at SNR=-3 dB when the parameter is adjusted

5 结语

针对变步长自适应算法收敛速度和稳态误差相矛盾的问题,本文在文献[3]的基础上,引入P调节因子,实时地调整非线性函数形状,用误差的自相关函数代替误差函数,避免了独立噪声的影响。在时延估计仿真实验中,本文算法较其他算法具有更快的收敛速度和更小的稳态误差。同时,本文算法及其ML加权可进一步抑制噪声,在选择合适参数的情况下,可实现-3 dB以上信噪比环境下的准确时延估计,具有很好的工程意义。本课题下一步的研究内容就是将本文算法应用在麦克风阵列的声源定位中,实现低信噪比下对声源的实时定位。

[1]Gitlin R D,Weinstein S B.On the design of gradient algorithms for digitally implemented adaptive filters[J].IEEE Transactions on CT,1973(2):125-136.

[2]覃景繁,欧阳景正.一种新的变步长LMS自适应滤波算法[J].数据采集与处理,1997,12(2):171-174.QIN Jing-fan,OUYANG Jing-zheng.New Variable Step Size LMS Adaptive Filtering Algorithm[J].Journal of Data Acquisition & Processing,1997,12(2):171-174.(in Chinese)

[3]高鹰,谢胜利.一种变步长LMS自适应滤波算法及分析[J].电子学报,2001,29(8):1094-1097.GAO Ying,XIE Sheng-li.A Variable Step Size LMS Adaptive Filtering Algorithm and Its Analysis[J].Acta Electronica Sinica,2001,29(8):1094-1097.(in Chinese)

[4]Huang Hsu-Chang,Lee Junghsi.A New Variable Step-Size NLMS Algorithm and Its Performance Analysis[J].Signal Processing,2012,60(4):2055-2060.

[5]Zhao Hai-quan.Novel adaptive VSS-NLMS algorithm for system identification[C]//Proceedings of 2013 Fourth International IEEE Conference on Intelligence Control and Information Processing.Beijing:IEEE,2013:760-764.

[6]贺洪江,王春霞.一种新的LMS自适应滤波算法分析仿真研究[J].传感器与微系统,2012,31(3):15-21.HE Hong-jiang,WANG Chun-xia.Analysis and simulation study on a new LMS self adaptive filtering algorithm[J].Transducer and Microsystem Technologies,2012,31(3):15-21.(in Chinese)

[7]杨逸,曹祥玉,杨群,等.一种基于指数函数的变步长LMS算法[J].传输与接收,2011,35(21):105-107.YANG Yi,CAO Xiang-yu,YANG Qun,et al.New Variable Step Size LMS Algorithm Based on Exponential Function[J].Transmitting & Receiving,2011,35(21):105-107.(in Chinese)

[8]Cakir F,Ozen A.A novel Variable Step Size LMS algorithm employing cross correlation between channel output and error signal[C]//Proceedings of 201220th IEEE Conference on Signal Processing and Communication Applications Conference.Mugla:IEEE,2012:1-4.

[9]Sun Yong-mei,Duan Xiao-xia.Novel variable step-size adaptive LMS time delay estimation algorithm with nonlinear preprocess[C]//Proceedings of 2011 IEEE Congress on Image and Signal Process.Shanghai:IEEE,2011:2767-2770.

[10]Knapp C,Carter,Clifford G.The generalized correlation method for estimation of time delay[J].IEEE Transactions on Acoustic,Speech and Signal Processing,1976,24(4):320-327.