基于全局与局部模型相互制约及具有模型不确定性评估的车道线检测方法

2013-08-15刘晓龙邓志东

刘晓龙 邓志东

(清华大学计算机系,北京 100084)

(清华大学智能技术与系统国家重点实验室,北京 100084)

对城区和高速公路等具有车道线的结构化或半结构化道路交通环境,要实现无人驾驶车辆的自主行驶,完成单一车道的基于摄像机视觉的可靠跟踪与变道超车等功能,车道线的检测、识别与跟踪无疑是最基本与最重要的能力之一.

基于摄像机视觉的有关车道线检测方法的研究,已有较长历史并已应用到各个实验系统中.例如,早在1991年,CMU基于NavLab实现了UNSCARF(非监督分类器un-supervised classification applied to road finding)[1],1993 年则进一步实现了SCARF(监督分类器supervised classification applied to road finding)[2].近年来,车道线检测方法的研究得到了长足的发展.McCall等[3]于2006年实现了一种基于视觉的车道线检测辅助驾驶功能.在这些方法中使用的车道线模型,则经历了直线模型、同心圆模型[4]、二次曲线模型[5]、三次曲线模型和样条曲线模型[6]等,这些模型各有特点,并具有不同的适用条件.在有关车道线跟踪方法的研究中,1998年,Isard等[7]利用条件概率传播模型实现了一种基于粒子滤波的车道线检测方法.Sehestedt等[8]在城区道路中使用了粒子滤波的方法.2012年我们在车道线的检测与跟踪中也利用了粒子滤波方法来提高车道线检测的稳定性[9].其他研究还有使用蒙特卡洛方法进行车道线检测的研究[10],将原始图像变换为俯瞰图进行车道线检测的方法[11],或者与原始图像相结合进行车道线检测的方法[12-13]等.

为了提高车道线检测方法对光照、阴影及地面上其他干扰的适应性,本文提出了一种新的基于全局与局部模型相互制约及具有模型不确定性评估的车道线检测方法.这里的车道线局部模型基于分段直线模型建立,而全局模型则采用了3次B样条曲线.同时通过对扫描点进行不确定性评估,以重新确定扫描范围等.文中面向高速公路进行了大量的真实道路实验.实验结果表明,利用本文方法获得的预瞄点,其平均侧向偏差小于0.3 m,平均角度偏差小于0.03°,能够基本满足无人驾驶车辆在高速公路上进行自主行驶的实际需要.

1 一种新的车道线检测方法

本文提出基于全局模型与局部模型的相互交互来进行车道线的定位检测.这里的局部模型采用了分段直线模型来拟合车道线,以达到去除噪声的目的.而全局车道线模型则采用了3次B样条,并通过对噪声的不确定性估计,为下一次检测划定扫描范围.在指定的扫描范围内,反过来也可更好地去除噪声的干扰.如此反复,通过全局模型与局部模型的相互交互与相互制约,就可实现对车道线的可靠稳定检测与跟踪.

1.1 车道线模型

1)局部模型

为了提高检测的可靠性,局部模型选择了分段直线模型,该模型可以很好地逼近车前近距离的车道线,并可同时处理连续型车道线与断续型车道线等各种情形.

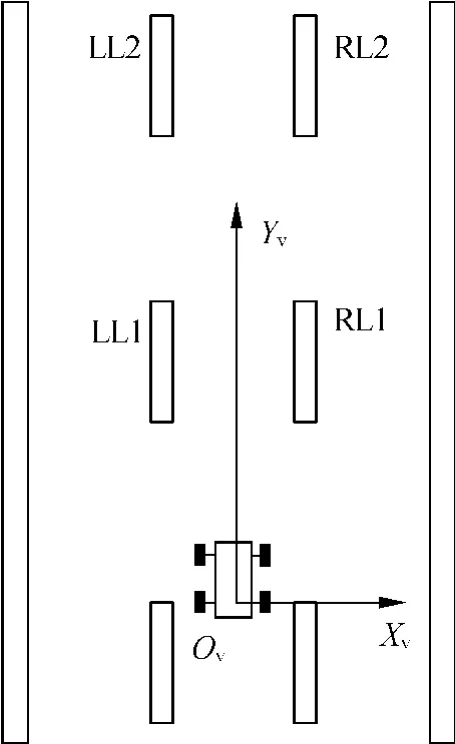

如图1所示,对于车前的车道线,可以按左右、近远划分为4个部分,即LL1,LR1,LL2和LR2.

图1 车道线局部分段直线模型

事实上,从车道线的原始图像中可以非常清晰地观察到前方的4段车道直线,因此该模型的使用具有坚实的数据与实验基础.但对连续的车道线,由于无法区分出车道直线的两端,因此此时需要采取强制分段的方法来实现分段模型的应用.

强制分段的做法是在像素图像中先验地划出一个感兴趣的范围.划分的规则须保证同时至少有一段车道线能进入像素图像的视野.基于检测到的第1段车道线,再进行第2段车道线的范围划分,并在此范围进行检测.

2)全局模型

由于局部模型可以准确地检测到车道线的位置,因此在局部模型基础上可进一步引入全局模型,这里我们使用3次B样条曲线作为车道线的全局模型.

3次B样条控形能力强,变差小,具有二阶导数的连续性,在自由曲线和曲面设计中得到了广泛的应用.非均匀3次B样条曲线具有局部性、几何不变性、连续性、对称性、递推性、凸包性和变差缩减性等性质[14].

根据局部模型的检测结果,若能准确地给出车道线上的若干点,则能够实现3次B样条曲线的插值.对于左侧和右侧分别提取出的车道线直线段LL1,LL2和LR1,LR2,可对其4个端点采用3次B样条进行插值,并据此将左右车道线分别用插值点点集来表示.

1.2 不确定性评估

在车道线局部模型的检测过程中,不可避免地存在来自光照与路面阴影等各种噪声干扰,因此需要对检测到的车道线进行不确定性评估.考虑到道路感知不但有可见光视觉,而且还有基于激光雷达与毫米波雷达的马路牙子检测等,因此检测车道线并进行相应的不确定性评估,还可以实现多源异构传感器的信息融合.

不确定性评估可以基于多种指标进行描述,比如标准离差、高斯度等.考虑到计算的实时性,本文采用均方根值作为置信度,即根据扫描点到样条曲线的距离,取均方根作为置信度,最后进行归一化处理作为扫描范围和数据融合的依据.

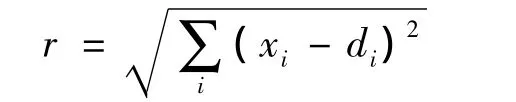

为简化计算,按行扫描,取每个点到对应行的列距离,即x坐标的差值进行计算:

式中,di为样条曲线上的对应点;xi为扫描到的对应点.这里r被称为置信度.

计算出的置信度r通常需要进行归一化处理,即→r=min(kr,1),→r为归一化后的置信度.经过比例因子k的处理,若大于1则认为是1,若小于1,则取乘积值,这里k的取值可根据经验数据确定.

1.3 一种基于全局与局部模型相互制约及具有模型不确定性评估的车道线检测方法

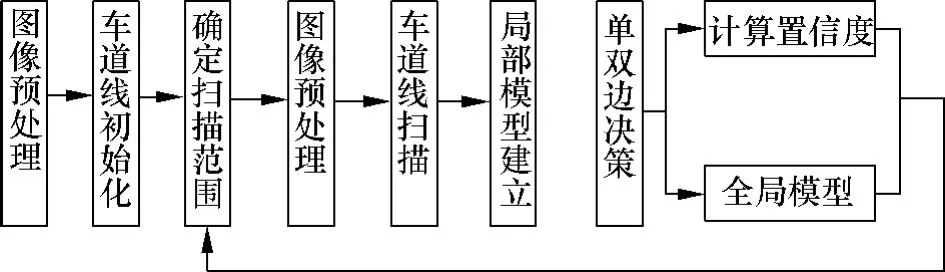

在进行车道线检测之前,需要首先完成摄像机的标定工作,以便得到摄像机的内参数和畸变参数等,此处不再讨论.本文提出的基于可见光摄像机的车道线检测系统,其结构框图如图2所示.

图2 车道线检测框图

1.3.1 车道线检测的初始化

为简化车道线追踪的过程,假设车停在车道线内,且基本与车道线平行,车道线中间无其他的标志转弯或者直道等标志信息.保证车道线边缘清晰以便容易检测.

1)初始扫描范围的确定

大部分的其他信息在车道线检测中并不需要,因此采用剪切的方式,提取出可能是车道线的范围.根据车的初试位置假设,可以大致确定左边车道线和右边车道线的大致范围.

如图3所示,左侧车道线和右侧扫描范围.在车初试位置假设条件下,只提取出图中所示2块区域就可以得到左侧车道线和右侧车道线的信息.

图3 车道线扫描范围的划定

而在此扫描范围划定后,可以在此范围内计算均值,得到二值化的阈值信息,将更好地反映出车道线邻近的光照变化,从而减少与其他区域光照影响的相关度.

2)检测LL1,LR1

在以上划定范围的图像中,可以很轻松地区分出左侧车道线和右侧车道线.以左侧车道线为例,进行初始检测的描述.

在左侧车道线扫描范围内,进行双阈值二值化.利用霍夫变换,能够检测到一系列的直线,并且同一段直线可能出现分成2段的可能性.需要对检测到的直线进行聚类.

聚类的规则是,任意2个直线的斜率差小于某阈值,截距差也小于某一阈值,可以认为是同一个类内的直线.然后对直线进行合并,合并的规则为斜率和截距都取两直线的均值,直线的长度取最长的一条.然后与新的直线进行判别,若是属于同一类则进行合并,如果不满足要求则建立一个新的类.聚类最后可以得到一条或者几条直线.选择LL1的规则为在聚类后的结果中选择最长的直线作为LL1.同此原则可以得到LR1.

3)检测LL2,LR2

根据检测出来的LL1,在LL1的最上端,加上一个固定值,作为扫描第2段范围的下边界,重复第1段的检测方法则可以得到第2段的LL2值.同理可得到LR2.

若车道线不是分段的,而是连续的,则不存在第1段的上边界作为第2段的下边界.可以利用强制分段的方法来解决此问题.

当得到4段车道线后,则根据局部模型进行3次B样条的插值得到全局模型,如图4所示.左侧车道和右侧车道线均线插值为直线.8个提取出来的控制点作为强制控制点,将成为B样条拟合用的基准点.中间线为经过双侧车道线进行取均值后得到的直线,并且如果是运行在单边模式,则根据实时的路宽平移半个车道的宽度进行计算.

图4 初始检测结果

初始化的过程中还能得到车道的宽度信息,且此信息在进行维护的时候可进行实时更新.

1.3.2 全局与局部模型的建立

根据初始检测得到的左右车道线的信息,可以确定出初始的扫描范围,并基于新的扫描范围完成内侧车道线的扫描.

对扫描得到的一系列点,右侧处理方式与左侧相同,这里不妨以左侧为例予以说明.若左侧得到的扫描点很清晰,则可基于Hough变换方法对扫描点进行直线检测,且取其中最长的直线作为LL1.记录下LL1的斜率和截距信息,根据强制取直线上固定点的方法得到2个基准点.通过第LL1的上端点,可以确定出第2段的扫描范围点.

在第2段的扫描范围内,同样可采用Hough变换方法检测直线.检测到的直线取最长的作为LL2,即认为检测到的直线越长,其越可能是车道线.

如果LL2能够被检测到,还要满足其与LL1的相互约束关系.设定的规则为LL2的斜率与LL1的斜率差和截距差均要小于相应的设定阈值.此阈值需要通过实际调试来确定.如果太小,则不容易检测到LL2;如果太大,则容易引入干扰.

强度图的加入可以增加对抗阴影的能力.由于强度图扫描得到的点在车道线的中间,这是宽度滤波器的作用.如果车道线边缘比较清晰,则不会扫描到强度图信息.反之,如果车道线边缘不清晰,则可以扫描到强度图信息,从而避免扫描到路缘等周围的其他信息使检测结果产生较大的误差.事实证明,此法可在很大程度上提高了车道线在阴影区域的检测可靠性.

检测到4条直线则可以建立左右车道线的局部模型.得到局部模型后以左侧车道线为例,从2条线上取4个点作为全局模型的基准点,从而通过3次B样条建立相应的全局模型.

进一步利用前述的基于均方根的置信度计算方法,可得到单侧车道线的不确定性评估值.同理也可完成右侧车道线的处理.

2 实验结果与分析

实验平台采用清华大学最新研制的新一代无人驾驶汽车THU-ALV2,如图5所示.可见光摄像机采用高速黑白相机.试验测试环境为G7高速公路(北京五环路-北清路段),长度约有5 km左右.

图5 清华新一代无人驾驶汽车THU-ALV2

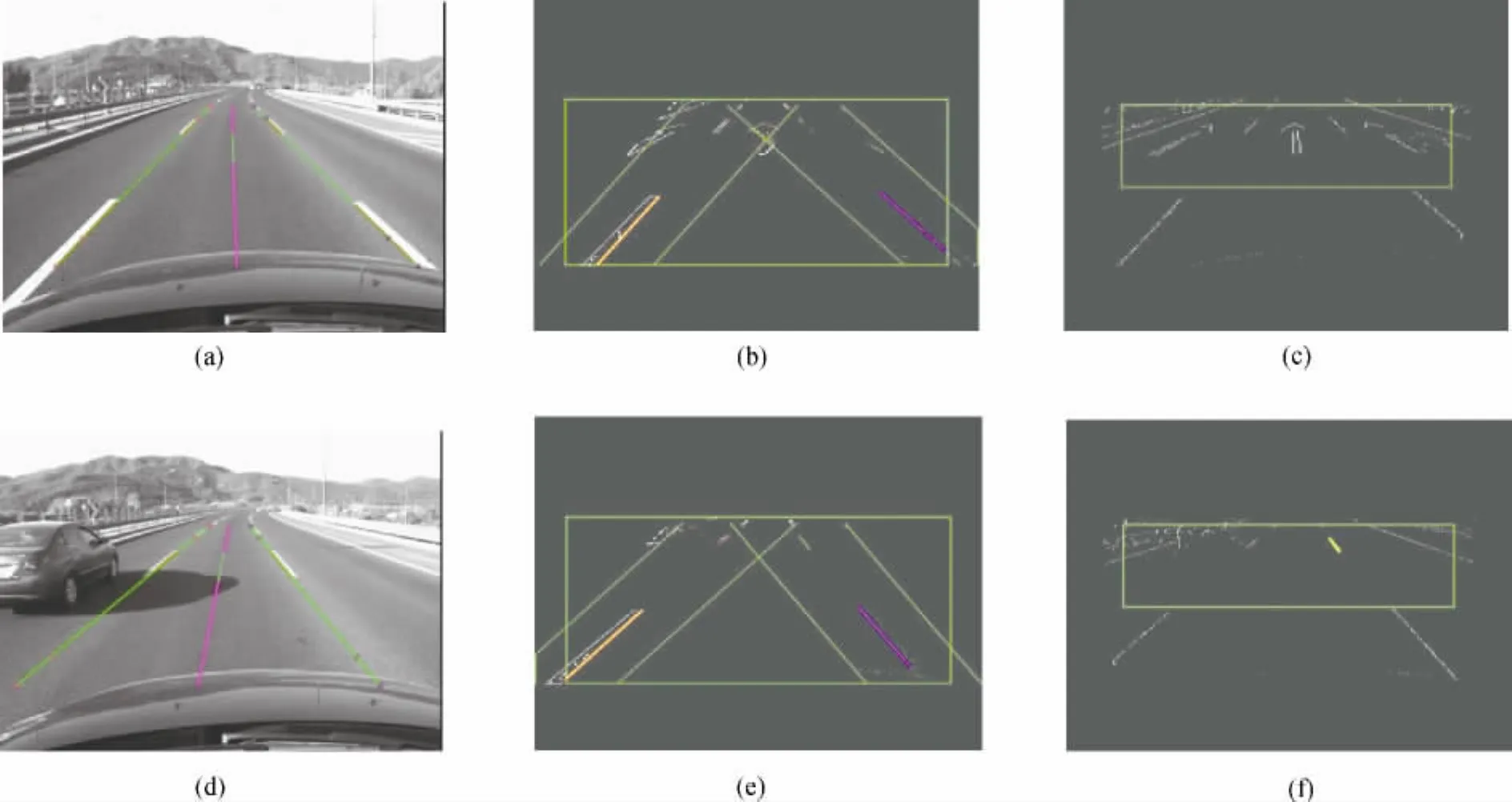

高速公路上的干扰相对较少,主要来自光照变化和路面阴影等.此外也有诸如地上的箭头、多层车道线等指示性信息所带来的干扰.高速公路自主行驶试验结果,如图6所示.其中,图6(a)为车道线检测结果图,图6(b)为二值化后的结果显示,图6(c)为强度过滤后的显示图;图6(d)、(e)、(f)为对应的结果显示,但路况为有其他车辆干扰.

图6 高速公路试验结果

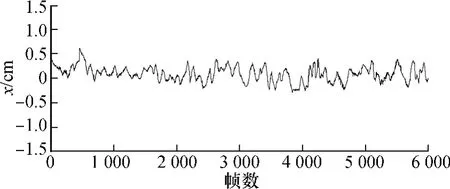

如图7所示,我们截取了约200 s的侧向位置数据,其中横轴表示帧数(帧率为30帧/s),纵轴表示局部坐标系下的侧向位置x,单位为cm.由于高速公路弯道平缓,因此没有出现较大的x值.从图中可以看出,x值一直在0附近波动,无野值出现,这与无人驾驶车辆平稳自主行驶的实际情况相符.图8给出了预瞄点处的航向角度值.显然,航向角并未出现较大的波动,符合高速公路自主行驶的实际情况.

图7 预瞄点侧向位置值x

图8 预瞄点航向角度值Ψ

无人车在正常速度下行驶,长时间内会出现车道向左或向右转弯的情况,因此我们截取了从起初10 s到20 s内的10 s数据,在70 km/h的车速下无人驾驶车辆一共行驶了194.4 m.在此时间段内假定车道线曲率不变,相应的测试结果如图9所示.

图9 10 s内预瞄点侧向位置x和航向角Ψ

从图9可以看出,10 s内预瞄点侧向位置x的均值与方差分别为0.3113和0.0194;航向角Ψ的均值与方差分别为0.0131和4.7484×10-5.进一步分析表明,侧向位移最大误差为0.3026 m,方差为 0.0194;航向角最大误差为 0.0247°,方差为0.00047484.显然侧向位置与航向误差及其方差都很小.实际测试时车速小于70 km/h,无人驾驶车辆运行平稳,车道线检测稳定可靠,且满足实时性的要求.

3 结语

本文提出了一种新的基于全局与局部模型相互制约及具有模型不确定性评估的车道线检测方法.实验结果表明,采用此方法获得的侧向定位误差小于0.3 m,航向定位误差小于0.03°,能够基本满足无人驾驶车辆在高速公路自主行驶的实际需要.

由于车道线检测是基于扫描的方法,如果中途路况复杂,导致车道线丢失,车道线就会进入初始化阶段.由于初始化扫描范围较小,并且存在一些假定(如车道线非常干净且无人驾驶车辆位于车道线中间),因此此时或会出现车道线重新检测时延或者不能重新找回车道线的情况.未来我们将进一步提高重新检测的可靠性,以便结合本文提出的方法,进行更大范围的应用.

References)

[1]Crisman J.UNSCARF:a color vision system for the detection of unstructured roads[C]//Proceedings of IEEE International Conference on Robotics and Automation.Sacnunento,CA,USA,1991:2496-2501.

[2]Crisman J D.SCARF:a color vision system that tracks road sand intersections[J].IEEE Transactions on Robotics and Automation,1993,9(1):49-58.

[3]McCall J C,Trivedi M M.Video-based lane estimation and tracking for driver assistance:survey,system,and evaluation[J].IEEE Transactions on Intelligent Transportation Systems,2006,7(1):20-37.

[4]Kluge K,Thorpe C.The YARF system for vision-based road following[J].Mathmatical and Computer Modelling,1995,22(4/5/6/7):213-233.

[5]Kluge K.Extracting road curvature and orientation from image edge points without perceptual grouping into features[C]//Proceedings of the Intelligent Vehicles'94 Symposium.Paris,France,1994:109-114.

[6]Zhao Kun,Meuter M,Nunn C,et al.A novel multilane detection and tracking system[C]//Proceedings of 2012 IEEE Intelligent Vehicles Symposium.Madrid,Spain,2012:1084-1089.

[7]Isard M, Black A. CONDENSATION—conditional density propagation for visual tracking[J].International Journal of Computer Vision,1998,29(1):5-28.

[8]Sehestedt S,Kodagoda S,Alempijevic A,et al.Robust lane detection in urban environments[C]//Proceedings of the 2007 IEEE/RSJ International Conference on Intelligent Robots and Systems.San Diego,CA,USA,2007:123-128.

[9]Yao Wentao,Deng Zhidong,Chen Zhenhua.A global and local condensation for lane tracking[C]//Proceedings of 2012 International IEEE Conference on Intelligent Transportation Systems(ITSC).Anchorage,AK,USA,2012:276-281.

[10]Wang Yanqing,Chen Deyun,Shi Chaoxia et al.Vision-based road detection by Monte Carlo method[J].Information Technology Journal,2010,9(3):481-487.

[11]Bertozzi M,Broggi A.Gold:a parallel real-time stereo vision system for generic obstacle and lane detection[J].IEEE Transactions on Image Processing,1998,7(1):62-81.

[12]Kim Z.Robust lane detection and tracking in challenging scenarios[J].IEEE Transactions on Intelligent Transportation Systems,2008,9(1):16-26.

[13]Wang Y,Bai L,Fairhurst M.Robust road modeling and tracking using condensation[J].IEEE Transactions on Intelligent Transportation Systems,2008,9(4):570-579.

[14]穆国旺.非均匀有理B样条[M].北京:清华大学出版社,2010:50-52.