基于关键帧的人体行为识别方法

2013-07-20吴志杰

成 勋,常 飞,吴志杰

1.中国工程物理研究院 研究生部,四川 绵阳 621900

2.中国工程物理研究院 计算机应用研究所,四川 绵阳 621900

3.中国工程物理研究院 纪委监察局,四川 绵阳 621900

基于关键帧的人体行为识别方法

成 勋1,常 飞2,吴志杰3

1.中国工程物理研究院 研究生部,四川 绵阳 621900

2.中国工程物理研究院 计算机应用研究所,四川 绵阳 621900

3.中国工程物理研究院 纪委监察局,四川 绵阳 621900

1 引言

由于基于视频流的人体行为识别在智能安防,人机交互,虚拟现实,视频标注等领域有着重要的应用价值,成为了近些年计算机视觉中的热点研究方向[1]。从运动序列中提取合适的特征描述人体运动状态是人体行为识别的关键问题。根据行为识别基于的特征不同可以将识别法分为四类:(1)基于人体轮廓形状的识别,包括平面几何下的二维轮廓[2]和时空状态下的三维轮廓[3];(2)基于几何描述的识别方法[4],该方法将人体表示为多个骨骼模型链接而成,通过刚体部分的运动和相对关系描述人体运动,从而实现人体行为识别;(3)基于运动信息的行为识别,该方法采用运动场模型如光流[5]提取人体运动信息;(4)基于时空特征点的行为识别,例如人体的局部信息包括角点信息[6]和时空兴趣点信息[7]来描述人体运动状态。由于图像质量,分辨率,背景是否固定不变,应用的实时性等因素影响,不同的方法有不同的应用场景。

近些年,基于视频流的前景分割和目标提取等相关技术逐渐成熟,在较多的场景下完整准确地提取运动的人体剪影成为了可能,因此基于剪影的人体行为识别有着较为广泛的应用。印等[8]针对Radon变换对缩放敏感的问题,采用改进的Radon变换提取运动人体区域最小外接矩形的Radon变换特征,并采用隐马尔可夫模型进行行为识别。Abdelkader等[9]则采用一种平方根的方法对人体轮廓进行描述,通过将人体姿态看着闭合曲线形状空间中的一点,将行为识别转化为形状空间中动态轨迹匹配问题,并且采用模板匹配法和隐马尔可夫模型实现了人体行为识别。

本文提出了一种基于人体轮廓的行为识别方法,主要包括行为描述与行为识别两个方面。对于行为描述采用基于弧长的方向函数对人体轮廓进行描述,该描述方法具有较高的鲁棒性和缩放不变性。行为识别包括训练与识别两个阶段。为了提高识别的准确性和实时性,提取样本的关键帧,通过关键帧实现行为识别。主要过程如下:首先采用背景差分法得到人体剪影,经过预处理得到光滑人体轮廓,并且通过对人体外接矩形宽高比曲线的分析提取关键帧。然后采用基于弧长的方向函数对人体轮廓进行描述,并且通过微分流形中两点间的测地线距离对相似度进行度量。最后通过聚类算法得到人体姿态模板,实现了人体行为识别。

2 关键帧检测

关键帧提取是指从原始视频序列中提取出能够反映视频内容的少数几帧图像。通过视频中的关键帧代表该视频能够极大地减少视频处理的计算复杂度,是视频分析和基于内容检索的重要步骤。关键帧的选取需要具有代表性,能够反映视频的序列的主要内容并且需要根据内容的变化程度确定关键帧的数目,通常内容变化大的视频需要更多的关键帧表示。对于一些简单的人体行为,通过视频序列中的少量几帧关键图像就可以进行有效的识别。

首先采用背景消减法提取运动的人体目标,获取人体剪影的二值图像序列。然后计算人体轮廓的外接矩形的宽度w(i)与高度h(i)比(简称宽高比),并且绘制该比值随时间变化的曲线图,设在视频序列中t时刻,人体轮廓的外接矩形的宽度为w(t),高度为h(t),人体轮廓的宽高比计算:

对于一些近似周期性的行为,如CASIA单人行为数据库中的步行、奔跑、弯腰走等,人体外界矩形的宽高比随时间呈现周期性变化,定义在一个周期内,宽高比函数的极值点对应的帧为关键帧。对于非周期性行为,如跌倒,定义宽高比函数的全局极值点对应的帧为关键帧。由于运动姿态本身以及噪音的干扰等原因,在相邻的数帧内可能出现多个小的峰值,为了准确地获取关键帧需要对宽高比曲线进行平滑。采用滑动平均的方法对曲线进行平滑。设滑动平均函数为h(c,wl),其中,c为待平滑的数据,wl为平滑窗口的长度。令为平滑后的宽高比

对于人体的移动行为,如步行、跑步、跳跃等,注意到人体外接轮廓的宽高比的极小值对应的人体姿态往往代表的是人体直立状态,包含可以识别的特征十分少,而对于宽高比的极大值对应的人体姿态往往是人体肢体展开最大时对应的人体姿态,包含了较多的可供识别的行为特征,因此,取极值序列中的极大值对应的帧作为行为识别的关键帧,忽略极小值。

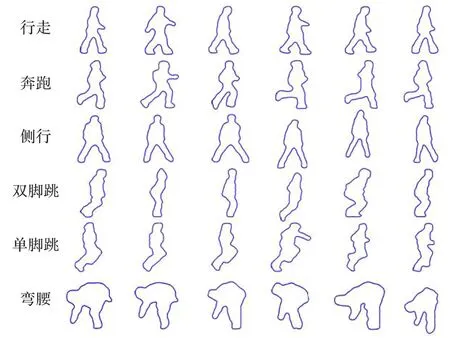

通过背景剪除法得到的二值剪影图像具有噪音,空洞以及非连通区域等干扰,为了准确地提取人体的外接轮廓采用文献[10]提供的方法对其进行预处理,并且通过边界的离散傅里叶变换得到光滑的人体轮廓曲线。图1为 Weismann数据库中检测到的部分关键帧,经过预处理后的示意图。

图1 Weismann数据库中检测到的行为关键帧

3 人体形状描述与相似性度量

文献[11]采用一种关于弧长的方向函数和曲率函数对二维平面上的闭合曲线进行描述,并且通过构造基于方向函数和曲率函数的形状空间,将平面上简单闭合曲线嵌入到无限维微分流形中,每一条曲线都可以看成是该流形上的一个点。并且在该微分流形上定义黎曼度量,通过流形上两点间的测地线距离定义形状间的相似度。本文引入其相关方法对人体轮廓进行描述。

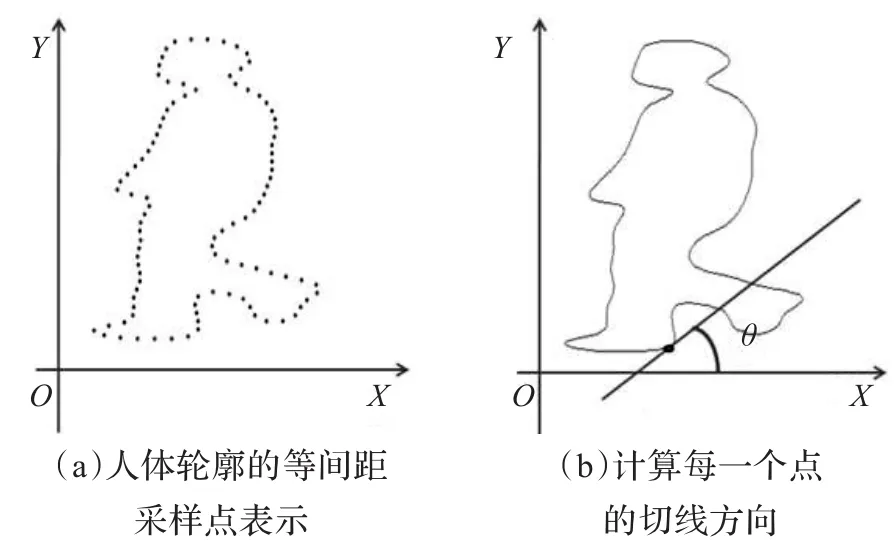

上一章中得到表征人体行为的关键帧以及人体姿态的光滑闭合曲线。首先采用文献[12]中的方法对该曲线进行等间距采样,采样点总数为N。然后,计算每一个采样点的切线方向θi,θi∈[0,2π],i=1,2,…,N,该方向定义为切线与坐标轴的X轴的正方向的夹角,如图2所示。

由中国造纸协会生活用纸专业委员会承办的《生活用纸》杂志,自1993年创刊以来,经过20多年的不断努力和改进,已成为生活用纸及相关行业从业人员的重要信息来源和参考资料。

图2 人体轮廓的切线方向

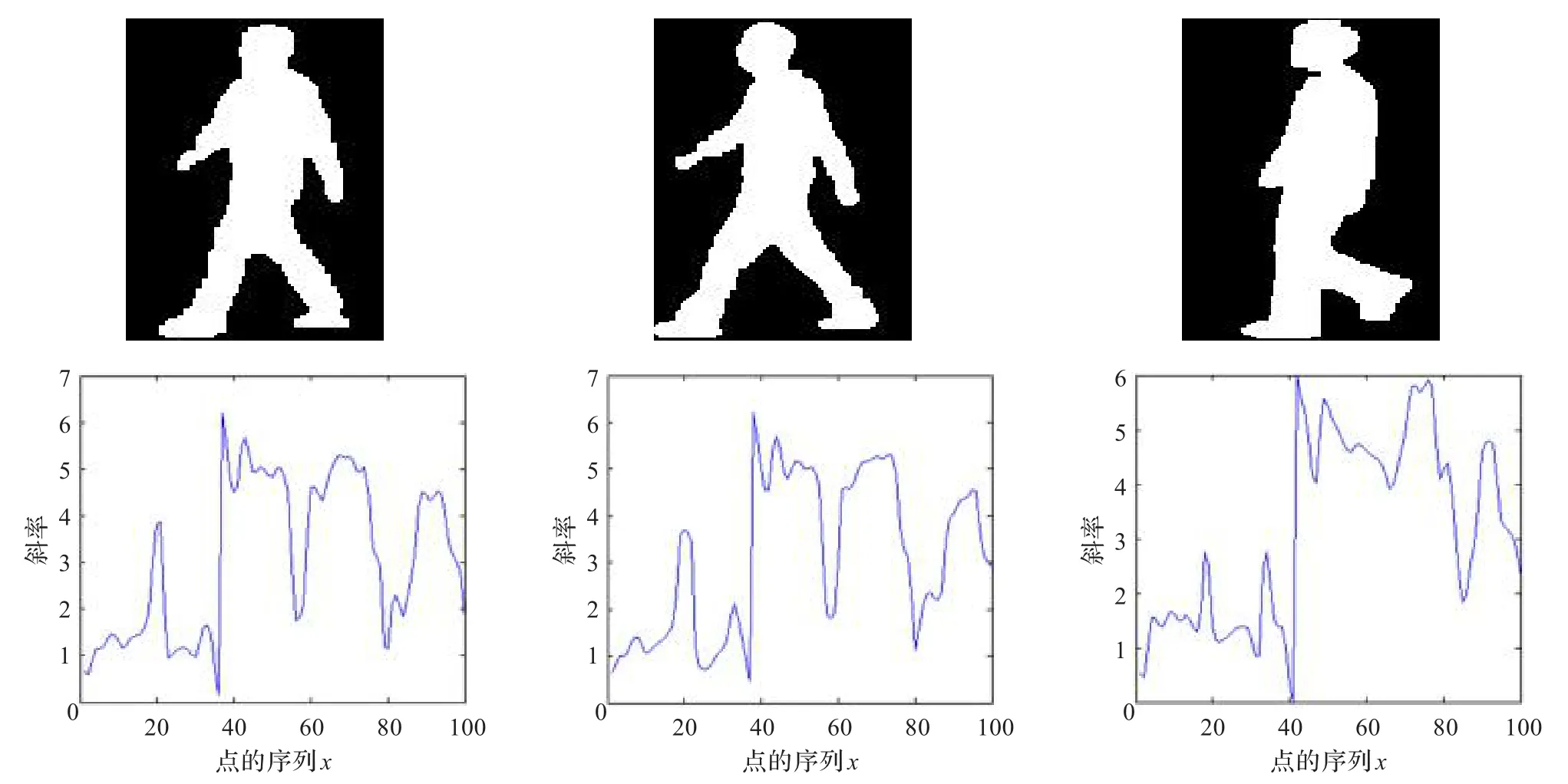

由于人体轮廓通常处于直立状态,不需要考虑人体形状的旋转性,不妨选取一个固定点作为采样点的起始点,定义该点为距离坐标轴原点最近的点。于是由采样点的切线方向构成的序列(θ1,θ2,…,θN)唯一表示了二维平面中的一条闭合曲线。图3为人体轮廓剪影与其相对应的方向函数表示。

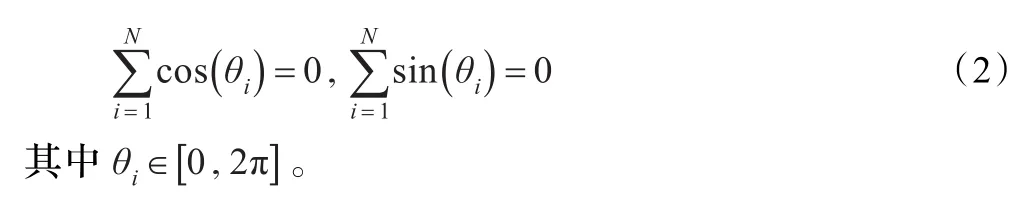

注意到θi,i=1,2,…,N为曲线关于弧长的方向函数θ(s)的一个子集,其满足下面约束:

图3 人体轮廓的方向函数表示

寻找N维流形上两点θ1和θ2之间的测地线是十分困难的,通常通过离散的数值计算的方法,构建一条近似最短路径作为测地线。Klassen等[11]采用了一种打靶法寻找到了一条近似的测地线,该方法的基本思想是:首先计算形状θ1处的切平面,选取该平面上的一条切向量f使得连接θ1和θ2两点间的曲线能量最小,然后通过指数映射将向量指向的一点映射到Cc中得到点θ1′,在该点处寻找下一个切向量,直到将θ1和θ2用分段曲线连接起来,该连线近似为测地线。Srivastava等人[13]通过一种路径拉直的方法找到了一条局部最短距离的测地线:首先任意构建一条曲线连接形状空间中的两个点,然后逐步拉直这条曲线,使之不断接近测地线。由于前一种方法容易陷入局部最短路径,选择第二种方法计算人体轮廓间相似性。定义θ1和θ2之间的测地线距离的负值为两者间的相似度。

4 训练关键帧模板与行为识别

行为识别整体过程分为模板训练与模板匹配两个阶段。在训练阶段,对于每一类行为的训练样本首先提取其关键帧,并对关键帧进行聚类得到具有代表性的姿态模板。选择训练数据中的同一类型的多个行为实例,采用AP(Affinity Propagation)聚类算法[14]获取该类行为的关键帧模板。AP算法通过数据点之间的信息传播来寻找代表点,将每一个数据点看做网络中的一个节点,节点之间迭代地传递实值信息,直到稳定的聚类出现。算法的输入为样本间的相似度矩阵,相比k均值聚类算法和模糊聚类算法,不需要事先人工定义聚类数目。

通过对关键帧进行聚类,得到每一类动作的几个具有代表性的关键帧模板。在识别阶段,提取测试样本的关键帧与训练阶段得到的模板进行匹配。设数据库中的行为类型总数为N,行为分别表示为A1,A2,…,AN。在行为识别过程中,首先提取测试数据的关键帧{C1,C2,…,Ck}。

若k=1,提取该帧中的人体姿态,与每一种行为的姿态模板进行比较,计算其相似度,取与其相似度最大的模板所属的行为类别作为识别结果。

其中,C表示测试数据,表示行为An的关键帧模板集合,表示C与集合中所有数据的相似度最大值。

若k>1,计算加权相似度,每一个关键帧的权值为1/k。

5 实验结果与分析

分别采用Weismann人体行为数据库以及CASIA单人行为数据库进行测试。其中Weismann数据库共包含了90个视频,视频中包含10个自然动作,分别由9名实验人员完成。视频的分辨率为180像素×144像素,速率为50 frame/s。CASIA单人行为数据库分辨率为320×240,速率为25 frame/s,包含八种行为,分别为行走、奔跑、弯腰走、跳行、下蹲、晕倒、徘徊和砸车,每种行为由24实验人员在3个不同视角(平视、斜视、俯视)下分别完成4次。选取CASIA单人行为数据库中在平视视角下的行走、奔跑、弯腰走、跳行、下蹲、晕倒这六种行为进行测试。

在前景检测阶段文中采用的是Barnich等人提供的Vibe算法[15]。对人体剪影的四连通边界的点集表示进行离散傅里叶变换,采用描绘子中的10%的数据对人体轮廓进行重构得到平滑的人体轮廓。对每一个人体轮廓等间距进行采样,采样点个数为100。

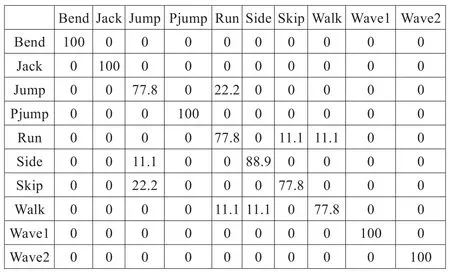

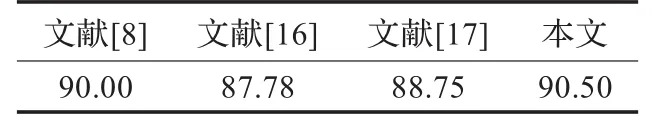

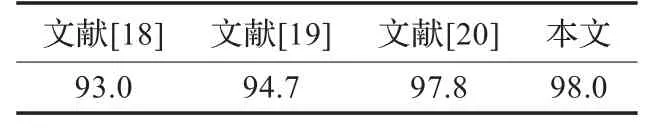

对于周期行为如步行、奔跑等每个周期内的视频片段作为测试样本。测试过程中采用的是留一交叉验证法(Leave-One-Out Cross-Validation),即每一轮验证选取一个个体的所有动作作为测试数据,其余个体的所有动作作为训练数据,轮流对每一个个体进行测试。测试结果如图4和图5所示。对比近些年较为流行的基于剪影的行为识别方法,本文提出的方法的平均识别率比部分文献中提出的方法略高,如表1和表2所示。

图4 Weismann数据库行为识别混淆矩阵(%)

图5 CASIA单人行为数据库行为识别混淆矩阵(%)

表1 Weismann数据库不同方法的识别率比较 (%)

表2 CASIA数据库不同方法的识别率比较 (%)

对于Weismann数据库,相似的行为易造成误判,如单脚跳越和向前蹦跳,步行与跑步等行为,其原因是采用背景减除法提取的人体剪影包含噪音,不同实验者实施同一种行为具有较大的差异以及一些不同的类型行为本身具有很大相似性。对于CASIA数据库取得了较高的平均识别率,主要由于下蹲和晕倒以及弯腰走这类行为的人体轮廓特征十分明显,较容易识别。而步行、奔跑和跳行这三类行为容易混淆。

6 结论

文中采用基于弧长的方向函数对人体轮廓进行描述,并且通过微分流形中两点间的测地线距离对相似度进行度量,为了提高识别的实时性,结合关键帧检测的方法实现了人体行为识别。实验证明,该方法具有较高的识别率。

[1]Ronald P.A survey on vision-based human action recognition[J].Image and Vision Computing,2010,28(6):976-990.

[2]Kellokumpu V,Pietikainen M,Heikkila J.Human activity recognition using sequences of postures[C]//IAPR Conf Machine Vision Applications,2005.

[3]黄飞跃,徐光祐.视角无关的动作识别[J].软件学报,2008,19(7).

[4]Green R D,Guan Ling.Quantifying and recognizing human movement patterns from monocular video images——part I:a new framework for modeling human motion[J].IEEE Trans on Circuits and Systems for Video Technology,2004,14(2).

[5]Efros A,Berg A,Mori G,et al.Recognizing action at a distance[C]//Proc Int’l Conf Computer Vision,2003:726-733.

[6]Harris C,Stephens M.A combined corner and edge detector[C]// Alvey Vision Conference,1988:147-152.

[7]Laptev I.On space-time interest points[J].Int’l J Computer Vision,2005,64(2/3):107-123.

[8]印勇,张晶,王建东.人体行为识别的改进Radon变换方法[J].计算机工程与应用,2012,48(11):196-200.

[9]Abdelkader M F,Abd-Almageed W,Srivastava A,et al.Silhouette-based gesture and action recognition via modeling trajectories on Riemannian shape manifolds[J].Computer Vision and Image Understanding,2011,115:439-455.

[10]张军.基于视频的运动人体异常行为分析识别研究[D].西安:西安电子科技大学,2009.

[11]Klassen E,Srivastava A,Mio W,et al.Analysis of planar shapes using geodesic paths on shape spaces[J].IEEE Trans on Pattern Anal Mach Intell,2004,26(4).

[12]赵宇,陈雁秋.曲线描述的一种方法:夹角链码[J].软件学报,2004,15(2).

[13]Srivastava A,Klassen E,Joshi S H,et al.Shape analysis of elastic curves in euclidean spaces[J].IEEE Trans on Pattern Anal Machine Intell,2011,33.

[14]Frey B J,Dueck D.Clustering by passing messages between data points[J].Science,2007,315(5814):972-976.

[15]Olivier B,Marc V D.Vibe:a universal background subtraction for video sequences[J].IEEE Transactions on Image Processing,2011,20(6).

[16]Chen Yan,Wu Qiang,He Xiangjian.Human action recognition by Radon transform[C]//Proceedings of IEEE International Conference on Data Mining Workshops,Pisa,2008:862-868.

[17]赵海勇,刘志镜,张浩.基于轮廓特征的人体行为识别[J].光电子·激光,2010,21(10).

[18]Oikonomopoulos A,Pantic M,Patras I.Sparse B-spline polynomial descriptors for human activity recognition[J].Image and Vision Computing,2009,27(12):1814-1825.

[19]Ikizler N,Duygulu P.Histogram of oriented rectangles:a new pose descriptor for human action recognition[J].Image and Vision Computing,2009,27(10):1515-1526.

[20]Zhang Hao,Liu Zhijin,Zhao Haiyong,et al.Recognizing human activities by key frame in video sequences[J].Journal of Software,2010,5(8):818-825.

CHENG Xun1,CHANG Fei2,WU Zhijie3

1.Graduate Division of China Academy of Engineering Physics,Mianyang,Sichuan 621900,China

2.Institute of Computer Science and Application of China Academy of Engineering Physics,Mianyang,Sichuan 621900,China

3.Commission for Discipline Inspection and Supervision Bureau of China Academy of Engineering Physics,Mianyang,Sichuan 621900,China

This paper addresses an approach which uses the direction function on the arc length to describe the body shape and the geodesic distance between any two points in the shape spaces to measure the similarity of shapes.It extracts key frames in the video sequence and recognizes the human action based on the template matching approach.The experimental results on the CASIA single behavior database and the Weismann database show that the method has a high recognition rate.

action recognition;key-frame detection;similarity measure

提出了一种基于关键帧的人体行为识别方法。利用关于弧长的方向函数对人体形状进行描述以及通过形状空间中两点间的测地线距离对形状间的相似性进行度量,提取视频序列中的关键帧,通过模板匹配的方法实现对行为的识别。对CASIA单人行为数据库和Weismann数据库进行测试,实验结果表明该方法具有较高的识别率。

行为识别;关键帧检测;相似性度量

A

TP391.41

10.3778/j.issn.1002-8331.1301-0189

CHENG Xun,CHANG Fei,WU Zhijie.Human behavior recognition based on key frame.Computer Engineering and Applications,2013,49(18):134-137.

国家自然科学基金(No.11176056)。

成勋(1987—),男,硕士,研究领域为视频分析与识别;常飞(1986—),男,工程师,研究领域为软件工程;吴志杰(1961—),男,研究员,研究领域为软件工程与视频分析。E-mail:chengxuntk@126.com

2013-01-18

2013-03-04

1002-8331(2013)18-0134-04

CNKI出版日期:2013-04-11 http://www.cnki.net/kcms/detail/11.2127.TP.20130411.1555.001.html