基于认知模型的室内移动服务机器人人机耦合协同作业机制

2012-09-24江济良屠大维张国栋赵其杰

江济良,屠大维,张国栋,赵其杰

(1.上海大学机电工程与自动化学院,上海 200072;2.上海大学 上海市机械自动化及机器人重点实验室,上海 200072)

随着社会人口老龄化,以及由于各种原因导致的大量肢残人士及运动、语障患者的出现,发展先进的助老助残服务机器人成为社会发展和进步的迫切需求[1-2].服务机器人是非结构化环境下为人类提供服务的集成多种高技术的智能系统,即具有一定“智能”的自动化机械[3].但要发展具有完全自主行为的智能机器人在当前及可预见的将来仍有一定的困难[4].20世纪 90年代初,钱学森、戴汝为、路甬祥、陈鹰等专家学者从不同角度提出了“人机智能”、“人机一体化智能系统”等概念的理论体系和技术立论[5-8].人机智能系统强调智能的“人”与智能的“机器”共同感知、共同认知、共同决策、平等合作,彼此执行自己最擅长的工作,实现人的智能与机器智能在决策层面融合,产生更高的智能形式.在那以后的十几年,研究人员针对不同应用系统,寻求能发挥人类定性、判断、决策的智能,并与机器定量、计算、推理的智能相结合的人机一体化体系[9-11].例如,刘雁飞和吴朝晖基于ACT-R(adaptive control of thought-rational)认知体系建立了符合真实驾驶认知行为的认知模型,并应用于车辆辅助驾驶系统[12].AMANT等基于ACT-R认知行为架构,设计开发的手机菜单人机交互模式极大地提高了交互效率[13].

对于行动不便的老人、肢残人士、运动和语障患者这些心智正常并具有基本认知行为能力的对象与服务机器人构成的人机智能系统,也需要设计一种新的人机界面和工作机制.本文针对室内移动的助老助残服务机器人,提出了基于ACT-R认知架构的人机耦合协同作业机制,通过人机耦合,建立人机一体化决策机制,实现在室内半结构化环境下人机协同路径规划、避障等功能.

1 ACT-R认知架构

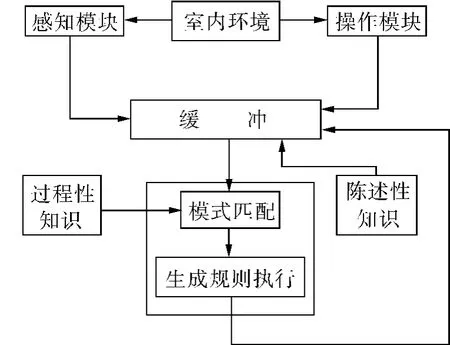

美国心理学家Anderson于1976年提出了ACTR(理性思维的适应性控制)认知架构模型,试图揭示人类组织知识、产生智能行为的思维运动规律[14],包括感知与注意力、学习和记忆、问题解决与决策推理等.到目前为止,已发布多个ACT-R版本,并实现了对不同系统操作平台的支持.ACT-R架构主要有3种类型的部件组成:基本模块(modules)、缓冲(buffers)和模式匹配(pattern matcher),其工作原理如图1所示.

图1 ACT-R认知架构Fig.1 ACT-R cognitive architecture

基本模块有感知运动模块(perceptual-motor modules)和记忆模块(memory modules)2种类型.感知运动模块负责系统与外界的交互,ACT-R较完善的感知运动模块是视觉和操作模块,例如看到一个房间,走了进来.记忆模块有2类,即说明性记忆(declarative memory)模块和过程性记忆(procedural memory)模块.说明性记忆也叫做陈述性知识,由事实陈述构成,如上面例子中关于房间的知识.过程性记忆也叫过程性知识,是关于怎么做事情的知识,如上面例子中先走到房门位置,然后穿过房门,最后进入房间的全过程.模式匹配是在知识库中搜索和缓冲状态一致的生成规则,如果规则匹配则被模型触发.生成规则实质上是当条件满足时被激发的条件反射的触发规则,同一时间只有1个规则被触发,触发结果修改缓冲状态从而改变系统的状态.缓冲是实现生成规则与其他基本模块交互的接口,缓冲的内容标识ACT-R目前的状态.ACT-R认知架构的认知过程实质上就是生成规则的不断触发.

本文从ACT-R认知架构模型及其实质出发,对移动服务机器人的人机一体化系统进行总体设计,通过建立人机耦合协同作业平台,使人的智能和机器智能建立在共同的ACT-R认知架构下,达到人机协同决策的目的.

2 基于ACT-R的人机一体化系统

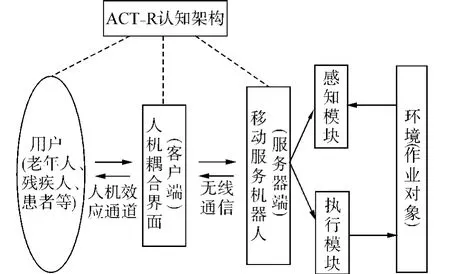

基于ACT-R认知架构的室内移动服务机器人的人机耦合协同作业系统如图2所示.

图2 移动服务机器人人机耦合协同作业系统Fig.2 Human-robot coupling and collaborative operation system for mobile service robot

该系统中人(用户)的行动不便,但具备基本的认知能力,用户通过人机界面实现人与机器(计算机和机器人)之间的耦合,移动服务机器人处在室内半结构化环境中,其环境特征为室内房间、走廊、门窗等尺寸精确固定,室内家具、杂物等可以移动.在ACT-R认知架构下用户通过人机效应通道与人机耦合界面之间进行信息交互,人机耦合界面感知到人的意愿需求并将控制命令传达给移动服务机器人,机器人发挥局部自主智能执行对应的任务,同时将执行数据、作业环境等信息实时地反馈到人机耦合界面,并能与人协同决策.人机耦合界面与移动服务机器人之间的信息耦合通过基于C/S结构的无线通信来实现.

2.1 人机效应通道和人机耦合界面

对于老年人和残疾人这类特殊用户群体来说,首先要解决人机效应通道问题,课题组面向助老、助残应用,研究开发了基于“视觉-眼动”、“听觉-语音”等简单自然双向人机效应通道的人机交互装置[15-17].其次,通过简单自然的人机效应通道,设计了基于ACT-R认知架构的人机耦合智能界面,它主要由横向排列的任务对话框和信息耦合界面组成.任务对话框由一系列的任务列表组成,当用户通过人机效应通道与人机耦合界面交互时,该任务对话框可以进行智能展开和左右延伸并进行响应,自由而充分地表达用户的意愿需求.信息耦合界面由简单自然的耦合窗口组成.

此外,为降低老年人和残疾人这类特殊用户群体在交互过程中的负担,在人机界面设计上采用基于ACT-R认知架构的主动引导、用户适应、机器学习等智能模块.计算机(或机器人)在交互或执行任务过程中遇到困难时,通过上下文提示、语义联想等主动引导缺省信息,要求用户做出响应;针对不同用户的行为特点和个性化参数,自适应修正系统参数,提高系统可靠性;计算机(或机器人)通过不断学习获得新的陈述性知识和过程性知识.如图3所示.

图3 基于ACT-R的人机交互Fig.3 Human-robot interaction based on ACT-R

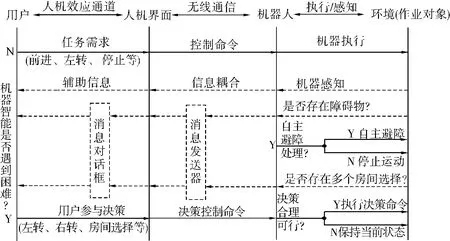

2.2 移动服务机器人

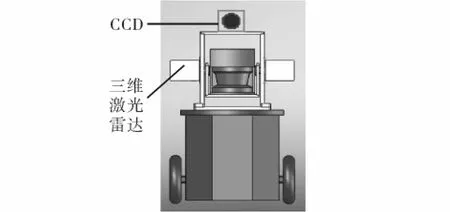

移动服务机器人安装了差动驱动的左右主动轮及各种机载传感器,包括左右驱动电机编码器、LMS200激光雷达、CCD、声呐、数字罗盘、GPS等.其中德国SICK公司的LMS200激光雷达在一个平面作水平扫描获取该平面内场景的距离信息,笔者设计了一个摆动机构使之俯仰摆动,成为三维激光雷达传感器,获取场景三维图像(range image)[18],如图4所示.三维激光雷达传感器与CCD传感器联合使用,使机器人既获得场景中二维物体的轮廓及颜色、文字、符号等信息,又获得场景三维空间信息,两者在时间上同步,视场上重合,且相互映射(mapping).

图4 移动服务机器人Fig.4 Mobile service robot

该移动机器人具有局部自主智能,一方面依赖其内存中的室内固定环境电子地图,如走廊、门、墙等的位置和尺寸;另一方面,利用其自身携带的传感器感知环境信息,特别是环境中的障碍物信息.移动机器人局部自主路径导航和智能避障同样基于ACT-R认知架构,即系统采用以环境电子地图描述的固定信息为基础的陈述性知识和以传感器获得的场景信息为基础的过程性知识,通过缓冲,生成执行规则,完成局部路径规划、避障等功能.执行规则是一系列特征匹配和预测控制算法[19].

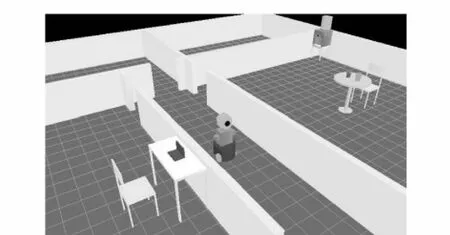

3 用户与机器人的空间环境耦合

对室内移动机器人来说,用户与机器人在空间环境耦合是实现人机协作导航进行避障的关键.利用电子地图和左右电机编码器、GPS、机载数字罗盘可以实现机器人在环境中的实时定位和姿态检测.利用OpenGL三维动画技术构建移动服务机器人与室内环境的三维模型,当机器人在室内移动时同步显示其在环境中的位置和姿态改变,将这一空间环境呈现在用户界面(见图5),实现用户与机器人在空间环境的耦合.

图5 人-机-环境耦合Fig.5 Human-robot-environment coupling

因此,必须不断地将移动服务机器人的执行数据实时反馈到用户界面,并通过这些数据在人机耦合界面实时驱动移动服务机器人三维模型的相应运动.反过来也一样,当人机耦合界面中的移动服务机器人三维模型在用户的命令下发生运动时,实际环境中移动服务机器人也应该保持相应的同步运动.

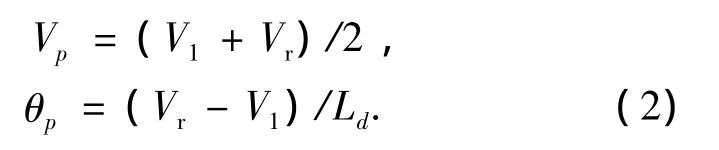

图6为移动机器人运动学分析,其左右主动轮中心之间的距离为Ld,主动轮和从动轮之间的距离为Lp.图6中建立了2个坐标系W和P.W为世界坐标系{xw,ow,yw},P 为机器人坐标系{xp,op,yp},其中op为机器人主动轮轴的中点,xp为主动轮轴线方向,yp为机器人前进方向.在世界坐标系W下,机器人的位姿为(xp,yp,θp),其中(xp,yp)为点 op在世界坐标系W中的坐标,θp为坐标系P相对于世界坐标系W的旋转角,称为机器人的航向角.

图6 移动机器人运动学分析Fig.6 Kinematic analysis of the mobile service robot

对其左右主动轮进行运动分析,如图6所示.已知左右轮的半径相同为R,设轮心o1、or的速度大小分别为V1和Vr,由于轮子受非完整约束,其在地面作无滑动的纯滚动,可得

在世界坐标系W中,op点的速度Vp为

式中:|Vp|为op点的速度大小.由式(1)~(3)整理得

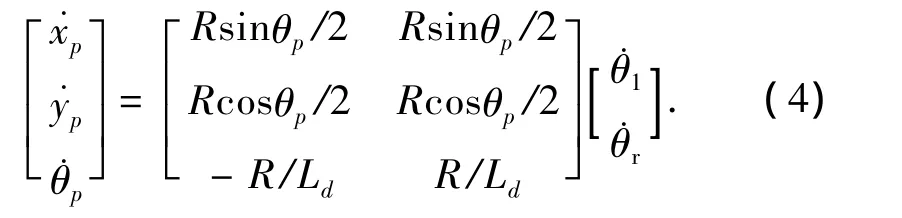

4 人机协同决策作业机制

该系统采用人-机一体的技术路线,人与机器共同组成一个系统,人机共同感知、共同认知、共同决策、平等合作,彼此执行自己最擅长的工作;在充分发挥人的智能的基础上,适当地去开发机器的智能,旨在实现人的智能与机器智能在决策层面的融合,以产生更高的智能形式.图7为基于ACT-R认知架构的移动服务机器人人机一体化决策模型.整个系统中,除了用户具有人的智能,人机耦合界面和机器人也具有基于ACT-R认知架构的智能.

人机耦合界面主要由任务需求对话框和4个耦合窗口组成,4个耦合窗口分别为CCD二维视频窗口、激光雷达三维图像窗口、人-机-环境耦合三维模型窗口和环境几何地图窗口,如图8所示.视频窗口显示机器人前方视频图像;激光雷达三维图像窗口显示三维激光雷达通过扫描获得的前方场景距离图像;人-机-环境耦合三维模型窗口显示与实际移动服务机器人同步运动的三维作业模拟图像;环境几何地图窗口显示室内环境电子地图.人机作业进程中,在界面上就会产生虚实结合、多维、交互的人机耦合效果.

图7 基于ACT-R的人机协同决策模型Fig.7 Human-robot decision model based on ACT-R

图8 人机耦合界面设计Fig.8 Design of human-robot coupling interface

图9为移动服务机器人人机一体化决策协同作业机制的原理图.用户通过“视觉-眼动”、“听觉-语音”等简单自然的人机效应通道与人机耦合界面进行交互,人机耦合界面与机器人之间通过基于C/S架构的无线通信实现信息耦合,机器人通过其操作模块和感知模块与环境之间发生相互作用,用户和环境之间形成一条交互耦合通道,实现人-机-环境的空间耦合感知,以实现人机一体化决策.

移动服务机器人接收到用户的决策命令时,机器人自身也进行决策,权衡用户决策的合理性和可行性,如果合理可行,则执行用户的决策命令,否则将机器决策的相关信息反馈到耦合界面供用户参考.机器人在执行任务过程中,当自身的局部智能遇到困难时,会通过消息发送器和消息对话框在人机耦合界面上自主弹出消息,给予用户适当提示,请求用户参与决策.表1列出了移动服务机器人人机协同作业的条件响应生成规则.例如人机协同避障条件-响应生成规则中,如果同时满足条件1)处于前进、左转或右转运动状态;2)前方安全距离范围内检测到障碍物;3)机器智能有限不能避开这类障碍物,则触发人机协同避障进程,机器人在安全距离处停止运动,向人机界面发送消息“左转,右转?”,请求用户参与避障决策.人机作业进程中,用户主要负责定性判断和决策,例如转弯方向判断、目的地选择等.移动服务机器人是作业任务的执行者,主要承担定量计算和推理工作,它一方面将环境信息和相关执行信息实时地反馈到人机耦合界面上,另一方面运用陈述性知识和过程性知识,通过缓冲,生成规则,发挥自主局部智能,例如转弯半径选择、自主避障等.用户和移动服务机器人通过人机协同决策和分工合作来完成复杂的作业任务.

图9 人机一体化决策协同作业机制Fig.9 Human-robot integrated and collaborative decision operation mechanism

表1 人机协作条件-响应生成规则Table 1 Condition-action productions of HRC

5 室内人机协同作业实验

实验系统如图10所示,其中图10(a)为在走廊中的移动服务机器人,图10(b)为在房间内的用户及人机交互界面.用户使用语音、视觉等简单自然的人机效应通道,在具有ACT-R认知特征的智能人机界面进行人机交互.

图10 实验系统Fig.10 Experiment system

图11为移动服务机器人人机耦合协同作业过程中的几幅画面.图11(a)~(c)表示机器人利用自身携带的传感器检测到前方存在障碍物,发挥机器自主智能在安全距离处停止运动,并在界面上给予用户适当的提示:“左转,右转?”(见图12(a));用户通过人机耦合界面感知到这一提示,作出右转决策命令,机器人在用户决策命令下发挥机器智能自主避开障碍物.图11(d)~(f)表示机器人即将行至房门位置面临多个房间选择时,提示用户:“请问进入哪一房间?”(见图12(b));用户选择所要进入的房间后,机器人依据内部电子地图和自身携带的传感器自主进入该房间.

图11 人机耦合协同作业过程的几幅画面Fig.11 Pictures of human-robot collaborative operation

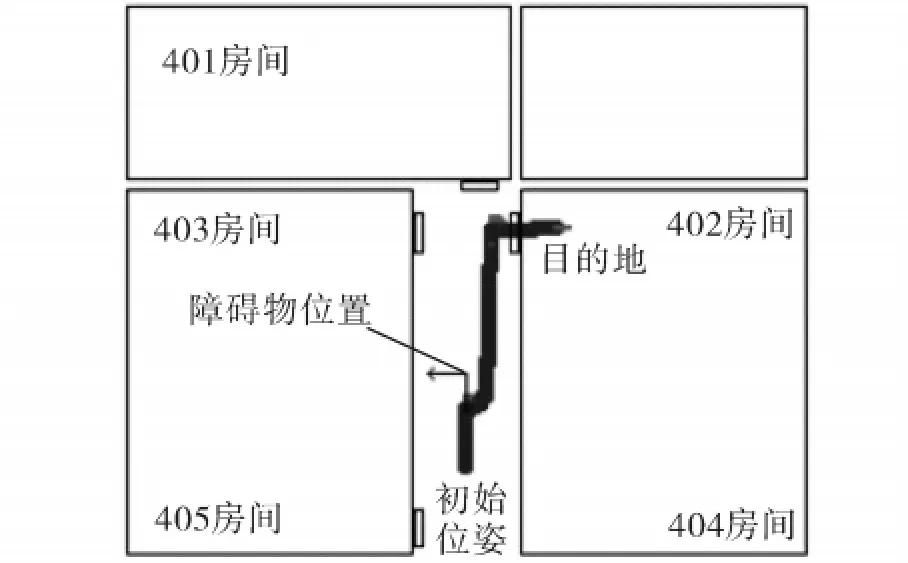

图12为人机协同作业时的人机耦合界面,其中图12(a)是机器人在安全距离处停止运动时的人机耦合协同决策界面,这时界面上的人-机-环境耦合三维模型窗口上会弹出“左转,右转?”消息字样;图12(b)是机器人即将到达房门位置存在多个房间选择时的人机耦合协同决策界面,这时界面上的人-机-环境耦合三维模型窗口上会弹出“请问进哪一房间?”消息字样,且任务需求对话框也发生相应变化,列出所有的房间号供用户选择.环境几何地图窗口中的圆点及箭头表示机器人在地图上的位姿(圆点中心位于粗实线的中心线上),曲线为实验中所保留的机器人的运动轨迹.图13为机器人进入指定房间时界面上的环境几何地图窗口,该窗口显示了人机耦合协同作业过程中机器人的运动轨迹.

图12 人机耦合界面Fig.12 Human-robot coupling interface

图13 环境几何地图窗口Fig.13 Environment geometric map window

6 结束语

本文将具备基本认知能力的老、残、障这类特殊服务对象纳入到人机系统中,提出了基于ACT-R认知架构模型的移动服务机器人人机耦合协同作业机制,用户与机器人共同感知、共同决策、平等协作地完成室内避障、导航等作业任务.从该系统人机耦合协同作业机制的实现上看,设计了基于ACT-R认知架构的人机耦合智能界面,用户通过与交互界面之间的自然友好交互和人与机器人之间的空间环境耦合感知,实现了人机一体化协同决策作业.该人机耦合协同作业机制以移动服务机器人为例,在室内环境下进行人机耦合协同避障导航实验,顺利、高效地完成了作业任务.

[1]MIURA J,SHIRAI Y,SHIMADA N,et al.Development of a personal service robot with user-friendly interfaces[C]//Proceedings of the 4th International Conference on Field and Service Robotics.Lake Yamanaka,Japan,2003:293-298.

[2]GRAF B,HANS M,SCHRAFTL R D.Care-O-bot II—development of a next generation robotic home assistant[J].Autonomous Robots,2004,16(2):193-205.

[3]LEE K W,KIM H R,YOON W C,et al.Designing a human-robot interaction framework for home service robot[C]//Proceedings of the 14th IEEE International Workshop on Robots and Human Interactive Communication.Nashville,USA,2005:286-293.

[4]陆新华,张桂林.室内服务机器人导航方法研究[J].机器人,2003,25(1):80-87.

LU Xinhua,ZHANG Guilin.Summarization on indoor service robot navigation[J].Robot,2003,25(1):80-87.

[5]钱学森,于景元,戴汝为.开放的复杂巨系统及其方法论[J].自然杂志,1990,13(1):3-10,64.

[6]戴汝为.“人机结合”的大成智慧[J].模式识别与人工智能,1994,7(3):181-190.

DAI Ruwei.Metasyntactic wisdom of man computer cooperation[J].Pattern Recognition and Artificial Intelligence,1994,7(3):181-190.

[7]路甬祥,陈鹰.人机一体化系统科学体系和关键技术[J].机械工程学报,1995,31(1):1-7.

LU Yongxiang,CHEN Ying.Academic architecture and key techniques of the humachine system[J].Chinese Journal of Mechanical Engineering,1995,31(1):1-7.

[8]王巍,王志良,郑思仪.人机交互中的个性化情感模型[J].智能系统学报,2010,5(1):10-16.

WANG Wei, WANG Zhiliang, ZHENG Siyi. Affective model in human-robot interaction[J].CAAI Transactions on Intelligent Systems,2010,5(1):10-16.

[9]杨灿军,陈鹰,路甬祥.人机一体化智能系统理论及应用研究探索[J].机械工程学报,2000,36(6):42-47.

YANG Canjun,CHEN Ying,LU Yongxiang.Study of the humachine intelligent system and its application[J].Chinese Journal of Mechanical Engineering,2000,36(6):42-47.

[10]苏相国,樊继壮,臧希喆.改进的多机器人协作探索策略研究[J].哈尔滨工程大学学报,2010,31(3):350-354.

SU Xiangguo,FAN Jizhuang,ZANG Xizhe.An improved method for multi-robot coordinated exploration[J].Journal of Harbin Engineering University,2010,31(3):350-354.

[11]KAUPP T,MAKARENKO A,DURRANT-WHYTE H.Human-robot communication for collaborative decision making—a probabilistic approach[J].Robotics and Autonomous Systems,2010,58(5):444-456.

[12]刘雁飞,吴朝晖.驾驶ACT-R认知行为建模[J].浙江大学学报:工学版,2006,40(4):1657-1662.

LIU Yanfei,WU Chaohui.Driver behavior modeling in ACT-R cognitive architecture[J].Journal of Zhejiang University:Engineering Science,2006,40(4):1657-1662.

[13]AMANT R S,HORTON T E,RITTER F E.Model-based evaluation of cell phone menu interaction[C]//Proceedings of the SIGCHI Conference on Human Factors in Computing Systems.Vienna,Austria,2004:343-350.

[14]ANDERSON J R.ACT-R:a simple theory of complex cognition[J].American Psychologist,1996,51(4):355-365.

[15]赵其杰.服务机器人多通道人机交互感知反馈工作机制及关键技术[D].上海:上海大学,2005:14-38.

ZHAO Qijie.Information perception and feedback mechanism and key techniques of multi-modality human-robot interaction for service robots[D].Shanghai:Shanghai University,2005:14-38.

[16]屠大维,赵其杰,尹海荣.自动适用用户头部位置变化的眼睛盯视输入系统[J].仪器仪表学报,2005,25(6):828-831.

TU Dawei,ZHAO Qijie,YIN Hairong.Eye-gaze input system being adaptive to the user’s head movement[J].Chinese Journal of Scientific Instrument,2005,25(6):828-831.

[17]赵其杰,屠大维,高达明,等.人机交互方法及装置:中国,1584791[P].2005-02-23.

[18]罗荣贵.基于视觉传感集成的移动机器人环境感知研究[D].上海:上海大学,2011:25-54.

LUO Ronggui.Research of mobile robot’s environmental perception based on vision sensors integration[D].Shanghai:Shanghai University,2011:25-54.

[19]黄志华,屠大维,赵其杰.基于人机交互的移动服务机器人导航系统[J].机器人,2009,31(3):248-253.

HUANG Zhihua,TU Dawei,ZHAO Qijie.A human-robotinteraction-based navigation system for mobile service robot[J].Robot,2009,31(3):248-253.