基于核密度估计和马尔科夫随机场的运动目标检测

2012-07-13魏磊魏江

魏磊,魏江

(西北工业大学 电子信息学院,陕西 西安 710072)

运动目标检测在计算机视觉领域是一个重要的研究方向,精确快速的运动目标检测算法能使目标跟踪、分类和行为理解等获得更好的效果。

影响运动目标检测准确性的因素主要有动态背景和光照变化。常见的动态背景有相机抖动、树叶扰动、水面波动和背景物体位置变动等,常见的光照变化有长时的缓慢光照变化(如昼夜变化)、短时的光照突变(如开关灯)和局部的光照变化(阴影)。

运动目标检测方法主要有基于帧间差的方法、光流法和基于背景建模的方法。基于背景建模的方法因其较高的准确度,较好的鲁棒性,成为目前应用最为广泛的方法,它可分为基本背景建模[1-2]、基于聚类背景建模[3-4]和基于统计背景建模。基于统计背景建模又可分为参数背景建模[5-6]和非参数背景建模[7]。非参数背景建模无需预先对模型进行假设也不需对其参数进行显示的估计,适用于各种分布的数据,鲁棒性好,文献[8]基于贝叶斯模型和马尔科夫随机场的方法,文献[9]基于混合高斯模型和粒子群优化的方法,分别是非参数背景建模和参数背景建模中的优秀方法。

马尔科夫随机场描述的是,任意点的局部条件概率密度由其邻域的概率分布决定。通过引入马尔科夫随机场,可以保持目标和背景像素的空间连续性。同时考虑到非参数背景建模的优势,提出一种基于核密度估计和马尔科夫随机场的运动目标检测算法,对背景扰动和光照变化具有较强的鲁棒性,错误检测率更低。

1 算法描述

1.1 算法步骤

本文算法对每个新采集到的样本,利用扩展的特征向量估计出其属于背景的概率密度,再根据概率密度和空间连续性约束构造马尔科夫随机场,并通过最小化其能量函数得到目标分割结果。

具体算法步骤如下:

Step 1读取待检测视频的前N帧,计算每一像素点的色度分量[r,g]和颜色空间运动矢量分量d,构成用于核密度估计的特征向量[r,g,d],建立背景模型;

Step 2利用核密度估计,计算当前帧每一像素点属于背景的概率密度 P(x|lB);

Step 3根据Step 2计算所得的P(x|lB)和空间连续性约束构造马尔科夫随机场能量函数E(l),并利用图论的最小切算法得到使得该能量函数最小的标记场,此即为当前帧的分割结果,输出标记结果;

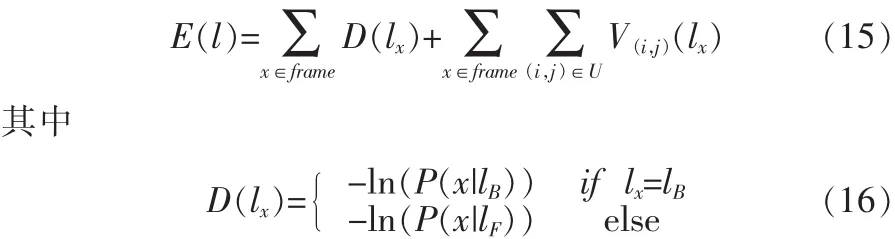

Step 4判断是否为最后一帧,若不是,则按照更新规则将之前的帧乘以衰减系数α更新背景模型,然后转入Step 2,若是,则结束退出。

1.2 核密度估计

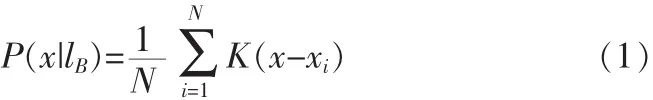

本文采用核密度估计计算当前帧每一像素点属于背景的先验概率密度[10],假设x为当前帧某一像素点在特征空间中的特征向量,x1,x2,…xN为前N帧该像素点在特征空间中的特征向量,则当前帧这一像素点属于背景的概率密度可用下式估计:

其中K为核函数,若取高斯核,则概率密度函数如下:

其中,d为特征向量x维数,lB表示当前像素点标记为背景,Σ为核函数带宽,文献[10]假设颜色空间的各个分量是独立的,使得Σ是正定对角阵。实际上,每一个颜色通道并非完全独立,可利用前N帧样本相邻帧间差值的协方差矩阵[11]近似估计Σ:

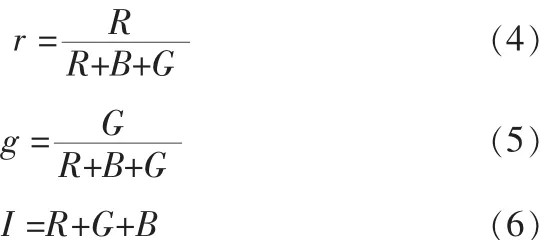

为减小光照影响,将像素点由颜色空间[R,G,B]转换到颜色空间[r,g,I][10]:

将色度和亮度分离。光照变化可近似认为只影响亮度分量I,而对色度分量[r,g]影响较小。像素点仅受光照变化影响而景物并未变化的情况下,I会保持在一个范围内,α<I/E(I)<β[10],E(I)为I的均值。 利用[r,g]进行核密度估计,可以减少光照变化的影响,但在像素点饱和度很低或是很暗的情况下,色度信息很少,仅利用[r,g]会带来较大误差。因此,本文提出在[r,g]的基础上加入颜色空间运动矢量这一分量,以进一步增强对背景扰动和光照变化的鲁棒性。

背景扰动和光照变化可以看作是像素点在颜色空间的运动,相机的抖动,树叶的扰动,水波纹和长时的光照变化(如昼夜交替)等,像素点在颜色空间的运动模式是相对固定的,对其运动矢量的模进行核密度估计,也可以得到一个多峰的概率密度函数,概率密度较高判断为背景,概率密度较低则判断为前景。令运动矢量的模为d:

本文计算的为 2-范数。 在[r,g]内加入分量d,得到[r,g,d],将其作为核密度估计的特征向量,可进一步增强算法对背景扰动和光照变化的鲁棒性,不加分量d和加入分量d估计的当前帧概率密度如图1所示,每个像素点灰度值的大小表示该点概率密度值的大小,灰度值高表示概率密度低,灰度值低表示概率密度高,由图可见,加入分量d后结果更加准确。由于加入了分量d,核函数带宽:

其中,Σr,g和Σd分别按照式(3)计算。

1.3 马尔科夫随机场

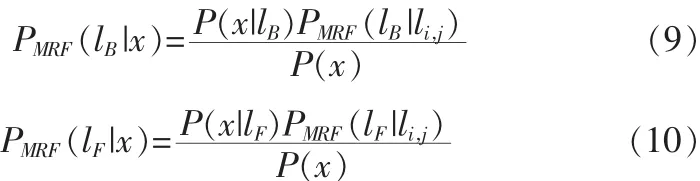

马尔科夫随机场描述的是,任意点的局部条件概率密度由其邻域的概率分布决定。考虑目标和背景像素具有空间连续性的特点,对当前像素点加入空间连续性约束即条件概率PMRF(lx|li,j),l∈{lB,lF},(i,j)∈U,lx为当前像素点标记,lB表示标记为背景,lF表示标记为前景,U为当前像素点的邻域,比如说4-邻域或8-邻域,根据贝叶斯定理,当前像素点加入空间连续性约束后判断为背景和前景的后验概率密度如下:

图1 不加分量d和加入分量d概率密度对比图Fig.1 Contrast figure of probability density calculated with and without d

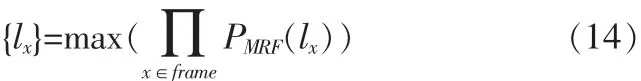

di,j为一常数,其大小决定了分割结果的平滑程度。令PMRF(lB|x)和PMRF(lF|x)为PMRF(l),那么,求当前帧的最佳前景背景分割,就是求当前帧每一点的标记l,使所有像素点标记的联合概率最大。

对式(14)两端求负自然对数,则求其最大值可转化为求能量函数最小值。略去常数项,能量函数如下:

先验概率密度(P(x|lB))和(P(x|lF))有很多零值或很大的值,直接求负自然对数会得到许多极大的数或是无穷,造成数据溢出和漏警,对后续最小切的计算也会带来困难。通常(P(x|lB))越大,像素点越接近于背景,(P(x|lF))就越小;(P(x|lB))越小,像素点越接近于前景目标,(P(x|lF))就越大。考虑上述两个原因,本文提出E(l)的第一项D(lx)用如下饱和线性函数近似表示:

其中,P(lB|x)按式(2)计算,Q为D(lB)的最大值,表示判断为背景的代价项最大可为多少;λ为正的常数,且0<λ<1,λ越大,D(lF)的最大值越小,判断为前景的代价越小,漏警率越低,相应的虚警率越高。令之前帧算得的同一像素点的先验概率密度集合为A={P(x|lB),x∈x1…xN},对于这一像素点,θ为大于A中ρ%的数的最小值,θ/λQ表示线性饱和函数线性部分的斜率。

再加入亮度分量的影响,如果当前像素点的I满足0.6<I/E(I)<1.5[12],那么D(lB)= μD(lB), μ 为一个小于 1 的正常数。

计算马尔科夫随机场能量函数(15)最小值的过程,可以转化为计算图的最小切过程[13],每一个像素点和前景背景标记为图的节点,前景和背景标记分别为源和汇,这样共有M×N+2个节点,M×N为帧的大小,D(lx)为像素节点连接源和汇的边,V(i,j)为连接像素节点间的边。最小切算法的结果使子图中每个节点只与源或汇相连,这便是使能量函数最小的最佳分割,也就是最终的运动目标检测结果。

1.4 背景模型的更新

由于距离当前帧越早的帧,与当前背景的相关性往往越低,因此需要对较早的帧进行衰减。本文采用的方法为每次更新时,将之前的帧乘上衰减系数α。当前帧85%都判断为前景时,说明背景发生了突变,如镜头的切换或者剧烈的光照变化,此时α取0.01,近似于重新建立背景模型,否则,α取0.99[8]。通过这一更新方法,可以减小由于太早的帧与当前背景相关性过低造成的误差。

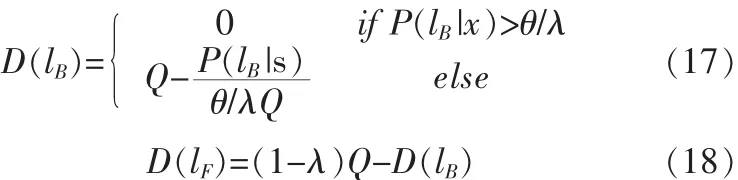

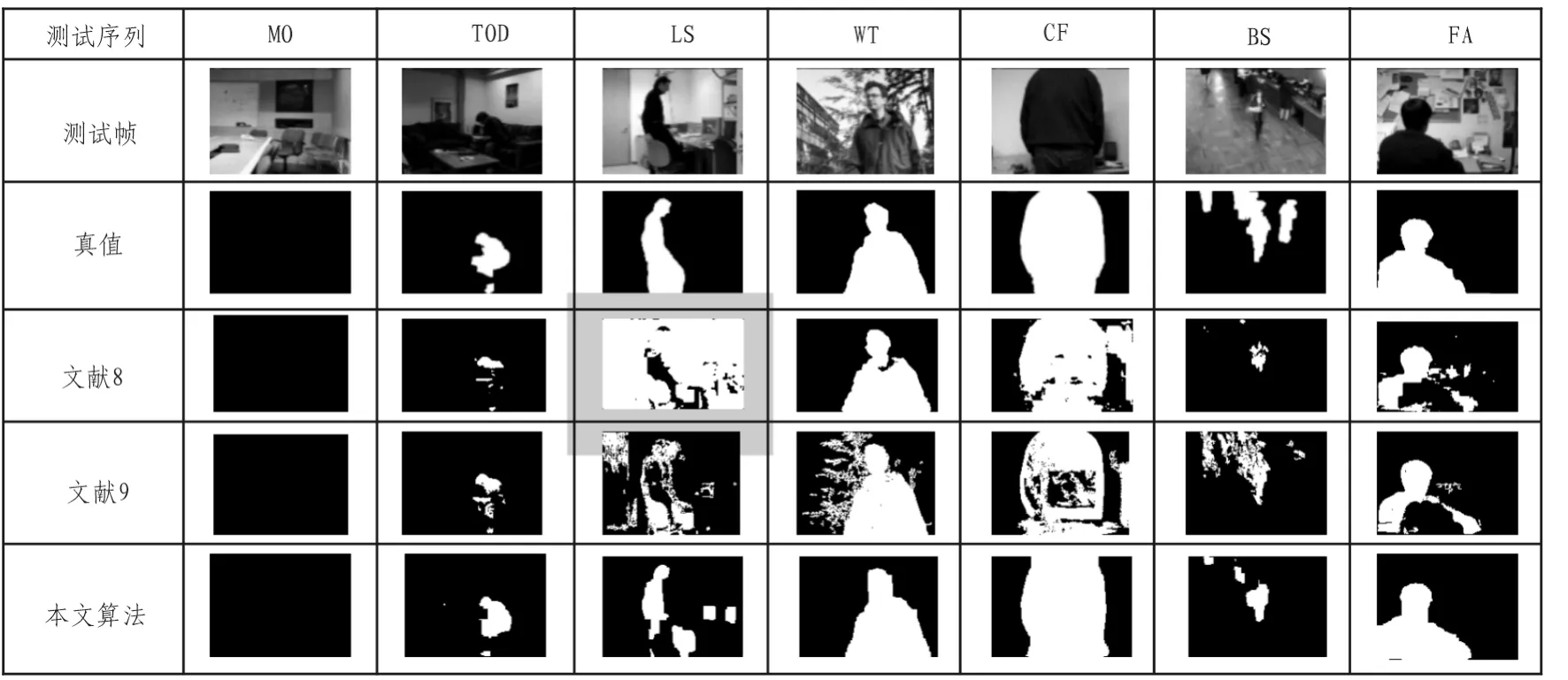

2 实验结果及分析

1)TOD序列的实验结果表明,本文算法对光照变化的序列有更强的鲁棒性,得到的目标更接近真值;

2)从WT序列的结果可看出,本文算法对背景扰动有更强的鲁棒性。由于加入了像素连续性约束,检测出的目标边缘稍有模糊,但从FA序列的结果看,加入的处理可消除目标内空洞;

3)从CF的结果看,本文算法对背景和目标色度相近的情况也能取得更好的检测效果;

4)对BS序列,本文算法漏检了一些处于相同位置较长时间的小目标,这是因为长时间静止的目标属于背景的先验概率密度较高,并且小目标通过能量函数的计算,易于被背景淹没。

从表1可以看出本文算法比另两种算法错误检测率η更低。但正如前面所述,BS序列的错误检测率η偏高,这一点上算法有待改进。

3 结 论

文中提出了一种基于核密度估计和马尔科夫随机场的运动目标检测算法[15]。在特征向量中加入颜色空间运动矢量分量,提高了对背景扰动和光照变化的鲁棒性;用饱和线性函数计算能量函数代价项,避免了数据溢出导致的计算失败。实验证明,本文算法比文献[8]和文献[9]算法的漏警和虚警率更低,对背景扰动和光照变化具有更强的鲁棒性。文中算法的不足在于对场景中较小且长时间不动的目标检测不是很理想,这是下一步研究和改进的方向。

图2 针对Wallflower测试集的结果对比图Fig.2 Results on the Wallflower dataset for the three methods

表1 针对Wallflower测试集的误警数、漏警数和错误检测率Tab.1 Comparison on the Wallflower dataset for the three methods

[1]Lee B,Hedley M.Background estimation for video surveillance[C]//New Zealand:Image and Vision Computing New Zealand,2002:315-320.

[2]Zheng J,Wang Y,Nihan N,et al.Extracting roadway background image:a mode based approach[J].Journal of the Transportation Research Board, 2006(1944):82-88.

[3]Butler D,Sridharan S.Real-time adaptive background segmentation[C]//China:International Conference on Acoustics,Speech and Signal Processing,2003:349-352.

[4]Ilyas A,Scuturici M,Miguet S.Real-time foreground-background segmentation using a modified codebook model[C]//Genova:AdvancedVideoandSignalBasedSurveillance,2009:454-459.

[5]Wren C,Azarbayejani A,Darrell T,et al.Pfinder:real-time tracking of the human body[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1997,19(7):780-785.

[6]Stauffer C,Grimson W.Adaptive background mixture models for real-time tracking[C]//America:Proceedings IEEE Conference on Computer Vision and Pattern Recognition,1999:246-252.

[7]Elgammal A,Harwood D,Davis L.Non-parametric model for background subtraction [C]//Ireland:6th European Conference on Computer Vision,2000:751-767.

[8]Sheikh Y,Shah M.Bayesian modeling of dynamic scenes for object detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(11):1778-1792.

[9]White B,Shah M.Automatically tuning background subtraction parameters using particle swarm optimization[C]//China:IEEE International Conference on Multimedia and Expo,2007:1826-1829.

[10]Elgammal A,Duraiswami R,Harwood D,et al.Background and foreground modeling using nonparametric kernel density estimation for visual surveillance[J].Proceedings of The IEEE,2002,90(7):1151-1163.

[11]Tavakkoli A,Nicolescu M,Bebis G.Automatic statistical object detection for visual surveillance[C]//America:Proceedings of the IEEE Southwest Symposium on Image Analysis and Interpretation,2006:144-148.

[12]Schindler K,Wang H.Smooth foreground-background segmentation for video processing[C]//India:Asian Conference on Computer Vision,2006:581-590.

[13]Boykov Y,Kolmogorov V.An experimental comparison of min-cut/max-flow algorithmsforenergyminimization in vision[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2004,26(9):1124-1137.

[14]Toyama K,Krumm J,Brumitt B,et al.Wallflower:Principles and practice of background maintenance[C]//Greece:International Conference on Computer Vision,1999:255-261.

[15]黄锦殿,柴卫东.基于小波分析的氢涡轮泵低温轴承保持架故障特征辨识[J].火箭推进,2011(2):43-47.

HUANG Jin-dian,CHAI Wei-dong.Fault identification based on wavelet analysis for bearing cage of hydrogen turbopump[J].Journal of Rocket Propulsion,2011(2):43-47.