运动补偿预测残差稀疏重构的压缩视频传感

2012-06-25朱向军冯志林鲍卫兵

朱向军,冯志林,王 洁,鲍卫兵

(浙江工业大学之江学院,浙江 杭州 310024)

以块运动估计和变换编码为核心的视频压缩技术(如MPEG及H.26x等标准)因编码器复杂度高且抗误码能力差等缺陷,很难适用于移动视频电话、无线低功耗视频监控及无线视频传感网络等新兴应用场合。最近提出的压缩传感(Compressive Sensing,CS)[1-2]理论,对稀疏信号(或可压缩图像)以远低于奈奎斯特频率的速度进行投影观测,将传感和压缩合并为一个环节,在解码端采用适当的稀疏重构算法从观测向量中重建出原始信号,显著降低了信号采集中的采样频率、功耗和数据存储量。基于压缩传感原理,Duarte等[3]发明了单像素摄像机,验证了低像素摄像机也能拍摄高质量图像。压缩传感技术在编码端通过简单的随机观测来压缩采样信号,且全局观测对信道误码鲁棒性强,非常适合分布式编码应用[4]。

Gan等[5]提出了一种压缩图像传感方法,用置乱块哈达玛矩阵投影观测整帧图像,选择离散小波变换为稀疏变换,采用凸优化算法重构原图像。结合分布式视频编码框架和CS理论的分布式压缩视频传感方法[5-9],为解决低复杂度视频编码问题提供了新的思路。将视频序列分为关键帧和CS帧,对关键帧独立编码/解码或观测/重建;对CS帧直接投影观测实现低复杂度编码,在解码端利用帧间相关性重建CS帧,与CS帧独立重建相比,图像质量有了显著提高。提高此类算法性能的关键是在解码端充分利用帧间相关性或稀疏性,Kang等[6]将帧率提升工具生成的边信息作为稀疏重构的初始值,Prades-Nebot[7]和Do[8]等由重建关键帧的相邻块生成局部冗余字典以及Chen等[9]训练生成全局冗余字典作为块稀疏变换基。

笔者提出了利用运动补偿预测(Motion Compensated Prediction,MCP)进行残差稀疏重构的分布式压缩视频传感算法(CVS_MCP),主要特点是:1)编码端采用“关键帧-多个CS帧-关键帧……”的分组压缩传感方式,对整帧图像投影观测;2)在解码端,利用已重建的关键帧和CS帧进行重叠块运动估计,获得稠密运动矢量场,生成运动补偿预测帧;3)利用原始帧的观测向量与预测帧的观测向量之差,对预测残差稀疏重构。

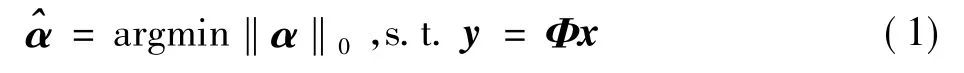

1 压缩传感

给定长度为N的一维离散信号列向量x,可以用一个N×N的稀疏变换基Ψ表示为x=Ψα,其中,α是系数向量。如果α中只有K(K≪N)个非零的系数,称x是K-稀疏的。压缩传感[1-2]理论表明,对未知K-稀疏信号x,利用M×N(K≤M≪N)的随机观测矩阵Φ进行线性投影观测,得到长度为M的线性观测向量(x的压缩表示):y===,其中,Θ称为传感矩阵。当满足约束等距性条件且观测数M≥c(Klg(N/K))(c是与重建精度有关的常数)时,运用稀疏重构算法按式(1)求解满足y=Θα的最稀疏解^α,可稳定精确的重建原始信号=,

2 CVS_MCP算法

2.1 算法结构

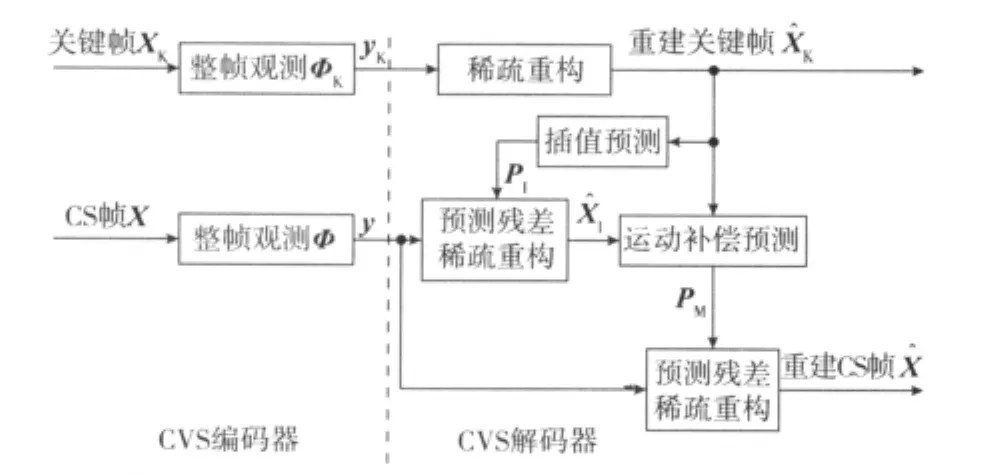

CVS_MCP算法的结构如图1所示,首先将视频序列分为由一帧关键帧和后续多帧CS帧构成的若干图像组(Group of Pictures,GOP)。在编码端,顺序独立压缩传感单帧图像,采用计算快速且通用性好的置乱块哈达玛矩阵[5]全局观测整帧,得到观测向量y,关键帧记为yK。在解码端,以逆离散小波变换(IDWT)为稀疏变换基Ψ,采用SpaRSA[10]稀疏重构算法独立重建关键帧得到;对CS帧按如下步骤重建:将重建关键帧插值生成预测帧pI,稀疏重构预测残差,得到初始重建帧,然后结合重建关键帧,通过运动补偿预测生成CS帧的预测帧pM,再次进行预测残差稀疏重构得到最终的重建图像。

图1 CVS_MCP算法结构框图

所提算法对CS帧整帧全局观测,避免了分块压缩传感[7-9]方法面临的块效应以及观测数分配等问题(例如需要解码端反馈观测数的分配信息[9])。也不同于Do等[8]的分块和整帧观测结合的方法,面临如何分配两类观测数的问题;并且 Prades-Nebot[7]和 Do[8]等算法中关键帧采用H.264帧内编码方法,复杂度较高,与单像素摄像机[3]也不兼容。所提算法对关键帧和CS帧采用相同的编码结构,与单像素摄像机完全兼容。

2.2 解码端运动补偿预测

算法选用性能较好且运算快速的重叠块运动补偿方法(OBMC)[11]生成预测帧pM,但与编码端运动估计不同,解码端的运动估计中原始帧无法获得,先通过插值重建关键帧生成预测帧pI,然后稀疏重构预测残差生成初始重建帧作为运动估计中的目标帧,保证了目标帧具有与重建关键帧近似的信噪比。解码端不需要编码传输运动矢量,采用更为稠密的运动矢量场可以提高运动补偿预测的准确性。所以,算法采用了重叠块运动估计,选择16×16块,重叠步长设定为4像素,以绝对差之和作为块匹配准则。算法支持前向运动补偿预测(Forward MCP,FMCP)和双向运动补偿预测(Bidirectional MCP,BMCP)两种方式,前者仅由前一关键帧运动补偿预测,后者还使用后一关键帧,预测帧为前后两帧运动补偿预测的简单平均。与FMCP相比,BMCP残差较小,但需先重建下一图像组中的关键帧才能重建当前CS帧,增大了解码延时。

2.3 预测残差稀疏重构

3 仿真结果与分析

按Chen等[9]文章的测试条件,设定图像组内帧数GOP=2,在不同观测率MR下,对典型测试序列News.qcif,Foreman.qcif(176×144)以及 Football.cif(352×240)(运动程度和复杂度依次由低到高)的前51帧的Y分量压缩传感。分配给CS帧较少的观测数,图像组内的观测率分配为:关键帧 MR_K=min(0.9 ×MR ×GOP,0.6),CS帧MR_CS=(MR×GOP-MR_K)/(GOP-1)。采用前向运动补偿和双向运动补偿两种方式(CVS_FMCP和CVS_BMCP),稀疏重构算法SpaRSA[10]的参数为默认设置。

比较所提算法与全局冗余字典(Global-Dict)[9]、局部冗余字典(Local-Dict)[7-8]及基准 CS(Baseline CS)[5]等3种算法的平均重建质量(指标为峰值信噪比PSNR),结果见表1。在MR≥0.2时,CVS_BMCP算法比其他3种算法的重建质量都有不同程度的提高,对运动复杂度低的News序列,PSNR提高约0.9~4.1 dB,对运动复杂度中等或较高的序列,PSNR提高0.15~2.6 dB。但在MR=0.1时,由于关键帧的观测率低于0.2,关键帧重建质量比较差,严重影响了CS帧的运动补偿预测准确性,所以CVS_BMCP算法的重建质量低于Global-Dict算法(在GOP较大时所提算法性能更好,详见下一段的测试结果),但仍然比其他两种算法的PSNR高出4 dB以上。而CVS_FMCP算法比CVS_BMCP算法的重建质量低0.3~1.5 dB,在MR≤0.2时性能也比Global-Dict略差,但与其他两种算法相比PSNR提高了3 dB以上。

表1 不同序列的重建质量

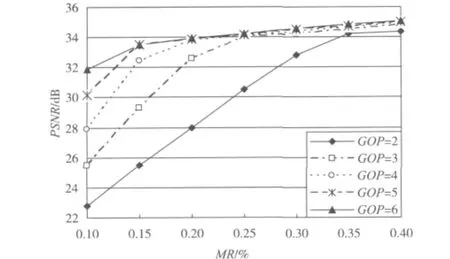

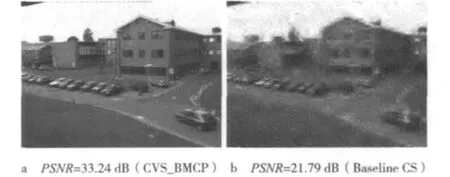

在不同图像组GOP设定下,测试CVS_BMCP算法的性能,对PETS序列(无线视频监控或无线视频传感网络应用)的测试结果如图2所示。低观测率下(MR≤0.25),当GOP逐渐增大时,图像重建质量有明显改善,PETS序列的PSNR提高了3.5~9.0 dB,主要是因为分配给关键帧更高的观测率,其重建质量获得了大幅提高,预测残差也更稀疏,CS帧的重建质量也有相应提高。图3给出了重建的PETS序列第9帧,与基准CS算法相比,采用CVS_BMCP算法(GOP=6)重建帧的PSNR提高了11.4 dB,主观视觉质量也有显著提升。值得指出,对PETS序列,在MR=0.1,GOP=6时,重建帧PSNR达到了32 dB,所提算法更加适合低观测率下的背景静止的无线视频监控类应用。

图2 不同GOP时PETS序列的重建质量

4 结束语

图3 PETS序列第9帧重建CS帧(MR=0.15)

依据运动补偿预测残差比原始图像更稀疏这一特点,提出了一种分布式视频压缩传感算法。仿真测试表明,在相同观测率下,通过将观测数优先分配给关键帧,提高了关键帧的重建质量以及运动补偿预测帧的准确性,对预测残差稀疏重构则提高了CS帧重建质量,非常适合摄像机静止的无线低功耗视频监控与无线视频传感网络类应用。后续需深入研究的几个问题是:在极低观测率下尚需进一步提高算法性能;还需解决观测值的量化、熵编码以及码率控制等问题,以提高编码效率;开发更加快速实用的稀疏重构算法。

[1]DONOHO D L.Compressed sensing[J].IEEE Trans.Information Theory,2006,52(4):1289-1306.

[2]BARANIUK R G.Compressive sensing[J].IEEE Signal Processing Magazine,2007,24(4):118-124.

[3]DUARTE M F,DAVENPORT M A,TAKHAR D,et al.Single-pixel imaging via compressive sampling[J].IEEE Signal Processing Magazine,2008,25(2):83-91.

[4]李树涛,魏丹.压缩传感综述[J].自动化学报,2009,35(11):1369-1377.

[5]GAN L,DO T T,TRAN T D.Fast compressive imaging using scrambled block hadamard ensemble[EB/OL]. [2011-10-12].http://dsp.rice.edu/sites/dsp.rice.edu/files/cs/scrambled_blk_WHT.pdf.

[6]KANG L W,LU C S.Distributed compressive video sensing[C]//Proc.of IEEE International Conference on Acoustics,Speech,and Signal Processing 2009.Taipei:IEEE Press,2009:1169-1172.

[7]PRADES-NEBOT J,MA Y,HUANG T.Distributed video coding using compressive sampling[C]//IEEE Picture Coding Symposium,2009.Chicago:IEEE Press,2009:1-4.

[8]DO T T,CHEN Y,NGUYEN D T,et al.Distributed compressed video sensing[EB/OL].[2011-10-12].http://thanglong.ece.jhu.edu/Tran/Pub/DISCOS_ICIP2009.pdf.

[9]CHEN H W,KANG L W,LU C S.Dynamic measurement rate allocation for distributed compressive video sensing[EB/OL].[2011-10-11].http://vcip2010.ustc.edu.cn/BPC/Special/Dynamic%20measurement%20rate%20allocation% 20for% 20distributed% 20compressive% 20video%20sensing.pdf.

[10]WRIGHT S J,NOWAK R D,FIGUEIREDO M A T.Sparse reconstruction by separable approximation[J].IEEE Trans.Signal Processing,2009,57(8):2479-2493.

[11]ORCHARD M T,SULLIVAN G J.Overlapped block motion compensation:an estimation-theoretic approach[J].IEEE Trans.Image Processing,1994,3(5):693-699.