基于区域预测和视觉注意计算的快速目标检测

2011-08-07秦世引

刘 琼 秦世引

(北京航空航天大学 自动化科学与电气工程学院,北京100191)

随着计算机科学和认知科学的交叉发展,基于人类视觉生理机制实现计算机视觉并应用于目标检测逐渐成为一个活跃的研究分支[1-4].心理学对人类视觉生理机制的研究发现,包含新异刺激、较强刺激和人所期待刺激的场景区域最容易引起观察者的研究注意[5].目前绝大部分的视觉注意计算模型都针对前两种刺激来源开展研究,即通过视觉显著性度量寻找感兴趣区域[6-7].很显然,与前述两种刺激引发的注意机制不同,目标检测是源于高层知识驱动的视觉行为,这种刺激可以处于图像中的任意非显著位置,因此简单地将已有的视觉注意计算模型应用于目标检测时,将会产生大量无关的视点转移而浪费时间,甚至漏检.

从人脑的认知原理可知:即使在复杂的场景下,人眼也可以辨识出目标位置.人脑可以根据经验预测目标大致区域后再进行细致的搜索,因此由粗到精是人眼检测目标的常用检测模式.针对现有的视觉注意计算模型应用于目标检测的不足,并受人类视觉系统检测目标的行为方式所启发,本文提出了一种基于决策规则的目标区域预测方法,并对Itti-Koch视觉注意计算模型进行了改进,进而将两者结合起来,以实现快速精确的目标检测.

1 面向目标区域预测的特征提取

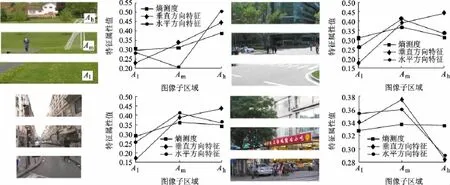

根据大脑中存有的先验知识进行区域预测,并逐渐聚焦注意力是人类视觉系统执行目标检测任务之前的潜意识行为[8].在实现计算机目标检测算法时,采用类似的由粗到精的目标检测模式,可以缩小检测范围,提高检测速度[9].本文通过将图像从上往下依次划分为Ah,Am,Al3个水平子区域,并计算各子区域的方向特征灰度比率和区域信息熵特征,作为预测目标区域的依据.

1.1 方向特征提取

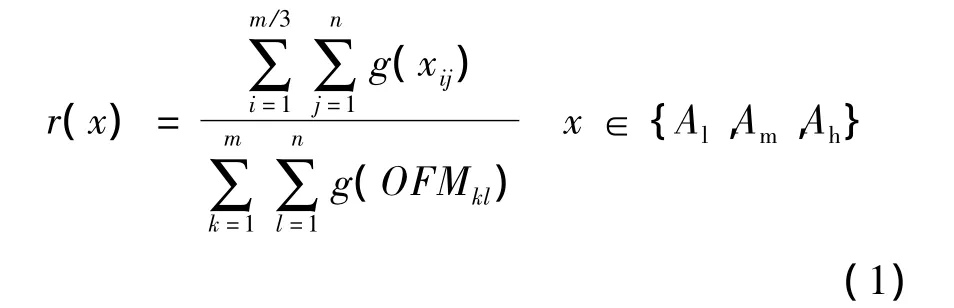

水平和垂直方向特征是行人的典型特征,尤其在远距离拍摄的情况下,其步态对水平和垂直方向特征的干扰可以忽略不计.因而,提取图像的水平和垂直方向特征图,综合比较特征图中各子区域的灰度比率值,可以将天空、地面、车辆等具有典型水平方向特征的物体与行人初步分辨.Gabor滤波器模拟人眼视网膜细胞对方向信息的感知特性,在提取方向特征中得到了广泛地应用[10].本文采用Gabor滤波器提取水平和垂直方向特征图后,根据式(1)计算各子区域的灰度比率特征值作为有效预测目标区域的第1类特征.

其中,r(x)为x子区域在原图方向特征图中的灰度比率特征值;g(xij)为x子区域中(i,j)处的像素灰度值;g(OFMkl)为原图方向特征图中(k,l)处的像素灰度值.

1.2 区域信息熵计算

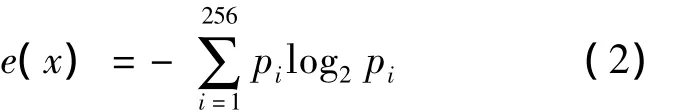

由于场景中建筑物的出现频率高且同样具有典型的垂直和水平方向特征,因而根据单一的方向特征无法有效地预测目标区域.通过对比发现:当区域中主要内容为建筑物时,其纹理丰富导致灰度分布比较均匀,信息熵较大;反之当区域中主要内容为行人时,其灰度的分布比较集中,且信息熵较小.因此,本文选择区域信息熵作为有效预测目标区域的第2类特征.信息熵的计算式为

其中,pi为子区域256维灰度直方图中各个维度上的像素个数占该区域总像素个数的比率.

2 基于规则推断的目标区域预测

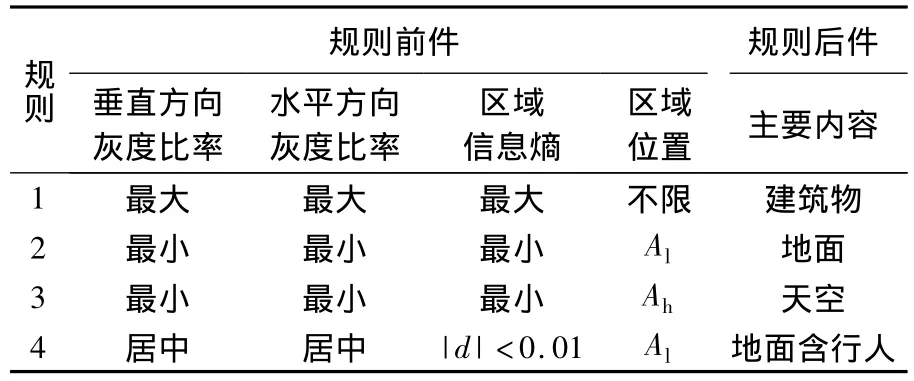

2.1 目标区域预测的规则集合

通过对街道户外场景图像提取相应特征,并分析3个子区域的两类特征属性值的大小关系,如图1所示,可建立表1中的预测规则集,表中|d|代表原图任意两个子区域的熵差.

图1 3个水平子区域图像及其对应的3种特征属性值

表1 目标区域预测的规则集合

2.2 目标区域预测的决策算法

本文在预测过程中采用逐步剔除非目标区域的方式,得到目标区域.决策算法具体步骤如下:

1)区域划分:将原图划分为3个大小近似相等的水平子区域.

2)特征提取与计算:①采用Gabor滤波器提取原图的水平和垂直方向特征图;②根据式(1)计算各子区域方向特征;③根据式(2)计算各子区域信息熵.

3)目标区域预测:①根据各子区域的特征属性值以及其位置信息,并对照表1中的规则前件;若图像某一区域的相应特征能完全满足第1条或第3条规则的前件,则排除该区域;若图像某一区域的相应特征能完全满足第2条规则的前件,则排除该区域,并将其相邻的上方区域作为目标区域;若图像某一区域的相应特征能完全满足表中第4条规则的前件,则保留该区域;若图像中所有子区域的特征组合不能构成表1中任何规则的规则前件,则将整幅图像作为目标区域;②当预测结果为相邻的两个区域,则将其合并输出,作为一个目标区域.

根据上述区域预测的决策算法,对83幅待检测图片进行测试发现,本文算法预测准确率平均为96%,相对随机预测,准确率提高了63%.部分实验图像的目标区域预测结果如图2所示.

图2 原图与行人所在区域的预测结果

3 快速目标检测与精确定位

3.1 改进的Itti-Koch视觉注意计算模型

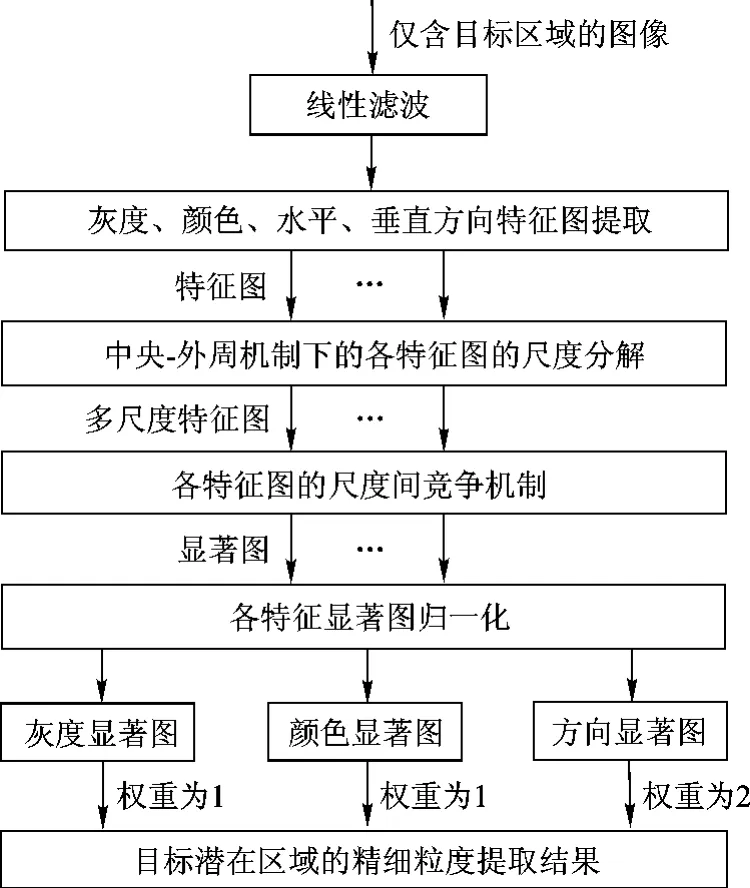

经典的Itti-Koch模型中对所有视觉特征通道采取一概而论的方式,因而将模型直接用于目标检测将有可能导致误检.本文通过优选特征以及优化特征显著图之间的组合权重,得到了更好的检测效果.通过大量试验,当方向特征的融合权重设置为2,灰度和颜色特征的融合权重设置为1时,对行人目标的检测效果最为可靠.此外,考虑到通常情况下,行人目标并不具有对角线方向的特征,而提取该特征反而会给目标检测带来不利的竞争,因此,在改进的Itti-Koch模型中,方向特征只考虑水平和垂直两个方向.改进后的Itti-Koch计算模型如图3所示.

图3 改进的Itti-Koch视觉注意计算模型

3.2 快速目标检测与精确定位算法

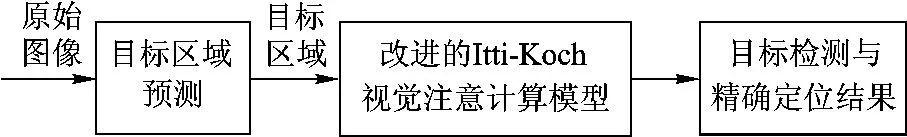

对目标区域进行预测并结合具有主动搜索行为的视觉注意模型,是本文实现复杂场景快速目标检测与精确定位的核心思想,检测流程如图4所示.

图4 基于区域预测和视觉注意模型的目标检测流程

快速目标检测与定位的具体算法步骤如下:

1)目标区域预测:根据目标区域预测的决策算法实现目标区域预测.

2)基于改进Itti-Koch模型的视觉注意计算:①优化模型参数;②将预测的目标区域作为视觉注意计算模型的输入,计算模型预测结果.

3)目标精确定位:人工辅助判断模型计算结果是否为目标区域.若是,即输出带有目标位置标记的原始图像;若否,即开始新一轮的特征显著图之间的竞争得到新的计算结果,并给出新的判断,直到找到目标位置.

4 实验结果比较与算法性能分析

本文实验分别在图像数据库和实拍图像中进行.图像数据库来源于Li Jia的自然图像数据库[11]和 MIT LabelMe 图像数据库[12].在上述两个图像库中包含有行人目标的街道户外场景图像,共选出52幅.此外,实拍图片31幅.为了充分说明区域预测和改进视觉注意模型结合的有效性,将本文算法与经典的Itti-Koch模型相比较,部分实验结果如图5.从图中可看出,本文算法只需很少的视点转移,即可精确捕获目标.

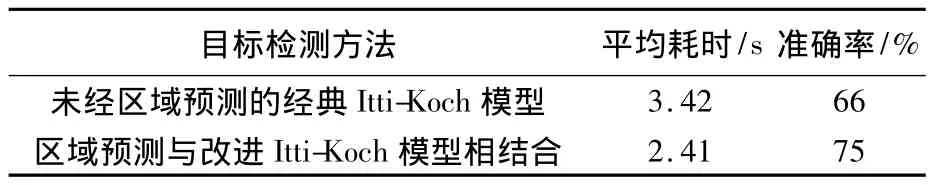

对83幅图像进行目标检测,其算法性能分析统计结果如表2.

表2 算法性能分析统计结果对比

结果表明:相比单纯的Itti-Koch模型视觉注意计算,本文的快速目标检测方法缩短了30%的检测时间,并提高了9%的检测准确率.

图5 Itti-koch模型与本文方法在图像库图像与实拍图像中的目标检测结果

5 结论

本文提出的结合区域预测与视觉注意计算的目标检测方法在能快速检测到目标的同时,还能保证检测结果具有较高的准确率.实现区域预测的4条规则主要源于对日常拍摄的自然图像的总结.在这一类图像中,行人在图像中的尺寸一般不超过图像高度的1/3.由于文中实验图像都是自然图像,且通过日常非特写的拍摄方式获取,因此可将其推广用于安防视频监控以及灾难救援中的行人检测,也可用于相机拍摄中的人物锁定等.

本文方法以户外场景中的行人目标作为实验验证平台,在将其应用于不同检测目标时,只需构建相应的区域预测决策规则,优化视觉注意模型参数,则基于区域预测和视觉注意模型相结合的快速目标检测模式依然适用.

References)

[1]郑南宁.认知过程的信息处理和新型人工智能系统[J].中国基础科学,2000(8):11-20 Zheng Nanning.Information processing for cognition process and new artificial intelligent systems[J].China Basic Science,2000(8):11-20(in Chinese)

[2]王璐,蔡自兴.未知环境中基于视觉显著性的自然路标检测[J].模式识别与人工智能,2006,19(1):100 -105 Wang Lu,Cai Zixing.Visual saliency based natural landmarks detection under unknown environments[J].Pattern Recognition and Artificial Intelligence,2006,19(1):100 -105(in Chinese)

[3]Mutch J,Lowe D G.Object class recognition and localization using sparse features with limited receptive fields[J].International Journal of Computer Vision,2008,80(1):45 -57

[4]李志成,秦世引,Itti L.遥感图像的显著-概要特征提取与目标检测[J].北京航空航天大学学报,2010,36(6):659 -662 Li Zhicheng,Qin Shiyin,Itti L.Extraction of saliency-gist features and target detection for remote sensing images[J].Journal of Beijing University of Aeronautics and Astronautics,2010,36(6):659-662(in Chinese)

[5]Yantis S.Stimulus-driven attentional capture and attentional control settings[J].Journal of Experimental Psychology:Human Perception and Performance,1993,19(3):676 -681

[6]Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254 -1259

[7]张菁,沈兰荪,高静静.基于视觉注意模型和进化规划的感兴趣区检测方法[J].电子与信息学报,2009,31(7):1646-1652 Zhang Jing,Shen Lansun,Gao Jingjing.Region of interest detection based on visual attention model and evolutionary programming[J].Journal of Electronics & Information Technology,2009,31(7):1646 -1652(in Chinese)

[8]Pollmann S,Manginelli A A.Repeated contextual search cues lead to reduced bold-onset times in early visual and left inferior frontal cortex[J].Open Neuroimag J,2010(4):9 - 15

[9]Oliva A,Torralba A,Castelhano M S,et al.Top-down control of visual attention in object detection[C]//SuviSofi Oy Ltd.Proceedings of the IEEE International Conference on Image Processing.Barcelona,Spain:IEEE Signal Processing Society,2003:253-256

[10]Durrie D,Mcminn P S.Computer-based primary visual cortex training for treatment of low myopia and early presbyopia[J].Trans Am Ophthalmol Soc,2007,105:132 -140

[11]Li Jia.Photography image database[EB/OL].University Park:The Pennsylvania State University,2001[2010-06-17].http://www.stat.psu.edu/~ jiali/index.download.html

[12]Torralba A.LabelMe image database[EB/OL].Cambridge,MA:Computer Science and Artificial Intelligence Laboratory,Massachusetts Institute of Technology,2006 [2010-06-17].http://people.csail.mit.edu/torralba/GlobalFeaturesAndAttention/