基于多特征融合的稳健手势检测方法

2010-06-07王贵锦林行刚

沙 亮,王贵锦,林行刚

(清华大学 信息科学与技术国家实验室;电子工程系,北京 100084)

1 手势检测技术简介

基于手势的人机交互在机器人控制、3D动画、娱乐、汽车电子、安全认证等诸多领域应用广泛[1]。近年来,Sony,Toshiba,Nintendo,Microsoft,IBM,Nokia 等国际知名企业纷纷致力于将手势交互应用于消费电子领域,推出了大量原型产品[2-7]。这些产品大多仍采用接触式传感器来测量手关节的参数,虽然可精确地还原手势的3D空间模型,却因不舒适而降低了用户体验。目前,手势交互正逐渐转变为通过非接触式的实时视频采集用户动作,以计算机视觉的方式分析手势的纯视觉方式。该方式下用户无须佩戴任何装置,也不受空间位置的约束,采用日常生活中的手势给出交互指令,在自然舒适的状态下进行人机对话[8]。

手势视觉交互的核心是手势检测,其实质是指通过系统的分析,标定出视频中特定手势出现的时间和空间位置。由于人手是由27自由度的复杂链接体[1],同一手势经常因尺度、旋转、仿射和用户个体差异等呈现外观差异,同时受到纹理混杂或相似颜色背景的干扰,使稳健的手势检测面临巨大挑战。

现有的手势视觉检测技术可分为3类:1)通过佩戴颜色标记进行检测,性能有保证,但使用不便[9];2)基于运动检测,方法简单但易受光照影响,不够稳定[10];3)通过机器学习的方法,运用AdaBoost技术,实现对特定手势的快速检测[11]。该方法对尺度和用户差异有很好的效果,但因采用Haar特征,易受背景混杂的影响,对交互场景有一定限制。

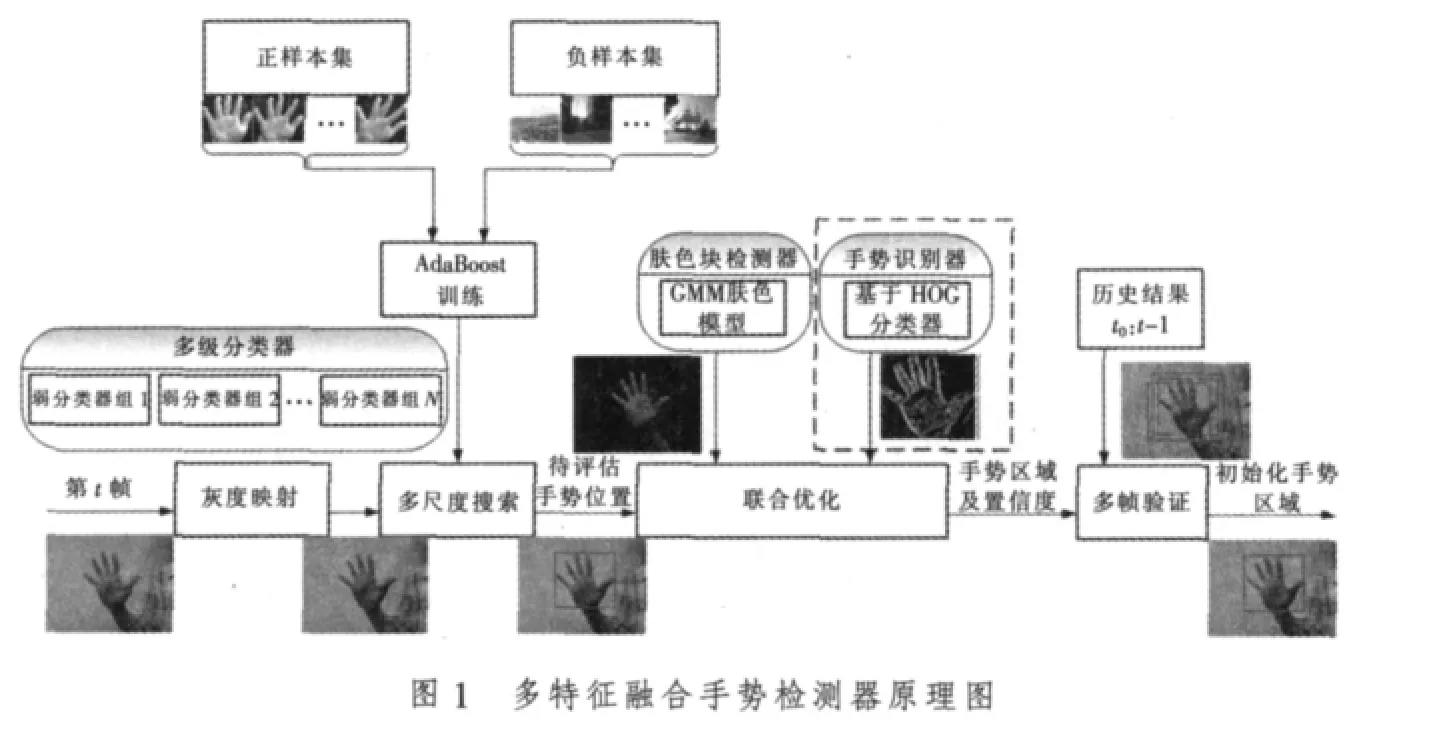

为在不同场景中实现稳健的交互手势检测,笔者提出了一种基于多特征融合的检测方案。在训练AdaBoost检测器基础上,通过结合混合高斯模型的肤色检测器和梯度方向直方图的识别器,运用连续多帧的结果,依据Fisher准则融合为最优线性鉴别式分类器,在多类复杂场景中取得了很好的检测结果。图1为多特征融合手势检测器原理图。以手掌与拳头两类典型的交互手势检测对本文方法进行验证。

2 AdaBoost手势检测器

本文采用Intel OpenCV中的开源AdaBoost训练器[12]。在训练前将正样本图像调整为24×24像素灰度图,设定分类器结构为TreeBoost,采用FloatBoost训练以便得到概率输出的结果,每级强分类器正样本通过率为99.5%,负样本通过率为50%。对于“拳头”,训练得到15级强分类器,使用1250个Haar-like特征;对于 “开手掌”,训练得到20级强分类器,使用1730个Haar-like特征。为减少漏检,在融合过程中分别保留5级强分类器。

3 肤色块检测器

肤色是人体的特征,且在手势上分布较为一致。由于基于混合高斯模型(GMM)的检测器具备简练的参数化的建模方式和适合快速运算的特点,本文选择其作为肤色快检测器的基础。在本文的训练过程中,采用在不同光照和不同样本下采集的视频,标定出肤色区域的像素,约4000000个。以其他静止图片和视频中其他像素为非肤色像素集进行训练,分别生成16核的肤色模型和非肤色模型。

4 手势识别器

利用提取梯度方向直方图(HOG)特征描述手势,可以有效地解决手势平面内旋转造成的影响。因而基于AdaBoost检测的手势区域通过提取HOG特征并与相应的手势模板计算相似度,以概率的形式提供手势识别的置信度信息,参与融合过程。本文通过采集25个人的760个不同外观的手势样本,进行统计获得手势模板,具体过程参见文献[13]。

5 融合算法

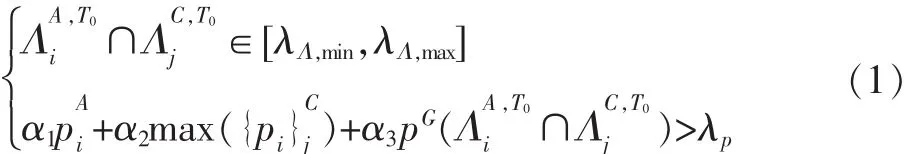

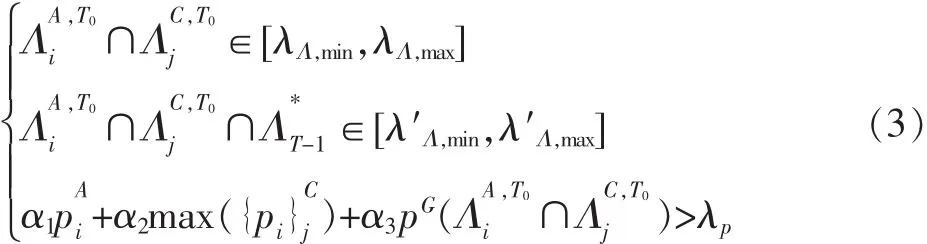

本部分阐述的是多个检测器的融合方法,其融合依据为上述各检测器输出的检测结果区域Λ及其对应的置信度pG(Λ)。设检测过程从T0帧开始,则在T帧,AdaBoost手势检测器输出为,肤色块检测器输出为。若T-1帧的融合后输出为,则多检测器的融合过程可概括为以下3个步骤:

1)初始化

设 T=T0,当 i∈[1,M],j∈[1,N],使得

完成初始化,令T=T+1,进入步骤2)。否则T=T+1,重复步骤1)。

2)单帧融合

当 i∈[1,M],j∈[1,N],使得

其中,[λ′Λ,min,λ′Λ,max]为考虑了多帧重叠的较小的面积区间。

否则令 T=T0,返回步骤 1)。

3)多帧融合

若

其中,λT和λ′p,t分别为积累帧数阈值和积累置信度阈值。是一组遗忘因子,本文中满足

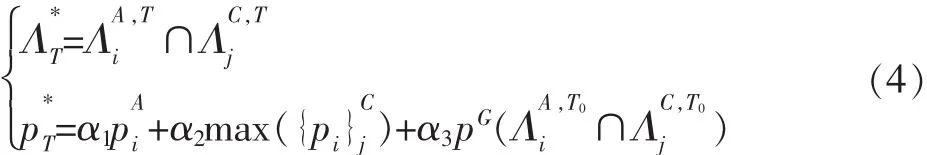

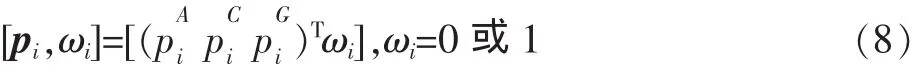

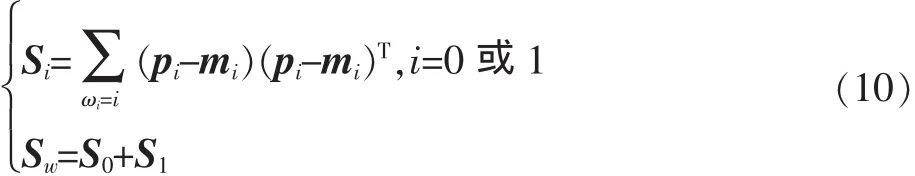

上述算法中的关键问题是如何确定各检测器的输出概率融合阈值λp。事实上,从机器学习的观点来看,采用标记好的若干正样本区域,每个区域提供的参数包括,提供若干负样本区域,每个区域提供的参数包括则转化为一个半监督的学习问题。简化起见,设计一个线性分类器如下

设

式中:[pi,ωi]为一个标记了是/非手势区域的样本。存在正样本N1个,负样本N0个的训练集。若设各类样本均值向量mi为

样本类内离散度矩阵Si和总类内离散度矩阵Sw为

利用Fisher准则解得

于是可得

这一算法的最大特色在于综合考虑了目标尺度的需求、帧内多检测(识别)器的联合置信度、多帧检测结果的一致性和置信度的稳定性,最大程度上均衡了多检测器因采用单一特征而造成的性能缺陷。例如Haar特征在相似的衣服纹理上造成的误检,可由肤色块检测校正;而Haar特征在目标平面内小角度旋转下输出置信度很低,可由手势识别器中对小角度比较稳健的梯度方向直方图特征的置信度输出来提升,以免发生漏检。肤色块在背景颜色近似时造成连通域很大,可由AdaBoost检测调整。时域上多帧参数的验证则消除了背景运动,特别是用户身体移动的影响,因而能够比较准确地提供手势区域的目标模型,为全手势的人机交互奠定基础。

6 实验结果分析

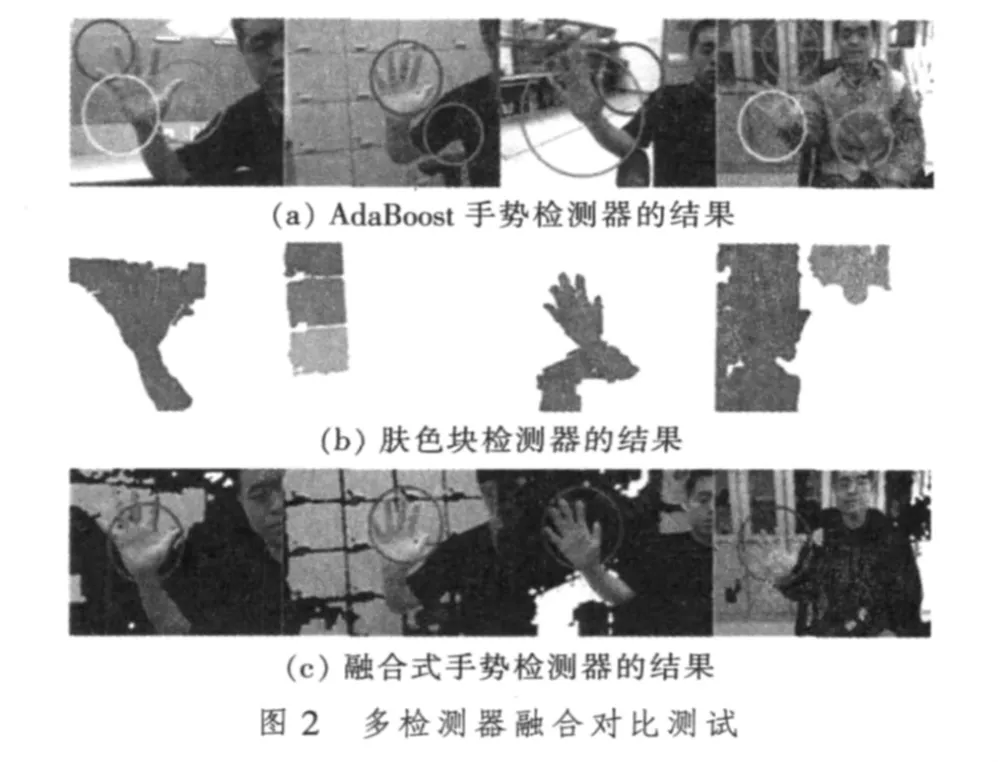

为验证本文多检测器置信度融合的手势检测算法的检测性能和实时性能,这里特别给出通用计算机和低硬件资源的上网本两款平台上的测试结果。在下文中,A平台为配备Intel Pentium41.6 GHz CPU和2 Gbyte RAM的PC,B平台为配备Intel Atom 1.6 GHz CPU和2 Gbyte RAM的上网本。测试中使用的数据是实时采集的多个场景的交互视频,考虑到不同背景、光照的条件,在采集过程中,对用户的手势标准性未做严格限制,使得平面内旋转,尺度变化,与相似颜色背景、混杂背景的重叠等挑战更为突出。共测试5段视频,共1782帧,每帧中包括1个开手掌手势,另有1132帧不含交互手势或包括其他干扰手势。表1是各检测器在这些测试数据上的运行性能,表2是融合检测器各模块在平台A和平台B上的资源占用情况。图2中列出了一些有代表性的帧分别通过单独的检测器和融合后的检测结果。

表1 实时视频性能测试 %

表2 融合检测器的资源占用评估

图2a为使用AdaBoost的测试结果,图2b给出了对应各帧基于肤色/非肤色模型检测的肤色块,图2c给出了上述检测器结合手势识别器进行的融合检测的结果。可见,通过融合后的检测器,不仅手势的检测稳健性很强,更适合在低端的计算平台上进行实时处理,有利于嵌入不同平台上的应用程序。

7 小结

笔者从多特征融合的角度出发,深入研究了各种特征对手势检测问题的贡献和缺陷,从而提出一种融合式的手势检测器。从AdaBoost手势检测器的设计出发,依次论述了基于混合高斯模型的肤色块检测器的原理和训练过程、基于梯度方向直方图描述的手势识别器和多帧历史输出的验证模型,提出了多概率加权的判决准则和区域有效性判别准则,解决了异构特征在检测结果上的难于互补的困境。最后通过性能和效率的实验验证了融合式检测器的优势,证明了本文检测器在不同条件下,都能够有效地解决稳健检测特定手势的难题,为多种人机交互任务提供了保障。

[1]WU Y,HUANG T.Hand modeling,analysis and recognition[J].IEEE Signal Processing Magazine,2001,18(3):51-60.

[2]REKIMOTO J.Gesturewrist and gesturepad:unobtrusive wearable interaction devices[EB/OL].[2010-02-20].http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.24.6401&rep=rep1&type=pdf.

[3]CARREIRA J,PEIXOTO P.Retrieving and exploiting hand′s orientation in tabletop indenfication[EB/OL].[2010-02-20].http://www.isr.uc.pt/~joaoluis/papers/ieeemultimedia07.pdf.

[4]Nintendo.Wii sensor[EB/OL].[2010-02-20].http://www.nintendo.com/wii.

[5]Microsoft.Xbox360[EB/OL].[2010-02-20].http://www.xbox.com/.

[6]IBM vision group.Virtual forbidden city[EB/OL].[2010-02-20].http://emsys.denayer.wenk.be/T-cell/Presentaties/Austin/IBM_Gesture_Interface_Recognition_with_Cell_BE_March_4.pdf.

[7]ZHANG X,CHEN X,WANG W,et al.Hand gesture recognition and virtual game control based on 3D accelerometer and EMG sensors[EB/OL].[2010-02-20].http://portal.acm.org/citation.cfm?id=1502708.

[8]PENTLAND A.Perceptual intelligence[EB/OL].[2010-02-20].http://www.ayrmetes.com/articles/perceptual_intelligence.htm.

[9]MISTRY P,MAES P.SixthSense: a wearable gestural interface[EB/OL].[2010-02-20].http://www.pranavmistry.com/projects/sixthsense/.

[10]KOLSCH M.Vision based hand gesture interfaces for wearablecomputing and virtual environment[D].Santa Barbara,USA:University of California,2004.

[11]FANG Y,WANG K,CHENG J,et al.A real-time hand gesture recognition method[C]//Proc.IEEE International Conference on Multimedia and Expo.Beijing:IEEE Press,2007:995-998.

[12]BRADSKI G,KAEHLER A,PISARERSKY V.Learning-based computer vision with Intel′s open source computer vision library[J].Intel Technology Journal,2005,9(2):119-130.

[13]SHA L,WANG G,LIN X,et al.Hand posture recognition in video using multiple cues[C]//Proc.the 2009 IEEE International Conference on Multimedia and Expo.New York,USA:IEEE Press,2009:886-889.