面向小样本苗绣图像的生成与识别研究

2025-02-21吴菁杨邦勤张银建李明珠陈妍

摘 要:为了解决苗绣图像样本量不足以及识别精度较低的问题,提出了一个新颖的样式生成对抗网络(StyleGAN2)结合高效通道注意力机制(ECA)优化的残差神经网络(ResNet50)苗绣图像分类模型。首先,利用StyleGAN2对原始苗绣数据集进行训练和生成,以扩充小样本数据集。接着,在ResNet50骨干网络中融入ECA注意力机制,增强了模型的特征提取能力。最终,结合StyleGAN2和ECA优化后的ResNet50创建了新的StyleGAN2-ECA-ResNet50模型,用于小样本苗绣图像的识别。实验结果显示,该方法在测试集上的准确率达到了89.29%,较传统的ResNet50模型提高了5.87%,并且在性能上超过了多个先进的深度学习模型。

关键词:苗绣;小样本图像分类;数据增强;StyleGAN2;ECA

中图分类号:TP391 文献标识码:A 文章编号:2096-4706(2025)02-0024-09

Research on Generation and Recognition of Few-Shot Miao Embroidery Images

WU Jing1,2, YANG Bangqin1, ZHANG Yinjian1, LI Mingzhu2, CHEN Yan1,3

(1.School of Data Science and Information Engineering, Guizhou Minzu University, Guiyang 550025, China; 2.ZX-YZ School of Network Science, Haikou University of Economics, Haikou 570203, China; 3.School of Automation Science and Engineering, South China University of Technology, Guangzhou 510641, China)

Abstract: To address the issues of insufficient sample sizes and low recognition accuracy of Miao embroidery images, this paper proposes a novel Miao embroidery image classification model, which combines StyleGAN2 with optimized ResNet50 by the Efficient Channel Attention (ECA). Firstly, StyleGAN2 is utilized to train and generate on the original Miao embroidery dataset, thereby augmenting the Few-Shot dataset. Subsequently, the ECA Attention Mechanism is integrated into the ResNet50 backbone network to enhance the feature extraction capability of the model. Ultimately, the new StyleGAN2-ECA-ResNet50 model is created by combining StyleGAN2 and ResNet50 optimized by ECA for the recognition of Few-Shot Miao embroidery images. Experimental results show that the accuracy of this method reaches 89.29% on the test set, which is an improvement of 5.87% over the traditional ResNet50 model and surpasses several advanced Deep Learning models in performance.

Keywords: Miao embroidery; Few-Shot image classification; data augmentation; StyleGAN2; ECA

0 引 言

苗绣,作为中国独特的非物质文化遗产,是中国苗族文化的重要组成部分,具有深厚的历史文化积淀和丰富的艺术价值。它不仅是苗族人民日常生活、婚嫁仪式等重要社会活动中的必备技艺,更承载着苗族独特的民族记忆与审美追求[1]。然而,随着现代化的推进和传统手工艺传承方式的衰退,苗绣的生存环境日益严峻。为了保护这一珍贵的非物质文化遗产,探索数字化手段的保护与传承已成为当前学界和文化保护领域的重要方向[2]。

近年来,苗绣的数字化保护日益受到重视。数字化技术为苗绣的纹样、技法和文化信息的精确记录提供了新的手段,不仅能够动态保存这一非物质文化遗产,还可以通过虚拟现实(VR)和增强现实(AR)等技术增强其展示效果,提升观众的互动体现[3]。此外,智能绣花机的数码仿真技术在苗绣的传承与创新中发挥了重要作用,为其在现代社会中的应用开辟了新的路径[4]。陈世婕的研究表明,利用多尺度网络对苗绣绣片纹样进行分割,不仅提高了图像处理的效率,还为苗绣的数字化保护提供了技术支持[5]。田玉晶在贵州遵义苗绣纹样的数字化生成研究中指出,数字技术可以实现苗绣纹样的高效生成和展示,为苗绣的传承提供了新的途径[6]。通过数字化手段,不仅可以记录和保存传统苗绣的技艺和图案,还能通过线上平台进行展示和传播,使得更多人能够了解和学习这一传统技艺。

在当前的计算机视觉领域,小样本学习(Few-Shot Learning, FSL)作为一种应对训练数据稀缺的有效方法,受到广泛关注。小样本学习的主要方法包括元学习(Meta-Learning),通过从多任务中学习共享知识快速适应新任务;度量学习(Metric Learning),通过优化度量空间提升分类性能;以及数据增强(Data Augmentation),用于扩充有限数据以增强模型泛化能力[7-9]。

近年来,国内外学者采用了多种深度学习模型来解决小样本分类问题。例如,EfficientNetB0作为一种高效的卷积神经网络架构,通过复合缩放方法提升了分类性能,但在处理高多样性的图像数据时表现仍不够理想[10]。MobileNetV2由于其轻量化结构和高效的卷积操作,被广泛应用于移动设备中的图像分类任务,然而在小样本学习场景中,其泛化能力有限[11]。DenseNet121通过密集连接机制改善了梯度传递和特征复用,但在面对复杂的苗绣图案时,其特征提取能力仍显不足[12]。VGG16以其深层次的网络结构在许多图像分类任务中表现优异,但其参数量大,计算成本高,且在小样本学习中容易过拟合[13]。针对上述模型的不足,本文提出了一种结合StyleGAN2数据增强和ECA注意力机制的苗绣图像分类方法,以提高分类精度和泛化能力。

本文选择数据增强方法来解决苗绣小样本图像分类问题,采用StyleGAN2来扩充数据集。StyleGAN2是基于StyleGAN改进的生成对抗网络(GAN),在图像生成任务中表现出色,能够生成高质量且多样化的图像,有效缓解过拟合问题并提高模型的泛化能力[14-15]。通过使用StyleGAN2,能够扩展现有的数据集,捕捉到苗绣图案的细微特征,进一步提高分类模型的精度。在数据增强之后,在ResNet50模型中嵌入了有效通道注意力机制(Efficient Channel Attention, ECA),以进一步提升分类性能。ECA注意力机制通过自适应地调整不同通道的权重来增强模型对关键特征的关注,从而提高分类的准确性和鲁棒性[16]。

本文的主要贡献包括:提出了一种结合StyleGAN2数据增强和ECA注意力机制的苗绣图像分类方法;通过实验证明,使用StyleGAN2生成的扩充数据结合嵌入ECA注意力机制的ResNet50模型,能够显著提升分类性能;为苗绣设计的创意化提供了一种人工智能的方式——利用算法进行苗绣图像生成。

1 理论基础

1.1 ResNet50残差网络

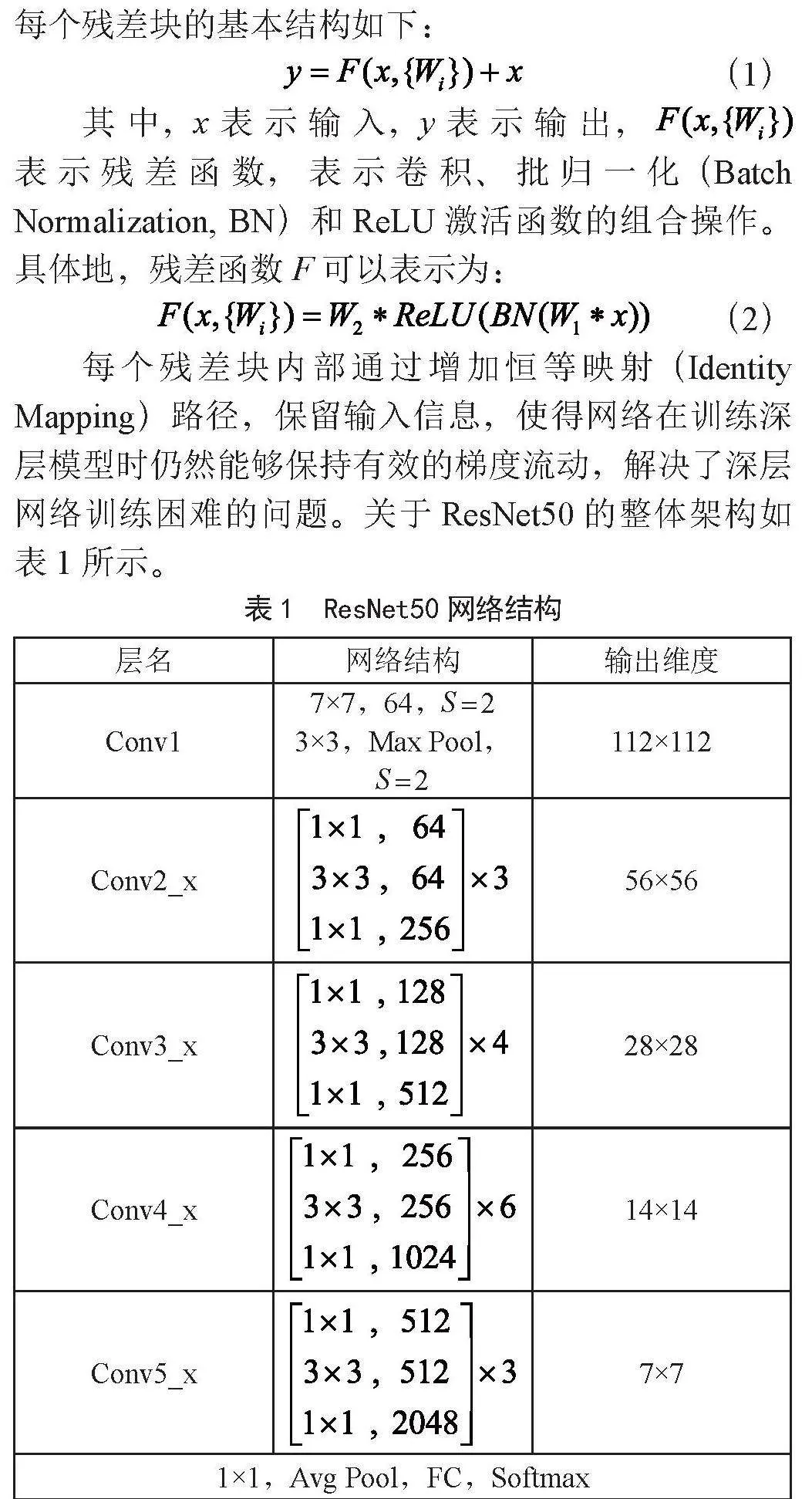

本文选择了基于ResNet50的架构作为核心的卷积神经网络框架。ResNet50通过引入恒等映射的卷积网络结构来减轻退化问题,消减深度网络的训练难度,提高网络的性能及精度。该模型的结构包括六个关键部分:一个输入单元、四个包含不同数量残差单元(3、4、6和3个)的残差模块,以及一个输出单元。每个残差块的基本结构如下:

(1)

其中,x表示输入,y表示输出,表示残差函数,表示卷积、批归一化(Batch Normalization, BN)和ReLU激活函数的组合操作。具体地,残差函数F可以表示为:

(2)

每个残差块内部通过增加恒等映射(Identity Mapping)路径,保留输入信息,使得网络在训练深层模型时仍然能够保持有效的梯度流动,解决了深层网络训练困难的问题。关于ResNet50的整体架构如表1所示。

1.2 StyleGAN2网络

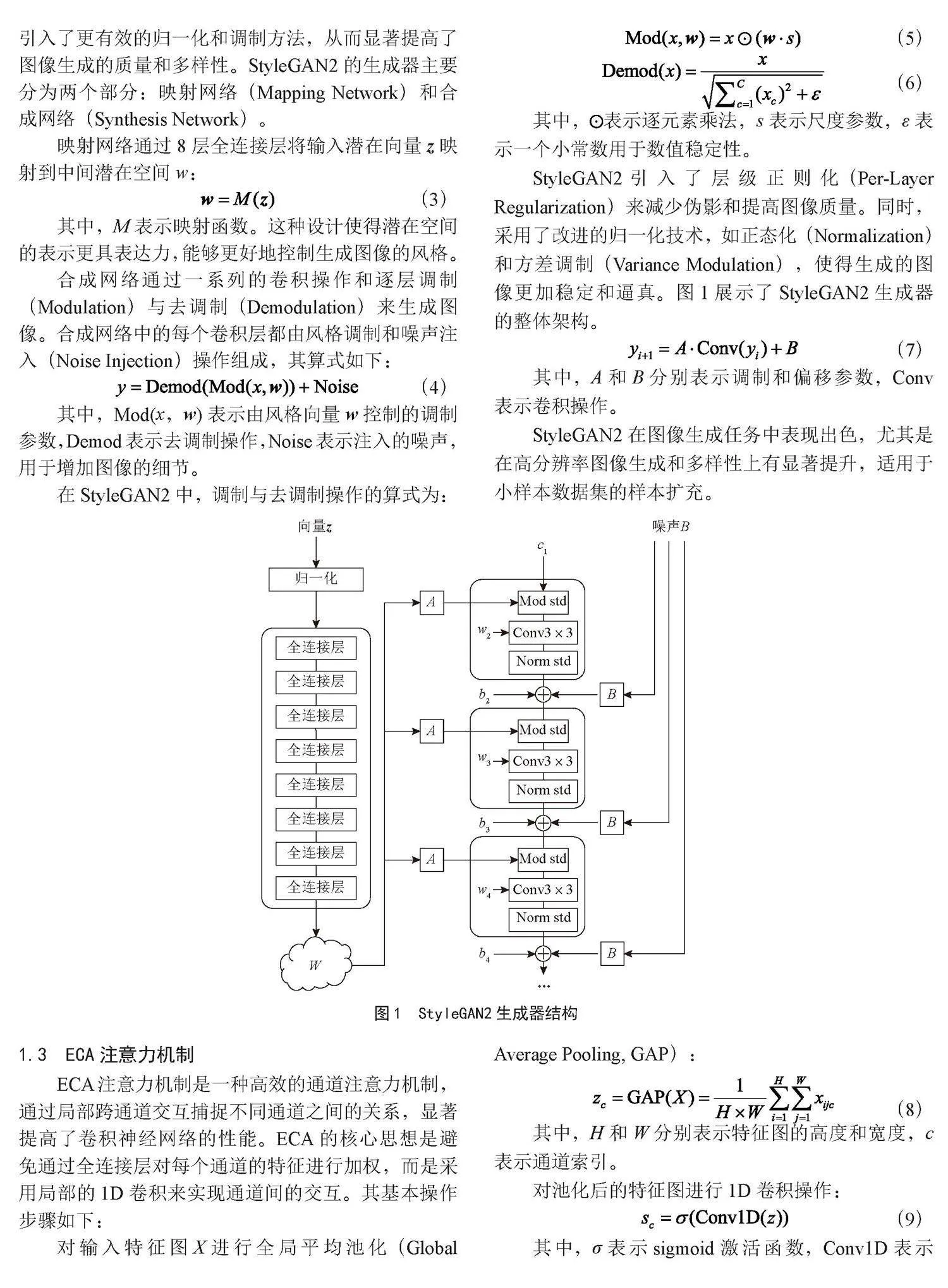

StyleGAN2是一种先进的生成对抗网络(Generative Adversarial Network, GAN)模型,用于高质量图像生成。相比其前身StyleGAN,StyleGAN2引入了更有效的归一化和调制方法,从而显著提高了图像生成的质量和多样性。StyleGAN2的生成器主要分为两个部分:映射网络(Mapping Network)和合成网络(Synthesis Network)。

映射网络通过8层全连接层将输入潜在向量z映射到中间潜在空间w:

(3)

其中,M表示映射函数。这种设计使得潜在空间的表示更具表达力,能够更好地控制生成图像的风格。

合成网络通过一系列的卷积操作和逐层调制(Modulation)与去调制(Demodulation)来生成图像。合成网络中的每个卷积层都由风格调制和噪声注入(Noise Injection)操作组成,其算式如下:

(4)

其中,Mod(x,w)表示由风格向量w控制的调制参数,Demod表示去调制操作,Noise表示注入的噪声,用于增加图像的细节。

在StyleGAN2中,调制与去调制操作的算式为:

(5)

(6)

其中,表示逐元素乘法,s表示尺度参数,ε表示一个小常数用于数值稳定性。

StyleGAN2引入了层级正则化(Per-Layer Regularization)来减少伪影和提高图像质量。同时,采用了改进的归一化技术,如正态化(Normalization)和方差调制(Variance Modulation),使得生成的图像更加稳定和逼真。图1展示了StyleGAN2生成器的整体架构。

(7)

其中,A和B分别表示调制和偏移参数,Conv表示卷积操作。

StyleGAN2在图像生成任务中表现出色,尤其是在高分辨率图像生成和多样性上有显著提升,适用于小样本数据集的样本扩充。

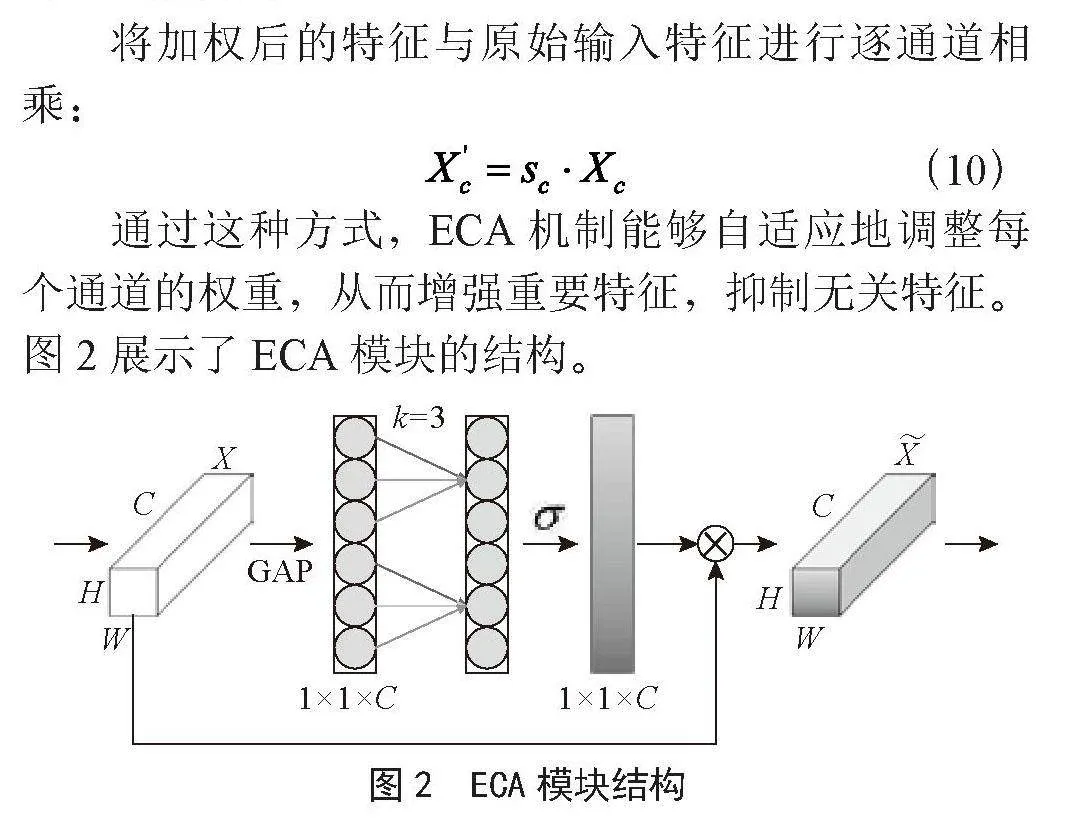

1.3 ECA注意力机制

ECA注意力机制是一种高效的通道注意力机制,通过局部跨通道交互捕捉不同通道之间的关系,显著提高了卷积神经网络的性能。ECA的核心思想是避免通过全连接层对每个通道的特征进行加权,而是采用局部的1D卷积来实现通道间的交互。其基本操作步骤如下:

对输入特征图X进行全局平均池化(Global Average Pooling, GAP):

(8)

其中,H和W分别表示特征图的高度和宽度,c表示通道索引。

对池化后的特征图进行1D卷积操作:

(9)

其中,σ表示sigmoid激活函数,Conv1D表示1D卷积操作。

将加权后的特征与原始输入特征进行逐通道相乘:

(10)

通过这种方式,ECA机制能够自适应地调整每个通道的权重,从而增强重要特征,抑制无关特征。图2展示了ECA模块的结构。

2 本文所提模型架构

2.1 苗绣小样本生成识别模型框架流程图

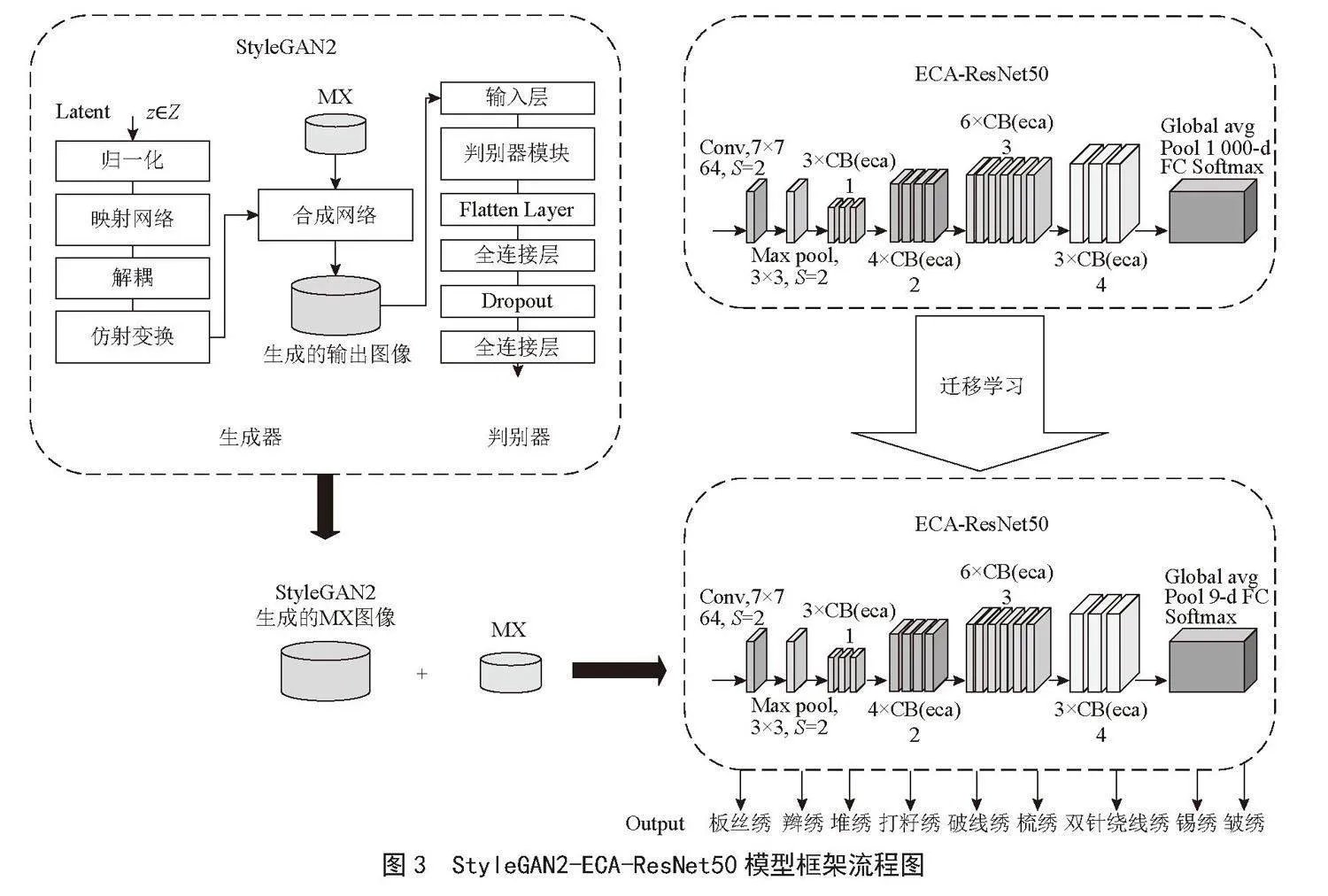

在本次研究中,提出了一种改进的基于样式生成对抗网络(StyleGAN2)和高效注意力机制(ECA)的苗绣小样本生成识别模型框架,称为StyleGAN2-ECA-ResNet50模型框架,其结构如图3所示。

从StyleGAN2-ECA-ResNet50模型框架流程图中可以看出,本文采用了跨域迁移学习方法[17]。迁移学习是一种深度学习方法,它通过复用源数据集中训练好的模型权重,能够有效解决目标数据集数据不足的问题,减少对大规模标注数据的依赖,并提高模型在目标任务中的性能[18-19]。ImageNet数据集庞大,包含约1 400万张图像和1 000个类别。在ImageNet上训练的特征可以有效地迁移到其他图像分类任务中,并且使用迁移学习进行训练比从头开始训练效果更好。

该模型的工作流程可分为三个步骤:

1)对MX数据集使用StyleGAN2进行数据扩充。即从潜在空间z采样潜在向量并进行归一化处理,将归一化后的潜在向量通过映射网络映射到中间潜在空间,并进行结构操作生成风格向量,风格向量再通过合成网络最终输出新生成的苗绣图像。

2)在ResNet50模型中嵌入ECA模块。图中的CB(eca)则表示嵌入了ECA模块的卷积块,亦即嵌入了ECA的Bottleneck块,输入图像通过卷积层、池化层和ECA注意力机制模块后被提取特征,最后通过全局平均池化和全连接层进行分类。

3)将预训练的ECA-ResNet50模型进行迁移学习,并对最后一层进行微调,使其适应生成的图像和原始图像的混合输入。即新生成的图像与原始MX图像被混合输入到微调后的嵌入ECA模块的ResNet50模型中,利用预训练的模型权重,通过卷积层、池化层和ECA注意力机制模块提取图像特征,最终通过全局平均池化和全连接层进行分类,得到苗绣分类结果。

2.2 苗绣分类器ECA-ResNet50介绍

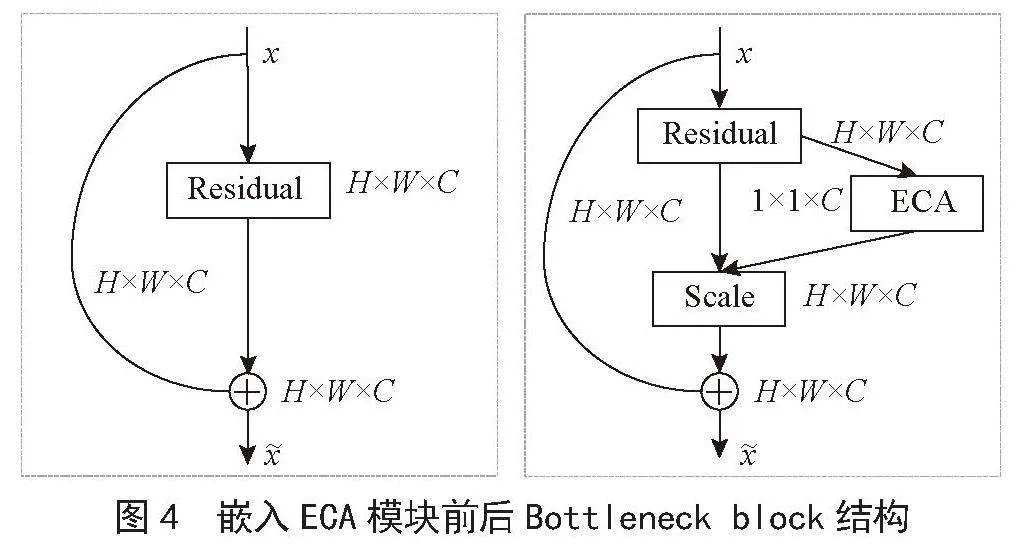

该模型的关键部分是将ECA注意力机制嵌入到ResNet50的残差块中,以提升模型的特征提取能力。具体来说,ECA模块被嵌入在每个残差块的ReLU激活函数之后,通过对每个通道进行加权,增强重要特征的表达。ECA模块通过全局平均池化(GAP)和一维卷积(Conv1D)实现对通道注意力的高效捕捉。首先,对输入特征图进行全局平均池化,得到每个通道的全局描述,然后通过一维卷积操作实现通道间的交互,最后通过Sigmoid激活函数生成注意力权重,并将这些权重应用于原始特征图上,从而增强重要通道特征,抑制不重要通道特征。

在具体实现上,将预训练的ResNet50模型中的每个瓶颈层(Bottleneck)替换为带有ECA模块的增强版瓶颈层。原始的瓶颈层由多个卷积层和批归一化层组成,在这些层之后嵌入ECA模块,使得每个瓶颈层在提取空间特征的同时,还能动态调整通道的重要性。

改进后的瓶颈层结构如下:

1)输入特征图经过多个卷积层和批归一化层的处理。

2)在ReLU激活函数之后,特征图进入ECA模块,通过全局平均池化和一维卷积生成注意力权重。

3)将注意力权重应用于特征图,增强关键特征。

4)将原始输入特征图通过残差连接与增强后的特征图相加,缓解梯度消失问题。

5)最后经过ReLU激活函数,输出处理后的特征图。

通过这种方式,ECA模块能够在保持网络深度和复杂度的同时,进一步提升模型对重要特征的学习效率和精确度。在ECA-ResNet50中,每个残差块经过上述改进,使得整个模型在特征提取过程中更加高效,嵌入ECA模块前后Bottleneck block结构如图4所示。这种嵌入方式的优势在于,通过局部的卷积操作实现了对通道注意力的高效捕捉,同时避免了全连接层带来的大量参数开销,适用于各种深层卷积神经网络。

3 实验设置

3.1 实验数据集及参数

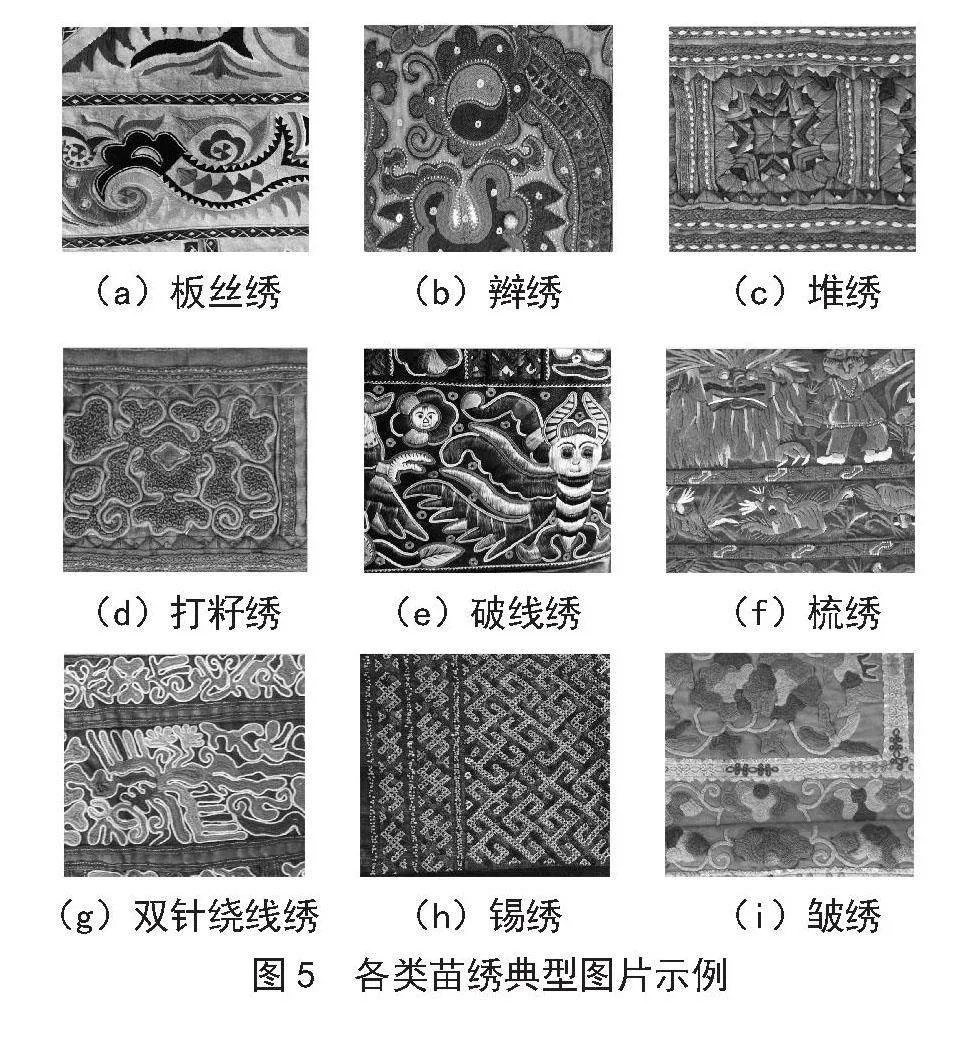

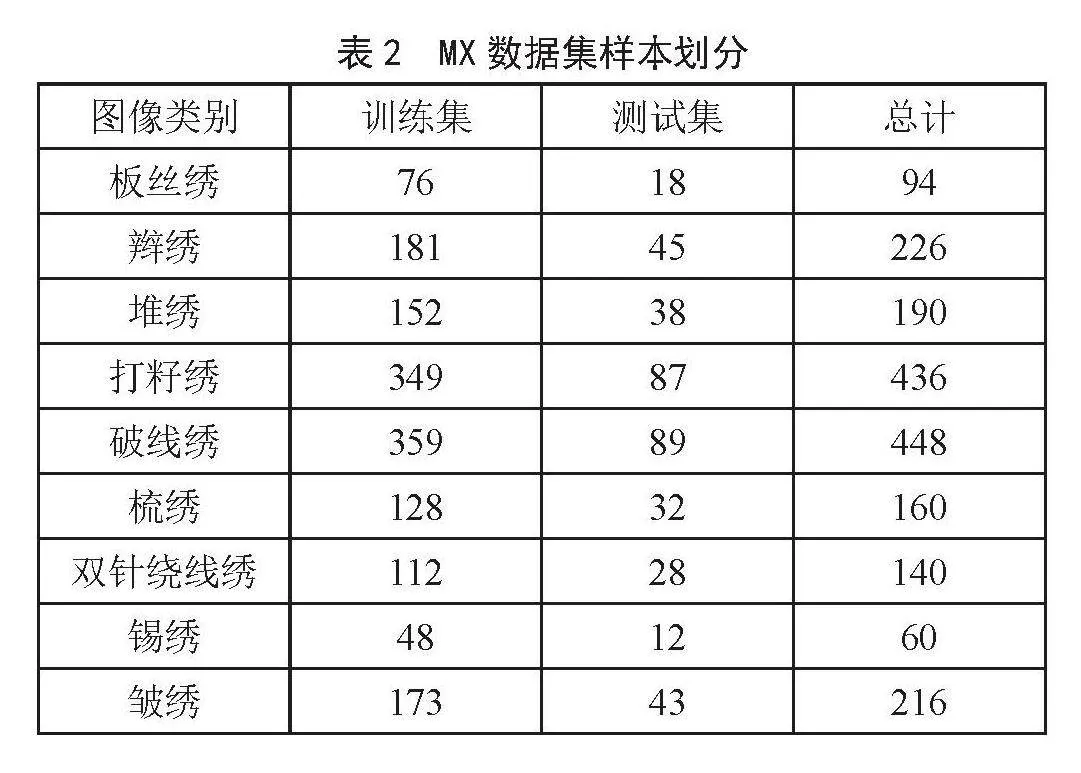

本文使用的苗绣数据集主要通过实地调研贵州省黔东南苗族侗族自治州台江县的苗族村落获得。研究团队在走访过程中用手机拍摄收集了这些数据,确保了数据的真实性和多样性,下面将该苗绣数据集称为MX,其包含九个类别,分别是板丝绣、辫绣、堆绣、打籽绣、破线绣、梳绣、双针绕线绣、锡绣和皱绣,共计1 970张图片,各类苗绣的典型图片如图5所示,MX数据集训练和测试集按照8∶2的比例划分,具体样本数量如表2所示。

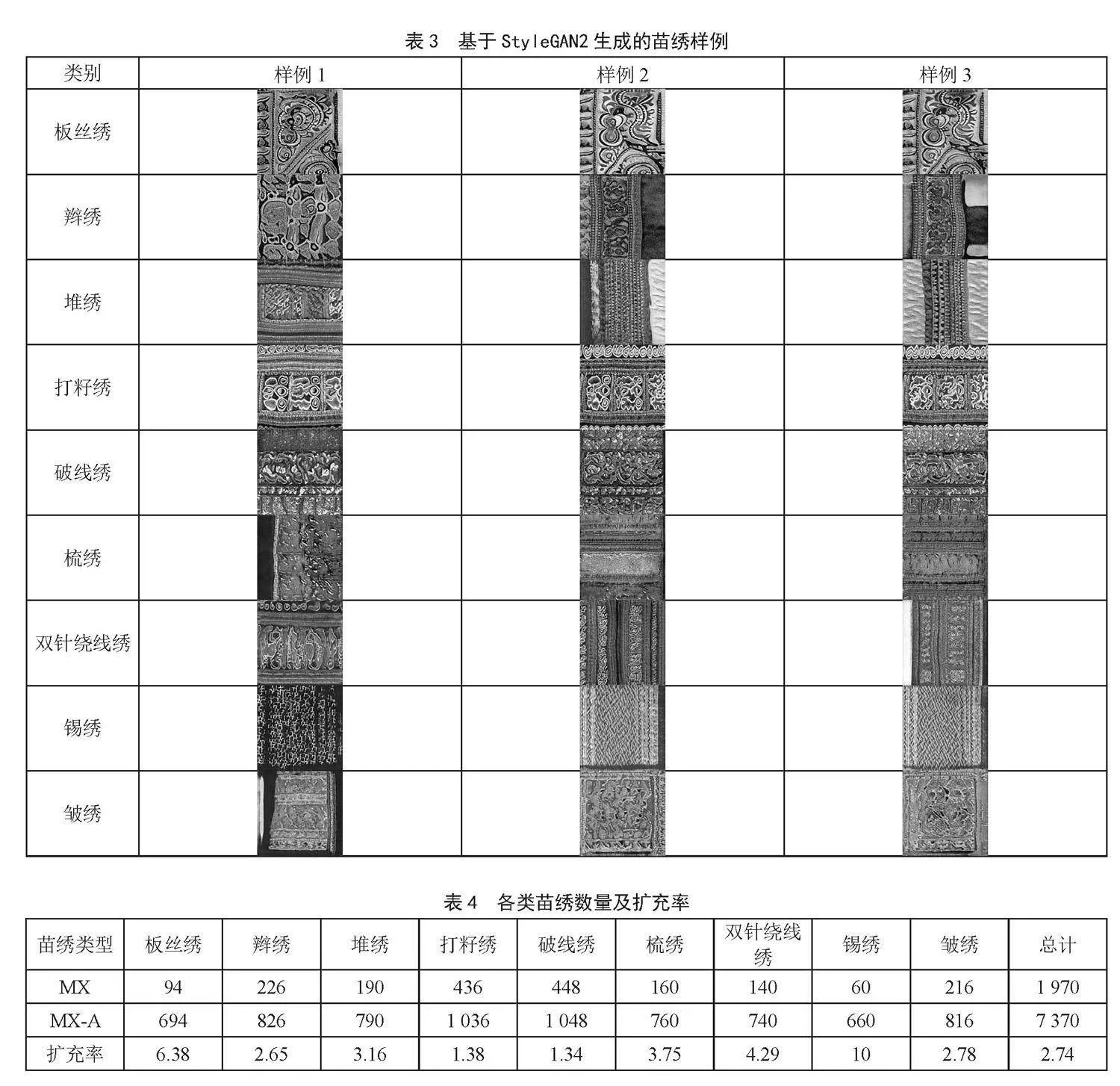

此外,将经过StyleGAN2模型扩充后的数据集命名为MX-A,即在MX训练集中为每类苗绣增加了600张图片。扩充生成的苗绣图片如表3所示,具体类别数量及扩充率如表4所示。

StyleGAN2-ECA-ResNet50模型运行实验环境为Linux操作系统,CUDA版本为11.3,软件编程环境为Python 3.9.7,使用的深度学习框架为PyTorch 1.10.1,使用的显卡为英伟达 GeForce RTX 2080 Ti,显存为11 GB。模型训练epoch设置为30,批量大小设置为32。

3.2 实验评价指标

为了对StyleGAN2-ECA-ResNet50模型性能进行评估,采用准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数(F1 Score)四个指标作为实验的评估标准。计算式如下所示:

(11)

(12)

(13)

(14)

如表5所示,TP(True Positive)表示真正类的正确预测数,TN(True Negative)表示真负类的正确预测数,FP(False Positive)表示负类被错误预测为正类的数目,FN(False Negative)表示正类被错误预测为负类的数目。

4 结果与分析

4.1 消融实验

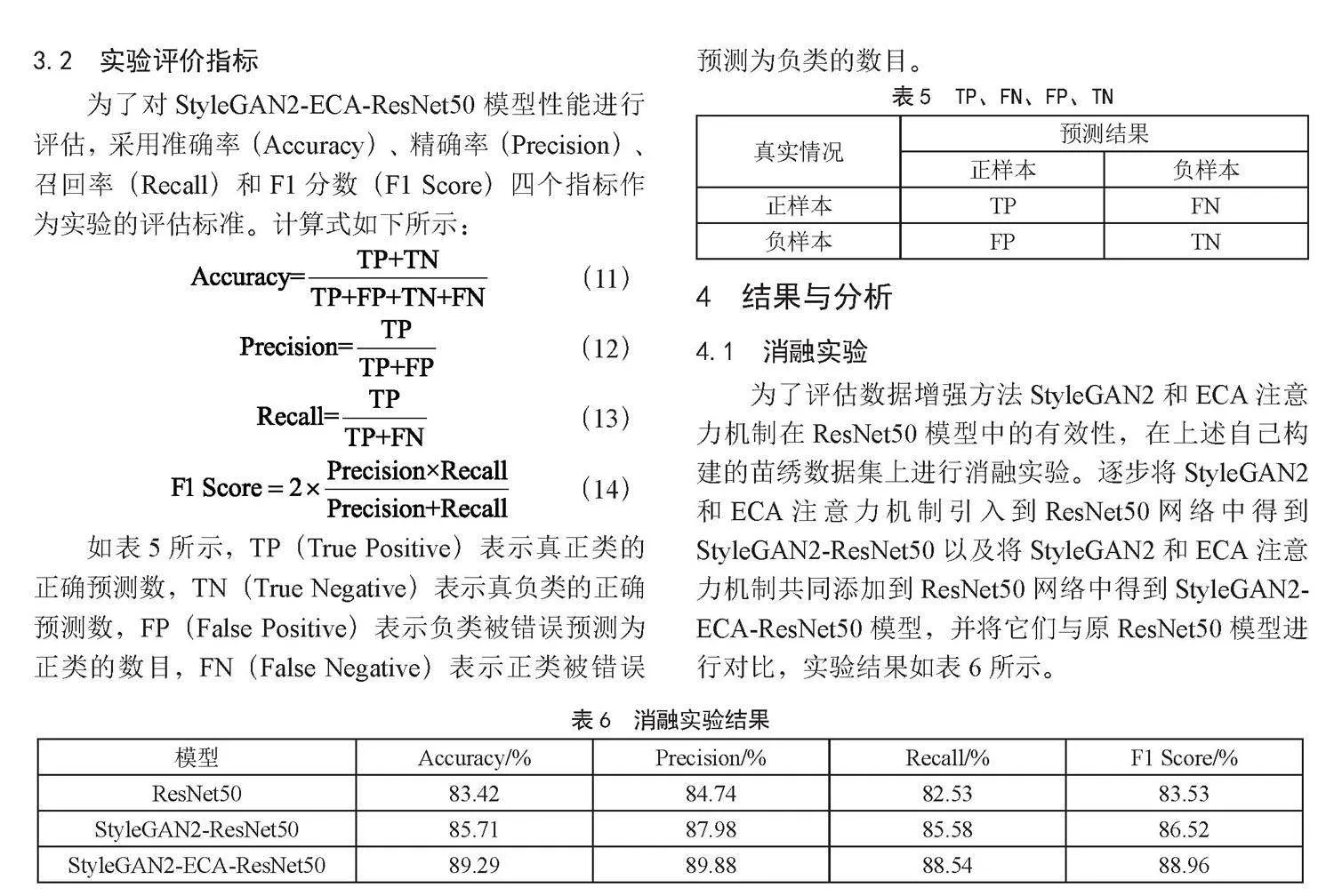

为了评估数据增强方法StyleGAN2和ECA注意力机制在ResNet50模型中的有效性,在上述自己构建的苗绣数据集上进行消融实验。逐步将StyleGAN2和ECA注意力机制引入到ResNet50网络中得到StyleGAN2-ResNet50以及将StyleGAN2和ECA注意力机制共同添加到ResNet50网络中得到StyleGAN2-ECA-ResNet50模型,并将它们与原ResNet50模型进行对比,实验结果如表6所示。

由表5可知,通过迁移学习后重训练的ResNet50模型显示出了基本的性能水平,其准确率为83.42%,精确度为84.74%,召回率为82.53%,F1得分为83.53%。这一结果为后续的技术增强提供了基准,具体如下:

1)引入StyleGAN2后的模型StyleGAN2-ResNet50,其性能得到了显著提升。具体而言,模型的准确率提高到85.71%,精确度提高到87.98%,召回率提高到85.58%,F1得分提高到86.52%。这一显著提升表明,StyleGAN2对模型的特征提取和图像理解能力有极大的增强作用。

2)同时采用StyleGAN2和ECA注意力机制的模型StyleGAN2-ECA-ResNet50展现了最佳性能,准确率高达89.29%,相比于ResNet50模型提升了5.87%,精确度为89.88%,召回率为88.54%,F1得分为88.96%。这表明两种技术的结合存在协同效应,共同推动了模型性能的极大提升。

整体上看,这些消融实验结果清楚地展示了不同技术组合在提高模型性能方面的有效性和潜力。特别是StyleGAN2和ECA的结合,在所有评估指标上都表现出最优性能,证实了多技术集成的策略在复杂模型优化中的重要价值。同时,这也证明了StyleGAN2数据增强方法和ECA注意力机制在ResNet50网络中的有效性。

4.2 对比实验

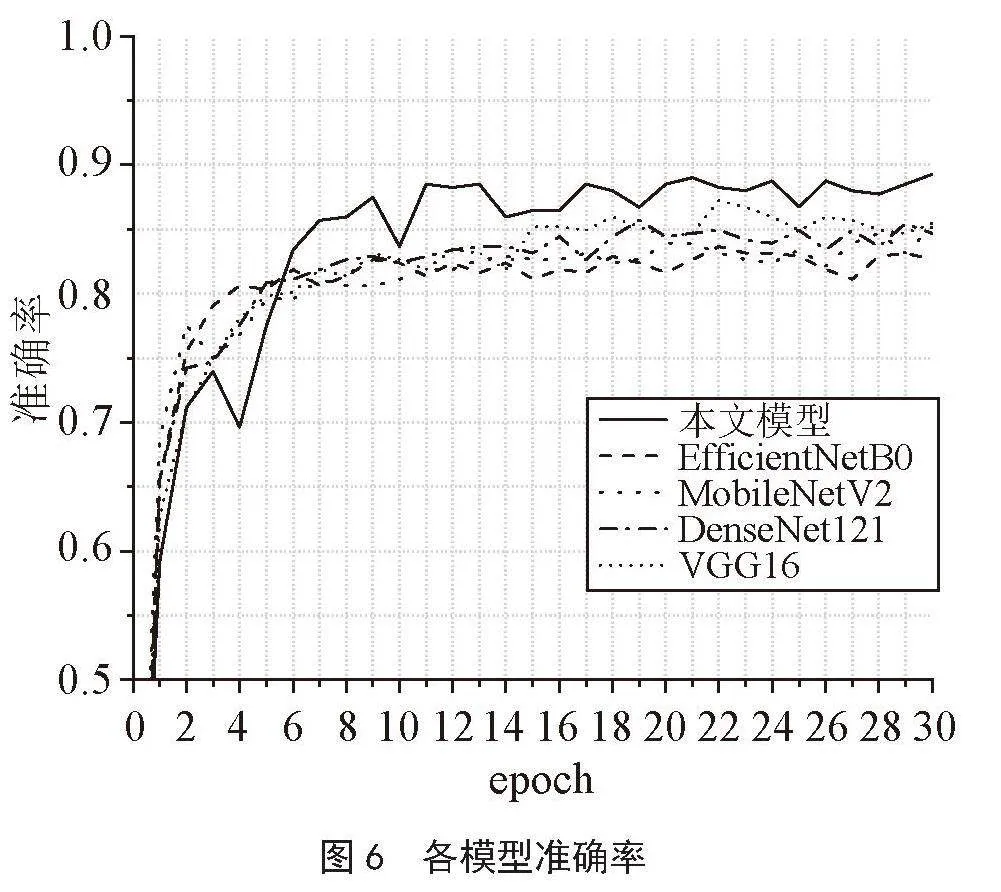

为进一步评估StyleGAN2-ECA-ResNet50模型的性能,在同等实验条件下,将其与当前领域内一些表现卓越的模型进行了对比分析,包括EfficientNetB0、MobileNetV2、DenseNet121和VGG16。这些模型在MX数据集上的分类表现如表7所示。

通过一系列综合性能指标的评估,包括准确率、精确度、召回率和F1分数。本文模型(StyleGAN2-ECA-ResNet50)表现出了卓越的性能,其准确率高达89.29%,精确度为89.88%,召回率为88.54%,F1分数为88.96%,除了精确率略低于模型VGG-16外,其余指标均高于其他对比模型。各模型在苗绣测试集上的准确率变化曲线如图6所示。

总体而言,本文模型(StyleGAN2-ECA-ResNet50)显现出了在精确性和泛化能力上的显著优势。尤其在准确率和召回率上,模型展示了它在正确识别和减少误判方面的强大能力,确保了对苗绣图像细腻特征的高度敏感性和识别准确性。这些成果不仅验证了该模型在图像分类领域的强大应用潜力,也为未来图像处理技术的研究和实际应用提供了宝贵的参考和启示。

5 结 论

本文提出了一种新颖的苗绣图像生成识别模型StyleGAN2-ECA-ResNet50。通过利用StyleGAN2生成技术,显著扩展了苗绣图像数据集,不仅有效解决了苗绣样本量不足的问题,为ResNet50分类模型提供了丰富且多样的训练样本,同时还为苗绣的设计提出了一种AI解决的方式——苗绣图像生成。通过添加ECA注意力机制,使得ResNet50能够有效地处理不同层次的图像信息,降低了分类难度,显著提升了苗绣图像的分类精度,这也进一步推动了苗绣作品的数字化保护。展望未来,计划进一步优化生成模型,以产生更高质量的图像,从而从源头上解决数据质量问题。此外,本文提出的图像生成与分类框架也可应用于更广泛的小样本图像分类任务中,例如侗族服饰分类、瑶族刺绣分类、蒙古族节日图像分类等。

参考文献:

[1] 耿心入.贵州苗绣色彩与野兽主义绘画色彩对比分析 [J].文艺争鸣,2024(7):194-197.

[2] 刘文良,黄洁.数字时代苗绣智慧化传承的困惑与破解路径研究 [J].家具与室内装饰,2023,30(1):68-74.

[3] 代永琪,彭莉,谢乃鹏.数字赋能:基于视觉Transformer的非遗苗绣纹样数字化提取 [J].丝绸,2024,61(7):14-24.

[4] 王建萍,周玉莹,虞倩雯,等.基于智能绣花机的数码仿真绉绣研发和工艺参数研究 [J].丝绸,2024,61(7):47-54.

[5] 陈世婕,王卫星,彭莉.基于多尺度网络的苗绣绣片纹样分割算法研究 [J].计算机技术与发展,2023,33(11):149-155.

[6] 田玉晶,薛凯文,崔齐,等.贵州遵义苗绣纹样的数字化生成研究 [J].东华大学学报:社会科学版,2023,23(2):49-58.

[7] CHEN H X,LI H X,LI Y H,et al. Multi-level Metric Learning for Few-Shot Image Recognition [C]//Artificial Neural Networks and Machine Learning(ICANN 2022).Bristol:Springer International Publishing,2022:243-254.

[8] LI X,SONG K,LIN T,et al. PDAMeta: Meta-Learning Framework with Progressive Data Augmentation for Few-Shot Text Classification [C]//2024 Joint International Conference on Computational Linguistics, Language Resources and Evaluation(LREC-COLING 2024).Torino:ELRA and ICCL,2024:12668-12678.

[9] SONG Y S,WANG T,MONDAL S K,et al. A Comprehensive Survey of Few-Shot Learning: Evolution, Applications, Challenges, and Opportunities [J/OL].arXiv:2205.06743 [cs.LG].(2022-05-13).https://arxiv.org/abs/2205.06743v1.

[10] TAN M X,LE Q V. EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks [C]//International Conference on Machine Learning.Taiyuan:IMLS,2019:6105-6114.

[11] SANDLER M,HOWARD A,ZHU M L,et al. MobileNetV2: Inverted Residuals and Linear Bottlenecks [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:4510-4520.

[12] HUANG G,LIU Z,MAATEN L V D,et al. Densely Connected Convolutional Networks [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu:IEEE,2017:2261-2269.

[13] SIMONYAN K,ZISSERMAN A. Very Deep Convolutional Networks for Large-scale Image Recognition [J/OL].arXiv:1409.1556 [cs.CV].(2014-09-04).https://arxiv.org/abs/1409.1556.

[14] KARRAS T,LAINE S,AITTALA M,et al. Analyzing and Improving the Image Quality of StyleGAN [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle:IEEE,2020:8107-8116.

[15] KARRAS T,LAINE S,AILA T. A Style-based Generator Architecture for Generative Adversarial Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2021,43(12):4217-4228.

[16] WANG Q L,WU B G,ZHU P F,et al. ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Seattle:IEEE,2020:11531-11539.

[17] 孟伟,袁艺琳.迁移学习应用于新型冠状病毒肺炎诊断综述 [J].计算机科学与探索,2023,17(3):561-576.

[18] IMAN M,RASHEED K,ARABNIA H R. A Review of Deep Transfer Learning and Recent Advancements [J/OL].arXiv:2201.09679 [cs.LG].(2022-01-19).https://arxiv.org/abs/2201.09679?context=cs.CV6.

[19] TIAN S I P,REN Z,VENKATARAJ S,et al. Tackling Data Scarcity with Transfer Learning: A Case Study of thickness Characterization from Optical Spectra of Perovskite Thin Films [J/OL].arXiv:2207.02209 [cs.LG].(2022-06-14).https://arxiv.org/abs/2207.02209.

作者简介:吴菁(1988.05—),女,苗族,贵州贵阳人,副教授,硕士生导师,博士,研究方向:检测技术与自动化装置;杨邦勤(1999.10—),女,汉族,贵州黎平人,硕士在读,研究方向:海量数据统计与分析;张银建(1998.09—),男,汉族,贵州织金人,硕士在读,研究方向:海量数据统计与分析;李明珠(1983.03—),女,汉族,海南临高人,副教授,硕士,研究方向:智能检测与智能控制、软测量建模;通信作者:陈妍(1987.09—),女,汉族,贵州遵义人,博士在读,研究方向:苗绣图像识别研究与可视化。

DOI:10.19850/j.cnki.2096-4706.2025.02.005

收稿日期:2024-09-02

基金项目:贵州省科技计划项目(黔科合基础-ZK〔2021〕一般340);贵州省教育厅自然科学研究项目(黔教技〔2023〕061号);贵州省教育厅自然科学研究项目(黔教技〔2023〕012号);贵州省教育厅自然科学研究项目(黔教技〔2022〕047号);贵州民族大学博士科研启动项目(GZMUZK〔2024〕QD11)