学术研究中使用AIGC工具的风险审视与应对策略研究

2024-10-07张艳丽管玉燕宛雪赵晶浩

摘要:[目的/意义]分析学术研究中使用AIGC工具可能存在的风险,对规避风险的策略展开研究,为科研人员合规使用AIGC工具提供参考和借鉴。[方法/过程]梳理国内外学术领域有关AIGC应用的政策规定,归纳分析使用AIGC的主要风险,结合科研人员的学术研究过程,提出规避风险的策略以及在不同阶段使用AIGC的可行性建议。[结果/结论]科研人员使用AIGC工具面对的风险主要集中在输入内容的安全性、输出结果的可靠性、学术伦理风险以及潜在法律风险。科研人员应提高风险意识,理解政策规定,明确不同研究阶段和场景的使用边界,规范使用行为,以确保AIGC工具在学术研究中发挥积极作用。

关键词:AIGC;生成式人工智能;学术研究;风险分析;应对策略

分类号:TP18;G2;B82-057

引用格式:张艳丽, 管玉燕, 宛雪, 等. 学术研究中使用AIGC工具的风险审视与应对策略研究[J/OL]. 知识管理论坛, 2024, 9(4): 341-352 [引用日期]. http://www.kmf.ac.cn/p/397/. (Citation: Zhang Yanli, Guan Yuyan, Wan Xue, et al. The Risk Review and Countermeasures of Using AIGC in Academic Research[J/OL]. Knowledge Management Forum, 2024, 9(4): 341-352 [cite date]. http://www.kmf.ac.cn/p/397/.)

1 研究背景/Research background

2022年末问世的ChatGPT,改变传统内容生成方式,在人工智能领域产生轰动性效应。随之涌现出大量人工智能生成内容(artificial intelligence generated content, AIGC)工具的研发和应用,为科学研究和学术出版领域提供新机遇,也提出新挑战。对于广大科研人员而言,AIGC工具正在成为科学工作和学术研究的助手,如辅助文献调研和综述,启发选题思路,进行数据分析和挖掘,从大量文献中比较发现科学关联和研究方向,可视化呈现研究结果等,为科研人员提供更便利、更高效、更具个性化的支持。然而,风险与发展并存。AIGC在助力科研人员完成科研任务的同时也带来潜在风险和局限,如内容可靠性、版权归属、隐私和数据泄露、法律和伦理问题等。

这些由AIGC技术生成性特征带来的应用风险,也引发研究人员对科研诚信和学术出版的广泛讨论,由此带来的法律、伦理等风险受到国际组织、政府机构的密切关注。国内外众多政府部门、企事业单位,鉴于AIGC工具内容生成对训练语料、提问倾向性的高度依赖,生成结果无法确保准确性等事实,颁发多项政策予以管控。例如:在国内,国家网信办、发改委、教育部、科技部、工信部、公安部和广电总局七部门于2023年7月联合发布《生成式人工智能服务管理暂行办法》[1],该条例是全球范围内首个由国家层面制定的、关于AIGC的专门监管规章,引起联合国教科文组织等机构的广泛关注。中国科学技术信息研究所联合爱思唯尔、施普林格·自然、约翰威立国际出版集团于2023年9月发布《学术出版中AIGC使用边界指南》[2],对AIGC用于学术出版的行为进行规范,以防范AIGC不当使用,引导相关利益主体就AIGC使用达成共识。国际上,2023年5月召开的G7领导人日本峰会着重探讨生成式人工智能监管问题,计划起草“负责任的AI”标准并于2023年底出台对生成式人工智能的监管措施[3]。欧盟的《人工智能法案》(European Union Artificial Intelligence Act)自2021年首次提出,直到2024年3月13日由欧洲议会投票通过,这是全球人工智能领域监管进入新时代的标志性事件[4-5]。

由此,科研人员需要对AIGC建立较为全面的认知,了解应用AIGC工具的风险,确保负责任、安全且合乎伦理地使用AIGC工具,严格对待其生成内容的准确性和有效性,避免因不当使用带来难以预估的后果。

2 学术研究中使用AIGC工具的风险分析/Risk analysis of using AIGC tools in academic research

学术领域中研究者使用AIGC工具,主要是通过向AIGC工具输入指令,AIGC工具根据指令输出相应的成果内容,研究者将输出的结果应用到相关研究材料中,因此,其风险也主要集中在4个方面:输入内容的安全风险、输出内容的可靠性风险、学术伦理和道德风险、潜在的法律风险。

2.1 输入内容的安全风险

使用AIGC工具过程中,互动内容可能成为大型语言模型训练语料库的一部分,很可能带来敏感内容泄露、研究数据篡改、机密信息滥用等安全问题。AIGC开发者通常在其用户使用协议中单方面声明:用户上传的提示词/内容授予AIGC开发者使用。如腾讯混元模型《用户使用协议》第五部分“知识产权”中的第三条明确表示:“您理解并且同意,除非您与我们另有约定,您上传至本服务平台的内容(包括但不限于作为提示词的文本或其他一切用于协助腾讯混元模型产生人工智能生成内容的提示性内容)即代表您不可撤销地授予腾讯公司及其关联方一项不可撤销的、非排他的、无地域限制的、永久的、免费的许可使用,以使我们得以对上传内容进行存储、使用、复制、修订、编辑、发布、展示、翻译、分发上述内容或制作派生作品等商业或非商业使用,及可再许可第三方使用的权利,以及可以自身名义对第三方侵权行为取证及提起诉讼的权利”。在其他AIGC工具的用户使用协议中也有类似描述,这类用户使用协议给用户带来内容泄露风险。

科研人员在使用AIGC工具时输入的提示语可能与自身研究内容密切相关,也可能上传研究过程中的文档获得AIGC辅助分析或纠错润色等,这些提示语和相关文档可能纳入AIGC训练数据,参与生成新的输出内容,被未经授权的第三方获取,导致正在研究的内容、数据、成果等泄露,从而可能为科研人员带来安全风险。

根据韩国媒体《经济学人》报道,三星公司于2023年3月批准半导体业务部门引入ChatGPT,同时向员工发布“注意公司内部信息安全,不要输入私人内容”的警示公告。然而,在此后不到20天的时间内,半导体业务部门就接连发生3起机密信息泄露事件,导致相关半导体设备测量资料和产品良率等机密数据被完整传输保存至ChatGPT学习数据库。泄密事件发生后,三星公司迅速启动事故调查和应急方案,火速出台公司内控新举措。不仅将员工向ChatGPT提问的上传容量限定在1 024字节以内,而且声明如遇紧急情形会考虑切断公司内网与ChatGPT的连接。2023年5月,三星公司进一步收紧管理政策,要求员工不得在工作场所使用类似ChatGPT的生成式人工智能应用[6]。

由此可见,用户在使用AIGC工具过程中无法保障“知情同意”权益,在互动提问、信息收集、统计分析、存储备份等环节均存在研究内容、隐私信息、敏感数据、商业秘密甚至是国家机密泄露的安全风险和隐患。

2.2 输出内容的可靠性风险

AIGC工具通常需要处理大量的数据和信息,在处理过程中采用AIGC进行推理和决策。然而,这些过程涉及许多不确定性因素,如训练数据有偏差缺少多样性、模型参数的不确定性、数据的时效性、算法的稳定性和鲁棒性、提示词的倾向性等。这些因素均可导致AIGC工具生成内容的不准确和不可靠。另外,训练数据和算法模型也会造成在训练过程中可能引入偏见和歧视,导致不公平的输出结果。AIGC模型继承并延续其训练数据中存在的偏差,鉴于模型的不透明性质,这些偏差很难检测和排除。

2023年2月,谷歌公司AI聊天机器人工具Bard的发布演示中,有用户提问“该如何告诉一个9岁孩子关于詹姆斯·韦伯空间望远镜的发现”,Bard回答:詹姆斯·韦布空间望远镜拍摄太阳系以外行星的第一批照片。随后,哈佛—史密森天体物理中心的专家格兰特·特朗布莱指出,这并非事实,2004年欧洲南方天文台的甚大望远镜(Very Large Telescope, VLT)拍摄第一张系外行星照片。Bard回答出错被发现后,随之谷歌母公司Alphabet股价下跌超7%,市值蒸发约1 000亿美元[7]。由此可见,AIGC工具输出内容的不可靠将带来巨大风险。

本研究对多个AIGC工具进行实验。对同一个模型多次提问,提示语略有差异时给出的答案也不完全相同,若不进行验证,相关结果容易混淆。例如,笔者对同一模型分别提问:“2020年中国人口普查总人数是多少?”与“2020年中国人口普查全国总人口是多少?”获得的答案,分别是“2022年中国总人口数为141 175万人,即14.117 5亿人”与“2020年中国进行的第七次全国人口普查结果显示,全国总人口为1 411 780 000人(14.117 8亿人)”,结果略有差异。

2.3 学术伦理和道德风险

科学研究是人类知识生产的重要途径,在实践中形成一套约定俗成的道德规范和行为准则,包括要求严谨求实的作风和诚实守信的行为。AIGC工具可能被用来生成伪造的实验数据或输出不真实的结果等,容易违背道德规范和行为准则,造成学术不端行为。

科学研究过程包括:科研选题、文献阅读和综述、实践调研论证、实验观察验证、分析数据得出结论、论文撰写等,每个过程都需要十分严谨。近些年来,人工智能技术突飞猛进,在为社会各个领域提供便捷的同时,也带来“学术造假”的“低成本”现象。缺失道德规范和行为准则的科研人员将研究过程演变为:向AIGC工具提问,直接生成论文,再由AIGC工具修改,完成论文。在这个过程中,一旦科研人员缺乏对整体内容的基础研究和理解,缺少对AIGC工具生成内容的严格把关和确认,大量不可靠的学术论文就会出现,这不仅存在学术伦理与道德规范方面的风险,对于整个学术领域与社会发展来说均是一场灾难。

2024年2月,科学网转发文章《发表3天被撤稿!中国作者用AI生成论文插图,每幅都荒谬》。被撤论文的作者在发表于开放获取期刊《细胞与发育生物学前沿》(Fron.Cell Dev. Biol)论文中不负责任地采用由AI绘图工具Midjourney生成的三组图片,这些图片夸张、荒谬、违背事实真相,在解剖学和科学上都是不正确的,插图中还出现生造的、不具备任何意义的字母排列标签。该论文在线发表3天即被撤稿,编辑部表示“该文章不符合本刊的编辑和科学严谨性标准,因此予以撤稿”[8-9]。这是一个违背科学研究应具备严谨求实作风和诚实守信原则、无视研究成果应具有真实性和可靠性基础的典型例子。该事件引发一轮对“人工智能技术以及学术论文科学性”的讨论,也令人担忧未来AIGC工具生成的、更多更逼真的学术图片将会以假乱真,这将对科研论文的可信度和科学性产生负面影响。

2.4 潜在法律风险

科研人员使用AIGC工具输出内容,首当其冲面对的是版权风险,同时还存在潜在的其他法律风险。

(1)输出内容的版权风险分为两个方面:一是AIGC模型的形成和完善依赖于大量的数据训练,这些数据可能包含受版权法保护的内容,存在训练数据的版权侵权风险。当下,多数AI公司对训练数据集的来源秘而不宣,缺乏透明度。2022年3月非营利组织LAION(全名Large-scale Artificial Intelligence Open Network)发布的LAION-5B包含58.5亿个图像文本,彭博社曾报道其来源包括从亚马逊网、Shopify等公司获取的视觉数据,还有YouTube缩略图、各类新闻网站上的抓取内容等。2023年1月,英美发生两起AIGC版权侵权案,均与被告使用LAION数据集中的未授权数据有关。许多知名AI公司未经授权,就将这些数据用于训练各种大模型,如谷歌Imagen、Stable Diffusion等[10]。二是使用AIGC工具生成内容的版权归属问题。现阶段,AIGC的版权归属各个国家均没有明确规定,其在理论和实践上存在五种可能性:归属AI(非人)、归属AI开发者、归属AI使用者、归属AI开发者和使用者共享、不授予版权而采用其他方式保护。2023年1月,Nature期刊公开声明,任何大型语言模型工具都不会被接受作为研究论文的署名作者。这是因为任何作者的归属权都伴随着对工作的责任,而AI工具无法承担这种责任[11]。

AIGC的版权风险给学术研究领域带来巨大冲击,也推动AIGC开发者做出响应。2023年11月,Open AI在开发者大会上推出“Copyright Shield”(版权盾)服务,为AI大模型的版权问题提供新思路。这项服务实质上是一种赔偿条款,当企业级用户使用ChatGPT面临版权侵权法律指控时,Open AI会为用户提供素材来源、内容生成过程等证据,同时承担判定侵权后的赔偿金(这一承诺主要针对ChatGPT机构用户和开发者平台的使用者,对普通用户不提供赔偿)。这个功能旨在缓解用户对于生成式人工智能存在潜在版权风险的担忧。类似的版权包赔模式并非Open AI独有,其他公司如谷歌、微软、亚马逊、Getty Images、Shutterstock、Adobe等也向企业级用户承诺支付大模型使用所涉版权纠纷的诉讼费用。这类侵权包赔模式在前期训练数据合规的情况下具备可行性,也体现AIGC开发者对于AI技术应用中版权风险的广泛关切,以及对用户合法权益的重视。

(2)使用输出内容潜在的其他法律风险包括隐私泄露、商业秘密和国家安全风险。

AIGC工具未经同意使用个人数据或未能妥善保护这些数据,就可能泄露用户隐私信息,违反数据保护法规,侵犯公民个人信息自决权。

2023年3月,ChatGPT发生用户的个人数据泄露事件,开源组件Redis中的竞争条件漏洞(race condition vulnerability)导致用户的聊天历史中显示其他用户的信息内容,包括用户的姓名、电子邮件地址、付款地址、信用卡号后4位,以及信用卡有效期等个人信息均被泄露。这个漏洞使得大约1.2%的ChatGPT Plus订阅用户的个人敏感数据被直接暴露。ChatGPT发布声明,向用户和社区致歉,并表示将紧急维护ChatGPT。

AIGC工具生成的虚假内容可能造成国家安全风险。2023年以来,AIGC驱动图像生成器制作的虚假图像和视频在社交媒体上广泛流传,如美国前总统特朗普和俄罗斯总统普京被捕的照片,以及乌克兰总统泽连斯基宣布投降的视频,这些虚假新闻传播混淆公众对事实的判断,也可能引发对全球政治形势的误判并给国家安全带来威胁。

若AIGC输出内容中存在个人隐私数据、商业秘密和国家安全的信息,科研人员一旦采用,相关权利主体进行追责,会给科研人员带来相应的法律风险。

3 学术出版领域AIGC使用政策及规定分析/Analysis of AIGC usage policies and regulations in the academic publishing field

AIGC被广泛应用以来,国内外学术出版领域相继发布政策声明。

国际上,Nature[11]、Science[12]、The Lancet[13]等多家顶级权威期刊在2023年陆续更新投稿指南或发布政策,规定AIGC使用细则。国外大多数学术期刊没有明文规定禁止使用AIGC,但均声明须基于学术诚信和研究透明的原则,在有限制条件的情况下使用。Elsevier[14]、Taylor & Francis[15]等多家知名出版社及著名预印本平台arXiv[16]等学术组织也陆续出台AIGC使用条件、限制、相关倡议等官方声明。

在国内,我国政府不仅及时出台专门监管规章《生成式人工智能服务管理暂行办法》,而且初步形成一套监管规范体系,已发布多项法律、行政法规等规范性文件,涉及科技发展、网络安全、个人信息保护、互联网信息等方面,构成人工智能领域多层级、多角度的规范治理体系[17]。学术期刊《暨南学报(哲学社会科学版)》《文献与数据学报》《中国科技期刊研究》《智库理论与实践》《图书情报工作》《中华医学会杂志》等也陆续发布有关AI的政策声明或有关规定。

趋势调研表明,越来越多学术期刊、出版机构以及学术联盟相继发布政策声明或使用规定,界定AIGC在学术领域的使用边界,规范学术共同体的使用行为,以确保学术研究/成果的可信度与可靠性。不同机构、组织针对AIGC应用所制定的政策或规定不尽相同,但在主要问题和原则上基本达成共识。主要包括如下几点:

(1)透明度和问责制。所有学术出版领域(包括科研人员、作者、同行评议人和出版方)都应该了解并明确披露AIGC的使用情况,明确AIGC的应用责任,包括底层数据集、数据来源和数据处理方法的透明度,以及知识产权和版权的归属和责任。

(2)遵守法律和伦理标准。AIGC的应用要遵守相应的法律法规和伦理标准,包括数据隐私和版权问题。

(3)确保研究质量和诚信。确保AIGC的应用建立在信任基础上,通过透明标注和声明等手段表明对AIGC生成内容的使用,保证学术研究的质量和诚信不受AIGC技术应用的影响。

(4)公平使用。确保AIGC的应用秉持公平原则,避免偏见,评估潜在的偏差来源,并建立反馈机制监测和审查可能的不公平现象。

(5)AIGC没有署名权。论文作者必须是能够对论文真实性、完整性、科学性等负责的自然人,AIGC不能作为论文作者。

(6)使用标注声明。使用AIGC工具的作者须在方法、致谢或者其他适当部分说明使用情况,包括:AIGC开发者、AIGC工具名称和版本、使用时间、使用过程、完整提示词等。

(7)论文主要内容不能源于AIGC工具。作者不能将AIGC工具生成的内容作为一手来源资料进行引用。如论文主要内容是利用AIGC工具生成的,一旦被发现,将以学术不端行为处理。

(8)视觉内容不能源于AIGC工具。不接受作者在文章中完全或部分使用AIGC工具生成图像、图形、视频和其他多媒体内容。

(9)参考文献验证。经AIGC工具提供的参考文献须经人工验证其真实性和时效性,参考文献中不应包含将AIGC列为作者的论文。

不同机构、组织针对AIGC使用政策和规定的细则有所不同,差别主要体现在限制使用范围和使用程度上。这些原则和共识体现出学术出版界对于AIGC技术应用的谨慎态度和对学术诚信的重视,也体现出学术出版界希望基于规范和政策的制定,从而进一步促进AIGC技术的健康发展和负责任地应用。

4 学术研究中AIGC工具使用风险规避策略/Risk avoidance strategies for AIGC tools usage in academic research

基于对学术领域使用AIGC工具的风险分析和对国内外学术出版领域发布的AIGC使用条件、限制与相关倡议等官方声明的调研,笔者提出在学术研究中使用AIGC工具的应用策略与注意事项,以帮助科研人员在研究过程中结合自身情况,规范使用AIGC工具,从行为层面规避AIGC带来的风险。

4.1 提高风险防范意识

4.1.1 输入内容的安全风险防范

科研人员在选择使用AIGC工具时需仔细研读其用户协议与隐私政策,选择可接受可信任的模型。若所研究内容涉密,则应禁止使用AIGC工具开展相关工作;若所研究内容还在成果保护期,则避免上传到AIGC工具中,避免使用个人隐私信息、涉密信息进行提问。

对可信任AIGC工具的评估包括:①经过各层级管理部门的登记备案和风险评估,一旦出现问题,便于溯源追责;②确认AIGC模型训练数据具有可靠合法的来源并获得正式授权,避免侵权纠纷;③确认AIGC工具对各类数据的采集、保管、使用及删除均有精细化的合规设置;④确认AIGC服务提供者掌握隐私保护计算技术,采取防止用户信息泄露的技术措施;⑤确认AIGC工具对生成内容具有审查过滤机制,具有从产品侧对敏感内容屏蔽和阻断虚假信息、偏见歧视、违法和违背公序等信息的技术手段,确保生成内容符合相关法律法规的要求。

4.1.2 输出内容的可靠性验证

学术研究是一个严肃的过程,AIGC工具使用者需要对研究内容的真实性、可靠性负直接责任。AIGC模型无法根据现实世界观察、科学规律和方法、人类社会的价值观进行实时调整,因而AIGC工具所生成的内容在逻辑、科学、时效性方面都存在不确定性,容易生成一些不符合科学规律、现实生活中不存在的、被称之为“幻觉”的内容,因此难以直接实现真正可靠的学术创新。使用者需要对AIGC工具生成的内容采取批判态度,不能盲目信任和直接采用,使用前需要逐字逐句进行验证和把关,需要审核这些内容是否包括伪造内容、不准确信息、错误的数据、无依据的结论或偏颇的观点等。

4.1.3 恪守学术道德,严守诚信底线

科研人员须在恪守学术伦理和道德的情况下,诚实可信、负责任地使用AIGC工具,避免在研究过程中依赖和沉迷于AIGC生成的内容。随着AIGC的广泛应用,其生成内容缺乏透明度和可解释性的问题越来越多,经常生成貌似正确而实质错误的内容,这些内容很可能对人类的认知造成干扰,如引导人们去质疑真实的信息,甚至背弃学术诚信的原则。科研人员需要对此有高度警惕和预先防范。

科技部监督司在2023年12月发布的《负责任研究行为规范指引》中提出科学研究实践中应普遍遵循的科学道德准则和学术研究规范,也对生成式人工智能的使用作出明确要求,如“不得使用生成式人工智能直接生成申报材料”“应遵循相关法律法规及学术规范,依规合理使用生成式人工智能处理文字、数据或学术图像,防范伪造、篡改数据等风险”“不得直接使用未经核实的由生成式人工智能生成的参考文献”“生成式人工智能不得列为成果共同完成人。应在研究方法或附录等相关位置披露使用生成式人工智能的主要方式和细节”“在评议活动中使用生成式人工智能的,应事先征得评议活动组织者同意,操作中应防止泄漏评议内容,如发生信息泄漏应及时采取必要补救措施”[18]。同日,国家自然科学基金委也发布《科研诚信规范手册》,对生成式人工智能在研究过程中的使用做出明确要求,相关条款与《负责任研究行为规范指引》基本一致[19]。

因此,学术领域工作者,在使用AIGC工具时须保持初心,不能触碰学术伦理与道德规范底线。

4.1.4 公开透明标注,规避法律风险

AIGC的出现正在迅速改变科学、艺术和文学作品的创作、传播和消费方式,为了规避相关法律风险,使用者必须负责地使用AIGC工具生成内容,公开透明标注,并清楚使用风险,承担所有责任。

一方面,现行的版权政策规定,未经版权所有者的许可而以任何方式复制、分发或使用受版权保护的作品均构成对版权的侵权,并可能导致法律后果。在目前AIGC工具生成内容版权归属不明确的情况下,科研人员直接采用AIGC工具所生成内容与当前版权政策存在冲突,有一定的版权风险。所以,不建议使用者直接将AIGC生成内容作为自己的最终成果,而是将AIGC作为实现目标的工具,要验证AIGC生成的内容,并尽可能地增加自己的创新思路和实质投入。

另一方面,使用AIGC工具时,使用者不仅要严格把关和审核其生成的内容,以确保信息的真实性和准确性,而且要对内容进行详尽的溯源和明确标注,以确保内容的可靠性、合规性和合法性,规避潜在的法律风险。

4.2 遵循AIGC工具使用原则

在AIGC技术快速发展且缺乏监管的情况下,坚持原则既是对使用者的要求,也是对使用者的保护。根据业界发布的各项政策法规与大众共识,笔者将使用AIGC工具应遵循原则总结如下:

(1)诚信原则。使用者应保持良好的诚信意识,恪守学术道德,坚守学术诚信,自觉遵守学术研究与出版规范。

(2)透明原则。使用者在学术成果形成和撰写过程中无论哪个环节、何种程度使用AIGC,均须清晰地进行声明和标注,以便管理机构进行查证和评估。学术出版机构应履行或制定相关的出版规范,引导使用者正确、规范地使用AIGC,从而保障学术出版物的质量和公信力。

(3)适度原则。使用者应根据实际需求和目的,合理、适度地应用AIGC工具,避免过度依赖或不恰当使用。

(4)保密原则。使用者应有学术成果保密意识,在成果形成和撰写过程中使用AIGC工具导致自有涉密成果泄露,责任应由使用者承担。

4.3 学术研究过程中使用AIGC工具的注意事项

根据对AIGC工具的特点、使用风险与政策的分析,笔者结合科研人员学术研究过程的特点,对于学术研究中不同阶段能否使用该工具以及使用时的注意事项,给出明确的参考意见,以辅助科研人员进行风险判断与规避。

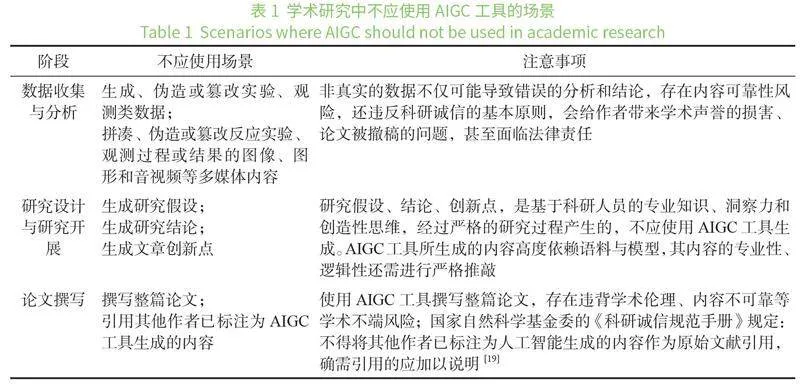

4.3.1 不应使用AIGC工具的场景

Science期刊主编H. H. Thorp在该刊2023年1月发表的一篇社论中指出,ChatGPT采用“从人类反馈中强化学习”技术来训练语言模型,使其具有很强的对话性。尽管如此,正如工具开发者所述,“ChatGPT有时会写出看似合理但不正确或荒谬的答案”。比如,引用一项不存在的科学研究导致最后结论发生偏差,这对于追求准确性的科学研究来说是致命性的[12]。国内《中华医学会杂志》规定,生成式人工智能(Generative Artificial Intelligence,GenAI)不能用于整篇论文或论文重要部分的撰写(如研究方法、结果和对结果的解释分析等)。所有属于科学贡献或智力劳动范畴的内容均应由作者完成,如论文主要内容使用GenAI完成,编辑部将按照学术不端行为进行处理[20]。因此,科研人员需要树立规范使用AIGC工具的意识,规避使用不当带来的学术诚信、涉嫌伪造、篡改数据等风险。学术研究中不应使用AIGC工具的场景如表1所示:

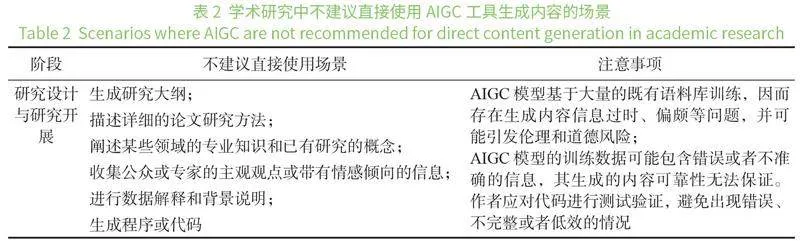

4.3.2 不建议直接使用AIGC工具生成内容的场景

随着AI技术的快速发展,AIGC工具缺乏透明度和可解释性带来的问题日益凸显,其黑匣子的特征不仅会导致产生意想不到的或不想要的结果,也会编造一些现实生活中不存在的东西。生成式人工智能开发者承认这一点,在ChatGPT公共接口的底部声明:“ChatGPT可能会产生关于人、地点或事实的不准确信息”[21]。科研人员尤其需要认识到,AIGC工具并不理解它所生成的内容,可能会经常生成不准确的陈述,直接采用AIGC工具生成的研究大纲、领域知识、专家观点等均须承担相关风险。因此,科研人员需要对AIGC工具所生成的内容采取谨慎参考和审核批判的态度。学术研究中不建议直接使用AIGC工具生成内容的场景如表2所示:

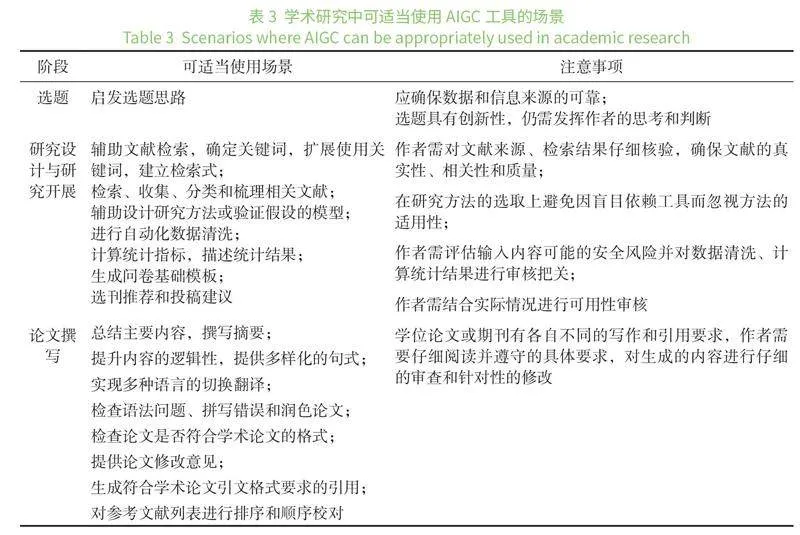

4.3.3 可适当使用AIGC工具的场景

科技部监督司在2023年12月发布的《负责任研究行为规范指引》中指出“应严格遵守相关安全保密、经费使用、资源和数据共享、知识产权归属等规定。依规合理使用生成式人工智能参与研究实施”[18]。2023年11月,Science期刊更新编辑政策,声明“只要在研究方法部分对AI辅助技术(如大型语言模型、聊天机器人和图像生成工具)的使用进行合适的披露,在研究中使用这些工具是可以接受的”[12]。由此,科研人员在学术研究和成果发表的各个阶段,包括论文选题、研究设计与开展以及论文撰写过程中,可适当使用AIGC工具。学术研究中可适当使用AIGC工具的场景如表3所示:

4.4 使用AIGC的引用标注与声明

4.4.1 使用AIGC的引用标注

在国际上,APA格式和MLA格式是两种颇具影响的用于学术论文写作的引用格式。

APA格式由美国心理学会(American Psychological Association, APA)制定。APA认为其他读者无法检索ChatGPT“聊天”的结果,而且AIGC的主要贡献来自于算法,所以AIGC工具的制作者应当被标注为作者,引用者不需要在参考文献表中列出AIGC的具体内容,但可以将交互记录作为附录[22]。APA给出AIGC引用格式的示例如下:

OpenAI.(2023).ChatGPT(Mar 14 version)[Large language model]. https://chat.openai.com/chat

MLA格式由美国现代语言协会(Modern Language Association, MLA)制定。MLA格式指南建议作者在参考文献中引用ChatGPT内容时,应包括完整检索提示句,以及“ChatGPT”、版本号、“OpenAI”、使用ChatGPT的日期和网页链接URL[23]。MLA给出AIGC引用格式的示例如下:

“In 200 words, describe the symbolism of the green light in The Great Gatsby” follow-up prompt to list sources. ChatGPT, 13 Feb. version, OpenAI, 9 Mar. 2023, chat.openai.com/chat.

2023年12月,科技部监督司发布的《负责任研究行为规范指引》中指出,“使用生成式人工智能生成的内容,特别是涉及事实和观点等关键内容的,应明确标注并说明其生成过程,确保真实准确和尊重他人知识产权”[18]。

由于国内对AIGC生成内容尚未明确其引用格式,笔者参照《信息与文献 参考文献著录规则(GB/T 7714-2015)》[24]提供以下两种引用格式的参考建议:

(1)参考文献中引用。将AIGC工具的开发者作为主要责任者,AIGC工具作为主题名,简要描述AIGC交互内容作为其他题目信息,文献类型标识为[CP]:计算机程序(computer program),文献载体标识为[OL]:联机网络(online),更新或修改日期为AIGC工具的版本更新时间,引用日期注明内容生成时间,并注明访问路径。推荐如下参考文献格式:

[序号]主要责任者. 题名: 其他题目信息[文献类型标识/文献载体标识].出版年(更新或修改日期)[引用日期].获取或访问路径.

示例如下:

[1]同方知网.知网AI智能写作:请阐述放射源事故急性外照射的计算方法并详细解释[CP/OL].(2023-05-16)[2023-11-17].https://aidoc.cnki.net/.

(2)参考文献+附录引用。如果使用AIGC工具的交互内容或提示语过长(或者有多项交互内容或提示语),无法在参考文献中详细展示,可以将交互记录(包括提示语和结果等)移至文后的附录中。参考文献列表中的引用可以不再标注与AIGC工具的交互内容或提示语。示例如下:

[1]百度.文心一言[CP/OL].(2024-01-19)[2024-01-24]. https://yiyan.baidu.com/.

[2]北京智谱华章科技有限公司.智谱清言[CP/OL].[2024-01-25]. https://chatglm.cn/main/detail.

详细的AIGC交互内容或提示语展示在附录中,示例如下:

[1]近十年中国南水北调规模的曲线图.(百度.文心一言[CP/OL].[2024-01-24])

[2]近十年中国南水北调工程的投资概况.(百度.文心一言[CP/OL].[2024-01-24])

[3]中国、美国、印度、欧盟近十年的人口规模数据.(北京智谱华章科技有限公司.智谱清言[CP/OL].[2024-01-25])

[4]中国、美国、印度、欧盟近十年的粮食生产规模概况.(北京智谱华章科技有限公司.智谱清言[CP/OL].[2024-01-25])

4.4.2 使用AIGC工具的声明

基于学术诚信原则,在研究过程的任何环节使用AIGC工具,均须在方法部分、附录部分或者其他适当部分公开、透明、详细地做出使用声明。使用声明内容包括:使用AIGC工具解决研究中什么问题;使用AIGC工具产生的想法或结论;由AIGC工具生成内容所占全文比例;作者对AIGC工具生成的内容承担全部责任;等等。示例如下:

“在本研究中,作者在研究设计章节采用ChatGPT作为辅助工具,进行基于学术文献特征的数据清洗、文本分类和信息抽取的相关工作;得出学术文献可以通过ChatGPT实现自动分类,为大规模地按学科知识揭示文献提供更好的支持结论;ChatGPT生成内容约300字,在全文内容中的占比约为3%;本人对使用ChatGPT生成的内容承担全部责任。 ”

5 结语/Conclusions

任何一项新技术的出现,对于社会的发展均是一把双刃剑。AIGC技术的应用可推动学术研究的创新与发展,促进学术生产的质量与效率大幅提升。同时,鉴于这项技术的原理与局限性,也带来一系列的应用风险。面对技术的进步,科研人员需要在了解AIGC风险的基础上积极探索规范使用之道。笔者通过分析学术研究中使用AIGC工具的风险,对相关政策声明和规定进行梳理,提出使用AIGC工具的风险规避策略。一方面,这些应对策略可助力科研人员更好地理解AIGC政策声明和相关规定,自觉规范使用行为,规避使用风险,促进AIGC工具在学术研究中的合法合规的使用;另一方面,也为立法、教育、技术和产业协同等多层面寻求AIGC应用落地的解决方案提供参考依据。

参考文献/References:

国家网信办, 国家发展改革委, 教育部, 等. 生成式人工智能服务管理暂行办法[EB/OL]. [2023-12-20]. https://www.gov.cn/zhengce/zhengceku/202307/content_6891752.html. (Cyberspace Administration of China, National Development and Reform Commission, Ministry of Education, et al. Interim Measures for the Management of Generative Artificial Intelligence Services[EB/OL]. [2023-12-20]. https://www.gov.cn/zhengce/zhengceku/202307/content_6891752.html.)

中国科学技术信息研究所, 爱思唯尔, 施普林格·自然, 等. 学术出版中AIGC使用边界指南[EB/OL]. [2023-12-20]. https://www.istic.ac.cn/html/1/284/338/1701698014446298352.html. (Institute of Scientific and Technical Information of China, ELSEVIER, SPRINGER NATURE, et al. Guideline on the Boundaries of AIGC Usage in Academic Publishing[EB/OL]. [2023-12-20]. https://www.istic.ac.cn/html/1/284/338/1701698014446298352.html.)

和军, 杨慧. ChatGPT类生成式人工智能监管的国际比较与借鉴[J]. 湖南科技大学学报(社会科学版), 2023, 26(6): 119-128. (HE J, YANG H. International comparison and reference on ChatGPT-like Generative Artificial Intelligence Regulation[J]. Journal of Hunan University of Science and Technology (social science edition), 2023, 26(6): 119-128.)

European Parliament. Artificial Intelligence Act[EB/OL]. [2023-12-20]. https://www.europarl.europa.eu/doceo/document/TA-9-2023-0236_EN.pdf.

闫宏秀, 宋胜男. 双重脆弱性与适度信任:从ChatGPT到Sora[J/OL]. 新疆师范大学学报(哲学社会科学版)[2024-04-21]. https://doi.org/10.14100/j.cnki.65-1039/g4.20240408.001. (YAN H X, SONG S N. Dual vulnerability and moderate trust: from ChatGPT to Sora [J/OL]. Journal of Xinjiang Normal University (philosophy and social sciences edition) [2024-04-21]. https://doi.org/10.14100/j.cnki.65-1039/g4.20240408.001.)

李艳. 三星ChatGPT泄密事件及启示 [J]. 保密工作, 2023(9): 65-68. (LI Y. Samsung due to ChatGPT leakage incident and its inspiration [J]. Confidentiality, 2023(9): 65-68.)

ZHAO R, LI X, CHIA Y K, et al. Can ChatGPT-like generative models guarantee factual accuracy? on the mistakes of new generation search engines[EB/OL]. [2024-02-26]. https://arxiv.org/abs/2304.11076.

孙滔.发表3天被撤稿!中国作者用AI生成论文插图, 每幅都荒谬[EB/OL]. [2024-02-27]. https://news.sciencenet.cn/htmlnews/2024/2/517714.shtm. (SUN T. Published for 3 days and was withdrawn! Chinese authors use AI to generate paper iEKYs2BWeVCsUmZo2pn1ydg==llustrations, and each one is absurd[EB/OL]. [2024-02-27]. https://news.sciencenet.cn/htmlnews/2024/2/517714.shtm.)

ELISABETH B. The rat with the big balls and the enormous penis – how Frontiers published a paper with botched AI-generated images[EB/OL]. [2024-02-27]. https://scienceintegritydigest.com/2024/02/15/the-rat-with-the-big-balls-and-enormous-penis-how-frontiers-published-a-paper-with-botched-ai-generated-images/.

种晓明. AIGC赋能出版业背景下版权监管新路径研究[J]. 科技与出版, 2023(8): 96-104. (ZHONG X M. A study on the new path of copyright supervision under the background of AIGC empowering the publishing industry[J]. Science-technology & publication, 2023(8): 96-104.)

Nature. Why Nature will not allow the use of generative AI in images and video[EB/OL]. [2023-12-20]. https://www.nature.com/articles/d41586-023-01546-4.

THORP H H. ChatGPT is fun, but not an author[J]. Science, 2023, 379(6630): 313.

The lancet. Information for authors[EB/OL]. [2023-12-20]. https://www.thelancet.com/pb/assets/raw/Lancet/authors/tl-info-for-authors.pdf.

Elservier. The use of generative AI and AI-assisted technologies in writing for Elsevier[EB/OL]. [2023-12-25]. https://www.elsevier.com/about/policies-and-standards/the-use-of-generative-ai-and-ai-assisted-technologies-in-writing-for-elsevier.

Taylor & Francis Group. Taylor & Francis editorial policies on authorship[EB/OL]. [2023-12-25]. https://authorservices.taylorandfrancis.com/editorial-policies/defining-authorship-research-paper/.

ame5. arXiv announces new policy on ChatGPT and similar tools[EB/OL]. [2023-12-25]. https://blog.arxiv.org/2023/01/31/arxiv-announces-new-policy-on-chatgpt-and-similar-tools/.

王威.《布莱奇利宣言》:人工智能国际合作监管的新起点[J]. 服务外包, 2023(12): 46-52. (WANG W. Bletchley Declaration: a new starting point for international cooperation and regulation of artificial intelligence[J]. China outsourcing, 2023(12): 46-52.)

科技部监督司.负责任研究行为规范指引(2023)[EB/OL]. [2023-12-22]. https://www.most.gov.cn/kjbgz/202312/t20231221_189240.html. (Supervision Department of the Ministry of Science and Technology. Guidelines for responsible research code of conduct (2023)[EB/OL]. [2023-12-22]. https://www.most.gov.cn/kjbgz/202312/t20231221_189240.html.)

国家自然科学基金委员会.科研诚信规范手册[EB/OL]. [2023-12-22]. https://www.nsfc.gov.cn/publish/portal0/tab442/info91294.html. (National Natural Science Fundation of China. Handbook of scientific research integrity standards[EB/OL]. [2023-12-22]. https://www.nsfc.gov.cn/publish/portal0/tab442/info91294.html.)

胡彬.人工智能可否被用来写医学论文[N]. 健康报, 2024-01-17(5). (HU B. Can AI be used to write medical papers[N]. Health, 2024-01-17(5).)

Silvia Vaccino-Salvadore.Exploring the Ethical Dimensions of using ChatGPT in language learning and beyond[J]. Languages, 2023, 8(3): 191.

MCADOO T. How to cite ChatGPT[EB/OL]. [2024-01-29]. https://apastyle.apa.org/blog/how-to-cite-chatgpt.

MLA style center. How do I cite generative AI in MLA style?[EB/OL]. [2023-12-25]. https://style.mla.org/citing-generative-ai/.

全国信息与文献标准化技术委员会.信息与文献 参考文献著录规则: GB/T 7714-2015 [S]. 北京: 中国标准出版社, 2015. (Information and Documentation. Information and documentation—rules for bibliographic references and citations to information resources: GB/T 7714-2015[S]. Beijing: Standard Press of China, 2015.)

作者贡献说明/Author contributions:

张艳丽:确定研究思路,撰写论文初稿,修改论文与定稿;

管玉燕:相关政策资料收集整理,修改论文和校对格式;

宛 雪:调研、分析AIGC工具,进行数据分析和解释,校对论文;

赵晶浩:调研、论证AIGC工具生成原理和存在风险。

The Risk Review and Countermeasures of Using AIGC in Academic Research

Zhang Yanli Guan Yuyan Wan Xue Zhao Jinghao

Tongfang Knowledge Network Digital Publishing Technology Co., Ltd.(Beijing), Beijing 100192

Abstract: [Purpose/Significance] This study aims to analyze the potential risks of using AIGC tools during academic research, study the strategies to avoid these risks and provide references and guidance for researchers so that they can use AIGC tools in compliance with rules and laws. [Method/Process] This study sorted out the policies and regulations related to the application of AIGC in academic fields at home and abroad, summarized and analyzed the main risks of using AIGC. Then, combined with the researchers’ academic research process, risk avoidance strategies and feasible suggestions for using AIGC at different stages were proposed. [Result/Conclusion] The risks of using AIGC tools for researchers mainly focus on the security of input content, the reliability of output results, academic ethical risks, and potential legal risks. Researchers should enhance their risk-awareness, understand the policy regulations, know the usage boundaries for different research stages and scenarios very well, and regulate their usage behavior to ensure that AIGC tools play a positive role in academic research.

Keywords: AIGC Generative AI academic research risk analysis countermeasure

Author(s): Zhang Yanli, master, E-mail: zyl11604@cnki.net; Guan Yuyan, master; Wan Xue, master; Zhao Jinghao, master.

Received: 2024-05-12 Published: 2024-07-22