基于YOLOv5的室内小物品识别定位关键算法研究

2024-05-19王映晖邱文惠刘广臣

王映晖 邱文惠 刘广臣

摘要:对于盲人而言,室内寻找水杯、毛巾、遥控器等物品是日常生活中必不可少的技能。由于他们无法依靠视觉来定位和识别物品,因此必须依赖其他感官或工具来进行这项行动。针对盲人寻物困难的痛点, 因此主要研究YOLOv5与训练个性化数据集、目标检测技术对室内目标进行检测和定位的理论和实现,辅以Kaldi技术进行语音交互,实现辅助视障人士智能化搜寻和识别室内物品。基于YOLOv5训练个性化数据与特征提取,用于后期物体识别与定位提供数据支持。最后,基于YOLOv5目标检测算法与单目测距进行目标物体的识别与定位。实验结果表明该算法可以准确地识别和定位小物品,实现了室内导航的基本功能。

关键词:YOLOv5;目标检测;Kaldi;语音交互;单目测距

中图分类号:TP312 文献标识码:A

文章编号:1009-3044(2024)07-0015-03

开放科学(资源服务)标识码(OSID)

0 引言

根据世界卫生组织2014年的统计数据,全球有2.17亿人患有中度至重度视力障碍,3 600万人失明[1]。到2025年,这个数字可能会超过5.5亿。我国是全世界盲人最多的国家之一,中国盲人群体数量庞大,占世界盲人总数的18%。随着国家经济发展加快以及对残障人士的关注支持力度加大,大多数盲人生活水平有大幅度提高。面对数量如此巨大的盲人群体,解决因视力障碍带来的生活困难成了研究者共同关注的问题,然而各异的致盲原因和盲人群体的经济水平,使得生物技术无法完全解决盲人问题。而室内小物品定位与识别导航技术大多需要在被定位物体上安装标签或者终端设备,在一些特殊环境下存在着一定的局限性。

针对盲人导盲辅助设备的外观设计,基本分为三大类[2],分别是手杖类、穿戴类、移动类辅助工具,如斯坦福大学智能系统实验室的博士后帕特里克·斯莱德(Patrick Slade) 研发的基于超声波传感器的增强型手杖[3]、宛处好等人[4]研发的基于地图定位与卷积神经网络的可穿戴智能导盲设备、李达等人[5]研制的导盲机器人。万子朴等人[6]研究了一种基于RFID射频识别的盲人寻物器;林会祺等人[7]研究了一种基于YOLOv3算法和超声波测距的AI智能导盲眼镜设计;洪毅[8]研究了一种基于红外线传感器、超声波传感器、激光雷达的电子导盲车和一种基于Unity3D的听觉空间感知导盲系统;陈晓燕[9]研究了一种基于射频识别技术来实现环境识别、局部导航以及通过SIM868模块实现GPS定位且具有GPRS、GSM功能的导盲杖;吴涛[10]提出了一种基于边缘的自动种子点深度图像分割算法以通过自适应的边缘检测算法找到图像中的物体轮廓边缘的图像处理技术和基于RGB-D的室内电子导盲系统研究。

本文提出YOLOv5及单目测距进行目标识别与定位,相比于以上几种技术,YOLOv5及单目测距进行目标识别与定位具有结构简单、适应能力强等优点,YOLOv5通过摄像头来获取视觉信息,可以获取更为丰富的室内环境信息,且随着图像处理技术的深入发展,使得该项目具有更广阔的发展平台,该项目所提供的交互式信息输入与输出具有一定的创新性。

1 室内小物品定位与识别算法设计

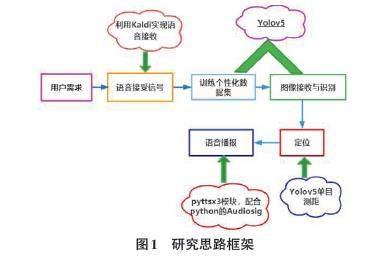

本课题围绕在室内生活相对静止的环境中,对多目标、小物品的识别及定位导航问题。课题内研究思路框架如图1所示:

1.1 语音信号输入

要想使用Kaldi對语音数据进行识别,通常需要将语音数据切割成较短的语音片段,以便于后续的特征提取和模型训练。在Kaldi中,语音建模是语音识别的核心部分,它将特征数据进行统计建模,建立起音素、词、句子等语音单位之间的映射关系。常用的建模方法包括隐马尔可夫模型(HMM) 和深度神经网络(DNN) 等。

1.2 YOLOv5模型建立

要进行模型训练首先要进行图像特征标定,选择利用labelimg进行图像特征标定,对收集好的数据集进行分类,分为训练集与验证集,以便进一步利用YOLOv5训练图像识别模型,通过对模型权重等参数的调整,进行图像识别模型的训练。

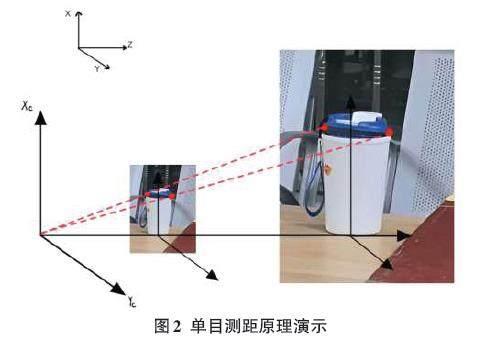

1.3 图像识别与测距

用摄像头采集图片,将三维场景投影到摄像机二维像平面上,主要利用小孔成像模型求解,即任意点P1 在图像中的投影位置P1'为光心O与 P1点的连线与图像平面的交点。F为摄像头的焦距,C为镜头光心。物体发出的光经过相机的光心,然后成像于图像传感器或者也可以说是像平面上。如果设物体所在平面与相机平面的距离为D,目标框实际宽度P1和P2之间的宽度为W,且W是已知量,摄像头采集到图像内目标的P1'和P2'宽度为P,根据公式可以求得距离D。目标识别算法标出了图像区域的范围以及矩形框的长宽,所以图像中的距离P可以得到。W为实际图片中的边长,为已知量,摄像头焦距F也已知,故可求出距离D。已知物体尺寸的单目视觉测距是指在已知物体信息的条件下,利用摄像头获得的目标图片得到深度信息[11]。

在众多测距方式中,笔者选择利用摄像头进行视频测距,与前面介绍的几种算法相比较,视频测距最大的不同是被动式的测距。它不需要向被测物体发射任何信号或接收信号,只需要拍摄下包含所需要目标的视频或者图片就可以根据需要对目标进行距离的测量。另外,由于图像中往往包含的信息量很大,利用图像处理技术识别并提取这些信息,能够获得更多的数据信息,可以提高判断的精度。随着图像处理速度的提高和技术的不断完善,视频测距技术的应用前景也越来越广阔[12]。

要实现单目测距[13]需要定义两个变量:分别是焦距、待测物品高度。然后再定义一个自定义函数,用于进行单目测距。这两个函数都有一个参数h,表示检测到的目标高度,通过目标高度、焦距和实际高度计算目标与相机之间的距离。函数中使用英寸作为距离单位,最后将距离转换为米作为距离单位并返回。

在图像识别的过程中,在计算待测物品与摄像头的距离之前,应当针对物品的置信度进行筛选,即为识别精度,如公式(1) :

[D=F×WP] (1)

式中:D为目标到摄像机的距离;F为摄像机焦距;W为目标的宽度或者高度;P为目标在图像中所占据的x方向像素(宽)或者y方向像素(高)。

确定好焦距与和待测物品高度(单位为英寸),经过转换,最终得到单位为米的距离。

1.4 语音信号输出

在得到摄像头距待测物品的距离之后,通过Python的pyttsx3库,将数据转化为文字信息,传递给语音合成引擎,然后引擎将文本转换为音频文件,并通过操作系统的音频设备进行播放,以此进行对距离的语音播报,并通过setProperty函数进行语速与音量的设置。

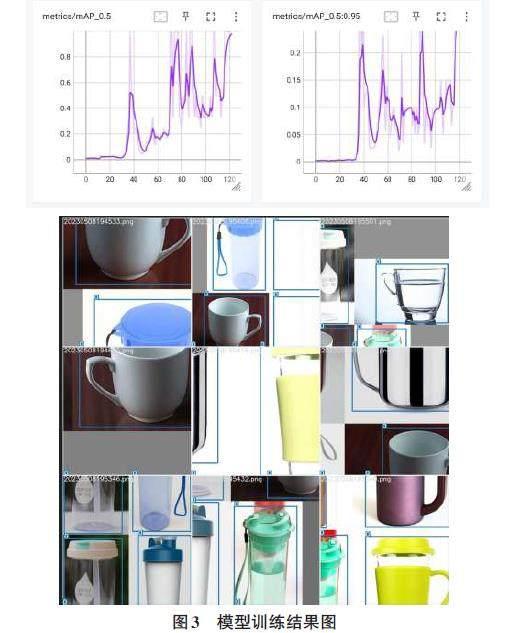

1.5 模型评价标准与回测

平均精确度(mAP) 是目标检测中常用的评价指标之一,象征着模型的推理的准确程度。

精确度(Precision) 和召回率(Recall) 通常是一对矛盾的指标,精确度是指模型在检测出的目标中真正正确的比例,召回率是指模型在所有正确目标中检测到真正正确的比例。

错误率(Error Rate) 是指模型在目标检测过程中的错误率,包括漏检和误检。

定位误差(Localization Error) 是指模型检测到的目标位置与真实目标位置之间的误差。通常使用IoU(Intersection over Union) 作为定位误差的度量,IoU是指检测到的目标框与真实目标框的交集面积与并集面积之比。

处理速度(Inference Speed) 是指模型在实际应用中的推理速度,包括模型的前向推理和后处理时间。

模型的回测(Retrospective Evaluation) 指的是在模型训练完毕后,使用之前保留的测试集或验证集数据对模型进行评估的过程。

当模型训练完毕后,可以使用测试集数据对模型进行回测。通常,回测过程会使用之前保留的测试集数据输入已经训练好的模型中,获取模型的检测结果,并与真实标签进行比较,计算模型在测试集上的性能指标,如平均精确度、精确度、召回率、错误率、定位误差等。通过回测评估模型在未见过数据上的性能,可以更全面地了解模型的性能表现,并对模型进行调整和改进。

2 算法实证研究

2.1 数据集来源与预处理

本文选用自主拍摄物品图像,利用Labelimg自主标注。

首先,需要准备包含目标检测样本的数据集。这个数据集应该包括目标物体(水杯、手机等)的图像以及相应的标注信息。

其次,将整个数据集划分为训练集、验证集和测试集对模型进行训练。本文采用的文件夹划分,将数据集中的样本按照存储文件夹进行划分。比例根据数据量不同有所不同,本文按96%:2%:2%进行划分。在进行数据集划分时,保持训练集和测试集的数据分布一致性。

2.2 实验结果

对模拟结果进行分析,可以计算模型的准确率、召回率等性能指标,也可以可视化输出结果以便观察。如果结果不够理想,可以通过调整模型参数或者增加数据集的大小来改进模型性能,也可以对检测结果进行后处理,包括非极大值抑制(NMS) 等处理方式,以去除重叠的检测框并选择置信度较高的检测结果。

YOLOv5模型的推理速度相较于其训练速度较快,可以在实时或近实时的应用场景中进行目标检测和定位,在训练完成后,检测物品的实例如图4所示。

3 结论

本文提出一种基于YOLOv5模型识别生活中小物品与对其进行单目测距的算法设计。由于YOLOv5深度学习模型高度的稳定性和准确性,较为适合用来进行小目标的检测与识别。设备利用摄像头采集图像,YOLOv5模型配合摄像头单目测距原理对用户与物品之间的距离进行判断,设备同时将距离转化为语音信号播报出来,实现实时提醒用户距离待寻物品的距离,从而达到在无他人协助的前提下,实时指导盲人用户寻找室内小物品的需求,解决了传統方式准确率低、信息滞后的问题。

参考文献:

[1] 武曌晗,荣学文,范永.导盲机器人研究现状综述[J].计算机工程与应用,2020,56(14):1-13.

[2] BOURNE R R A,FLAXMAN S R,BRAITHWAITE T,et al.Magnitude,temporal trends,and projections of the global prevalence of blindness and distance and near vision impairment:a systematic review and meta-analysis[J].The Lancet Global Health,2017,5(9):e888-e897.

[3] Patrick Slade et al.Science Robotics 6[J].Issue 59,2021.

[4] 宛处好,陈雨濛,杨力川,等.一种可穿戴式智能导盲装置:CN110623820A[P].2019-12-31.

[5] 李达,付开磊,王兵雷,等.一种导盲机器人:[P].甘肃:CN206285242U, 2017- 06-30.

[6] 万子朴,胡宸瑞哲,周煜然,等.一种基于RFID射频识别的盲人寻物器:CN208000669U[P].2018-10-23.

[7] 林会祺,周义涛,翁名键,等.AI智能导盲眼镜的设计与实现[J].信息与电脑(理论版),2021,33(6):171-173.

[8] 洪毅.电子导盲系统研究及应用[D].广州:广东工业大学,2021.

[9] 陈晓燕.基于RFID、GPS实现环境识别、路径查看的导盲杖[D].保定:河北大学,2019.

[10] 吴涛.基于RGB-D的室内电子导盲系统研究[D].西安:西安科技大学,2018.

[11] 王文胜,李继旺,吴波,等.基于YOLOv5交通标志识别的智能车设计[J].国外电子测量技术,2021,40(10):158-164.

[12] 黎晓珊.《中国视频社会化趋势报告》发布[N].人民日报, 2020-11-26.

[13] 王士明.基于计算机视觉的车辆单目测距系统研究[D].天津:天津大学,2012.

【通联编辑:唐一东】